想像してみてください。2025年、ウェブの世界はこれまで以上に広大で複雑、そしてチャンスにあふれています。でも現実は、今やインターネットのトラフィックの半分近くが人間ではなくボットによるもので、その多くがビジネス目的のデータ収集なんです。SaaSや自動化の現場で長年やってきた私からすると、リンクを手作業でコピペする時代はもう完全に終わりました。今、リンク抽出ツールやURL抽出ツールを使わないのは、まるでバターナイフで戦場に出るようなものです。

では、膨大なリンクやURL、データを効率よく抜き出すには、どんなツールを選べばいいのでしょう?AI搭載のノーコード型から開発者向けまで、2025年におすすめのリンク抽出ツール12選を徹底比較しました。営業、マーケター、データ分析担当など、どんな立場の方にもピッタリの選択肢が見つかります。そしてもちろん、私たちのチームが開発したが、なぜビジネスユーザーにとって最先端の選択肢なのかもご紹介します。

2025年にリンク抽出ツールやURL抽出ツールが必要な理由

今やウェブ上には膨大なデータが溢れ、企業はその混沌から価値あるインサイトを引き出すためにしのぎを削っています。やは、次のような業務に欠かせない存在となっています:

- リード獲得:営業チームは、ディレクトリやLinkedInから企業プロフィールのリンクを一括取得し、連絡先情報の抽出に活用できます。もう無限クリックは不要です。

- コンテンツ集約・SEO強化:マーケターは、ブログ記事のURLをまとめて収集したり、競合の被リンクを監視したり、サイト構造のリンク切れをチェックできます。

- 競合調査・市場リサーチ:オペレーション担当は、新商品や価格ページ、プレスリリースのリンクを自動で集め、競合動向を手間なく把握できます。

- 業務自動化・時短:最新のリンクスクレイパーは、複数URLの一括処理やサブページのクロール、CSV・Excel・Google Sheets・Notionなどへのエクスポートに対応。手作業のコピペやテキスト整理から解放されます。

現代、手作業での対応は現実的ではありません。優れたリンク抽出ツールは、疲れ知らずでミスもなく、コーヒーブレイクも不要なスーパーアシスタントのような存在です。

ベストなリンク抽出ツールの選定基準

ツールが多すぎて選べない…そんな方のために、私が12選を厳選したポイントは以下の通りです:

- 使いやすさ:プログラミング不要で直感的に使えるか?ノーコード・ローコード型は高評価。

- 大量・多階層対応:数百のURLを一括処理できるか?サブページの自動クロールは可能か?

- エクスポート・連携:CSV、Excel、Google Sheets、Notion、Airtable、API連携など、手間なくデータを活用できるか。

- ユーザー層・柔軟性:ビジネスユーザー、アナリスト、開発者など、誰向けか。汎用性や専門性も考慮。

- 高度な機能:AIによる自動認識、スケジューリング、クラウド実行、データクレンジング、テンプレート対応など。

- 価格・スケーラビリティ:無料枠、従量課金、エンタープライズ向けなど、コストパフォーマンスも重視。

ブラウザ拡張から大規模プラットフォームまで幅広く網羅しているので、個人事業主から大企業のデータチームまで、最適なツールが見つかります。

Thunderbit:ビジネスユーザー向け最先端リンク抽出ツール

まずは筆頭からご紹介。は、2025年のリンク抽出で私が最もおすすめするツールです(開発に携わったからだけではありません)。Thunderbitはで、スピーディーに結果を出したいビジネスユーザー向けに設計されています。

Thunderbitの強みは、まるで「指示通りに動くAIインターン」がいるかのような使い心地。たとえば「このページから商品リンクと価格を全部取得して」と自然な日本語で伝えるだけで、AIが自動で抽出設定をしてくれます。面倒なセレクタ指定やスクリプト作成は不要です。

さらに:

- 大量URL対応:1件でも数百件でも、URLリストをまとめて一括処理。

- サブページ自動巡回:リストページから詳細ページへ移動し、さらにリンクを抽出する多階層ロジックもOK。

- 構造化エクスポート:抽出したリンクはフィールド名の変更やカテゴリ分けもでき、Google Sheets、Notion、Airtable、Excel、CSVへ直接出力。後処理の手間がありません。

Thunderbitは世界3万人以上のユーザーに利用されており、営業、不動産、ECショップなど幅広い業種で活躍中。しかも(6ページまで、トライアルで最大10ページ)もあるので、気軽にお試しいただけます。

Thunderbitの注目機能

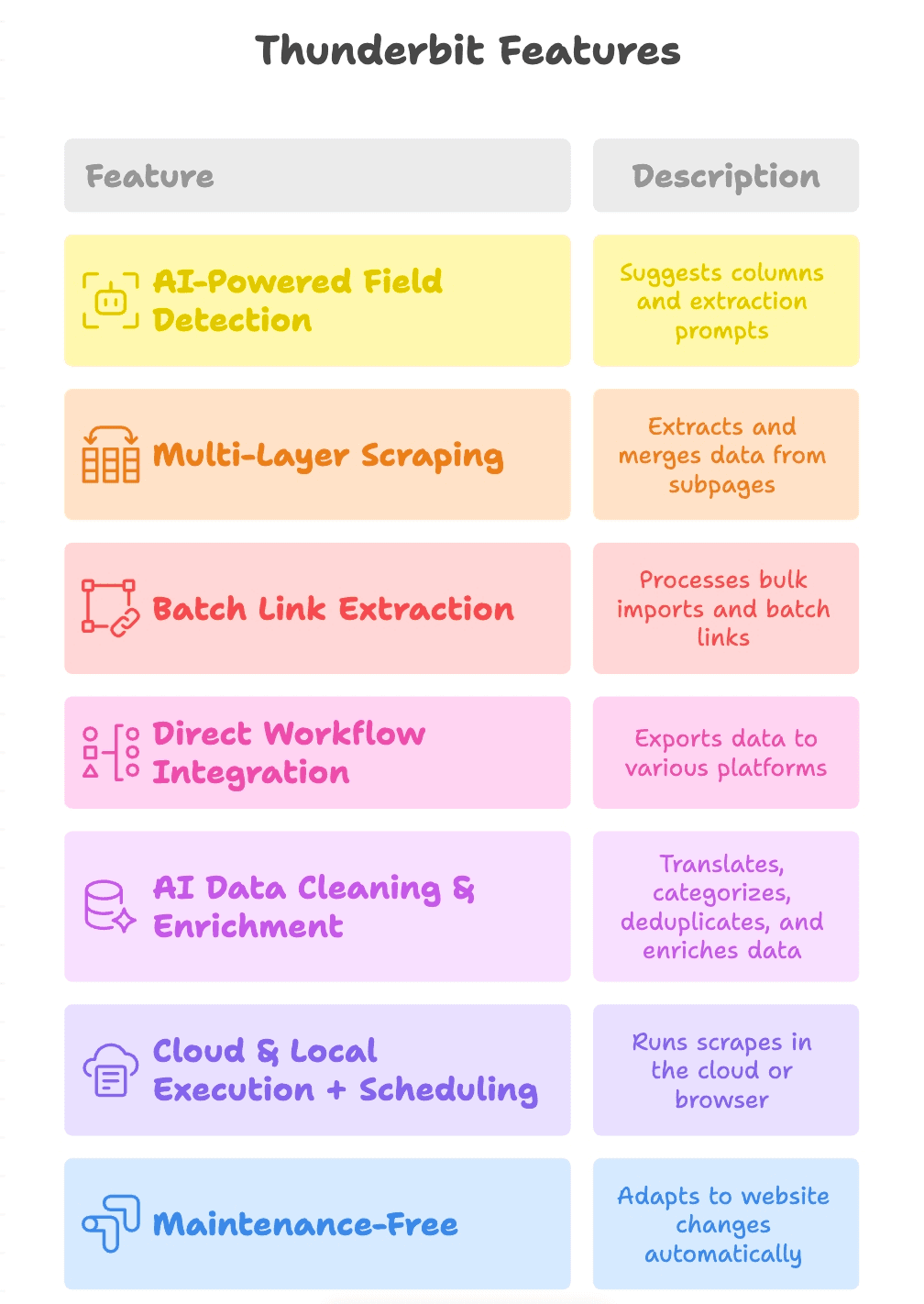

Thunderbitが他と一線を画す理由を詳しくご紹介します:

- AIによるフィールド自動認識:「AIでフィールド提案」をクリックするだけで、ページ内容を解析し「商品リンク」「PDF URL」「連絡先メール」などのカラムを自動で提案。各フィールドごとに抽出プロンプトも作成。

- 多階層スクレイピング:メインページからサブページ(商品詳細やPDFダウンロードなど)へリンクをたどり、さらにリンクを抽出して1つのテーブルに統合。

- バッチリンク抽出:1ページでも1000ページでも、URLリストの一括インポート&バッチ抽出が可能。

- ワークフロー連携:Google Sheets、Notion、Airtableへの直接出力や、CSV/Excelダウンロードに対応。チームのデータ活用がスムーズ。

- AIによるデータクレンジング・付加価値化:翻訳、カテゴリ分け、重複排除、データ補完なども自動で実行。抽出結果はすぐに使える状態に。

- クラウド&ローカル実行+スケジューリング:高速なクラウド実行、ログインが必要なサイトはローカル実行、定期実行も設定可能。

- メンテナンス不要:AIがサイト構造の変化に自動対応。壊れたスクレイパーの修正に追われる心配なし。

Octoparse:ノーコードで使える定番リンク抽出ツール

は、ノーコード型スクレイピングの定番。Windows/Mac対応のデスクトップアプリで、画面上で抽出したいリンクをクリックするだけの直感操作が魅力です。

- 初心者に最適:プログラミング不要。クリックして抽出、すぐに使えます。

- ページ送り・動的コンテンツ対応:「次へ」ボタンの自動クリックやスクロール、ログインもOK。

- クラウド実行・スケジューリング:有料プランでクラウド実行や定期実行も可能。

- 多彩なエクスポート:CSV、Excel、JSON、データベース連携も対応。

無料プランは小規模用途に十分(10タスク・月5万行まで)。本格利用は月75ドル程度から。

Apify:カスタムワークフローに強い柔軟なURL抽出ツール

は、ウェブスクレイピングの万能ツール。マーケットプレイスの「アクター」(プリセットツール)や、JavaScript/Pythonで独自スクリプトも作成できます。

- プリセット&カスタマイズ:よく使うタスクはコミュニティ製アクター、独自ワークフローは自作もOK。

- 大量・定期スクレイピング:URLをキューに登録し、並列実行や定期実行も可能。

- APIファースト:JSON、CSV、Excel、Google Sheetsへのエクスポートやデータパイプライン連携。

- 従量課金制:毎月無料クレジットあり、以降は使った分だけ課金。

柔軟性と拡張性を求める開発者やセミテクニカルなチームに最適です。

Bright Data URL Scraper:大規模業務向けエンタープライズツール

は、超大規模なデータ収集が必要な企業向け。Data CollectorにURLスクレイパーのプリセットが用意されています。

- 大規模対応:数千〜数百万ページのスクレイピングも安定稼働。強力なプロキシでブロック回避。

- テンプレート充実:EC、SNS、不動産など業種別プリセットも豊富。

- エンタープライズ機能:コンプライアンス、専門サポート、高度なアンチブロック機能。

- 価格:10万ページで約350ドル〜。大規模用途向け。

スタートアップにはオーバースペックですが、ミッションクリティカルな大規模案件には最適です。

WebHarvy:クリック操作で使えるビジュアルリンク抽出ツール

は、Windows対応のデスクトップアプリ。内蔵ブラウザでリンクをクリックするだけで抽出できます。

- 超シンプル操作:リンクをクリックすると、同じ要素を自動でハイライト&抽出。

- 正規表現対応:よく使うパターンも内蔵、コーディング不要。

- 多彩なエクスポート:Excel、CSV、JSON、XML、SQLなど。

- 買い切りライセンス:一度購入すればずっと使えます。

小規模ビジネスや研究者、手軽にリンク抽出したい方におすすめです。

Web Scraper(Chrome拡張):ブラウザで手軽にリンク抽出

は、無料&オープンソースで使えるブラウザ用スクレイパー。

- サイトマップ定義:巡回ルートや抽出内容を設定。

- ページ送り・多階層クロール:カテゴリ・サブカテゴリ・詳細ページも自動巡回。

- CSV/XLSX出力:ブラウザから直接ダウンロード。

- コミュニティテンプレート:人気サイト用の共有サイトマップも豊富。

単発の作業や予算を抑えたい学生・小規模チームに最適です。

ScraperAPI:開発者向けスケーラブルなリンク抽出API

は、プロキシやブロック対策を気にせず大量ページを取得したい開発者向けAPI。

- API駆動:URLを送信→HTMLや抽出データを受信。

- 大規模&アンチボット対応:プロキシ自動切替、JSレンダリング、CAPTCHA回避も内蔵。

- コード連携:Python、Node.jsなど様々な言語で利用可能。

- 価格:無料枠(約1000APIコール)、以降は従量課金。

信頼性とスピード重視のカスタムクローラーに最適です。

ParseHub:高度な選択ができるビジュアルリンク抽出ツール

は、Windows/Mac/Linux対応のデスクトップアプリ。視覚的にスクレイピングプロジェクトを構築できます。

- 高度な選択・巡回:クリック、ループ、条件抽出で動的・隠れ要素も対応。

- 多階層ページ対応:カテゴリ→詳細ページ→さらにリンク抽出もOK。

- 多彩なエクスポート:CSV、Excel、JSON、API連携(有料プラン)。

- 無料プラン:5プロジェクト、1回200ページまで。

ノーコードでパワフルな抽出をしたいマーケターやリサーチャーに人気です。

Scrapy:開発者向けPython製リンク抽出フレームワーク

は、Python開発者に定番の本格派フレームワーク。

- コード重視:カスタムスパイダーで大規模クロール&抽出。

- 分散クロール対応:非同期・高効率・柔軟なカスタマイズ。

- 多彩な出力:CSV、JSON、XML、DBなど自由自在。

- オープンソース&無料:自分で環境構築が必要。

Pythonに慣れている方なら、最高レベルのパワーを発揮します。

Diffbot:AIで構造化データを返すリンク抽出ツール

は、AIでページを解析し、リンクを含む構造化データを自動返却。

- 自動コンテンツ認識:URLを送るだけで記事・商品・リンクなどを構造化データで取得。

- Crawlbot&ナレッジグラフ:サイト全体のクロールや巨大なウェブインデックスのクエリも可能。

- API駆動:BIツールやデータパイプラインと連携。

- エンタープライズ価格:月299ドル〜。高品質なデータが必要な企業向け。

スクレイパー管理不要でクリーンなデータが欲しい大企業に最適です。

Cheerio:Node.js向け軽量リンク抽出ライブラリ

は、Node.js用の高速HTMLパーサー。jQueryライクな記法で使えます。

- 超高速:ミリ秒単位でHTML解析。

- 馴染みやすい構文:jQuery経験者ならすぐ使えます。

- 静的ページ向き:JSレンダリングは非対応ですが、サーバーサイド生成ページに最適。

- オープンソース&無料:axiosやfetchと組み合わせて利用。

スピードとシンプルさ重視のカスタムスクリプトにおすすめです。

Puppeteer:高度なブラウザ自動化でリンク抽出

は、Chromeをヘッドレスで操作できるNode.jsライブラリ。

- 完全なブラウザ自動化:ページ読み込み、クリック、スクロール、ユーザー操作も自在。

- 動的コンテンツ・ログイン対応:JSが多用されたサイトや複雑なワークフローに最適。

- 細かな制御:要素待機、スクリーンショット、ネットワーク監視も可能。

- オープンソース&無料:軽量ツールよりはリソース消費大。

通常のスクレイパーが苦手なサイトのリンク抽出に活躍します。

一目で分かる12ツール比較表

各ツールの特徴をまとめました:

| ツール名 | おすすめユーザー | 大量・サブページ対応 | データ出力形式 | 価格 |

|---|---|---|---|---|

| Thunderbit | ノーコード・ビジネス | あり(AI・多階層) | Excel, CSV, Sheets, Notion, Airtable | 無料トライアル、約9ドル/月〜 |

| Octoparse | ノーコード・分析 | あり | CSV, Excel, JSON, クラウド | 無料枠、約75ドル/月〜 |

| Apify | セミテク・開発者 | あり | CSV, JSON, Sheets(API) | 無料クレジット、従量課金 |

| Bright Data | エンタープライズ | あり(大規模) | CSV, JSON, NDJSON(API) | 約350ドル/10万ページ |

| WebHarvy | ノーコード・デスクトップ | あり | Excel, CSV, JSON, XML, SQL | 買い切り |

| Web Scraper拡張 | どなたでも・無料 | あり | CSV, XLSX | 無料・OSS |

| ScraperAPI | 開発者・API利用 | あり | JSON(HTML/API) | 無料1k回、従量課金 |

| ParseHub | ノーコード・高機能 | あり | CSV, Excel, JSON, API | 無料5件、課金あり |

| Scrapy | 開発者・Python | あり | CSV, JSON, XML, DB | 無料・OSS |

| Diffbot | エンタープライズ・AI | あり(AIクロール) | JSON(構造化API) | 約299ドル/月〜 |

| Cheerio | 開発者・Node.js | あり(自作コード) | カスタム(JSON等) | 無料・OSS |

| Puppeteer | 開発者・複雑サイト | あり(全自動) | カスタム(スクリプト出力) | 無料・OSS |

ビジネスに最適なリンク抽出ツールの選び方

どれを選ぶべきか迷ったら、以下を参考にしてください:

- プログラミング不要派:Thunderbit、Octoparse、ParseHub、WebHarvy、Web Scraper拡張がおすすめ。

- カスタムワークフロー重視:Apify、ScraperAPI、Cheerioは開発者向け。

- 大規模・エンタープライズ用途:Bright DataやDiffbotが最適。

- Python/Node.js開発者:Scrapy(Python)、Cheerio/Puppeteer(Node.js)が自由度抜群。

- Sheets/Notionへ直接出力したい:Thunderbitが最適解。

自分の技術レベルやデータ量、連携先に合わせて選んでみてください。多くのツールが無料トライアルを用意しているので、まずは気軽に試してみるのがおすすめです。

2025年のリンク抽出でThunderbitが選ばれる理由

改めて、Thunderbitの独自価値をまとめます:

- AIによる圧倒的な手軽さ:やりたいことを日本語で伝えるだけでAIが自動抽出。

- 多階層スクレイピング:メインページ→サブページ→さらにURL抽出まで一括処理。

- 大量インポート&バッチ処理:数百URLも一括抽出、即座に構造化データ化。

- ワークフロー連携:Google Sheets、Notion、Airtableへ直接出力、CSV/ExcelもOK。

- メンテナンス不要:AIがサイト変化に自動対応、壊れたスクレイパーの修正不要。

Thunderbitは「ただデータを集める」だけでなく、「すぐ使えるデータを手に入れる」ための架け橋です。私自身、手作業でデータ整理に追われていた頃に欲しかったツールです。

まとめ:リンク抽出を賢く自動化し、業務効率を最大化

2025年、ウェブデータはビジネス成長の原動力。そのデータを活かすには、最適なリンク抽出ツールが不可欠です。リードリスト作成、競合監視、リサーチ自動化など、あなたの目的やスキルに合ったツールが必ず見つかります。

最新のリンク抽出を体験したい方は、をぜひお試しください。数クリックで驚くほど多くのことが実現できるはずです。もしThunderbitが合わなければ、他のツールもぜひ試してみてください。今こそ、面倒な作業を自動化し、本当に価値ある仕事に集中できる時代です。

リンク抽出がスムーズに進み、常にクリーンで構造化されたデータが手に入りますように。さらに詳しいウェブスクレイピング情報はもご覧ください。

よくある質問(FAQ)

1. 2025年にリンク抽出ツールが必須な理由は?

インターネットトラフィックの約半分がボット化し、企業によるデータ収集競争が激化する中、リンク抽出ツールはウェブの混沌を価値あるインサイトに変えるために不可欠です。リード獲得、コンテンツ集約、SEO監査、競合監視などを自動化し、大幅な時短と効率化を実現します。

2. Thunderbitが他のリンク抽出ツールと違う点は?

ThunderbitはAIを活用し、やりたいことを日本語で伝えるだけで自動抽出。大量URL入力、多階層抽出、スマートなフィールド検出、Google SheetsやNotionなどへのシームレスな出力に対応。非エンジニアやビジネスユーザーでも強力な結果を簡単に得られます。

3. 開発者やカスタムワークフロー向けのリンク抽出ツールは?

はい。Apify、ScraperAPI、Cheerio、Puppeteer、Scrapyなどは開発者向けで、スクリプト作成やAPI連携、複雑な自動化や大規模処理にも柔軟に対応します。

4. コーディング不要で使えるリンク抽出ツールは?

Thunderbit、Octoparse、ParseHub、WebHarvy、Web Scraper Chrome拡張は、非エンジニアでも使いやすいビジュアル操作やAI機能が充実しています。

5. 自分に合ったリンク抽出ツールの選び方は?

技術レベル、データ量、出力先を考慮しましょう。ノーコード派はThunderbitやOctoparse、開発者はScrapyやPuppeteer、大規模用途はBright DataやDiffbotがおすすめ。まずは無料トライアルで使い勝手を確かめてみてください。