2025年のウェブサイト運営は、まるで終わりのない障害物競走のように感じることも多いですよね。今日はリンク切れの修正、明日はコンテンツ移行の準備、そして「なぜGoogleが2019年の“テスト”ページをインデックスしたのか?」と頭を抱える日々…。私も何度もそんな経験をしてきました。きっとあなたも深夜2時に「無料ウェブサイトクローラー おすすめ」と検索したことがあるはず。できれば、難しい知識がなくてもサクッと使えるツールが欲しいですよね。

でも実は、「ウェブクローラー」と「ウェブスクレイパー」を混同している人がとても多いんです。似ているようで、実は全然違うもの。このガイドでは、その違いを分かりやすく解説し、なぜ今オンラインのウェブクローラーがこれまで以上に重要なのか、そして2025年におすすめの無料ウェブサイトクローラー10選を紹介します。さらに、の共同創業者として、面倒な設定なしでAIが必要なデータを一発で取得できる方法もお伝えします。さあ、一緒にクロールの世界をのぞいてみましょう!

ウェブサイトクローラーとは?基本をおさらい

まず最初に整理しましょう。ウェブサイトクローラーとウェブスクレイパーは別物です。よく混同されがちですが、役割が違います。クローラーは、サイト全体を巡回してページ構造を把握し、すべてのURLを発見・マッピングする“探検家”のような存在。Googleなどの検索エンジンやSEOツールがサイト診断で使うのがこれです()。

一方、ウェブスクレイパーは“データ採掘者”。全体像には興味がなく、特定の情報(商品価格、会社名、レビュー、メールアドレスなど)だけをピンポイントで抽出します。クローラーが見つけたページから、必要なデータだけを抜き出す役割です()。

イメージで例えると:

- クローラー: スーパーの全通路を歩き回って、すべての商品をリストアップする人

- スクレイパー: コーヒー売り場だけに直行して、オーガニック商品の価格だけを書き出す人

この違いを知っておくと、目的に合ったツール選びができます。例えば、サイト全体のページを把握したい(SEO診断など)ならクローラー。競合サイトの商品価格を集めたいならスクレイパー、もしくは両方の機能を持つツールが最適です。

オンラインウェブクローラーを使うメリットとは?

2025年、なぜオンラインのウェブクローラーが必要なのでしょうか?その理由は、ウェブの規模が年々拡大し続けているからです。実際、し、SEOツールの中にはもクロールするものもあります。

クローラーでできることは?

- SEO診断: リンク切れ、タイトル抜け、重複コンテンツ、孤立ページなどを発見()。

- リンクチェック&品質管理: 404エラーやリダイレクトループを事前に検知()。

- サイトマップ自動生成: 検索エンジン用XMLサイトマップや設計用マップを作成()。

- コンテンツ棚卸し: 全ページのリストや階層、メタ情報を整理。

- アクセシビリティ&法令対応: WCAGやSEO、法的要件のチェック()。

- パフォーマンス&セキュリティ: 表示速度や画像サイズ、セキュリティ問題を検出()。

- AI・分析用データ収集: クロールデータを分析やAIツールに活用()。

用途と担当者の関係をまとめた表はこちら:

| 用途 | おすすめ職種 | 主なメリット |

|---|---|---|

| SEO・サイト診断 | マーケター、SEO担当、中小企業オーナー | 技術的課題の発見、構造最適化、検索順位向上 |

| コンテンツ棚卸し・品質管理 | コンテンツ管理者、ウェブ担当 | 移行や監査、リンク・画像切れの発見 |

| リード獲得(スクレイピング) | 営業、事業開発 | 見込み客リスト自動化、CRMへの新規リード追加 |

| 競合調査 | EC、プロダクトマネージャー | 価格・新商品・在庫変動のモニタリング |

| サイト構造クローン | 開発者、DevOps、コンサル | サイトリニューアルやバックアップ用構造複製 |

| コンテンツ集約 | リサーチャー、メディア、アナリスト | 複数サイトからのデータ収集・トレンド分析 |

| 市場調査 | アナリスト、AI開発チーム | 大規模データセットの収集・AI学習用 |

()

無料ウェブサイトクローラーの選定基準

実際にいろいろなクローラーを試して、ドキュメントを読み込み、テストクロールも繰り返してきました。選ぶときに重視したポイントは以下の通りです:

- 技術対応力: JavaScriptやログイン、動的コンテンツに対応できるか

- 使いやすさ: 非エンジニアでも扱えるか、コマンド操作が必要か

- 無料プランの範囲: 本当に無料か、体験版だけか

- オンライン対応: クラウド型、デスクトップ型、ライブラリ型の違い

- 独自機能: AI抽出、ビジュアルサイトマップ、イベント駆動型などの特徴

実際に使い比べて、ユーザー評価も参考にしました。「使いにくい」と感じたツールはリストから外しています。

一目で分かる!2025年おすすめ無料ウェブサイトクローラー10選

| ツール&タイプ | 主な機能 | 最適な用途 | 技術要件 | 無料プラン内容 |

|---|---|---|---|---|

| BrightData(クラウド/API) | 大規模クロール、プロキシ、JS対応、CAPTCHA突破 | 大量データ収集 | 技術知識あると便利 | 無料トライアル:3スクレイパー、各100件(計約300件) |

| Crawlbase(クラウド/API) | APIクロール、アンチボット、プロキシ、JS対応 | バックエンド開発者 | API連携 | 無料:7日間5,000回、その後月1,000回 |

| ScraperAPI(クラウド/API) | プロキシ自動切替、JS対応、非同期クロール | 開発者、価格監視、SEO | 最小限のセットアップ | 無料:7日間5,000回、その後月1,000回 |

| Diffbot Crawlbot(クラウド) | AIクロール+抽出、ナレッジグラフ、JS対応 | 構造化データ収集、AI/ML | API連携 | 無料:月10,000クレジット(約1万ページ) |

| Screaming Frog(デスクトップ) | SEO診断、リンク/メタ分析、サイトマップ | SEO監査、サイト管理 | デスクトップアプリ | 無料:1回500URLまで、基本機能のみ |

| SiteOne Crawler(デスクトップ) | SEO、パフォーマンス、アクセシビリティ、セキュリティ、Markdown出力 | 開発、QA、移行、ドキュメント | デスクトップ/CLI | 無料・OSS、GUIレポートは1,000URLまで(設定可) |

| Crawljax(Java, OSS) | JSサイト向けイベント駆動クロール、静的出力 | 動的WebアプリQA | Java, CLI設定 | 無料・OSS、制限なし |

| Apache Nutch(Java, OSS) | 分散型、プラグイン、Hadoop連携、カスタム検索 | 独自検索エンジン、大規模クロール | Java, コマンドライン | 無料・OSS、インフラ費用のみ |

| YaCy(Java, OSS) | P2Pクロール&検索、プライバシー重視 | プライベート検索、分散型 | Java, ブラウザUI | 無料・OSS、制限なし |

| PowerMapper(デスクトップ/SaaS) | ビジュアルサイトマップ、アクセシビリティ、QA | 制作会社、QA、構造可視化 | GUI、簡単操作 | 無料体験:30日間、デスクトップ100ページ/オンライン10ページ |

BrightData:エンタープライズ向けクラウド型ウェブクローラー

BrightDataは、業界トップクラスの大規模クラウドクローラー。膨大なプロキシネットワークやJavaScriptレンダリング、CAPTCHA突破、カスタムクロール用IDEなど、圧倒的なインフラが魅力です。数百のECサイトを同時監視したい場合などに最適です()。

メリット:

- 強力なアンチボット対策

- エンタープライズ規模の拡張性

- 主要サイト向けテンプレートも用意

デメリット:

- 永続的な無料プランはなし(トライアルのみ)

- シンプルな診断にはオーバースペック

- 非技術者にはやや学習コストあり

大規模クロールが必要な場合はBrightDataがF1マシンのような存在ですが、無料で使い続けるのは難しいです()。

Crawlbase:開発者向けAPI型無料ウェブクローラー

Crawlbase(旧ProxyCrawl)は、API経由でURLを送るだけでHTMLを返してくれるプログラマブルなクローラー。プロキシやジオターゲティング、CAPTCHAも自動対応()。

メリット:

- 成功率99%以上の高精度

- JavaScript対応サイトもOK

- 独自アプリやワークフローに組み込みやすい

デメリット:

- APIやSDK連携が必要

- 無料枠は7日間5,000回、その後月1,000回

開発者で、プロキシ管理なしで大規模クロールしたいならおすすめです()。

ScraperAPI:動的ページも簡単クロール

ScraperAPIは「URLを渡すだけでOK」のシンプルなAPI型クローラー。プロキシやヘッドレスブラウザ、アンチボット対策も自動で、HTMLや一部サイトでは構造化データも取得できます。動的ページにも強く、無料枠も充実()。

メリット:

- 開発者にとって導入が非常に簡単

- CAPTCHAやIP制限、JavaScriptも自動対応

- 無料:7日間5,000回、その後月1,000回

デメリット:

- ビジュアルなクロールレポートはなし

- リンク追跡などは自分でスクリプトが必要

コードに組み込むだけでクロールしたいなら最適です。

Diffbot Crawlbot:AIで自動構造化データ抽出

Diffbot Crawlbotは、AIでページを分類し、記事・商品・イベントなどをJSON形式で自動抽出できる次世代型。まるで“理解力のあるロボットインターン”のような存在です()。

メリット:

- AIによる高精度なデータ抽出

- JavaScriptや動的コンテンツも対応

- 無料:月10,000クレジット(約1万ページ)

デメリット:

- 開発者向け(API連携必須)

- SEO診断ツールではなく、データプロジェクト向き

AIや分析用の大量データ収集に最適です。

Screaming Frog:無料デスクトップSEOクローラー

Screaming Frogは、SEO診断の定番デスクトップクローラー。無料版は1回500URLまでクロール可能で、リンク切れやメタ情報、重複コンテンツ、サイトマップなどを一括チェックできます()。

メリット:

- 高速・高精度でSEO業界でも信頼度抜群

- コーディング不要、URL入力だけでOK

- 無料で500URLまで対応

デメリット:

- デスクトップ専用(クラウド版なし)

- JSレンダリングやスケジューリングは有料

SEO担当者なら必携。ただし大規模サイトには有料版が必要です。

SiteOne Crawler:静的サイト出力&技術監査

SiteOne Crawlerは、技術監査に強いオープンソースの多機能クローラー。SEO・パフォーマンス・アクセシビリティ・セキュリティ診断に加え、サイト全体をMarkdownでエクスポートも可能()。

メリット:

- SEOからパフォーマンス、法令対応まで幅広くカバー

- サイトのアーカイブや移行にも便利

- 無料・OSS、利用制限なし

デメリット:

- 一部GUIツールより技術的

- GUIレポートはデフォルト1,000URLまで(設定変更可)

開発者やQA、コンサルにおすすめの隠れた名ツールです。

Crawljax:動的ページ対応のJava製OSSクローラー

Crawljaxは、ReactやAngularなどのSPAやAJAXサイトをユーザー操作をシミュレートしながらクロールできる専門ツール。イベント駆動型で、動的サイトを静的に出力することも可能()。

メリット:

- SPAや動的サイトのクロールに最適

- オープンソースで拡張性あり

- 利用制限なし

デメリット:

- Javaや設定の知識が必要

- 非技術者には不向き

動的Webアプリのクロールならこれ一択です。

Apache Nutch:大規模分散型ウェブクローラー

Apache Nutchは、オープンソースクローラーの元祖。Hadoop連携で数百万~数十億ページの分散クロールも可能。独自検索エンジン構築にも使われています()。

メリット:

- Hadoop連携で大規模クロール対応

- 高いカスタマイズ性と拡張性

- 無料・OSS

デメリット:

- Javaやコマンド操作など学習コスト高

- 小規模サイトや初心者には不向き

大規模クロールや独自検索エンジン構築に最適です。

YaCy:P2P型ウェブクローラー&検索エンジン

YaCyは、分散型のクローラー兼検索エンジン。各インスタンスがサイトをクロール・インデックスし、P2Pネットワークでインデックスを共有できます()。

メリット:

- プライバシー重視、中央サーバー不要

- プライベート検索やイントラネットにも最適

- 無料・OSS

デメリット:

- 検索結果はネットワークの規模に依存

- Javaや初期設定が必要

分散型や独自検索エンジンに興味がある方におすすめです。

PowerMapper:UX・QA向けビジュアルサイトマップ生成

PowerMapperは、サイト構造をビジュアルで可視化できるツール。クロール結果をインタラクティブなサイトマップとして表示し、アクセシビリティやSEOの基本チェックも可能()。

メリット:

- 制作会社やデザイナーに最適なビジュアルマップ

- アクセシビリティや法令対応もチェック

- GUIで簡単操作、技術知識不要

デメリット:

- 無料体験のみ(30日間、デスクトップ100ページ/オンライン10ページ)

- 本格利用は有料

クライアントへの構造提案やコンプライアンスチェックに便利です。

目的別・無料ウェブクローラーの選び方

選択肢が多い中、どう選ぶべきか?簡単なガイドはこちら:

- SEO診断なら: Screaming Frog(小規模)、PowerMapper(ビジュアル)、SiteOne(詳細診断)

- 動的Webアプリなら: Crawljax

- 大規模・独自検索なら: Apache Nutch、YaCy

- API連携したい開発者なら: Crawlbase、ScraperAPI、Diffbot

- ドキュメント化やアーカイブなら: SiteOne Crawler

- エンタープライズ規模のトライアルなら: BrightData、Diffbot

選定時のポイント:

- スケーラビリティ: サイトやクロール対象の規模

- 使いやすさ: コード操作が必要か、GUIで完結するか

- データ出力形式: CSVやJSON、他ツール連携の有無

- サポート体制: コミュニティやヘルプが充実しているか

クローリングとスクレイピングの融合:Thunderbitが選ばれる理由

実際、多くの人がウェブサイトをクロールする本当の目的は「構造化データの取得」です。商品リストや連絡先、コンテンツ棚卸しなど、最終的には“使えるデータ”が欲しいはず。そこで登場するのがです。

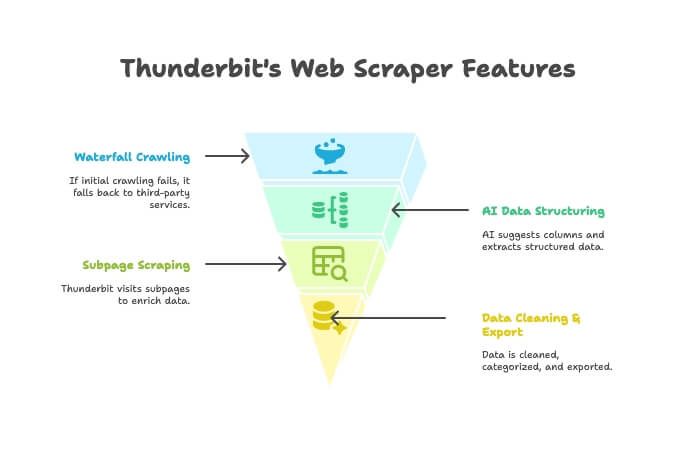

Thunderbitは、クローラーとスクレイパーの両方の機能をAIで統合したChrome拡張機能。主な特徴は:

- AIクローラー: サイト全体を自動巡回

- ウォーターフォールクロール: 独自エンジンで取得できない場合は自動で外部サービスに切り替え、手動設定不要

- AIデータ構造化: HTML取得後、AIが最適なカラムを提案し、名前・価格・メールなどを自動抽出。セレクタ不要

- サブページ自動抽出: 商品詳細ページなども自動巡回し、テーブルを充実化

- データ整形&エクスポート: 要約・分類・翻訳もワンクリックで、ExcelやGoogle Sheets、Airtable、Notionに出力

- ノーコードで簡単操作: ブラウザが使えれば誰でもOK。プロキシや複雑な設定も不要

Thunderbitが従来型クローラーより優れている場面:

- 目的が「URLリスト」ではなく「きれいな表データ」の場合

- クロールから抽出・整形・エクスポートまで一括自動化したい場合

- 時間と手間を大幅に省きたい場合

。多くのビジネスユーザーが乗り換えている理由をぜひ体感してください。

まとめ:2025年、無料ウェブサイトクローラーの活用で業務効率化

ウェブサイトクローラーはどんどん進化しています。マーケター、開発者、サイト管理者など、誰でも無料(または無料体験)で使えるツールが揃っています。BrightDataやDiffbotのようなエンタープライズ向けから、SiteOneやCrawljaxのようなOSS、PowerMapperのようなビジュアル系まで、選択肢は本当に豊富です。

「必要なデータをすぐに表形式で取得したい」なら、Thunderbitをぜひ試してみてください。レポートだけでなく、実務で使えるデータを重視するビジネスユーザーに最適です。

まずは気になるツールをダウンロードしてクロールを体験してみましょう。2クリックで“使えるデータ”まで一気に進みたいなら、!

さらに詳しい解説や実践ガイドはで公開中です。

よくある質問(FAQ)

ウェブサイトクローラーとウェブスクレイパーの違いは?

クローラーはサイト全体のページを発見・マッピングする役割(目次を作るイメージ)。スクレイパーは、そのページから価格やメール、レビューなど特定データだけを抽出します。クローラーは“探す”、スクレイパーは“掘る”イメージです()。

非技術者におすすめの無料ウェブクローラーは?

小規模サイトやSEO診断ならScreaming Frogが使いやすいです。構造をビジュアルで見たいならPowerMapper(体験期間中)。ノーコード&ブラウザ完結で構造化データが欲しいならThunderbitが最も簡単です。

ウェブクローラーをブロックするサイトはある?

はい。robots.txtやCAPTCHA、IP制限などでクローラーを制限するサイトもあります。ScraperAPIやCrawlbase、Thunderbit(ウォーターフォールクロール対応)などは突破できる場合もありますが、必ずルールを守って利用しましょう()。

無料ウェブクローラーにはページ数や機能制限がある?

多くのツールで制限があります。例:Screaming Frog無料版は1回500URL、PowerMapper体験版は100ページなど。API型は月間クレジット制限が多いです。SiteOneやCrawljaxなどOSSは基本無制限ですが、PCスペックに依存します。

ウェブクローラーの利用は合法?プライバシー的に問題ない?

一般的に公開ウェブページのクロールは合法ですが、必ず各サイトの利用規約やrobots.txtを確認しましょう。非公開・パスワード保護ページのクロールや、個人情報の抽出は許可が必要です。プライバシー法にも注意してください()。