ネットの情報量はとんでもない勢いで増え続けていて、2025年にはものデジタルデータが存在する見込みです。これ、スプレッドシートが固まるレベルの膨大さ。しかも今や、その膨大なデータの多くは人間じゃなくてAI搭載の웹 스크래퍼が集めているんです。実際、2024年末にはしたというデータも出ています。

営業やマーケ、オペレーションなどで日々ネットから情報を集めている人なら、手作業のデータ収集がどれだけ面倒でミスが多いか、身にしみてるはず。だからこそ、無料で使えるAI 웹 스크래퍼は、誰でもネットのごちゃごちゃした情報を一瞬で整理されたデータに変えてくれる“裏ワザ”みたいな存在です。しかもプログラミング知識は一切不要。

自分もSaaSや自動化の現場で長く働いてきましたが、AI搭載の웹 스크래퍼を導入してから、チームの作業時間が劇的に短縮されて、手作業じゃ絶対に見つけられない気づきも得られるようになりました。この記事では、2026年版・無料で使えるAI 웹 스크래퍼12選をビジネス目線で徹底比較。各ツールの特徴や強み、選び方のコツまでしっかり解説します。

なぜ無料のAI 웹 스크래퍼がビジネスユーザーに必須なのか

正直、「インターンにリストをコピペさせればいい」なんて時代はもう終わり。今のビジネスチームにはスピードと自動化が求められています。無料のAI 웹 스크래퍼を使えば、エンジニアじゃなくてもこんなことが簡単にできます:

- リード獲得:ディレクトリやLinkedIn、専門サイトから数分でリスト化。

- 競合調査:価格や新商品、レビュー情報を自動で収集。

- 業務自動化:CRMの更新、在庫管理、市場調査などのルーチン作業を効率化。

その効果は本当に大きいです。最新の業界レポートによると、AI 스크래퍼は従来のやり方よりデータを集められて、コストや初期設定の手間も大幅カット。実際に導入したチームからは、作業時間の大幅短縮やヒューマンエラー激減の声が続々届いています()。

無料AI 웹 스크래퍼の選び方ポイント

すべての스크래퍼が同じじゃありません。今回の12選を選ぶにあたって、こんなポイントを重視しました:

- 使いやすさ:ノーコードやローコードで直感的に操作できるか。

- AI機能:AIによる自動フィールド検出やカラム提案、サイト構造の変化への強さ。

- 無料プランの範囲:無料でどこまで使えるか(ページ数、エクスポート形式、主要機能の利用可否)。

- 機能の充実度:ページネーション、サブページ対応、画像・メール・電話番号抽出、テンプレートの有無。

- 拡張性・連携性:ExcelやGoogle Sheets、NotionへのエクスポートやAPI連携ができるか、大量データ処理に強いか。

- 用途別の最適性:初心者向け、開発者向け、大規模案件向けなど、どんなシーンに強いか。

記事の最後には、ニーズに合ったツールを選びやすい比較表も用意しています。

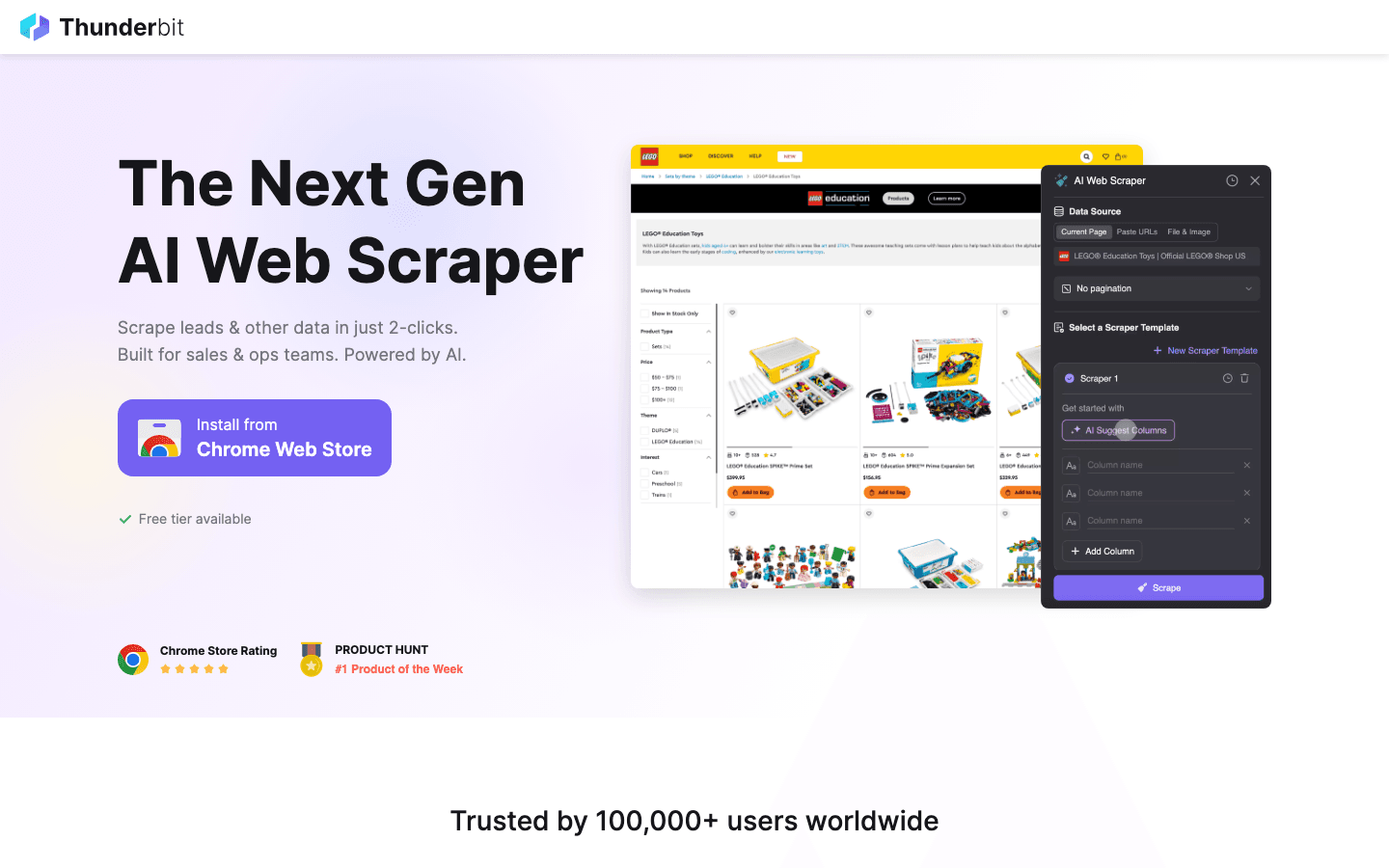

1. Thunderbit

は、ビジネスユーザー向けの完全無料AI 웹 스크래퍼として一番おすすめ。Chrome拡張機能なので、営業・オペ・EC・不動産など、エンジニアじゃなくても2クリックでどんなウェブサイトからでもデータを抽出できます。

は、ビジネスユーザー向けの完全無料AI 웹 스크래퍼として一番おすすめ。Chrome拡張機能なので、営業・オペ・EC・不動産など、エンジニアじゃなくても2クリックでどんなウェブサイトからでもデータを抽出できます。

Thunderbitの強みは?

- AIによるフィールド提案:「AIフィールド提案」を押すだけで、ThunderbitのAIがページを解析して最適なカラム(氏名、メール、価格など)を自動で提案。各フィールドごとに抽出プロンプトも自動生成。

- サブページ・ページネーション対応:詳細ページへの遷移や無限スクロールもAIが自動で追跡し、すべてのデータを1つのテーブルにまとめます。

- 即時テンプレート:Amazon、Zillow、Instagram、Shopifyなど人気サイト用のテンプレートが豊富。1クリックでスクレイピング可能。

- 無料データエクスポート:Excel、Google Sheets、Airtable、Notionへ無料でエクスポート。CSVやJSON形式のダウンロードもOK。

- 画像・メール・電話番号抽出:どんなサイトからでもワンクリックで画像や連絡先を抽出。

- ノーコード・メンテナンス不要:コーディングやテンプレート作成、保守作業は一切不要。AIがサイトの変化にも自動対応。

無料プラン:月6ページまで(無料トライアルで10ページまで拡張可)、すべての機能が利用可能。もっと使いたい場合は月額15ドルからの有料プランも。

ユーザー評価:Thunderbitは「シンプルで正確」と高評価。特に他の스크래퍼が苦手な複雑なサイトやニッチなリスト作成、商品モニタリング、市場調査で重宝されています()。

実際に使ってみたい人は、して、1分以内にスクレイピングを体験してみてください。

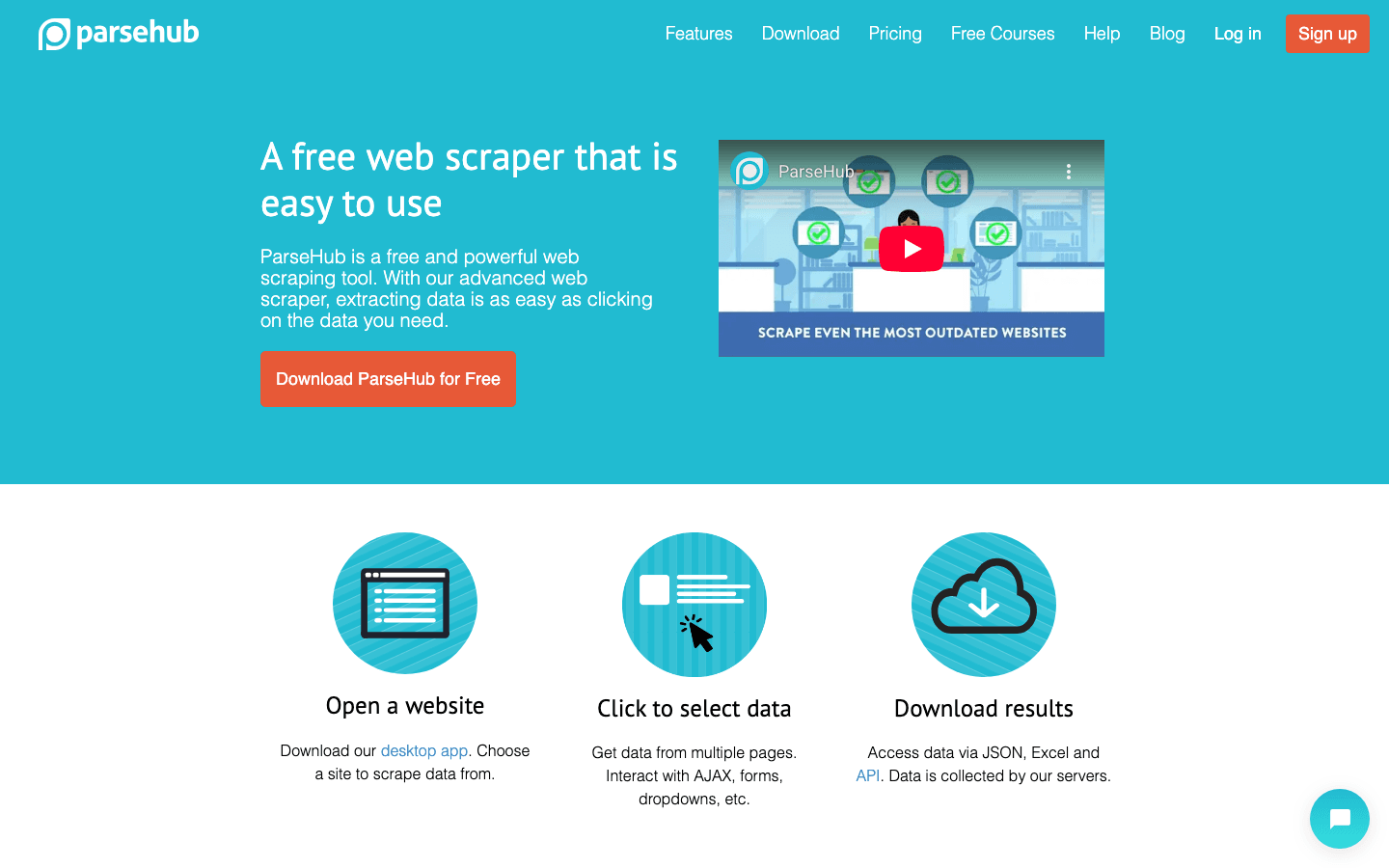

2. ParseHub

は、初心者や小規模チーム向けのビジュアル型ノーコード웹 스크래퍼。機械学習で要素をグループ化し、AJAXやフォーム、画像を含む複雑なサイトにも対応。

は、初心者や小規模チーム向けのビジュアル型ノーコード웹 스크래퍼。機械学習で要素をグループ化し、AJAXやフォーム、画像を含む複雑なサイトにも対応。

- 直感的な操作:抽出したい要素をクリックするだけで、ParseHubが自動で認識。

- 画像認識・API連携:画像や動的コンテンツの抽出、API経由でのデータ取得も可能。

- クラウド・デスクトップ両対応:クラウドでもローカルでも実行OK。

- 無料プラン:1回の実行で200ページ、5プロジェクトまで。CSVやJSONでエクスポート。

おすすめ用途:商品リストやニュース記事など、小規模でビジュアル重視の案件にぴったり。操作は簡単ですが、大規模利用には有料プランが必要です()。

3. Octoparse

は、ノーコードで使えるデスクトップ/クラウド型스크래퍼。豊富なテンプレートと強力なAI機能が魅力。

は、ノーコードで使えるデスクトップ/クラウド型스크래퍼。豊富なテンプレートと強力なAI機能が魅力。

- AI自動検出:JavaScriptやCAPTCHA対応サイトでも、AIがワークフローを自動作成。

- バッチ処理:数千件のデータを一括抽出、スケジューリングやログイン対応も。

- 無料プラン:月1万件まで、主要機能が利用可能。

- エクスポート:CSV、Excel、Google Sheets、API連携。

おすすめ用途:動的サイトや定期的な大規模スクレイピングに最適。やや学習コストはありますが、ドキュメントが充実しています()。

4. Scrapy

は、世界中で使われているPython製のオープンソース웹 스크래핑フレームワーク。コーディングが必要ですが、カスタマイズ性と拡張性は抜群。

は、世界中で使われているPython製のオープンソース웹 스크래핑フレームワーク。コーディングが必要ですが、カスタマイズ性と拡張性は抜群。

- 柔軟な設計:独自のスパイダーを作成し、どんなサイト構造にも対応。

- 利用制限なし:オープンソースなので、ハードウェアの許す限り無制限に利用可能。

- 拡張性:豊富なプラグインとコミュニティサポート。

おすすめ用途:開発者や技術チーム向け。大規模・カスタム案件に最適。非エンジニアにはやや難易度高め()。

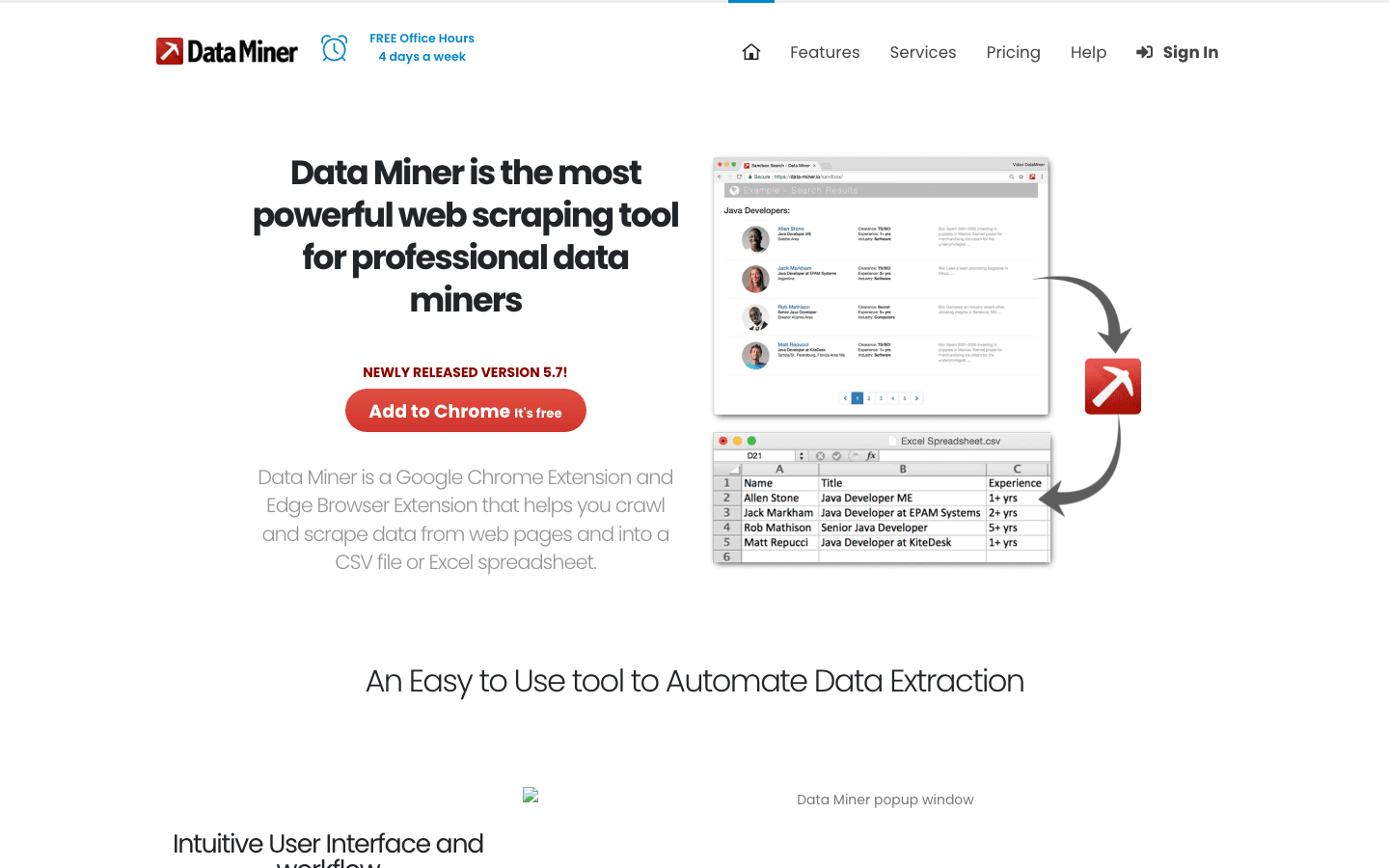

5. Data Miner

は、Chrome/Edge拡張機能で、5万件以上のレシピ(テンプレート)を使って15,000以上の人気サイトからテーブルやリスト、連絡先情報を抽出できます。

は、Chrome/Edge拡張機能で、5万件以上のレシピ(テンプレート)を使って15,000以上の人気サイトからテーブルやリスト、連絡先情報を抽出できます。

- ワンクリック抽出:レシピを選んでクリックするだけ。

- ページネーション・自動入力:複数ページやフォーム入力にも対応。

- 無料プラン:月500ページまで。CSV、Excel、Google Sheetsにエクスポート。

おすすめ用途:リードリストや商品カタログなど、表形式データの素早い抽出に最適()。

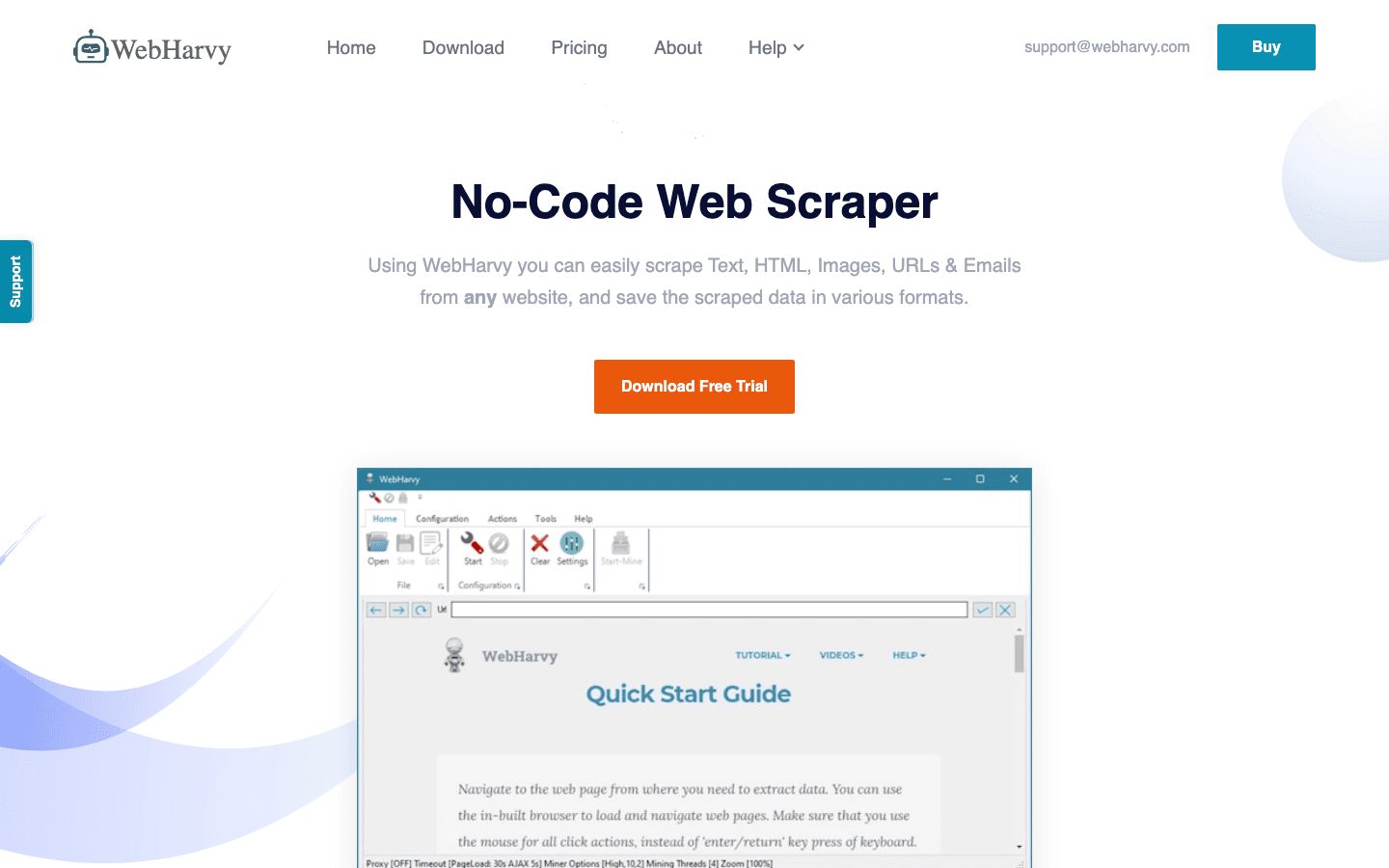

6. WebHarvy

は、Windows用のデスクトップ型스크래퍼。ビジュアル操作とパターン認識が特徴。

は、Windows用のデスクトップ型스크래퍼。ビジュアル操作とパターン認識が特徴。

- パターン認識:1つの商品をクリックするだけで、類似アイテムを自動選択。

- 画像抽出:画像やメール、URLも簡単にダウンロード。

- 無料トライアル:無料プランはありませんが、トライアル利用可。継続利用にはライセンス購入が必要。

おすすめ用途:ECサイトや大量の画像・商品データ抽出に最適()。

7. Dexi.io

は、クラウド型の高度な웹 스크래핑&ワークフロー自動化プラットフォーム。

は、クラウド型の高度な웹 스크래핑&ワークフロー自動化プラットフォーム。

- ビジュアルワークフロービルダー:ドラッグ&ドロップで複雑なパイプラインを設計。

- API連携:データウェアハウスやCRM、分析基盤と連携可能。

- 無料トライアル:期間限定の無料トライアルあり。有料プランは月119ドルから。

おすすめ用途:エンタープライズや複雑な定期データ収集が必要な業務向け()。

8. Apify

は、開発者向けのクラウドプラットフォーム。6,000以上の「アクター」(스크래핑スクリプト)がマーケットプレイスで利用でき、API連携も充実。

は、開発者向けのクラウドプラットフォーム。6,000以上の「アクター」(스크래핑スクリプト)がマーケットプレイスで利用でき、API連携も充実。

- マーケットプレイス&カスタマイズ:既存アクターの利用や、JavaScript/Pythonで独自開発も可能。

- クラウド実行&スケジューリング:クラウド上で定期実行、AIワークフローとの連携も。

- 無料枠:月30コンピュートユニットまで。

おすすめ用途:カスタム自動化や大規模パイプライン構築を目指す技術チーム向け()。

9. Import.io

は、エンタープライズ向けのAI強化型データ抽出プラットフォーム。構造化データとコンプライアンス重視。

は、エンタープライズ向けのAI強化型データ抽出プラットフォーム。構造化データとコンプライアンス重視。

- AIセレクター:サイト構造の変化にも自動対応。

- データ変換:抽出データのクレンジングや加工も可能。

- 無料トライアル:14日間の無料トライアル後、有料プランは月249ドルから。

おすすめ用途:大規模かつ法令遵守が求められるBIや分析用途に最適()。

10. Diffbot

は、NLPとコンピュータビジョンを活用し、どんなウェブページからでも構造化データを自動抽出できるAIプラットフォーム。

は、NLPとコンピュータビジョンを活用し、どんなウェブページからでも構造化データを自動抽出できるAIプラットフォーム。

- ナレッジグラフ:人物、商品、記事などを自動で識別。

- API連携:ニュースフィードや分析、リサーチ用にAPIでデータ取得。

- 無料プラン:月10,000クレジットまでExtract/NLP/Knowledge Graph APIが利用可能。

おすすめ用途:高品質な構造化データ(ニュース、商品、ディスカッション等)が必要なチーム向け()。

11. VisualScraper

は、初心者向けのシンプルなポイント&クリック型웹 스크래핑サービス。

は、初心者向けのシンプルなポイント&クリック型웹 스크래핑サービス。

- コーディング不要:抽出したいフィールドを選ぶだけ。

- 複数ページ対応:リアルタイムで複数ページを抽出。

- 無料プラン:基本機能は無制限で利用可能。CSV、JSON、XML、SQL形式でエクスポート。

おすすめ用途:ニュースやフォーラム、小規模ディレクトリなどの一時的なデータ収集に最適()。

12. Portia by Scrapinghub

は、ブラウザ上でページに注釈をつけてスパイダーを訓練できるオープンソースのビジュアル型웹 스크래퍼。

は、ブラウザ上でページに注釈をつけてスパイダーを訓練できるオープンソースのビジュアル型웹 스크래퍼。

- ドラッグ&ドロップ操作:要素をクリックするだけで抽出ルールを自動推論。

- オープンソース:無料で利用可能(2018年以降公式サポートなし)。

- Scrapy連携:Scrapyパイプライン経由でデータ出力。

おすすめ用途:技術に明るいチーム向けの無料ビジュアル스크래퍼()。

無料AI 웹 스크래퍼徹底比較表

| ツール名 | 使いやすさ | AI/スマート機能 | 無料プランの範囲 | エクスポート形式 | おすすめ用途 |

|---|---|---|---|---|---|

| Thunderbit | ★★★★★(2クリック) | AIフィールド提案、サブページ/ページネーション | 月6ページ(トライアル10ページ) | Excel、Sheets、Airtable、Notion、CSV | 非エンジニア、素早いウェブデータ抽出 |

| ParseHub | ★★★★☆(ビジュアルUI) | ML要素グループ化、API | 1回200ページ、5プロジェクト | CSV、JSON、API | 小規模案件、AJAX/JSサイト |

| Octoparse | ★★★★☆(ビジュアルUI) | AI自動検出、JS/CAPTCHA対応 | 月1万件 | CSV、Excel、Sheets、API | 動的サイト、スケジューリング、クラウド実行 |

| Scrapy | ★★☆☆☆(コーディング要) | 拡張性、オープンソース | 無制限(オープンソース) | 任意(プログラム経由) | 開発者、大規模・カスタムスクレイピング |

| Data Miner | ★★★★☆(拡張機能) | 5万+レシピ、セレクタ検出 | 月500ページ | CSV、Excel、Sheets | 表形式/リスト/連絡先データの素早い抽出 |

| WebHarvy | ★★★★☆(ビジュアルUI) | パターン認識、画像抽出 | 無料トライアル(ライセンス要) | CSV、SQL、Excel | EC、商品画像抽出 |

| Dexi.io | ★★★☆☆(クラウド) | ワークフロー自動化、API | 無料トライアル | JSON、CSV、各種連携 | エンタープライズ、複雑なワークフロー |

| Apify | ★★★☆☆(開発者向け) | アクターマーケット、API | 月30コンピュートユニット | JSON、API、Webhook | カスタム自動化、開発チーム |

| Import.io | ★★★☆☆(エンタープライズ) | AIセレクター、コンプライアンス機能 | 14日間トライアル | CSV、Excel、データベース | 大規模・法令遵守データ |

| Diffbot | ★★★☆☆(API/UI) | NLP、ビジョン、ナレッジグラフ | 月10,000クレジット | JSON、API | 高品質なエンティティ/ニュース/商品データ |

| VisualScraper | ★★★☆☆(Web UI) | ポイント&クリック選択 | 基本機能は無制限 | CSV、JSON、XML、SQL | シンプル、定期・複数ページ抽出 |

| Portia | ★★★☆☆(ブラウザUI) | ビジュアルScrapyラッパー | 無制限(オープンソース) | JSON、XML(Scrapy経由) | 技術者向けの無料ビジュアルスクレイピング |

自分に合った無料AI 웹 스크래퍼の選び方

選び方のコツをまとめました:

- 初心者・ノーコード派:Thunderbit、ParseHub、Data Miner、VisualScraperが最速で結果を出せます。

- 複雑・動的サイト対応:Octoparse、Dexi.io、ParseHubはJavaScriptや複雑なレイアウトもOK。

- 大規模・カスタム案件:Scrapy、Apify、Import.ioは開発者やエンタープライズ向け。

- 画像・商品データ抽出:WebHarvyとThunderbitは画像や構造化商品情報に強み。

- 構造化知識・エンティティ抽出:Diffbotは高品質なAIデータが必要な場合に最適。

- オープンソース・コミュニティ重視:ScrapyとPortiaは技術に自信があれば無料で使い続けられます。

ワンポイントアドバイス:大規模案件の前には必ず無料プランの制限やエクスポート形式を確認しましょう。「無料」だからといって、必ずしも自分の業務に最適とは限りません。用途(リード獲得、競合調査、リサーチ等)に合ったツールを選びましょう。

まとめ:無料AI 웹 스크래퍼でビジネス価値を最大化

AI搭載の웹 스크래핑は、もはや開発者やデータサイエンティストだけのものじゃありません。正しい無料ツールを使えば、誰でもデータ収集を自動化して、業務効率を一気にアップできます。リードリスト作成、価格調査、コピペ作業からの解放など、あなたの課題に合ったツールがきっと見つかります。

特に、複雑でニッチなサイトにも強いThunderbitは、AIによるフィールド提案やサブページ抽出、主要アプリへの即時エクスポートが魅力。まずは気軽にいくつかのツールを試して、自分に合ったものを見つけてみてください。

もう手作業のデータ入力にサヨナラしませんか?無料のAI 웹 스크래퍼をダウンロードして、あなたの生産性とデータ品質を一気に高めましょう。

さらに詳しいノウハウやチュートリアルはでチェックできます。

よくある質問

1. AI搭載웹 스크래퍼って何?従来型とどう違うの?

AI搭載웹 스크래퍼は、人工知能を使ってウェブサイトからデータを自動検出・抽出・構造化してくれるツール。従来の스크래퍼が固定テンプレや手動設定に頼るのに対し、AIスクレイパーはサイト構造の変化や非構造データにも柔軟に対応できるのが強みです。

2. ビジネス利用でも本当に無料のAI 웹 스크래퍼はある?

もちろん!やParseHub、Octoparse、Data Minerなどは無料プランでも多機能。ページ数やエクスポート形式など、各ツールの制限は事前にチェックしましょう。

3. 非エンジニア向けでおすすめの無料AI 웹 스크래퍼は?

Thunderbit、ParseHub、Data Miner、VisualScraperはノーコード設計。特にThunderbitは2クリックでAIフィールド提案ができて、営業・オペ・マーケチームにもぴったりです。

4. 画像やメール、電話番号も抽出できる?

はい!Thunderbit、WebHarvy、Data Minerは画像・メール・電話番号の抽出に対応。取得した連絡先データは、必ず法令やプライバシー規定を守って使いましょう。

5. ノーコードとコーディング型、どっちを選ぶべき?

スピードと手軽さ重視ならThunderbitやParseHubなどノーコード型を。カスタマイズ性や大規模自動化、他システム連携が必要ならScrapyやApifyなどコーディング型を選びましょう。

快適な스크래핑ライフを!データがいつもきれいで構造化され、すぐに活用できることを願っています。

さらに詳しく知りたい方へ