ウェブ上の情報量は、どんなに優秀なビジネスアナリストでも追いつけないほど爆発的に増え続けています。2026年にはと予想されていて、企業同士が新鮮で価値あるデータを求めてしのぎを削っています。でも、昔ながらのスクレイピングは手間が多いし、スクリプトはすぐ壊れるし、アンチボット対策もどんどん進化。プログラミングが苦手だと、結局は手作業でコピペ…なんてことも。そんな悩みを一気に解決してくれるのがAIウェブスクレイピングツール。データ収集のハードルをグッと下げて、営業やオペレーション、データ活用したい人みんなの“生産性ブースター”になっています。

SaaSや自動化の現場で長年やってきた自分も、AI搭載のウェブスクレイパーが現場をガラッと変えているのを肌で感じています。リードリスト作成や競合調査、スプレッドシートの最新化など、正しいツールを使えば何時間もかかる作業が一瞬で終わることも。ここでは、ノーコードで使えるものから開発者向けまで、2026年注目のAIウェブスクレイピングツール10選を厳選して紹介します。

なぜAIウェブスクレイピングツールが今のビジネスに欠かせないのか

ウェブデータは“新しい石油”なんて言われますが、昔は抽出作業に専門知識や膨大な手間が必要でした。でも今はもうそんな時代じゃありません。手作業でスクリプトを書いたり、メンテナンスやアンチボット対策に悩まされるのは過去の話。ツールの登場で、エンジニアじゃなくても簡単にデータを集めて、構造化して、エクスポートできるようになりました。

主な進化ポイントはこんな感じです:

- 壊れやすいスクリプトからの解放: AIがウェブサイトの変化に自動で対応してくれるので、コード修正の手間が激減(参照)。

- ノーコード・ローコード対応: IT部門に頼らなくても、営業やマーケ担当が自分でデータ収集できる。

- 賢い抽出: AIがパターンを見抜いて、抜けてる項目の補完や要約・分類も自動でやってくれる。

- スケーラビリティ: 単発の抽出から定期的な大量データ収集まで柔軟に対応。

その結果、AI搭載スクレイパーを導入した企業はできて、重要プロジェクトの納期も大幅に短縮しています。

主な活用例:

- リード獲得: ディレクトリやLinkedIn、イベントサイトからターゲットリストを自動生成。

- 市場調査: 競合の価格やレビュー、トレンドをモニタリング。

- 業務効率化: データ入力や在庫管理、コンプライアンスチェックの自動化。

AIウェブスクレイピングツールの選び方

ツールが多すぎて、どれを選べばいいか迷うのはまるでテック系イベントのスピードデートみたい。今回の10選は、以下のポイントで厳選しました:

- 使いやすさ: 非エンジニアでもすぐ使える?学習コストは?

- AIの適応力: サイト構造の変化や動的コンテンツ、非構造データに強い?

- 自動化機能: スケジューリングやクラウド実行、ワークフロー連携ができる?

- 価格: 無料プランやビジネス向けの分かりやすい料金体系がある?

- サポート・コミュニティ: ドキュメントやユーザー層、サポート体制は?

- 用途適合性: ビジネスユーザー向け?開発者向け?大規模運用向け?

ノーコード、コードベース、ブラウザ拡張、クラウド型など幅広くカバーしているので、個人起業家から大企業のデータチームまでピッタリの選択肢が見つかります。

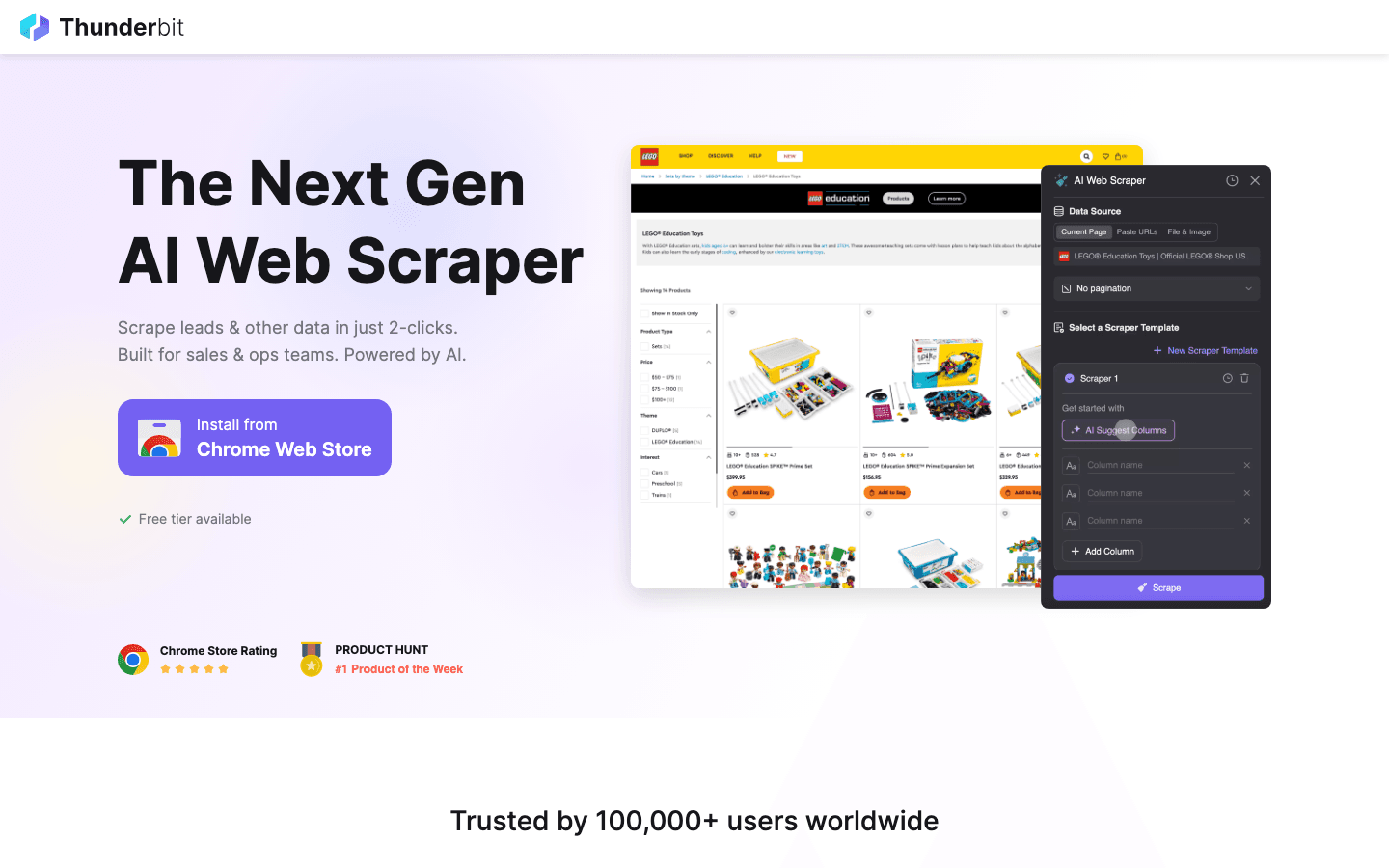

1. Thunderbit

は、ノーコードでAIウェブスクレイピングを実現したいビジネスユーザーにピッタリのツール。自分が共同創業者なのでちょっと贔屓目ですが、「コードやテンプレート、面倒な設定は一切不要」というコンセプトで作りました。やりたいことを日本語や英語で入力して「AIフィールド提案」をクリックするだけで、AIが自動でデータを抽出してくれます。

主な特徴:

- 2クリックで抽出完了: 自然言語プロンプト+AIフィールド提案ですぐ結果が出る。

- サブページ・ページネーション対応: 詳細ページやレビュー、リストも設定不要で抽出。

- 即時テンプレート: Amazon、Zillow、Shopifyなど主要サイト用のワンクリックテンプレート。

- 無料データエクスポート: Excel、Google Sheets、Notion、Airtableに出力OK。

- AIオートフィル: データ抽出だけじゃなく、フォーム入力や業務自動化もできる。

- 段階的な学習曲線: シンプルに始めて、必要に応じて高度な機能も使える。

Thunderbitが選ばれる理由:

非エンジニアでも、複雑・動的・ログイン必須のサイトから構造化データを簡単に抽出できます。営業やオペレーション部門のリード獲得、価格調査、不動産データ収集などで高評価。無料枠も充実(6ページまで、トライアルで10ページまで拡大)、有料プランも月額1,500円程度からと手軽です。

実際の動作を見たい人はするか、でチュートリアルをチェックしてみてください。

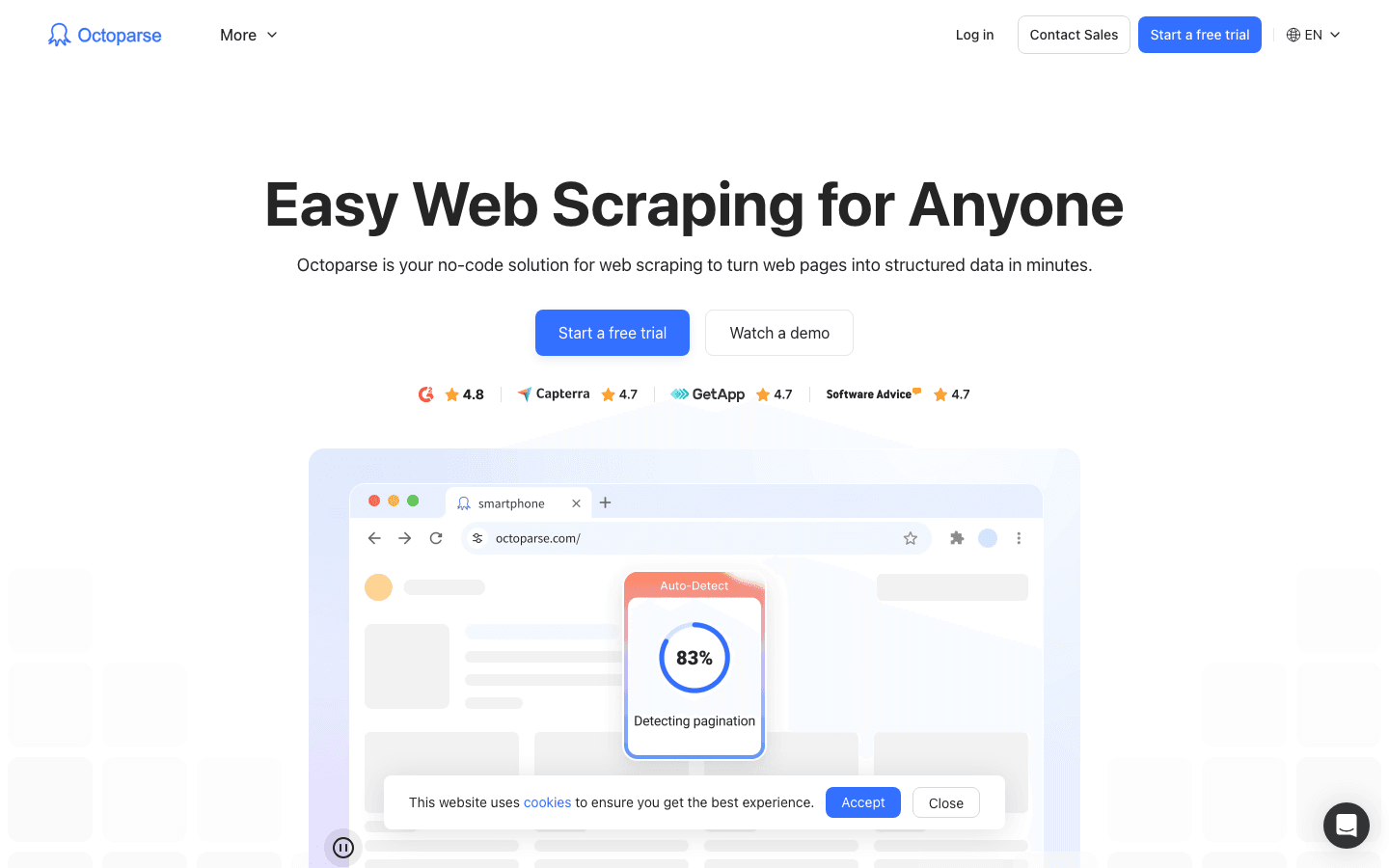

2. Octoparse

は、直感的なUIと豊富なテンプレートライブラリが魅力のノーコードAIウェブスクレイパー。柔軟性と使いやすさを両立したいビジネスユーザーにおすすめ。

主な特徴:

- ビジュアルワークフロー: ポイント&クリックで抽出対象を指定。

- AIフィールド自動検出: 多くのサイトでデータ項目を自動認識。

- テンプレートライブラリ: 6万件以上の人気サイト用テンプレート。

- クラウド&ローカル実行: デスクトップでもクラウドでも利用可能。

- スケジューリング・自動化: 定期的なデータ更新も簡単設定。

価格:

小規模用途は無料(10タスク・月5万行まで)。本格利用は月額75ドルから。

おすすめユーザー:

テンプレートを活用して、いろんなサイトを定期的に抽出したいチーム向け。

3. Scrapy

は、開発者向けのオープンソースPythonフレームワーク。カスタマイズ性・拡張性が高く、機械学習やAIモジュールとの連携も簡単です。

主な特徴:

- フルコード制御: 任意のサイトやワークフローに合わせてカスタムスパイダーを構築。

- 大規模パイプライン: 数百万ページの処理やDB・ML連携も可能。

- 活発なコミュニティ: プラグインやドキュメントが豊富。

- AI連携: NLPや画像認識と組み合わせて高度なデータ構造化も。

価格:

完全無料・オープンソース。必要なのは自分の時間とインフラだけ。

おすすめユーザー:

技術者・データエンジニア・大規模カスタムプロジェクト担当者。

4. ParseHub

は、複雑なJavaScriptサイトもノーコードで抽出できるビジュアル型スクレイパー。ロジック設定も柔軟です。

主な特徴:

- ポイント&クリック設定: 動的ページも直感的に要素選択。

- AI認識: 複雑なレイアウトや入れ子データも対応。

- クラウド抽出&スケジューリング: 定期実行やExcel/JSON出力も簡単。

- API連携: 独自ワークフローとの統合も可能。

価格:

基本利用は無料。高機能・大容量は月額149ドルから。

おすすめユーザー:

複雑なサイトをビジュアル&ロジックで抽出したいビジネスユーザー。

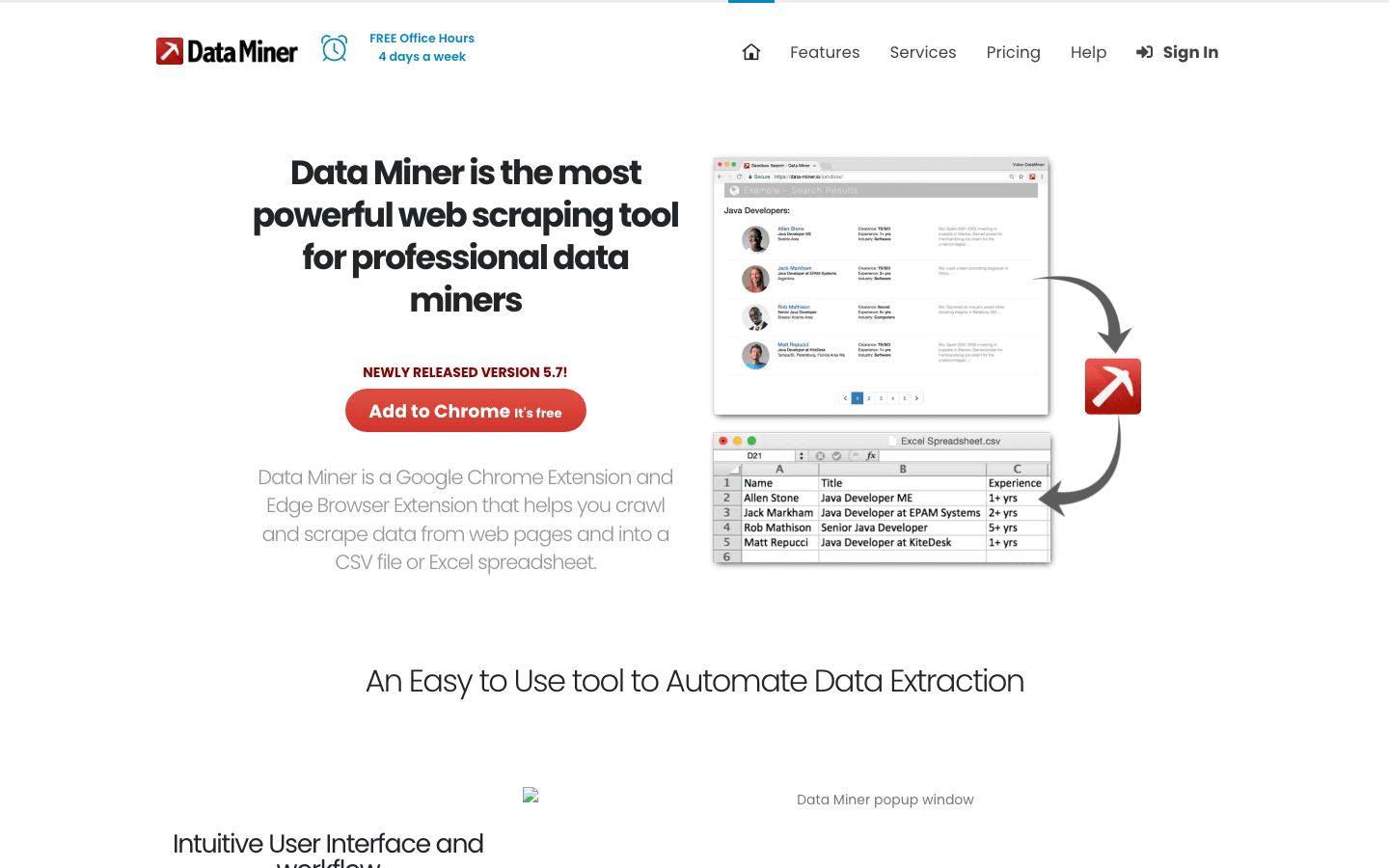

5. DataMiner

は、Chrome/Edge拡張機能型のテンプレート駆動型スクレイパー。小規模なリスト抽出や即時データ取得に最適です。

主な特徴:

- ブラウザ完結: 拡張機能を追加するだけですぐ使える。

- 6万件以上の公開テンプレート: Google検索やLinkedIn、各種ディレクトリ対応。

- ワンクリックエクスポート: CSV、Excel、Google Sheetsに即出力。

- カスタムレシピ: 定期作業用の独自テンプレート作成も。

価格:

月500ページまで無料。上位プランは月額19ドルから。

おすすめユーザー:

営業・リサーチ・ブラウザ上でサクッとデータ取得したい人。

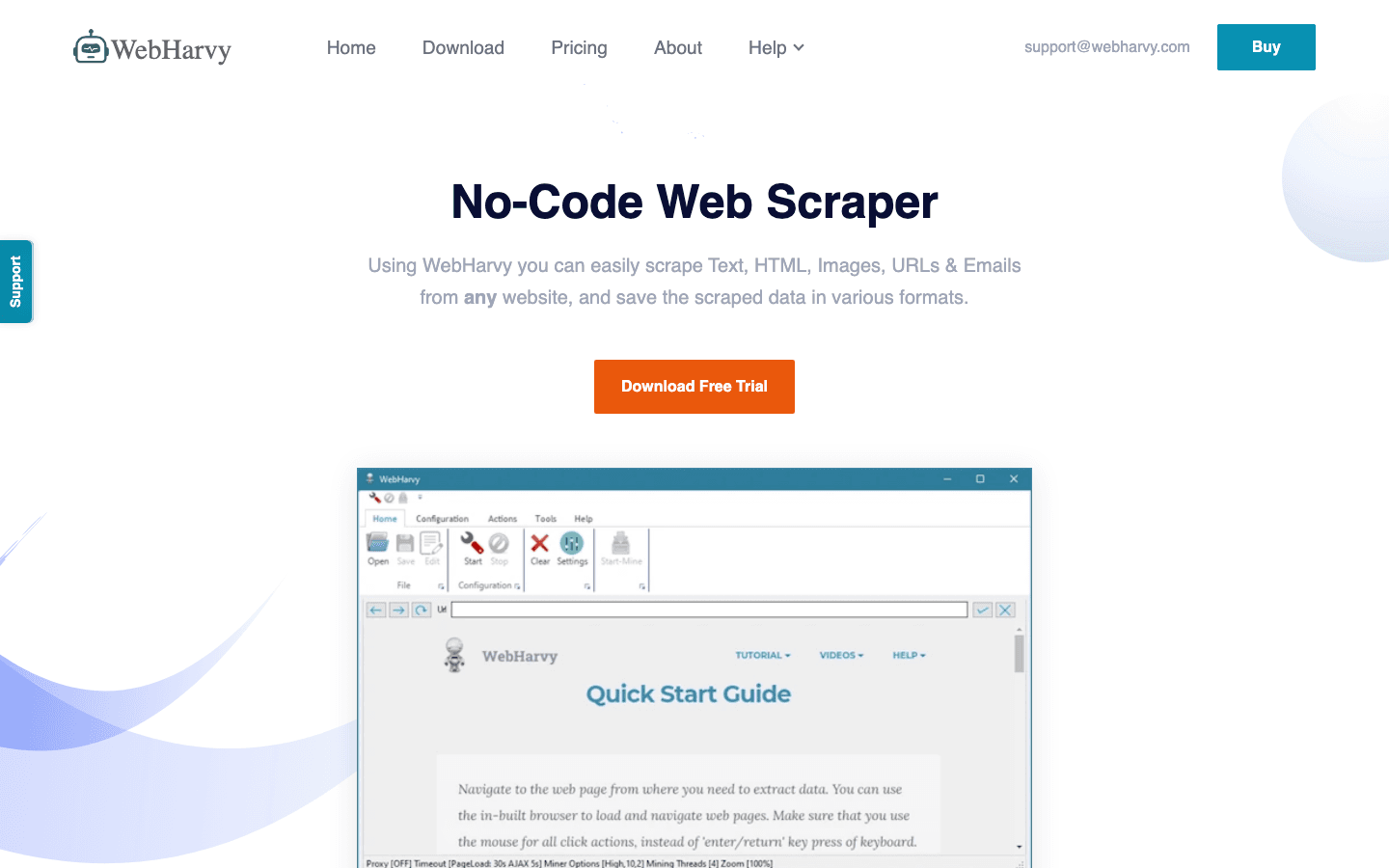

6. WebHarvy

は、Windows用デスクトップアプリ。ポイント&クリック操作と自動パターン認識で、画像や複合データの抽出に強いのが特徴です。

主な特徴:

- ビジュアル選択: テキスト・画像・リンクをクリックで抽出。

- パターン認識: 繰り返しデータも自動検出で一括抽出。

- ページネーション対応: 複数ページのリストも簡単処理。

- 多彩な出力形式: Excel、CSV、XML、DB直送も可能。

価格:

買い切りライセンス(約139ドル)、1年間のアップデート・サポート付き。

おすすめユーザー:

非エンジニアで画像や複雑なサイトをデスクトップで抽出したい人。

7. Import.io

は、エンタープライズ向けのクラウド型AIウェブスクレイピングプラットフォーム。大規模・自動化・コンプライアンス重視の現場に最適です。

主な特徴:

- クラウド自動化: 定期実行や大容量ジョブもスケジューリング可能。

- AI抽出: ログイン・CAPTCHA・動的コンテンツも対応。

- ワークフロー連携: BIツールやCRMなどと接続。

- データクレンジング: 重複排除やバリデーション機能も内蔵。

価格:

個別見積(通常月額299ドル〜)。無料プランなし。

おすすめユーザー:

大規模運用・管理・コンプライアンス重視の企業やデータチーム。

8. Content Grabber

は、エンタープライズ向けのデスクトップ/ウェブスクレイパー。高度な自動化・統合・レポーティング機能を備えています。

主な特徴:

- 自動化: 複数エージェントのスケジューリング・監視・管理。

- 統合性: DBやAPI、独自ワークフローへの出力も柔軟。

- エラーハンドリング: ログ・リカバリー機能で重要業務も安心。

- カスタムスクリプト: C#や.NETで高度な拡張も可能。

価格:

無料プランなし。買い切りライセンスは約2,995ドル〜。

おすすめユーザー:

大規模運用・代理店・本格的なレポーティングが必要な組織。

9. BeautifulSoup

は、HTMLやXMLのパースに特化した軽量Pythonライブラリ。AIと組み合わせてカスタム抽出したい開発者に人気です。

主な特徴:

- 柔軟なパース: 複雑なHTMLからもデータを抽出・整形。

- AI連携: NLPやMLモデルと組み合わせて賢く抽出。

- オープンソース: 無料&巨大な開発者コミュニティ。

価格:

完全無料・オープンソース。

おすすめユーザー:

Pythonで細かく制御したい開発者・カスタムパース担当者。

10. Apify

は、数千種類の「アクター」(事前構築済みスクレイパー)とAI SDKを備えたクラウドプラットフォーム。大規模自動化やインフラ管理不要の現場に最適です。

主な特徴:

- アクターマーケット: 1万件以上の即利用可能なスクレイパー。

- AI SDK: カスタムAIワークフローの構築・デプロイ・スケジューリング。

- クラウドスケーリング: 並列実行や大容量データ処理も簡単。

- 統合性: SheetsやDB、API連携も柔軟。

価格:

無料枠あり(回数制限)、有料プランは月額39ドルから。

おすすめユーザー:

大規模自動化やカスタムAIワークフローをサーバーレスで運用したいチーム。

AIウェブスクレイピングツール比較表

用途やスキルに合わせて最適なツールを選ぶための早見表です:

| ツール | ユーザー体験 | 技術スキル | 自動化 | 価格 | おすすめ用途 |

|---|---|---|---|---|---|

| Thunderbit | ノーコード・2クリック・AI | 不要 | あり | 無料/15ドル〜月 | 非技術者・営業・業務担当 |

| Octoparse | ビジュアル・テンプレート | 低 | あり | 無料/75ドル〜月 | ビジネス・定期抽出 |

| Scrapy | コードベース・柔軟 | 高 | あり | 無料 | 開発者・カスタムプロジェクト |

| ParseHub | ビジュアル・ロジック型 | 低 | あり | 無料/149ドル〜月 | 複雑・動的サイト |

| DataMiner | ブラウザ拡張 | 不要 | 限定的 | 無料/19ドル〜月 | 小規模・即時抽出 |

| WebHarvy | デスクトップ・クリック | 不要 | あり | 139ドル(買い切り) | 画像・非技術者 |

| Import.io | クラウド・エンタープライズ | 低〜中 | あり | 299ドル〜月 | 大規模・エンタープライズ |

| Content Grabber | デスクトップ・業務用 | 中〜高 | あり | 2,995ドル〜(ライセンス) | 運用・大規模レポート |

| BeautifulSoup | Pythonライブラリ | 高 | なし | 無料 | 開発者・カスタムパース |

| Apify | クラウド・アクター・SDK | 低〜中 | あり | 無料/39ドル〜月 | 大規模・自動化運用 |

自社に最適なAIウェブスクレイピングツールの選び方

最適なツール選びは、チームのスキル・データ量・予算で決まります。簡単な選び方のポイント:

- 非技術者: やOctoparse—設定簡単・ノーコード・即結果。

- 開発者: ScrapyやBeautifulSoup—フルカスタム・オープンソース。

- 複雑/動的サイト: ParseHubやWebHarvy—ビジュアルロジックで柔軟対応。

- 小規模・即時作業: DataMiner—ブラウザ完結・即エクスポート。

- 大規模/エンタープライズ: Import.io、Content Grabber、Apify—自動化・スケジューリング・統合性重視。

検討ポイント:

- 抽出頻度は?(単発 or 定期)

- データ量は?(小規模リスト or 数百万行)

- ワークフロー連携は必要?(Sheets・CRM・API出力など)

- 予算は?(無料・従量課金・エンタープライズ)

迷ったらまず無料トライアルから始めてみましょう。実際に使い続けられるツールが“最良の選択”です。

まとめ:AIウェブスクレイピングでデータ戦略をアップデート

ウェブデータの価値はこれからもっと高まるし、抽出の難易度もどんどん上がっていきます。AIウェブスクレイピングツールがあれば、ビジネスユーザーも開発者も、手間なく高品質なデータを活用できる時代がやってきました。リードリスト作成、市場動向の把握、CRMの最新化など、最適なツールを使えば時間もコストも大幅に節約できます。

AIウェブスクレイピングの実力を体感したい人は、や、他のおすすめツールをぜひ試してみてください。さらに詳しい解説や活用ノウハウはでも発信中です。

快適なスクレイピングライフを!データがいつもクリーンで構造化されて、すぐに活用できることを願っています。

よくある質問(FAQ)

1. AIウェブスクレイピングとは?従来型との違いは?

AIウェブスクレイピングは、機械学習を活用してウェブサイトのデータを認識・抽出・構造化する手法です。従来の壊れやすいスクリプトに頼らず、サイト構造の変化にも柔軟に対応し、メンテナンス負担が大幅に軽減されます。

2. 非技術者におすすめのAIウェブスクレイピングツールは?

やOctoparseは、ノーコードで使えるビジュアルインターフェースやAIフィールド提案、ExcelやGoogle Sheetsへの簡単エクスポート機能が充実していて、非エンジニアに最適です。

3. 動的サイトやログイン必須のページも抽出できますか?

はい。Thunderbit、ParseHub、Import.ioなどは、動的コンテンツやログインが必要なページにも対応しています(設定方法はツールによって異なります)。

4. AIウェブスクレイピングの費用は?

ScrapyやBeautifulSoupは無料、Thunderbit(月額15ドル〜)、Octoparse(月額75ドル〜)など手頃なSaaS型から、Import.ioやContent Grabberのようなエンタープライズ向けまで幅広いです。多くのツールが無料トライアルや小規模向け無料枠を用意しています。

5. ウェブスクレイピングはビジネスで合法・安全ですか?

適切に行えば合法です。各サイトの利用規約を守り、個人情報の不正利用を避け、プライバシー法にも配慮しましょう。多くのAIツールは、法令遵守や抽出速度管理などの機能も備えています。

さらに詳しく知りたい方はこちら: