2015年にちょっとだけタイムスリップしてみましょう。当時、ウェブサイトからデータを集めたいと思ったら、選択肢はほぼ2つしかありませんでした。ひとつはエンジニアの友達にPythonスクリプトを書いてもらうこと。もうひとつは、週末を丸ごと使ってXPathの使い方を必死に覚えること(そして月曜にはすっかり忘れてしまう…)。

でも、時代は大きく変わりました。AIや大規模言語モデル(LLM)が登場したことで、ウェブクローリングは専門知識がなくても、営業やマーケ担当者でも数クリックでできる時代になったんです。

自分はSaaSや自動化の分野で長く仕事をしてきて、ウェブクローリングが壊れやすいスクリプトからAI搭載のパワフルなエージェントへと進化するのを間近で見てきました。ウェブデータの需要は爆発的に増えていて、(スタートアップからGoogleのような大企業まで)が、インサイト獲得のためにクローリングを活用しています。市場規模はに到達し、2030年にはさらに倍増する見込みです。最大の変革ポイントは、欲しいデータを英語で指示するだけで自動的に取得してくれるAIウェブクローラーの登場です。

開発者はもちろん、「もう手作業でコピペは限界!」というビジネスユーザーまで、2025年に注目すべきAIウェブクローラー15選を、Thunderbit(自分が共同創業した会社)がなぜトップに選ばれるのかも含めて紹介します。

AIがウェブページクローリングを変える理由:新時代のAIウェブスクレイパーツール

正直、昔のウェブクローリングは一般のビジネスユーザーにはハードルが高すぎました。コードやセレクターを駆使して、ウェブサイトのレイアウトが変わるたびにスクリプトが壊れないことを祈るしかなかったんです。でも、AIとLLMの登場で状況は一変。

主な変化はこんな感じです:

- 自然言語で指示できる:コードを書く代わりに、AIに「何が欲しいか」伝えるだけ。たとえばは、英語での指示を理解して自動で抽出設定をしてくれます()。

- レイアウト変化にも強い:AIスクレイパーはし、メンテナンスの手間を大幅に減らします。

- 動的コンテンツもOK:JavaScriptや無限スクロールなど、最新のウェブサイトにもAIツールはしっかり対応。従来のスクレイパーでは取れなかったデータもキャッチできます。

- AIによるきれいなデータ出力:LLM搭載のスクレイパーは、整理されたデータを出力します。

- 自動アンチボット回避:AIスクレイパーはし、プロキシやヘッドレスブラウザでIPブロックも防ぎます。

- データ連携も自動化:優秀なツールはデータを取得するだけじゃなく、Google SheetsやAirtable、Notionなどにワンクリックでエクスポートできます()。

この結果、ウェブクローリングは「クリックするだけ」や「チャット感覚」で使えるようになり、営業・マーケ・オペレーション部門でも直接ウェブデータを活用できるようになりました。

2025年注目のAIウェブクローラーツール15選

ここからはThunderbitをはじめ、各ツールの特徴・対象ユーザー・価格・強みをまとめて紹介します。良い点も課題も正直にお伝えします。

1. Thunderbit:誰でも使えるAIウェブスクレイパー

ちょっと自画自賛ですが、Thunderbitは「数年前の自分が本当に欲しかったAIウェブスクレイパー」です。1位に選んだ理由は以下の通り:

- 自然言語で抽出:「このページから商品名と価格を全部取得して」とThunderbitに話しかけるだけで、AIが自動で処理します()。コードもセレクターも不要。

- サブページ・多階層クロール:Thunderbitは。商品一覧から各商品詳細まで一括で抽出可能です。

- 即時の構造化出力:AIがし、必要な項目やフォーマットも提案。要約やカテゴリ分けも可能。

- 多様なデータソース対応:HTMLだけでなく、PDFや画像からもOCR・画像認識AIでデータ抽出できます()。

- ビジネス連携:Google Sheets、Airtable、Notion、Excelへワンクリックでエクスポート。スケジュール実行やワークフロー連携も簡単です。

- テンプレート搭載:AmazonやLinkedIn、Zillowなど主要サイト向けのも用意。

- 直感的で使いやすい:クリック操作とアシスタントで、誰でも数分で使い始められます。

Thunderbitはに利用されていて、Accenture、Grammarly、Pumaなどのチームにも導入されています。営業チームは、不動産業者は物件情報の集約、マーケターは競合調査など、コード不要で幅広く活用されています。

料金:(月100ステップまで)あり。有料プランは月14.99ドルから。個人や小規模チームでも手軽に始められます。

Thunderbitは「ウェブをそのままデータベース化」できる唯一のツール。エンジニアだけでなく、誰でも使えます。

2. Crawl4AI

対象:開発者や技術チーム向け。

Crawl4AIはオープンソースのPythonフレームワークで、に設計されています。高速で大規模なクロールが可能、動的コンテンツにも対応し、AIワークフローへのデータ供給も簡単です。

- おすすめ:強力なカスタマイズ性を求める開発者。

- 料金:無料(MITライセンス)。自分でホスティングが必要。

3. ScrapeGraphAI

対象:AIエージェントや複雑なデータパイプラインを構築する開発者・アナリスト。

ScrapeGraphAIはプロンプト駆動型のオープンソースPythonライブラリで、LLMを活用してウェブサイトを構造化データの「グラフ」に変換します。「最初の5ページから商品名・価格・評価を抽出」などの指示で自動ワークフローを構築()。

- おすすめ:柔軟なプロンプト型スクレイピングを求める技術者。

- 料金:OSSは無料、クラウドAPIは月20ドル~。

4. Firecrawl

対象:AIエージェントや大規模データパイプラインを構築する開発者。

FirecrawlはAI中心のクローリングプラットフォーム・APIで、ウェブ全体を「LLM対応データ」に変換()。MarkdownやJSON出力、動的コンテンツ対応、LangChainやLlamaIndexとの連携も可能。

- おすすめ:AIモデルにライブウェブデータを供給したい開発者。

- 料金:コアは無料、クラウドプランは月19ドル~。

5. Browse AI

対象:ビジネスユーザー、グロースハッカー、アナリスト。

Browse AIは。欲しいデータをクリックで指定し、AIがパターンを学習。ログインや無限スクロール、サイトの変化監視も対応。

- おすすめ:非技術者でデータ収集や監視を自動化したい方。

- 料金:無料プラン(50クレジット/月)、有料は月19ドル~。

6. LLM Scraper

対象:AIによるパースを求める開発者。

LLM ScraperはオープンソースのJavaScript/TypeScriptライブラリで、し、LLMが任意のウェブページからデータを抽出。Playwrightベースで複数のLLMプロバイダーに対応、再利用可能なコード生成も可能。

- おすすめ:LLMで任意ページを構造化データ化したい開発者。

- 料金:無料(MITライセンス)。

7. Reader (Jina Reader)

対象:LLMアプリやチャットボット、要約ツールを開発する技術者。

Jina Readerは、LLM対応のMarkdownやJSONで返します。独自AIモデル搭載、画像キャプションも可能。

- おすすめ:LLMやQ&Aシステム向けのクリーンなデータ取得。

- 料金:無料API(基本利用はキー不要)。

8. Bright Data

対象:大規模・高信頼性・コンプライアンス重視の企業ユーザー。

Bright Dataは業界最大級のプロキシネットワークとを提供。既製スクレイパーやWeb Scraper API、「LLM対応」データフィードも。

- おすすめ:大規模なウェブデータが必要な組織。

- 料金:従量課金制、無料トライアルあり。

9. Octoparse

対象:非技術者~中級者。

OctoparseはとAI自動検出を備えたノーコードツール。ログインや無限スクロール、各種フォーマットでのエクスポートも対応。

- おすすめ:アナリスト、中小企業、研究者。

- 料金:無料プランあり、有料は月59ドル~。

10. Apify

対象:カスタムスクレイピングや自動化が必要な開発者・技術チーム。

Apifyはクラウド上でスクレイピングスクリプト(「アクター」)を実行でき、も提供。スケーラブルでAI連携やプロキシ管理も可能。

- おすすめ:クラウドでカスタムスクリプトを動かしたい開発者。

- 料金:無料枠あり、従量課金は月49ドル~。

11. Zyte (Scrapy Cloud)

対象:エンタープライズ向けの大規模スクレイピングが必要な開発者・企業。

ZyteはScrapyの開発元で、クラウドプラットフォームやを提供。スケジューリングやプロキシ、大規模案件にも対応。

- おすすめ:長期的なスクレイピングプロジェクトを運用する開発チーム。

- 料金:無料トライアル~エンタープライズ向けカスタムプラン。

12. Webscraper.io

対象:初心者、ジャーナリスト、研究者。

はで、ポイント&クリックでデータ抽出。ローカル利用は無料、クラウドサービスもあり。

- おすすめ:手軽な一時的スクレイピング。

- 料金:拡張は無料、クラウドは月約50ドル~。

13. ParseHub

対象:ノーコードツール以上の機能を求める非技術者。

ParseHubはデスクトップアプリで、動的コンテンツ(地図やフォーム含む)もビジュアルワークフローで抽出。クラウド実行やAPIも提供。

- おすすめ:デジタルマーケター、アナリスト、ジャーナリスト。

- 料金:無料枠(1回200ページ)、有料は月189ドル~。

14. Diffbot

対象:大規模・構造化ウェブデータが必要な企業やAI企業。

DiffbotはコンピュータビジョンとNLPで、記事・商品APIや巨大なナレッジグラフも提供。

- おすすめ:市場調査、金融、AIトレーニングデータ。

- 料金:プレミアム、月約299ドル~。

15. DataMiner

対象:営業・マーケ・ジャーナリズムなど非技術者。

DataMinerはで、ポイント&クリックでウェブデータを抽出。プリセットレシピも豊富で、Google Sheetsへ直接エクスポート可能。

- おすすめ:表やリストをスプレッドシートに素早く出力したい場合。

- 料金:無料枠(1日500ページ)、Proは月約19ドル~。

AIウェブスクレイパーツールの比較:自分に合うのはどれ?

以下の比較表で、各ツールの特徴をざっくり把握できます:

| ツール | AI/LLM活用 | 使いやすさ | 出力・連携 | 理想的な用途 | 価格 |

|---|---|---|---|---|---|

| Thunderbit | 自然言語UI・AIが項目提案 | 最も簡単(ノーコードチャット) | Sheets, Airtable, Notion出力 | 非技術チーム | 無料枠・Pro約30ドル/月 |

| Crawl4AI | AI対応クロール・LLM連携 | 難(Pythonコーディング) | ライブラリ/CLI・コード連携 | 高速AIデータパイプライン開発者 | 無料 |

| ScrapeGraphAI | LLMプロンプト型パイプライン | 中(コーディング/ API) | API/SDK・JSON出力 | AIエージェント開発者/アナリスト | OSS無料・API20ドル~/月 |

| Firecrawl | LLM対応Markdown/JSON出力 | 中(API/SDK利用) | SDK(Py, Node等)・LangChain連携 | AIにライブデータ供給 | 無料+有料クラウド |

| Browse AI | AI支援ポイント&クリック | 簡単(ノーコード) | 7000+アプリ連携(Zapier) | 非技術者の自動化 | 無料50回・有料19ドル~/月 |

| LLM Scraper | LLMでスキーマ抽出 | 難(TS/JSコーディング) | コードライブラリ・JSON出力 | AIでパースしたい開発者 | 無料(自前LLM API) |

| Reader (Jina) | AIモデルでテキスト/JSON抽出 | 簡単(APIコール) | REST APIでMarkdown/JSON | LLM向けウェブ検索/要約 | 無料API |

| Bright Data | AI強化API・大規模プロキシ | 難(API/技術要) | API/SDK・データストリーム | エンタープライズ規模 | 従量課金 |

| Octoparse | AI自動リスト検出 | 中(ノーコードアプリ) | CSV/Excel, API出力 | 中級者 | 無料枠・59~166ドル/月 |

| Apify | 一部AI機能(Actors等) | 難(スクリプト) | API・LangChain連携 | クラウドでカスタム開発 | 無料枠・従量課金 |

| Zyte (Scrapy) | ML自動抽出・Scrapy基盤 | 難(Pythonコーディング) | API, Scrapy Cloud UI・JSON/CSV | 長期プロジェクト開発チーム | カスタム価格 |

| Webscraper.io | AIなし(手動テンプレ) | 簡単(拡張機能) | CSVダウンロード・Cloud API | 初心者・一時利用 | 無料拡張・Cloud約50ドル/月 |

| ParseHub | LLMなし・ビジュアル設計 | 中(ノーコードアプリ) | JSON/CSV・クラウドAPI | 複雑サイトの非開発者 | 無料200ページ・有料189ドル/月 |

| Diffbot | AIビジョン/NLP・ナレッジグラフ | 簡単(APIコール) | 各種API+ナレッジグラフ | エンタープライズ・構造化データ | 約299ドル/月~ |

| DataMiner | LLMなし・コミュニティレシピ | 最も簡単(拡張UI) | Excel/CSV・Google Sheets | 非技術者の表データ抽出 | 無料枠・Pro約19ドル/月 |

ツールのタイプ別分類:開発者向けからビジネス向けまで

このリストを分かりやすくするため、以下のカテゴリに分類します:

1. 開発者・オープンソース系

- 例:Crawl4AI、LLM Scraper、Apify、Zyte/Scrapy、Firecrawl

- 強み:柔軟性・拡張性・大規模対応。AIモデル連携やカスタムパイプライン構築に最適。

- 注意点:コーディングや設定が必要。

- 用途例:独自データパイプライン構築、複雑サイトのクローリング、社内システム連携。

2. AI統合型クローリングエージェント

- 例:Thunderbit、ScrapeGraphAI、Firecrawl、Reader (Jina)、LLM Scraper

- 強み:クローリングとデータ理解のギャップを縮小。自然言語UIで使いやすい。

- 注意点:一部は発展途上、細かい制御は苦手な場合も。

- 用途例:クイックなデータ取得、AIエージェント構築、LLMへのライブデータ供給。

3. ノーコード/ローコード・ビジネス向け

- 例:Thunderbit、Browse AI、Octoparse、ParseHub、Webscraper.io、DataMiner

- 強み:直感的でコーディング不要、日常業務に最適。

- 注意点:超複雑サイトや大規模案件は苦手な場合も。

- 用途例:リード獲得、競合調査、リサーチ、一時的なデータ取得。

4. エンタープライズ向けデータプラットフォーム

- 例:Bright Data、Diffbot、Zyte

- 強み:フルスタック、マネージドサービス、信頼性・コンプライアンス重視。

- 注意点:コスト高め、導入に時間がかかる場合も。

- 用途例:大規模・常時稼働のデータパイプライン、市場調査、AIトレーニングデータ。

自分に合ったAIウェブクローラーの選び方

ツール選びに迷ったら、以下のステップで整理してみてください:

- 目的とデータ要件を明確に:どのサイト・どんなデータが・どれくらい・何に使うのか?

- 技術レベルを自己評価:コード不要ならThunderbitやBrowse AI、Octoparse。少しスクリプトOKならLLM ScraperやDataMiner。開発者ならCrawl4AIやApify、Zyte。

- 頻度と規模を考慮:一時的なら無料ツール、定期的ならスケジューリング機能、大規模ならエンタープライズやOSS。

- 予算と料金体系:無料枠で試し、サブスクか従量課金かも要確認。

- 実データで試す:多くのツールは無料枠あり。実際のデータでテストを。

- 保守・サポート体制:サイト変更時の対応は?AI搭載ノーコードは自動修正も。OSSは自力またはコミュニティ頼み。

- 用途別マッピング:営業リードならThunderbitやBrowse AI、SNS収集ならDataMinerやWebscraper.io、AIモデル用ならJina ReaderやZyte、比較サイト構築ならApifyやZyte。

- バックアップも用意:特定サイトで動かない場合に備え、代替ツールも検討。

「最適なツール」とは、最小限の手間とコストで必要なデータを得られるもの。複数併用もアリです。

Thunderbitと従来型ウェブスクレイパーの違い

Thunderbitが他と違う理由を具体的に挙げます:

- 自然言語インターフェース:コードも複雑な操作も不要。欲しい内容をそのまま伝えるだけ()。

- ゼロ設定&テンプレート提案:ページネーションやサブページも自動検出、主要サイトはテンプレートも自動提案()。

- AIによるデータ整形・拡張:要約・カテゴリ分け・翻訳・データ補完もAIで自動化()。

- 保守の手間が少ない:AIが小さなサイト変更にも強く、壊れにくい。

- ビジネスツール連携:Google SheetsやAirtable、Notionへ直接出力。CSV変換の手間なし()。

- スピード感:アイデアからデータ取得まで数分で完了。

- 学習コストが低い:ウェブ閲覧と指示ができれば誰でも使える。

- 多用途性:ウェブ・PDF・画像など、1つのツールで幅広く対応。

Thunderbitは単なるスクレイパーではなく、営業・マーケ・EC・不動産など、あらゆる業務にフィットする「データアシスタント」です。

AIウェブスクレイパー活用のコツ・ベストプラクティス

AIウェブスクレイパーを最大限活用するためのポイント:

- 欲しいデータを明確に:必要な項目・ページ数・フォーマットを事前に整理。

- AIの提案を活用:自動項目検出やAIの提案で、見落としがちなデータもカバー()。

- 小規模でテスト&検証:まずは少量で試し、出力を確認・調整。

- 動的コンテンツ対応を確認:ページネーションや無限スクロールなど、動的要素に対応しているか要チェック。

- サイトポリシーを守る:robots.txtの確認、機密データの回避、リクエスト制限の順守。

- 自動化連携を活用:エクスポートやWebhookでワークフローに直結。

- データ品質を維持:出力の確認・後処理・エラー監視も忘れずに。

- プロンプトは簡潔に:AI型ツールは明確な指示ほど精度が上がります。

- コミュニティ活用:フォーラムやコミュニティでノウハウやトラブル解決。

- 最新情報をチェック:AIツールは進化が早いので、新機能や改善点も随時確認。

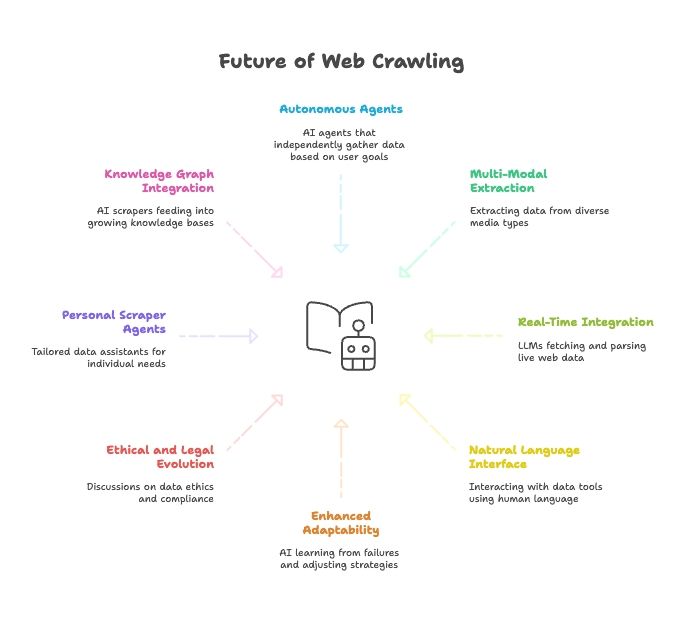

ウェブクローリングの未来:AI・LLM・自然言語エージェントの台頭

これから先、AIとウェブクローリングの融合はさらに加速していきます:

- 完全自律型クローラーエージェント:目標を伝えるだけでAIが最適な方法でデータを取得。

- マルチモーダル抽出:テキスト・画像・PDF・動画など多様なデータを一括取得。

- AIモデルとのリアルタイム連携:LLMがウェブデータ取得・解析機能を標準搭載。

- 自然言語での全操作:人と話す感覚でデータツールを操作、誰でもデータ活用が可能に。

- 適応力の強化:AIクローラーが失敗から学び、自動で戦略を最適化。

- 倫理・法規制の進化:データ倫理やコンプライアンス、フェアユースの議論も活発化。

- パーソナルクローラーエージェント:自分専用のデータアシスタントがニュースや求人情報などを自動収集。

- ナレッジグラフ連携:AIクローラーが知識ベースを拡充し、より賢いAIを実現。

つまり、ウェブクローリングの未来はAIと切っても切れない関係。ツールはどんどん賢く・自律的・使いやすく進化しています。

まとめ:最適なAIウェブクローラーでビジネス価値を最大化

ウェブクローリングは、かつての専門技術から、AIの力でビジネスの必須スキルへと進化しました。ここで紹介した15のツールは、2025年の最先端を代表するものです。

本当に大事なのは、自分に合ったツールを選ぶことで、ウェブデータの価値を最大化できるということ。非技術者チームにはThunderbitが一番手軽で、ウェブをそのまま分析可能なデータベースに変換できます。コードも手間も不要、すぐに結果が得られます。

リード獲得、競合調査、AIモデルへのデータ供給など、まずは自分のニーズを整理し、いくつかのツールを試してみてください。ウェブクローリングの未来を今すぐ体験したいなら、。必要なインサイトは、あなたの指示ひとつで手に入ります。

さらに詳しく知りたい方は、で最新のAIデータ抽出ノウハウやチュートリアルをチェック!

関連記事:

よくある質問(FAQ)

1. AIウェブクローラーとは?従来のウェブスクレイパーと何が違う?

AIウェブクローラーは、自然言語処理や機械学習を活用してウェブデータを理解・抽出・構造化します。従来のスクレイパーのように手動でコードやXPathを指定する必要がなく、動的コンテンツやレイアウト変更にも柔軟に対応し、英語での指示も解釈できます。

2. ThunderbitのようなAIウェブクローリングツールはどんな人におすすめ?

Thunderbitは非技術者から技術者まで幅広く使えます。営業・マーケ・オペレーション・リサーチ・EC担当者など、ウェブ・PDF・画像から構造化データを抽出したい方に最適です。コードは一切不要です。

3. Thunderbitが他のAIウェブクローラーと比べて優れている点は?

Thunderbitは自然言語インターフェース、多階層クロール、自動データ構造化、OCR対応、Google SheetsやAirtableなどへのシームレスなエクスポート、AIによる項目提案や主要サイト向けテンプレートなどを備えています。

4. 2025年に無料で使えるAIウェブクローリングツールはある?

はい。Thunderbit、Browse AI、DataMinerなどは無料プランを提供しています。開発者向けにはCrawl4AIやScrapeGraphAIなどのオープンソースもあり、技術的なセットアップができれば無料でフル機能を使えます。

5. 自分に合ったAIウェブクローラーの選び方は?

まずはデータの目的・技術レベル・予算・規模を整理しましょう。ノーコードで簡単に使いたいならThunderbitやBrowse AI、大規模やカスタム用途ならApifyやBright Dataが適しています。