ちょっとした裏話をお届けします。昔は「ウェブスクレイピング」と聞くと、パーカーをかぶったハッカーや、何台もモニターを並べたデータサイエンティストだけの世界だと思っていました。でも今や、ウェブサイトからデータ抽出するのは、オフィスでコーヒーを飲むくらい日常的なこと。しかも、Pythonの知識も、朝からエスプレッソ3杯分の気合も不要です。AIウェブスクレイパーの登場で、「HTMLって何?サンドイッチの新メニュー?」という人でも、ウェブ上のデータをサクッと取り出せる時代になりました。

もしあなたが、商品情報や営業リスト、価格表などを手作業でコピペした経験があるなら、それはあなただけじゃありません。実際、が市場調査や競合分析のためにウェブスクレイピングを活用しています。さらに、ウェブスクレイピングツールの市場はに成長すると予想されており、もはや一部の技術者だけのものではありません。営業やマーケティング、単純作業から解放されたい人にも、このガイドはきっと役立ちます。基本から、従来型とAI型の違い、始め方まで、分かりやすくまとめました。

ウェブスクレイパーの基本:ウェブサイトからデータを抽出するとは?

まずはシンプルに。ウェブスクレイパーとは、ウェブサイトから自動でデータを集めてくれるツール(またはスクリプトやChrome拡張機能)のこと。例えるなら、文句も言わずに単純作業を爆速でこなしてくれるスーパーインターンみたいな存在です。あなたが1行ずつコピペする代わりに、数秒で必要な情報をまとめて取得してくれます。

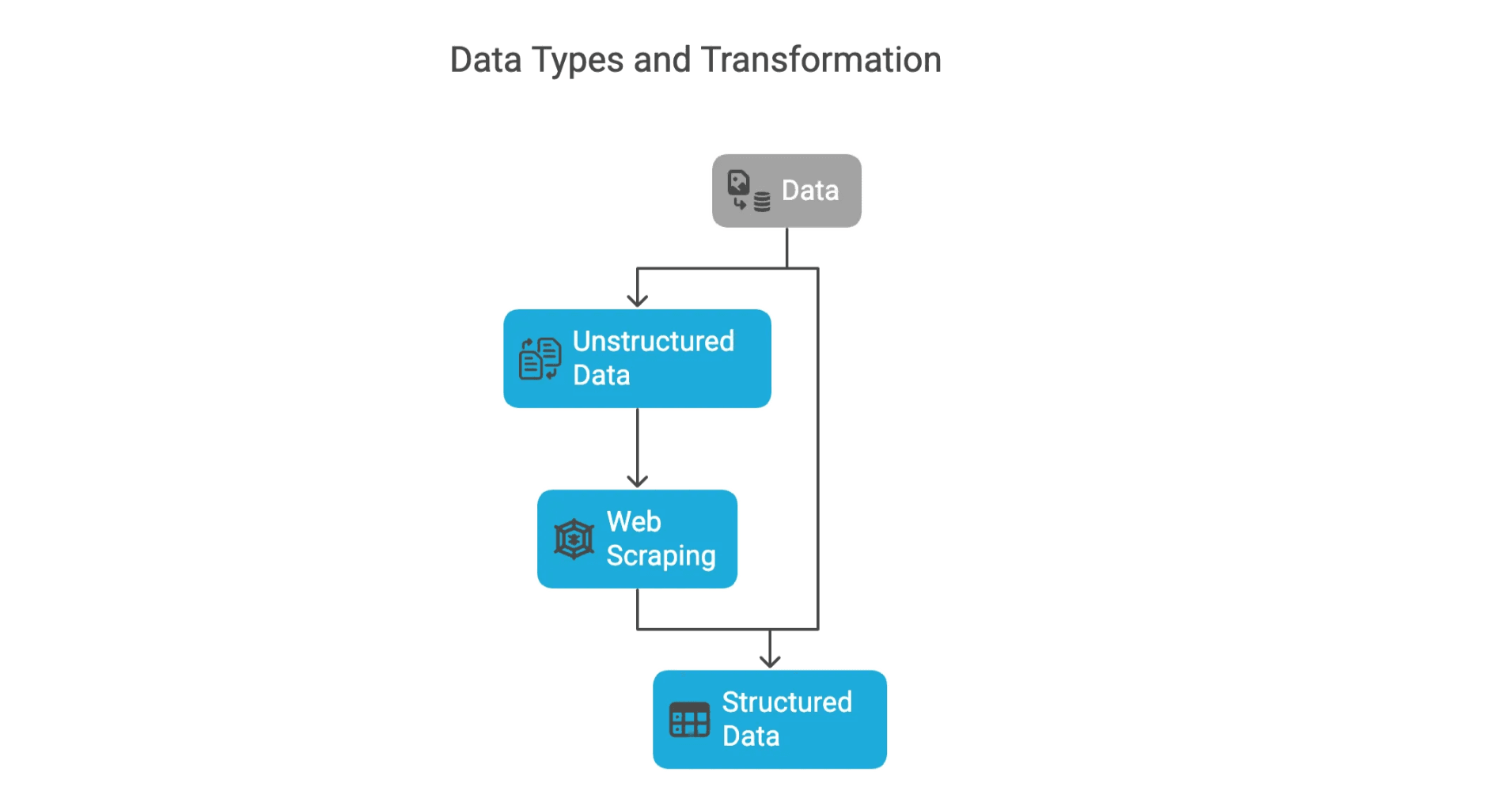

ウェブ上のデータには主に2種類あります:

- 構造化データ:表やリストのように整理されていて、すぐにスプレッドシートで使えるデータ。商品名や価格、メールアドレスなど、ラベル付きで分析しやすい情報です。

- 非構造化データ:ブログ記事やレビュー、画像など、行や列にきれいに収まらないデータ。多くのウェブスクレイピングは、この非構造化データを構造化データに変換することが目的です。

もしウェブサイトの表をExcelにコピペしたことがあれば、それは手作業のウェブスクレイピングをしたことになります。でも、それを1万ページ分やるのは現実的じゃありません。そこでウェブスクレイパーの出番です。

なぜウェブサイトからデータを抽出するのか?ビジネスでの主なメリット

そもそも、なぜデータ抽出が必要なのでしょう?答えはシンプル。ビジネスはデータで動き、ウェブは世界最大のデータベースだからです。営業、マーケティング、EC、不動産など、どの業界でもウェブデータの活用は大きな武器になります。

代表的な活用例をいくつかご紹介します:

| ユースケース | 概要 | ROI/メリット例 |

|---|---|---|

| リード獲得 | ディレクトリやSNSから連絡先や企業リストを収集 | 営業チームの作業時間を大幅短縮、質の高いリード獲得 |

| 価格モニタリング | 競合の価格や在庫、キャンペーンをリアルタイムで追跡 | 小売業者が価格を柔軟に調整し、売上4%アップ |

| 市場調査 | レビューやニュース、SNSの声を集約しトレンドを把握 | マーケターが消費者動向に合わせて施策を最適化 |

| 競合分析 | 競合商品のカタログや新商品、コンテンツを監視 | 市場変化に素早く対応可能 |

| 不動産インテリジェンス | 物件情報や価格、空き状況を収集 | エージェントや投資家がいち早くチャンスを発見 |

実際、が、競合価格のスクレイピングを活用したダイナミックプライシングを導入しています。John LewisやASOSといった企業も、ウェブデータを活用することで売上アップを実現しています。

従来型ウェブスクレイパーツールの仕組み

AIが登場する前の「クラシック」な方法を振り返ってみましょう。従来型のウェブスクレイパーは、主にPythonなどで書かれたスクリプトやブラウザ拡張機能で、決められたルールに従ってデータを取得します。

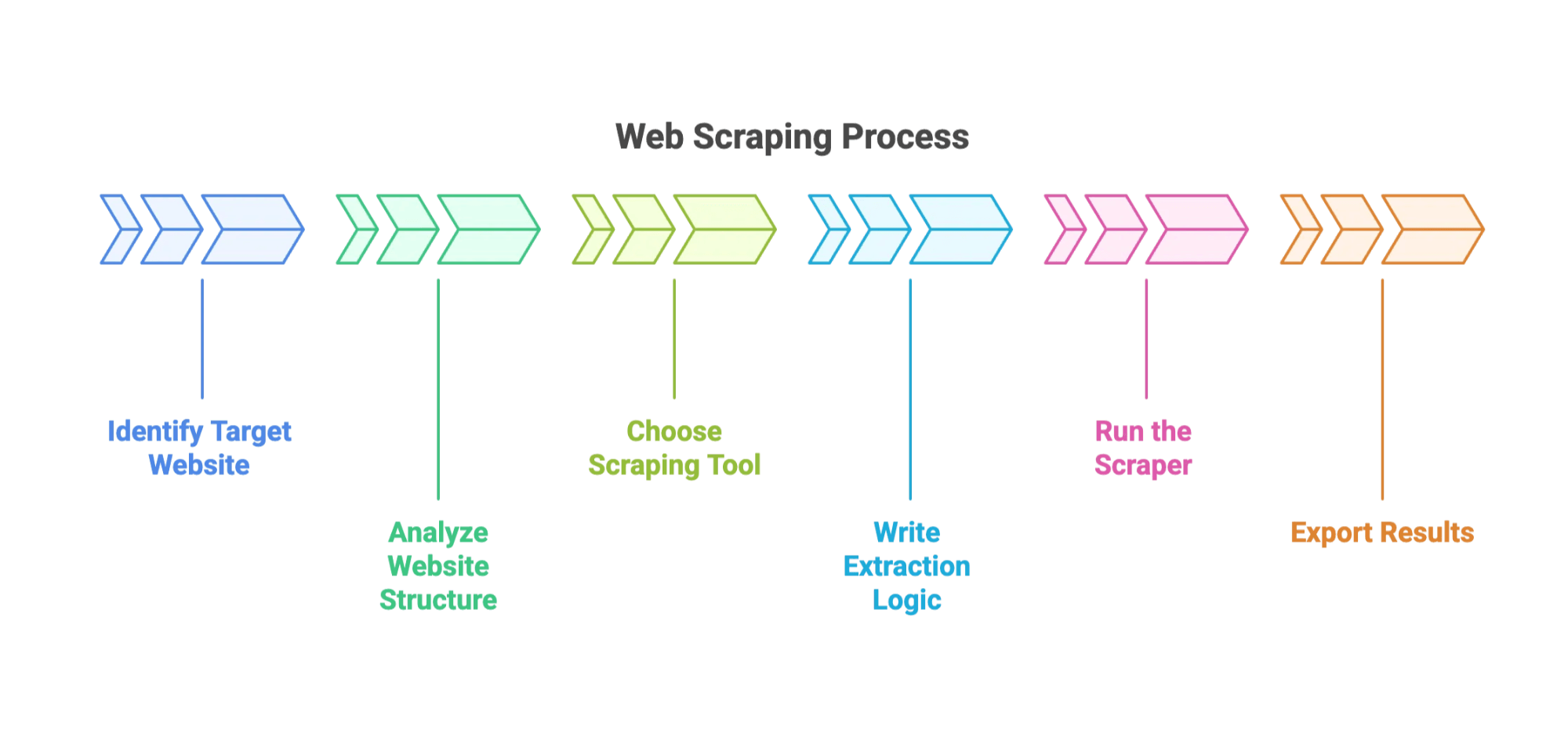

一般的な流れはこんな感じです:

- 対象サイトと抽出したいデータ項目を決める

- サイトの構造を調査(ブラウザの開発者ツールでHTMLを確認。まるでデジタル考古学です)

- ツールを選ぶ:代表的なのはや、ブラウザプラグインなど

- 抽出ロジックを書く:CSSセレクタやXPathでデータの位置を指定

- スクレイパーを実行:複数ページからデータを収集

- 結果をエクスポート:CSVやJSON、Excelなどに保存

実践:従来型ウェブスクレイパーでデータを抽出する手順

例えば、ECサイトの商品リストを抽出したい場合の流れです:

- ステップ1: PythonとBeautifulSoupをインストール

- ステップ2: ブラウザで商品ページのHTML構造を調査。商品名や価格がどのタグに入っているか確認

- ステップ3: ページを取得し、HTMLを解析して必要な項目を抽出するスクリプトを書く

- ステップ4: 複数ページに対応(ページ送りの処理)

- ステップ5: データをCSVファイルに出力

一見簡単そうですが、最初は必ずどこかでつまずきます(私も最初はクラス名のスペルミスで500行分「None」しか取れませんでした…)。

従来型ウェブスクレイパーのよくある課題

ここからが本番です:

- サイト構造の変更:ちょっとしたレイアウト変更でもスクレイパーが動かなくなることが多い。が毎週壊れるとも言われています。

- ボット対策:CAPTCHAやIPブロック、リクエスト制限などで止められることも。プロキシや遅延処理、CAPTCHA対応が必要です。

- 技術的な知識が必要:プログラミングやHTML/CSSの基礎が求められます。

- メンテナンスが大変:定期的な修正や監視が必要です。

- データの整形が手間:フォーマットのばらつきや欠損値、文字化けなどの処理が必要です。

初心者にとっては、レシピが毎回変わるケーキ作りに挑戦しているようなものです。

AIウェブスクレイパーの登場:データ抽出が誰でも簡単に

ここからが本題。AIウェブスクレイパーの登場で、状況は一変しました。コードを書いたり、セレクタを調整したりする必要はありません。欲しいデータを自然な日本語で伝えるだけで、AIが自動で抽出方法を判断してくれます。

Thunderbit(私たちのサービスです!)は、まさにこの新しい時代の代表例。なら、どんなウェブサイトでも自然言語で構造化データを抽出可能。営業やマーケティング、EC担当者でも、数分で必要なデータを手に入れられます。

Thunderbit AIウェブスクレイパーがデータ抽出を簡単にする理由

Thunderbitの便利なポイントを簡単にご紹介します:

- AIフィールド提案:「AIフィールド提案」をクリックするだけで、Thunderbitがページを解析し、カラム名や抽出方法を自動で提案します。

- サブページ抽出:詳細情報が必要な場合も、商品詳細ページなどを自動で巡回し、データを充実させます。

- 即使えるテンプレート:AmazonやZillowなど人気サイト用のテンプレートも用意。面倒な設定不要です。

- 無料データエクスポート:Excel、Googleスプレッドシート、Airtable、Notionなどにワンクリックで出力。CSVやJSONもOK。追加料金なし。

- 定期スクレイピング:スケジュール設定でデータを自動更新。価格監視やリード管理に最適です。

- AI自動入力:AIがオンラインフォームの入力も代行(10ページのベンダー登録もお任せ)。

- メール・電話番号・画像抽出:連絡先や画像もワンクリックで取得。

しかも、プログラミング知識は一切不要。ThunderbitのChrome拡張はからインストールできます。詳しくはもご覧ください。

従来型とAIウェブスクレイパーの比較

2つのアプローチを比較してみましょう:

| 項目 | 従来型ウェブスクレイパー | AIウェブスクレイパー(Thunderbit) |

|---|---|---|

| 使いやすさ | コーディングや複雑な設定が必要 | ノーコード、自然言語で操作可能 |

| 柔軟性 | サイト変更に弱く壊れやすい | AIが自動でレイアウト変更に対応 |

| メンテナンス | 頻繁な修正が必要 | AIが大半を自動対応 |

| 技術スキル | プログラミングやHTML知識が必要 | ビジネスユーザー向け設計 |

| セットアップ時間 | 数時間〜数日 | 数分で完了 |

| データ整形 | 手作業でのクリーニングが必要 | AIが自動でクリーン&構造化 |

| コスト | オープンソースは無料だが手間が多い | 手頃なプラン、無料エクスポートも |

特に初心者やビジネスユーザーにとっては、ThunderbitのようなAIウェブスクレイパーが圧倒的にスピーディーで簡単、しかも安定しています。大規模・特殊な案件以外は、AI型が最適解です。

初心者向け:ウェブサイトからデータを抽出する手順

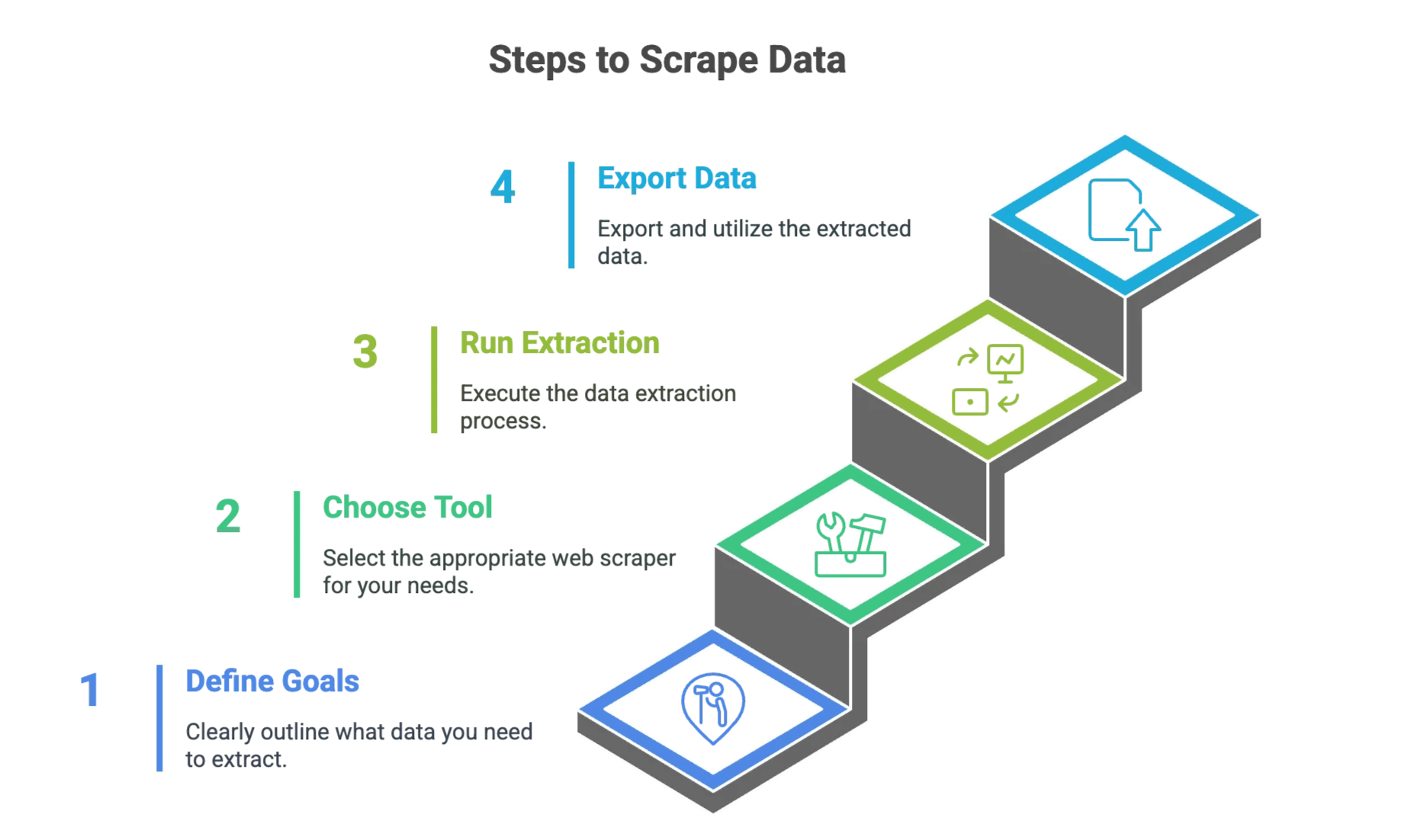

ステップ1:抽出したいデータの目的を明確にする

まずは、何をどこから取りたいのかを整理しましょう。

- どのウェブサイトからデータを抽出したいか?

- どんな項目が必要か?(例:商品名、価格、メール、電話番号など)

- データはどのくらいの頻度で必要か?(一度きりか、定期的か)

例:「XYZ.comの最初の5ページから商品名・価格・評価を集めたい」など、チェックリストを作るとスムーズです。

ステップ2:最適なウェブスクレイパーツールを選ぶ

簡単な判断フロー:

- コードに慣れていて細かく制御したい場合:BeautifulSoupやScrapyなど従来型ツールを選択

- スピード重視・ノーコード希望の場合:などAIウェブスクレイパーがおすすめ

迷ったら、まずはAI型から始めてみましょう。

ステップ3:データ抽出の実行

従来型アプローチ

- ツールのインストール:Pythonや必要なライブラリをセットアップ

- サイトの調査:ブラウザの開発者ツールでHTML構造を確認

- スクリプト作成:各データ項目の抽出方法を定義

- 1ページでテスト:正しくデータが取れるか確認

- 拡張:ページ送りやループ処理を追加

- データ出力:CSVやJSONで保存

AIアプローチ(Thunderbit)

- Thunderbit Chrome拡張をインストール:

- 対象サイトを開く:抽出したいページを表示

- 「AIフィールド提案」をクリック:Thunderbitが自動でカラムを提案

- プレビュー確認:データ内容をチェックし、必要ならカラムを調整

- 「スクレイピング」実行:Thunderbitがデータを収集

- データ出力:Excel、Googleスプレッドシート、Airtable、Notionなどにエクスポート

詳しい操作はもご覧ください。

ステップ4:データの活用・エクスポート

データが取得できたら:

- お好みのツールにエクスポート:Excel、Googleスプレッドシート、Airtable、Notion、CSV、JSONなど

- 業務フローに組み込む:営業リスト、価格分析、市場調査などに活用

- データの確認・整合性チェック:AIでも念のためサンプル確認をおすすめします

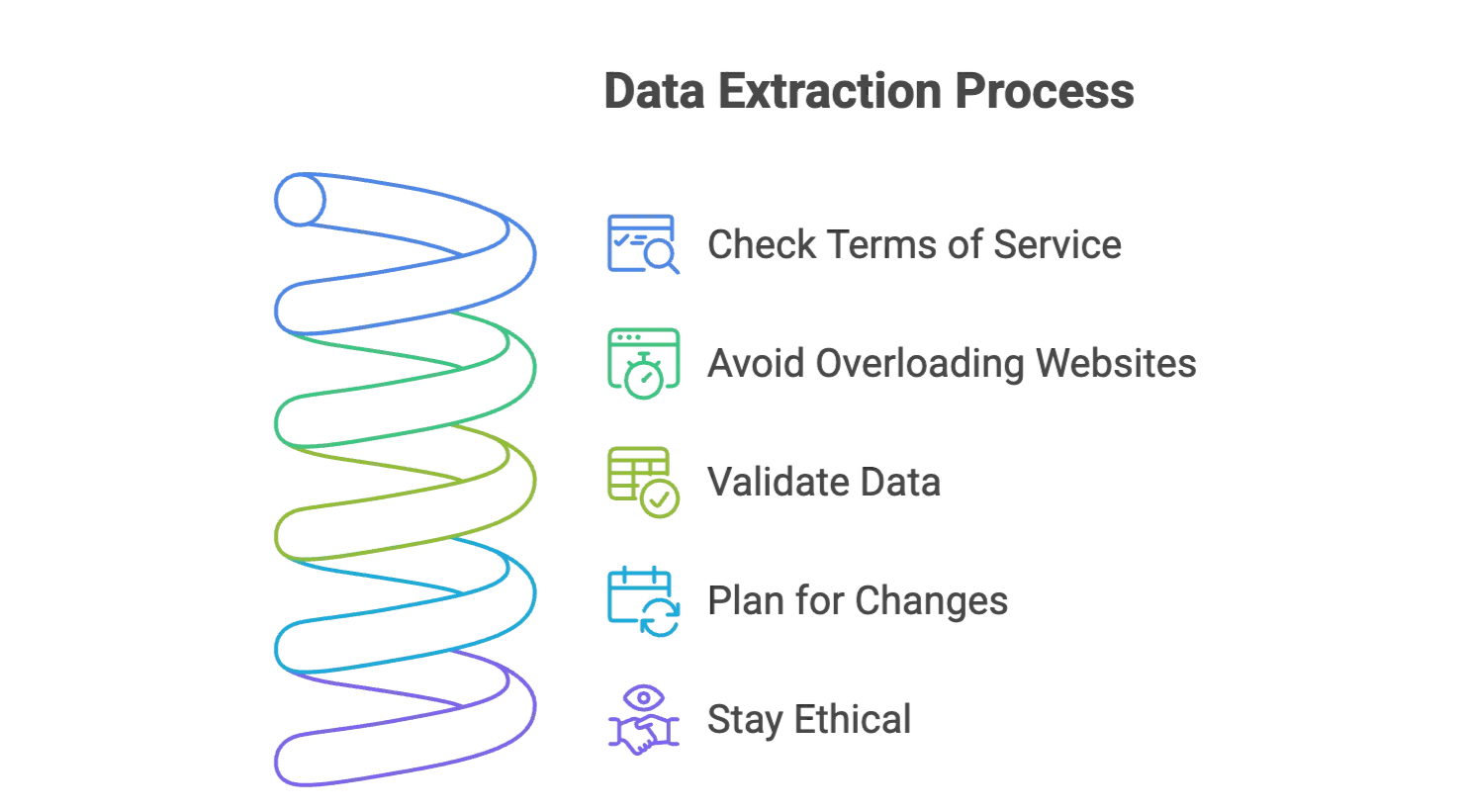

データ抽出を成功させるコツと注意点

- サイトの利用規約を確認:スクレイピングが許可されているか必ずチェック。公開情報のみを対象にし、個人情報は避けましょう。

- サイトに負荷をかけない:従来型ツールの場合はリクエスト間隔を空ける、Thunderbitなら自動で調整されます。

- データの精度を確認:取得結果の一部を必ずチェックしましょう。

- サイト変更への備え:ウェブサイトは頻繁に更新されます。ThunderbitのようなAI型は自動対応しますが、大きな変更時は注意。

- 倫理的な利用を心がける:必要な範囲だけ抽出し、レポートや公開時は出典を明記しましょう。

さらに詳しいコツはやもご覧ください。

まとめ・ポイント

ウェブスクレイピングは、手作業のスクリプト時代から、今やAI搭載の初心者向けツールへと大きく進化しました。主な違いは?

- 従来型スクレイパーは細かい制御ができる反面、コーディングやメンテナンスが必要で手間がかかります。

- AIウェブスクレイパー(など)は、自然言語で操作でき、プレビューやサブページ抽出、定期実行など多彩な機能を誰でも簡単に使えます。

ウェブスクレイピングが初めてでも心配いりません。今はツールがとても使いやすくなり、ビジネス価値も高まっています。リード獲得、価格調査、手作業のコピペからの解放など、AIウェブスクレイパーがあなたの強い味方になります。

もし大量のウェブデータを前に途方に暮れたら、もう難しい知識やパーカーは不要。明確な目的と最適なツール、そしてコーヒーが一杯あれば十分です。

さっそくして、ウェブデータ抽出の手軽さを体感してみてください。

もっと知りたい方は、でAmazonやGoogle、PDFのスクレイピング事例などもご紹介しています。ハッピー・スクレイピング!

よくある質問

Q1: ウェブスクレイピングは合法ですか? A: 公開データのスクレイピングは多くの国で合法ですが、必ず各サイトの利用規約を確認し、個人情報や機密データの抽出は避けましょう。

Q2: ログインが必要なサイトもスクレイピングできますか? A: 可能ですが、より高度な設定や認証処理が必要で、サイトの規約違反となる場合もあります。法的リスクも必ず確認しましょう。

Q3: JavaScriptで動的に表示されるサイトのデータも抽出できますか? A: ヘッドレスブラウザや、JavaScriptレンダリングに対応したAIスクレイパーを使えば可能です。人間の操作をシミュレートし、動的コンテンツも取得できます。

Q4: ブロックされないためのコツは? A: リクエスト間隔を空ける、ランダムな遅延やユーザーエージェントの切り替えを行う、過度なアクセスを避けるなどが有効です。AI型スクレイパーはこれらを自動で最適化してくれることが多いです。

さらに詳しく知りたい方へ

-

法的ガイドラインや業界統計、倫理的なベストプラクティスを解説。

-

トレンド、市場成長、AIの役割など2024〜2025年の動向を紹介。

-

robots.txtの読み方や、適切なスクレイピングのためのポイントを解説。