正直なところ、Amazonってネットのショッピングモールであり、スーパーであり、家電量販店みたいな存在ですよね。営業やEC、オペレーションに関わっている人なら、Amazonの動きが自社の価格設定や在庫管理、次のヒット商品の企画にまで影響するのは当たり前に感じているはず。でも、ここで困るのが、あの膨大な商品情報や価格、評価、レビューが、消費者向けの画面の奥に隠れていて、データとして活用したい人にとっては簡単に手に入らないこと。じゃあ、1999年みたいに手作業でコピペせずに、どうやって効率よくデータを集めればいいの?って話ですよね。

そこで活躍するのがウェブスクレイピング。この記事では、Amazonの商品データを抽出する2つの方法を紹介します。1つは「pythonで自分でコードを書く」昔ながらのやり方、もう1つはThunderbitみたいなノーコードAIウェブスクレイパーを使う最新の方法です。実際のpythonコード(つまずきやすいポイントや回避策も含めて)を解説したあと、Thunderbitなら数クリックで同じデータが取れることも紹介します。エンジニアも、ビジネスアナリストも、手作業のデータ入力にうんざりしている人も、ぜひ参考にしてみてください。

なんでAmazonの商品データを抽出するの?(amazonスクレイパーpython, pythonでのウェブスクレイピング)

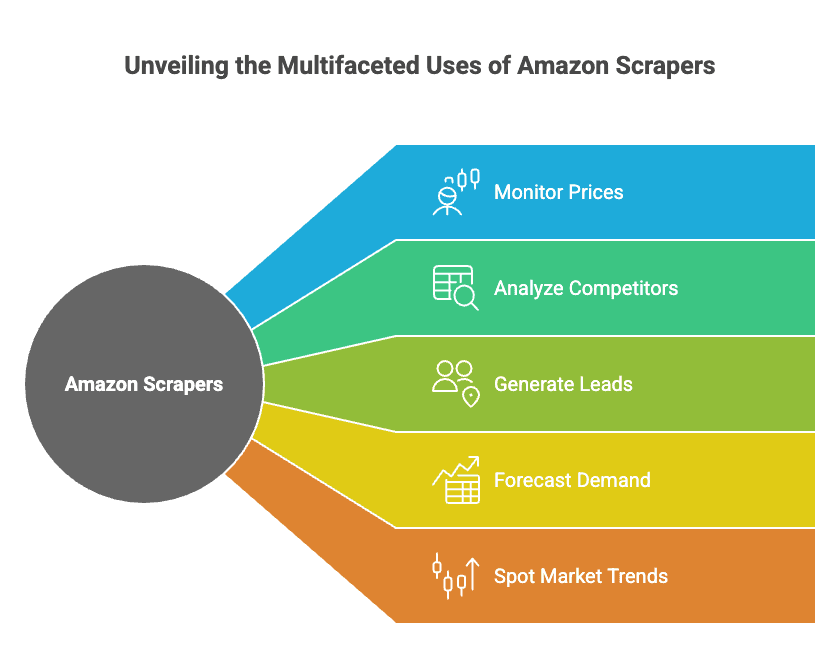

Amazonは世界最大級のオンライン小売業者であるだけじゃなく、競合分析のための巨大なオープンマーケットでもあります。とがいて、こんな目的で使われています:

- 価格のモニタリング(自社価格をリアルタイムで調整)

- 競合分析(新商品の動向や評価・レビューの追跡)

- リード獲得(セラーやサプライヤー、提携候補の発掘)

- 需要予測(在庫数や売上ランキングの監視)

- 市場トレンドの把握(レビューや検索結果から流行を発見)

これらは机上の空論じゃなく、実際のビジネスで大きな成果を生んでいます。たとえば、ある家電量販店はAmazonの価格データを活用してさせたり、別のブランドは競合価格の自動追跡でを実現しています。

主な活用例と期待できる効果はこんな感じです:

| ユースケース | 主な利用者 | 期待できる効果・ROI |

|---|---|---|

| 価格モニタリング | EC、オペレーション | 利益率15%以上向上、売上4%増、アナリスト作業30%削減 |

| 競合分析 | 営業、商品企画、オペレーション | 価格調整の迅速化、競争力強化 |

| 市場調査(レビュー分析) | 商品企画、マーケティング | 商品改善の高速化、広告文改善、SEOインサイト獲得 |

| リード獲得 | 営業 | 月3,000件以上のリード、担当者1人あたり週8時間以上の工数削減 |

| 在庫・需要予測 | オペレーション、サプライチェーン | 過剰在庫20%削減、欠品リスク低減 |

| トレンド発見 | マーケティング、経営層 | 人気商品や注目カテゴリの早期発見 |

さらに、がデータ分析の価値を実感しています。Amazonのデータを活用しないのは、ビジネスチャンスを逃しているのと同じですよ。

概要:AmazonスクレイパーPython vs ノーコードウェブスクレイパーツール

Amazonのデータをスプレッドシートやダッシュボードに取り込む方法は主に2つ。

-

amazonスクレイパーpython(pythonでのウェブスクレイピング)

RequestsやBeautifulSoupなどのpythonライブラリを使って自作スクリプトを書く方法。細かい制御ができるけど、コーディングやアンチボット対策、サイト変更時のメンテが必要です。

-

ノーコードウェブスクレイパーツール(Thunderbitなど)

ポイント&クリックでデータを抽出できるツールを使う方法。Thunderbitみたいな最新ツールはAIで抽出項目を自動判別、サブページやページ送りも対応、ExcelやGoogleスプレッドシートへのエクスポートもワンクリックです。

両者の比較はこんな感じ。

| 比較項目 | Pythonスクレイパー | ノーコード(Thunderbit) |

|---|---|---|

| 初期設定 | 高(インストール・コーディング・デバッグ) | 低(拡張機能を入れるだけ) |

| 必要スキル | コーディング必須 | 不要(ポイント&クリック) |

| 柔軟性 | 無制限 | 一般的な用途は高い柔軟性 |

| メンテナンス | 自分で修正 | ツールが自動で更新 |

| アンチボット対策 | プロキシやヘッダーを自分で設定 | 内蔵、ツール側で自動対応 |

| スケーラビリティ | 手動(スレッド・プロキシ管理) | クラウドで並列処理 |

| データ出力 | カスタム(CSV, Excel, DB) | ワンクリックでExcelやSheetsへ |

| コスト | 無料(時間+プロキシ代) | フリーミアム、規模に応じて課金 |

次の章では、まずpythonでAmazonスクレイパーを作る方法、続いてThunderbitのaiウェブスクレイパーで同じことをノーコードで実現する方法を解説します。

AmazonスクレイパーPython:準備とセットアップ

コードを書く前に、まずは開発環境を整えましょう。

必要なもの:

- Python 3.x(からダウンロード)

- コードエディタ(VS Code推奨、他でもOK)

- 使うライブラリ:

requests(HTTPリクエスト用)beautifulsoup4(HTML解析用)lxml(高速HTMLパーサー)pandas(データテーブル・エクスポート用)re(正規表現、標準搭載)

ライブラリのインストール:

1pip install requests beautifulsoup4 lxml pandasプロジェクトの準備:

- 新しいフォルダを作成

- エディタで新規Pythonファイル(例:

amazon_scraper.py)を作成 - これで準備OK!

ステップバイステップ:PythonでAmazon商品データをスクレイピング

まずはAmazonの商品ページ1件をスクレイピングしてみましょう。(複数商品やページ送りは後ほど解説します)

1. リクエスト送信とHTML取得

まずは商品ページのHTMLを取得します。(URLは任意のAmazon商品に差し替えてください)

1import requests

2url = "<https://www.amazon.com/dp/B0ExampleASIN>"

3response = requests.get(url)

4html_content = response.text

5print(response.status_code)注意: このままだとAmazonにブロックされやすく、503エラーやCAPTCHAが返ることがあります。Amazonは本物のブラウザからのアクセスかどうかをかなり厳しく見ています。

Amazonのアンチボット対策への対応

Amazonはボット対策がかなり厳しいので、こんな工夫が必要です:

- User-Agentヘッダーを設定(ChromeやFirefoxを装う)

- User-Agentをローテーション(毎回同じものを使わない)

- リクエスト間にランダムな遅延を入れる

- 大規模な場合はプロキシを利用

ヘッダーの設定例:

1headers = {

2 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)... Safari/537.36",

3 "Accept-Language": "en-US,en;q=0.9",

4}

5response = requests.get(url, headers=headers)もっと本格的にやるなら、User-Agentのリストを用意してリクエストごとに切り替えましょう。大規模なスクレイピングならプロキシサービスの利用も検討を。小規模ならヘッダーと遅延だけでも十分です。

主要な商品情報の抽出

HTMLが取れたら、BeautifulSoupで解析します。

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html_content, "lxml")ここから主要な情報を抜き出します:

商品タイトル

1title_elem = soup.find(id="productTitle")

2product_title = title_elem.get_text(strip=True) if title_elem else None価格

Amazonの価格は複数の場所にある場合があるので、以下を試してみてください:

1price = None

2price_elem = soup.find(id="priceblock_ourprice") or soup.find(id="priceblock_dealprice")

3if price_elem:

4 price = price_elem.get_text(strip=True)

5else:

6 price_whole = soup.find("span", {"class": "a-price-whole"})

7 price_frac = soup.find("span", {"class": "a-price-fraction"})

8 if price_whole and price_frac:

9 price = price_whole.text + price_frac.text評価とレビュー数

1rating_elem = soup.find("span", {"class": "a-icon-alt"})

2rating = rating_elem.get_text(strip=True) if rating_elem else None

3review_count_elem = soup.find(id="acrCustomerReviewText")

4reviews_text = review_count_elem.get_text(strip=True) if review_count_elem else ""

5reviews_count = reviews_text.split()[0] # 例:"1,554 ratings"メイン画像URL

Amazonは高解像度画像をHTML内のJSONに隠していることも。正規表現で抽出する例:

1import re

2match = re.search(r'"hiRes":"(https://.*?.jpg)"', html_content)

3main_image_url = match.group(1) if match else Noneまたは、メイン画像タグから取得:

1img_tag = soup.find("img", {"id": "landingImage"})

2img_url = img_tag['src'] if img_tag else None商品詳細

ブランドや重量、サイズなどのスペックはテーブルにあることが多いです:

1details = {}

2rows = soup.select("#productDetails_techSpec_section_1 tr")

3for row in rows:

4 header = row.find("th").get_text(strip=True)

5 value = row.find("td").get_text(strip=True)

6 details[header] = valueまたは「detailBullets」形式の場合:

1bullets = soup.select("#detailBullets_feature_div li")

2for li in bullets:

3 txt = li.get_text(" ", strip=True)

4 if ":" in txt:

5 key, val = txt.split(":", 1)

6 details[key.strip()] = val.strip()結果の出力例:

1print("Title:", product_title)

2print("Price:", price)

3print("Rating:", rating, "based on", reviews_count, "reviews")

4print("Main image URL:", main_image_url)

5print("Details:", details)複数商品のスクレイピングとページ送り対応

1商品だけじゃなく、リスト全体を取得したい場合はこんな感じ。

検索結果ページから商品リンクを取得

1search_url = "<https://www.amazon.com/s?k=bluetooth+headphones>"

2res = requests.get(search_url, headers=headers)

3soup = BeautifulSoup(res.text, "lxml")

4product_links = []

5for a in soup.select("h2 a.a-link-normal"):

6 href = a['href']

7 full_url = "<https://www.amazon.com>" + href

8 product_links.append(full_url)ページ送りの処理

Amazonの検索URLは&page=2、&page=3みたいにページ番号を指定できます。

1for page in range(1, 6): # 最初の5ページを取得

2 search_url = f"<https://www.amazon.com/s?k=bluetooth+headphones&page={page}>"

3 res = requests.get(search_url, headers=headers)

4 if res.status_code != 200:

5 break

6 soup = BeautifulSoup(res.text, "lxml")

7 # ... 上記と同様に商品リンクを抽出 ...商品ページをループしてCSVにエクスポート

商品データを辞書のリストでまとめて、pandasで出力します:

1import pandas as pd

2df = pd.DataFrame(product_data_list) # 辞書のリスト

3df.to_csv("amazon_products.csv", index=False)Excel出力もOK:

1df.to_excel("amazon_products.xlsx", index=False)AmazonスクレイパーPythonプロジェクトのベストプラクティス

Amazonは頻繁にサイト構造を変えたり、スクレイパー対策も強化しています。安定運用のためのポイントはこんな感じ:

- ヘッダーやUser-Agentのローテーション(

fake-useragentライブラリなど活用) - 大規模時はプロキシ利用

- リクエスト間にランダムな遅延(

time.sleep()) - エラー時のリトライやブロック時のバックオフ

- 柔軟なパースロジック(複数のセレクタを用意)

- HTML構造の変化を監視(突然すべてNoneになったら要確認)

- robots.txtの遵守(Amazonは多くの領域でスクレイピングを禁止しています。節度を持って使いましょう)

- データのクリーニング(通貨記号やカンマ、空白の除去)

- コミュニティとの情報交換(フォーラム、Stack Overflow、Redditのr/webscrapingなど)

スクレイパー運用チェックリスト:

- [ ] User-Agentやヘッダーのローテーション

- [ ] 大規模時はプロキシ利用

- [ ] ランダムな遅延の追加

- [ ] コードをモジュール化して保守性向上

- [ ] BANやCAPTCHAの監視

- [ ] 定期的なデータエクスポート

- [ ] セレクタやロジックのドキュメント化

もっと詳しく知りたい人はもチェックしてみてください。

ノーコードでAmazonをスクレイピング:Thunderbit aiウェブスクレイパー

ここまでpythonでの方法を紹介しましたが、「コードは書きたくない」「とにかくすぐデータが欲しい」って人にはThunderbitがぴったり。

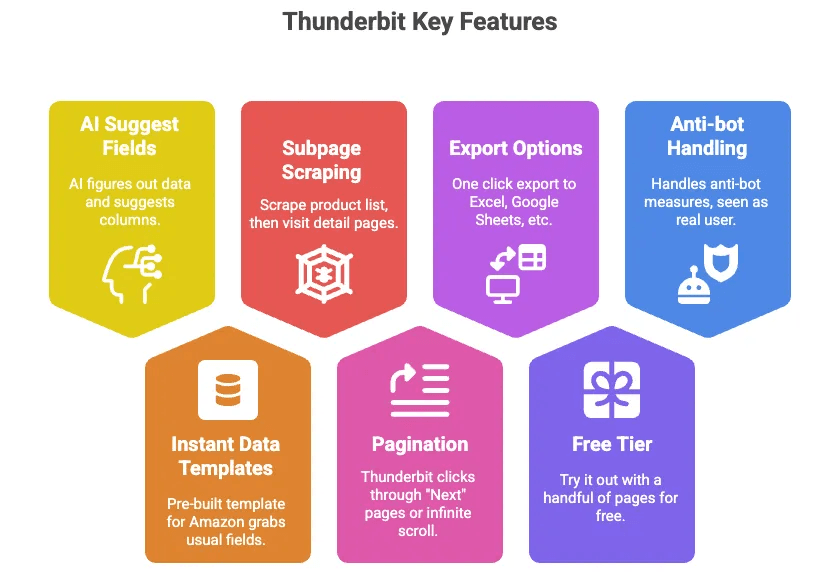

Thunderbitは、Amazonをはじめあらゆるウェブサイトから商品データをノーコードで抽出できるaiウェブスクレイパーのChrome拡張機能です。主な特長はこんな感じ:

- AIによる項目自動提案: ボタン1つでページ内のデータをAIが自動判別し、タイトル・価格・評価などのカラムを提案

- すぐ使えるデータテンプレート: Amazon用のテンプレートが用意されていて、面倒な設定不要

- サブページの自動巡回: 商品リストから各商品詳細ページに自動でアクセスし、追加情報も取得

- ページ送り対応: 「次へ」や無限スクロールも自動で処理

- Excel・Googleスプレッドシート・Airtable・Notionにエクスポート: ワンクリックでデータを出力

- 無料プランあり: まずは数ページ分を無料でお試し可能

- アンチボット対策も自動: ブラウザ上やクラウドで動作するので、Amazonからは本物のユーザーとして認識されやすい

ThunderbitでAmazon商品データを抽出する手順

操作はめちゃくちゃ簡単です:

-

Thunderbitをインストール

をダウンロードしてサインイン。

-

Amazonを開く

抽出したいAmazonのページ(検索結果や商品詳細など)を開きます。

-

「AIで項目提案」またはテンプレートを選択

Thunderbitが自動で抽出カラムを提案(またはAmazon商品テンプレートを選択)

-

カラムを確認・調整

必要に応じてカラムの追加・削除や名称変更もOK

-

「スクレイピング」ボタンをクリック

ページ内のデータがテーブル形式で表示されます

-

サブページ・ページ送り対応

リストを抽出した場合は「サブページをスクレイピング」で各商品詳細も自動取得。ページ送りも自動化できます

-

データをエクスポート

「Excelにエクスポート」や「Googleスプレッドシートにエクスポート」をクリックするだけ

-

(オプション)定期スクレイピングの設定

毎日自動でデータ取得したい場合はスケジューラー機能も使えます

これだけで、コードもデバッグもプロキシも不要。詳しい操作はやも参考にどうぞ。

AmazonスクレイパーPython vs ノーコードウェブスクレイパー:比較表

まとめると、両者の違いはこんな感じです:

| 比較項目 | Pythonスクレイパー | Thunderbit(ノーコード) |

|---|---|---|

| 初期設定 | 高(インストール・コーディング・デバッグ) | 低(拡張機能を入れるだけ) |

| 必要スキル | コーディング必須 | 不要(ポイント&クリック) |

| 柔軟性 | 無制限 | 一般的な用途は高い柔軟性 |

| メンテナンス | 自分で修正 | ツールが自動で更新 |

| アンチボット対策 | プロキシやヘッダーを自分で設定 | 内蔵、ツール側で自動対応 |

| スケーラビリティ | 手動(スレッド・プロキシ管理) | クラウドで並列処理 |

| データ出力 | カスタム(CSV, Excel, DB) | ワンクリックでExcelやSheetsへ |

| コスト | 無料(時間+プロキシ代) | フリーミアム、規模に応じて課金 |

| おすすめ対象 | 開発者・カスタム用途 | ビジネスユーザー・迅速な結果重視 |

カスタマイズ性やシステム連携が必要な開発者にはpython、スピードや手軽さ重視ならThunderbitが最適です。

Python・ノーコード・aiウェブスクレイパーの使い分け

pythonを選ぶべきケース:

- 独自ロジックやシステム連携が必要な場合

- 数万件以上の大規模データを扱う場合

- スクレイピングの仕組みを学びたい場合

Thunderbit(ノーコード・aiウェブスクレイパー)を選ぶべきケース:

- コーディング不要ですぐにデータが欲しい場合

- ビジネスユーザー・アナリスト・マーケター

- チームで誰でもデータ取得できるようにしたい場合

- プロキシやアンチボット対策、保守の手間を省きたい場合

両方を使い分ける場合:

- Thunderbitで素早くプロトタイプ、本番はpythonでカスタム構築

- Thunderbitでデータ収集、pythonでデータ加工・分析

多くのビジネス用途はThunderbitで90%カバーできます。超大規模や特殊な要件はpythonが活躍します。

まとめ・ポイント

Amazonの商品データを取れるようになると、営業・EC・オペレーションの現場でめちゃくちゃ強い武器になります。価格追跡や競合分析、手作業のコピペからの解放まで、使い道は本当にいろいろ。

- pythonによるスクレイピングは自由度が高いけど、学習コストや保守が必要

- Thunderbitみたいなノーコードウェブスクレイパーなら誰でも簡単にAmazonデータを抽出可能。面倒な設定やトラブルもなし

- 最適な方法は、あなたのスキル・目的・納期に合わせて選ぼう

まずはThunderbitを無料で試してみてください。驚くほど簡単にデータが手に入ります。エンジニアの人も、AIに面倒な部分を任せて効率化するのがおすすめです。

よくある質問(FAQ)

1. なぜ企業はAmazonの商品データをスクレイピングしたいの?

Amazonのデータを取ることで、価格監視、競合分析、レビュー収集による商品企画、需要予測、営業リード獲得などが可能です。6億点以上の商品と約200万のセラーがいるので、競争力強化に欠かせない情報源です。

2. pythonとThunderbitみたいなノーコードツールの違いは?

pythonは柔軟性が高い反面、コーディングやセットアップ、保守が必要。Thunderbitはノーコードのaiウェブスクレイパーで、Chrome拡張機能からすぐにAmazonデータを抽出可能。アンチボット対策やExcel/Sheetsへのエクスポートも内蔵されています。

3. Amazonからデータをスクレイピングするのは合法?

Amazonの利用規約ではスクレイピングを原則禁止していて、アンチボット対策も厳しいです。ただ、多くの企業が公開情報の範囲で節度を守って活用しています(リクエスト頻度を抑える、過剰なアクセスを避けるなど)。

4. ウェブスクレイピングツールでAmazonからどんなデータが取れる?

商品タイトル、価格、評価、レビュー数、画像、スペック、在庫状況、セラー情報などが一般的です。Thunderbitはサブページやページ送りにも対応し、複数リスト・ページのデータもまとめて取得できます。

5. pythonとThunderbit、どっちを選ぶべき?

カスタムロジックやシステム連携が必要ならpython、手軽さやスピード重視ならThunderbitがおすすめ。ビジネスユーザーやスケール重視、保守の手間を減らしたい場合もThunderbitが最適です。

さらに詳しく知りたい人はこちら:

スクレイピングを活用して、いつでも最新のデータを手に入れましょう!