ネット上にはとんでもない量のデータが転がってるけど、正直、手作業でコピペなんてやってられないよね。2025年にもなって、リード情報を1件ずつ集めたり、競合の価格を手で追いかけてるなら、まるでみんなが電動自転車で爆走してる中、自分だけスローモーションで走ってる感じ。だけど、今はAIウェブスクレイパーがあるから、営業やマーケ、オペレーションの現場でも、複雑なウェブサイトからサクッと整理されたデータを引っこ抜ける時代。しかも、プログラミングなんて一切不要!

SaaSや自動化の現場で長年やってきた自分が断言するけど、ちゃんとしたAIウェブスクレイパーを使えば、チームの作業時間を何百時間も節約できるし、精度もグッと上がる。リスト作成や市場調査、日々の業務効率化まで、2025年に注目のAIウェブスクレイパーツールを10個ピックアップしたよ。きっとあなたの仕事にピッタリなツールが見つかるし、週末の自由時間も取り戻せるはず!

なんでAIウェブスクレイパーが生産性アップに欠かせないの?

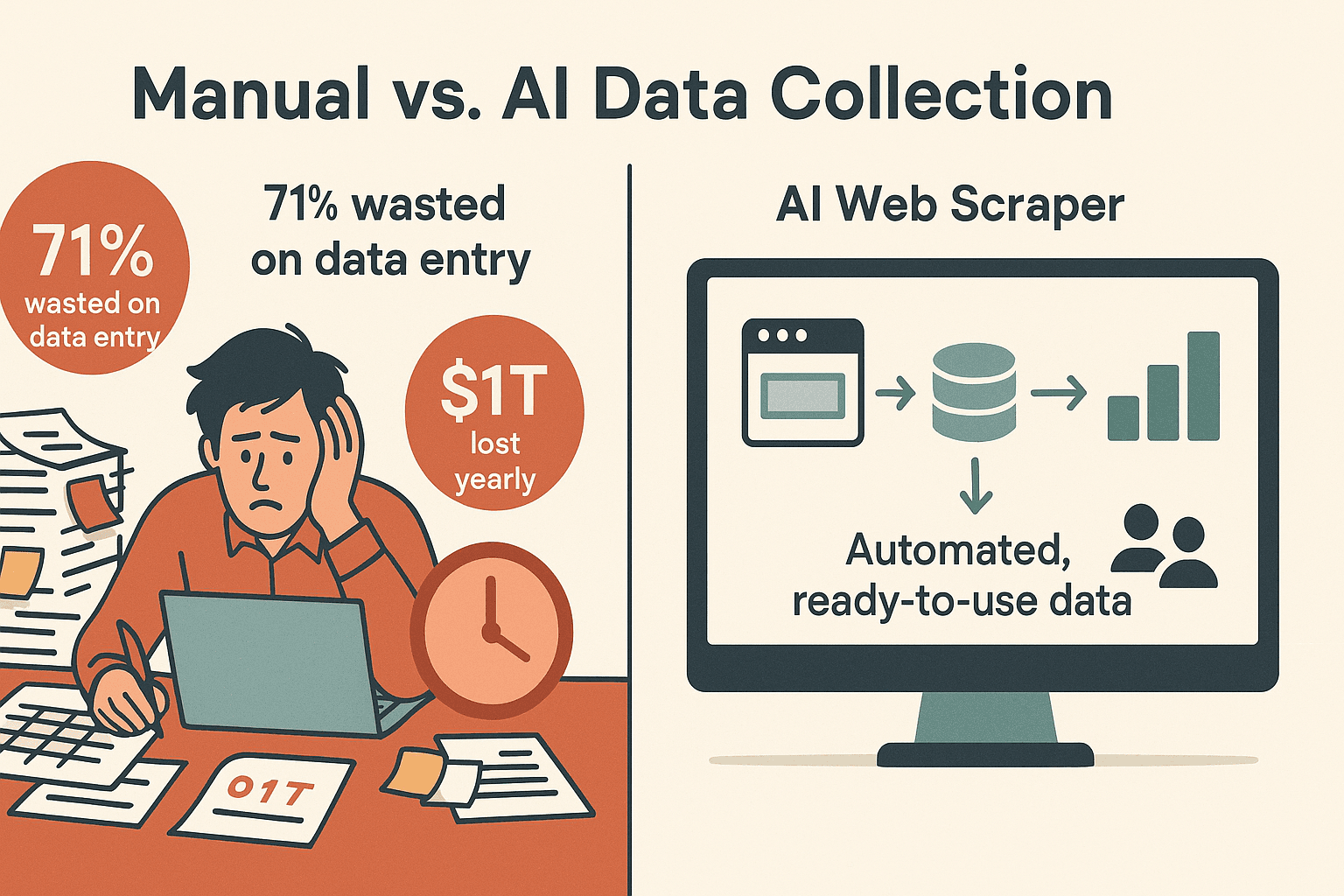

結論から言うと、手作業でデータ集めてると生産性がガタ落ちする。が「データ入力に時間取られすぎ!」って感じてて、リード管理のミスや時間のムダは、企業にもの損失を生んでる。AIウェブスクレイパーなら、こういう繰り返し作業を自動化して、ウェブサイトをすぐ使えるデータに変えてくれる。

AIウェブスクレイパーがビジネス現場で必須になった理由はこんな感じ:

- 圧倒的な時短: AIスクレイパーを使えば、手作業より30〜40%も早くデータ収集できて、分析や意思決定に集中できる()。

- 高精度: AIの抽出は)で、複雑なサイトでもキレイなデータが手に入る。

- 複雑なサイトも余裕: 最新AIスクレイパーは、JavaScriptや無限スクロール、ログイン、サブページも自動で処理。「もっと見る」で止まる心配なし。

- ノーコード: ほとんどのツールは直感的な操作や自然言語で使えるから、プログラミング経験ゼロでもすぐ使える。

主なビジネス活用例:

- リード獲得: ディレクトリやLinkedIn、イベントサイトから見込み客を抽出。

- 競合調査: ECサイトで価格やSKU、レビューを自動収集。

- 市場調査: 記事やリスティング、フォーラム投稿をまとめて分析。

- 業務効率化: 商品仕様やコンプライアンス情報、サプライヤーデータをIT部門に頼らず取得。

で、データ活用を重視するチームの強力な武器になってるよ。

ベストaiウェブスクレイパーの選び方

AI機能や使いやすさはツールごとに全然違う。今回の10選は、こんなポイントを重視して選んだよ:

- 使いやすさ: エンジニアじゃなくても数分で結果が出せる?ノーコードやAIアシスタントがある?

- 自動化性能: ページ送りやサブページ、ログイン、動的コンテンツに対応できる?定期実行できる?

- データ出力・連携: Excel、Google Sheets、Airtable、Notion、API連携できる?

- 拡張性: クラウドスクレイピングや同時実行、大規模処理に対応してる?

- 価格: 無料プランやトライアルがある?ビジネス用途でも手頃?

- サポート・コミュニティ: ドキュメントやチュートリアル、サポート体制は充実してる?

それぞれのツールの個性を紹介していくよ。

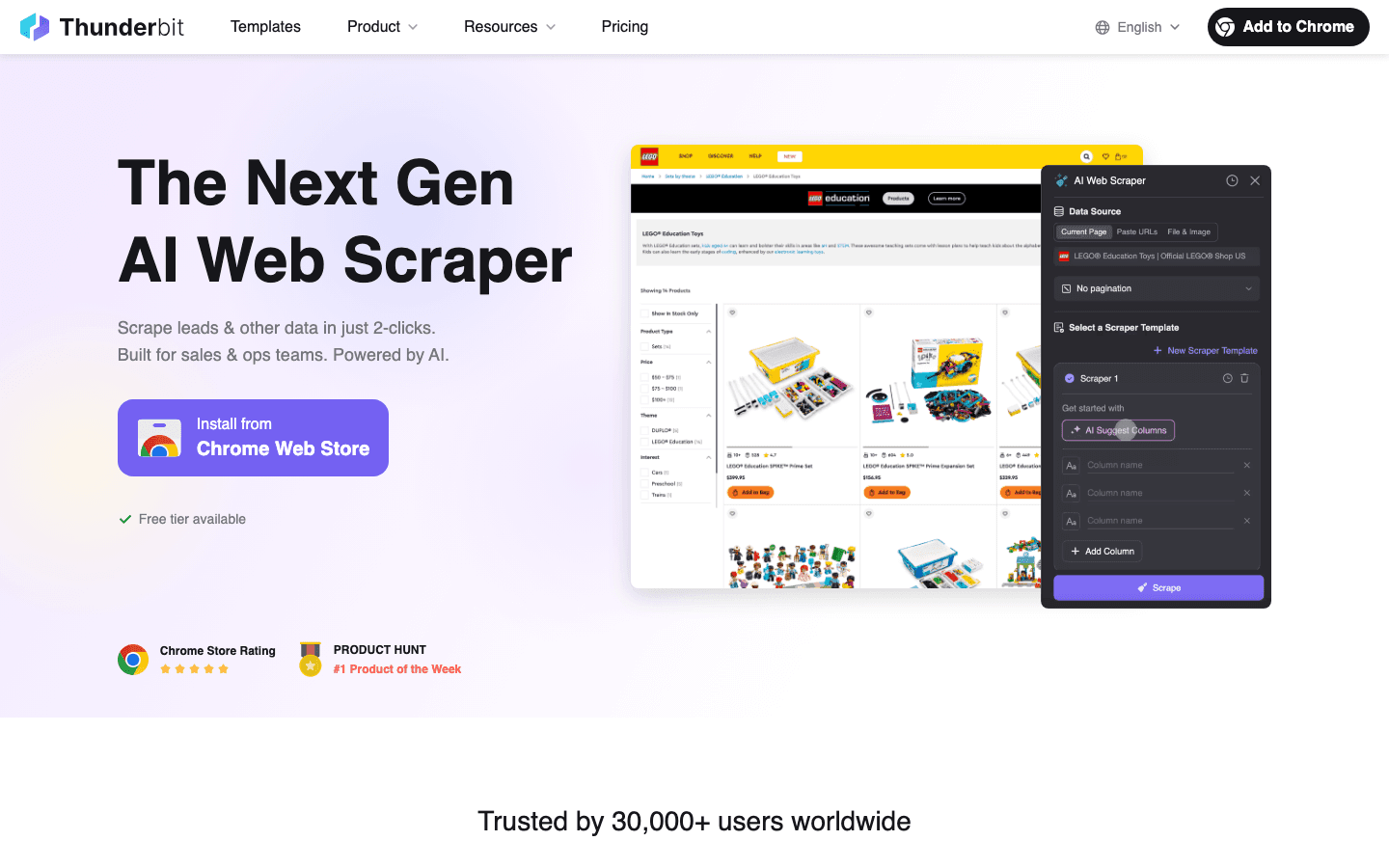

1. Thunderbit:AIウェブスクレイパーでデータ抽出が超ラク

は、「このデータ欲しい!」と思ったら5分以内にスプレッドシート化できる、イチオシのツール。Chrome拡張で、たった2クリックでスクレイピング完了。「AIでフィールドを提案」→「スクレイプ」って進めば、AIがページを解析して必要な情報を自動で抜き出してくれる。

主な特徴:

- AIで2クリック抽出: テンプレやコーディング不要。AIが自動で抽出項目を判別。

- サブページ・ページ送り対応: リストからサブページまで自動で詳細データを取得。

- 即時テンプレート: Amazon、Zillow、Googleマップなど人気サイトはワンクリックでOK。

- 無料データエクスポート: Excel、Google Sheets、Airtable、Notionへ追加料金なしで出力。

- AIオートフィル: AIがウェブフォーム入力も自動化(繰り返し作業に最適)。

- スケジュールクラウドスクレイピング: 「毎週月曜9時」みたいに自然言語で定期実行を設定できる。

- 多言語対応: 34言語に対応。

- 無料のメール・電話番号・画像抽出: 連絡先や画像もワンクリックで取得。

メリット:

- 非エンジニアでもすぐ使える手軽さ。

- 複雑な動的サイトやサブページも高精度で対応。

- 有料プランで全てのエクスポート・高度機能が使える。

- 無料枠も充実(6ページ/月、トライアルで10ページ)。

デメリット:

- クレジット制だから大量利用は有料プランが必要。

- めちゃくちゃ複雑なサイトはAIプロンプトの調整が必要な場合あり。

- CRMとの直接連携は未対応(APIは利用可能)。

料金:

- 無料:6ページ/月(1ページあたり行数無制限)。

- 有料:月15ドル(500クレジット)〜月249ドル(20,000クレジット)。

おすすめ用途:

営業・マーケ・オペレーション部門で、コーディングや面倒な設定なしにサクッと正確なデータを取りたい人。リード獲得、競合調査、EC価格追跡にピッタリ。

気になる人はして無料で試してみて!

2. Octoparse:ビジュアル操作で大量データを一気に抽出

は、ノーコードスクレイピングの老舗。ドラッグ&ドロップの直感操作と大量データの一括抽出が強み。Windows/Mac対応のデスクトップアプリで、サイトをクリックしていくだけでワークフローを自動記録。

主な特徴:

- ビジュアルワークフローデザイナー: コード不要で直感的にスクレイパーを作成。

- クラウド&ローカル実行: PCでもクラウドでもジョブを実行可能。

- 100以上のサイトテンプレート: Amazon、eBay、Twitter、Googleマップなど主要サイトに対応。

- スマートモード: AIがリストデータを自動検出し、セットアップが簡単。

- ログイン・AJAX・無限スクロール対応: 動的サイトにも強い。

- CSV、Excel、JSON、HTML、API出力対応。

メリット:

- 初心者にも使いやすく、上級者にも対応。

- 豊富なテンプレートライブラリ。

- クラウドスケジューリングで定期実行も簡単。

- 多言語対応。

デメリット:

- Windows/Mac専用(LinuxやWeb版はなし)。

- 高度な機能(XPathやロジック)は学習が必要。

- 無料プランは制限あり。大量利用は高額になる場合も。

料金:

- 無料プラン(10タスクまで)。

- スタンダード:約月75ドル(年払い)。

- プロフェッショナル:約月209ドル(年払い)。

おすすめ用途:

テンプレートを活用したいアナリストや中小企業、定期的に大量データを集めたい人におすすめ。

3. ParseHub:複雑なウェブサイトもOKな高機能ビジュアルスクレイパー

は、Windows/Mac/Linux対応のデスクトップアプリ。JavaScript多用のページや無限スクロール、複雑なナビゲーションにも強い。

主な特徴:

- ビジュアルワークフロービルダー: 要素をクリックしてループやアクションを設定。

- AJAX・地図・ログイン対応: 難易度の高いサイトにも対応。

- スケジュール実行: 定期的なジョブも可能(有料プラン)。

- クロスプラットフォーム: Windows、Mac、Linuxで利用可能。

- JSON、CSV、Excel出力対応。

メリット:

- 動的・インタラクティブなサイトの抽出に最適。

- 無料枠が充実(1回200ページ、5プロジェクトまで)。

- クロスプラットフォーム対応。

デメリット:

- 基本的にローカル実行(PCを起動しておく必要あり)。

- 高度なワークフローは学習が必要。

- 有料プランはライトユーザーには割高。

料金:

- 無料:5プロジェクト、1回200ページまで。

- スタンダード:月189ドル(1回10,000ページ)。

- プロフェッショナル:月599ドル(無制限)。

おすすめ用途:

技術に強いユーザーやデータジャーナリスト、動的コンテンツが多いサイトを扱うチーム向け。

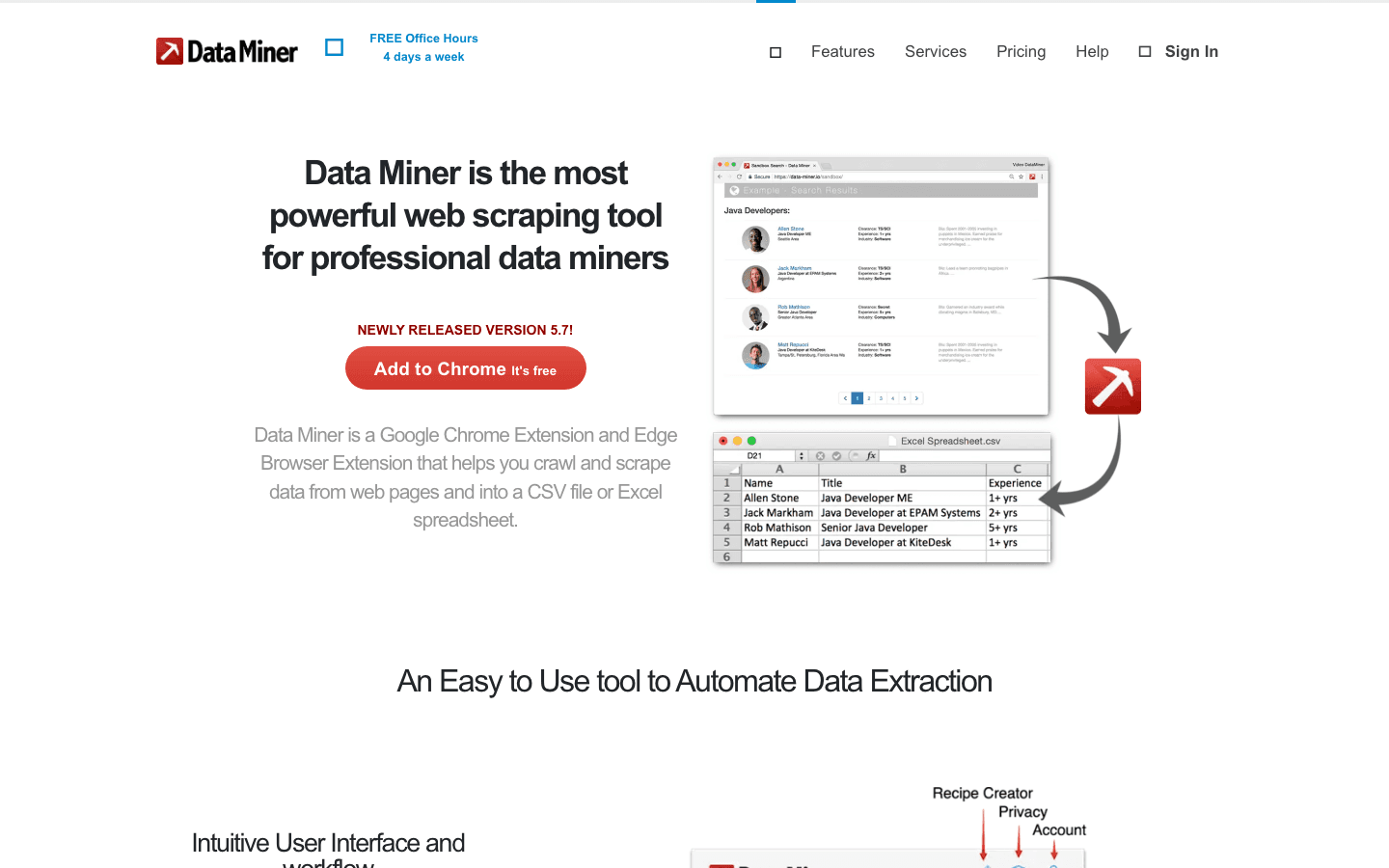

4. DataMiner:ブラウザ拡張でテーブル・リスト抽出が超簡単

は、Chrome/Edge対応の拡張機能で、テーブルやリストを数クリックで抽出できる。最大の特徴は、6万件以上の「レシピ」(抽出テンプレート)が用意されてること。

主な特徴:

- ポイント&クリックでデータ選択: ブラウザ上で直接テーブルやリストを選択。

- レシピライブラリ: Google、Amazon、LinkedInなど主要サイトにワンクリック対応。

- ページ送り対応: 「次へ」ボタンも自動でクリックし、結果を統合。

- Google Sheets連携: データを直接スプレッドシートに送信。

- クラウドスクレイピング(有料プラン): サーバー上でジョブ実行。

メリット:

- 短時間で手軽にデータ取得。

- 豊富なレシピライブラリ。

- 無料トレーニングやサポートも充実。

デメリット:

- 無料プランは月500ページまで。

- 高度な機能(多階層クロールや自動化)は学習と有料プランが必要。

- IPローテーションは非搭載のため、大量抽出には不向き。

料金:

- 無料:月500ページまで。

- Solo:月19.99ドル(500ページ、全機能)。

- Small Business:月49ドル(1,000ページ)。

- Business:月99ドル(4,000ページ)。

おすすめ用途:

営業・マーケ・リサーチ担当で、ブラウザからすぐにスプレッドシート向けデータを取りたい人。

5. Scrapy:開発者向けのオープンソース高機能フレームワーク

は、Pythonベースのオープンソースフレームワークで、カスタムクローラーや大規模スクレイピングに最適な開発者向けツール。

主な特徴:

- コードベース: Pythonで独自のスパイダーを作成。

- 高速・非同期クロール: 1時間で数千ページの抽出も可能。

- 拡張性: プロキシやCAPTCHA、カスタムパースなど自由に追加。

- CSV、JSON、データベースなど多様な出力形式。

- 大規模なコミュニティとエコシステム。

メリット:

- 柔軟性・拡張性が無限大。

- 完全無料(オープンソース)。

- どんなワークフローやデータパイプラインにも統合可能。

デメリット:

- Pythonの知識が必須で、非エンジニアにはハードル高め。

- JavaScript主体のサイトは標準では非対応(ヘッドレスブラウザ連携が必要)。

- インフラやメンテナンスは自分で管理。

料金:

- 無料(セルフホスト、オープンソース)。

おすすめ用途:

開発チームやデータエンジニアが大規模・カスタムスクレイピングを構築する場合に最適。

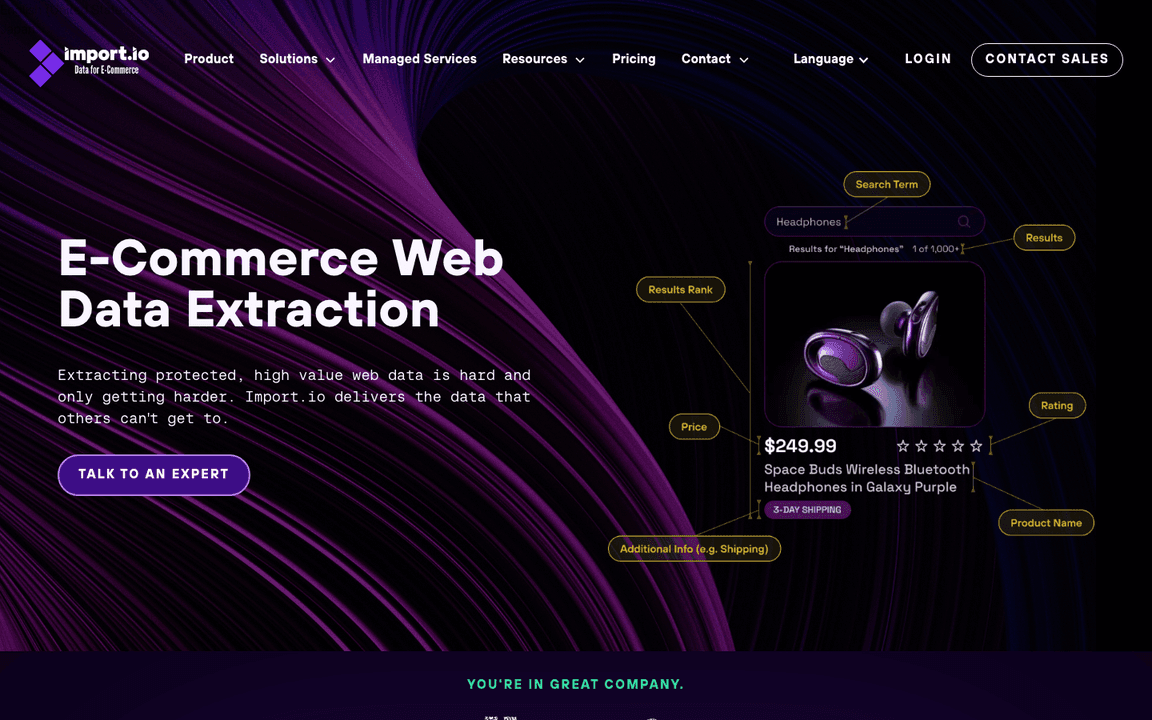

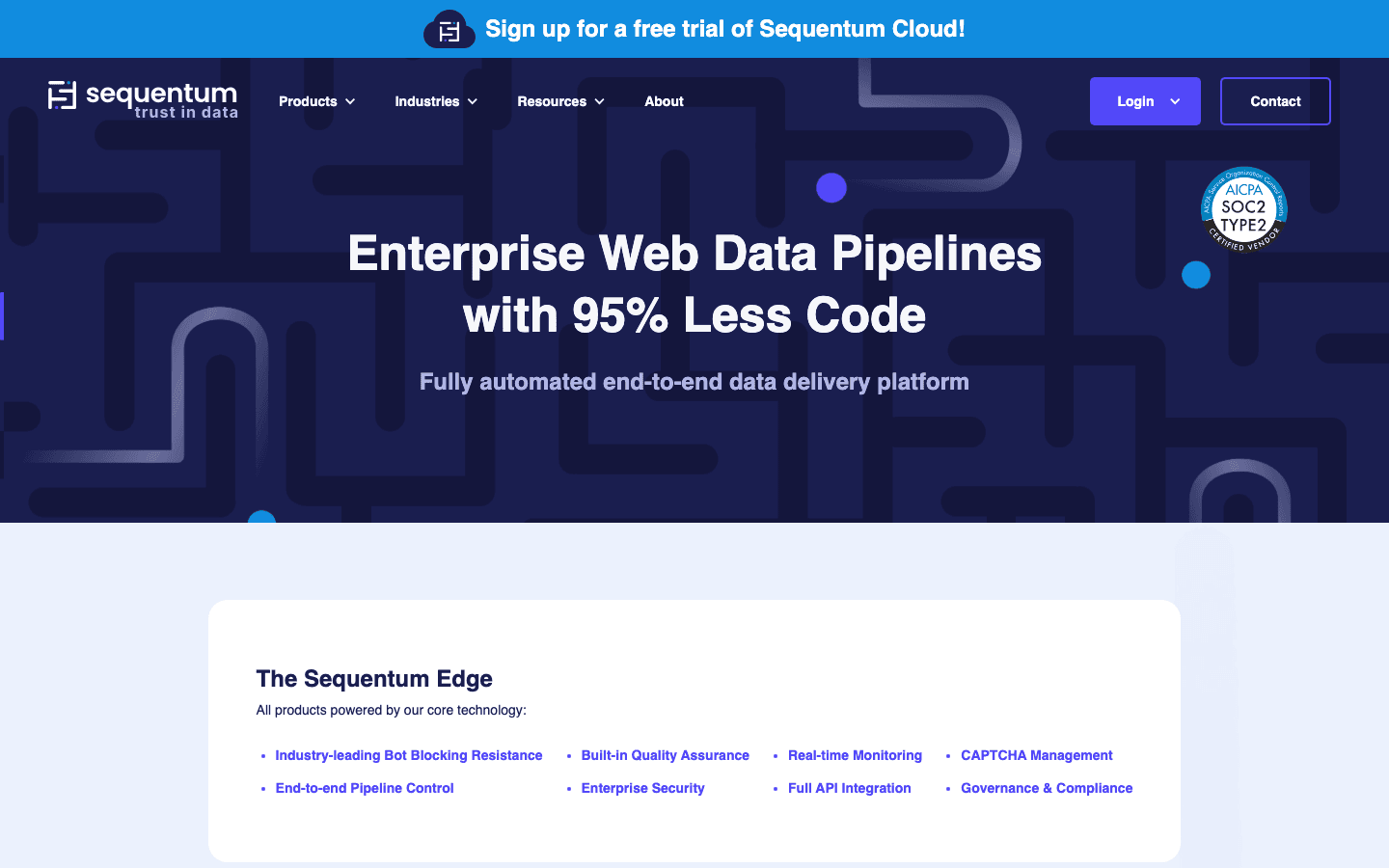

6. Import.io:大規模データ向けエンタープライズAIウェブスクレイパー

は、ビジュアル抽出・機械学習・高機能なデータ変換を組み合わせたエンタープライズ向けプラットフォーム。

主な特徴:

- ビジュアル抽出: コード不要で抽出設定。

- チェーン抽出: リストからサブページまで自動クロール。

- データクリーニング・変換: 標準化や品質管理機能を搭載。

- スケジューリング・API連携: 定期実行やBIツール連携も可能。

- エンタープライズ管理: ユーザー管理、監査ログ、SLA対応。

メリット:

- 大規模・複雑なプロジェクトも高信頼で対応。

- データ品質・変換に強み。

- 専任サポートやSLAも充実。

デメリット:

- 価格は高め(数百〜1,000ドル/月〜)。

- 小規模・単発案件には不向き。

- 導入や設定にやや手間がかかる。

料金:

- カスタム見積(約月499ドル〜)。

- 無料トライアルあり。

おすすめ用途:

大企業やデータ重視の組織で、信頼性の高い大規模ウェブデータが必要な場合。

7. WebHarvy:パターン検出で簡単ビジュアルスクレイピング

は、Windows専用のデスクトップアプリで、欲しいデータをクリックするだけで自動的にリスト全体を抽出できる。パターン検出機能で、同じ種類のデータをまとめて取得可能。

主な特徴:

- ポイント&クリック操作: 欲しいデータをクリックするだけ。

- 自動パターン検出: セレクタ設定不要。

- 複数ページ・画像抽出: ページ送りや画像ダウンロードも対応。

- フォーム入力・キーワード抽出: 検索自動化や結果抽出も可能。

- 買い切りライセンス: 一度購入すればずっと使える。

メリット:

- 初心者にも非常に使いやすい。

- 長期利用ならコスパ抜群。

- オフライン利用可能でデータはPC内に保存。

デメリット:

- Windows専用(Mac/Linux非対応)。

- クラウド機能なし(定期実行はPCを起動しておく必要あり)。

- 高度な動的サイトはスクリプトが必要な場合も。

料金:

- 1台あたり129ドル(1年間のアップデート付き)。

- 15日間無料トライアル。

おすすめ用途:

Windowsユーザーの個人事業主や小規模ビジネス、定期的なデータ抽出を手軽にやりたい人。

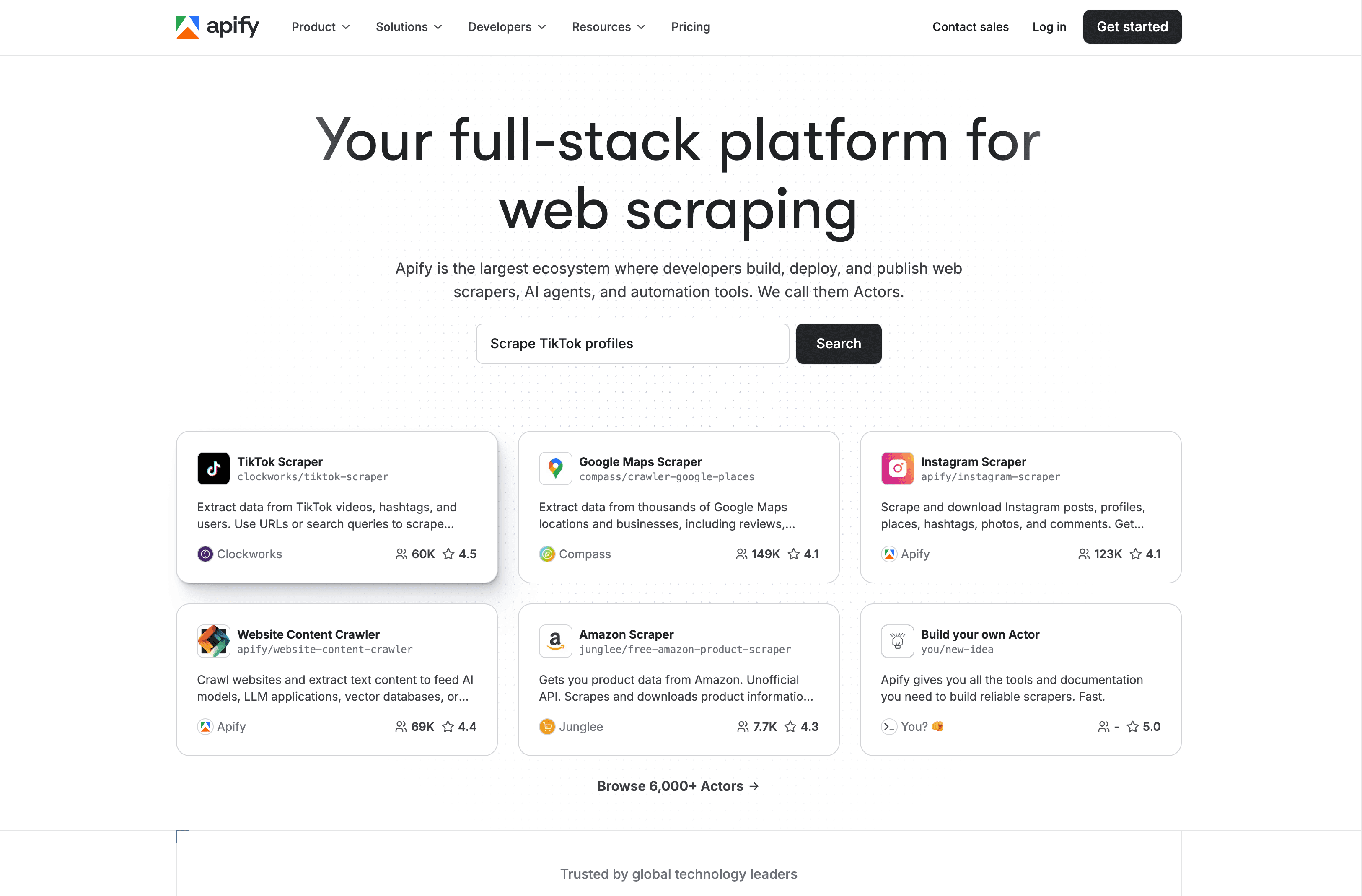

8. Apify:クラウド自動化&AIウェブスクレイピングのマーケットプレイス

は、クラウド上で動作し、5,000以上の「アクター」(スクレイピングボット)が揃うマーケットプレイスと、JavaScriptやPythonでのカスタムスクリプト実行が特徴。

主な特徴:

- 5,000以上のアクター: Googleマップ、Amazon、Facebookなど主要サイト向けのワンクリックスクレイパー。

- カスタムスクリプト対応: Node.jsやPythonで独自ボット作成。

- クラウドインフラ: スケーリング、スケジューリング、プロキシ、ストレージも自動化。

- API・連携: Zapier、Make、Google Sheets、AWSなどと連携可能。

- アンチブロック機能: IPローテーションやリトライ機能。

メリット:

- 既成ボットとカスタム開発の両立。

- 大規模プロジェクトにも柔軟に対応。

- コミュニティが活発で連携も豊富。

デメリット:

- 初心者にはやや複雑なインターフェース。

- クレジット制の料金体系が分かりづらい。

- コミュニティ製アクターはメンテナンス状況にばらつきあり。

料金:

- 無料枠(クレジット制限あり)。

- Personal:月49ドル。

- Scale:月499ドル。

- Enterprise:月999ドル〜。

おすすめ用途:

開発者や技術に強いチーム、大規模・カスタマイズ可能なスクレイピングが必要な人。既成ボットを活用したい場合にも最適。

9. Dexi.io:クラウド型AIウェブスクレイパーで業務自動化

(旧CloudScrape)は、複雑なウェブデータワークフローを自動化できるエンタープライズ向けクラウドプラットフォーム。RPA的な使い方もできる。

主な特徴:

- ビジュアルロボットビルダー: ロジックやループ、条件分岐を使ったワークフロー設計。

- クラウド実行: Dexiのサーバー上でロボットが稼働。

- データ変換・連携: データベースやAPI、分析ツールへの出力も簡単。

- チームコラボレーション: 複数ユーザー、バージョン管理、権限設定対応。

- スケジューリング・モニタリング: 定期実行やパフォーマンス監視も可能。

メリット:

- 複数工程・チーム連携の自動化に最適。

- 連携・後処理機能が充実。

- エンタープライズ規模でも信頼性高い。

デメリット:

- 高度なワークフローは学習コスト高め。

- 価格は月119ドル〜とやや高額。

- ユーザーコミュニティは小さめで、サポートはDexiチーム依存。

料金:

- 月119ドル〜。

- 無料トライアルあり。

おすすめ用途:

中〜大規模企業や代理店で、複雑なウェブデータワークフローをチームで自動化したい場合。

10. Content Grabber:パワーユーザー向けの自動化・連携特化型

は、Windows専用のエンタープライズ向けスクレイピングプラットフォームで、IT部門やパワーユーザー向けに高度な自動化・連携機能を備えてる。

主な特徴:

- フルIDE環境: ビジュアルエディタ+C#やVB.NETでのスクリプト対応。

- スケジューラ・ログ機能: 自動実行・監視・アラートも可能。

- データベース・API連携: SQL、XML、JSON、Excelへ直接出力。

- スタンドアロン実行ファイル: .EXE形式で配布可能。

- エンタープライズ管理コンソール: 大規模展開も一元管理。

メリット:

- 圧倒的な機能と拡張性。

- オンプレミス運用で機密データも安心。

- 買い切り・サブスク両方の料金体系。

デメリット:

- 学習コストが高く、技術者向け。

- Windows専用。

- 小規模案件には初期費用が高め。

料金:

- プロフェッショナル:約995ドル(買い切り)または月149ドル。

- プレミアム:約2,495ドル(買い切り)または月299ドル。

- サーバー版:年449ドル。

おすすめ用途:

大企業やIT部門、データプロバイダーで、大規模・高度なカスタマイズや連携が必要な場合。

AIウェブスクレイパーツール比較表(一覧)

| ツール名 | 主な特徴 | 料金(最安) | おすすめ用途 | 独自の強み |

|---|---|---|---|---|

| Thunderbit | Chrome拡張、AI2クリック抽出、サブページ対応 | 無料/15ドル〜 | 非エンジニアのビジネスユーザー | 圧倒的な手軽さ、AIフィールド検出、無料エクスポート |

| Octoparse | ビジュアルデスクトップ、100+テンプレ、クラウド/ローカル | 無料/75ドル〜 | アナリスト、中小企業、テンプレ活用 | 豊富なテンプレ、クラウド/デスクトップ両対応 |

| ParseHub | ビジュアルワークフロー、動的サイト、クロスプラットフォーム | 無料/189ドル〜 | 技術者、複雑サイト | JSサイトに強い、無料枠が充実 |

| DataMiner | Chrome拡張、6万+レシピ、Sheets連携 | 無料/19.99ドル〜 | 営業・マーケ・クイック抽出 | レシピ数最多、Sheets出力が簡単 |

| Scrapy | Pythonフレームワーク、コード駆動、拡張性 | 無料(OSS) | 開発チーム、大規模カスタム | 柔軟性無限大、ライセンス費用なし |

| Import.io | エンタープライズクラウド、ML抽出、データ変換 | 約499ドル〜(カスタム) | 大企業、信頼性重視のデータ供給 | エンドツーエンド、サポート・SLA充実 |

| WebHarvy | Windowsアプリ、パターン検出、買い切り | 129ドル(買い切り) | Windowsの個人・小規模ビジネス | 初心者向け、買い切り、オフライン利用 |

| Apify | クラウド、5千+アクター、カスタムスクリプト、API | 無料/49ドル〜 | 開発者、大規模・カスタム | マーケット+カスタム、スケーラブル |

| Dexi.io | クラウドビジュアルビルダー、ワークフロー自動化 | 約119ドル〜 | 企業、チーム自動化 | ETLワークフロー、コラボ機能 |

| Content Grabber | Windows IDE、スクリプト、スケジューリング、連携 | 995ドル(買い切り)/149ドル〜 | 企業・IT部門・高度連携 | 機能豊富、オンプレミス、スタンドアロンボット |

ビジネスに最適なaiウェブスクレイパーの選び方

どのAIウェブスクレイパーを選ぶか迷ったら、こんな感じで選ぶといいよ:

- 初心者・営業/マーケ・設定が面倒な人: がベスト。速くて正確、学習不要。

- テンプレ重視・一括抽出派: やは人気サイトや定型作業に強い。

- 複雑・動的サイトや技術者チーム: 、、なら柔軟に対応可能。

- 大規模・業務自動化・高度連携: 、、はエンタープライズ向け。

ワンポイント: まずは無料トライアルや無料枠で実際の業務に使ってみて。自分のワークフローやスキルに合うか、実際に試すのが一番!

AIウェブスクレイパーのこれから:注目トレンド

AIウェブスクレイパーはこれからもっと進化するよ。注目ポイントは:

- 動的コンテンツへの対応強化: AIが人間みたいにページを「理解」して、レイアウト変更やJavaScriptにも柔軟に対応()。

- データ変換の高度化: クリーニングや分類、付加情報の自動化が進んで、すぐ使えるインサイトに()。

- 自然言語での指示: Thunderbitみたいに「欲しい内容を説明するだけ」でAIが自動抽出()。

- ワークフロー自動化の深化: CRM更新やメール配信など、データ抽出後のアクションも自動化。

- マルチモーダル抽出: テキストだけじゃなく、画像・動画・音声も抽出対象に。

まとめ:次世代AIウェブスクレイパーなら、ほぼ手間いらずでデータ抽出ができて、ビジネスの本質的な価値創出に集中できる時代がやってくる!

よくある質問(FAQ)

1. AIウェブスクレイパーって何?従来型と何が違うの?

AIウェブスクレイパーは、AIを使ってウェブサイトから自動でデータを検出・抽出・構造化するツール。従来型みたいにコーディングや手動設定がいらなくて、サイト構造の変化や動的コンテンツにも柔軟に対応。多くは自然言語で指示できて、非エンジニアでも使いやすいのが特徴。

2. 非エンジニアにおすすめのAIウェブスクレイパーは?

は2クリックで使える手軽さとAIによるフィールド自動検出で、プログラミング不要のビジネスユーザーに最適。やも初心者向けで人気。

3. AIウェブスクレイパーは動的・JavaScript主体のサイトも対応できる?

もちろんOK。、、などは、動的コンテンツや無限スクロール、ログインにも対応。もっと複雑なサイトには、(ヘッドレスブラウザ連携)など開発者向けフレームワークが最適。

4. 自社に合ったAIウェブスクレイパーの選び方は?

自分の技術レベル、対象サイトの複雑さ、データ出力形式、予算を考えて選ぼう。まずは無料トライアルで実際の業務に使ってみて、ワークフローに合うか確認するのがおすすめ。ノーコードで手軽に使いたいならThunderbitやOctoparse、大規模・カスタム案件ならApifyやScrapyが向いてる。

5. ウェブスクレイピングの法的・倫理的注意点は?

必ず対象サイトの利用規約やデータプライバシー法を確認しよう。多くのAIウェブスクレイパーはリクエスト制御機能を備えてて、サイトへの負荷を抑えてる。公開データのみに絞って、同意なく機密情報を集めないなど、倫理的な利用を心がけてね。

生産性を一気に上げたい人は、やの他のガイドもぜひチェックしてみて。快適なスクレイピングライフを!

さらに詳しく知りたい人はこちら: