अब इंटरनेट सिर्फ एक डिजिटल स्पेस नहीं रहा—ये पूरी दुनिया का सबसे बड़ा डेटा स्टोरहाउस बन चुका है, और चाहे सेल्स टीम हो या मार्केट एनालिस्ट, हर कोई इसका फायदा उठाने की दौड़ में है। लेकिन सच कहें तो, वेब डेटा को मैन्युअली इकट्ठा करना कुछ वैसा ही है जैसे बिना गाइड के IKEA का फर्नीचर जोड़ना—आखिर में कुछ स्क्रू तो बच ही जाते हैं! जैसे-जैसे बिज़नेस रियल-टाइम मार्केट इंटेलिजेंस, कंपटीटर प्राइसिंग और लीड जनरेशन पर डिपेंडेंट होते जा रहे हैं, वैसे-वैसे तेज़ और भरोसेमंद डेटा क्रॉलिंग टूल्स की डिमांड भी आसमान छू रही है। असल में, आज लगभग और ग्लोबल वेब स्क्रैपिंग मार्केट ।

अगर आप बार-बार कॉपी-पेस्ट करने से परेशान हो चुके हैं, ताज़ा लीड्स मिस कर रहे हैं, या बस देखना चाहते हैं कि ऑटोमेशन से क्या-क्या मुमकिन है—तो आप बिलकुल सही जगह पर आए हैं। मैंने खुद कई साल वेब एक्सट्रैक्शन टूल्स बनाने और टेस्ट करने में लगाए हैं (और हां, की टीम को लीड भी किया है), इसलिए मुझे पता है कि सही टूल कैसे घंटों का काम मिनटों में कर सकता है। चाहे आप टेक्निकल न हों और तुरंत रिज़ल्ट चाहते हों, या डेवलपर हों और पूरी कस्टमाइज़ेशन चाहिए—यह टॉप 10 डेटा क्रॉलिंग टूल्स की लिस्ट आपके लिए ही है।

क्यों सही डेटा क्रॉलिंग टूल चुनना ज़रूरी है

सच कहें तो, एक अच्छे और औसत डेटा क्रॉलर में फर्क सिर्फ सहूलियत का नहीं है—बल्कि ये सीधे आपके बिज़नेस ग्रोथ से जुड़ा है। जब आप वेब एक्सट्रैक्शन को ऑटोमेट करते हैं, तो आप सिर्फ समय नहीं बचाते (एक G2 रिव्यूअर ने बताया कि ), बल्कि गलतियों को भी कम करते हैं, नए मौके खोलते हैं, और अपनी टीम को सबसे ताज़ा, सटीक डेटा के साथ काम करने देते हैं। मैन्युअल रिसर्च धीमा, गलतियों से भरा और अक्सर आउटडेटेड हो जाता है। सही टूल के साथ आप मिनटों में कंपटीटर मॉनिटरिंग, प्राइस ट्रैकिंग या लीड लिस्ट बना सकते हैं—दिनों में नहीं।

एक उदाहरण लें: एक ब्यूटी रिटेलर ने वेब स्क्रैपिंग से कंपटीटर स्टॉक और प्राइसिंग ट्रैक की, जिससे । ये वो असर है जो सिर्फ स्प्रेडशीट्स और मैन्युअल मेहनत से नहीं मिल सकता।

हमने बेस्ट डेटा क्रॉलिंग टूल्स को कैसे परखा

इतने सारे ऑप्शन्स के बीच सही टूल चुनना किसी टेक इवेंट में स्पीड-डेटिंग जैसा लग सकता है। मैंने बेस्ट टूल्स को चुनने के लिए ये क्राइटेरिया अपनाए:

- इस्तेमाल में आसान: क्या आप बिना कोडिंग या Python के एक्सपर्ट बने शुरू कर सकते हैं? क्या नॉन-कोडर्स के लिए विज़ुअल इंटरफेस या AI असिस्टेंस है?

- ऑटोमेशन कैपेबिलिटी: क्या ये पेजिनेशन, सबपेज, डायनामिक कंटेंट और शेड्यूलिंग संभाल सकता है? क्या बड़े कामों के लिए क्लाउड में रन कर सकता है?

- प्राइसिंग और स्केलेबिलिटी: क्या फ्री या किफायती प्लान है? जैसे-जैसे डेटा की ज़रूरत बढ़े, कीमत कैसे बढ़ती है?

- फीचर सेट और इंटीग्रेशन: क्या आप डेटा को Excel, Google Sheets या API के ज़रिए एक्सपोर्ट कर सकते हैं? क्या टेम्प्लेट्स, शेड्यूलिंग या डेटा क्लीनिंग जैसे फीचर्स हैं?

- किसके लिए बेस्ट: ये टूल असल में किसके लिए बना है—बिज़नेस यूज़र्स, डेवलपर्स या एंटरप्राइज़ टीम्स?

आखिर में एक क्विक कंपैरिजन टेबल भी है, जिससे आप हर टूल की तुलना कर सकते हैं।

अब जानते हैं 2025 के लिए टॉप 10 डेटा क्रॉलिंग टूल्स के बारे में, जो वेब एक्सट्रैक्शन को आसान बनाते हैं।

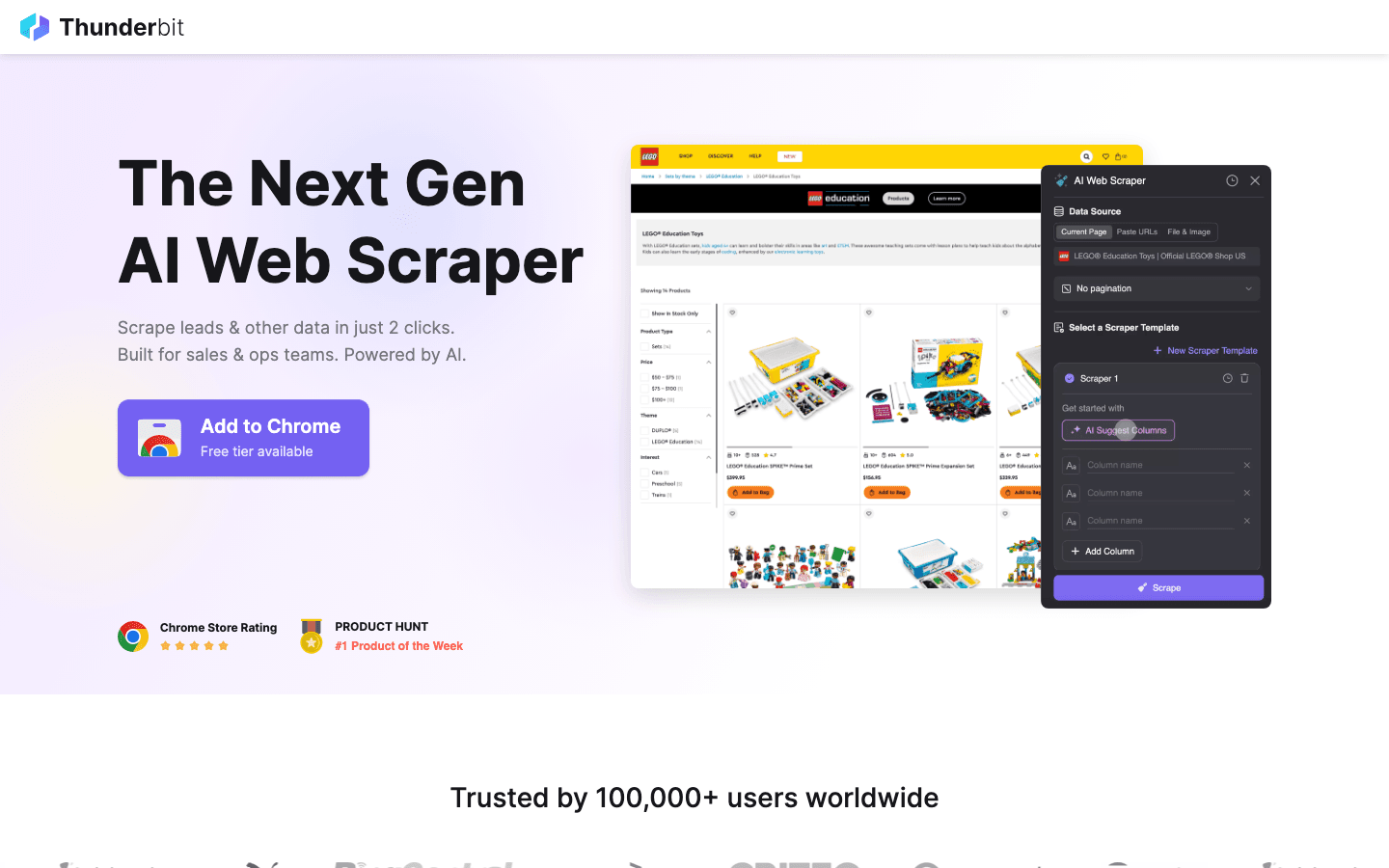

1. Thunderbit

मेरी पहली पसंद है उन लोगों के लिए जो डेटा क्रॉलिंग को उतना ही आसान बनाना चाहते हैं जितना ऑनलाइन खाना ऑर्डर करना। ये एक AI-पावर्ड Chrome एक्सटेंशन है, जिसमें 2-क्लिक स्क्रैपिंग मिलती है: बस “AI Suggest Fields” दबाएं, AI खुद पेज को पढ़कर ज़रूरी कॉलम सुझा देगा, फिर “Scrape” पर क्लिक करें और डेटा ले लें। न कोडिंग, न सेलेक्टर्स के साथ झंझट—बस तुरंत रिज़ल्ट।

मेरी पहली पसंद है उन लोगों के लिए जो डेटा क्रॉलिंग को उतना ही आसान बनाना चाहते हैं जितना ऑनलाइन खाना ऑर्डर करना। ये एक AI-पावर्ड Chrome एक्सटेंशन है, जिसमें 2-क्लिक स्क्रैपिंग मिलती है: बस “AI Suggest Fields” दबाएं, AI खुद पेज को पढ़कर ज़रूरी कॉलम सुझा देगा, फिर “Scrape” पर क्लिक करें और डेटा ले लें। न कोडिंग, न सेलेक्टर्स के साथ झंझट—बस तुरंत रिज़ल्ट।

Thunderbit को सेल्स, मार्केटिंग और ईकॉमर्स टीम्स क्यों पसंद करती हैं? क्योंकि ये असली बिज़नेस वर्कफ्लो के लिए डिज़ाइन किया गया है:

- AI Suggest Fields: AI पेज को पढ़कर नाम, प्राइस, ईमेल जैसी ज़रूरी जानकारी खुद चुनता है।

- सबपेज स्क्रैपिंग: और डिटेल चाहिए? Thunderbit खुद सबपेज (जैसे प्रोडक्ट डिटेल्स या LinkedIn प्रोफाइल्स) पर जाकर आपकी टेबल को समृद्ध करता है।

- इंस्टेंट एक्सपोर्ट: डेटा को सीधे Excel, Google Sheets, Airtable या Notion में भेजें। सभी एक्सपोर्ट फ्री हैं।

- वन-क्लिक टेम्प्लेट्स: पॉपुलर साइट्स (Amazon, Zillow, Instagram) के लिए रेडीमेड टेम्प्लेट्स से और तेज़ रिज़ल्ट पाएं।

- फ्री डेटा एक्सपोर्ट: डेटा निकालने के लिए कोई पेवॉल नहीं है।

- शेड्यूल्ड स्क्रैपिंग: सिंपल इंग्लिश में बार-बार चलने वाले जॉब्स सेट करें (“हर सोमवार सुबह 9 बजे”)—प्राइस मॉनिटरिंग या साप्ताहिक लीड्स के लिए परफेक्ट।

Thunderbit में क्रेडिट सिस्टम है (1 क्रेडिट = 1 रो), और में 6 पेज (या ट्रायल बूस्ट के साथ 10) तक स्क्रैप कर सकते हैं। पेड प्लान $15/माह से शुरू होते हैं, जिससे हर साइज की टीम इसे अफोर्ड कर सकती है।

Thunderbit को एक्शन में देखना है? हमारा या देखें। ये वही टूल है जिसकी मुझे मैन्युअल डेटा एंट्री के दिनों में सबसे ज़्यादा ज़रूरत थी।

2. Octoparse

डेटा क्रॉलिंग की दुनिया में एक बड़ा नाम है, खासकर उन एंटरप्राइज़ यूज़र्स के लिए जिन्हें भारी-भरकम काम करना होता है। इसमें एक विज़ुअल डेस्कटॉप इंटरफेस (Windows और Mac) है, जिसमें आप पॉइंट-एंड-क्लिक से वर्कफ्लो बना सकते हैं—कोडिंग की ज़रूरत नहीं। लेकिन इसकी आसान UI के पीछे, Octoparse लॉगिन, इनफिनिट स्क्रॉल, प्रॉक्सी रोटेशन और CAPTCHA सॉल्विंग जैसे एडवांस फीचर्स भी देता है।

डेटा क्रॉलिंग की दुनिया में एक बड़ा नाम है, खासकर उन एंटरप्राइज़ यूज़र्स के लिए जिन्हें भारी-भरकम काम करना होता है। इसमें एक विज़ुअल डेस्कटॉप इंटरफेस (Windows और Mac) है, जिसमें आप पॉइंट-एंड-क्लिक से वर्कफ्लो बना सकते हैं—कोडिंग की ज़रूरत नहीं। लेकिन इसकी आसान UI के पीछे, Octoparse लॉगिन, इनफिनिट स्क्रॉल, प्रॉक्सी रोटेशन और CAPTCHA सॉल्विंग जैसे एडवांस फीचर्स भी देता है।

- 500+ रेडीमेड टेम्प्लेट्स: Amazon, Twitter, LinkedIn जैसी साइट्स के लिए तुरंत शुरू करें।

- क्लाउड-बेस्ड 스크래핑: Octoparse के सर्वर पर जॉब्स चलाएं, शेड्यूल करें और बड़े प्रोजेक्ट्स के लिए स्केल करें।

- API एक्सेस: डेटा को सीधे अपने बिज़नेस ऐप्स या डेटाबेस में इंटीग्रेट करें।

- एडवांस्ड ऑटोमेशन: डायनामिक कंटेंट, पेजिनेशन और मल्टी-स्टेप वर्कफ्लो हैंडल करता है।

में 10 टास्क तक मिलते हैं, लेकिन ज़्यादातर बिज़नेस यूज़र्स को Standard (~$83/माह) या Professional (~$299/माह) प्लान चाहिए होगा। Thunderbit के मुकाबले सीखने में थोड़ा समय लगता है, लेकिन अगर आपको हज़ारों पेज 스크래핑 करने हैं, तो Octoparse बेहतरीन विकल्प है।

3. Scrapy

डेवलपर्स के लिए बेस्ट है जो अपने डेटा क्रॉलिंग प्रोजेक्ट्स पर पूरा कंट्रोल चाहते हैं। ये एक ओपन-सोर्स Python फ्रेमवर्क है, जिसमें आप किसी भी वेबसाइट के लिए कस्टम स्पाइडर (크롤러) कोड कर सकते हैं। जो चाहें, वो बना सकते हैं।

डेवलपर्स के लिए बेस्ट है जो अपने डेटा क्रॉलिंग प्रोजेक्ट्स पर पूरा कंट्रोल चाहते हैं। ये एक ओपन-सोर्स Python फ्रेमवर्क है, जिसमें आप किसी भी वेबसाइट के लिए कस्टम स्पाइडर (크롤러) कोड कर सकते हैं। जो चाहें, वो बना सकते हैं।

- फुल प्रोग्रामेबिलिटी: Python कोड से आप तय कर सकते हैं कि किस साइट को कैसे 크ॉल और पार्स करना है।

- तेज़ और असिंक्रोनस: बड़े प्रोजेक्ट्स के लिए हज़ारों पेज एक साथ हैंडल करता है।

- एक्स्टेंसिबल: प्रॉक्सी, हेडलेस ब्राउज़र या कस्टम लॉजिक के लिए मिडलवेयर जोड़ सकते हैं।

- मजबूत कम्युनिटी: ढेरों ट्यूटोरियल्स, प्लगइन्स और सपोर्ट मिलता है।

Scrapy फ्री और ओपन-सोर्स है, लेकिन इसके लिए प्रोग्रामिंग स्किल्स चाहिए। अगर आपकी टीम टेक्निकल है या कस्टम पाइपलाइन बनानी है, तो Scrapy शानदार है। नॉन-코डर्स के लिए ये थोड़ा मुश्किल हो सकता है।

4. ParseHub

एक विज़ुअल, नो-코드 वेब 스크래퍼 टूल है, जो नॉन-코डर्स के लिए खासतौर पर बढ़िया है, खासकर जटिल वेबसाइट्स के लिए। इसकी पॉइंट-एंड-क्लिक इंटरफेस से आप एलिमेंट्स चुन सकते हैं, एक्शन सेट कर सकते हैं और 스크래핑 वर्कफ्लो बना सकते हैं—यहां तक कि डायनामिक कंटेंट या मुश्किल नेविगेशन वाली साइट्स के लिए भी।

एक विज़ुअल, नो-코드 वेब 스크래퍼 टूल है, जो नॉन-코डर्स के लिए खासतौर पर बढ़िया है, खासकर जटिल वेबसाइट्स के लिए। इसकी पॉइंट-एंड-क्लिक इंटरफेस से आप एलिमेंट्स चुन सकते हैं, एक्शन सेट कर सकते हैं और 스크래핑 वर्कफ्लो बना सकते हैं—यहां तक कि डायनामिक कंटेंट या मुश्किल नेविगेशन वाली साइट्स के लिए भी।

- विज़ुअल वर्कफ्लो बिल्डर: डेटा चुनें, पेजिनेशन सेट करें, पॉप-अप या ड्रॉपडाउन हैंडल करें।

- डायनामिक कंटेंट हैंडल करता है: JavaScript-हैवी साइट्स और इंटरएक्टिव पेज भी 스크래핑 कर सकता है।

- क्लाउड रन और शेड्यूलिंग: 클라우드 में 스크래핑 चलाएं और बार-बार जॉब्स शेड्यूल करें।

- CSV, Excel या API के ज़रिए एक्सपोर्ट: अपने पसंदीदा टूल्स के साथ आसानी से इंटीग्रेट करें।

ParseHub का फ्री प्लान (5 प्रोजेक्ट्स) है, पेड प्लान से शुरू होते हैं। ये कुछ प्रतिस्पर्धियों से महंगा है, लेकिन इसका विज़ुअल तरीका एनालिस्ट्स, मार्केटर्स और रिसर्चर्स के लिए बहुत आसान बनाता है।

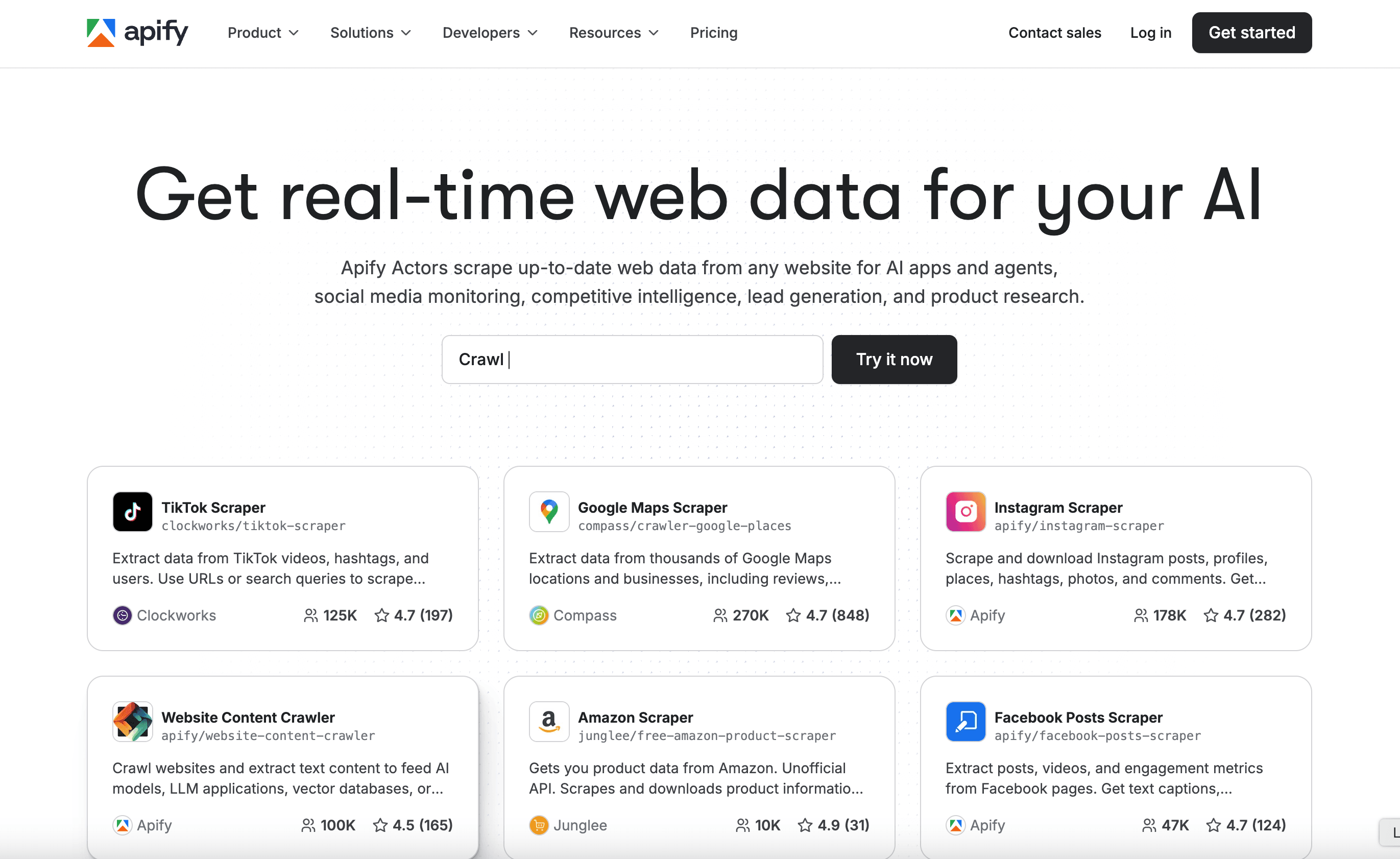

5. Apify

एक प्लेटफॉर्म और मार्केटप्लेस दोनों है। इसमें ढेरों रेडीमेड “Actors” (스크래퍼) मिलते हैं, साथ ही आप खुद के कस्टम 크ॉलर भी 클라우드 में बना और चला सकते हैं।

एक प्लेटफॉर्म और मार्केटप्लेस दोनों है। इसमें ढेरों रेडीमेड “Actors” (스크래퍼) मिलते हैं, साथ ही आप खुद के कस्टम 크ॉलर भी 클라우드 में बना और चला सकते हैं।

- 5,000+ रेडीमेड एक्टर्स: Google Maps, Amazon, Twitter जैसी साइट्स तुरंत 스크래핑 करें।

- कस्टम स्क्रिप्टिंग: डेवलपर्स JavaScript या Python से एडवांस्ड 크ॉलर बना सकते हैं।

- 클라우드 스케लिंग: जॉब्स को पैरेलल में चलाएं, टास्क शेड्यूल करें और डेटा 클ाउड में मैनेज करें।

- API और इंटीग्रेशन: रिज़ल्ट्स को अपने ऐप्स, वर्कफ्लो या डेटा पाइपलाइंस में प्लग करें।

Apify का लचीला है, पेड प्लान $29/माह से शुरू होते हैं (कंप्यूट टाइम के हिसाब से)। सीखने में थोड़ा समय लग सकता है, लेकिन अगर आपको प्लग-एंड-प्ले और फुल कस्टमाइज़ेशन दोनों चाहिए, तो Apify शानदार है।

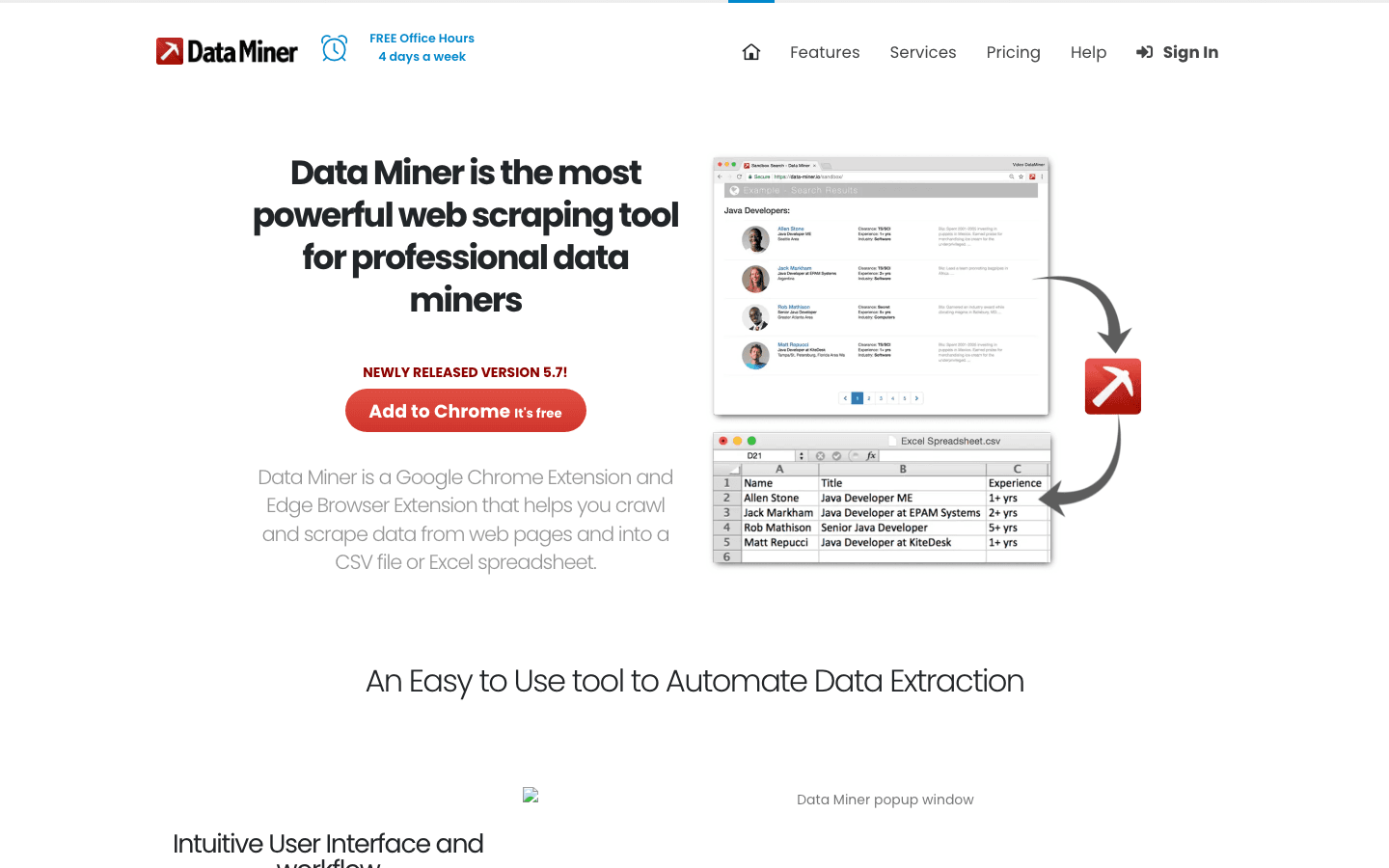

6. Data Miner

एक Chrome एक्सटेंशन है, जो टेम्प्लेट-बेस्ड डेटा 크ॉलिंग के लिए बना है। ये उन बिज़नेस यूज़र्स के लिए परफेक्ट है, जो टेबल या लिस्ट से डेटा तुरंत निकालना चाहते हैं।

एक Chrome एक्सटेंशन है, जो टेम्प्लेट-बेस्ड डेटा 크ॉलिंग के लिए बना है। ये उन बिज़नेस यूज़र्स के लिए परफेक्ट है, जो टेबल या लिस्ट से डेटा तुरंत निकालना चाहते हैं।

- बड़ी टेम्प्लेट लाइब्रेरी: LinkedIn, Yelp जैसी साइट्स के लिए हज़ारों रेडीमेड टेम्प्लेट्स।

- पॉइंट-एंड-क्लिक एक्सट्रैक्शन: टेम्प्लेट चुनें, डेटा प्रीव्यू करें और तुरंत एक्सपोर्ट करें।

- 브라우저-बेस्ड: आपके करंट सेशन के साथ काम करता है—लॉगिन के पीछे भी 스크래핑 कर सकते हैं।

- CSV या Excel में एक्सपोर्ट: कुछ ही सेकंड में डेटा स्प्रेडशीट में पाएं।

में 500 पेज/माह मिलते हैं, पेड प्लान $20/माह से शुरू होते हैं। ये छोटे, एक बार के काम या तुरंत डेटा चाहिए हो तो बेस्ट है—बस बड़े या जटिल कामों के लिए न सोचें।

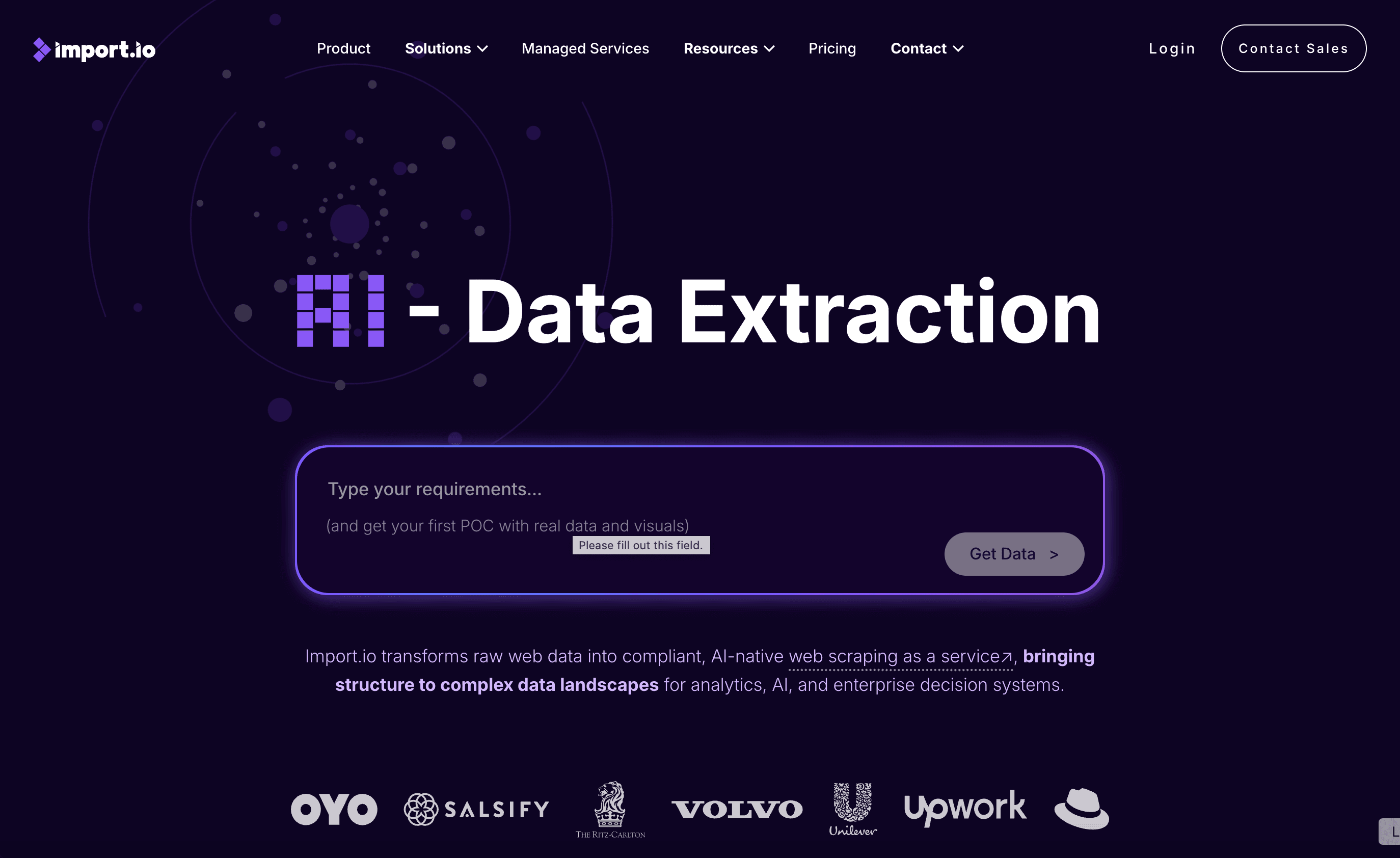

7. Import.io

एंटरप्राइज़-ग्रेड प्लेटफॉर्म है, जो लगातार, भरोसेमंद वेब डेटा इंटीग्रेशन के लिए बना है। ये सिर्फ 크ॉलर नहीं, बल्कि एक मैनेज्ड सर्विस है, जो क्लीन, स्ट्रक्चर्ड डेटा सीधे आपके बिज़नेस सिस्टम्स में पहुंचाती है।

एंटरप्राइज़-ग्रेड प्लेटफॉर्म है, जो लगातार, भरोसेमंद वेब डेटा इंटीग्रेशन के लिए बना है। ये सिर्फ 크ॉलर नहीं, बल्कि एक मैनेज्ड सर्विस है, जो क्लीन, स्ट्रक्चर्ड डेटा सीधे आपके बिज़नेस सिस्टम्स में पहुंचाती है।

- नो-코드 एक्सट्रैक्शन: विज़ुअल सेटअप से तय करें कि कौन सा डेटा चाहिए।

- रियल-टाइम डेटा फीड्स: डेटा को डैशबोर्ड, एनालिटिक्स टूल्स या डेटाबेस में स्ट्रीम करें।

- कंप्लायंस और रिलायबिलिटी: IP रोटेशन, एंटी-बॉट और लीगल कंप्लायंस संभालता है।

- मैनेज्ड सर्विसेज: Import.io की टीम आपके 스크래퍼 सेटअप और मेंटेन कर सकती है।

है, SaaS प्लेटफॉर्म के लिए 14 दिन का फ्री ट्रायल मिलता है। अगर आपका बिज़नेस हमेशा ताज़ा वेब डेटा पर निर्भर है (जैसे रिटेल, फाइनेंस या मार्केट रिसर्च), तो Import.io ज़रूर देखें।

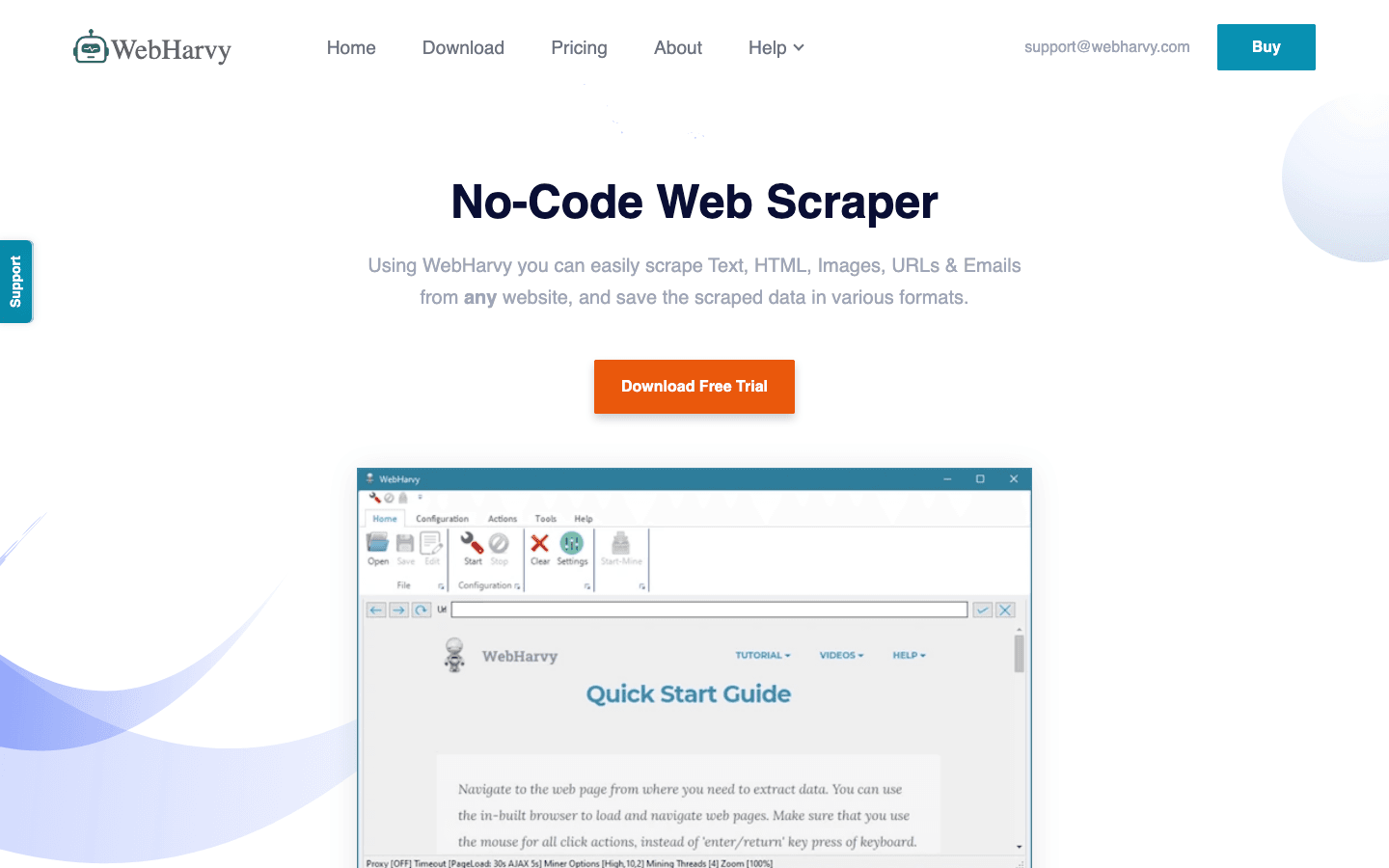

8. WebHarvy

एक डेस्कटॉप-बेस्ड 스크래퍼 है, खासकर Windows यूज़र्स के लिए जो सब्सक्रिप्शन के झंझट से बचना चाहते हैं। ये छोटे बिज़नेस और उन लोगों में लोकप्रिय है, जो एक बार खरीदकर बार-बार इस्तेमाल करना चाहते हैं।

एक डेस्कटॉप-बेस्ड 스크래퍼 है, खासकर Windows यूज़र्स के लिए जो सब्सक्रिप्शन के झंझट से बचना चाहते हैं। ये छोटे बिज़नेस और उन लोगों में लोकप्रिय है, जो एक बार खरीदकर बार-बार इस्तेमाल करना चाहते हैं।

- विज़ुअल पैटर्न डिटेक्शन: डेटा एलिमेंट्स पर क्लिक करें, WebHarvy खुद रिपीटिंग पैटर्न पहचान लेता है।

- टेक्स्ट, इमेज और बहुत कुछ: ईमेल, URL समेत सभी आम डेटा टाइप्स निकालता है।

- पेजिनेशन और शेड्यूलिंग: मल्टी-पेज साइट्स पर नेविगेट करें और शेड्यूल्ड 스크래핑 सेट करें।

- Excel, CSV, XML, JSON, SQL में एक्सपोर्ट: किसी भी वर्कफ्लो के लिए फ्लेक्सिबल आउटपुट।

है, जो रेगुलर यूज़ के लिए किफायती है—बस ध्यान दें कि ये सिर्फ Windows पर चलता है।

9. Mozenda

एक 클라우드-बेस्ड 데이터 크ॉलिंग प्लेटफॉर्म है, जो बिज़नेस ऑपरेशंस और लगातार डेटा की ज़रूरतों के लिए बना है। इसमें डेस्कटॉप डिज़ाइनर (Windows) और पावरफुल 클ाउड ऑटोमेशन दोनों मिलते हैं।

एक 클라우드-बेस्ड 데이터 크ॉलिंग प्लेटफॉर्म है, जो बिज़नेस ऑपरेशंस और लगातार डेटा की ज़रूरतों के लिए बना है। इसमें डेस्कटॉप डिज़ाइनर (Windows) और पावरफुल 클ाउड ऑटोमेशन दोनों मिलते हैं।

- विज़ुअल एजेंट बिल्डर: पॉइंट-एंड-क्लिक इंटरफेस से एक्सट्रैक्शन रूटीन डिज़ाइन करें।

- 클라우드 스케लिंग: कई एजेंट्स को पैरेलल में चलाएं, जॉब्स शेड्यूल करें और डेटा सेंट्रली मैनेज करें।

- डेटा मैनेजमेंट कंसोल: एक्सट्रैक्शन के बाद डेटा को जोड़ें, फिल्टर करें और क्लीन करें।

- एंटरप्राइज़ सपोर्ट: बड़ी टीमों के लिए डेडिकेटेड अकाउंट मैनेजर्स और मैनेज्ड सर्विसेज।

प्लान्स से शुरू होते हैं, ज्यादा यूज़र्स और प्रोसेसिंग के लिए हाईयर टियर्स हैं। Mozenda उन कंपनियों के लिए बेस्ट है जिन्हें रोज़ाना भरोसेमंद वेब डेटा चाहिए।

10. BeautifulSoup

क्लासिक Python लाइब्रेरी है, जो HTML और XML पार्सिंग के लिए जानी जाती है। ये फुल 크ॉलर नहीं है, लेकिन छोटे, कस्टम 스크래핑 प्रोजेक्ट्स के लिए डेवलपर्स की पसंदीदा है।

क्लासिक Python लाइब्रेरी है, जो HTML और XML पार्सिंग के लिए जानी जाती है। ये फुल 크ॉलर नहीं है, लेकिन छोटे, कस्टम 스크래핑 प्रोजेक्ट्स के लिए डेवलपर्स की पसंदीदा है।

- सिंपल HTML पार्सिंग: स्टैटिक वेब पेज से डेटा आसानी से निकालें।

- Python Requests के साथ काम करता है: फेचिंग और 크ॉलिंग के लिए दूसरी लाइब्रेरीज़ के साथ मिलाएं।

- फ्लेक्सिबल और हल्का: क्विक स्क्रिप्ट्स या लर्निंग प्रोजेक्ट्स के लिए परफेक्ट।

- बड़ी कम्युनिटी: ढेरों ट्यूटोरियल्स और Stack Overflow पर सपोर्ट।

BeautifulSoup है, लेकिन आपको खुद कोड लिखना और 크ॉलिंग लॉजिक संभालना होगा। ये डेवलपर्स या सीखने वालों के लिए बेस्ट है।

तुलना तालिका: 데이터 크ॉलिंग टूल्स एक नज़र में

| टूल | इस्तेमाल में आसानी | ऑटोमेशन लेवल | प्राइसिंग | एक्सपोर्ट विकल्प | किसके लिए बेस्ट |

|---|---|---|---|---|---|

| Thunderbit | बहुत आसान, नो-코드 | हाई (AI, सबपेज) | फ्री ट्रायल, $15/माह से | Excel, Sheets, Airtable, Notion, CSV | सेल्स, मार्केटिंग, ईकॉमर्स, नॉन-코डर्स |

| Octoparse | मीडियम, विज़ुअल UI | बहुत हाई, 클라우드 | फ्री, $83–$299/माह | CSV, Excel, JSON, API | एंटरप्राइज़, 데이터 टीमें, डायनामिक साइट्स |

| Scrapy | कम (Python चाहिए) | हाई (कस्टमाइज़ेबल) | फ्री, ओपन-सोर्स | कोई भी (코드 से) | डेवलपर्स, बड़े कस्टम प्रोजेक्ट्स |

| ParseHub | हाई, विज़ुअल | हाई (डायनामिक साइट्स) | फ्री, $189/माह से | CSV, Excel, JSON, API | नॉन-코डर्स, जटिल वेब स्ट्रक्चर |

| Apify | मीडियम, फ्लेक्सिबल | बहुत हाई, 클라우드 | फ्री, $29–$999/माह | CSV, JSON, API, 클라우드 स्टोरेज | डेवलपर्स, बिज़नेस, रेडीमेड या कस्टम एक्टर्स |

| Data Miner | बहुत आसान, 브라우저 | कम (मैन्युअल) | फ्री, $20–$99/माह | CSV, Excel | क्विक, एक बार की एक्सट्रैक्शन, छोटे 데이터 सेट |

| Import.io | मीडियम, मैनेज्ड | बहुत हाई, एंटरप्राइज़ | कस्टम, वॉल्यूम-बेस्ड | CSV, JSON, API, डायरेक्ट इंटीग्रेशन | एंटरप्राइज़, लगातार 데이터 इंटीग्रेशन |

| WebHarvy | हाई, डेस्कटॉप | मीडियम (शेड्यूलिंग) | $129 एक बार | Excel, CSV, XML, JSON, SQL | SMBs, Windows यूज़र्स, रेगुलर 스크래핑 |

| Mozenda | मीडियम, विज़ुअल | बहुत हाई, 클라우드 | $250–$450+/माह | CSV, Excel, JSON, 클라우드, DB | लगातार, बड़े बिज़नेस ऑपरेशंस |

| BeautifulSoup | कम (Python चाहिए) | कम (मैन्युअल 코डिंग) | फ्री, ओपन-सोर्स | कोई भी (코ड से) | डेवलपर्स, सीखने वाले, छोटे कस्टम स्क्रिप्ट्स |

अपनी टीम के लिए सही 데이터 크ॉलिंग टूल कैसे चुनें

बेस्ट 데이터 크ॉलिंग टूल चुनना “सबसे पावरफुल” ढूंढने का सवाल नहीं है—बल्कि ये आपकी टीम की स्किल्स, ज़रूरतों और बजट के हिसाब से सही विकल्प चुनने का है। मेरी सलाह:

- नॉन-코डर्स या बिज़नेस यूज़र्स: Thunderbit, ParseHub या Data Miner से शुरू करें—इंस्टेंट रिज़ल्ट और आसान सेटअप के लिए।

- एंटरप्राइज़ या बड़े प्रोजेक्ट्स: Octoparse, Mozenda या Import.io देखें—ऑटोमेशन, शेड्यूलिंग और सपोर्ट के लिए।

- डेवलपर्स या कस्टम प्रोजेक्ट्स: Scrapy, Apify या BeautifulSoup—फुल कंट्रोल और फ्लेक्सिबिलिटी के लिए।

- बजट या एक बार के काम: WebHarvy (Windows) या Data Miner (브라우저)—सस्ते और आसान विकल्प।

हमेशा अपने टॉप चॉइस को फ्री ट्रायल में अपनी असली टारगेट साइट्स पर टेस्ट करें—जो एक साइट पर काम करता है, जरूरी नहीं दूसरी पर भी करे। और इंटीग्रेशन का भी ध्यान रखें: अगर आपको डेटा Sheets, Notion या डेटाबेस में चाहिए, तो टूल में वह सपोर्ट जरूर देखें।

निष्कर्ष: बेस्ट 데이터 크ॉलिंग टूल्स से बिज़नेस वैल्यू अनलॉक करें

वेब डेटा आज के दौर का नया तेल है—लेकिन तभी जब आपके पास उसे निकालने और इस्तेमाल करने के लिए सही टूल्स हों। मॉडर्न 데이터 크ॉलिंग टूल्स के साथ आप घंटों की मैन्युअल रिसर्च को मिनटों में ऑटोमेटेड इनसाइट्स में बदल सकते हैं—जिससे आपकी सेल्स, मार्केटिंग और ऑपरेशंस और भी स्मार्ट बनती हैं। चाहे आप लीड लिस्ट बना रहे हों, कंपटीटर ट्रैक कर रहे हों या बस कॉपी-पेस्ट से तंग आ चुके हों—इस लिस्ट में जरूर कोई टूल आपकी लाइफ आसान बना देगा।

तो अपनी टीम की ज़रूरतें देखें, कुछ टूल्स ट्राई करें और देखें कि ऑटोमेशन से आप कितना आगे जा सकते हैं। और अगर आप देखना चाहते हैं कि AI-पावर्ड, 2-क्लिक 스크래핑 कैसी होती है, तो । हैप्पी 크ॉलिंग—और उम्मीद है आपका डेटा हमेशा ताज़ा, स्ट्रक्चर्ड और एक्शन के लिए तैयार रहे।

अक्सर पूछे जाने वाले सवाल (FAQs)

1. 데이터 크ॉलिंग टूल क्या है और इसकी ज़रूरत क्यों है?

데이터 크ॉलिंग टूल वेबसाइट्स से जानकारी निकालने की प्रक्रिया को ऑटोमेट करता है। ये समय बचाता है, गलतियां कम करता है और सेल्स, मार्केटिंग, रिसर्च व ऑपरेशंस के लिए ताज़ा डेटा जल्दी उपलब्ध कराता है—मैन्युअल कॉपी-पेस्टिंग से कहीं बेहतर।

2. नॉन-टेक्निकल यूज़र्स के लिए सबसे अच्छा 데이터 크ॉलिंग टूल कौन सा है?

Thunderbit, ParseHub और Data Miner नॉन-코डर्स के लिए बेहतरीन हैं। Thunderbit अपनी 2-क्लिक AI वर्कफ़्लो के लिए जाना जाता है, जबकि ParseHub जटिल साइट्स के लिए विज़ुअल तरीका देता है।

3. 데이터 크ॉलिंग टूल्स की प्राइसिंग मॉडल्स में क्या फर्क है?

प्राइसिंग बहुत अलग-अलग है: कुछ टूल्स (जैसे Thunderbit और Data Miner) फ्री टियर और किफायती प्लान देते हैं, जबकि एंटरप्राइज़ प्लेटफॉर्म्स (जैसे Import.io और Mozenda) कस्टम या वॉल्यूम-बेस्ड प्राइसिंग अपनाते हैं। हमेशा देखें कि टूल की कीमत आपकी 데이터 ज़रूरतों के हिसाब से है या नहीं।

4. क्या इन टूल्स से लगातार, शेड्यूल्ड 데이터 एक्सट्रैक्शन किया जा सकता है?

हाँ—Thunderbit, Octoparse, Apify, Mozenda और Import.io जैसे टूल्स शेड्यूल्ड या बार-बार चलने वाले 크ॉल्स सपोर्ट करते हैं, जो प्राइस मॉनिटरिंग, लीड जनरेशन या मार्केट रिसर्च के लिए आदर्श हैं।

5. 데이터 크ॉलिंग टूल चुनने से पहले किन बातों का ध्यान रखें?

अपनी टीम की टेक्निकल स्किल्स, जिन साइट्स को 크ॉल करना है उनकी जटिलता, डेटा वॉल्यूम, इंटीग्रेशन की ज़रूरत और बजट को ध्यान में रखें। पेड प्लान लेने से पहले कुछ टूल्स को असली काम में ट्राई करें।

और गहराई से जानने के लिए देखें।

और जानें