웹에는 영업, 이커머스, 시장 조사 등 다양한 분야에서 활용할 수 있는 알짜 데이터가 넘쳐납니다. 웹 스크래핑은 리드 발굴, 가격 모니터링, 경쟁사 분석 등에서 정말 강력한 무기가 되어주죠. 하지만 요즘은 스크래핑을 시도하는 사람이 많아지면서, 웹사이트들도 이에 맞서 점점 더 강력한 방어막을 세우고 있습니다. 실제로 을 도입했고, 등은 이제 기본 옵션이 됐습니다. 파이썬 스크립트가 20분 잘 돌아가다가 갑자기 403 에러로 멈춰버린 경험, 한 번쯤 해보셨다면 그 좌절감이 얼마나 현실적인지 공감하실 거예요.

저는 SaaS와 자동화 분야에서 오래 일하면서, 스크래핑 프로젝트가 "생각보다 쉽네"에서 "왜 다 막히지?"로 순식간에 바뀌는 상황을 수도 없이 봤습니다. 이제 본격적으로 실전에 들어가 볼까요? 파이썬으로 웹 스크래핑할 때 차단을 피하는 방법, 실전 코드 예시, 그리고 같은 AI 기반 대안까지 모두 안내해드릴게요. 파이썬 고수든, 이제 막 시작하는 분이든, 이 글을 통해 안정적이고 차단 걱정 없는 데이터 수집 노하우를 얻어가실 수 있습니다.

파이썬에서 차단 없이 웹 스크래핑이란?

차단 없이 웹 스크래핑이란, 웹사이트의 봇 감지 시스템에 걸리지 않고 데이터를 뽑아내는 걸 말합니다. 파이썬에서는 단순히 requests.get() 반복문만 돌려서는 부족하죠. 실제 사용자처럼 행동하고, 탐지 시스템보다 한 발 앞서 움직여야 합니다.

왜 하필 파이썬일까요? 입니다. 간결한 문법, 방대한 라이브러리(requests, BeautifulSoup, Scrapy, Selenium 등), 그리고 확장성 덕분이죠. 하지만 그만큼 많은 사이트들이 파이썬 기반 스크래핑 패턴을 집중적으로 감시하고 있습니다.

그래서 제대로 데이터를 수집하려면 기본을 넘어 사이트의 봇 탐지 원리와 우회 전략을 이해해야 합니다. 물론, 윤리와 법적 기준도 꼭 지켜야겠죠.

파이썬 웹 스크래핑에서 차단 방지가 중요한 이유

차단은 단순한 기술적 문제를 넘어서, 비즈니스 전체의 흐름을 멈출 수 있습니다. 구체적으로 보면:

| 활용 사례 | 차단 시 영향 |

|---|---|

| 리드 발굴 | 불완전하거나 오래된 잠재고객 리스트, 영업 기회 상실 |

| 가격 모니터링 | 경쟁사 가격 변동 놓침, 잘못된 가격 전략 |

| 콘텐츠 집계 | 뉴스, 리뷰, 리서치 데이터 누락 |

| 시장 정보 | 경쟁사/업계 동향 파악 불가 |

| 부동산 매물 | 부정확한 매물 정보, 기회 손실 |

스크래퍼가 차단되면 단순히 데이터를 못 얻는 게 아니라, 시간과 자원을 낭비하고, 규정 위반 위험까지 생깁니다. 하는 시대, 신뢰성은 곧 경쟁력입니다.

웹사이트가 파이썬 웹 스크래퍼를 감지하고 차단하는 방식

웹사이트들은 봇을 잡아내는 데 점점 더 똑똑해지고 있습니다. 대표적인 차단 기술은 다음과 같습니다 (, ):

- IP 주소 블랙리스트: 한 IP에서 요청이 몰리면 차단

- User-Agent 및 헤더 검사: 기본 파이썬 헤더(

python-requests/2.25.1등)는 바로 티가 남 - 요청 속도 제한: 짧은 시간에 너무 많은 요청 시 차단

- CAPTCHA: 봇이 풀기 어려운 인증 퍼즐

- 행동 패턴 분석: 일정한 간격, 반복 클릭 등 비인간적 행동 감지

- 허니팟: 봇만 클릭하는 숨겨진 링크/필드로 함정 설치

- 브라우저 지문 추적: 브라우저/기기 정보로 자동화 도구 탐지

- 쿠키/세션 추적: 쿠키나 세션을 무시하는 봇은 쉽게 걸림

공항 보안 검색을 떠올려 보세요. 모두와 비슷하게 행동하면 무난히 통과하지만, 수상한 행동을 하면 바로 의심받게 됩니다.

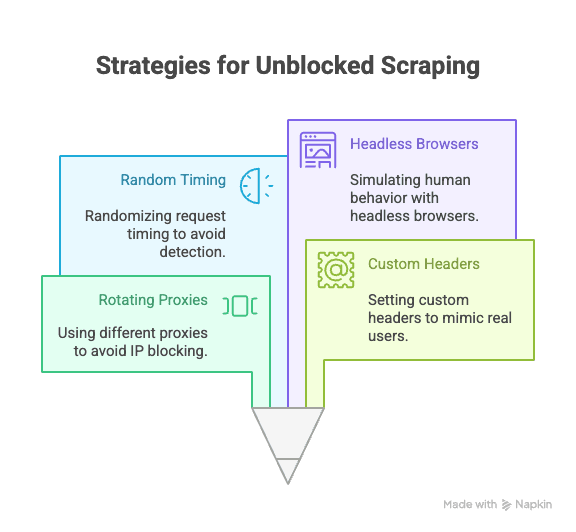

파이썬으로 차단 없이 웹 스크래핑하는 핵심 기술

이제 실전 팁을 살펴보겠습니다. 파이썬 스크래퍼라면 꼭 알아야 할 핵심 전략입니다.

프록시 및 IP 주소 회전

중요성: 모든 요청이 한 IP에서 발생하면 차단 대상이 됩니다. 프록시를 사용해 여러 IP로 분산하면 차단 위험이 크게 줄어듭니다.

파이썬 적용 예시:

1import requests

2proxies = [

3 "<http://proxy1.example.com:8000>",

4 "<http://proxy2.example.com:8000>",

5 # ...더 많은 프록시

6]

7for i, url in enumerate(urls):

8 proxy = {"http": proxies[i % len(proxies)]}

9 response = requests.get(url, proxies=proxy)

10 # 응답 처리신뢰성 높은 유료 프록시(레지던셜, 회전 프록시 등)를 활용하면 더욱 효과적입니다 ().

User-Agent 및 커스텀 헤더 설정

중요성: 기본 파이썬 헤더는 봇임을 바로 드러냅니다. 실제 브라우저처럼 User-Agent와 다양한 헤더를 설정하세요.

예시 코드:

1headers = {

2 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/124.0.0.0 Safari/537.36",

3 "Accept-Language": "en-US,en;q=0.9",

4 "Accept-Encoding": "gzip, deflate, br",

5 "Connection": "keep-alive"

6}

7response = requests.get(url, headers=headers)User-Agent도 주기적으로 바꿔주면 더욱 안전합니다 ().

요청 간격 및 패턴 무작위화

중요성: 봇은 빠르고 일정하게 동작하지만, 사람은 느리고 불규칙합니다. 요청 간 딜레이를 주고, 이동 경로도 다양하게 만드세요.

파이썬 팁:

1import time, random

2for url in urls:

3 response = requests.get(url)

4 time.sleep(random.uniform(2, 7)) # 2~7초 랜덤 대기Selenium을 쓴다면 클릭 경로나 스크롤도 무작위로 조정할 수 있습니다.

쿠키 및 세션 관리

중요성: 많은 사이트가 쿠키나 세션 토큰을 요구합니다. 이를 무시하면 쉽게 차단됩니다.

파이썬에서 관리하는 방법:

1import requests

2session = requests.Session()

3response = session.get(url)

4# 세션이 쿠키를 자동 관리더 복잡한 흐름은 Selenium으로 쿠키를 직접 받아 재사용할 수 있습니다.

헤드리스 브라우저로 인간 행동 시뮬레이션

중요성: 일부 사이트는 자바스크립트, 마우스 이동, 스크롤 등 실제 사용자 행동을 감지합니다. Selenium, Playwright 같은 헤드리스 브라우저로 이를 흉내낼 수 있습니다.

Selenium 예시:

1from selenium import webdriver

2from selenium.webdriver.common.action_chains import ActionChains

3import random, time

4driver = webdriver.Chrome()

5driver.get(url)

6actions = ActionChains(driver)

7actions.move_by_offset(random.randint(0, 100), random.randint(0, 100)).perform()

8time.sleep(random.uniform(2, 5))이렇게 하면 행동 분석이나 동적 콘텐츠도 우회할 수 있습니다 ().

고급 전략: 파이썬으로 CAPTCHA와 허니팟 우회하기

CAPTCHA는 봇을 막기 위한 대표적 장치입니다. 간단한 CAPTCHA는 파이썬 라이브러리로 풀 수 있지만, 대부분은 2Captcha, Anti-Captcha 같은 외부 서비스를 유료로 이용합니다 ().

통합 예시:

1# 2Captcha API 사용 예시(의사코드)

2import requests

3captcha_id = requests.post("<https://2captcha.com/in.php>", data={...}).text

4# 답변 대기 후 요청에 적용허니팟은 봇만 클릭하는 숨겨진 필드/링크입니다. 실제 브라우저에서 보이지 않는 요소는 건드리지 마세요 ().

파이썬 라이브러리로 견고한 요청 헤더 설계하기

User-Agent 외에도 Referer, Accept, Origin 등 다양한 헤더를 무작위로 바꿔주면 더욱 자연스럽게 위장할 수 있습니다.

Scrapy 예시:

1class MySpider(scrapy.Spider):

2 custom_settings = {

3 'DEFAULT_REQUEST_HEADERS': {

4 'User-Agent': '...',

5 'Accept-Language': 'en-US,en;q=0.9',

6 # 추가 헤더

7 }

8 }Selenium 사용 시: 브라우저 프로필, 확장 프로그램, 자바스크립트로 헤더를 조작할 수 있습니다.

실제 브라우저의 네트워크 요청을 참고해 헤더를 최신 상태로 유지하세요.

전통적 파이썬 스크래핑의 한계: 진화하는 차단 기술

현실적으로, 스크래핑이 대중화될수록 차단 기술도 고도화되고 있습니다. 하는 사이트가 늘고 있습니다. AI 기반 탐지, 동적 요청 임계치, 브라우저 지문 추적 등으로 인해, 숙련된 파이썬 스크립트도 점점 더 쉽게 탐지됩니다 ().

아무리 코드를 잘 짜도 한계에 부딪힐 때가 있습니다. 그럴 땐 새로운 접근이 필요합니다.

Thunderbit: 파이썬 스크래핑을 대체하는 AI 웹 스크래퍼

파이썬이 한계에 다다랐다면, 이 해답이 될 수 있습니다. Thunderbit은 개발자가 아니어도 누구나 쓸 수 있는 노코드, AI 기반 웹 스크래퍼입니다. 프록시, 헤더, CAPTCHA 걱정 없이, Thunderbit의 AI가 웹사이트를 읽고, 추출할 필드를 추천하며, 하위 페이지 탐색부터 데이터 내보내기까지 모두 자동으로 처리합니다.

Thunderbit만의 차별점

- AI 필드 추천: "AI 필드 추천" 버튼만 누르면, Thunderbit이 페이지를 분석해 컬럼을 제안하고 추출 규칙까지 자동 생성

- 하위 페이지 스크래핑: 상품 상세, LinkedIn 프로필 등 하위 페이지도 자동 방문해 데이터 확장

- 클라우드/브라우저 스크래핑: 공개 사이트는 클라우드, 로그인 필요한 페이지는 브라우저 등 상황에 맞게 선택

- 스케줄 스크래핑: 예약만 해두면, 항상 최신 데이터 자동 수집

- 즉시 사용 가능한 템플릿: Amazon, Zillow, Shopify 등 인기 사이트는 1클릭 템플릿 제공

- 무료 데이터 내보내기: Excel, Google Sheets, Airtable, Notion 등으로 추가 비용 없이 내보내기 가능

Thunderbit은 가 신뢰하며, 코딩 한 줄 없이 사용할 수 있습니다.

Thunderbit가 차단 없이 자동화된 데이터 추출을 지원하는 방식

Thunderbit의 AI는 단순히 인간 행동을 흉내내는 데 그치지 않고, 각 사이트에 맞춰 실시간으로 전략을 조정해 차단 위험을 최소화합니다. 주요 특징은 다음과 같습니다:

- AI가 레이아웃 변화에 자동 대응: 사이트 디자인이 바뀌어도 스크립트가 깨지지 않음

- 하위 페이지/페이지네이션 자동 처리: 실제 사용자처럼 링크와 페이지 리스트를 따라감

- 대량 클라우드 스크래핑: 최대 50페이지 동시 처리, 빠른 속도

- 코딩/유지보수 필요 없음: 분석에만 집중, 디버깅 걱정 끝

자세한 내용은 에서 확인하세요.

파이썬 스크래핑 vs Thunderbit: 무엇을 선택해야 할까?

비교해보면 다음과 같습니다:

| 기능 | 파이썬 스크래핑 | Thunderbit |

|---|---|---|

| 세팅 시간 | 중~상 (스크립트, 프록시 등 필요) | 매우 빠름 (2번 클릭, AI 자동 처리) |

| 기술 요구 | 코딩 필수 | 코딩 불필요 |

| 신뢰성 | 상황에 따라 다름 (쉽게 깨짐) | 높음 (AI가 변화에 적응) |

| 차단 위험 | 중~상 | 매우 낮음 (AI가 사용자처럼 행동) |

| 확장성 | 별도 코드/클라우드 세팅 필요 | 클라우드/배치 스크래핑 내장 |

| 유지보수 | 잦음 (사이트 변경, 차단 등) | 최소화 (AI 자동 조정) |

| 내보내기 | 수동(CSV, DB 등) | Sheets, Notion, Airtable, CSV 바로 내보내기 |

| 비용 | 무료(시간 소모 큼) | 무료 플랜, 대량은 유료 |

파이썬이 적합한 경우:

- 세밀한 제어, 커스텀 로직, 파이썬 워크플로우와의 연동이 필요할 때

- 차단 기술이 약한 단순 사이트를 스크래핑할 때

Thunderbit이 적합한 경우:

- 빠르고 안정적인 데이터 수집이 필요할 때

- 복잡하거나 자주 바뀌는 사이트를 스크래핑할 때

- 프록시, CAPTCHA, 코드 관리가 번거로울 때

실전 가이드: 파이썬으로 차단 없이 웹 스크래핑 세팅하기

실제 예시로, 상품 데이터를 스크래핑하면서 차단 방지 팁을 적용해봅시다.

1. 필수 라이브러리 설치

1pip install requests beautifulsoup4 fake-useragent2. 스크립트 준비

1import requests

2from bs4 import BeautifulSoup

3from fake_useragent import UserAgent

4import time, random

5ua = UserAgent()

6urls = ["<https://example.com/product/1>", "<https://example.com/product/2>"] # 실제 URL로 교체

7for url in urls:

8 headers = {

9 "User-Agent": ua.random,

10 "Accept-Language": "en-US,en;q=0.9"

11 }

12 response = requests.get(url, headers=headers)

13 if response.status_code == 200:

14 soup = BeautifulSoup(response.text, "html.parser")

15 # 데이터 추출

16 print(soup.title.text)

17 else:

18 print(f"{url}에서 차단 또는 오류 발생: {response.status_code}")

19 time.sleep(random.uniform(2, 6)) # 랜덤 대기3. 프록시 회전 추가(선택)

1proxies = [

2 "<http://proxy1.example.com:8000>",

3 "<http://proxy2.example.com:8000>",

4 # 더 많은 프록시

5]

6for i, url in enumerate(urls):

7 proxy = {"http": proxies[i % len(proxies)]}

8 headers = {"User-Agent": ua.random}

9 response = requests.get(url, headers=headers, proxies=proxy)

10 # ...이하 동일4. 쿠키/세션 처리

1session = requests.Session()

2for url in urls:

3 response = session.get(url, headers=headers)

4 # ...이하 동일5. 문제 해결 팁

- 403/429 에러가 많으면 요청 속도를 줄이거나 프록시를 바꿔보세요.

- CAPTCHA가 뜨면 Selenium이나 CAPTCHA 솔버를 활용하세요.

- 사이트의

robots.txt와 이용약관을 반드시 확인하세요.

결론 & 핵심 요약

파이썬 웹 스크래핑은 강력하지만, 차단 기술의 발전으로 항상 위험이 따릅니다. 차단을 피하려면 프록시 회전, 헤더 위장, 랜덤 딜레이, 세션 관리, 헤드리스 브라우저 등 다양한 기술을 조합하고, 사이트 규칙과 윤리도 반드시 지켜야 합니다.

하지만 때로는 파이썬만으로는 한계가 있습니다. 이럴 때 같은 AI 기반 도구를 활용하면, 코딩 없이도 차단 걱정 없이 빠르고 안정적으로 데이터를 수집할 수 있습니다.

웹 스크래핑이 얼마나 쉬워질 수 있는지 직접 경험해보고 싶다면, 을 설치해보세요. 더 많은 팁과 튜토리얼은 에서 확인할 수 있습니다.

자주 묻는 질문(FAQ)

1. 왜 웹사이트는 파이썬 웹 스크래퍼를 차단하나요?

웹사이트는 데이터 보호, 서버 과부하 방지, 자동화된 봇의 남용 차단을 위해 스크래퍼를 막습니다. 파이썬 스크립트는 기본 헤더 사용, 쿠키 미처리, 과도한 요청 등으로 쉽게 탐지될 수 있습니다.

2. 파이썬으로 스크래핑 시 차단을 피하는 가장 효과적인 방법은?

프록시 회전, 실제 브라우저와 유사한 User-Agent/헤더 설정, 요청 간격 무작위화, 쿠키/세션 관리, Selenium/Playwright 등으로 인간 행동을 시뮬레이션하세요.

3. Thunderbit는 파이썬 스크립트와 비교해 어떻게 차단을 피하나요?

Thunderbit는 AI로 사이트 레이아웃에 적응하고, 실제 사용자처럼 탐색하며, 하위 페이지/페이지네이션도 자동 처리합니다. 실시간으로 전략을 바꿔 차단 위험을 줄이고, 코딩이나 프록시 없이도 사용할 수 있습니다.

4. 파이썬 스크래핑과 Thunderbit, 언제 각각 써야 하나요?

커스텀 로직, 파이썬 코드 연동, 단순 사이트라면 파이썬이 적합합니다. 빠르고 신뢰성 높은 대량/복잡 사이트 스크래핑, 차단 걱정 없는 자동화가 필요하다면 Thunderbit이 더 효율적입니다.

5. 웹 스크래핑은 합법인가요?

공개 데이터에 한해 합법이지만, 각 사이트의 이용약관, 개인정보 보호정책, 관련 법률을 반드시 준수해야 합니다. 민감하거나 비공개 데이터는 절대 스크래핑하지 마시고, 항상 윤리적으로 접근하세요.

더 똑똑하게, 더 쉽게 스크래핑하고 싶으신가요? Thunderbit을 직접 체험해보세요. 차단 걱정은 이제 그만!

더 알아보기:

- 파이썬으로 Google 뉴스 스크래핑: 단계별 가이드

- 파이썬으로 Best Buy 가격 추적기 만들기

- 차단 없이 웹 스크래핑하는 14가지 방법

- 웹 스크래핑 차단 방지 10가지 꿀팁