한 번쯤은 이런 경험 있으시죠? 커피 한 잔 들고 책상에 앉아, 텅 빈 스프레드시트를 멍하니 바라보는 그 순간. 영업팀은 경쟁사 가격 정보가 필요하다 하고, 마케팅팀은 새로운 리드가 급하다 하고, 운영팀은 여러 사이트의 상품 목록을 어제까지 달라고 재촉합니다. 데이터가 웹에 있다는 건 다 알지만, 그걸 직접 가져오는 게 진짜 골치 아픈 일입니다. 혹시 복붙만 하다 지친 적 있다면, 저만 그런 거 아니에요.

하지만 요즘은 완전히 달라졌어요. 웹 스크래핑은 이제 개발자들만의 취미가 아니라, 비즈니스의 핵심 전략이 됐습니다. JavaScript와 Node.js는 단순한 스크립트부터 대규모 데이터 파이프라인까지, 웹 스크래핑의 중심에 자리 잡았죠. 물론 도구는 좋아졌지만, 여전히 시작이 쉽진 않습니다. 그래서 이 글에서는 비즈니스 실무자, 데이터 분석가, 그리고 반복적인 데이터 입력에 지친 모든 분들을 위해 웹 스크래핑 생태계, 필수 라이브러리, 어려운 점, 그리고 때로는 AI에게 맡기는 게 왜 똑똑한 선택인지까지 쫙 정리해드릴게요.

왜 JavaScript와 Node.js로 웹 스크래핑을 해야 할까?

먼저, 왜 이걸 써야 하는지부터 짚고 넘어가야겠죠. 2025년, 웹 데이터는 선택이 아니라 필수입니다. 최근 조사에 따르면, 고 답했고, 가 웹 데이터 수집에 쓰이고 있습니다. 웹 스크래핑을 포함한 대체 데이터 시장은 이미 로 빠르게 성장 중이죠.

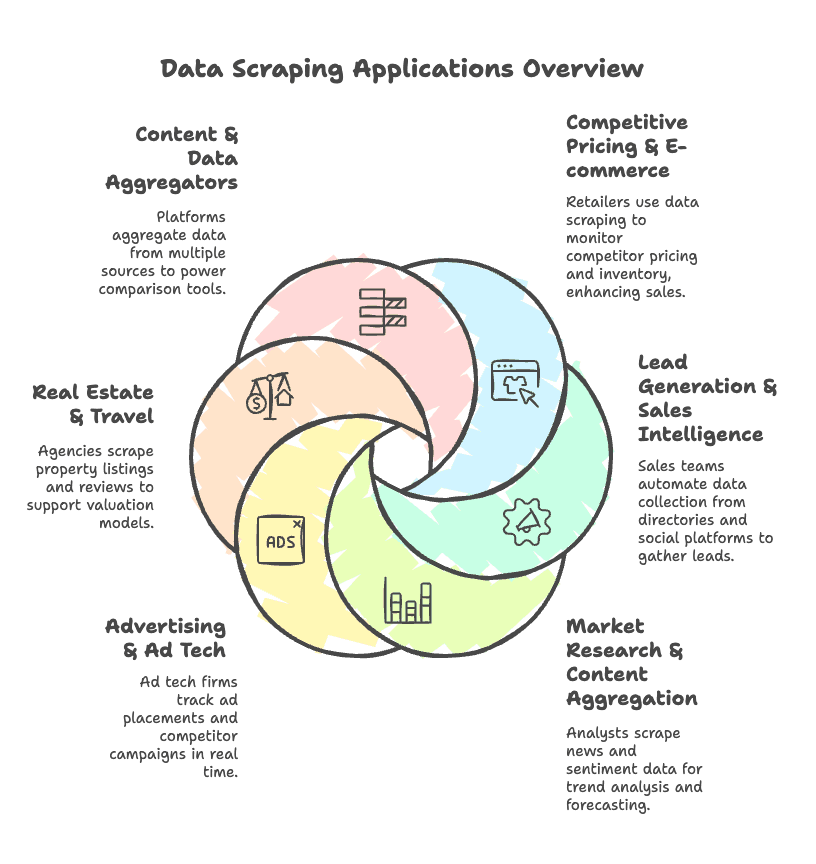

이런 데이터 경쟁의 배경에는 어떤 활용 사례가 있을까요?

- 경쟁사 가격 및 이커머스 분석: 소매업체들은 경쟁사 사이트에서 가격과 재고를 수집해 매출을 끌어올리기도 합니다.

- 리드 생성 및 영업 인텔리전스: 영업팀은 디렉터리나 소셜 플랫폼에서 이메일, 연락처, 회사 정보를 자동으로 수집합니다.

- 시장 조사 및 콘텐츠 집계: 분석가들은 뉴스, 리뷰, 감성 데이터를 모아 트렌드를 파악하고 예측합니다.

- 광고 및 애드테크: 광고 기술 기업은 실시간으로 광고 위치와 경쟁사 캠페인을 추적합니다.

- 부동산 및 여행: 에이전시들은 부동산 매물, 가격, 리뷰를 수집해 가치 평가와 시장 분석에 활용합니다.

- 콘텐츠 및 데이터 집계 플랫폼: 여러 소스의 데이터를 모아 비교 도구나 대시보드에 제공합니다.

이처럼 JavaScript와 Node.js는 동적 콘텐츠가 많은 요즘 웹사이트에 딱 맞는 스택입니다. Node.js는 비동기 처리에 강해서 대량 데이터 수집에 적합하고, 다양한 라이브러리 덕분에 간단한 스크립트부터 대규모 자동화까지 다 할 수 있어요.

핵심 워크플로우: JavaScript와 Node.js로 웹 스크래핑하는 방법

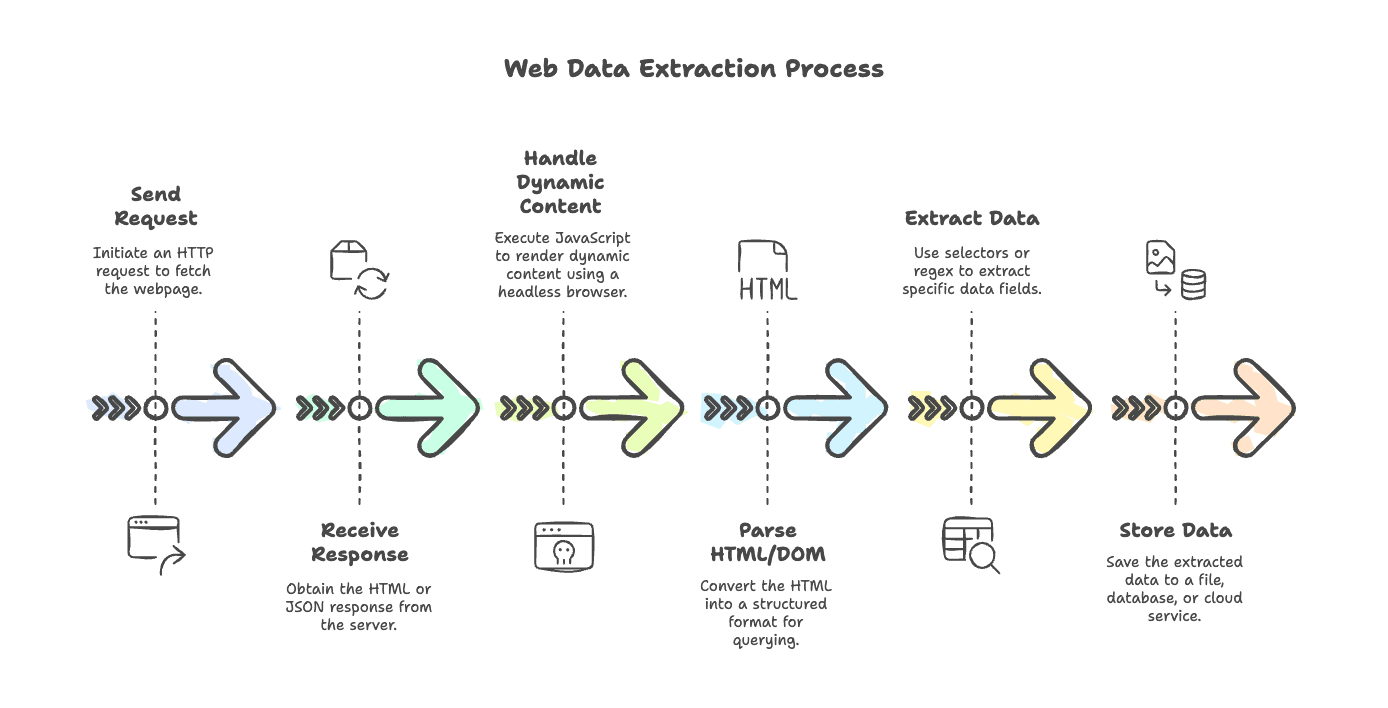

웹 스크래핑의 기본 흐름, 어렵지 않게 풀어볼게요. 단순한 블로그든, JavaScript로 렌더링되는 이커머스 사이트든, 기본 단계는 비슷합니다.

- 요청 보내기: HTTP 클라이언트(예:

axios,node-fetch,got)로 페이지 요청 - 응답 받기: 서버에서 HTML(또는 JSON) 데이터 수신

- 동적 콘텐츠 처리: JavaScript로 렌더링된 페이지라면 Puppeteer, Playwright 같은 헤드리스 브라우저로 최종 콘텐츠 확보

- HTML/DOM 파싱:

cheerio,jsdom등으로 HTML을 구조화 - 데이터 추출: 셀렉터나 정규식으로 필요한 정보 뽑기

- 데이터 저장: 파일, 데이터베이스, 클라우드 등에 저장

각 단계별로 어떤 도구가 좋은지, 아래에서 더 자세히 알려드릴게요.

웹 스크래핑용 HTTP 요청 라이브러리

스크래핑의 시작은 HTTP 요청이죠. Node.js에는 선택지가 정말 많아요.

1. Axios

Promise 기반 HTTP 클라이언트로, 거의 모든 스크래핑에 만능입니다.

1const axios = require('axios');

2const response = await axios.get('https://example.com/api/items', { timeout: 5000 });

3console.log(response.data);장점: 기능 풍부, async/await 지원, JSON 자동 파싱, 인터셉터, 프록시 지원

단점: 다소 무겁고, 내부 동작이 복잡할 수 있음

2. node-fetch

브라우저의 fetch API를 Node.js에서 쓸 수 있게 해주는 경량 라이브러리입니다.

1import fetch from 'node-fetch';

2const res = await fetch('https://api.github.com/users/github');

3const data = await res.json();

4console.log(data);장점: 가볍고, 프론트엔드 개발자에게 익숙한 API

단점: 기능이 적고, 에러 처리와 프록시 설정이 번거로움

3. SuperAgent

체이닝 방식의 API를 제공하는 오래된 HTTP 라이브러리입니다.

1const superagent = require('superagent');

2const res = await superagent.get('https://example.com/data');

3console.log(res.body);장점: 성숙한 라이브러리, 폼/파일 업로드, 플러그인 지원

단점: API가 다소 구식, 의존성 큼

4. Unirest

간단하고 언어 중립적인 HTTP 클라이언트입니다.

1const unirest = require('unirest');

2unirest.get('https://httpbin.org/get?query=web')

3 .end(response => {

4 console.log(response.body);

5 });장점: 문법이 쉽고, 빠른 스크립트에 적합

단점: 기능이 적고, 커뮤니티가 작음

5. Got

고급 기능을 갖춘 빠른 HTTP 클라이언트입니다.

1import got from 'got';

2const html = await got('https://example.com/page').text();

3console.log(html.length);장점: 빠르고, HTTP/2, 재시도, 스트림 지원

단점: Node.js 전용, 초보자에겐 다소 복잡

6. Node 내장 http/https

가장 기본적인 방법입니다.

1const https = require('https');

2https.get('https://example.com/data', (res) => {

3 let data = '';

4 res.on('data', chunk => { data += chunk; });

5 res.on('end', () => {

6 console.log('Response length:', data.length);

7 });

8});장점: 외부 의존성 없음

단점: 코드가 장황하고, 콜백 위주, Promise 미지원

프로젝트에 맞는 HTTP 클라이언트 고르기

선택 기준은 이렇습니다:

- 사용 편의성: Axios, Got은 async/await와 깔끔한 문법 지원

- 성능: Got, node-fetch는 대량 동시 요청에 적합

- 프록시 지원: Axios, Got은 프록시 회전이 쉬움

- 에러 처리: Axios는 HTTP 에러에 자동 대응, node-fetch는 수동 체크 필요

- 커뮤니티: Axios, Got은 예제와 지원이 풍부

간단 추천:

- 빠른 스크립트/프로토타입: node-fetch, Unirest

- 실전/대규모 스크래핑: Axios(기능), Got(성능)

- 브라우저 자동화: Puppeteer, Playwright

HTML 파싱과 데이터 추출: Cheerio, jsdom 등

HTML을 받아왔다면, 이제 진짜 데이터를 뽑아야죠. 이때 파서가 필요합니다.

Cheerio

서버에서 jQuery처럼 쓸 수 있는 빠르고 가벼운 파서입니다.

1const cheerio = require('cheerio');

2const $ = cheerio.load('<ul><li class="item">Item 1</li></ul>');

3$('.item').each((i, el) => {

4 console.log($(el).text());

5});장점: 매우 빠르고, 익숙한 API, 지저분한 HTML도 잘 처리

단점: JavaScript 실행 불가, HTML만 파싱

jsdom

Node.js에서 브라우저와 비슷한 DOM 환경을 제공합니다. 간단한 스크립트 실행도 가능합니다.

1const { JSDOM } = require('jsdom');

2const dom = new JSDOM(`<p id="greet">Hello</p><script>document.querySelector('#greet').textContent += ", world!";</script>`);

3console.log(dom.window.document.querySelector('#greet').textContent);장점: 스크립트 실행 가능, DOM API 지원

단점: Cheerio보다 느리고 무거움, 완전한 브라우저는 아님

정규식 및 기타 파싱 방법 활용 시점

정규식은 웹 스크래핑에서 양념처럼 적당히 쓰면 좋습니다. 예를 들어:

- 텍스트에서 이메일, 전화번호, 가격 등 패턴 추출

- 데이터 정제 및 검증

- 스크립트 태그 등에서 값 뽑기

예시: 텍스트에서 숫자 추출

1const text = "Total sales: 1,234 units";

2const match = text.match(/([\d,]+)\s*units/);

3if (match) {

4 const units = parseInt(match[1].replace(/,/g, ''));

5 console.log("Units sold:", units);

6}단, 전체 HTML 파싱에는 DOM 파서를 쓰는 게 안전합니다.

동적 웹사이트 처리: Puppeteer, Playwright, 헤드리스 브라우저

요즘 웹사이트는 JavaScript로 데이터를 렌더링하는 경우가 많아요. 이런 경우, 단순 HTML 요청만으로는 원하는 정보를 얻기 어렵죠. 이럴 때 헤드리스 브라우저가 필요합니다.

Puppeteer

Google에서 만든 Node.js용 Chrome/Chromium 자동화 라이브러리입니다. 실제 브라우저처럼 페이지를 조작할 수 있습니다.

1const puppeteer = require('puppeteer');

2const browser = await puppeteer.launch();

3const page = await browser.newPage();

4await page.goto('https://example.com');

5const title = await page.$eval('h1', el => el.textContent);

6console.log(title);

7await browser.close();장점: 실제 Chrome 렌더링, 쉬운 API, 동적 콘텐츠에 강함

단점: 크롬 전용, 리소스 소모 큼

Playwright

Microsoft에서 만든 최신 라이브러리로, Chromium, Firefox, WebKit까지 지원합니다.

1const { chromium } = require('playwright');

2const browser = await chromium.launch();

3const page = await browser.newPage();

4await page.goto('https://example.com');

5const content = await page.textContent('h1');

6console.log(content);

7await browser.close();장점: 다양한 브라우저 지원, 병렬 처리, 요소 자동 대기

단점: 설치 용량 크고, 학습 곡선이 있음

Nightmare

Electron 기반의 구형 자동화 도구로, 유지보수는 거의 되지 않습니다. 레거시 프로젝트에만 권장합니다.

헤드리스 브라우저 비교

| Aspect | Puppeteer (Chrome) | Playwright (Multi-browser) | Nightmare (Electron) |

|---|---|---|---|

| Browser Support | Chrome/Edge | Chrome, Firefox, WebKit | Chrome (old) |

| Performance & Scale | Fast, but heavy | Fast, better parallelism | Slower, less stable |

| Dynamic Scraping | Excellent | Excellent + more features | OK for simple sites |

| Maintenance | Well-maintained | Very active | Deprecated |

| Best For | Chrome scraping | Complex, cross-browser | Simple, legacy jobs |

추천: 복잡한 신규 프로젝트에는 Playwright, 크롬 전용 작업에는 Puppeteer, 구형 스크립트에는 Nightmare를 사용하세요.

보조 도구: 스케줄링, 환경 관리, CLI, 데이터 저장

실제 스크래퍼는 단순히 데이터만 뽑는 게 아니라, 다양한 보조 도구와 함께 사용됩니다.

스케줄링: node-cron

스크래핑 작업을 자동으로 예약 실행할 수 있습니다.

1const cron = require('node-cron');

2cron.schedule('0 9 * * MON', () => {

3 console.log('매주 월요일 오전 9시에 스크래핑 실행');

4});환경 변수 관리: dotenv

API 키 등 민감한 정보를 코드에서 분리할 수 있습니다.

1require('dotenv').config();

2const apiKey = process.env.API_KEY;CLI 도구: chalk, commander, inquirer

- chalk: 콘솔 출력 색상 지정

- commander: 명령줄 옵션 파싱

- inquirer: 사용자 입력 프롬프트

데이터 저장

- fs: 파일(JSON, CSV) 저장

- lowdb: 경량 JSON DB

- sqlite3: 로컬 SQL DB

- mongodb: 대규모 프로젝트용 NoSQL DB

예시: JSON 파일로 저장

1const fs = require('fs');

2fs.writeFileSync('output.json', JSON.stringify(data, null, 2));전통적인 JavaScript/Node.js 웹 스크래핑의 어려움

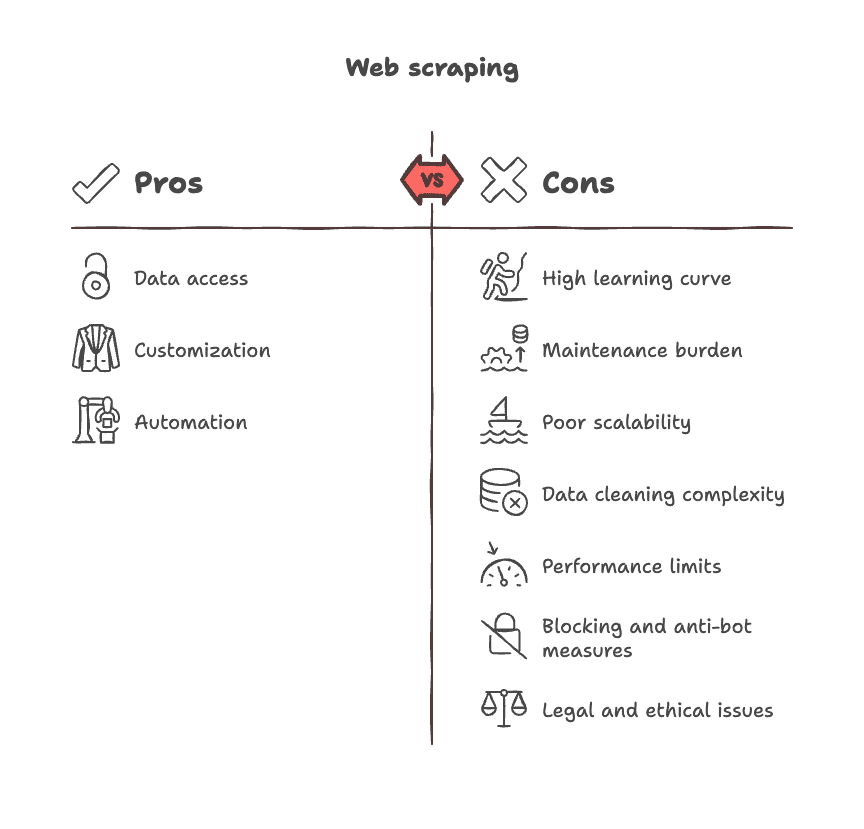

현실적으로, 전통적인 스크래핑은 쉽지 않습니다. 대표적인 문제점은 다음과 같습니다.

- 높은 학습 곡선: DOM, 셀렉터, 비동기 로직, 브라우저 특성까지 익혀야 함

- 유지보수 부담: 사이트 구조가 바뀌면 코드도 계속 수정해야 함

- 확장성 한계: 사이트마다 별도 스크립트 필요, 범용성 부족

- 데이터 정제의 어려움: 수집 데이터가 지저분해 추가 정제 작업 필요

- 성능 한계: 브라우저 자동화는 대규모 작업에 느리고 리소스 소모 큼

- 차단 및 봇 방지: 사이트에서 스크래퍼 차단, CAPTCHA, 로그인 등 장애물

- 법적/윤리적 이슈: 서비스 약관, 개인정보, 컴플라이언스 등 고려 필요

Thunderbit vs. 전통적 웹 스크래핑: 생산성 혁신

이제 중요한 질문! 만약 코드, 셀렉터, 유지보수 걱정 없이 데이터를 얻을 수 있다면 어떨까요?

바로 가 그 해답입니다. 저는 Thunderbit의 공동 창업자이자 CEO로서, 이 도구가 비즈니스 사용자를 위해 만들어졌다는 점을 강조하고 싶어요.

Thunderbit와 전통적 스크래핑 비교

| Aspect | Thunderbit (AI No-Code) | Traditional JS/Node Scraping |

|---|---|---|

| Setup | 2번 클릭, 코드 불필요 | 스크립트 작성, 디버깅 필요 |

| Dynamic Content | 브라우저 내 자동 처리 | 헤드리스 브라우저 스크립팅 |

| Maintenance | AI가 자동 적응 | 수동 코드 수정 필요 |

| Data Extraction | AI가 필드 추천 | 수동 셀렉터 지정 |

| Subpage Scraping | 1클릭 내장 지원 | 사이트별 반복 코드 작성 |

| Export | 엑셀, 시트, Notion 등 | 파일/DB 연동 직접 구현 |

| Post-processing | 요약, 태깅, 포맷 자동 | 추가 코드/도구 필요 |

| Who Can Use | 브라우저만 있으면 누구나 | 개발자만 가능 |

Thunderbit는 AI가 페이지를 읽고, 필드를 추천하며, 클릭 몇 번만으로 데이터를 수집합니다. 하위 페이지도 자동으로 따라가고, 레이아웃이 바뀌어도 AI가 적응합니다. 요약, 태깅, 번역까지 실시간으로 처리하며, 엑셀, 구글 시트, Airtable, Notion 등으로 바로 내보낼 수 있습니다.

Thunderbit가 빛을 발하는 활용 사례:

- 이커머스팀: 경쟁사 SKU/가격 추적

- 영업팀: 리드 및 연락처 수집

- 시장조사팀: 뉴스/리뷰 집계

- 부동산 중개인: 매물 및 상세 정보 수집

자주 반복되는 데이터 수집에는 Thunderbit가 정말 시간 절약이 큽니다. 물론 대규모 맞춤형 프로젝트에는 전통적 스크립팅이 필요할 수 있지만, 대부분의 팀에게 Thunderbit는 '데이터가 필요하다'에서 '데이터를 확보했다'까지 가장 빠른 길이에요.

또는 에서 다양한 활용 사례를 확인해보세요.

빠른 참고: 인기 JavaScript & Node.js 웹 스크래핑 라이브러리

2025년 기준, JavaScript 스크래핑 생태계의 핵심 라이브러리를 정리했습니다.

HTTP 요청

- : Promise 기반, 기능 풍부

- : Node.js용 Fetch API

- : 빠르고 고급 기능 지원

- : 체이닝 방식, 성숙한 라이브러리

- : 간단한 문법, 경량

HTML 파싱

- : 빠르고 jQuery 유사

- : 브라우저 유사 DOM 환경

동적 콘텐츠

- : 헤드리스 Chrome 자동화

- : 멀티 브라우저 자동화

- : Electron 기반, 구형

스케줄링

- : Node.js용 크론 작업

CLI & 유틸리티

- : 터미널 문자열 스타일링

- : CLI 인자 파싱

- : CLI 프롬프트

- : 환경 변수 로더

저장소

- : 내장 파일 시스템

- : 경량 JSON DB

- : 로컬 SQL DB

- : NoSQL DB

프레임워크

- : 고수준 크롤링/스크래핑 프레임워크

(항상 최신 문서와 GitHub를 참고하세요.)

웹 스크래핑 JavaScript 실력 향상을 위한 추천 자료

더 깊이 배우고 싶다면, 아래 자료를 참고하세요.

공식 문서 & 가이드

튜토리얼 & 강의

오픈소스 프로젝트 & 예제

커뮤니티 & 포럼

도서 & 종합 가이드

- O’Reilly “Web Scraping with Python” (언어 불문 개념 학습용)

- Udemy/Coursera: “Node.js 웹 스크래핑” 강의

(최신판과 업데이트를 꼭 확인하세요.)

결론: 우리 팀에 맞는 웹 스크래핑 방식은?

정리하자면, JavaScript와 Node.js는 웹 스크래핑에 강력한 유연성과 확장성을 제공합니다. 간단한 스크립트부터 대규모 크롤러까지 직접 구축할 수 있죠. 하지만 그만큼 유지보수와 관리 부담도 큽니다. 개발 리소스가 충분하고, 맞춤형 통제가 필요한 프로젝트라면 전통적 스크립팅이 적합합니다.

반면, 비즈니스 사용자, 분석가, 마케터 등 '데이터만 빠르게 얻고 싶은' 분들에게는 Thunderbit 같은 최신 노코드 솔루션이 훨씬 효율적입니다. Thunderbit의 AI 기반 크롬 확장 프로그램을 사용하면, 코드나 셀렉터 없이 몇 분 만에 데이터를 수집·구조화·내보낼 수 있습니다.

결국 선택은 팀의 역량과 목표에 달려 있습니다. 개발 역량과 커스텀 요구가 있다면 Node.js 도구를, 속도와 단순함, 인사이트에 집중하고 싶다면 Thunderbit를 추천합니다. 웹은 곧 데이터베이스입니다. 원하는 데이터를 자유롭게 활용해보세요.

혹시 막히는 부분이 있다면, 모든 스크래퍼도 처음엔 빈 페이지와 진한 커피 한 잔에서 시작했다는 걸 기억하세요. 즐거운 스크래핑 되시길!

AI 기반 스크래핑이나 Thunderbit 활용법이 궁금하다면?

질문이나 경험담, 혹은 스크래핑 관련 에피소드가 있다면 댓글이나 연락을 남겨주세요. 여러분이 웹을 데이터 놀이터로 바꾸는 이야기를 듣는 걸 좋아합니다.

호기심을 잃지 말고, 커피와 함께, 더 똑똑하게 스크래핑하세요!

자주 묻는 질문(FAQ):

1. 2025년에 JavaScript와 Node.js로 웹 스크래핑을 해야 하는 이유는?

대부분의 최신 웹사이트가 JavaScript로 만들어지기 때문입니다. Node.js는 빠르고 비동기 처리에 강하며, Axios, Cheerio, Puppeteer 등 다양한 생태계가 단순 요청부터 대규모 동적 스크래핑까지 지원합니다.

2. Node.js로 웹사이트를 스크래핑하는 기본 흐름은?

일반적으로 다음과 같습니다:

요청 → 응답 처리 → (필요시 JS 실행) → HTML 파싱 → 데이터 추출 → 저장/내보내기

각 단계별로 axios, cheerio, puppeteer 등 전용 도구를 활용할 수 있습니다.

3. 동적, JavaScript 렌더링 페이지는 어떻게 스크래핑하나요?

Puppeteer나 Playwright 같은 헤드리스 브라우저를 사용하세요. 실제 사용자처럼 전체 페이지(스크립트 포함)를 로드해 원하는 데이터를 추출할 수 있습니다.

4. 전통적 스크래핑의 가장 큰 어려움은?

- 사이트 구조 변경

- 봇 탐지 및 차단

- 브라우저 리소스 소모

- 수동 데이터 정제

- 장기적으로 높은 유지보수 비용

이런 점 때문에 대규모나 비개발자에게는 부담이 큽니다.

5. 코드 대신 Thunderbit를 써야 하는 경우는?

빠르고 간편하게, 코드 작성이나 유지보수 없이 데이터를 얻고 싶을 때 Thunderbit가 제격입니다. 특히 영업, 마케팅, 리서치팀이 복잡하거나 다중 페이지 웹사이트에서 데이터를 빠르게 추출·구조화할 때 이상적입니다.