웹 스크래핑에 처음 발을 들였을 때, ‘HTML만 긁어오면 끝이지 않을까?’라고 생각했던 적이 있어요. 그런데 직접 해보니, 웹 스크래핑이 영업, 이커머스, 시장 조사 등 다양한 분야에서 없어서는 안 될 핵심 역량이란 걸 몸소 느끼게 됐죠. 웹에는 가 존재하고, 기업들은 이 방대한 데이터를 활용해 인사이트를 얻으려 합니다. 문제는, 대부분의 데이터가 동적 페이지, 자바스크립트, 인터랙티브 요소 등으로 숨어 있다는 점이죠. 단순한 도구로는 접근이 쉽지 않습니다.

이럴 때 Python 기반의 웹 스크래퍼, 특히 Selenium이 정말 유용하게 쓰입니다. Selenium Python을 활용하면 실제 브라우저를 자동으로 조작해서 복잡한 동적 웹사이트에서도 데이터를 쉽게 뽑아낼 수 있어요. 하지만 처음 접하는 분들에겐 다소 어렵게 느껴질 수 있습니다. 이 글에서는 의 상품 데이터를 예시로, Selenium을 활용한 웹 스크래핑 과정을 단계별로 안내할게요. 그리고 최근 주목받는 AI 기반 도구인 을 활용하면 훨씬 빠르고 간편하게 같은 작업을 할 수 있다는 점도 함께 소개합니다.

웹 스크래핑이 왜 중요한가? (그리고 동적 사이트가 왜 어려운가)

이제 웹 스크래핑은 개발자만의 취미가 아닙니다. 영업, 마케팅, 이커머스, 운영팀 등 다양한 조직에서 경쟁사 가격 모니터링, 리드 생성, 리뷰 분석 등 핵심 업무에 적극적으로 활용되고 있어요. 실제로 이 가격 데이터를 주요 타깃으로 삼고 있고, 온라인 데이터의 **80~90%**는 비정형 데이터라 단순 복사/붙여넣기로는 활용이 어렵습니다.

문제는 요즘 웹사이트 대부분이 동적으로 동작한다는 점이에요. 자바스크립트로 콘텐츠를 불러오거나, 버튼을 눌러야 데이터가 보이거나, 무한 스크롤이 적용된 경우가 많죠. requests나 BeautifulSoup 같은 단순 스크래퍼는 정적인 HTML만 볼 수 있어서, 마치 업데이트가 안 되는 신문을 읽는 것과 비슷합니다. 클릭, 스크롤, 로그인 등 사용자 행동이 필요한 데이터라면, 실제 사용자처럼 동작할 수 있는 도구가 필요합니다.

Selenium Python이란? 웹 스크래핑에 왜 쓰일까?

Selenium Python은 쉽게 말해 브라우저를 자동으로 조작하는 도구입니다. Python 코드로 실제 브라우저를 움직여서 버튼 클릭, 폼 입력, 페이지 스크롤 등 다양한 동작을 자동화할 수 있고, 그 과정에서 동적으로 생성되는 데이터도 추출할 수 있죠.

Selenium Python과 단순 스크래퍼의 차이

- Selenium Python: 실제 브라우저(크롬 등)를 자동화해서 자바스크립트 실행, 동적 요소 조작, 콘텐츠 로딩 대기 등 사람이 하는 모든 행동을 흉내낼 수 있습니다.

- Requests/BeautifulSoup: 정적 HTML만 가져올 수 있어서, 자바스크립트나 사용자 행동이 필요한 데이터는 수집이 불가능합니다. 빠르고 가볍지만 한계가 뚜렷하죠.

Selenium은 마치 브라우저를 대신 움직여주는 로봇 인턴 같아요. 명확한 지시와 약간의 인내심만 있으면, 사람이 하는 거의 모든 작업을 자동화할 수 있습니다.

Selenium을 꼭 써야 하는 상황

- 무한 스크롤 피드 (예: 소셜 미디어, 상품 리스트)

- 인터랙티브 필터/드롭다운 (예: 에서 신발 사이즈 선택)

- 로그인이나 팝업 뒤에 숨겨진 콘텐츠

- SPA(Single Page Application, React/Vue 등)

정적 텍스트만 필요하다면 BeautifulSoup으로도 충분하지만, 동적 요소가 있다면 Selenium이 정답입니다.

Selenium Python 환경 준비하기

본격적으로 시작하기 전에, 필요한 환경을 하나씩 준비해볼게요. 처음 해보는 분들도 따라할 수 있도록 쉽게 설명합니다.

1. Python과 Selenium 설치

먼저 Python 3이 설치되어 있는지 확인하세요. 에서 다운로드할 수 있습니다. 설치 여부는 아래 명령어로 확인할 수 있어요:

1python --version다음으로 pip로 Selenium을 설치합니다:

1pip install selenium최신 Selenium 패키지가 설치됩니다. 간단하죠?

2. ChromeDriver 다운로드 및 설정

Selenium이 브라우저를 제어하려면 ‘드라이버’가 필요합니다. 크롬의 경우 를 사용해요.

- 크롬 버전 확인: 크롬에서 메뉴 → 도움말 → Chrome 정보에서 버전을 확인하세요.

- ChromeDriver 다운로드: 내 브라우저 버전에 맞는 드라이버를 받으세요.

- 드라이버 위치 지정:

chromedriver.exe(또는 Mac/Linux용 파일)를 시스템 PATH나 프로젝트 폴더에 넣으세요.

팁: webdriver_manager 같은 Python 패키지를 쓰면 드라이버를 자동으로 관리할 수 있지만, 처음엔 수동으로 해도 충분합니다.

3. 환경 테스트

모든 준비가 끝났다면, test_selenium.py라는 파일을 만들어 아래 코드를 실행해보세요:

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://www.example.com")

4print(driver.title)

5driver.quit()크롬이 열리고 에 접속한 뒤, 타이틀을 출력하고 브라우저가 닫히면 성공입니다. ‘Chrome이 자동화 테스트 소프트웨어에 의해 제어되고 있습니다’라는 메시지가 보이면 정상이에요!

Selenium Python으로 상품 데이터 스크래핑 실전

이제 Selenium을 실전에 투입해봅시다. 목표는 에서 상품명과 가격을 추출하는 거예요.

1단계: 브라우저 실행 및 페이지 이동

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()

4driver.get("https://www.allbirds.com/collections/mens")2단계: 동적 콘텐츠 로딩 대기

동적 사이트는 로딩이 느릴 수 있으니, Selenium의 대기 기능을 활용합니다:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3WebDriverWait(driver, 10).until(

4 EC.presence_of_element_located((By.CSS_SELECTOR, "div.product-card"))

5)(실제 사이트에서 CSS 셀렉터를 확인하세요. 예시에서는 div.product-card를 사용합니다.)

3단계: 요소 찾기 및 데이터 추출

1products = driver.find_elements(By.CSS_SELECTOR, "div.product-card")

2print(f"Found {len(products)} products")

3data = []

4for prod in products:

5 name = prod.find_element(By.CSS_SELECTOR, ".product-name").text

6 price = prod.find_element(By.CSS_SELECTOR, ".price").text

7 data.append((name, price))

8 print(name, "-", price)실행 결과 예시:

1Found 24 products

2Wool Runner - $110

3Tree Dasher 2 - $135

4...4단계: CSV 파일로 저장

결과를 CSV로 저장해봅시다:

1import csv

2with open("allbirds_products.csv", "w", newline="") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Product Name", "Price"])

5 writer.writerows(data)마지막으로 브라우저를 닫아줍니다:

1driver.quit()이제 CSV 파일을 열면 상품명과 가격이 정리되어 있습니다.

Selenium Python으로 웹 스크래핑할 때 자주 겪는 문제와 해결법

실제 웹 스크래핑을 하다 보면 생각보다 변수가 많아요. 대표적인 문제와 해결법을 소개할게요:

요소 로딩 대기

동적 사이트는 로딩이 느릴 수 있으니, 명시적 대기를 사용하세요:

1WebDriverWait(driver, 10).until(

2 EC.visibility_of_element_located((By.CSS_SELECTOR, ".product-card"))

3)이렇게 하면 요소가 나타나기 전에 코드를 실행하는 실수를 막을 수 있습니다.

페이지네이션 처리

여러 페이지의 데이터를 수집하려면 반복문을 사용하세요:

1while True:

2 try:

3 next_btn = driver.find_element(By.LINK_TEXT, "Next")

4 next_btn.click()

5 WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.CSS_SELECTOR, ".product-card")))

6 except Exception:

7 break # 더 이상 페이지가 없을 때 종료무한 스크롤의 경우:

1import time

2last_height = driver.execute_script("return document.body.scrollHeight")

3while True:

4 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

5 time.sleep(2)

6 new_height = driver.execute_script("return document.body.scrollHeight")

7 if new_height == last_height:

8 break

9 last_height = new_height팝업 및 로그인 처리

팝업이 뜨면 닫아주세요:

1driver.find_element(By.CSS_SELECTOR, ".modal-close").click()로그인이 필요하다면 입력 후 제출:

1driver.find_element(By.ID, "email").send_keys("user@example.com")

2driver.find_element(By.NAME, "login").click()단, CAPTCHA나 2단계 인증은 자동화가 어렵습니다.

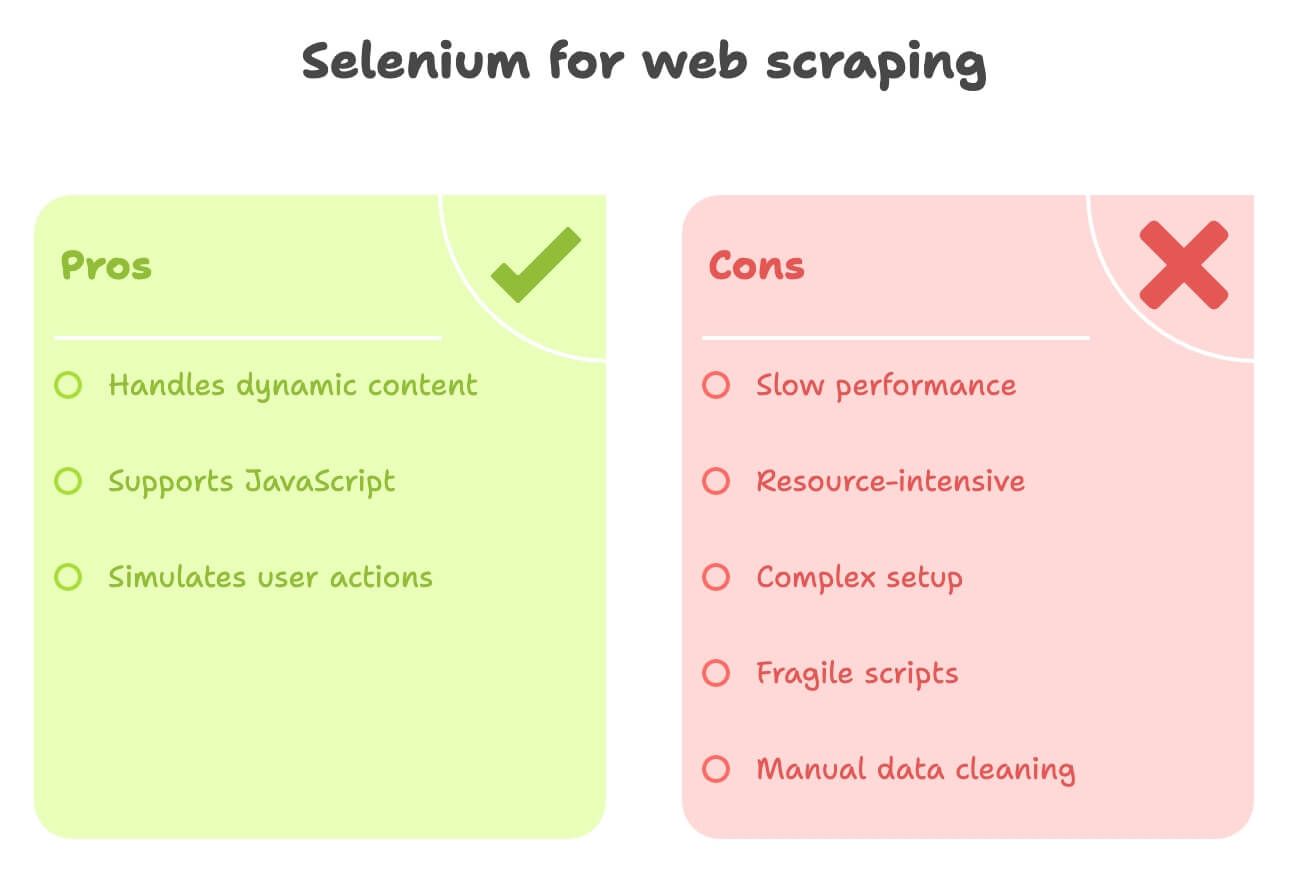

Selenium Python 웹 스크래핑의 한계와 단점

Selenium은 강력하지만, 단점도 분명합니다:

- 느림: 매번 브라우저 전체를 띄우기 때문에 속도가 느립니다. 1,000페이지를 스크래핑하려면 시간과 인내가 필요해요.

- 리소스 소모: CPU와 메모리 사용량이 높아, 여러 브라우저를 동시에 돌리려면 고사양 PC가 필요합니다.

- 설정 복잡: ChromeDriver 버전 관리, 사이트별 코드 작성 등 유지보수가 번거롭습니다.

- 취약함: 사이트 구조가 바뀌면 스크립트가 쉽게 깨질 수 있습니다.

- 데이터 후처리 필요: 번역, 감정 분석 등 추가 처리가 필요하면 별도 라이브러리나 API를 연동해야 합니다.

비개발자나 빠르게 데이터를 얻고 싶은 분들에게는 다소 무거운 선택일 수 있습니다.

Thunderbit: Selenium Python을 대체하는 AI 웹 스크래퍼

이제 비즈니스 사용자를 위한 혁신적인 도구, 을 소개합니다. Thunderbit은 AI 웹 스크래퍼 크롬 확장 프로그램으로, 별도의 코드 작성이나 복잡한 설정 없이 클릭 몇 번만으로 원하는 데이터를 추출할 수 있어요.

Thunderbit만의 강점

- AI 필드 자동 인식: ‘AI 필드 추천’을 클릭하면, Thunderbit의 AI가 상품명, 가격, 이미지 등 주요 데이터를 자동으로 찾아줍니다.

- 서브페이지 스크래핑: 상품 상세 페이지 등 추가 정보가 필요한 경우, Thunderbit이 자동으로 클릭해 세부 데이터까지 수집합니다.

- 데이터 고도화: 스크래핑과 동시에 번역, 요약, 감정 분석 등 다양한 AI 기능을 바로 적용할 수 있습니다.

- 원클릭 내보내기: 추출한 데이터를 Excel, Google Sheets, Notion, Airtable 등으로 바로 내보낼 수 있습니다.

- 코딩 필요 없는 인터페이스: 비개발자도 쉽게 사용할 수 있도록 설계되었습니다.

저 역시 Thunderbit 개발에 참여했지만, 비즈니스 팀이 구조화된 웹 데이터를 가장 빠르게 얻는 방법이라고 자신 있게 말씀드릴 수 있어요. 특히 영업, 이커머스, 리서치 분야에서 강력한 도구입니다.

Thunderbit vs. Selenium Python: 한눈에 비교

아래 표에서 두 도구의 차이를 한눈에 확인해보세요:

| 기준 | Selenium Python | Thunderbit (AI, 노코드) |

|---|---|---|

| 설정 시간 | 중간~복잡: Python, Selenium, ChromeDriver 설치 및 코드 작성 필요 | 매우 빠름: 크롬 확장 설치 후 바로 사용 가능 |

| 필요 역량 | 높음: 코딩 및 HTML 이해 필요 | 낮음: 클릭만으로 AI가 자동 처리 |

| 동적 콘텐츠 처리 | 우수: JS, 클릭, 스크롤 등 모두 가능 | 우수: 브라우저 내에서 AJAX, 무한 스크롤, 서브페이지 지원 |

| 속도 | 느림: 브라우저 오버헤드 | 빠름: 소규모/중간 작업에 최적, AI 자동 인식 및 DOM 직접 접근 |

| 확장성 | 대규모 병렬화 어려움, 리소스 소모 큼 | 수백~수천 건까지 적합, 초대형 대량 작업에는 부적합 |

| 데이터 처리 | 수동: 데이터 정제, 번역, 감정 분석 등 별도 코드 필요 | 자동: AI가 실시간 번역, 요약, 분류, 고도화 지원 |

| 내보내기 옵션 | CSV, Sheets 등 직접 코드 작성 필요 | Excel, Google Sheets, Notion, Airtable로 원클릭 내보내기 |

| 유지보수 | 높음: 사이트 구조 변경에 취약 | 낮음: AI가 다양한 레이아웃 변화에 적응, 사용자 유지보수 최소화 |

| 특화 기능 | 전체 브라우저 자동화, 맞춤 워크플로우 | AI 인사이트, 템플릿, 데이터 고도화, 무료 추출기 제공 |

대부분의 비즈니스 사용자는 Thunderbit을 통해 복잡한 코드나 드라이버 설정 없이 손쉽게 웹 데이터를 수집할 수 있습니다.

실전 예시: Thunderbit으로 스크래핑하기

Thunderbit으로 같은 작업을 어떻게 처리하는지 살펴볼게요:

- 로 이동

- Thunderbit 아이콘 클릭 후 ‘AI 필드 추천’ 선택

- AI가 ‘상품명’, ‘가격’, ‘상품 URL’ 등 주요 컬럼을 자동 인식합니다.

- (선택) ‘설명(일본어)’, ‘감정 분석’ 등 추가 컬럼 지정

- AI가 스크래핑과 동시에 번역/분석을 수행합니다.

- ‘스크래핑’ 버튼 클릭

- 모든 상품 데이터가 표로 정리됩니다.

- Google Sheets, Notion, Excel 등으로 원클릭 내보내기

코드 작성, 브라우저 대기, CSV 정리 없이 바로 구조화된 데이터를 얻을 수 있습니다.

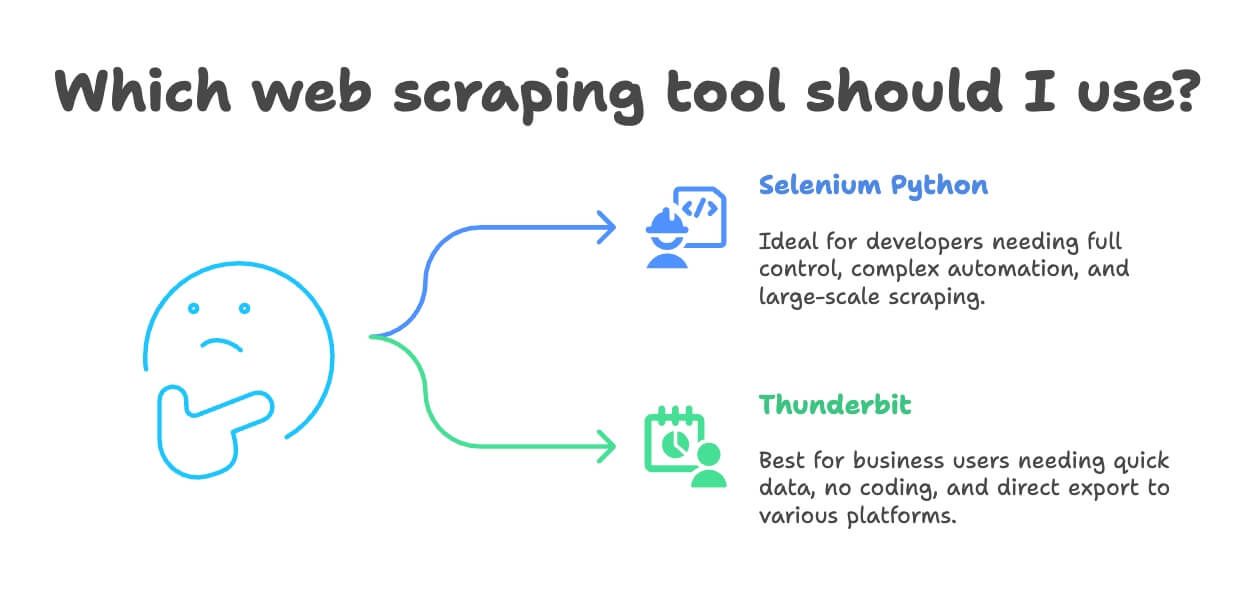

Selenium Python과 Thunderbit, 언제 어떤 도구를 써야 할까?

내 상황에 맞는 도구는 무엇일까요? 아래 기준을 참고해보세요:

- Selenium Python이 적합한 경우:

- 개발자이거나 브라우저 자동화 전체를 세밀하게 제어해야 할 때

- 복잡한 맞춤 워크플로우(로그인, 다운로드, 다단계 폼 등)가 필요한 프로젝트

- 대규모(수만~수십만 건) 데이터 수집이 필요한 경우(적절한 인프라 필요)

- Thunderbit이 적합한 경우:

- 비즈니스 사용자, 데이터 분석가, 마케터 등 빠르게 데이터가 필요한 경우

- 코딩이나 복잡한 환경 설정 없이 바로 사용하고 싶은 경우

- 스크래핑과 동시에 번역, 감정 분석, 데이터 고도화가 필요한 경우

- 소~중규모(수백~수천 건) 프로젝트에 적합

- Excel, Google Sheets, Notion, Airtable 등으로 바로 내보내고 싶은 경우

실제로 많은 팀이 Selenium 스크립트 작성에 며칠을 투자하지만, Thunderbit으로는 10분 만에 같은 결과를 얻을 수 있습니다. 대규모 커스터마이징이나 초대형 작업이 아니라면, Thunderbit이 훨씬 빠르고 편리한 선택입니다.

보너스: 웹 스크래핑 시 꼭 지켜야 할 에티켓과 팁

데이터 수집에 앞서, 아래 사항을 꼭 기억하세요:

- robots.txt와 서비스 약관 준수: 사이트에서 스크래핑을 허용하는지 반드시 확인하세요. 금지된 경우 무리하게 시도하지 마세요.

- 요청 속도 조절: 서버에 과부하를 주지 않도록, 요청 간 딜레이나 제한을 두세요.

- User-Agent/IP 변경: 간단한 차단을 피할 수 있지만, 사이트 정책을 위반하지 않도록 주의하세요.

- 개인정보/민감정보 수집 금지: 공개된 정보만 수집하고, GDPR 등 개인정보 보호법을 준수하세요.

- 공식 API 활용: API가 제공된다면, 스크래핑보다 API 사용이 더 안전하고 안정적입니다.

- 로그인/유료벽 뒤 데이터는 허가 없이 수집 금지: 법적, 윤리적으로 문제가 될 수 있습니다.

- 활동 기록 및 에러 처리: 차단당하면 즉시 중단하고, 접근 방식을 조정하세요.

웹 스크래핑의 윤리와 법적 이슈에 대해 더 알고 싶다면 를 참고하세요.

마무리: 내게 맞는 웹 스크래핑 도구를 선택하세요

웹 스크래핑은 이제 수작업 스크립트에서 AI 기반 노코드 도구까지 진화했습니다. Selenium Python은 복잡한 동적 사이트를 다루는 개발자에게 강력한 선택지지만, 진입장벽과 유지보수 부담이 있습니다. 반면, Thunderbit은 번역, 감정 분석, 원클릭 내보내기 등 다양한 기능을 갖춘 쉽고 빠른 솔루션입니다.

제 조언은? 두 가지 방법 모두 직접 경험해보세요. 개발자라면 같은 사이트에 Selenium 스크립트를 짜보시고, 빠른 결과가 필요하다면 을 바로 사용해보세요. 무료 플랜도 있으니, 원하는 사이트에서 바로 테스트해볼 수 있습니다.

마지막으로, 책임감 있게 스크래핑하고, 데이터를 현명하게 활용하며, IP 차단 없는 데이터 수집을 기원합니다.

더 알고 싶다면 아래 자료도 참고하세요: