웹사이트를 둘러보다가 ‘이 데이터, 한 번에 엑셀로 쏙 옮길 수 있으면 얼마나 편할까?’ 생각해본 적 있지 않나요? 복사-붙여넣기로 시간 낭비하지 않고 말이죠. 2025년 현재, 웹 스크래핑은 더 이상 개발자만의 영역이 아니라, 비즈니스에서 꼭 필요한 역량이 됐어요. 영업팀이 리드 리스트를 만들거나, 이커머스 담당자가 경쟁사 가격을 추적할 때 등, 누구나 빠르고 쉽게 웹 데이터를 원하죠. 다행히 파이썬만 있으면 웹 스크래핑이 생각보다 간단하고, 초보자도 금방 시작할 수 있습니다. 예전에 MySpace 배경만 바꿔본 경험밖에 없어도 걱정 없어요.

이 글에서는 파이썬으로 웹 데이터를 스크래핑하는 방법을 단계별로 안내합니다. 기본 개념부터 정적/동적 사이트 처리, 그리고 AI 기반 웹 스크래퍼인 와 파이썬을 결합해 워크플로우를 자동화하는 방법까지 모두 다룹니다. 완전 초보자든, 데이터 활용을 한 단계 업그레이드하고 싶은 분이든, 실전 팁과 코드 예제, 그리고 SaaS와 자동화 현장에서 얻은 노하우까지 아낌없이 담았어요.

웹 스크래핑이란? 그리고 왜 파이썬을 쓸까?

먼저 기본부터 짚고 넘어가볼게요. 웹 스크래핑은 웹사이트에서 원하는 정보를 자동으로 뽑아내는 과정입니다. 쉽게 말해, 컴퓨터가 웹페이지를 ‘읽고’ 필요한 데이터(예: 상품 가격, 뉴스 헤드라인, 연락처 등)만 골라내는 거죠(). 기업들은 실시간 경쟁사 모니터링, 시장 조사, 리드 생성, AI 모델 학습 등 다양한 목적으로 웹 스크래핑을 활용합니다().

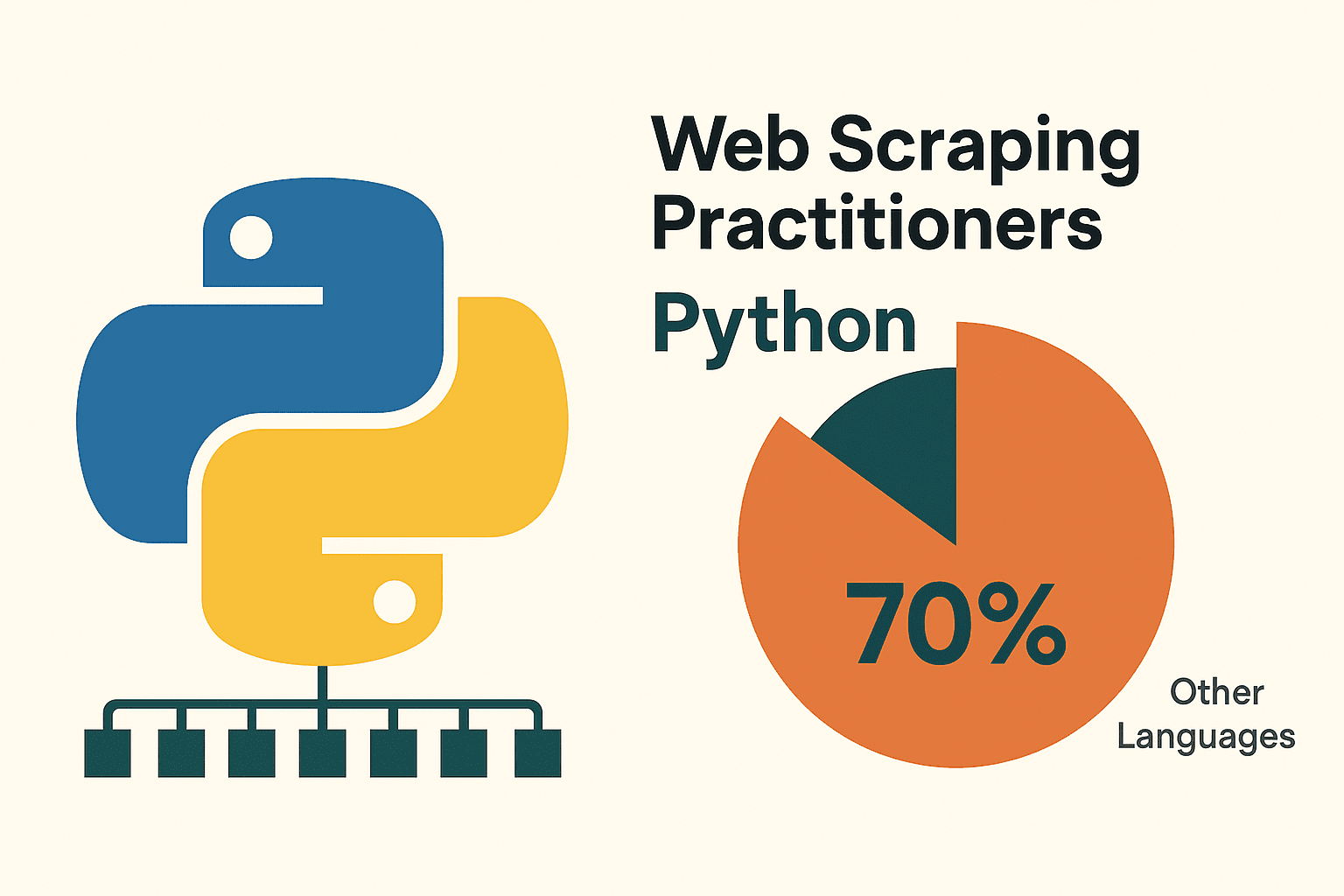

그렇다면 파이썬이 웹 스크래핑에 가장 많이 쓰이는 이유는 뭘까요? 우선 문법이 직관적이고 읽기 쉬워서, 코딩이 처음인 분들도 부담 없이 시작할 수 있습니다. 그리고 파이썬에는 requests, BeautifulSoup, Scrapy, Selenium, pandas 등 웹페이지 요청부터 HTML 파싱, 데이터 정제·저장까지 모든 과정을 지원하는 강력한 라이브러리들이 있습니다. 실제로 할 정도로 압도적인 선택을 받고 있죠.

왜 웹 스크래핑에 파이썬이 적합할까?

여러 언어를 써봤지만, 웹 스크래핑만큼은 파이썬이 단연 최고였습니다. 특히 입문자라면 더욱 그렇죠. 그 이유를 정리하면 다음과 같습니다:

- 간결하고 쉬운 문법: 파이썬은 코드가 명확하고 짧아, 스크래핑 스크립트를 작성하고 디버깅하기가 쉽습니다().

- 풍부한 라이브러리: requests(HTTP 요청), BeautifulSoup(HTML 파싱), Scrapy(대규모 크롤링), Selenium(브라우저 자동화), pandas(데이터 분석) 등 스크래핑에 필요한 모든 도구가 준비되어 있습니다().

- 강력한 커뮤니티: 파이썬은 전 세계적으로 활발한 커뮤니티가 있어, 막히는 부분이 생기면 이미 누군가 해결책을 공유해둔 경우가 많습니다.

다른 언어와 비교하면 어떨까요? 아래 표를 참고하세요:

| 방식 | 장점 | 단점 |

|---|---|---|

| 파이썬 | 배우기 쉽고, 라이브러리 생태계가 크며, 데이터 분석에 강점, 다양한 용도에 활용 가능 | 코딩이 필요, 자바스크립트가 많은 사이트는 추가 도구 필요 |

| 자바스크립트/Node | 동적 콘텐츠 처리에 강점, 비동기 처리, 웹 프론트엔드와 동일 언어 | 진입장벽이 높고, 스크래핑 특화 라이브러리 부족, 초보자에겐 코드가 장황함 |

| R (rvest) | 연구용 데이터 추출에 적합, R의 분석 기능과 연동 | 스크래핑 생태계가 작고, 동적 사이트에는 약함 |

| 노코드 도구 | 코딩 없이 빠른 구축, AI/비주얼 도우미(Thunderbit 등) | 커스텀 로직 한계, 사용량 제한, 세밀한 제어 어려움 |

(, )

대부분의 비즈니스 사용자와 데이터 입문자에게 파이썬은 강력하면서도 부담 없는 최고의 선택입니다.

파이썬 환경 준비하기: 데이터 스크래핑 시작 전 세팅

스크래핑을 시작하려면 먼저 파이썬 환경을 세팅해야 합니다. 걱정 마세요. IKEA 가구 조립보다 훨씬 쉽고, 남는 나사도 없습니다.

1. 파이썬 설치:

에서 최신 파이썬 3 버전을 다운로드하세요. 윈도우는 설치 시 'Add Python to PATH'를 꼭 체크하세요. 맥은 Homebrew로 brew install python3 명령어를, 리눅스는 apt install python3 python3-pip로 설치할 수 있습니다().

2. (추천) 가상환경 만들기:

프로젝트별로 라이브러리를 분리해 관리할 수 있습니다. 프로젝트 폴더에서:

1python -m venv venv

2# 활성화:

3# Windows:

4venv\Scripts\activate

5# Mac/Linux:

6source venv/bin/activate3. 필수 라이브러리 설치:

터미널에서 아래 명령어를 실행하세요:

1pip install requests beautifulsoup4 pandas selenium lxmlrequests: HTTP 요청용beautifulsoup4: HTML 파싱용pandas: 데이터 가공/저장selenium: 동적 사이트용(선택)lxml: 빠른 HTML/XML 파싱

4. 코드 에디터 선택:

- : 가볍고 인기 많으며, 초보자에게 적합

- : 파이썬 전용, 강력한 기능

- : 실험·분석에 최적화된 인터랙티브 환경()

5. (Selenium용) 웹드라이버 설치:

Selenium은 브라우저 드라이버(예: ChromeDriver)가 필요합니다. webdriver_manager를 쓰면 간편합니다:

1pip install webdriver-manager스크립트에서 아래처럼 사용하세요:

1from selenium import webdriver

2from selenium.webdriver.chrome.service import Service

3from webdriver_manager.chrome import ChromeDriverManager

4driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))문제 해결 팁: pip 명령어가 안 먹힌다면, 파이썬이 PATH에 추가되어 있는지, 가상환경이 활성화되어 있는지 확인하세요.

정적 웹사이트 스크래핑: 파이썬으로 단계별 실습

정적 웹사이트는 스크래핑 입문에 가장 적합합니다. 브라우저에서 '페이지 소스 보기'로 데이터가 보인다면, 파이썬으로 쉽게 추출할 수 있습니다.

예시로 사이트를 스크래핑해봅시다.

1단계: 페이지 가져오기

1import requests

2url = "http://quotes.toscrape.com/page/1/"

3response = requests.get(url)

4html = response.text

5print(response.status_code) # 200이면 정상2단계: HTML 파싱

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, 'html.parser')

3quotes = soup.find_all("div", class_="quote")3단계: 데이터 추출

1for q in quotes:

2 text = q.find("span", class_="text").get_text()

3 author = q.find("small", class_="author").get_text()

4 print(f"{text} --- {author}")4단계: 페이지네이션 처리

1import pandas as pd

2all_data = []

3page = 1

4while True:

5 url = f"http://quotes.toscrape.com/page/{page}/"

6 resp = requests.get(url)

7 if resp.status_code != 200:

8 break

9 soup = BeautifulSoup(resp.text, 'html.parser')

10 quotes = soup.find_all("div", class_="quote")

11 if not quotes:

12 break

13 for q in quotes:

14 text = q.find("span", class_="text").get_text()

15 author = q.find("small", class_="author").get_text()

16 all_data.append({"quote": text, "author": author})

17 page += 1

18df = pd.DataFrame(all_data)

19df.to_csv("quotes.csv", index=False)이렇게 하면 여러 페이지의 데이터를 한 번에 CSV로 저장할 수 있습니다. 몇 줄의 코드만으로도 충분하죠! ()

팁: 스크래핑 전에는 반드시 사이트의 robots.txt와 이용약관을 확인하세요. 그리고 서버에 과도한 요청을 보내지 않도록, 요청 사이에 time.sleep(1)로 잠깐씩 쉬어주는 것이 예의입니다.

동적 웹사이트 스크래핑: 파이썬 Selenium 활용법

일부 웹사이트는 데이터를 바로 보여주지 않고, 자바스크립트 실행 후에야 나타나기도 합니다(무한 스크롤, 팝업, 대시보드 등). 이런 경우에는 실제 브라우저처럼 동작하는 Selenium이 필요합니다.

1단계: 브라우저 실행

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3from selenium.webdriver.chrome.service import Service

4from webdriver_manager.chrome import ChromeDriverManager

5driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))

6driver.get("https://example.com/dynamic-products")2단계: 콘텐츠 로딩 대기

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3WebDriverWait(driver, 10).until(

4 EC.presence_of_element_located((By.ID, "product-list"))

5)3단계: 스크롤/클릭으로 더 많은 데이터 로딩

1import time

2last_height = driver.execute_script("return document.body.scrollHeight")

3while True:

4 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

5 time.sleep(2)

6 new_height = driver.execute_script("return document.body.scrollHeight")

7 if new_height == last_height:

8 break

9 last_height = new_height4단계: 데이터 추출

1products = driver.find_elements(By.CLASS_NAME, "product-item")

2data = []

3for prod in products:

4 name = prod.find_element(By.CSS_SELECTOR, "h2.product-name").text

5 price = prod.find_element(By.CSS_SELECTOR, "span.price").text

6 data.append({"name": name, "price": price})5단계: 저장 및 마무리

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4driver.quit()팁:

- 요소가 로드되지 않았을 때 오류를 방지하려면

WebDriverWait을 활용하세요(). - GUI 없이 실행하려면 Chrome 옵션에

options.headless = True를 추가하세요. - 네트워크 탭에서 JSON API 엔드포인트를 찾았다면, Selenium 대신

requests로 더 빠르게 데이터를 받을 수도 있습니다.

Thunderbit와 파이썬을 결합한 강력한 데이터 자동화

여기서부터가 진짜 재미있는 부분입니다. 파이썬 라이브러리만으로도 충분히 강력하지만, 복잡하거나 구조가 뒤죽박죽인 사이트를 다루다 보면 머리가 아플 때가 있죠. 이럴 때 가 큰 도움이 됩니다.

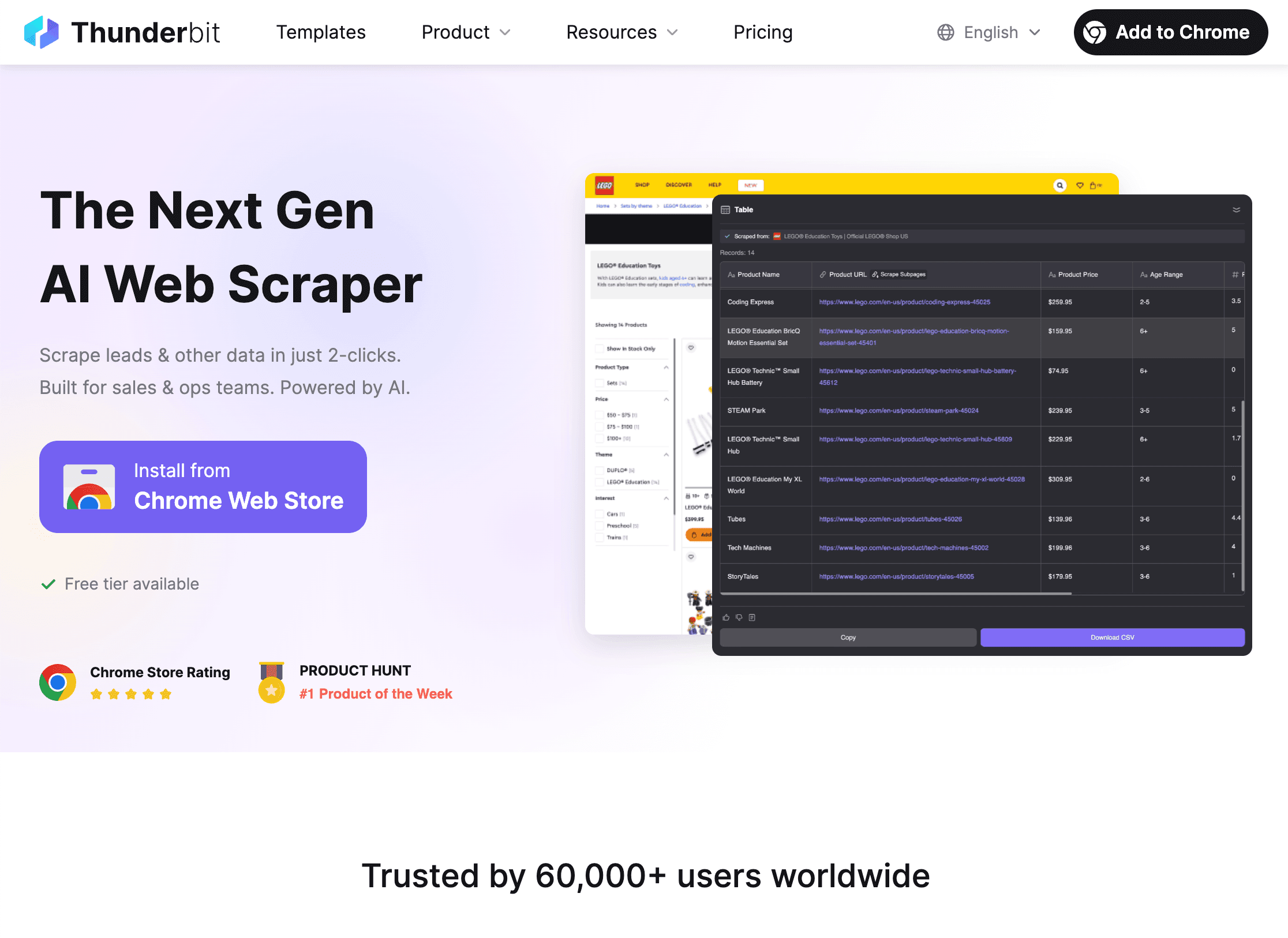

Thunderbit는 AI 기반 웹 스크래퍼 크롬 확장 프로그램으로, 클릭 몇 번만으로 어떤 웹사이트든 데이터를 추출할 수 있습니다. 코딩이 필요 없어서 비즈니스 실무자에게도 적합하지만, 파이썬과 연동해 더 고도화된 자동화도 가능합니다.

Thunderbit + 파이썬 조합의 활용법:

Thunderbit + 파이썬 조합의 활용법:

-

Thunderbit로 데이터 추출:

- 을 실행하세요.

- 'AI 필드 추천'을 클릭하면 Thunderbit의 AI가 추출할 데이터를 자동으로 제안합니다.

- 페이지네이션, 하위 페이지, 이미지·PDF 추출도 클릭 한 번이면 끝.

- 추출한 데이터를 CSV, Excel, Google Sheets, Notion, Airtable 등으로 바로 내보낼 수 있습니다.

-

파이썬에서 데이터 분석 및 정제:

- 내보낸 파일을 pandas로 불러오세요:

1import pandas as pd 2df = pd.read_csv("thunderbit_output.csv") - 이후 필터링, 정제, 병합, 시각화, 고급 분석 등 원하는 대로 활용할 수 있습니다.

- 내보낸 파일을 pandas로 불러오세요:

-

파이프라인 자동화:

- Thunderbit는 정기 스크래핑(스케줄 기능)도 지원해, 매일 최신 데이터를 자동으로 받을 수 있습니다.

- 파이썬 스크립트와 연동해 자동 리포트, 알림, 추가 가공도 가능합니다.

둘 다 써야 할 이유? Thunderbit는 복잡한 사이트나 일회성 작업에서 코딩·디버깅 시간을 대폭 줄여줍니다. 파이썬은 데이터 정제·분석·자동화에 강점을 갖고 있죠. 땅콩버터와 잼처럼, 따로 써도 좋지만 함께 쓰면 시너지가 극대화됩니다().

파이썬 웹 스크래핑에서 자주 만나는 문제와 해결법

웹 스크래핑이 항상 순탄한 건 아닙니다. 대표적인 문제와 해결책을 정리했습니다:

1. 차단(403/429 오류, CAPTCHA):

- User-Agent를 변경해 실제 브라우저처럼 보이게 하세요.

- 프록시를 사용해 IP를 주기적으로 바꾸세요().

- 요청 사이에 딜레이(

time.sleep())를 추가하세요. - robots.txt와 crawl-delay 규칙을 준수하세요.

- CAPTCHA가 뜨면 Selenium으로 수동 해결하거나, CAPTCHA 솔버 서비스를 활용하세요.

2. 동적 콘텐츠 미로딩:

- 자바스크립트가 많은 페이지는 Selenium으로 렌더링하세요.

- 브라우저 네트워크 탭에서 내부 API 호출을 찾아, JSON 데이터로 바로 받아올 수 있는지 확인하세요.

3. 로그인/세션 문제:

requests.Session()으로 쿠키를 유지하세요.- 필요하다면 Selenium으로 로그인 과정을 자동화하세요.

4. 사이트 구조 변경:

- 셀렉터는 ID를 우선 사용하고, 구조 변경에 대비해 코드를 유연하게 작성하세요.

- 사이트 구조가 바뀌면 스크립트를 즉시 업데이트하세요.

- Thunderbit의 AI는 레이아웃 변화에도 자동으로 적응해 유지보수 부담을 줄여줍니다.

5. 대용량 데이터 처리:

concurrent.futures나asyncio로 동시 처리 속도를 높이세요.- 메모리 부족을 막으려면 데이터를 실시간으로 파일이나 데이터베이스에 저장하세요.

(, )

스크래핑 스크립트 디버깅 & 최적화 체크리스트

문제가 생겼을 때 빠르게 점검할 수 있는 체크리스트입니다:

- HTTP 404/403/429: URL, 헤더, 요청 속도를 점검하세요.

- 타임아웃/연결 오류: 재시도 로직(지수 백오프)을 추가하세요.

- AttributeError/NoneType: 요소 접근 전 존재 여부를 확인하고, 실제 받은 HTML을 점검하세요.

- 인코딩 문제:

response.encoding = 'utf-8'설정 또는 파일 저장 시 인코딩 지정. - Selenium 요소 미발견: 명시적 대기 사용, 셀렉터 재확인.

- 메모리 부족: 데이터를 배치로 저장하거나, 제너레이터/DB 활용.

- 디버깅: print/logging 활용, HTML을 파일로 저장해 직접 확인.

대규모 프로젝트라면 비동기 요청(aiohttp), 멀티스레딩, Scrapy 프레임워크도 고려해보세요. 하지만 소규모 작업에서는 복잡한 최적화보다 코드의 명확성이 더 중요합니다.

윤리적·합법적 웹 스크래핑을 위한 실천 가이드

강력한 스크래핑 능력에는 책임이 따릅니다. 아래 원칙을 꼭 지켜주세요:

- robots.txt와 이용약관 준수: 스크래핑 금지 사이트는 건드리지 마세요.

- 개인정보·민감정보 수집 금지: 공개된 정보만 활용하고, 본인도 수집당하기 싫은 데이터는 피하세요.

- 예의 지키기: 요청 속도 제한, 피크 시간대 피하기, 서버 과부하 방지.

- 자신을 밝히기: 필요하다면 User-Agent에 연락처 등 정보 추가.

- 법적 이슈 확인: 미국 등 일부 국가에서는 공개 데이터 스크래핑이 합법이지만, 약관 위반이나 비공개 데이터 수집은 처벌받을 수 있습니다().

- API가 있으면 API 사용: 공식 API가 제공된다면, 그게 더 안전하고 안정적입니다.

(, )

마무리 & 핵심 요약

파이썬으로 데이터 스크래핑을 배우는 것은 데이터 중심 시대에 가장 가치 있는 역량 중 하나입니다. 핵심만 정리하면:

- 파이썬은 웹 스크래핑의 최강자입니다. 쉬운 문법, 풍부한 라이브러리, 활발한 커뮤니티 덕분이죠().

- 정적 사이트는 requests/BeautifulSoup로, 동적 콘텐츠는 Selenium으로 접근하세요.

- Thunderbit를 활용하면 복잡하거나 일회성 스크래핑도 빠르게 처리할 수 있고, 파이썬과 연동해 분석·자동화까지 확장할 수 있습니다.

- 문제 상황에서는 헤더·프록시·딜레이·에러 핸들링 등으로 대응하세요.

- 윤리적 스크래핑: 사이트 규칙을 지키고, 민감 정보는 피하며, 법적 이슈를 항상 확인하세요.

조언을 드리자면, 처음에는 간단한 사이트부터 시작해 첫 스크립트를 직접 작성해보세요. 익숙해지면 Thunderbit와 파이썬을 결합해 더 강력한 자동화도 도전해보시고요. 그리고 에러가 나도 좌절하지 마세요. 모든 스크래퍼는 한 줄의 코드에서 시작했고, Stack Overflow의 도움을 받으며 성장합니다.

Thunderbit의 실제 활용법이나 더 많은 스크래핑 팁이 궁금하다면 와 도 참고해보세요.

여러분의 데이터가 항상 깔끔하고, 스크립트는 버그 없이, IP는 차단되지 않길 바랍니다. 해피 스크래핑!

자주 묻는 질문(FAQ)

1. 웹 스크래핑이란 무엇이며, 합법인가요?

웹 스크래핑은 웹사이트에서 데이터를 자동으로 추출하는 작업입니다. 미국 등 많은 국가에서는 공개 데이터 스크래핑이 일반적으로 합법이지만, 사이트 약관을 준수하고 민감 정보·개인정보는 피해야 하며, 관련 법률을 따라야 합니다().

2. 왜 대부분의 사람들이 웹 스크래핑에 파이썬을 쓰나요?

파이썬은 입문자에게 친숙하고, 스크래핑 전 과정(요청, 파싱, 자동화, 분석)을 지원하는 강력한 라이브러리와 방대한 커뮤니티가 있기 때문입니다().

3. requests/BeautifulSoup 대신 Selenium을 써야 하는 경우는?

데이터가 자바스크립트로 동적으로 로드되어, 페이지 소스에 바로 보이지 않을 때 Selenium이 필요합니다. Selenium은 실제 브라우저처럼 동작해 사용자가 보는 화면 그대로 데이터를 추출할 수 있습니다.

4. Thunderbit와 파이썬은 어떻게 연동되나요?

Thunderbit로 복잡하거나 비정형 데이터를 AI로 손쉽게 추출한 뒤, CSV/Excel/Sheets로 내보내 파이썬에서 불러와 정제·분석·자동화에 활용할 수 있습니다. 코딩 시간을 크게 줄여줍니다.

5. 스크래핑 차단을 피하는 핵심 팁은?

User-Agent 변경, 프록시 사용, 요청 간 딜레이, robots.txt 준수, 민감/비공개 데이터 스크래핑 금지 등이 있습니다. 대규모 스크래핑에는 안티봇 도구나 서비스도 고려해보세요.

직접 스크래핑을 시작해보고 싶으신가요? 을 설치해 AI와 파이썬을 결합한 데이터 프로젝트를 경험해보세요. 막히는 부분이 생기면, 모든 스크래퍼가 한 줄의 코드에서 시작했다는 점을 기억하세요.

더 알아보기