처음으로 비즈니스 데이터를 위해 웹사이트에서 정보를 뽑아보려 했던 그 순간이 아직도 생생합니다. 부엌 식탁에 앉아 한 손엔 커피, 다른 한 손엔 어설픈 파이썬 스크립트를 들고 경쟁사 사이트에서 상품 가격을 긁어내려 애쓰던 기억이죠. ‘이 정도야 금방 하겠지?’ 싶었는데, 결과는 빈 셀만 가득한 CSV 파일과 ‘파이썬 자동화’라는 말의 무게를 뼈저리게 느끼는 경험이었습니다. 2025년이 된 지금, 웹 스크래핑은 데이터 중심 비즈니스의 필수 도구가 되었고, 영업, 이커머스, 마케팅, 운영팀 모두가 수작업으론 불가능한 실시간 인사이트를 얻는 데 없어선 안 될 무기가 됐습니다.

하지만 중요한 점이 있습니다. 파이썬 웹 스크래핑이 예전보다 훨씬 강력해졌지만, 시장 환경은 더 빠르게 변하고 있습니다. 웹 스크래핑 시장은 로, 매년 28%씩 성장 중입니다. 그리고 하며 더 똑똑한 의사결정을 내리고 있죠. 하지만 진짜 어려운 건 단순히 코드를 짜는 게 아니라, 목적에 맞는 도구를 고르고, 확장성을 챙기며, 수많은 스크립트를 관리하는 데서 시작됩니다. 이 글에서는 주요 파이썬 웹 스크래핑 라이브러리(코드 예시 포함), 실제 비즈니스 활용 사례, 그리고 제가 파이썬을 좋아함에도 2025년에는 같은 노코드 솔루션이 대부분의 비즈니스 사용자에게 최적이라고 생각하는 이유까지 모두 풀어보겠습니다.

파이썬 웹 스크래핑이란? 비전문가도 바로 이해할 수 있게

쉽게 말해, 웹 스크래핑은 ‘자동 복붙’이라고 보면 됩니다. 인턴을 시켜서 상품 가격, 연락처, 리뷰 등을 일일이 복사하게 하는 대신, 소프트웨어가 웹페이지를 돌아다니며 필요한 데이터를 알아서 뽑아주고, 이걸 스프레드시트나 데이터베이스로 정리해주는 거죠. 파이썬 웹 스크래핑은 이 과정을 파이썬 스크립트로 자동화하는 방식입니다. 즉, 웹페이지를 불러오고, HTML을 분석해서 원하는 정보를 뽑아내는 거예요.

마치 디지털 비서가 24시간 내내 웹사이트를 대신 돌아다니며 정보를 모아주는 느낌이죠. 기업들이 가장 많이 추출하는 데이터는 가격 정보, 상품 상세, 연락처, 리뷰, 이미지, 뉴스 기사, 부동산 매물 등입니다. 일부 사이트는 API를 제공하지만, 대부분은 제한적이거나 아예 없죠. 이럴 때 웹 스크래핑이 진가를 발휘합니다. 공식 다운로드 버튼이 없어도, 공개된 데이터를 대량으로 긁어올 수 있으니까요.

파이썬 웹 스크래핑이 비즈니스 팀에 중요한 이유

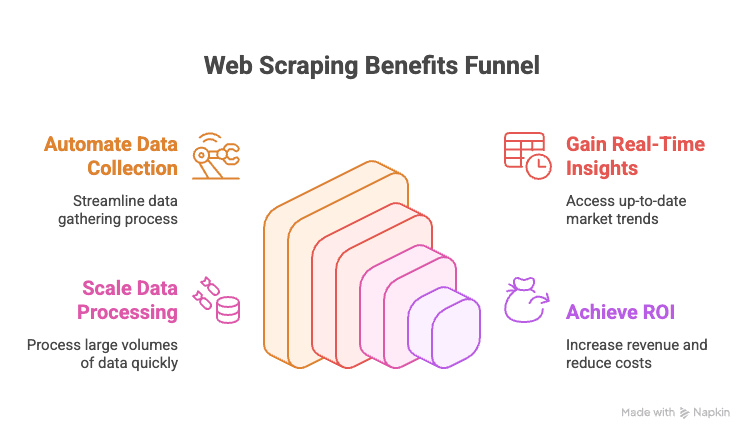

2025년에 웹 스크래핑을 활용하지 않는다면 경쟁에서 뒤처질 수밖에 없습니다. 그 이유는 아래와 같습니다.

- 수작업 데이터 수집 자동화: 경쟁사 사이트나 온라인 디렉터리에서 일일이 복붙할 필요가 없습니다.

- 실시간 인사이트 확보: 가격, 재고, 시장 동향 등 최신 정보를 바로바로 파악할 수 있습니다.

- 확장성: 점심 데우는 사이에 수천 개 페이지를 한 번에 긁어올 수 있습니다.

- ROI 극대화: 데이터 기반 전략을 도입한 기업은 효과를 보고 있습니다.

아래는 부서별 대표 활용 예시입니다:

| Department | Use Case Example | Value Delivered |

|---|---|---|

| Sales | Scrape leads from directories, enrich with emails | Bigger, better-targeted lead lists |

| Marketing | Track competitor prices, promotions, reviews | Smarter campaigns, faster pivots |

| Ecommerce | Monitor product prices, stock, and reviews | Dynamic pricing, inventory alerts |

| Operations | Aggregate supplier data, automate reporting | Time savings, fewer manual errors |

| Real Estate | Collect property listings from multiple sites | More listings, faster client response |

결국, 웹 스크래핑은 더 빠르고 똑똑한 비즈니스 의사결정의 비밀 무기입니다.

파이썬 웹 스크래핑 주요 라이브러리 한눈에 보기 (코드 예시 포함)

파이썬의 웹 스크래핑 생태계는 정말 다양합니다. 간단한 페이지 다운로드부터 브라우저 자동화까지, 목적에 따라 여러 라이브러리가 있죠. 주요 라이브러리와 코드 예시는 아래와 같습니다:

urllib, urllib3: HTTP 요청의 기본

파이썬 내장 HTTP 요청 도구로, 저수준이지만 기본적인 작업에 적합합니다.

1import urllib3, urllib3.util

2http = urllib3.PoolManager()

3headers = urllib3.util.make_headers(user_agent="MyBot/1.0")

4response = http.request('GET', "<https://httpbin.org/json>", headers=headers)

5print(response.status) # HTTP status code

6print(response.data[:100]) # first 100 bytes of content의존성을 최소화하거나 세밀한 제어가 필요할 때 쓰면 좋지만, 대부분의 경우엔 더 편리한 requests를 추천합니다.

requests: 가장 인기 있는 파이썬 웹 스크래핑 라이브러리

파이썬 스크래핑의 대표주자입니다. 간단하면서도 강력하고, HTTP 관련 처리를 모두 맡아줍니다.

1import requests

2r = requests.get("<https://httpbin.org/json>", headers={"User-Agent": "MyBot/1.0"})

3print(r.status_code) # 200

4print(r.json()) # parsed JSON content (if response was JSON)쿠키, 세션, 리다이렉트 등도 자동으로 처리해주니 데이터 추출에만 집중할 수 있습니다. 단, HTML 파싱은 별도의 라이브러리(BeautifulSoup 등)가 필요합니다.

BeautifulSoup: 쉬운 HTML 파싱과 데이터 추출

HTML 파싱에 가장 널리 쓰이는 라이브러리입니다. 초보자도 금방 쓸 수 있고, requests와 궁합이 좋습니다.

1from bs4 import BeautifulSoup

2html = "<div class='product'><h2>Widget</h2><span class='price'>$19.99</span></div>"

3soup = BeautifulSoup(html, 'html.parser')

4title = soup.find('h2').text # "Widget"

5price = soup.find('span', class_='price').text # "$19.99"소규모 프로젝트나 입문자에게 딱입니다. 대용량 데이터나 복잡한 쿼리는 lxml이 더 효율적일 수 있어요.

lxml과 XPath: 빠르고 강력한 HTML/XML 파싱

속도가 중요하거나 XPath 쿼리를 쓰고 싶을 때 lxml이 유용합니다.

1from lxml import html

2doc = html.fromstring(page_content)

3prices = doc.xpath("//span[@class='price']/text()")XPath로 원하는 데이터를 정밀하게 뽑을 수 있습니다. 다만, BeautifulSoup보다 배우는 데 약간 더 시간이 걸릴 수 있습니다.

Scrapy: 대규모 웹 크롤링을 위한 프레임워크

Scrapy는 대형 프로젝트에 적합한 프레임워크입니다. Django처럼 크롤링 전체를 체계적으로 관리할 수 있죠.

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com/>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 }비동기 요청, 링크 추적, 데이터 파이프라인, 다양한 포맷 내보내기 등 대규모 크롤링에 최적화되어 있습니다.

Selenium, Playwright, Pyppeteer: 동적 웹사이트 스크래핑

자바스크립트로 데이터가 로드되는 사이트는 브라우저 자동화가 필요합니다. Selenium, Playwright가 대표적이죠.

Selenium 예시:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()

4driver.get("<https://example.com/login>")

5driver.find_element(By.NAME, "username").send_keys("user123")

6driver.find_element(By.NAME, "password").send_keys("secret")

7driver.find_element(By.ID, "submit-btn").click()

8titles = [el.text for el in driver.find_elements(By.CLASS_NAME, "product-title")]Playwright 예시:

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://website.com>")

6 page.wait_for_selector(".item")

7 data = page.eval_on_selector(".item", "el => el.textContent")사람이 직접 보는 것처럼 모든 사이트를 처리할 수 있지만, 속도가 느리고 리소스 소모가 큽니다. 꼭 필요할 때만 쓰는 게 좋습니다.

MechanicalSoup, RoboBrowser, PyQuery, Requests-HTML: 기타 유용한 도구들

-

MechanicalSoup: 폼 제출, 로그인 등 자동화에 강점. Requests와 BeautifulSoup 기반.

1import mechanicalsoup 2browser = mechanicalsoup.StatefulBrowser() 3browser.open("<http://example.com/login>") 4browser.select_form('form#loginForm') 5browser["username"] = "user123" 6browser["password"] = "secret" 7browser.submit_selected() 8page = browser.get_current_page() 9print(page.title.text) -

RoboBrowser: MechanicalSoup와 비슷하지만 최근엔 관리가 다소 미흡.

-

PyQuery: jQuery 스타일의 HTML 파싱 지원.

1from pyquery import PyQuery as pq 2doc = pq("<div><p class='title'>Hello</p><p>World</p></div>") 3print(doc("p.title").text()) # "Hello" 4print(doc("p").eq(1).text()) # "World" -

Requests-HTML: HTTP 요청, 파싱, 간단한 JS 렌더링까지 지원.

1from requests_html import HTMLSession 2session = HTMLSession() 3r = session.get("<https://example.com>") 4r.html.render(timeout=20) 5links = [a.text for a in r.html.find("a.story-link")]

폼 자동화, CSS 선택자, 가벼운 JS 렌더링이 필요할 때 활용하면 좋습니다.

Asyncio와 Aiohttp: 파이썬 웹 스크래핑 속도 높이기

수백~수천 페이지를 스크래핑할 땐 동기 방식으론 너무 느립니다. aiohttp와 asyncio를 활용하면 동시 처리로 속도를 크게 높일 수 있습니다.

1import aiohttp, asyncio

2async def fetch_page(session, url):

3 async with session.get(url) as resp:

4 return await resp.text()

5async def fetch_all(urls):

6 async with aiohttp.ClientSession() as session:

7 tasks = [fetch_page(session, url) for url in urls]

8 return await asyncio.gather(*tasks)

9urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

10html_pages = asyncio.run(fetch_all(urls))이렇게 하면 여러 페이지를 동시에 빠르게 긁어올 수 있습니다.

특화 라이브러리: PRAW(Reddit), PyPDF2 등

-

PRAW: Reddit API를 통한 데이터 수집에 특화.

1import praw 2reddit = praw.Reddit(client_id='XXX', client_secret='YYY', user_agent='myapp') 3for submission in reddit.subreddit("learnpython").hot(limit=5): 4 print(submission.title, submission.score) -

PyPDF2: PDF에서 텍스트 추출.

1from PyPDF2 import PdfReader 2reader = PdfReader("sample.pdf") 3num_pages = len(reader.pages) 4text = reader.pages[0].extract_text() -

기타: 인스타그램, 트위터, OCR 등 다양한 데이터 소스별로 파이썬 라이브러리가 있습니다.

파이썬 스크래핑 라이브러리 비교표

| Tool / Library | Ease of Use | Speed & Scale | Best For |

|---|---|---|---|

| Requests + BeautifulSoup | Easy | Moderate | Beginners, static sites, quick scripts |

| lxml (with XPath) | Moderate | Fast | Large-scale, complex parsing |

| Scrapy | Hard | Very Fast | Enterprise, big crawls, pipelines |

| Selenium / Playwright | Moderate | Slow | JavaScript-heavy, interactive sites |

| aiohttp + asyncio | Moderate | Very Fast | High-volume, mostly static pages |

| MechanicalSoup | Easy | Moderate | Login, forms, session management |

| PyQuery | Moderate | Fast | CSS-selector fans, DOM manipulation |

| Requests-HTML | Easy | Variable | Small jobs, light JS rendering |

실전 예제: 파이썬 웹 스크래퍼 만들기 (단계별 설명)

가상의 이커머스 사이트에서 상품 목록을 추출하고, 페이지네이션을 처리해 CSV로 저장하는 과정을 예시로 살펴볼게요.

1import requests

2from bs4 import BeautifulSoup

3import csv

4base_url = "<https://example.com/products>"

5page_num = 1

6all_products = []

7while True:

8 url = base_url if page_num == 1 else f"{base_url}/page/{page_num}"

9 print(f"Scraping page: {url}")

10 response = requests.get(url, timeout=10)

11 if response.status_code != 200:

12 print(f"Page {page_num} returned status {response.status_code}, stopping.")

13 break

14 soup = BeautifulSoup(response.text, 'html.parser')

15 products = soup.find_all('div', class_='product-item')

16 if not products:

17 print("No more products found, stopping.")

18 break

19 for prod in products:

20 name_tag = prod.find('h2', class_='product-title')

21 price_tag = prod.find('span', class_='price')

22 name = name_tag.get_text(strip=True) if name_tag else "N/A"

23 price = price_tag.get_text(strip=True) if price_tag else "N/A"

24 all_products.append((name, price))

25 page_num += 1

26print(f"Collected {len(all_products)} products. Saving to CSV...")

27with open('products_data.csv', 'w', newline='', encoding='utf-8') as f:

28 writer = csv.writer(f)

29 writer.writerow(["Product Name", "Price"])

30 writer.writerows(all_products)

31print("Data saved to products_data.csv")여기서 하는 일은?

- 각 페이지를 돌며 HTML을 가져오고, 상품명과 가격을 뽑아 리스트에 저장합니다.

- 더 이상 상품이 없으면 종료하고, 결과를 CSV로 내보냅니다.

엑셀로 내보내고 싶다면 pandas를 활용하세요:

1import pandas as pd

2df = pd.DataFrame(all_products, columns=["Product Name", "Price"])

3df.to_excel("products_data.xlsx", index=False)폼, 로그인, 세션 처리 방법

로그인이나 폼 제출이 필요한 사이트도 많죠. 아래처럼 처리할 수 있습니다:

requests 세션 활용:

1session = requests.Session()

2login_data = {"username": "user123", "password": "secret"}

3session.post("<https://targetsite.com/login>", data=login_data)

4resp = session.get("<https://targetsite.com/account/orders>")MechanicalSoup 활용:

1import mechanicalsoup

2browser = mechanicalsoup.StatefulBrowser()

3browser.open("<http://example.com/login>")

4browser.select_form('form#login')

5browser["user"] = "user123"

6browser["pass"] = "secret"

7browser.submit_selected()세션을 활용하면 쿠키를 유지하며 여러 페이지를 연속적으로 스크래핑할 수 있습니다.

동적 콘텐츠 및 자바스크립트 렌더링 페이지 스크래핑

HTML 소스에 데이터가 없다면 브라우저 자동화가 필요합니다.

Selenium 예시:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3driver.get("<http://examplesite.com/dashboard>")

4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.ID, 'stats-table')))

5html = driver.page_source또는, 자바스크립트가 호출하는 API 엔드포인트를 찾았다면 requests로 직접 JSON을 받아오는 게 훨씬 빠릅니다.

데이터 내보내기: CSV, 엑셀, 데이터베이스 등

-

CSV: 파이썬 csv 모듈 활용(위 예시 참고)

-

엑셀: pandas 또는 openpyxl 사용

-

구글 시트:

gspread라이브러리 활용1import gspread 2gc = gspread.service_account(filename="credentials.json") 3sh = gc.open("My Data Sheet") 4worksheet = sh.sheet1 5worksheet.clear() 6worksheet.append_row(["Name", "Price"]) 7for name, price in all_products: 8 worksheet.append_row([name, price]) -

데이터베이스: SQL은

sqlite3,pymysql,psycopg2, SQLAlchemy, NoSQL은pymongo(MongoDB) 등 활용

파이썬 웹 스크래핑 vs 최신 노코드 솔루션: 2025년 Thunderbit가 최고의 선택인 이유

이제 가장 큰 고민, 바로 ‘유지보수’에 대해 얘기해볼까요? 직접 코딩한 스크래퍼는 처음엔 멋져 보이지만, 100개 사이트를 관리해야 하거나, 중요한 보고서 제출 전날에 스크립트가 다 깨지면 정말 난감합니다. 저도 그런 경험이 있거든요.

그래서 저는 를 강력히 추천합니다. 2025년 비즈니스 사용자에게 Thunderbit가 최적의 선택인 이유는 아래와 같습니다:

- 코딩 필요 없음: Thunderbit는 시각적 인터페이스를 제공합니다. ‘AI 필드 추천’ 클릭, 컬럼 조정, ‘스크래핑’ 버튼만 누르면 끝. 파이썬, 디버깅, Stack Overflow 검색이 필요 없습니다.

- 수천 페이지도 거뜬: 1만 개 상품을 추출해야 해도 Thunderbit의 클라우드 엔진이 알아서 처리합니다. 스크립트 붙잡고 있을 필요가 없죠.

- 유지보수 걱정 제로: 100개 경쟁사 사이트를 추적해야 한다면, 100개 파이썬 스크립트 관리가 악몽이 될 수 있습니다. Thunderbit는 템플릿만 선택하거나 약간 수정하면, AI가 레이아웃 변경도 자동으로 대응합니다.

- 서브페이지, 페이지네이션 지원: Thunderbit는 링크를 따라가며 상세페이지, 페이지네이션까지 자동 처리하고, 각 상품의 상세 정보까지 추출할 수 있습니다.

- 즉시 사용 가능한 템플릿: Amazon, Zillow, LinkedIn 등 인기 사이트는 미리 준비된 템플릿이 있어 클릭 한 번이면 데이터가 완성됩니다.

- 무료 데이터 내보내기: 엑셀, 구글 시트, Airtable, Notion 등 원하는 곳으로 추가 비용 없이 내보낼 수 있습니다.

정리하자면, 데이터만 필요하다면 Thunderbit는 개인 데이터 비서와 같습니다. 개발자라면 파이썬이 여전히 매력적이지만, 빠르고 간편하게 끝내고 싶을 땐 Thunderbit가 훨씬 효율적입니다.

윤리적·법적 파이썬 웹 스크래핑 실천 가이드

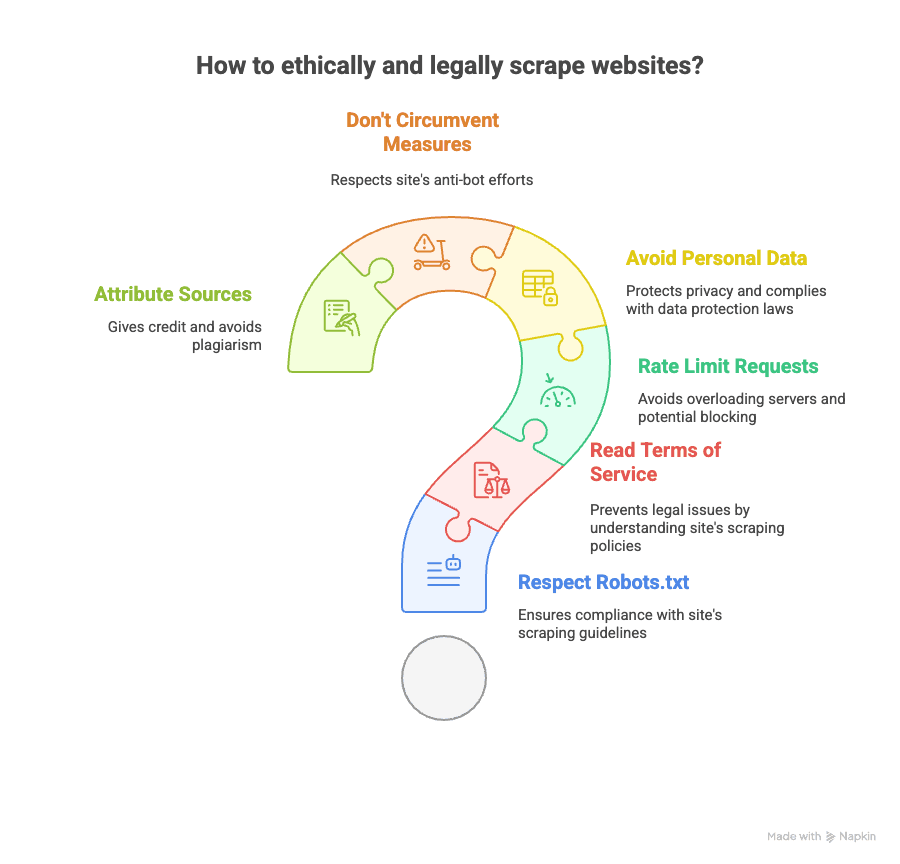

웹 스크래핑은 강력하지만, 책임감 있게 써야 합니다. 아래 사항을 꼭 지켜주세요:

- robots.txt 확인: 사이트가 허용하는 범위 내에서만 스크래핑하세요.

- 이용약관 숙지: 일부 사이트는 스크래핑을 명시적으로 금지합니다. 위반 시 차단 또는 법적 문제가 생길 수 있습니다.

- 요청 속도 제한: 서버에 과부하를 주지 않도록 요청 간 딜레이를 두세요.

- 개인정보 주의: 이메일, 전화번호 등 개인정보는 GDPR, CCPA 등 규정에 따라 신중히 다뤄야 합니다.

- 봇 차단 우회 금지: CAPTCHA 등 강력한 차단이 있다면 무리하게 우회하지 마세요.

- 출처 명시: 분석 결과를 공개할 때는 데이터 출처를 반드시 밝혀야 합니다.

법적 이슈가 궁금하다면 및 도 참고해보세요.

파이썬 웹 스크래핑 더 배우기: 추천 자료 모음

더 깊이 배우고 싶다면 아래 자료를 참고해보세요:

- 공식 문서:

- 추천 도서:

- “Web Scraping with Python” (Ryan Mitchell 저)

- “Automate the Boring Stuff with Python” (Al Sweigart 저)

- 온라인 가이드:

- 영상 강의:

- Corey Schafer 유튜브 채널

- 커뮤니티:

노코드 스크래핑이 궁금하다면 이나 도 참고해보세요.

결론 & 핵심 요약: 2025년, 나에게 맞는 웹 스크래핑 솔루션 고르기

- 파이썬 웹 스크래핑은 강력하고 유연합니다. 코딩을 좋아하고, 직접 제어하고 싶으며, 유지보수도 감수할 수 있다면 훌륭한 선택입니다.

- 정적 페이지, 동적 콘텐츠, 폼, API, PDF 등 모든 상황에 맞는 파이썬 라이브러리가 존재합니다.

- 하지만 대부분의 비즈니스 사용자에게는 수십 개 스크립트 관리가 큰 부담입니다. 빠르고 대규모로 데이터를 얻고 싶고, 컴퓨터공학 지식이 없어도 된다면 가 정답입니다.

- Thunderbit의 AI 기반 노코드 인터페이스는 클릭 몇 번으로 어떤 웹사이트든 스크래핑하고, 서브페이지·페이지네이션도 자동 처리, 원하는 곳으로 데이터 내보내기까지 지원합니다. 파이썬이 필요 없습니다.

- 윤리와 법적 책임도 중요합니다: 사이트 정책을 확인하고, 개인정보 보호와 책임 있는 스크래핑을 실천하세요.

결론적으로, 파이썬 전문가든 데이터만 빠르게 얻고 싶은 분이든, 2025년에는 선택지가 그 어느 때보다 다양합니다. 두 가지 방식을 모두 시도해보고, 내 업무에 맞는 방법을 찾으세요. 반복적이고 지루한 일은 로봇에게 맡기되, 항상 예의 바르게 활용하는 것 잊지 마시고요.

스크립트 오류에 지치셨다면 도 꼭 한 번 써보세요. 미래의 나와 커피가 고마워할 겁니다.

더 알고 싶다면 또는 도 참고해보세요.