2025년의 웹 환경은 정말 예측 불가한 신세계입니다. 경쟁사 가격을 모니터링하다 보면, 어느새 복잡한 자바스크립트와 강력한 봇 차단 시스템에 맞서 싸우고 있는 자신을 발견하게 되죠. 수년간 영업팀과 운영팀을 위한 자동화 툴을 만들어온 입장에서 단언컨대, 웹 스크래핑은 이제 선택이 아니라 필수 역량입니다. 이 데이터 분석을 전략적 의사결정에 활용하고, 온라인 데이터의 양이 단 4년 만에 한 지금, 웹에서 복잡하게 흩어진 정보를 실질적인 인사이트로 바꿀 수 있는 능력이 곧 비즈니스 경쟁력입니다.

하지만 현실은 만만치 않죠. 예전처럼 파이썬 몇 줄로 정적인 HTML만 긁어오던 시절은 지났습니다. 이제는 동적 콘텐츠, 무한 스크롤, 그리고 첨단 봇 차단 기술까지 상대해야 하니까요. 웹 스크래핑이 처음이든, 한 단계 더 성장하고 싶든, 이 글에서는 2025년 파이썬 스크래핑의 핵심 원칙과 도구, 그리고 Thunderbit 같은 AI 툴을 활용해 프로젝트를 한층 업그레이드하는 방법까지 모두 안내합니다.

입문부터 전문가까지: 파이썬 스크래핑의 기본

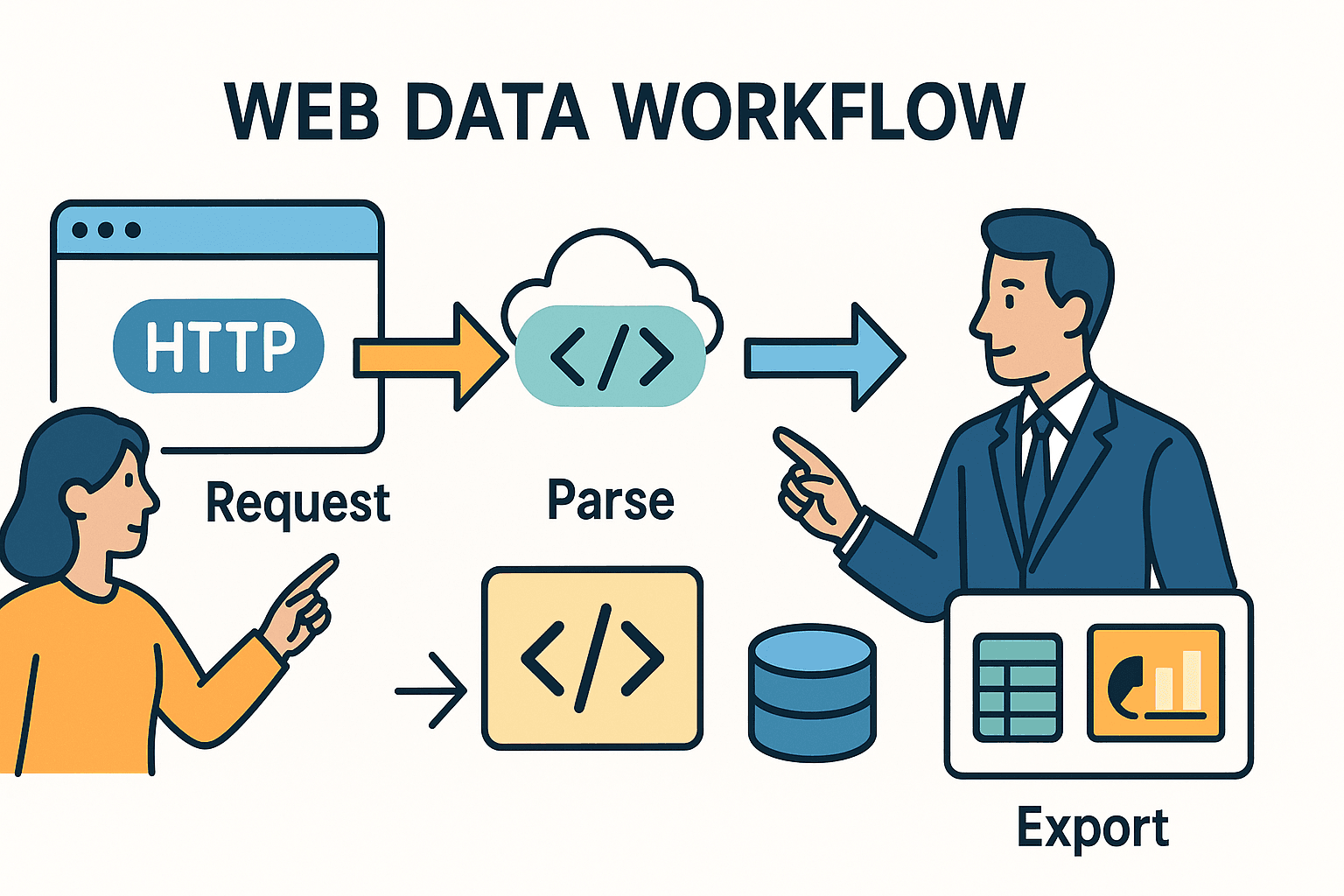

웹 스크래핑의 본질은 브라우저에서 반복적으로 하던 작업을 자동화하는 데 있습니다. 즉, 웹페이지를 불러오고, 원하는 데이터를 찾아내어, 나중에 쓸 수 있도록 저장하는 거죠. 파이썬에서는 보통 아래 세 단계로 진행됩니다:

- HTTP 요청 보내기 (브라우저가 URL에 접속하는 것과 동일)

- HTML 파싱해서 원하는 데이터 찾기

- 데이터 저장 또는 가공 (스프레드시트, 데이터베이스, 대시보드 등)

여기서 중요한 건, 사용하는 도구와 마주치는 난이도는 사이트의 복잡도와 목표에 따라 달라진다는 점입니다.

파이썬 스크래핑 101: 작동 원리

스크래핑을 도서관에서 신문을 빌려와 필요한 기사만 오려내는 일에 비유할 수 있습니다. 파이썬의 requests 라이브러리는 신문을 가져오는 사서 역할이고, BeautifulSoup은 가위처럼 원하는 부분만 잘라낼 수 있게 해줍니다.

하지만 만약 신문이 보이지 않는 잉크(즉, 자바스크립트)로 쓰여 있거나, 기사가 여러 페이지에 흩어져 있다면? 이럴 땐 더 강력한 도구나 AI의 힘이 필요하죠.

주요 도구 비교

아래는 대표적인 파이썬 스크래핑 도구와 사용 시점을 정리한 표입니다:

| 도구/라이브러리 | 이럴 때 사용 | 장점 | 단점 |

|---|---|---|---|

| Requests + BeautifulSoup | 정적 페이지, 소규모 작업 | 간단하고 빠르며, 입문자에게 적합. 완전한 제어 가능. | 자바스크립트, 대규모 크롤링에는 부적합. |

| Scrapy | 대규모 프로젝트, 다수의 페이지/사이트 | 고성능, 내장 크롤링, 비동기 처리, 파이프라인, 견고한 오류 처리. | 학습 곡선이 높고, 프로젝트 설정이 번거로움. |

| Selenium/Playwright | 자바스크립트, 로그인, 사용자 동작이 필요한 페이지 | 브라우저에서 보이는 모든 데이터 추출 가능. 동적 콘텐츠, 로그인, 무한 스크롤 처리. | 느리고, 리소스 소모가 크며, 배포가 복잡함. |

| Thunderbit (AI) | 비정형 데이터, PDF, 이미지, 코딩 없이 사용하고 싶을 때 | AI가 필드 자동 인식, 하위 페이지 처리, 엑셀/시트로 내보내기, 코딩 불필요. | 특수 상황에 대한 커스터마이즈 한계, 크레딧 기반 사용. |

일반적인 비즈니스 용도라면 requests와 BeautifulSoup 조합이 정적 사이트에 딱 맞습니다. 대규모나 복잡한 작업에는 Scrapy가 유용하고, 동적 콘텐츠나 비정형 데이터가 등장하면 Thunderbit 같은 AI 도구가 큰 힘이 됩니다.

실전 단계별 가이드: 복잡한 스크래핑의 모범 절차

"이 데이터가 꼭 필요해!"에서 실제로 견고한 스크래퍼를 만드는 과정은 다음과 같습니다:

1. 대상 사이트 구조 파악하기

코드를 짜기 전에, 브라우저 개발자 도구(F12 또는 우클릭 > 검사)를 열어 원하는 데이터가 HTML 어디에 있는지 먼저 확인하세요. 테이블에 있나요? <div> 여러 개에 흩어져 있나요? 혹시 숨겨진 API 호출로 JSON을 받아오나요? 의외로 쉬운 길이 바로 눈앞에 있을 수도 있습니다.

팁: "다음 페이지"나 "더 보기"를 클릭할 때 네트워크 요청에서 JSON을 받는다면, HTML 파싱 대신 그 API를 직접 호출하는 게 훨씬 효율적입니다.

2. 한 페이지에서 프로토타입 만들기

작게 시작하세요. requests로 한 페이지만 불러오고, BeautifulSoup으로 몇 개 필드만 추출해 출력해보세요. 데이터가 안 나오거나 차단된다면, 헤더(특히 User-Agent)를 추가하거나, 자바스크립트로 로딩되는지 확인해보세요(그럴 땐 3단계 참고).

3. 동적 콘텐츠와 페이지네이션 처리

HTML에 데이터가 없다면, 자바스크립트로 불러오는 경우가 많습니다. 이럴 땐:

- 브라우저 자동화: 이나 로 페이지를 열고, 콘텐츠가 로드될 때까지 기다린 후 HTML을 추출하세요.

- API 호출: 네트워크 탭에서 XHR 요청을 찾아 JSON 엔드포인트를 확인하고,

requests로 직접 호출하세요. - 페이지네이션: 여러 페이지라면 페이지 번호를 반복하거나 "다음" 링크를 따라가세요. 무한 스크롤은 Selenium으로 스크롤하거나, 스크롤 시 발생하는 API 호출을 모방하면 됩니다.

4. 예의와 오류 처리

웹사이트는 스크래퍼를 반기지 않을 수 있습니다. 차단을 피하려면:

- robots.txt 준수: 항상

example.com/robots.txt에서 금지 경로나 크롤링 지연을 확인하세요. - 속도 제한: 요청 사이에

time.sleep()을 추가하세요.Crawl-delay: 5라면 최소 5초 대기. - 커스텀 User-Agent: 스크래퍼를 정중하게 식별하세요(예:

"MyScraper/1.0 (your@email.com)"). - 재시도 로직: try/except로 요청을 감싸고, 실패 시 재시도 및 429(요청 과다) 시 대기하세요.

5. 데이터 파싱 및 정제

BeautifulSoup이나 Scrapy 셀렉터로 필드를 추출하세요. 공백 제거, 가격 숫자 변환, 날짜 파싱, 데이터 완성도 검증 등도 필요합니다. 대용량 데이터는 pandas로 정제 및 중복 제거를 하세요.

6. 하위 페이지 스크래핑

실제 핵심 정보는 상세 페이지에 있는 경우가 많습니다. 링크 목록을 추출한 뒤, 각 링크를 방문해 추가 정보를 수집하세요. 파이썬에서는 URL 반복, Thunderbit에서는 “하위 페이지 추출” 기능으로 AI가 자동 방문 및 데이터 확장까지 처리해줍니다.

7. 데이터 내보내기 및 자동화

정제된 데이터를 CSV, 엑셀, 구글 시트, 데이터베이스 등으로 내보내세요. 반복 작업이라면 cron, Airflow, 또는 Thunderbit의 자연어 스케줄러(“매주 월요일 오전 9시”)로 자동화하세요.

Thunderbit: AI로 파이썬 스크래핑을 한 단계 업그레이드

아무리 파이썬 코드가 완벽해도, 비정형·보호된 데이터 앞에서는 한계가 있습니다. 이럴 때 가 진가를 발휘합니다.

Thunderbit와 파이썬의 시너지

Thunderbit는 AI 기반 크롬 확장 프로그램으로, 웹페이지(PDF, 이미지 등 포함)를 읽어 구조화된 데이터로 바꿔줍니다. 코딩이 필요 없죠. 실제 활용 예시는 다음과 같습니다:

- 비정형 데이터: PDF, 이미지, 구조가 불규칙한 사이트는 Thunderbit의 AI에 맡기세요. PDF에서 표 추출, 이미지에서 텍스트 인식, 필드 자동 제안까지 가능합니다.

- 하위 페이지·다단계 스크래핑: Thunderbit의 “하위 페이지 추출” 기능은 시간 절약에 탁월합니다. 목록 페이지를 긁고, AI가 상세 페이지를 방문해 결과를 합쳐줍니다. 복잡한 반복문이나 상태 관리가 필요 없습니다.

- 데이터 내보내기: Thunderbit는 엑셀, 구글 시트, Notion, Airtable 등으로 바로 내보낼 수 있습니다. 이후 파이썬 파이프라인에서 추가 분석이나 리포팅에 활용하면 됩니다.

실전 예시: Python + Thunderbit 활용법

예를 들어 부동산 매물 정보를 수집한다고 가정해봅시다. 여러 사이트에서 파이썬과 Scrapy로 매물 URL을 모으고, 한 사이트는 상세 정보를 PDF로만 제공합니다. 이때 PDF를 Thunderbit에 업로드해 AI로 표를 추출, CSV로 내보냅니다. 이후 파이썬에서 모든 데이터를 통합해 시장 분석을 할 수 있습니다.

또는 영업 리드 리스트를 만들 때, 파이썬으로 회사 URL을 수집한 뒤 Thunderbit의 이메일·전화번호 추출기(무료!)로 각 사이트에서 연락처를 한 번에 뽑아낼 수 있습니다. 복잡한 정규식도 필요 없습니다.

유지보수 가능한 스크래핑 워크플로우 구축하기

단발성 스크립트도 좋지만, 대부분의 비즈니스 스크래핑은 반복적입니다. 확장성과 유지보수가 쉬운 구조를 만드는 방법은 다음과 같습니다:

CCCD 프레임워크: Crawl, Collect, Clean, Debug

- Crawl: 대상 URL 수집(사이트맵, 검색 페이지, 목록 등)

- Collect: 각 URL에서 데이터 추출(파이썬, Thunderbit, 또는 혼합)

- Clean: 데이터 정규화, 중복 제거, 검증

- Debug/Monitor: 실행 로그, 오류 처리, 이상 감지 및 알림 설정

이 과정을 파이프라인으로 그리면 다음과 같습니다:

URL → [크롤러] → [스크래퍼] → [정제기] → [내보내기] → [비즈니스 플랫폼]

스케줄링 및 모니터링

- 파이썬: cron, Airflow, 클라우드 스케줄러로 주기적 실행. 로그 기록, 오류 시 이메일/슬랙 알림.

- Thunderbit: 내장 스케줄러 사용—“매주 월요일 오전 9시”처럼 자연어로 예약하면, 클라우드에서 자동 실행 및 데이터 내보내기.

문서화 및 인수인계

코드는 Git 등 버전 관리에 보관하고, 워크플로우를 문서화하세요. 최소 한 명 이상이 파이프라인 실행·수정법을 알도록 하세요. 파이썬/Thunderbit 혼합 워크플로우라면, 각 도구가 어떤 사이트를 담당하고 결과물이 어디로 가는지 명확히 기록하세요(예: “Thunderbit는 C사이트를 구글 시트로, 파이썬은 모든 데이터를 주간 통합”).

윤리와 컴플라이언스: 2025년 책임 있는 스크래핑

강력한 스크래핑 능력에는 그만큼의 책임이 따릅니다. 법적·윤리적 기준을 지키는 방법은 다음과 같습니다:

robots.txt와 속도 제한

- robots.txt 확인: 사이트의 robots.txt에서 금지 경로와 크롤링 지연을 반드시 확인하세요. 파이썬의

robotparser로 자동화할 수 있습니다. - 예의 있는 스크래핑: 요청 간 딜레이를 추가하세요.

Crawl-delay가 있으면 반드시 지키세요. 과도한 요청으로 사이트에 부담을 주지 마세요. - User-Agent: 스크래퍼를 정직하게 식별하세요. Googlebot이나 브라우저로 위장하지 마세요.

데이터 프라이버시 및 법적 준수

- GDPR/CCPA: 이름, 이메일, 전화번호 등 개인정보를 수집할 경우, 관련 법률을 준수해야 합니다. 꼭 필요한 정보만 수집하고, 안전하게 보관하며, 삭제 요청 시 즉시 대응하세요.

- 이용약관: 로그인 뒤의 데이터는 허가 없이 스크래핑하지 마세요. 많은 사이트가 자동 접근을 금지하며, 위반 시 계정 정지 등 불이익이 있을 수 있습니다.

- 공개 데이터만: 공개적으로 접근 가능한 데이터만 수집하세요. 비공개, 저작권, 민감 정보는 피하세요.

컴플라이언스 체크리스트

- [ ] robots.txt에서 규칙과 지연 확인

- [ ] 예의 있는 속도 제한 및 커스텀 User-Agent 적용

- [ ] 공개적이고 민감하지 않은 데이터만 수집

- [ ] 개인정보는 관련 법에 따라 처리

- [ ] 사이트 이용약관 및 저작권 위반 금지

자주 발생하는 오류와 디버깅 팁

아무리 잘 만든 스크래퍼도 문제에 부딪힐 수 있습니다. 대표적인 오류와 해결법은 다음과 같습니다:

| 오류 유형 | 증상/메시지 | 디버깅 팁 |

|---|---|---|

| HTTP 403/429/500 | 차단, 속도 제한, 서버 오류 | 헤더 확인, 속도 조절, IP 회전, 프록시 사용. 크롤링 지연 준수. |

| 데이터 누락/NoneType | HTML에서 데이터 미발견 | HTML 출력 및 구조 확인. 구조 변경 또는 차단 페이지일 수 있음. |

| 자바스크립트 렌더링 데이터 | 정적 HTML에 데이터 없음 | Selenium/Playwright 사용 또는 API 호출 찾기. |

| 파싱/인코딩 문제 | 유니코드 오류, 이상한 문자 | 올바른 인코딩 설정, .text 또는 html.unescape() 활용. |

| 중복/불일치 | 데이터 반복 또는 불일치 | 고유 ID나 URL로 중복 제거. 필드 완성도 검증. |

| 봇 차단/CAPTCHA | CAPTCHA 페이지, 로그인 요구 | 속도 조절, 브라우저 자동화, Thunderbit/AI 활용. |

디버깅 워크플로우:

- 문제가 생기면 원본 HTML을 출력해보세요.

- 브라우저 개발자 도구로 스크립트와 실제 브라우저의 결과를 비교하세요.

- 모든 단계(요청 URL, 상태 코드, 추출 항목 수 등)를 로그로 남기세요.

- 대량 실행 전, 소규모 샘플로 테스트하세요.

실전 프로젝트 아이디어: 파이썬 스크래핑 실력 업그레이드

베스트 프랙티스를 실제로 적용해보고 싶다면, 아래 프로젝트에 도전해보세요:

1. 이커머스 가격 모니터링 대시보드

Amazon, eBay, Walmart에서 가격과 재고를 추출하세요. 봇 차단, 동적 콘텐츠 처리, 일일 데이터를 구글 시트로 내보내 트렌드 분석까지. 으로 빠르게 시작할 수 있습니다.

2. 구인 공고 통합 수집기

Indeed 및 특화된 구직 사이트에서 채용 공고를 모으세요. 직무, 회사, 위치, 게시일 등 파싱, 페이지네이션 처리, 공고 ID로 중복 제거, Airtable로 내보내기까지 자동화하세요.

3. 영업 리드용 연락처 추출기

회사 URL 목록을 받아 홈페이지·문의 페이지에서 이메일, 전화번호를 추출하세요. 파이썬의 정규식이나 Thunderbit의 무료 추출기를 활용해 엑셀로 내보내면 영업팀이 바로 활용할 수 있습니다.

4. 부동산 매물 비교 분석기

Zillow, Realtor.com 등에서 특정 지역의 매물 정보를 수집하세요. 주소와 가격을 정규화하고, 트렌드 비교, 구글 시트로 시각화까지 진행해보세요.

5. 소셜 미디어 언급 추적기

Reddit의 JSON API를 활용해 브랜드 언급을 추적하세요. 게시물 수 집계, 감성 분석, 시계열 데이터로 마케팅 인사이트를 얻을 수 있습니다.

결론: 2025년 파이썬 스크래핑의 핵심 요약

핵심만 다시 정리해보면:

- 웹 스크래핑은 비즈니스 인텔리전스, 영업, 운영에 필수입니다. 웹은 데이터의 금광이며, 이를 캐낼 줄 아는 사람이 승자입니다.

- 파이썬은 만능 도구:

requests와BeautifulSoup으로 시작해, Scrapy로 확장, 동적 사이트는 브라우저 자동화로 대응하세요. - Thunderbit 같은 AI 도구는 비정형·복잡·노코드 스크래핑의 비밀병기입니다. 파이썬과 AI를 결합하면 효율이 극대화됩니다.

- 베스트 프랙티스 준수: 구조 파악, 모듈화, 오류 처리, 데이터 정제, 자동화까지 꼼꼼히 챙기세요.

- 컴플라이언스는 필수: robots.txt 확인, 개인정보 보호법 준수, 윤리적 스크래핑을 실천하세요.

- 유연하게 대처: 웹은 계속 변합니다. 스크래퍼를 모니터링하고, 자주 디버깅하며, 변화에 빠르게 대응하세요.

웹 스크래핑의 미래는 하이브리드, 윤리적, 비즈니스 중심입니다. 초보든 전문가든, 계속 배우고 호기심을 유지하며, 데이터가 다음 성공을 이끌 수 있도록 하세요.

부록: 파이썬 스크래핑 학습 자료 & 도구

제가 자주 참고하는 학습 및 문제 해결 자료입니다:

- – 직관적인 HTTP 요청 라이브러리

- – HTML 파싱의 정석

- – 대규모, 실전용 스크래핑 프레임워크

- / – 브라우저 자동화 및 동적 콘텐츠 처리

- – 비즈니스 사용자를 위한 가장 쉬운 AI 웹 스크래퍼

- – AI 스크래핑 튜토리얼, 사례, 베스트 프랙티스

- – 최신 컴플라이언스 및 윤리 정보

- / ** – 커뮤니티 Q&A 및 문제 해결

Thunderbit가 스크래핑을 얼마나 쉽게 만들어주는지 궁금하다면, 에서 데모와 심층 가이드를 확인해보세요.

자주 묻는 질문(FAQ)

1. 2025년 기준, 최고의 파이썬 웹 스크래핑 라이브러리는?

정적 페이지와 소규모 작업에는 여전히 requests + BeautifulSoup 조합이 가장 쉽고 효율적입니다. 대규모·다중 페이지 스크래핑에는 가 적합하고, 동적 콘텐츠는 이나 을 추천합니다. 비정형·복잡 데이터는 같은 AI 도구가 큰 도움이 됩니다.

2. 자바스크립트 기반 동적 사이트는 어떻게 처리하나요?

Selenium이나 Playwright 같은 브라우저 자동화 도구로 페이지를 렌더링한 뒤 데이터를 추출하세요. 또는 네트워크 탭에서 JSON API 호출을 찾아 직접 요청하는 방법도 있습니다. 이 방식이 더 쉽고 안정적일 때가 많습니다.

3. 웹 스크래핑은 합법인가요?

미국 기준으로 공개 데이터 스크래핑은 대체로 합법이지만, 항상 확인, 사이트 이용약관 준수, GDPR/CCPA 등 개인정보 보호법을 지켜야 합니다. 비공개, 저작권, 민감 정보는 절대 스크래핑하지 마세요.

4. 스크래핑 워크플로우를 자동화·스케줄링하려면?

파이썬 스크립트는 cron, Airflow, 클라우드 스케줄러로 예약 실행하세요. 노코드 자동화가 필요하다면 의 내장 스케줄러를 활용하세요—일정만 자연어로 입력하면 클라우드에서 자동 실행됩니다.

5. 스크래퍼가 갑자기 작동하지 않을 때는?

먼저 사이트 구조가 변경됐거나 차단(HTTP 403/429)됐는지 확인하세요. HTML 구조를 재점검하고, 셀렉터를 수정하거나 요청 속도를 늦추세요. 봇 차단이 심하면 Thunderbit의 AI 기능이나 브라우저 자동화로 전환을 고려하세요.

즐거운 스크래핑 되시길 바랍니다! 데이터가 항상 깔끔하고, 합법적이며, 실전에서 바로 쓸 수 있기를 바랍니다. Thunderbit가 워크플로우에 어떻게 도움이 되는지 궁금하다면 을 설치해 직접 경험해보세요. 더 많은 팁이 필요하다면 에서 최신 정보를 확인할 수 있습니다.