웹에는 정말 셀 수 없이 많은 이미지가 넘쳐나고 있습니다. 매일 수십억 장의 이미지가 새로 올라오고, 이 이미지들은 이커머스 상품 사진부터 밈까지 다양한 곳에서 활용되고 있죠. 영업, 마케팅, 리서치 업무를 하다 보면 이미지를 하나하나 저장하는 반복 작업에 질릴 때가 많아요. 저도 예전에 ‘오른쪽 클릭 → 다른 이름으로 저장’을 무한 반복하다가, 더 효율적인 방법이 없을까 고민했던 적이 있습니다. 다행히 요즘은 python 이미지 스크래퍼와 같은 노코드 툴 덕분에 대량 이미지 다운로드가 훨씬 간편해졌어요.

이 글에서는 python 웹 이미지 스크래핑을 위한 실전 방법, 동적 사이트에서 이미지 추출하는 팁, 그리고 python과 Thunderbit을 함께 활용해 효율을 극대화하는 노하우까지 단계별로 소개합니다. 상품 카탈로그 구축, 경쟁사 분석, 혹은 단순 반복 작업에 지쳤다면, 실전 예제와 코드, 그리고 꿀팁까지 꼭 확인해보세요.

Python 이미지 스크래퍼란?

python 이미지 스크래퍼는 웹사이트를 자동으로 방문해서 <img> 태그 등에서 이미지 파일을 찾아 컴퓨터에 저장해주는 스크립트나 도구입니다. 일일이 이미지를 저장하지 않아도 python이 페이지를 불러오고, HTML을 분석해서 이미지를 한 번에 내려받을 수 있죠. ()

python 이미지 스크래퍼는 대량 이미지가 필요한 누구나 쓸 수 있습니다:

- 이커머스 팀: 공급사 사이트에서 상품 이미지를 한 번에 모아 카탈로그를 만듭니다.

- 마케터: 캠페인, 트렌드 분석을 위해 SNS 이미지를 수집합니다.

- 연구자: AI/머신러닝 데이터셋이나 논문 연구용 이미지 데이터를 구축합니다.

- 부동산 중개인: 매물 사진을 한 번에 모아 리스트를 만들거나 시장 분석에 활용합니다.

python 이미지 스크래퍼는 지치지 않는 디지털 인턴 같은 존재예요. 고양이 밈에 정신 팔릴 일도 없고요.

왜 Python으로 이미지 웹 스크래핑을 할까요?

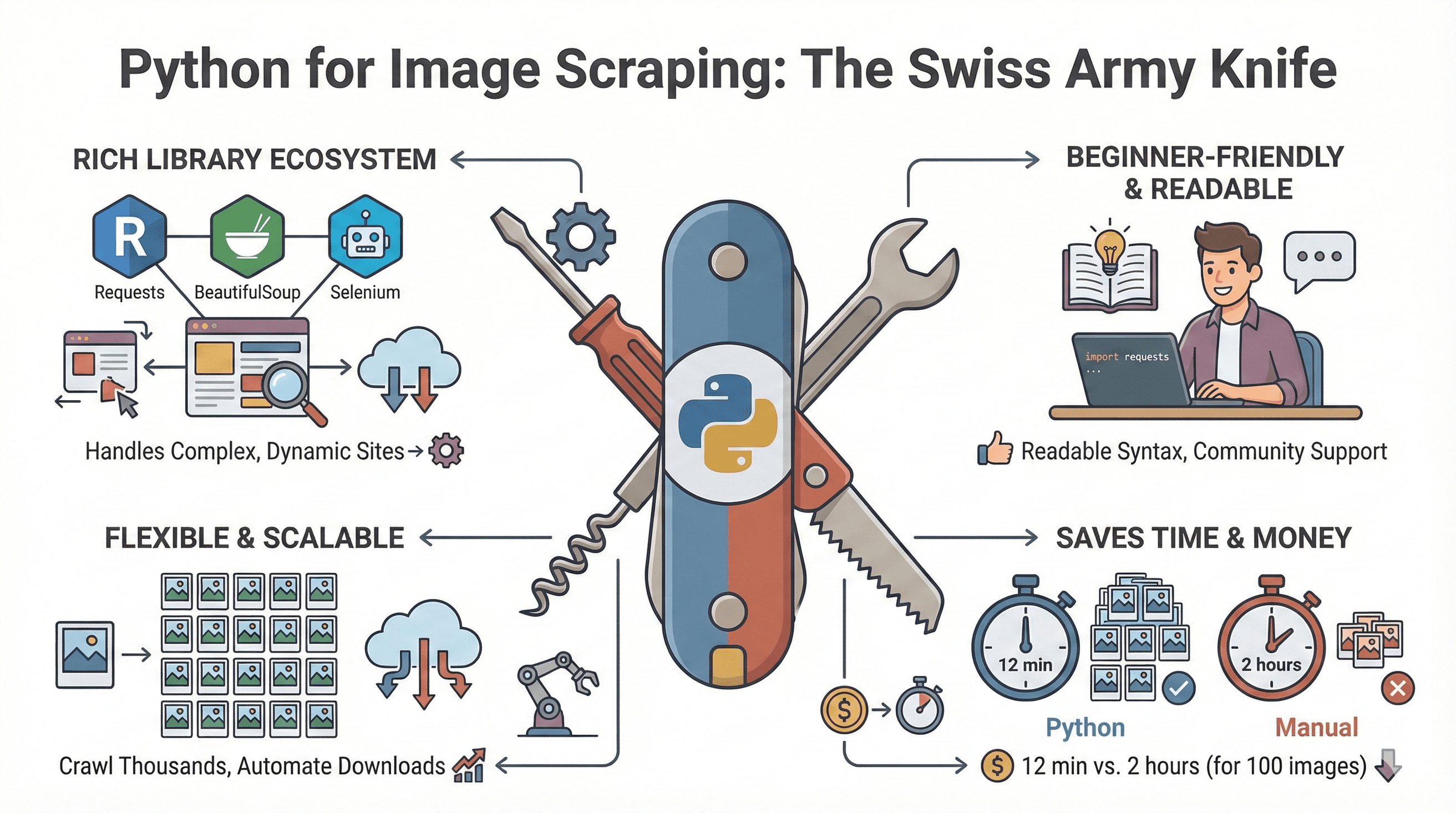

python은 웹 스크래핑 분야에서 거의 만능 도구로 통합니다. 그 이유는 다음과 같아요:

python은 웹 스크래핑 분야에서 거의 만능 도구로 통합니다. 그 이유는 다음과 같아요:

- 다양한 라이브러리: Requests, BeautifulSoup, Selenium 등으로 정적 사이트부터 자바스크립트 기반의 복잡한 사이트까지 모두 커버할 수 있습니다. ()

- 입문자도 쉽게 사용: python은 문법이 직관적이고, 튜토리얼과 커뮤니티 자료가 풍부합니다.

- 유연하고 확장성 높음: 한 페이지만이 아니라 수천 개의 페이지도 자동으로 크롤링하고, 다운로드 후 이미지 후처리까지 가능합니다.

- 시간과 비용 절감: python으로 100장 이미지를 스크래핑하는 데 12분 정도면 충분하지만, 수작업은 2시간 넘게 걸린다는 벤치마크도 있습니다. ()

비즈니스별 활용 예시는 아래 표를 참고하세요.

| 활용 사례 | 수작업의 어려움 | Python 스크래퍼의 장점 |

|---|---|---|

| 상품 카탈로그 구축 | 복사-붙여넣기 반복, 시간 소모 | 수천 장 이미지도 몇 분 만에 다운로드 |

| 경쟁사 분석 | 누락, 느린 비교 | 대량 이미지 동시 비교 |

| 트렌드 리서치 | 데이터셋 불완전 | 다양한 이미지 샘플 대량 수집 |

| AI/ML 데이터셋 구축 | 라벨링 반복, 번거로움 | 자동 수집 및 학습용 데이터 준비 |

| 부동산 매물 등록 | 정보 분산, 업데이트 어려움 | 사진을 한 곳에 모아 최신화 |

Python 이미지 스크래핑에 필요한 필수 도구

python으로 이미지 스크래핑을 할 때 주로 쓰는 라이브러리는 아래와 같습니다.

| 라이브러리 | 주요 기능 | 적합한 용도 | 장점 | 단점 |

|---|---|---|---|---|

| Requests | HTTP로 웹페이지 및 이미지 요청 | 정적 사이트 | 간단하고 빠름 | HTML 파싱/JS 미지원 |

| BeautifulSoup | HTML에서 <img> 태그 등 추출 | 이미지 URL 추출 | 사용법 쉬움, 유연함 | JS 미지원 |

| Scrapy | 대규모 크롤링/스크래핑 프레임워크 | 대형 프로젝트 | 비동기, 내장 데이터 내보내기 | 진입장벽 높음 |

| Selenium | 브라우저 자동화(자바스크립트, 스크롤 지원) | 동적/JS 기반 사이트 | JS 렌더링, 사용자 행동 시뮬레이션 | 느리고 설정 복잡 |

| Pillow (PIL) | 다운로드 후 이미지 처리 | 이미지 검증/편집 | 리사이즈, 포맷 변환, 검증 가능 | 스크래핑 자체는 불가 |

언제 어떤 도구를 쓸까?

- 정적 사이트:

requests + BeautifulSoup조합이 가장 기본입니다. - 동적/무한 스크롤 사이트:

Selenium이 필수입니다. - 대규모 반복 작업:

Scrapy로 구조화된 크롤링이 가능합니다. - 이미지 후처리:

Pillow로 리사이즈, 포맷 변환 등 후처리를 할 수 있습니다.

단계별 가이드: python으로 웹사이트 이미지 다운로드하기

이제 실제로 python을 이용해 정적 웹사이트에서 이미지를 다운로드하는 과정을 살펴볼게요.

Python 환경 준비하기

먼저 python 3가 설치되어 있는지 확인하세요. 가상환경을 만드는 것도 추천합니다.

1python3 -m venv venv

2source venv/bin/activate # Windows는 venv\Scripts\activate필요한 라이브러리 설치:

1pip install requests beautifulsoup4이미지 URL 찾고 추출하기

브라우저에서 대상 사이트를 열고, '검사' 기능으로 <img> 태그를 확인하세요. 이 태그들이 바로 타겟입니다.

아래는 이미지 URL을 추출하는 예시 코드입니다:

1import requests

2from bs4 import BeautifulSoup

3from urllib.parse import urljoin

4import os

5url = "https://example.com"

6response = requests.get(url)

7soup = BeautifulSoup(response.text, "html.parser")

8img_tags = soup.find_all("img")

9img_urls = [urljoin(url, img.get("src")) for img in img_tags if img.get("src")]팁: 일부 사이트는 data-src나 srcset 속성으로 이미지를 지연 로딩합니다. 해당 속성도 함께 확인하세요.

이미지 다운로드 및 저장하기

이미지를 폴더에 저장하는 코드 예시입니다:

1os.makedirs("images", exist_ok=True)

2for i, img_url in enumerate(img_urls):

3 try:

4 img_resp = requests.get(img_url, headers={"User-Agent": "Mozilla/5.0"})

5 if img_resp.status_code == 200:

6 file_ext = img_url.split('.')[-1].split('?')[0]

7 file_name = f"images/img_{i}.{file_ext}"

8 with open(file_name, "wb") as f:

9 f.write(img_resp.content)

10 print(f"Downloaded {file_name}")

11 except Exception as e:

12 print(f"Failed to download {img_url}: {e}")정리 팁:

- 파일명을 상품 ID나 페이지 제목 등으로 지정하면 관리가 쉽습니다.

- 카테고리별로 하위 폴더를 만들어 저장하세요.

- 중복 이미지는 URL이나 해시값으로 체크해 방지할 수 있습니다.

자주 발생하는 오류 및 해결법

- 이미지가 누락됨: JS로 로딩되는 이미지일 수 있습니다. 다음 섹션 참고.

- 요청 차단: User-Agent를 실제 브라우저처럼 설정하고, 다운로드 간에

time.sleep()으로 딜레이를 주세요. - 중복 다운로드: 이미 저장한 URL/파일명을 집합(set)으로 관리하세요.

- 권한 오류: 저장 폴더에 쓰기 권한이 있는지 확인하세요.

동적/자바스크립트 기반 페이지에서 이미지 스크래핑하기

일부 사이트는 이미지를 자바스크립트로 불러오거나, 무한 스크롤, '더보기' 버튼 등으로 숨겨놓기도 합니다. 이런 경우 Selenium을 활용하면 해결할 수 있습니다.

Selenium으로 동적 콘텐츠 처리하기

먼저 Selenium과 브라우저 드라이버(예: ChromeDriver)를 설치하세요:

1pip install selenium를 다운로드해 PATH에 추가합니다.

기본 Selenium 스크립트 예시:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3import time

4import os

5driver = webdriver.Chrome()

6driver.get("https://example.com/gallery")

7# 페이지 끝까지 스크롤해 이미지 로딩

8last_height = driver.execute_script("return document.body.scrollHeight")

9while True:

10 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

11 time.sleep(2) # 이미지 로딩 대기

12 new_height = driver.execute_script("return document.body.scrollHeight")

13 if new_height == last_height:

14 break

15 last_height = new_height

16img_elements = driver.find_elements(By.TAG_NAME, "img")

17img_urls = [img.get_attribute("src") for img in img_elements if img.get_attribute("src")]

18os.makedirs("dynamic_images", exist_ok=True)

19for i, img_url in enumerate(img_urls):

20 # (다운로드 로직은 위와 동일)

21 pass

22driver.quit()추가 팁:

WebDriverWait으로 이미지가 나타날 때까지 기다릴 수 있습니다.- 클릭해야 이미지를 볼 수 있는 경우

element.click()을 활용하세요.

대안: Playwright(파이썬 바인딩) 등은 더 빠르고 안정적으로 복잡한 사이트를 처리할 수 있습니다. ()

노코드 대안: Thunderbit로 웹사이트 이미지 추출하기

코딩이나 브라우저 드라이버 설치가 부담스럽다면 을 활용해보세요. Thunderbit은 AI 기반 웹 스크래퍼 크롬 확장 프로그램으로, 이미지 추출을 클릭 몇 번만에 끝낼 수 있습니다.

Thunderbit로 이미지 추출하는 방법

- Thunderbit 설치: 을 설치합니다.

- 대상 사이트 접속: 이미지를 추출할 페이지로 이동합니다.

- Thunderbit 실행: 확장 프로그램 아이콘을 클릭해 사이드바를 엽니다.

- AI 필드 추천: 'AI 필드 추천'을 클릭하면 Thunderbit의 AI가 페이지를 분석해 자동으로 '이미지' 컬럼을 생성합니다. ()

- 스크래핑 시작: '스크래핑' 버튼을 누르면, Thunderbit이 모든 이미지를 한 번에 수집합니다. (서브페이지, 무한 스크롤도 자동 지원)

- 내보내기: 이미지 URL 또는 파일을 Excel, Google Sheets, Notion, Airtable, CSV 등으로 바로 다운로드할 수 있습니다. 무료 플랜에서도 제한 없이 사용 가능합니다.

추가 기능: Thunderbit의 무료 이미지 추출기는 한 번의 클릭으로 페이지 내 모든 이미지 URL을 수집할 수 있습니다. ()

Thunderbit의 장점:

- 코딩이나 HTML 지식이 전혀 필요 없습니다.

- 동적 콘텐츠, 서브페이지, 페이지네이션도 자동 처리합니다.

- 내보내기가 즉시 가능하며, 무료 플랜에서도 무제한입니다.

- AI가 사이트 구조 변화를 자동으로 인식해 유지보수 걱정이 없습니다.

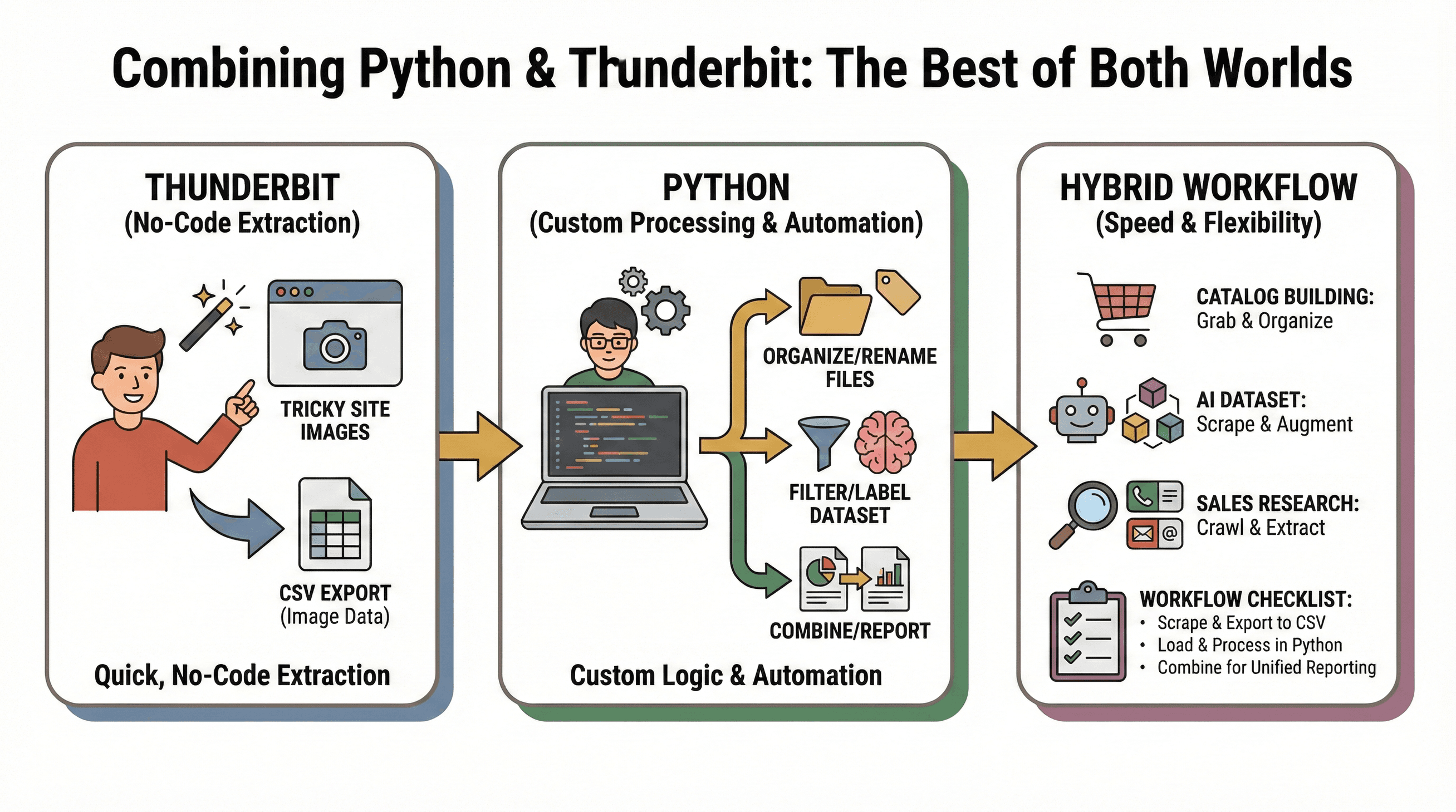

Python과 Thunderbit을 결합한 하이브리드 워크플로우

Thunderbit의 빠른 노코드 추출과 python의 맞춤형 자동화를 결합하면 최고의 효율을 낼 수 있습니다.

Thunderbit의 빠른 노코드 추출과 python의 맞춤형 자동화를 결합하면 최고의 효율을 낼 수 있습니다.

활용 예시:

- 카탈로그 구축: Thunderbit으로 복잡한 사이트에서 이미지를 추출한 뒤, python으로 파일 정리 및 이름 변경 등 후처리

- AI 데이터셋 제작: Thunderbit으로 여러 사이트에서 이미지를 수집하고, python 스크립트로 필터링, 라벨링, 증강 처리

- 영업 리서치: python으로 회사 URL 목록을 크롤링하고, Thunderbit으로 각 사이트에서 이미지, 이메일, 전화번호 등 추가 추출

워크플로우 체크리스트:

- Thunderbit으로 이미지를 스크래핑해 CSV로 내보내기

- python에서 CSV를 불러와 추가 분석 또는 자동화

- 여러 소스의 데이터를 통합해 리포트 작성

이런 하이브리드 방식은 속도, 유연성, 그리고 어떤 웹 이미지 스크래핑 상황에도 대응할 수 있는 강점을 줍니다.

python 이미지 스크래핑 실전 팁 & 문제 해결법

자주 겪는 문제:

- 요청 차단: User-Agent를 브라우저처럼 설정하고, 다운로드 간 딜레이를 추가하며, robots.txt를 준수하세요.

- 이미지 누락: JS로 로딩되는 경우 Selenium이나 Thunderbit을 활용하세요.

- 중복 다운로드: URL이나 파일 해시로 중복을 체크하세요.

- 손상된 파일: Pillow로 다운로드 후 이미지가 정상인지 검증하세요.

베스트 프랙티스:

- 사이트, 카테고리, 날짜별로 폴더를 체계적으로 관리하세요.

- 파일명은 상품 ID, 페이지 제목 등으로 구체적으로 지정하세요.

- 광고, 아이콘 등 불필요한 이미지는 파일 크기나 해상도로 필터링하세요.

- 이미지 스크래핑 전 저작권 및 서비스 이용약관을 반드시 확인하세요. ()

python 이미지 스크래퍼 솔루션 비교: 코드 vs 노코드

아래는 각 방식의 장단점을 한눈에 비교한 표입니다.

| 기준 | Python (Requests/BS) | Selenium (Python) | Thunderbit (노코드) |

|---|---|---|---|

| 사용 난이도 | 중간 (코딩 필요) | 높음 (코딩+브라우저 자동화) | 매우 쉬움 (클릭, AI 추천) |

| 동적 콘텐츠 지원 | 불가 | 가능 | 가능 |

| 준비 시간 | 길음 (설치, 코드 작성) | 매우 김 (드라이버, 코드) | 매우 짧음 (확장 설치) |

| 확장성 | 수동 (병렬화 가능) | 느림 (브라우저 부하) | 높음 (클라우드, 50페이지 동시) |

| 유지보수 | 높음 (사이트 변경 시 스크립트 수정) | 높음 | 낮음 (AI 자동 대응) |

| 내보내기 옵션 | 커스텀 (CSV, DB 등) | 커스텀 | 원클릭 Excel, Sheets, Notion 등 |

| 비용 | 무료 (오픈소스) | 무료 | 무료 플랜, 대량은 유료 |

정리: 코딩에 익숙하고 세밀한 제어가 필요하다면 python이 최적입니다. 빠르고 간편하게, 특히 동적 사이트에서 이미지를 추출하려면 Thunderbit이 큰 도움이 됩니다. 대부분의 팀은 두 가지를 함께 활용할 때 최고의 효율을 경험할 수 있습니다.

결론 & 핵심 요약

웹의 이미지 데이터는 점점 더 방대해지고 있습니다. python 이미지 스크래퍼는 자동화와 유연성을 제공하고, Thunderbit 같은 노코드 도구는 누구나 쉽게 이미지 스크래핑을 할 수 있게 해줍니다.

핵심 요약:

- 정적 사이트와 맞춤형 워크플로우에는 python (Requests + BeautifulSoup)이 적합합니다.

- 동적/자바스크립트 기반 페이지는 Selenium을 활용하세요.

- 빠르고 노코드로 이미지를 추출하려면 Thunderbit이 최적입니다. 특히 Excel, Google Sheets, Notion 등으로 즉시 내보내야 할 때 유용합니다.

- Thunderbit으로 데이터 수집, python으로 후처리 및 자동화를 결합하면 최고의 워크플로우를 만들 수 있습니다.

이미지 스크래핑을 한 단계 업그레이드하고 싶다면, 간단한 python 스크립트부터 시작하거나 해 얼마나 시간을 절약할 수 있는지 직접 경험해보세요. 더 많은 팁과 심화 가이드는 와 에서 확인할 수 있습니다.

즐거운 스크래핑 하시고, 이미지 폴더가 항상 깔끔하게 정리되길 바랍니다!

자주 묻는 질문(FAQ)

1. python 이미지 스크래퍼란 무엇인가요?

python 이미지 스크래퍼는 웹사이트를 자동으로 방문해 <img> 태그 등에서 이미지를 찾아 컴퓨터에 저장하는 스크립트 또는 도구입니다. 일일이 이미지를 저장하는 번거로움을 줄여줍니다.

2. 이미지 웹 스크래핑에 가장 많이 쓰는 python 라이브러리는?

Requests(웹페이지 요청), BeautifulSoup(HTML 파싱), Selenium(동적 콘텐츠 처리), Pillow(다운로드 후 이미지 처리)가 대표적입니다.

3. 자바스크립트 기반/무한 스크롤 사이트에서 이미지를 추출하려면?

Selenium으로 브라우저를 자동화해 페이지를 스크롤하고, 모든 콘텐츠가 로드된 후 이미지 URL을 추출하세요. Thunderbit도 AI 기반으로 동적 콘텐츠를 자동 처리할 수 있습니다.

4. 노코드로 웹사이트 이미지를 추출할 수 있나요?

네! Thunderbit은 AI로 이미지를 감지해 추출하는 노코드 크롬 확장 프로그램입니다. 클릭 몇 번만으로 Excel, Google Sheets, Notion, Airtable 등으로 내보낼 수 있습니다.

5. python과 Thunderbit을 함께 쓸 수 있나요?

물론입니다. Thunderbit으로 빠르게 이미지를 추출하고, python으로 고급 처리나 자동화를 할 수 있습니다. Thunderbit에서 내보낸 데이터를 python 스크립트로 추가 가공하면 최고의 효율을 얻을 수 있습니다.

더 알아보기