웹 스크래핑에 처음 발을 들이는 많은 개발자들이 경쟁사 사이트에서 상품 정보를 뽑아보고 싶다는 호기심에서 시작하곤 하죠. 이때 가장 먼저 접하게 되는 도구가 바로 BeautifulSoup입니다. 하지만 처음에는 설치나 사용법이 어렵게 느껴질 수 있어요. 여러 번 시도 끝에 pip install beautifulsoup4 명령어로 설치를 마치고, 간단하게 HTML 요소(예: 헤드라인)를 추출해보는 순간, '아! 이거구나!' 하는 깨달음이 오죠. 이 경험이 파이썬 입문자들에게 큰 자신감을 심어주곤 합니다.

웹 스크래핑을 막 시작했다면 BeautifulSoup이라는 이름을 가장 먼저 듣게 될 거예요. 그만큼 쉽고 강력해서, 10년 넘게 파이썬 웹 스크래핑의 대표 라이브러리로 자리 잡고 있거든요. 이 글에서는 pip으로 BeautifulSoup을 설치하는 방법부터, 실제 코드 예제, 그리고 여전히 많은 개발자와 데이터 분석가들이 BeautifulSoup을 선호하는 이유까지 하나씩 짚어볼게요. 물론 BeautifulSoup의 한계와, 최근 비개발자들이 AI 기반 도구(예: )로 옮겨가는 이유도 솔직하게 다룹니다.

BeautifulSoup이란? 그리고 여전히 많이 쓰이는 이유는?

먼저 BeautifulSoup이 뭔지부터 알아볼까요? 쉽게 말해, 파이썬에서 HTML이나 XML을 쉽게 다룰 수 있게 해주는 'HTML 파서'입니다. HTML 코드를 넣으면 BeautifulSoup이 트리 구조로 바꿔줘서, 원하는 데이터를 파이썬 코드로 쉽게 찾고, 탐색하고, 뽑아낼 수 있어요. 웹페이지의 내부 구조를 투명하게 들여다볼 수 있는 도구라고 생각하면 됩니다.

BeautifulSoup이 꾸준히 인기 있는 이유는?

새로운 스크래핑 프레임워크가 계속 나와도, BeautifulSoup은 여전히 파이썬 입문자들이 가장 먼저 찾는 도구입니다. 실제로 PyPI에서 다운로드되고 있고, Stack Overflow에는 이 올라와 있어서, 초보자도 쉽게 도움을 받을 수 있습니다.

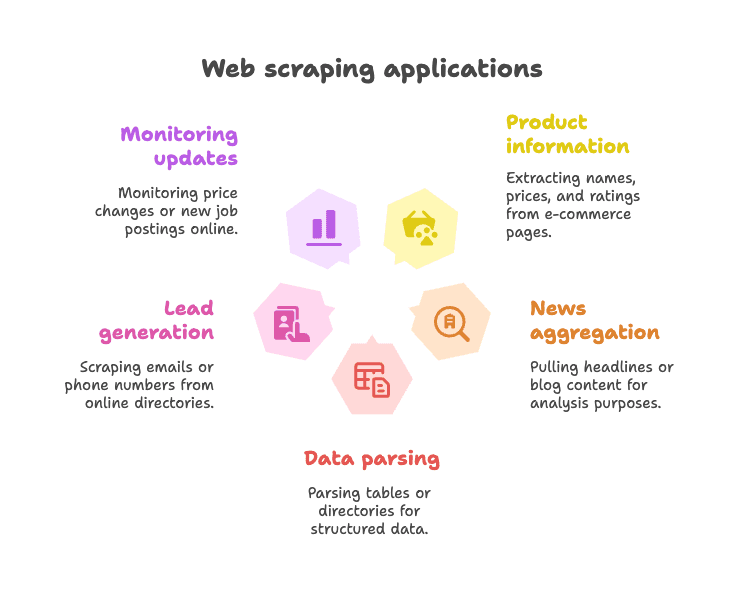

주요 활용 예시:

- 이커머스 상품 정보 추출 (상품명, 가격, 평점 등)

- 뉴스 헤드라인/블로그 콘텐츠 수집

- 테이블/디렉터리 등 구조화된 데이터 파싱 (예: 업체 목록)

- 리드 생성 (이메일, 전화번호 등 디렉터리에서 추출)

- 가격 변동, 채용 공고 등 웹사이트 업데이트 모니터링

BeautifulSoup은 특히 정적인 웹페이지(HTML에 데이터가 바로 노출된 사이트)에서 진가를 발휘합니다. 유연하고, HTML이 엉망이어도 잘 동작하며, 복잡한 프레임워크에 얽매이지 않아 초보자도 부담 없이 쓸 수 있어요. 그래서 2025년에도 여전히 많은 파이썬 웹 스크래퍼들의 '첫사랑'으로 불리고 있습니다. ()

pip으로 BeautifulSoup 설치하기: 가장 쉬운 시작법

pip이란? 왜 써야 할까?

파이썬을 처음 접했다면, pip은 PyPI(Python Package Index)에서 라이브러리를 설치해주는 패키지 매니저입니다. 쉽게 말해, 파이썬용 앱스토어라고 생각하면 돼요. pip으로 BeautifulSoup을 설치하는 게 가장 빠르고 확실한 방법입니다.

꿀팁: 패키지 이름은 꼭 beautifulsoup4로 입력해야 최신 버전을 설치할 수 있어요. (beautifulsoup만 입력하면 안 됩니다)

단계별 설치 방법

1. 파이썬 버전 확인

BeautifulSoup은 파이썬 3.7 이상에서 동작합니다. 터미널에서 아래 명령어로 버전을 확인하세요.

1python --version또는

1python3 --version2. pip으로 BeautifulSoup4 설치

터미널(명령 프롬프트)에서 아래 명령어를 입력하세요.

1pip install beautifulsoup4파이썬 버전이 여러 개라면 아래처럼 입력해야 할 수도 있어요.

1pip3 install beautifulsoup4윈도우에서는 다음 명령어도 가능합니다.

1py -m pip install beautifulsoup43. (선택) 파서 추가 설치

BeautifulSoup은 기본적으로 파이썬 내장 "html.parser"를 사용하지만, 더 빠르고 정확한 파싱을 원한다면 lxml과 html5lib도 함께 설치하는 게 좋아요.

1pip install lxml html5lib4. (선택) Requests 라이브러리 설치

BeautifulSoup은 HTML 파싱만 담당하므로, 웹페이지를 다운로드하려면 라이브러리가 필요합니다.

1pip install requests5. 설치 확인

파이썬에서 아래 코드를 실행해보세요.

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("http://example.com").text

4soup = BeautifulSoup(html, "html.parser")

5print(soup.title)<title>Example Domain</title>가 출력되면 정상입니다.

가상환경에서 BeautifulSoup 설치하기

파이썬 프로젝트에서는 을 사용하는 게 좋습니다. 프로젝트별로 라이브러리를 관리할 수 있어 충돌을 막을 수 있거든요.

설정 방법:

1python -m venv venv

2# 윈도우:

3venv\Scripts\activate

4# macOS/Linux:

5source venv/bin/activate

6pip install beautifulsoup4 requests lxml html5lib이제 설치한 라이브러리는 이 프로젝트 폴더 안에서만 적용됩니다. 패키지 충돌 걱정 끝!

기타 설치 방법(Conda 등)

를 쓴다면 아래 명령어로 설치할 수 있어요.

1conda install beautifulsoup4파서도 함께 설치하려면:

1conda install lxml설치 전에 conda 환경이 활성화되어 있는지 꼭 확인하세요.

BeautifulSoup 파이썬: 실전 코드 예제

이제 실제로 BeautifulSoup을 어떻게 쓰는지 살펴볼게요.

예제 1: 웹페이지 가져와서 제목 추출하기

1from bs4 import BeautifulSoup

2import requests

3url = "https://en.wikipedia.org/wiki/Python_(programming_language)"

4response = requests.get(url)

5soup = BeautifulSoup(response.content, "html.parser")

6# 페이지 제목 추출

7title_text = soup.title.string

8print("Page title:", title_text)위 코드는 위키피디아 파이썬 페이지의 제목을 출력합니다.

예제 2: 모든 하이퍼링크 추출

1links = soup.find_all('a')

2for link in links[:10]: # 처음 10개만 출력

3 href = link.get('href')

4 text = link.get_text()

5 print(f"{text}: {href}")페이지 내 첫 10개의 링크 텍스트와 URL을 출력합니다.

예제 3: 헤드라인 추출

1headings = soup.find_all('h2')

2for h in headings:

3 print(h.get_text().strip())모든 <h2> 헤드라인을 추출합니다.

예제 4: CSS 선택자 사용

1items = soup.select("ul.menu > li")

2for item in items:

3 print(item.get_text())select() 메서드로 CSS 선택자를 사용할 수 있습니다.

예제 5: 속성 및 중첩 태그 추출

1first_link = soup.find('a')

2print(first_link['href']) # 직접 접근(없으면 에러)

3print(first_link.get('href')) # 안전하게 접근(없으면 None)예제 6: 전체 텍스트 추출

1text_content = soup.get_text()

2print(text_content)페이지의 모든 텍스트를 한 번에 추출할 수 있습니다.

초보자를 위한 BeautifulSoup 주요 활용법

-

단일 요소 찾기:

soup.find('div', class_='price') -

여러 요소 찾기:

soup.find_all('p', class_='description') -

텍스트 추출:

element.get_text() -

속성값 추출:

element.get('href') -

CSS 선택자 사용:

soup.select('table.data > tr') -

요소가 없을 때 처리:

1price = soup.find('span', class_='price') 2if price: 3 print(price.get_text())

BeautifulSoup의 문법은 직관적이라 초보자도 금방 익힐 수 있습니다. ()

BeautifulSoup의 한계: 최신 웹 스크래핑에서 주의할 점

이제 BeautifulSoup의 단점도 솔직하게 짚어볼게요. 정적 페이지나 소규모 프로젝트에는 정말 좋지만, 모든 상황에 완벽하진 않습니다.

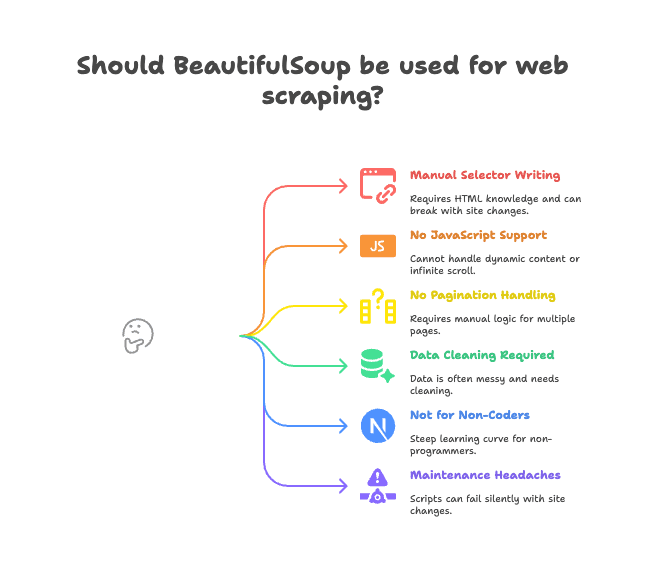

주요 한계점:

- 셀렉터 직접 작성: HTML 구조를 직접 분석해서 태그/클래스 경로를 지정해야 하고, 사이트 구조가 바뀌면 코드가 깨질 수 있어요.

- 자바스크립트 미지원: BeautifulSoup은 서버에서 받은 HTML만 볼 수 있습니다. JS로 동적으로 로드되는 데이터(무한 스크롤, 동적 콘텐츠 등)는 추출이 안 돼요. ()

- 페이지네이션/서브페이지 자동화 없음: 여러 페이지를 넘기거나 상세페이지로 들어가려면 직접 코드를 짜야 합니다.

- 데이터 정제 필요: 추출한 데이터에 불필요한 공백, 특수문자, 포맷 불일치 등이 많아 추가 정제가 필요해요.

- 비개발자에겐 진입장벽: 코딩 경험이 없는 영업, 마케팅, 운영 담당자에겐 진입장벽이 높습니다.

- 유지보수 어려움: 사이트 구조가 바뀌면 코드가 조용히 실패하거나, 데이터 누락이 생길 수 있습니다.

이런 '작은' 불편들이 쌓이면 실제 업무에서는 큰 비효율로 이어질 수 있어요. 실제로 많은 프로젝트가 스크래핑 코드 유지보수 때문에 중단되는 경우도 많습니다.

Thunderbit로 웹 데이터 추출을 바꾸는 이유

그럼 대안은 뭘까요? 바로 입니다. Thunderbit은 단순한 파이썬 라이브러리가 아니라, AI가 내장된 크롬 확장 프로그램으로 웹 데이터 추출 방식을 완전히 바꿔줍니다.

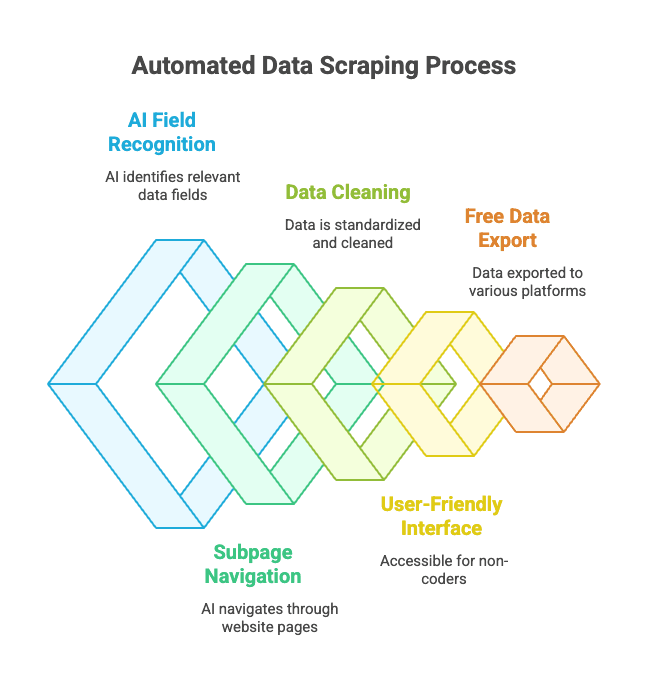

사용 방법도 정말 간단해요:

- 원하는 웹사이트를 열고,

- 'AI 필드 추천'을 클릭하면 Thunderbit의 AI가 페이지를 분석해서 '상품명', '가격', '위치' 등 적절한 컬럼을 자동으로 제안합니다.

- 필요에 따라 컬럼명이나 타입을 수정할 수 있어요.

- '스크래핑' 버튼만 누르면, Thunderbit이 데이터를 추출하고 자동으로 정리해줍니다.

- 엑셀, 구글 시트, Notion, Airtable 등 원하는 곳으로 한 번에 내보낼 수 있습니다.

코드도, 셀렉터도, 유지보수도 필요 없습니다.

Thunderbit의 주요 장점:

- AI 기반 필드 인식: HTML이 복잡해도 AI가 원하는 데이터를 자동으로 찾아줍니다.

- 서브페이지/페이지네이션 지원: 상품 상세페이지 클릭, '다음 페이지' 자동 이동 등도 지원합니다.

- 데이터 정제 및 포맷팅: 전화번호, 이메일, 이미지 등도 깔끔하게 정리됩니다.

- 비개발자도 사용 가능: 브라우저만 쓸 줄 알면 누구나 사용 가능.

- 무료 데이터 내보내기: 엑셀, 구글 시트, Airtable, Notion 등으로 무료로 내보낼 수 있습니다.

- 예약 스크래핑: 원하는 시간에 자동으로 데이터 추출도 가능합니다.

비즈니스 사용자라면, 이제 복잡한 파이썬 코드 대신 클릭 몇 번으로 데이터를 얻을 수 있습니다.

Thunderbit vs. BeautifulSoup: 어떤 도구가 나에게 맞을까?

비교해보면 다음과 같습니다:

| 기능 | BeautifulSoup (파이썬 코딩) | Thunderbit (노코드 AI) |

|---|---|---|

| 설치 | 파이썬, pip, 코드 필요 | 크롬 확장, 2번 클릭으로 설치 |

| 데이터 추출 속도 | 첫 스크립트까지 수 시간 | 사이트당 몇 분이면 완료 |

| 자바스크립트 지원 | 불가(추가 도구 필요) | 가능(브라우저에서 실행) |

| 페이지네이션/서브페이지 | 직접 코드 작성 | 내장, 옵션으로 지원 |

| 데이터 정제 | 직접 코드 작성 | AI가 자동 정리 |

| 내보내기 옵션 | CSV/엑셀 직접 구현 | 구글 시트, Notion 등 원클릭 |

| 추천 대상 | 개발자, 취미로 코딩하는 분 | 비즈니스 사용자, 비개발자 |

| 비용 | 무료(시간 소요) | 프리미엄(소규모 무료) |

BeautifulSoup이 적합한 경우:

- 파이썬에 익숙하고, 세밀한 제어가 필요할 때

- 정적 사이트나 커스텀 로직이 필요한 경우

- 파이썬 워크플로우에 스크래핑을 통합할 때

Thunderbit이 적합한 경우:

- 빠르게 결과가 필요하고, 코딩이 부담스러울 때

- 동적(자바스크립트 기반) 사이트를 다뤄야 할 때

- 영업, 마케팅, 운영 등 비개발자이거나, 데이터를 바로 비즈니스 도구로 내보내고 싶을 때

실제로 저도 개발자지만, 간단히 데이터만 뽑고 싶을 땐 Thunderbit을 자주 사용합니다. 브라우저에서 바로 데이터 추출이 가능하니 정말 편리해요.

BeautifulSoup 설치 및 활용 꿀팁

BeautifulSoup을 계속 쓴다면, 아래 팁을 참고해보세요.

- 가상환경 사용: 프로젝트별로 라이브러리를 관리해 충돌을 막으세요.

- pip 및 패키지 최신화:

pip install --upgrade pip와pip list --outdated로 주기적으로 업데이트하세요. - 추천 파서 설치:

pip install lxml html5lib로 성능과 안정성을 높이세요. - 코드 분리: 데이터 다운로드와 파싱 로직을 분리해 디버깅을 쉽게 하세요.

- robots.txt와 요청 간격 준수: 사이트에 과도한 요청을 보내지 않도록

time.sleep()을 활용하세요. - 안정적인 셀렉터 사용: 너무 구체적인 경로는 피하고, 변경에 강한 셀렉터를 사용하세요.

- HTML 저장 후 테스트: 페이지를 저장해 오프라인에서 파싱 테스트를 해보세요.

- 커뮤니티 활용: 에서 다양한 문제 해결법을 찾을 수 있습니다.

BeautifulSoup 설치 오류 해결법

문제가 생겼다면 아래 체크리스트를 참고하세요.

- “ModuleNotFoundError: No module named bs4”

- 올바른 환경에 beautifulsoup4를 설치했는지 확인.

python -m pip install beautifulsoup4로 재설치.

- 올바른 환경에 beautifulsoup4를 설치했는지 확인.

- 잘못된 패키지 설치(beautifulsoup → beautifulsoup4)

- 기존 패키지 삭제:

pip uninstall beautifulsoup - 올바른 패키지 설치:

pip install beautifulsoup4

- 기존 패키지 삭제:

- 파서 경고/유니코드 오류

lxml,html5lib설치 후, 파서 지정:BeautifulSoup(html, "lxml")

- 요소를 못 찾는 경우

- 데이터가 자바스크립트로 로드되는지 확인. BeautifulSoup은 렌더링된 DOM이 아닌, 원본 HTML만 볼 수 있습니다.

- pip 오류/권한 문제

- 가상환경 사용, 또는

pip install --user beautifulsoup4시도 - pip 업그레이드:

pip install --upgrade pip

- 가상환경 사용, 또는

- Conda 관련 문제

conda install beautifulsoup4또는 conda 환경 내에서 pip 사용

그래도 해결이 안 된다면, 와 Stack Overflow에서 대부분의 상황을 찾을 수 있습니다.

결론: BeautifulSoup 설치와 활용의 핵심 요약

-

BeautifulSoup은 파이썬 웹 스크래핑의 대표 라이브러리로, 쉽고 유연하며 초보자에게 적합합니다.

-

pip으로 설치하세요:

1pip install beautifulsoup4 lxml html5lib requests -

가상환경을 사용해 환경을 깔끔하게 관리하세요.

-

정적 페이지, 소규모 프로젝트에 특히 강점이 있지만, 자바스크립트, 페이지네이션, 유지보수에는 한계가 있습니다.

-

Thunderbit은 비개발자와 비즈니스 사용자를 위한 최신 AI 기반 대안입니다. 코드 없이, 복잡함 없이, 원하는 데이터를 바로 얻을 수 있습니다.

-

상황에 맞는 도구를 선택하세요:

- 개발자/코딩에 익숙하다면 BeautifulSoup이 자유도를 제공합니다.

- 비즈니스 사용자/팀이라면 이 빠른 결과를 보장합니다.

두 가지 방법을 모두 경험해보세요. 가장 효율적으로 결과를 얻을 수 있는 방법이 최고의 선택입니다.

자주 묻는 질문: pip으로 BeautifulSoup 설치 및 활용

Q: beautifulsoup와 beautifulsoup4의 차이는 무엇인가요?

A: 항상 beautifulsoup4를 설치하세요. 최신 버전이며, 파이썬 3과 호환됩니다. 예전 패키지(beautifulsoup)는 더 이상 지원되지 않습니다. 사용 시에는 from bs4 import BeautifulSoup로 불러옵니다. ()

Q: BeautifulSoup과 함께 lxml이나 html5lib도 꼭 설치해야 하나요?

A: 필수는 아니지만, 설치하면 파싱 속도와 안정성이 크게 향상됩니다. pip install lxml html5lib로 설치하세요. ()

Q: BeautifulSoup으로 자바스크립트 기반 사이트도 추출할 수 있나요?

A: 불가능합니다. BeautifulSoup은 정적 HTML만 볼 수 있습니다. 자바스크립트로 로드되는 데이터는 Selenium 같은 브라우저 자동화 도구나, 같은 AI 기반 브라우저 도구를 사용하세요. ()

Q: BeautifulSoup을 삭제하려면 어떻게 하나요?

A: 터미널에서 pip uninstall beautifulsoup4를 실행하세요. ()

Q: Thunderbit은 무료인가요?

A: Thunderbit은 소규모 작업은 무료, 대량 추출이나 고급 기능은 유료 플랜이 있습니다. 브라우저에서 바로 무료로 체험할 수 있습니다. ()

BeautifulSoup과 Thunderbit의 실제 비교가 궁금하다면 을 참고하세요. 웹 스크래핑에 대해 더 배우고 싶다면 , 가이드도 추천합니다.

즐거운 스크래핑 하세요! 파이썬 전문가든, 단순히 데이터를 스프레드시트로 옮기고 싶은 분이든, 여러분을 도와줄 도구와 커뮤니티가 항상 기다리고 있습니다.