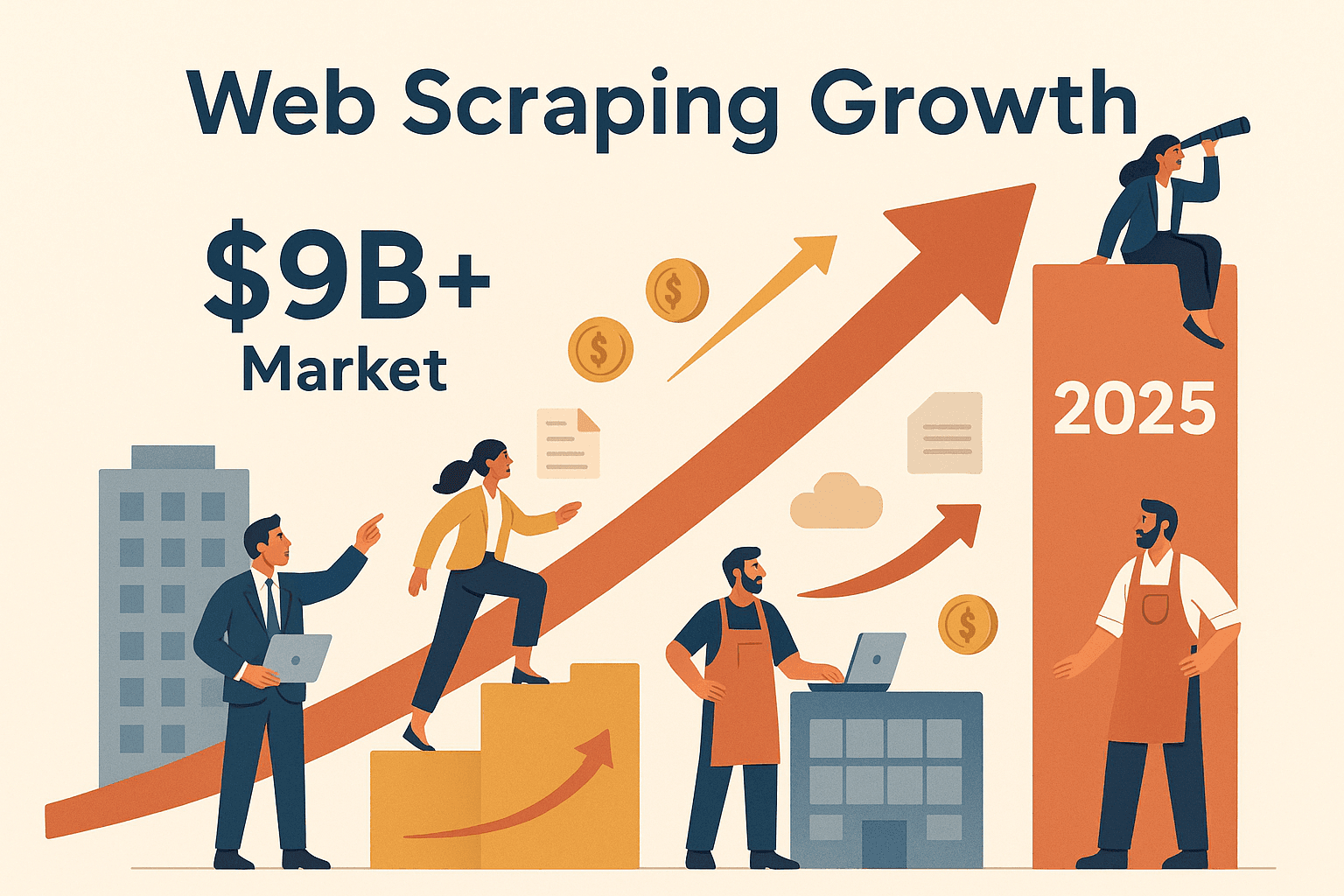

요즘 웹에는 정말 어마어마한 양의 데이터가 쏟아지고 있죠. 모든 기업이 이 데이터에서 더 많은 가치를 뽑아내고 싶어 하지만, 솔직히 수백 개 웹페이지에서 일일이 복사 붙여넣기 하는 건 너무 지루하고 비효율적입니다. 이럴 때 바로 node 웹 스크래핑이 진가를 발휘합니다. 최근 몇 년 사이 영업, 운영, 시장 조사 등 다양한 팀들이 웹에서 대규모로 인사이트를 얻기 위해 자동화에 눈을 돌리고 있어요. 실제로 글로벌 웹 스크래핑 시장은 이고, 대기업뿐 아니라 다양한 분야에서 활용되고 있습니다. 이커머스 가격 모니터링부터 리드 발굴까지, node 웹 스크래핑은 경쟁력을 갖추고 싶은 누구에게나 필수 역량이 되고 있어요.

Node.js로 웹사이트에서 데이터를 뽑아내는 방법이 궁금하거나, Node.js가 동적이고 자바스크립트 기반 사이트 스크래핑에 왜 강력한지 알고 싶었다면 이 가이드가 딱 맞아요. node 웹 스크래핑이 뭔지, 비즈니스에 왜 중요한지, 그리고 직접 스크래핑 워크플로우를 만드는 방법까지 단계별로 안내해 드릴게요. 만약 '결과부터 보고 싶다'면, 같은 도구로 몇 시간 걸릴 작업을 단 몇 분 만에 자동화하는 방법도 소개합니다. 이제 웹을 내 데이터 금광으로 바꿀 준비 되셨나요? 바로 시작해볼게요.

Node 웹 스크래핑이란? 자동 데이터 추출의 출발점

쉽게 말해, node 웹 스크래핑은 Node.js(자바스크립트 런타임)를 활용해 웹사이트에서 원하는 정보를 자동으로 뽑아내는 기술이에요. 마치 초고속 로봇이 웹페이지를 방문해서 필요한 정보만 쏙쏙 골라내는 느낌이죠. 예를 들어, 상품 가격, 연락처, 최신 뉴스 헤드라인 등 원하는 데이터를 자동으로 수집할 수 있습니다.

작동 방식은 이렇습니다:

- Node.js 스크립트가 웹사이트에 HTTP 요청을 보냅니다(브라우저처럼).

- 페이지의 원시 HTML을 받아옵니다.

- Cheerio 같은 라이브러리로 HTML을 파싱해서, jQuery처럼 쉽게 원하는 데이터를 뽑아냅니다.

- 만약 자바스크립트로 동적으로 로딩되는 사이트라면, Puppeteer로 실제 브라우저를 백그라운드에서 띄워 모든 스크립트가 실행된 후 데이터를 가져올 수 있어요.

Node.js를 쓰는 이유? 자바스크립트는 웹의 언어고, Node.js는 이걸 브라우저 밖에서도 쓸 수 있게 해줍니다. 정적/동적 사이트 모두 처리할 수 있고, 로그인이나 버튼 클릭 등 복잡한 상호작용도 자동화할 수 있죠. 또 Node의 비동기 구조 덕분에 여러 페이지를 동시에 빠르게 처리할 수 있어 대규모 데이터 추출에 딱입니다.

node 웹 스크래핑 대표 도구들:

- Axios: 웹페이지 요청 및 HTTP 통신 담당

- Cheerio: 정적 사이트의 HTML 파싱 및 데이터 추출

- Puppeteer: 자바스크립트 기반/동적 사이트에서 실제 브라우저 자동화

커피 한 잔 하면서 데이터가 자동으로 쌓이는 모습, 상상만 해도 뿌듯하죠?

Node 웹 스크래핑이 비즈니스 팀에 중요한 이유

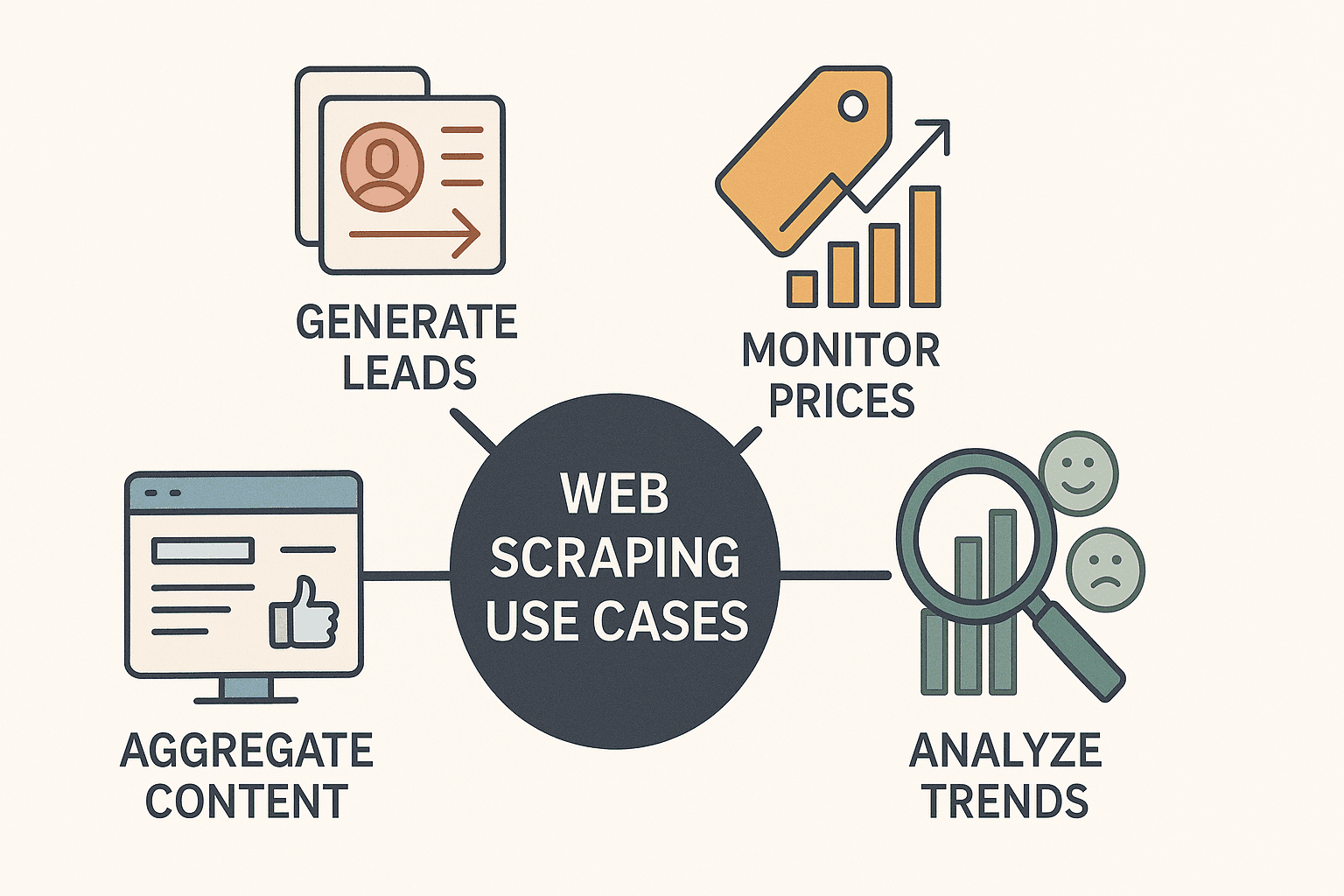

이제 웹 스크래핑은 해커나 데이터 과학자만의 영역이 아니에요. 비즈니스 경쟁력의 핵심 도구로 자리 잡았습니다. 다양한 업계의 기업들이 node 웹 스크래핑을 활용해:

- 리드 발굴: 디렉터리나 LinkedIn에서 연락처 정보 수집

- 경쟁사 가격 모니터링: 상품 가격을 실시간으로 추적 및 조정( 매일 경쟁사 가격을 스크래핑)

- 콘텐츠 집계: 뉴스, 리뷰, 소셜 미디어 언급을 한 곳에 모아 대시보드 구축

- 시장 트렌드 분석: 리뷰, 포럼, 구인 게시판 등에서 기회와 인사이트 발굴

Node.js를 활용하면 이 모든 작업이 훨씬 빠르고, 유연하며, 자동화도 쉽습니다. 비동기 처리 덕분에 수십~수백 개의 페이지를 동시에 처리할 수 있고, 최신 프레임워크로 만들어진 사이트도 손쉽게 스크래핑할 수 있어요.

실제 활용 예시는 다음과 같습니다:

| 활용 사례 | 설명 및 예시 | Node.js의 장점 |

|---|---|---|

| 리드 발굴 | 비즈니스 디렉터리에서 이메일, 이름, 전화번호 추출 | 빠른 병렬 스크래핑, CRM 및 API와 손쉬운 연동 |

| 가격 모니터링 | 이커머스 사이트에서 경쟁사 가격 추적 | 대량 페이지 비동기 요청, 일/시간 단위 스케줄링 용이 |

| 시장 트렌드 분석 | 리뷰, 포럼, 소셜 게시글 집계 및 감성 분석 | 다양한 데이터 처리, 텍스트 전처리 및 정제에 강력한 생태계 |

| 콘텐츠 집계 | 뉴스 기사나 블로그 포스트를 한 대시보드로 통합 | 실시간 업데이트, Slack/이메일 등 알림 도구와 연동 용이 |

| 경쟁사 분석 | 경쟁사 사이트에서 상품 카탈로그, 설명, 평점 등 추출 | 복잡한 사이트의 자바스크립트 파싱, 다중 페이지 크롤링에 모듈화된 코드 |

특히 Node.js는 자바스크립트 기반 사이트 스크래핑에 강점을 보이며, Python 등 다른 언어가 어려워하는 부분도 쉽게 처리할 수 있습니다. 제대로 세팅만 하면, '이 데이터만 있으면...'에서 '엑셀 파일로 정리 완료!'까지 단 몇 분이면 충분해요.

Node 웹 스크래핑 필수 도구 및 라이브러리

코드를 짜기 전에, node 웹 스크래핑에 꼭 필요한 주요 도구들을 먼저 알아볼게요:

1. Axios (HTTP 클라이언트)

- 역할: HTTP 요청을 보내 웹페이지의 HTML을 받아옴

- 사용 시점: 페이지의 원시 HTML이 필요할 때

- 장점: 간단한 Promise 기반 API, 리다이렉트/헤더 처리도 쉬움

- 설치:

npm install axios

2. Cheerio (HTML 파서)

- 역할: HTML을 파싱하고 jQuery 스타일로 데이터 추출

- 사용 시점: 정적 사이트에서 데이터가 HTML에 바로 있을 때

- 장점: 빠르고 가볍고, jQuery 경험자라면 바로 익숙함

- 설치:

npm install cheerio

3. Puppeteer (헤드리스 브라우저 자동화)

- 역할: 실제 Chrome 브라우저를 백그라운드에서 제어, 사용자처럼 페이지와 상호작용

- 사용 시점: 자바스크립트로 동적으로 로딩되거나, 로그인/팝업 등 상호작용이 필요한 사이트

- 장점: 버튼 클릭, 폼 입력, 스크롤, 스크립트 실행 후 데이터 추출까지 가능

- 설치:

npm install puppeteer

Tip: Playwright(멀티 브라우저 자동화), Apify의 Crawlee(고급 크롤링 프레임워크) 등도 있지만, 처음 시작할 땐 Axios, Cheerio, Puppeteer가 가장 기본이에요.

사전 준비: Node.js가 설치되어 있어야 하고, npm init -y로 새 프로젝트를 시작한 뒤 위 라이브러리들을 설치하세요.

단계별 실습: Node 웹 스크래퍼 직접 만들어보기

이제 직접 간단한 스크래퍼를 만들어볼게요. 데모 사이트 에서 Axios와 Cheerio로 도서 정보를 추출해보겠습니다.

1단계: 페이지 HTML 가져오기

1import axios from 'axios';

2import { load } from 'cheerio';

3const startUrl = 'http://books.toscrape.com/';

4async function scrapePage(url) {

5 const resp = await axios.get(url);

6 const html = resp.data;

7 const $ = load(html);

8 // ...데이터 추출 코드

9}2단계: 데이터 파싱 및 추출

1$('.product_pod').each((i, element) => {

2 const title = $(element).find('h3').text().trim();

3 const price = $(element).find('.price_color').text().replace('£', '');

4 const stock = $(element).find('.instock').text().trim();

5 const ratingClass = $(element).find('p.star-rating').attr('class') || '';

6 const rating = ratingClass.split(' ')[1];

7 const relativeUrl = $(element).find('h3 a').attr('href');

8 const bookUrl = new URL(relativeUrl, startUrl).href;

9 console.log({ title, price, rating, stock, url: bookUrl });

10});3단계: 페이지네이션 처리

1const nextHref = $('.next > a').attr('href');

2if (nextHref) {

3 const nextUrl = new URL(nextHref, url).href;

4 await scrapePage(nextUrl);

5}4단계: 데이터 저장

데이터를 다 모았다면 Node의 fs 모듈로 JSON이나 CSV 파일로 저장할 수 있어요.

1import fs from 'fs';

2// 스크래핑 완료 후:

3fs.writeFileSync('books_output.json', JSON.stringify(booksList, null, 2));

4console.log(`총 ${booksList.length}권의 도서를 추출했습니다.`);이렇게 하면 정적 사이트에 딱 맞는 기본 Node.js 웹 스크래퍼가 완성됩니다. 그런데 자바스크립트로 동작하는 사이트는 어떻게 할까요?

자바스크립트 기반 사이트 스크래핑: Puppeteer 활용법

요즘 웹사이트는 데이터를 자바스크립트로 숨겨놓는 경우가 많아요. 이런 사이트를 Axios와 Cheerio로 접근하면 빈 페이지나 누락된 정보만 얻을 수 있죠. 이럴 때 Puppeteer가 필요합니다.

Puppeteer를 쓰는 이유? 실제(헤드리스) 브라우저를 띄워 모든 스크립트가 실행된 후 렌더링된 콘텐츠를 가져올 수 있어서, 사람처럼 데이터를 추출할 수 있어요.

Puppeteer 예제 코드

1import puppeteer from 'puppeteer';

2async function scrapeWithPuppeteer(url) {

3 const browser = await puppeteer.launch({ headless: true });

4 const page = await browser.newPage();

5 await page.goto(url, { waitUntil: 'networkidle2' });

6 await page.waitForSelector('.product_pod'); // 데이터 로딩 대기

7 const data = await page.evaluate(() => {

8 let items = [];

9 document.querySelectorAll('.product_pod').forEach(elem => {

10 items.push({

11 title: elem.querySelector('h3').innerText,

12 price: elem.querySelector('.price_color').innerText,

13 });

14 });

15 return items;

16 });

17 console.log(data);

18 await browser.close();

19}Cheerio/Axios와 Puppeteer 선택 기준:

- Cheerio/Axios: 빠르고 가벼우며, 정적 콘텐츠에 적합

- Puppeteer: 느리지만 동적/상호작용 페이지(로그인, 무한 스크롤 등)에 필수

팁: 속도가 중요하다면 Cheerio/Axios부터 시도하고, 데이터가 누락된다면 Puppeteer로 전환하세요.

고급 Node 웹 스크래핑: 페이지네이션, 로그인, 데이터 정제

기본기를 익혔다면, 이제 더 복잡한 상황도 다뤄볼 차례입니다.

페이지네이션 처리

'다음' 링크를 감지해 반복적으로 페이지를 순회하거나, URL 패턴을 생성해 여러 페이지를 자동으로 크롤링합니다.

1let pageNum = 1;

2while (true) {

3 const resp = await axios.get(`https://example.com/products?page=${pageNum}`);

4 // ...데이터 추출

5 if (!hasNextPage) break;

6 pageNum++;

7}로그인 자동화

Puppeteer를 활용하면 실제 사용자처럼 로그인 폼을 자동으로 입력할 수 있습니다.

1await page.type('#username', 'myUser');

2await page.type('#password', 'myPass');

3await page.click('#loginButton');

4await page.waitForNavigation();데이터 정제

스크래핑 후에는 다음과 같이 데이터를 정리하세요:

- 중복 제거(집합 또는 고유 키로 필터링)

- 숫자, 날짜, 텍스트 포맷 통일

- 누락값 처리(null로 채우거나 불완전한 데이터는 제외)

정규표현식과 자바스크립트 문자열 메서드가 큰 도움이 됩니다.

Node 웹 스크래핑 실전 팁: 효율과 윤리 모두 챙기기

웹 스크래핑은 강력하지만, 주의할 점도 많아요. 다음은 꼭 지켜야 할 팁입니다:

- robots.txt 및 사이트 정책 준수: 스크래핑 허용 여부와 제한 구역 확인

- 요청 속도 조절: 초당 수백 건의 요청은 금물, 지연 및 무작위화로 사람처럼 행동()

- User-Agent/IP 회전: 대규모 스크래핑 시 헤더와 IP를 주기적으로 변경해 차단 방지

- 에러 처리: 예외 발생 시 재시도 및 에러 로그 기록

- 데이터 검증: 누락/이상 필드 체크로 사이트 구조 변경 조기 감지

- 코드 구조화: 데이터 수집, 파싱, 저장 로직 분리 및 설정 파일 활용

무엇보다도, 윤리적으로 스크래핑하세요. 웹은 모두의 자산이고, 무례한 봇은 환영받지 못합니다.

Thunderbit vs. 직접 구축: 언제 도구를 쓰고, 언제 직접 만들까?

이제 직접 Node.js로 스크래퍼를 만들지, 같은 도구를 쓸지 고민해볼 차례입니다.

직접 Node.js 스크래퍼 구축:

- 장점: 완전한 제어, 맞춤화, 다양한 워크플로우와 연동 가능

- 단점: 코딩 역량 필요, 구축/유지보수 시간 소요, 사이트 구조 변경 시 직접 수정 필요

Thunderbit AI 웹 스크래퍼:

- 장점: 코딩 필요 없이 AI가 필드 자동 인식, 하위 페이지/페이지네이션 자동 처리, 엑셀/구글시트/Notion 등 즉시 내보내기(). 유지보수 걱정 없이 AI가 사이트 변경에 자동 대응

- 단점: 매우 복잡하거나 특수한 워크플로우에는 제한(하지만 대부분의 비즈니스에는 충분)

간단 비교표:

| 항목 | 직접 Node.js 스크래퍼 | Thunderbit AI 웹 스크래퍼 |

|---|---|---|

| 기술 역량 | 코딩 필요 | 코딩 불필요, 클릭만으로 사용 |

| 구축 시간 | 수 시간~수일 | 수 분(필드 자동 추천) |

| 유지보수 | 지속적 필요(사이트 변경 시) | 최소(자동 AI 대응) |

| 동적 콘텐츠 | Puppeteer 직접 설정 | 내장 처리 |

| 페이지네이션/하위페이지 | 직접 코딩 | 1클릭 지원 |

| 데이터 내보내기 | 직접 코드 작성 | 엑셀, 시트, Notion 1클릭 |

| 비용 | 무료(개발 시간, 프록시 등) | 무료 플랜, 사용량 기반 결제 |

| 추천 대상 | 개발자, 맞춤 로직 | 비즈니스 사용자, 빠른 결과 |

Thunderbit는 영업, 마케팅, 운영팀이 빠르게 데이터를 확보해야 할 때 최고의 선택입니다. 개발자에게도 반복적인 스크래핑 작업이나 프로토타입 제작에 유용해요.

마무리 & 핵심 요약: Node 웹 스크래핑, 지금 시작하세요

node 웹 스크래핑은 웹의 숨겨진 데이터를 내 것으로 만드는 강력한 무기입니다. 리드 리스트 구축, 가격 모니터링, 새로운 아이디어 실현까지 모두 가능하죠. 꼭 기억해야 할 점은:

- Node.js + Cheerio/Axios는 정적 사이트에, Puppeteer는 동적/자바스크립트 기반 사이트에 적합합니다.

- 비즈니스 효과: 웹 스크래핑을 활용한 기업들은 부터 해외 매출 2배 성장까지 실질적인 성과를 내고 있습니다.

- 단순하게 시작: 기본 스크래퍼부터 만들고, 페이지네이션, 로그인 자동화, 데이터 정제 등 기능을 점차 추가하세요.

- 상황에 맞는 도구 선택: 빠른 결과와 무코드 스크래핑에는 이, 맞춤형 통합 워크플로우에는 직접 Node.js 스크립트가 적합합니다.

- 윤리적 스크래핑: 사이트 정책을 준수하고, 요청 속도 조절, 코드 유지보수에 신경 쓰세요.

지금 바로 Node.js 스크래퍼를 만들어보거나, 를 다운로드해 웹 데이터 추출이 얼마나 쉬운지 직접 경험해보세요. 더 많은 팁과 심화 가이드는 에서 확인할 수 있습니다.

즐거운 스크래핑 하시고, 항상 신선하고 구조화된 데이터로 한발 앞서가시길 바랍니다.

자주 묻는 질문(FAQ)

1. node 웹 스크래핑이란 무엇이며, Node.js가 좋은 선택인 이유는?

node 웹 스크래핑은 Node.js를 활용해 웹사이트에서 데이터를 자동으로 추출하는 과정입니다. Node.js는 비동기 요청 처리에 강하고, Puppeteer 같은 도구 덕분에 자바스크립트 기반 사이트도 쉽게 스크래핑할 수 있어요.

2. Cheerio/Axios와 Puppeteer는 언제 각각 사용해야 하나요?

Cheerio와 Axios는 데이터가 HTML에 바로 있는 정적 사이트에 적합합니다. Puppeteer는 자바스크립트로 로딩되는 콘텐츠, 로그인 등 상호작용이 필요한 경우, 무한 스크롤 등에서 사용하세요.

3. node 웹 스크래핑의 대표적인 비즈니스 활용 사례는?

리드 발굴, 경쟁사 가격 모니터링, 콘텐츠 집계, 시장 트렌드 분석, 상품 카탈로그 추출 등이 대표적입니다. Node.js로 빠르고 확장성 있게 처리할 수 있습니다.

4. node 웹 스크래핑에서 흔히 겪는 문제와 해결법은?

차단(anti-bot), 사이트 구조 변경, 데이터 품질 관리 등이 대표적입니다. 요청 속도 조절, User-Agent/IP 회전, 데이터 검증, 코드 구조화로 예방할 수 있습니다.

5. Thunderbit와 직접 Node.js 스크래퍼 구축, 무엇이 다른가요?

Thunderbit는 코딩 없이 AI가 필드 인식, 하위 페이지, 페이지네이션을 자동 처리합니다. 빠른 결과가 필요한 비즈니스 사용자에게 적합하며, 직접 구축은 맞춤화나 시스템 통합이 필요한 개발자에게 추천합니다.

더 많은 가이드와 인사이트는 와 에서 확인하세요.

더 알아보기