2025년, 웹 데이터는 이제 ‘있으면 좋은’ 수준이 아니라 비즈니스 전략의 핵심 자원이 됐어요. 이커머스 대기업이 경쟁사 가격을 실시간으로 추적하거나, 영업팀이 새로운 리드를 자동으로 모으는 등, 기업들은 공개 웹 데이터를 디지털 오일처럼 소중하게 다루고 있죠. 실제로 하고 있고, 하고 있습니다. 파이썬이 많이 언급되지만, 으로 자리 잡고 있어요. 특히 신뢰성과 시스템 연동이 중요한 엔터프라이즈 환경에서는 자바가 더욱 빛을 발합니다.

SaaS와 자동화 분야에서 오랜 시간 일하면서, 자바 웹 스크래핑이 비즈니스 운영을 어떻게 혁신하는지 직접 경험해왔어요. 하지만 많은 팀이 저수준 코드에 발목 잡히거나, 동적 웹사이트와 봇 차단에 막혀 어려움을 겪는 것도 자주 봤죠. 그래서 2025년 자바 웹 스크래핑을 제대로 익힐 수 있도록, 실전 위주의 단계별 가이드를 준비했습니다. 특히 같은 최신 AI 기반 도구와 연동하는 방법도 다루니, 개발자든 운영 담당자든, 혹은 복잡한 과정 없이 데이터만 얻고 싶은 비즈니스 사용자든 모두에게 도움이 될 거예요.

SaaS와 자동화 분야에서 오랜 시간 일하면서, 자바 웹 스크래핑이 비즈니스 운영을 어떻게 혁신하는지 직접 경험해왔어요. 하지만 많은 팀이 저수준 코드에 발목 잡히거나, 동적 웹사이트와 봇 차단에 막혀 어려움을 겪는 것도 자주 봤죠. 그래서 2025년 자바 웹 스크래핑을 제대로 익힐 수 있도록, 실전 위주의 단계별 가이드를 준비했습니다. 특히 같은 최신 AI 기반 도구와 연동하는 방법도 다루니, 개발자든 운영 담당자든, 혹은 복잡한 과정 없이 데이터만 얻고 싶은 비즈니스 사용자든 모두에게 도움이 될 거예요.

자바 웹 스크래핑이란? 쉽게 풀어보는 설명

어려운 용어는 잠시 접어두고, 자바 웹 스크래핑은 자바 코드를 이용해 웹사이트에서 원하는 정보를 자동으로 뽑아내는 과정이에요. 마치 수천 개의 웹페이지를 읽고 필요한 데이터를 엑셀에 정리해주는 초고속 가상 인턴을 고용한 느낌이죠. 이 인턴은 지치지도 않고, 오타도 내지 않으며, 인터넷 속도만큼 빠르게 일합니다.

쉽게 말해 이런 흐름이에요:

- 웹사이트에 요청을 보냄 (브라우저로 페이지 여는 것과 비슷)

- HTML 콘텐츠 다운로드 (페이지를 구성하는 원시 코드)

- HTML 파싱해서 프로그램이 이해할 수 있는 구조로 만듦

- 필요한 데이터만 추출 (예: 상품명, 가격, 이메일 등)

- 결과 저장 (CSV, 엑셀, 데이터베이스, Google Sheets 등)

복잡한 개발 지식이 없어도, 적당한 도구와 약간의 안내만 있으면 비즈니스 사용자도 웹 데이터를 쉽게 모으고, 복잡한 웹페이지를 인사이트로 바꿀 수 있습니다.

2025년 비즈니스에서 자바 웹 스크래핑이 중요한 이유

웹 스크래핑은 이제 개발자만의 취미가 아니라, 비즈니스 필수 전략이에요. 기업들이 자바 웹 스크래핑을 어떻게 활용해 경쟁력을 높이고, 실질적인 ROI를 얻는지 살펴볼게요.

| 웹 스크래핑 활용 사례 | 비즈니스 효과 (ROI) | 적용 산업 |

|---|---|---|

| 경쟁사 가격 모니터링 | 실시간 가격 정보 확보, 시장 변화에 빠르게 대응해 20% 이상 매출 증가 | 이커머스, 소매업 |

| 리드 생성 및 영업 인텔리전스 | 자동화된 최신 잠재고객 리스트, 70% 수작업 시간 절감 | B2B 영업, 마케팅, 채용 |

| 시장 조사 및 트렌드 분석 | 트렌드 조기 포착, 5–15% 매출 상승 및 10–20% 마케팅 ROI 향상 | 소비재, 마케팅 에이전시 |

| 금융 및 투자 데이터 | 대체 데이터로 투자 전략 강화, 웹 스크래핑 '대체 데이터' 시장 50억 달러 이상 | 금융, 헤지펀드, 핀테크 |

| 업무 자동화 및 모니터링 | 반복 데이터 수집 자동화, 73% 비용 절감 및 85% 빠른 배포 | 부동산, 공급망, 공공기관 |

()

자바가 선택받는 이유는 확장성, 안정성, 그리고 시스템 연동에 최적화되어 있기 때문이에요. 이미 많은 엔터프라이즈 데이터 파이프라인이 자바로 구축되어 있어서, 웹 스크래퍼를 자연스럽게 붙일 수 있죠. 또 자바의 멀티스레딩과 예외 처리 기능은 대량의 페이지를 빠르고 안정적으로 처리하는 데 강점이 있습니다.

자바 웹 스크래핑의 작동 원리와 차별점

일반적인 자바 웹 스크래퍼의 핵심 구조는 이렇습니다:

- HTTP 요청: JSoup, Apache HttpClient 같은 라이브러리로 웹페이지를 가져옵니다. 헤더 설정, 프록시 사용, 브라우저 흉내내기도 가능해요.

- HTML 파싱: JSoup 등으로 HTML을 ‘DOM’ 구조로 바꿔서, CSS 선택자로 원하는 데이터를 쉽게 찾을 수 있습니다.

- 데이터 추출: 예를 들어

<span class='price'>요소를 모두 가져오는 식으로 규칙을 정해 데이터를 뽑아냅니다. - 데이터 저장: 결과를 CSV, 엑셀, JSON, 데이터베이스 등 원하는 형식으로 저장합니다.

자바가 웹 스크래핑에 강한 이유

- 멀티스레딩: 자바는 여러 페이지를 동시에 처리해 대규모 크롤링 속도를 크게 높일 수 있어요. 파이썬의 GIL이 병목이 되는 상황에서도 자바는 진짜 병렬 처리가 가능합니다.

- 성능: 컴파일 언어인 자바는 대용량 작업과 메모리 집약적 작업에 강합니다.

- 엔터프라이즈 연동: 자바 스크래퍼는 기존 CRM, ERP, 데이터베이스 등과 손쉽게 통합됩니다.

- 에러 처리: 엄격한 타입과 예외 처리로, 장기적으로 유지보수하기 좋은 견고한 스크래퍼를 만들 수 있습니다.

미션 크리티컬한 데이터 파이프라인을 운영한다면, 자바의 안정성과 확장성은 최고의 선택이에요.

필수 자바 웹 스크래핑 라이브러리와 프레임워크: 선택 가이드

자바용 웹 스크래핑 라이브러리는 다양하지만, 비즈니스 현장에서 가장 많이 쓰이는 세 가지는 JSoup, HtmlUnit, Selenium입니다. 각각의 특징을 비교해볼게요.

| 라이브러리 | 자바스크립트 처리 | 사용 편의성 | 성능 | 추천 용도 |

|---|---|---|---|---|

| JSoup | ❌ (JS 미지원) | 매우 쉬움 | 높음 | 정적 페이지, 간단 작업, 가벼운 크롤링 |

| HtmlUnit | ⚠️ 일부 지원 | 보통 | 중간 | 간단한 JS, 폼 제출, 헤드리스 스크래핑 |

| Selenium | ✅ 완전 지원 | 보통/어려움 | 페이지당 낮음 | JS 많은 사이트, 동적/인터랙티브 페이지 |

()

JSoup: 간단한 HTML 파싱에 최적

은 대부분의 스크래핑 작업에서 가장 먼저 찾게 되는 도구입니다. 가볍고 사용법이 쉬워서, 데이터가 HTML에 바로 노출된 정적 페이지에 딱 맞아요.

예시:

1Document doc = Jsoup.connect("https://www.scrapingcourse.com/ecommerce/").get();

2String bannerTitle = doc.select("div.site-title").text();

3System.out.println("Banner: " + bannerTitle);이렇게 간단합니다. 블로그, 상품 리스트, 디렉터리 등 JS가 필요 없는 사이트라면 JSoup이 최고예요.

HtmlUnit: 복잡한 작업을 위한 브라우저 시뮬레이션

은 자바로 구현된 헤드리스 브라우저입니다. 일부 자바스크립트 실행, 폼 입력, 버튼 클릭 등도 지원해요.

사용 시점: 로그인이나 간단한 동적 콘텐츠가 필요한 경우, Selenium의 무거움을 피하고 싶을 때 적합합니다.

예시:

1WebClient webClient = new WebClient();

2HtmlPage page = webClient.getPage("https://example.com/login");

3// ... 폼 입력 및 제출 ...Selenium: JS가 많은 동적/인터랙티브 페이지 처리

은 실제 브라우저(Chrome, Firefox 등)를 제어해, 사람이 할 수 있는 모든 작업을 자동화할 수 있습니다. JS로만 구성된 사이트도 문제없죠.

사용 시점: 최신 웹앱, 무한 스크롤, 클릭·대기 등 사용자 행동이 필요한 사이트에 적합합니다.

예시:

1WebDriver driver = new ChromeDriver();

2driver.get("https://www.scrapingcourse.com/ecommerce/");

3List<WebElement> products = driver.findElements(By.cssSelector("li.product"));

4// ... 데이터 추출 ...

5driver.quit();Thunderbit로 자바 웹 스크래핑 업그레이드: 비주얼 자동화와 코드의 만남

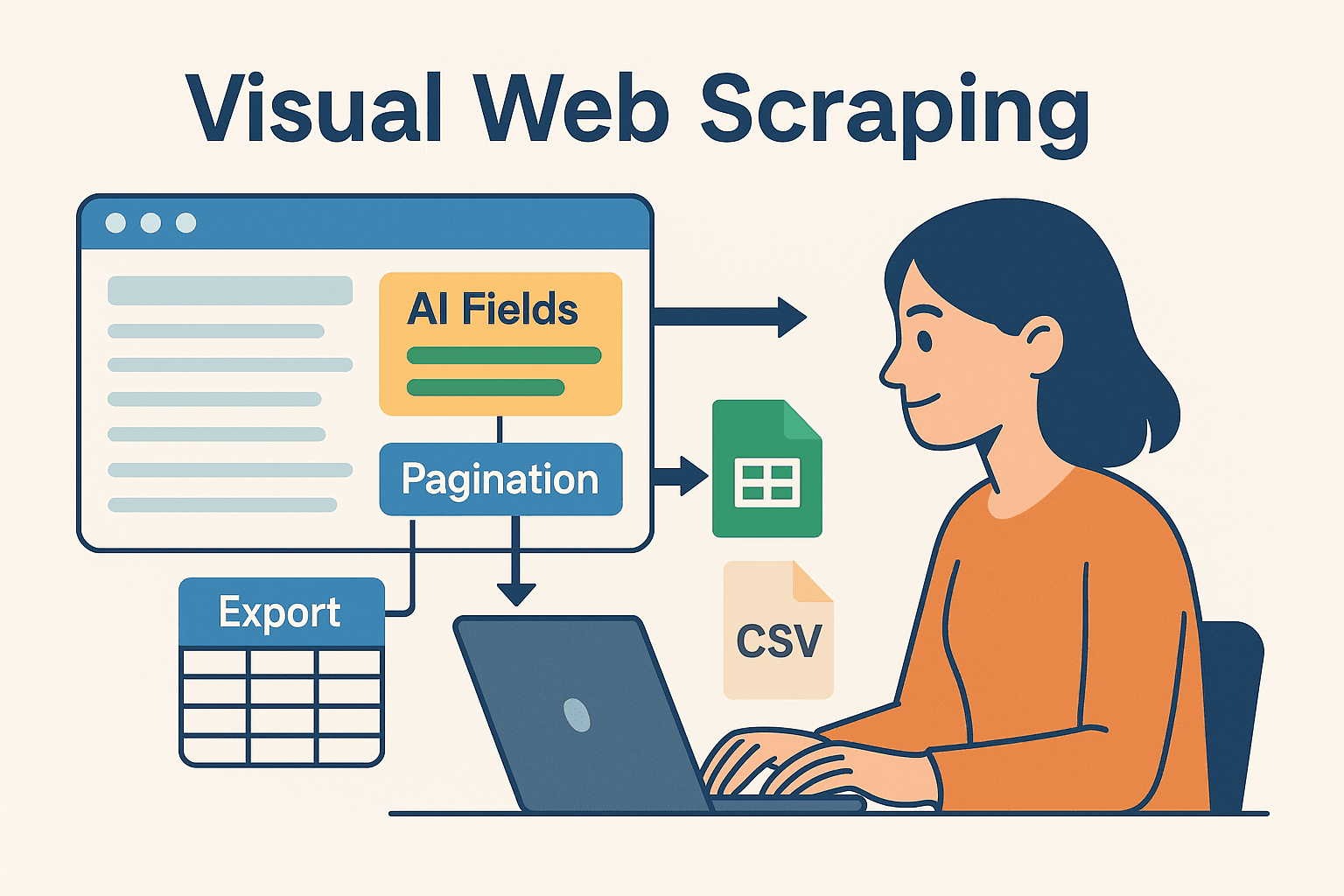

이제 정말 흥미로운 부분이에요. 코딩이 익숙하지 않거나, 반복 작업을 줄이고 싶은 팀에게 는 AI 기반의 노코드 웹 스크래퍼로, 브라우저에서 시각적으로 스크래핑 작업을 정의하고 데이터를 엑셀, Google Sheets, Airtable, Notion 등으로 바로 내보낼 수 있습니다.

자바와 Thunderbit를 함께 쓰는 이유

- AI 추천 필드: Thunderbit의 ‘AI 필드 추천’ 기능이 페이지를 읽고 추출할 데이터를 자동 제안해줘요. HTML 구조나 셀렉터를 몰라도 됩니다.

- 서브페이지 스크래핑: 상세 정보가 필요하다면, Thunderbit가 각 서브페이지(예: 상품 상세)까지 자동 방문해 데이터를 풍부하게 만듭니다.

- 즉시 사용 가능한 템플릿: Amazon, Zillow, LinkedIn 등 인기 사이트는 원클릭 템플릿으로 바로 시작할 수 있습니다.

- 간편한 내보내기: 추출한 데이터를 몇 초 만에 내보내고, 자바 코드에서 바로 활용할 수 있습니다.

Thunderbit는 프로토타이핑, 복잡한 사이트 처리, 비개발자 데이터 수집에 큰 시간을 절약해줍니다. 개발자에게도 반복적이고 불안정한 부분을 Thunderbit에 맡기고, 핵심 로직에 집중할 수 있는 좋은 방법이에요.

Thunderbit와 자바를 결합한 복합 워크플로우

제가 자주 쓰는 워크플로우는 이렇습니다:

- Thunderbit로 프로토타입: 크롬 확장 프로그램으로 시각적으로 스크래핑을 설정하고, AI로 필드 추천·페이지네이션 처리, Google Sheets나 CSV로 내보냅니다.

- 자바로 후처리: 내보낸 데이터를 자바 코드로 읽어와 추가 가공, 분석, 엔터프라이즈 시스템 연동을 진행합니다.

- 자동화 및 스케줄링: Thunderbit의 내장 스케줄러로 최신 데이터를 유지하고, 자바 파이프라인이 자동으로 최신 데이터를 가져오게 합니다.

이런 하이브리드 방식은 AI 기반 노코드 스크래핑의 속도와 유연성, 그리고 자바의 강력한 후처리 능력을 모두 누릴 수 있습니다.

이런 하이브리드 방식은 AI 기반 노코드 스크래핑의 속도와 유연성, 그리고 자바의 강력한 후처리 능력을 모두 누릴 수 있습니다.

실전 가이드: 자바 웹 스크래퍼 처음 만들기

직접 따라해봅시다. 자바로 간단한 웹 스크래퍼를 만드는 방법이에요.

자바 환경 세팅

- Java(JDK) 설치: Java 17 또는 21 버전 추천.

- Maven 세팅: 의존성 관리를 위해 사용합니다.

- IDE 선택: IntelliJ IDEA, Eclipse, VSCode 모두 사용 가능.

pom.xml에 JSoup 추가:1<dependency> 2 <groupId>org.jsoup</groupId> 3 <artifactId>jsoup</artifactId> 4 <version>1.16.1</version> 5</dependency>

스크래퍼 작성 및 실행

데모 이커머스 사이트에서 상품명과 가격을 추출해볼게요.

1import org.jsoup.Jsoup;

2import org.jsoup.nodes.Document;

3import org.jsoup.select.Elements;

4import org.jsoup.nodes.Element;

5public class ProductScraper {

6 public static void main(String[] args) {

7 String url = "https://www.scrapingcourse.com/ecommerce/";

8 try {

9 Document doc = Jsoup.connect(url)

10 .userAgent("Mozilla/5.0")

11 .get();

12 Elements productElements = doc.select("li.product");

13 for (Element productEl : productElements) {

14 String name = productEl.selectFirst("h2").text();

15 String price = productEl.selectFirst("span.price").text();

16 System.out.println(name + " -> " + price);

17 }

18 } catch (Exception e) {

19 e.printStackTrace();

20 }

21 }

22}팁: 사이트에 따라 User-Agent를 꼭 지정하세요. 기본 자바 User-Agent는 차단될 수 있습니다.

데이터 내보내기 및 활용

- CSV 내보내기:

FileWriter나 OpenCSV 라이브러리로 CSV 파일 저장. - 엑셀 내보내기: Apache POI로 .xls/.xlsx 파일 생성.

- DB 연동: JDBC로 데이터베이스에 직접 저장.

- Google Sheets: Thunderbit에서 내보낸 데이터를 자바 Google Sheets API로 읽기.

자바 웹 스크래핑에서 자주 만나는 문제와 해결법

웹 스크래핑이 항상 순탄한 건 아니에요. 대표적인 문제와 해결책은 다음과 같습니다:

- IP 차단 & 속도 제한: 요청 속도를 늦추고(

Thread.sleep()), 프록시를 돌리며, 지연시간을 무작위로 설정하세요. 대량 작업은 프록시 서비스 활용. - CAPTCHA & 봇 감지: Selenium으로 실제 사용자처럼 행동하거나, 외부 안티봇 API를 이용하세요. Thunderbit의 클라우드 스크래핑도 우회에 효과적입니다.

- 동적 콘텐츠: JSoup 결과가 비어 있다면, 데이터가 JS로 로드되는 경우입니다. Selenium, HtmlUnit으로 전환하거나, 사이트의 API를 찾아보세요.

- 웹사이트 구조 변경: 유연한 셀렉터로 코드를 작성하고, 스크래퍼를 모니터링해 변경 시 신속히 대응하세요. Thunderbit의 AI는 레이아웃 변화에도 빠르게 적응합니다(필드 추천 재실행).

- 세션 관리: 로그인 후 스크래핑은 쿠키와 세션을 신중히 다뤄야 합니다. Selenium, Thunderbit(Chrome 로그인 시)는 인증 페이지도 처리 가능합니다.

자바 웹 스크래핑 효율을 높이는 고급 팁

한 단계 더 성장하고 싶다면, 다음을 시도해보세요:

- 멀티스레딩: Java의

ExecutorService로 여러 페이지를 병렬로 스크래핑하세요. 단, 과도한 요청은 차단 위험이 있습니다! - 스케줄링: Java의 Quartz Scheduler 또는 Thunderbit의 클라우드 스케줄러(자연어로 '매주 월요일 9시' 등) 활용.

- 클라우드 확장: 대규모 작업은 클라우드에서 헤드리스 브라우저를 돌리거나, 여러 서버에 분산하세요.

- 하이브리드 워크플로우: 유지보수 어려운 사이트는 Thunderbit, 나머지는 자바 코드로 처리해 결과를 데이터 웨어하우스에 통합하세요.

- 모니터링 & 로깅: Java의 로깅 프레임워크로 스크래퍼 상태를 추적하고, 오류 발생 시 알림을 받으세요.

결론 및 핵심 요약

웹 데이터는 이제 비즈니스의 새로운 금광이고, 자바는 여전히 신뢰성과 확장성, 시스템 연동이 필요한 팀에게 최고의 도구입니다. 기본 워크플로우는 단순해요: 요청, 파싱, 추출, 출력. JSoup, HtmlUnit, Selenium 등 라이브러리로 정적 디렉터리부터 복잡한 JS 사이트까지 모두 처리할 수 있습니다.

하지만 모든 과정을 직접 코딩할 필요는 없어요. 같은 도구는 AI와 시각적 자동화를 결합해, 빠른 프로토타입과 유지보수, 확장까지 지원합니다. 제 조언은? 코드와 노코드를 적절히 섞으세요. Thunderbit로 빠르게 세팅·유지보수하고, 자바 파이프라인으로 본격적인 데이터 처리를 맡기면 됩니다.

Thunderbit가 어떻게 워크플로우를 혁신하는지 궁금하다면, 해 몇 분 만에 첫 사이트를 스크래핑해보세요. 더 깊이 있는 정보와 튜토리얼, 최신 자동화 트렌드는 에서 확인할 수 있습니다.

여러분의 데이터가 언제나 구조화되고, 신선하며, 바로 활용 가능하길 바랍니다.

자주 묻는 질문(FAQ)

1. 2025년에도 자바는 웹 스크래핑에 유효한가요?

그럼요! 파이썬이 빠른 스크립트에 적합하다면, 자바는 엔터프라이즈급 대규모·장기 스크래핑, 통합·멀티스레딩이 중요한 환경에서 여전히 최적의 선택입니다.

2. JSoup, HtmlUnit, Selenium은 언제 써야 하나요?

정적 페이지는 JSoup, 간단한 동적 콘텐츠나 폼 제출은 HtmlUnit, JS가 많은 동적/인터랙티브 사이트는 Selenium을 추천합니다. 사이트 복잡도에 따라 도구를 선택하세요.

3. 스크래핑 시 차단을 피하려면?

요청 속도 조절, 프록시 회전, 현실적인 User-Agent 설정, 사람처럼 행동하기 등이 필요합니다. 난이도 높은 사이트는 Thunderbit의 클라우드 스크래핑이나 안티봇 API도 고려해보세요.

4. Thunderbit와 자바를 함께 쓸 수 있나요?

네, Thunderbit로 시각적으로 스크래핑 작업을 정의·스케줄링하고, 데이터를 내보낸 뒤 자바 코드로 가공·통합할 수 있습니다. 비즈니스 사용자와 개발자 모두에게 강력한 조합입니다.

5. 자바 웹 스크래핑을 가장 빠르게 시작하는 방법은?

Java와 Maven을 세팅하고, JSoup을 추가해 간단한 사이트부터 시도해보세요. 더 복잡한 작업이나 빠른 프로토타입이 필요하다면 로 AI의 도움을 받아보고, 결과를 자바 워크플로우에 연동하세요.

더 많은 팁, 코드 샘플, 자동화 노하우가 궁금하다면 나 에서 실전 튜토리얼과 최신 웹 스크래핑 기술을 확인하세요. 더 알아보기