요즘 웹에는 정말 어마어마한 양의 데이터가 쏟아지고 있죠. 영업이든 운영이든, 어떤 비즈니스 분야에 있든 간에 이 복잡한 데이터를 실제로 쓸 수 있는 인사이트로 바꿔야 한다는 부담, 한 번쯤은 느껴봤을 거예요. 실제로 많은 팀들이 리드 발굴, 가격 모니터링, 시장 조사 등 다양한 목적으로 데이터 수집 자동화에 열을 올리고 있습니다. 솔직히, 누가 하루 종일 웹사이트에서 복사하고 붙여넣기만 하고 싶겠어요? 그래서 웹 스크래핑이 필요하고, 그 중심에 Python이 자리 잡고 있습니다.

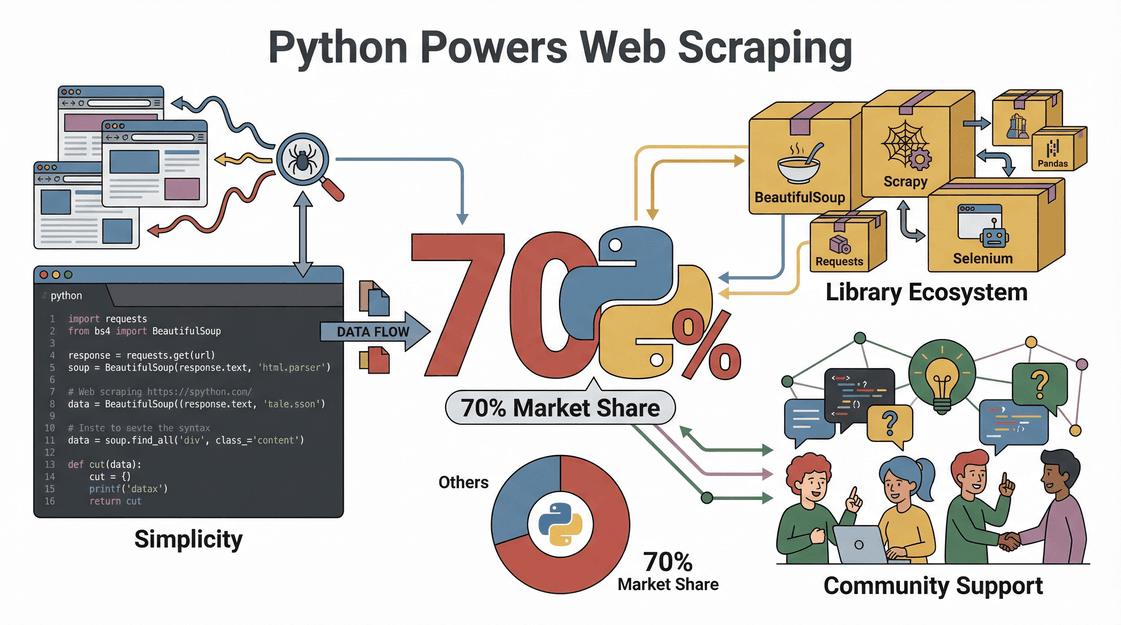

Python이 웹 스크래핑에서 인기 있는 건 단순히 유행 때문이 아닙니다. 가 Python으로 진행된다는 통계가 있을 정도로, 쉽고 강력한 라이브러리와 활발한 커뮤니티 덕분이죠. 이 글에서는 Python 환경 세팅부터 첫 스크립트 작성까지 단계별로 웹 스크래핑 방법을 안내하고, 코딩보다 클릭이 편한 분들을 위해 로 더 쉽게 데이터 수집하는 방법도 소개할게요.

웹 스크래핑이란? 그리고 왜 Python을 쓸까?

먼저 기본부터 짚고 넘어가죠. 웹 스크래핑은 웹사이트에서 원하는 정보를 자동으로 뽑아내는 과정이에요. 마치 디지털 비서가 웹페이지에서 필요한 내용을 복사해서 엑셀에 붙여넣는 것과 비슷하지만, 훨씬 빠르고 커피 한 잔 마실 시간도 필요 없죠. 기업들은 다양한 목적으로 웹 스크래핑을 활용하고 있습니다.

그렇다면 왜 하필 Python일까요?

- 쉬운 문법: Python은 코드가 간단하고 읽기 쉬워서 개발자가 아니어도 금방 배울 수 있어요.

- 풍부한 라이브러리: Requests, BeautifulSoup, Selenium, Scrapy 등 다양한 라이브러리로 단순 HTML 파싱부터 복잡한 자바스크립트 사이트까지 모두 커버할 수 있습니다.

- 활발한 커뮤니티: 막히는 부분이 생기면 Stack Overflow나 GitHub에서 이미 누군가 해결책을 공유했을 확률이 높아요.

- 빠른 개발과 유연성: Python 스크립트는 새로운 사이트나 데이터 구조에 맞게 빠르게 수정할 수 있고, 소규모 작업부터 대규모 프로젝트까지 확장성이 뛰어납니다.

즉, Python은 웹 스크래핑 분야에서 만능툴 같은 존재입니다. 강력하면서도 초보자에게도 친근하죠.

비즈니스 관점: Python 웹 스크래핑이 주는 효과

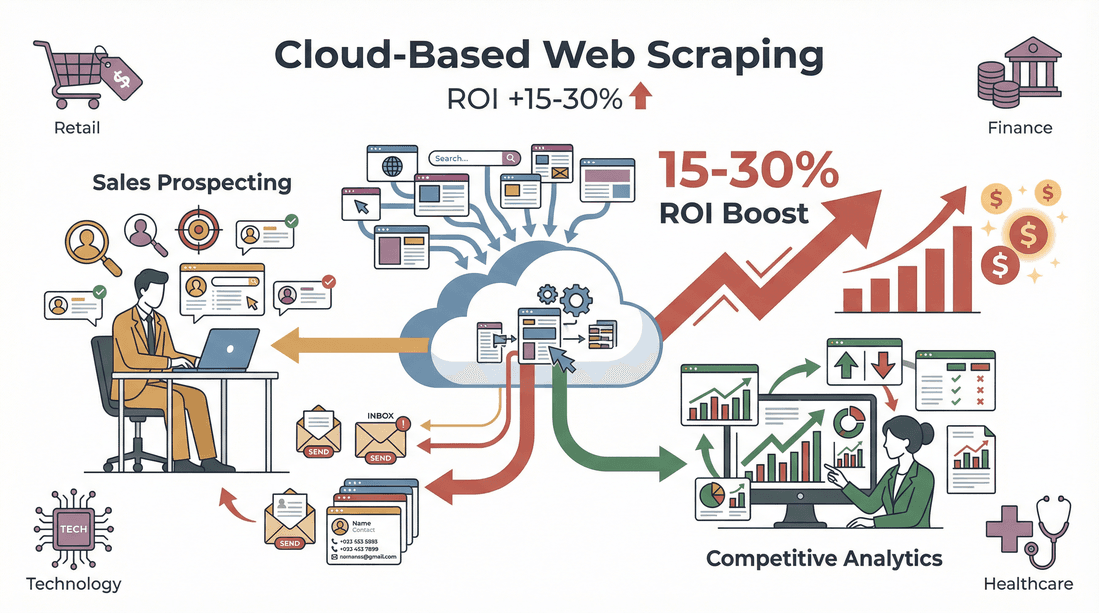

웹 스크래핑은 단순한 기술이 아니라, 비즈니스 성장의 핵심 동력입니다. 실제로 많은 기업들이 Python 기반 스크래핑으로 경쟁력을 높이고 있어요.

| 활용 사례 | Python의 역할 | 비즈니스 효과 |

|---|---|---|

| 리드 발굴 | 디렉터리, LinkedIn 등에서 연락처 정보 추출 | CRM에 신선하고 타겟팅된 리드 자동 등록 |

| 가격 모니터링 | 이커머스 사이트에서 경쟁사 가격 추적 | 실시간 가격 전략 수립 및 경쟁력 유지 |

| 시장 조사 | 리뷰, 기사, 소셜 언급 등 데이터 집계 | 트렌드 파악 및 데이터 기반 의사결정 |

| 부동산 데이터 수집 | 여러 사이트에서 매물 정보 스크래핑 | 통합된 최신 시장 데이터베이스 구축 |

| 상품 카탈로그 관리 | 공급사로부터 스펙 및 재고 데이터 자동 수집 | 재고 업데이트 자동화 및 수작업 오류 감소 |

투자 대비 효과(ROI)도 확실합니다. 한 에 따르면 리드 스크래핑 자동화로 주당 8시간을 절약했고, 까지 높였다고 해요.

Python 웹 스크래핑 환경 준비하기

스크래핑을 시작하기 전에 Python 환경부터 세팅해야겠죠? 코딩이 처음이어도 아래 순서대로 따라오면 어렵지 않아요.

1. Python 설치

- Python 다운로드: 에서 최신 버전(3.10 이상 추천)을 받아주세요.

- PATH 추가: Windows에서는 설치할 때 “Add Python to PATH” 옵션을 꼭 체크하세요. 커맨드라인에서 Python을 바로 실행할 수 있습니다. ()

2. 가상환경(Virtual Environment) 만들기

가상환경을 쓰면 프로젝트별로 라이브러리를 따로 관리할 수 있어 충돌을 막을 수 있어요.

1# Windows

2python -m venv venv

3venv\Scripts\activate

4# Mac/Linux

5python3 -m venv venv

6source venv/bin/activate3. 코드 에디터 선택

- VS Code: 가볍고 확장성 좋은 무료 에디터

- PyCharm: 대형 프로젝트에 적합, 똑똑한 코드 추천 기능

- Jupyter Notebook: 데이터 실험과 시각화에 딱 좋아요

4. 자주 발생하는 문제 해결법

- Python 명령어가 안 먹히면 PATH 설정을 다시 확인하세요.

- 권한 오류가 뜨면 터미널을 관리자 권한으로 실행해보세요.

- Mac 사용자는 Xcode Command Line Tools 설치가 필요할 수 있습니다 (

xcode-select --install).

Python 웹 스크래핑에 딱 맞는 라이브러리 고르기

Python의 진짜 강점은 다양한 라이브러리에 있습니다. 대표적인 라이브러리와 활용 상황을 정리해볼게요.

| 라이브러리 | 적합한 용도 | 난이도 | 속도 | 자바스크립트 지원 | 확장성 |

|---|---|---|---|---|---|

| Requests | 웹페이지(HTTP) 요청 | 쉬움 | 빠름 | X | 좋음 |

| BeautifulSoup | HTML/XML 파싱 | 매우 쉬움 | 중간 | X | 좋음 |

| lxml | 대용량 XML/HTML 빠른 파싱 | 중간 | 매우 빠름 | X | 좋음 |

| Selenium | 동적(자바스크립트) 사이트 조작 | 중간 | 느림 | O (브라우저 사용) | 보통 |

| Scrapy | 대규모 자동화 스크래핑 | 중간 | 매우 빠름 | 부분 지원/지원 | 탁월 |

- Requests: 간단한 HTTP 요청에 딱입니다.

- BeautifulSoup: 초보자도 쉽게 쓸 수 있는 HTML 파싱 라이브러리예요.

- lxml: 대용량 문서 처리에 아주 빠르지만, 초보자에겐 조금 까다로울 수 있어요.

- Selenium: 실제 브라우저를 띄워 자바스크립트 기반 사이트도 스크래핑할 수 있습니다.

- Scrapy: 대규모, 자동화된 스크래핑에 특화된 프레임워크입니다.

대부분의 초보자에게는 Requests + BeautifulSoup 조합이 가장 무난해요. ()

실전 예제: Python으로 웹 스크래핑하는 방법

가상의 이커머스 사이트에서 상품 데이터를 수집하는 과정을 예로 들어볼게요.

1. 웹사이트 구조 파악하기

브라우저의 개발자 도구(F12 또는 우클릭 > 검사)를 열고, 원하는 데이터(상품명, 가격, 평점 등)가 들어있는 HTML 요소를 확인하세요. 이 과정이 정말 중요합니다. ()

2. HTTP 요청 보내기

Requests로 페이지를 불러옵니다.

1import requests

2url = "https://example.com/products"

3response = requests.get(url)

4html = response.text3. BeautifulSoup으로 HTML 파싱

필요한 데이터를 추출합니다.

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3products = soup.find_all("div", class_="product-card")4. 데이터 추출 및 정제

각 상품별로 세부 정보를 가져옵니다.

1data = []

2for product in products:

3 title = product.find("h2", class_="title").text.strip()

4 price = product.find("span", class_="price").text.strip()

5 rating = product.find("span", class_="rating").text.strip()

6 # 가격에서 $ 기호 제거

7 price_num = float(price.replace("$", ""))

8 data.append({"title": title, "price": price_num, "rating": rating})5. CSV/Excel로 데이터 내보내기

Pandas를 활용해 결과를 저장합니다.

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4df.to_excel("products.xlsx", index=False)()

이렇게 하면 분석이나 CRM 업로드에 바로 쓸 수 있는 깔끔한 데이터가 완성됩니다.

동적 콘텐츠와 페이지네이션 처리하기

모든 웹사이트가 쉽게 스크래핑되는 건 아니에요. 어떤 곳은 자바스크립트로 데이터를 불러오거나, 여러 페이지에 결과를 나눠서 보여주기도 하죠. 이런 경우엔 이렇게 대응할 수 있습니다.

동적 콘텐츠 스크래핑

결과가 비어 있거나 데이터가 누락된다면, 사이트가 동적으로 데이터를 불러오는 것일 수 있어요. 이럴 땐 Selenium을 사용하세요.

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/products")

4html = driver.page_source

5# 이후 BeautifulSoup으로 파싱()

페이지네이션 처리

여러 페이지를 스크래핑하려면 페이지 번호나 “다음” 버튼을 반복해서 요청하면 됩니다.

1for page in range(1, 6):

2 url = f"https://example.com/products?page={page}"

3 response = requests.get(url)

4 # 앞서와 동일하게 파싱 및 추출()

대규모 프로젝트라면 Scrapy로 수백 페이지를 자동으로 크롤링할 수 있어요. ()

추출한 데이터 내보내기 및 활용법

데이터를 수집했다면 이제 실질적으로 활용할 차례입니다.

- CSV/Excel로 내보내기: 위에서처럼 Pandas로 손쉽게 저장할 수 있어요.

- 데이터 정제 및 표준화: 중복 제거, 오타 수정, 포맷 통일 등 데이터 품질을 높이세요. ()

- 업무 자동화 연동: Salesforce, HubSpot 등 CRM이나 분석 툴에 CSV를 바로 업로드하거나, Python 스크립트로 자동화할 수 있습니다.

Thunderbit: 비즈니스 팀을 위한 Python 웹 스크래핑의 혁신

사실 Python은 강력하지만, 코딩에 익숙하지 않다면 데이터 추출까지 시간이 오래 걸릴 수 있어요. 그래서 저희는 이라는 을 만들었습니다. 비즈니스 사용자가 복잡한 설정 없이도 빠르게 결과를 얻을 수 있도록 설계된 도구예요.

Thunderbit가 영업 및 운영팀에 혁신을 가져다주는 이유는 다음과 같습니다.

- AI 필드 매핑: “AI 필드 추천”만 누르면 Thunderbit가 페이지를 분석해 이름, 가격, 이메일 등 주요 컬럼을 자동으로 추천하고 추출 설정까지 끝냅니다.

- 서브페이지 스크래핑: 상품 상세, LinkedIn 프로필 등 각 서브페이지를 자동 방문해 추가 정보를 표에 채워줍니다.

- 페이지네이션/동적 콘텐츠 지원: 여러 페이지, 무한 스크롤 등도 클릭 한 번이면 처리—코딩 필요 없음.

- 즉시 사용 가능한 템플릿: Amazon, Zillow, Shopify 등 인기 사이트는 템플릿만 선택하면 바로 스크래핑 시작.

- 무료 데이터 내보내기: Excel, Google Sheets, Airtable, Notion 등으로 바로 내보내기 지원.

- 유지보수 필요 없음: Thunderbit의 AI가 웹사이트 변경에도 자동으로 적응해, 스크립트가 깨질 걱정이 없습니다.

실제로 많은 사용자가 “데이터가 필요하지만 어디서부터 시작해야 할지 모르겠다”에서 “스프레드시트 완성!”까지 5분도 안 걸렸다는 후기를 남깁니다. 도 있으니 부담 없이 체험해보세요.

Thunderbit와 Python의 조합: 데이터 수집의 완전체

데이터 분석가나 파워 유저라면 Thunderbit와 Python을 함께 활용할 수 있습니다. 저 역시 다음과 같이 조합해서 사용합니다.

- Thunderbit로 데이터 추출: 복잡하거나 처음 접하는 사이트에서 구조화된 데이터를 빠르게 스크래핑해 CSV/Excel로 저장합니다.

- Python으로 후처리: 내보낸 데이터를 Pandas로 불러와 정제, 분석, 추가 자동화를 진행합니다.

- 업무 자동화: Thunderbit로 정기적으로 스크래핑하고, Python 스크립트로 데이터 처리 및 업로드까지 자동화합니다.

이런 하이브리드 방식은 빠른 실행력과 유연성을 모두 갖추게 해줍니다.

웹 스크래핑의 법적·윤리적 고려사항

많은 분들이 궁금해하는 부분이죠. 웹 스크래핑, 합법일까요? 결론부터 말하면 규칙만 지키면 합법입니다.

- robots.txt 및 이용약관 준수: 일부 사이트는 스크래핑을 금지하니, 시작 전 반드시 확인하세요. ()

- 개인정보·저작권 데이터 금지: 공개된 사실 정보만 수집하세요.

- 요청 속도 조절: 서버에 과부하를 주지 않도록 요청 간 딜레이를 두고, 속도 제한을 지키세요. ()

- 개인정보 보호법 준수: 이메일 등 개인정보를 수집할 땐 GDPR, CCPA 등 관련 법규를 반드시 확인하세요. ()

Thunderbit는 브라우저에서 보이는 정보만 추출하고, 사이트 제한을 쉽게 지킬 수 있도록 설계되어 있어 준법 사용에 도움이 됩니다.

Python 웹 스크래핑 문제 해결 및 모범 사례

아무리 잘 만든 웹 스크래퍼도 문제에 부딪힐 수 있습니다. 아래 체크리스트를 참고하세요.

- 요청 차단: User-Agent 변경, 프록시 사용, 요청 속도 조절로 우회 ().

- 파싱 오류: HTML 셀렉터가 맞는지 재확인—웹사이트 구조는 자주 바뀝니다.

- 데이터 누락: 동적 로딩 여부 확인(필요시 Selenium 활용).

- 캡차/로그인 벽: 일부 사이트는 봇을 적극적으로 차단하니, 대안이나 수동 추출을 고려하세요.

모범 사례:

- 대량 작업 전 소규모 테스트로 안정성 확인

- 에러 로그 기록 및 예외 처리 필수

- 사이트 규칙 준수, 민감/제한 데이터는 피하기

- 코드 문서화 및 모듈화로 유지보수 용이성 확보

- 정기적으로 스크래퍼 점검—웹사이트가 바뀌면 스크래퍼도 업데이트 필요 ()

마무리 & 핵심 요약

Python 웹 스크래핑은 현대 비즈니스 팀에게 강력한 무기입니다. 복잡한 웹 데이터를 깔끔하고 활용도 높은 정보로 바꿔주죠. 기억해야 할 점은 다음과 같습니다.

- Python은 웹 스크래핑의 대표 언어입니다. 쉬운 문법, 강력한 라이브러리, 활발한 커뮤니티 덕분이죠.

- 기본 워크플로우는 단순합니다: 사이트 구조 파악 → 페이지 요청 → HTML 파싱 → 데이터 추출 및 정제 → CSV/Excel로 내보내기.

- Thunderbit는 비개발자도 쉽게 쓸 수 있는 도구로, 필드 매핑, 서브페이지 추출, 데이터 내보내기를 클릭 몇 번에 자동화합니다.

- Thunderbit와 Python을 함께 쓰면 빠른 추출과 강력한 데이터 처리 모두 가능해집니다.

- 법적·윤리적 기준을 지키세요: 사이트 규칙 준수, 개인정보 수집 금지, 친화적인 스크래퍼 운영.

이제 시작할 준비 되셨나요? Python으로 첫 웹 스크래퍼를 만들어보거나, 코딩 없이 로 웹 데이터 수집의 편리함을 경험해보세요. 더 많은 팁과 심층 가이드는 에서 확인할 수 있습니다.

자주 묻는 질문(FAQ)

1. 웹 스크래핑이란 무엇이며, 왜 Python이 인기가 많나요?

웹 스크래핑은 웹사이트에서 데이터를 자동으로 추출하는 기술입니다. Python은 읽기 쉬운 문법, Requests/BeautifulSoup 등 강력한 라이브러리, 초보자부터 전문가까지 지원하는 커뮤니티 덕분에 인기가 높아요. ()

2. 웹 스크래핑에 어떤 Python 라이브러리를 써야 하나요?

대부분의 프로젝트는 Requests(페이지 요청)와 BeautifulSoup(HTML 파싱)으로 시작하면 충분합니다. 동적/자바스크립트 기반 사이트는 Selenium, 대규모/복잡한 작업은 Scrapy가 적합해요. ()

3. Thunderbit와 Python 웹 스크래핑의 차이는?

Thunderbit는 AI 기반 크롬 확장 프로그램으로, 클릭 두 번이면 데이터를 추출할 수 있습니다(코딩 불필요). 빠른 결과가 필요한 비즈니스 사용자에게 적합하고, Python은 맞춤형/대규모 프로젝트에 더 유연합니다. ()

4. 웹 스크래핑은 합법인가요?

공개 데이터만 수집하고, robots.txt 및 이용약관을 준수하며, 개인정보·저작권 정보를 피하면 일반적으로 합법입니다. 스크래핑 전 사이트 규칙을 꼭 확인하세요. ()

5. Thunderbit와 Python을 함께 활용하려면?

Thunderbit로 구조화된 데이터를 빠르게 추출해 CSV/Excel로 내보내고, Python(Pandas 등)으로 정제·분석·자동화하면 두 가지 장점을 모두 누릴 수 있습니다.

웹을 비즈니스 최고의 데이터 소스로 바꿔보고 싶으신가요? Python과 Thunderbit로 데이터가 일하는 세상을 경험해보세요.

더 알아보기