웹은 정말 상상 이상으로 빠르게 커지고 있습니다. 2024년 기준으로 와 라는 어마어마한 데이터가 존재하고, 내년엔 181 ZB까지 늘어날 전망이에요. 정말 정보의 홍수죠. 그런데 놀라운 건, 되어 있다는 사실! 나머지는 우리가 평소에 검색할 수 없는 ‘딥웹’에 숨어 있습니다. 그렇다면 검색 엔진이나 기업들은 이 방대한 디지털 세상을 어떻게 이해할까요? 바로 웹 크롤러의 힘이죠.

이 글에서는 웹 크롤링이 뭔지, 어떻게 돌아가는지, 왜 중요한지 쉽게 풀어드립니다. IT 전문가뿐 아니라, 온라인 데이터의 가치를 활용하고 싶은 누구에게나 도움이 될 거예요. 웹 크롤링과 웹 스크래핑의 차이(둘은 엄연히 다릅니다!), 실제 활용 사례, 그리고 코드로 만드는 방법부터 노코드 솔루션(제가 추천하는 도 포함!)까지 다뤄봅니다. 웹 데이터에 관심 있는 초보자든, 비즈니스에 활용하고 싶은 분이든 꼭 읽어보세요.

웹 크롤러란? 웹 크롤링의 기본 개념

먼저, 웹 크롤러(스파이더, 봇, 웹사이트 크롤러 등으로도 불려요)는 자동으로 웹을 돌아다니며 페이지를 수집하고, 링크를 따라가며 새로운 콘텐츠를 찾아내는 프로그램입니다. 마치 로봇 사서가 책 목록(즉, URL)에서 시작해 한 권씩 읽고, 참고문헌을 따라 더 많은 책을 찾는 것과 비슷하죠. 여기서 책은 웹페이지, 도서관은 인터넷 전체라고 생각하면 됩니다.

핵심 원리는 이렇습니다:

- **URL 목록(시드)**에서 출발

- 각 페이지를 방문해 콘텐츠(HTML, 이미지 등)를 다운로드

- 페이지 안의 하이퍼링크를 찾아 큐에 추가

- 반복—새로운 링크를 따라가며 더 많은 페이지를 탐색

웹 크롤러의 주된 역할은 페이지를 찾아내고 정리하는 것이에요. 검색 엔진에서는 크롤러가 페이지 내용을 복사해 색인화와 분석을 위해 서버로 보냅니다. 이외에도, 특정 데이터를 뽑아내는 특화된 크롤러도 있는데, 이게 바로 웹 스크래핑과 연결됩니다(아래에서 자세히 설명할게요).

핵심 요약:

웹 크롤링은 웹을 탐색하고 지도를 그리는 과정입니다. 단순히 데이터를 긁어오는 게 아니라, 구글이나 Bing 같은 검색 엔진이 인터넷을 이해하는 데 꼭 필요한 기술이죠.

검색 엔진은 어떻게 작동할까? 크롤러의 역할

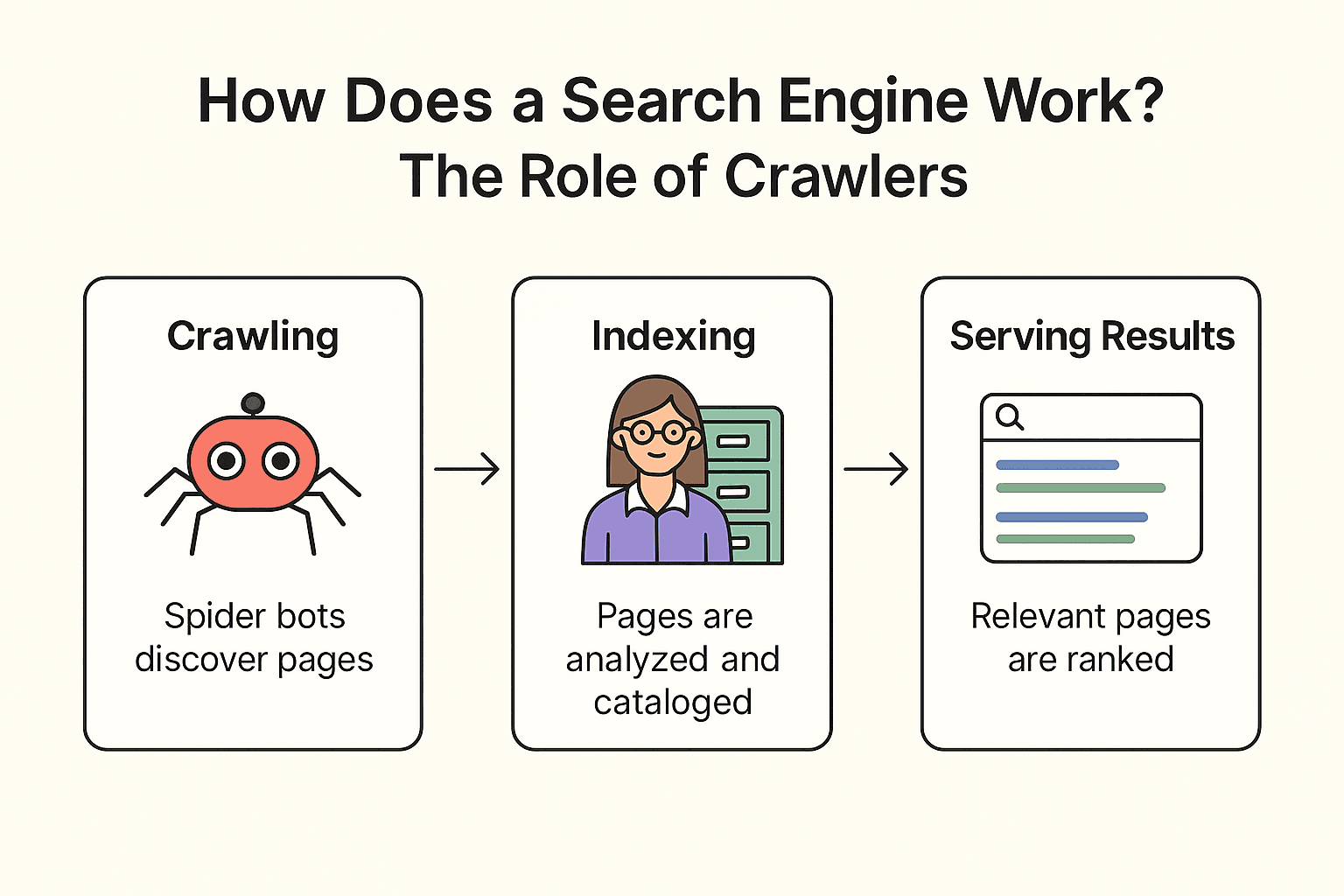

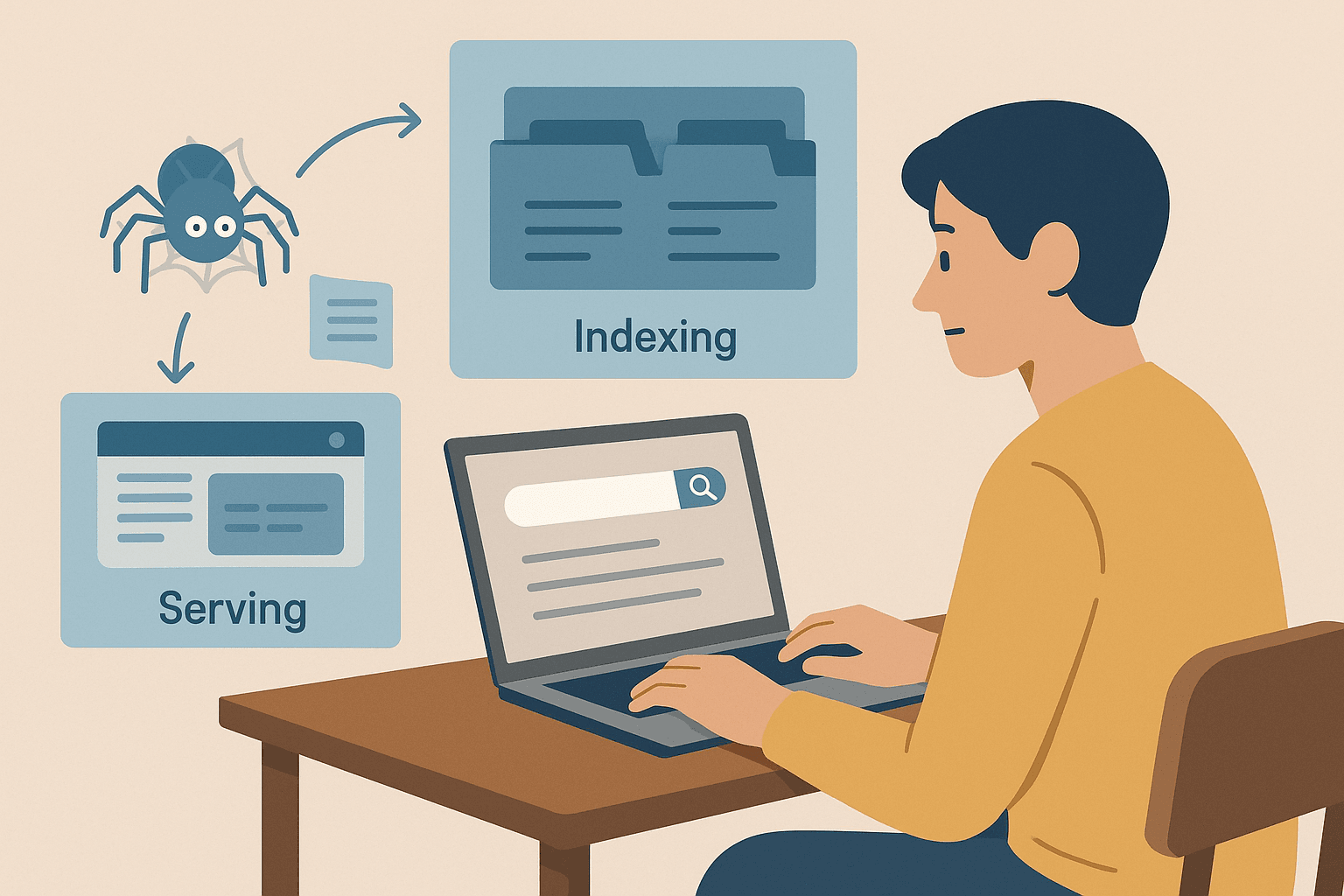

구글, Bing, DuckDuckGo 같은 검색 엔진은 어떻게 돌아갈까요? 크게 크롤링, 색인화, 검색 결과 제공 세 단계로 나뉩니다().

도서관에 비유해서 설명해볼게요:

-

크롤링:

검색 엔진은 ‘스파이더 봇’(예: Googlebot)을 웹에 보내 탐색을 시작합니다. 이미 알려진 페이지에서 출발해, 그 내용을 가져오고, 링크를 따라가며 새로운 페이지를 발견하죠. 마치 사서가 책장을 훑고, 각 책의 참고문헌을 따라 더 많은 책을 찾는 것과 비슷합니다.

-

색인화:

발견된 페이지는 검색 엔진이 내용을 분석해, 어떤 주제인지 파악하고, 중요한 정보를 거대한 디지털 카드 카탈로그(색인)에 저장합니다. 모든 페이지가 색인화되는 건 아니고, 차단되었거나 품질이 낮거나 중복된 페이지는 제외돼요.

-

검색 결과 제공:

사용자가 “내 주변 최고의 피자”를 검색하면, 검색 엔진은 색인에서 관련 페이지를 찾아 수백 가지 요소(키워드, 인기, 최신성 등)를 기준으로 순위를 매깁니다. 그 결과, 정돈된 웹페이지 목록이 제공됩니다.

알아두면 좋은 점:

검색 엔진이 웹의 모든 페이지를 크롤링하는 건 아닙니다. 로그인 뒤에 있거나, robots.txt로 막혀 있거나, 외부 링크가 없는 페이지는 아예 발견되지 않을 수도 있어요. 그래서 기업들은 직접 URL이나 사이트맵을 구글에 제출하기도 합니다.

웹 크롤링 vs. 웹 스크래핑: 뭐가 다를까?

많은 분들이 “웹 크롤링”과 “웹 스크래핑”을 헷갈리지만, 실제로는 목적과 방식이 다릅니다.

| 항목 | 웹 크롤링(스파이더링) | 웹 스크래핑 |

|---|---|---|

| 목적 | 가능한 많은 페이지를 발견하고 색인화 | 한두 개 또는 여러 웹페이지에서 특정 데이터 추출 |

| 비유 | 도서관의 모든 책을 정리하는 사서 | 필요한 책에서 핵심 내용만 필기하는 학생 |

| 결과물 | URL 목록 또는 페이지 내용(색인용) | 원하는 정보가 담긴 구조화된 데이터셋(CSV, Excel, JSON 등) |

| 주 사용자 | 검색 엔진, SEO 감사, 웹 아카이빙 | 영업, 마케팅, 리서치 등 비즈니스팀 |

| 규모 | 대규모(수백만~수십억 페이지) | 소규모(수십~수천 페이지) |

.

쉽게 정리하면:

- 웹 크롤링은 페이지를 찾는 것(웹의 지도를 그리는 것)

- 웹 스크래핑은 원하는 데이터를 뽑아내는 것(스프레드시트로 추출)

실제로 영업, 이커머스, 마케팅 등 비즈니스 현장에서는 스크래핑—즉, 분석을 위한 구조화된 데이터 추출—이 더 많이 쓰입니다. 크롤링은 검색 엔진이나 대규모 데이터 수집에 필수지만, 스크래핑은 특정 목적에 맞는 데이터 수집에 딱이죠.

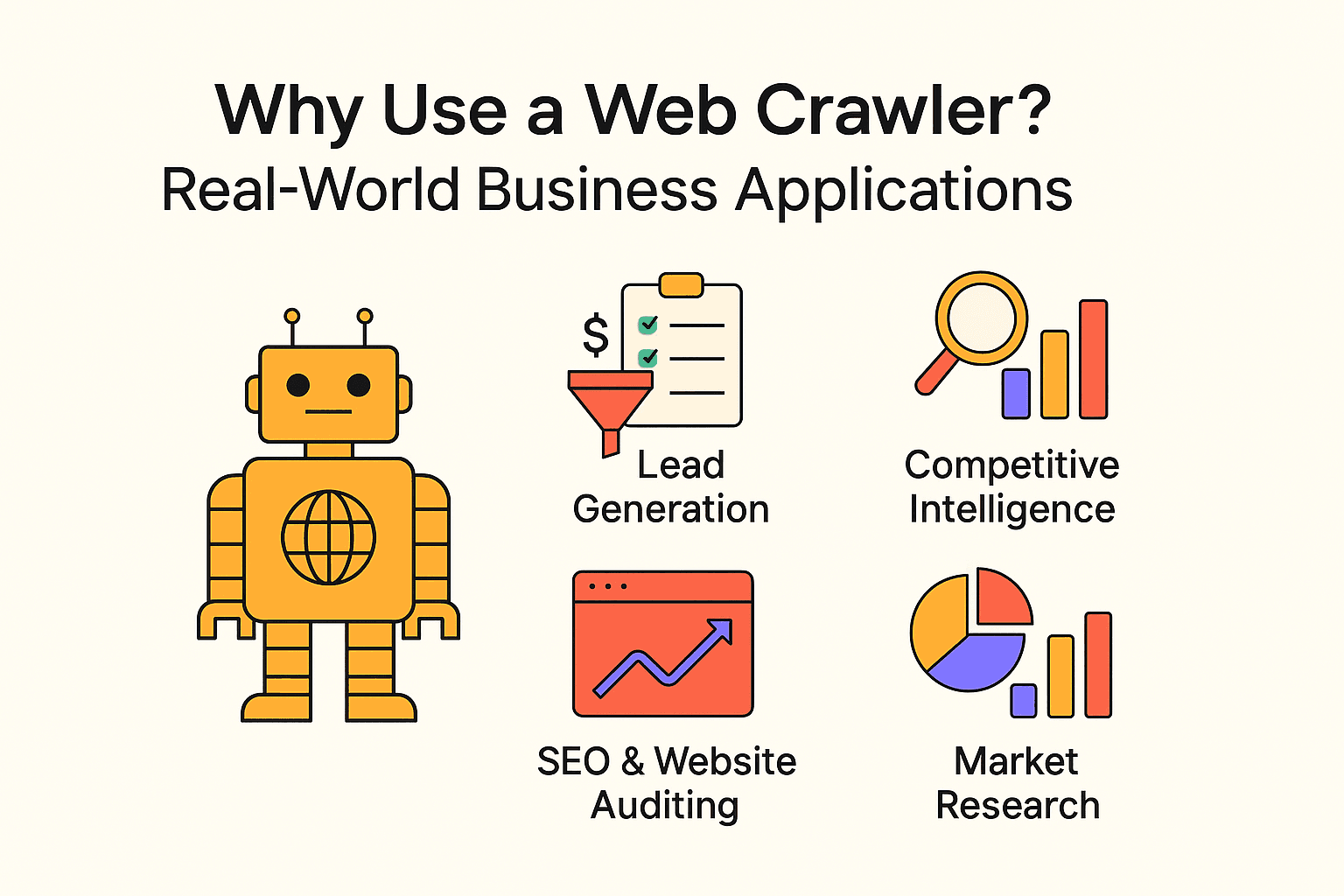

웹 크롤러의 활용: 실제 비즈니스 적용 사례

웹 크롤링은 검색 엔진만의 전유물이 아닙니다. 다양한 기업들이 크롤러와 웹 스크래퍼를 활용해 인사이트를 얻고 반복적인 업무를 자동화하고 있어요. 대표적인 활용 예시는 아래와 같습니다:

| 활용 사례 | 주요 사용자 | 기대 효과 |

|---|---|---|

| 리드 생성 | 영업팀 | 잠재 고객 자동 발굴, CRM에 신규 리드 추가 |

| 경쟁사 분석 | 리테일, 이커머스 | 경쟁사 가격, 재고, 상품 변화 모니터링 |

| SEO & 웹사이트 점검 | 마케팅, SEO팀 | 깨진 링크 탐지, 사이트 구조 최적화 |

| 콘텐츠 집계 | 미디어, 리서치, HR | 뉴스, 채용공고, 공개 데이터셋 수집 |

| 시장 조사 | 애널리스트, 제품팀 | 리뷰, 트렌드, 감성 분석 등 대규모 데이터 분석 |

- .

- , 가 의사결정에 웹 스크래핑을 적극 활용하고 있습니다.

- 웹 스크래핑은 , 까지 절감할 수 있습니다.

결론: 웹 데이터를 활용하지 않으면, 경쟁사가 이미 하고 있을 확률이 높아요.

파이썬으로 웹 크롤러 만들기: 알아야 할 것들

코딩에 익숙하다면, 파이썬은 맞춤형 웹 크롤러를 만들기에 가장 인기 있는 언어입니다. 기본적인 흐름은 이렇습니다:

- requests로 웹페이지 요청

- BeautifulSoup으로 HTML 파싱 및 링크/데이터 추출

- 반복문(또는 재귀)으로 링크를 따라가며 추가 페이지 크롤링

장점:

- 원하는 대로 유연하게 설계 가능

- 복잡한 로직, 데이터 흐름, DB 연동 등 고급 기능 구현 가능

단점:

- 프로그래밍 지식 필요

- 웹사이트 구조가 바뀌면 유지보수 필요

- 봇 차단, 지연, 오류 처리 등 직접 신경 써야 함

입문자를 위한 파이썬 크롤러 예시:

아래는 에서 명언과 저자를 추출하는 간단한 코드입니다:

1import requests

2from bs4 import BeautifulSoup

3url = "<http://quotes.toscrape.com/page/1/>"

4response = requests.get(url)

5soup = BeautifulSoup(response.text, 'html.parser')

6for quote in soup.find_all('div', class_='quote'):

7 text = quote.find('span', class_='text').get_text()

8 author = quote.find('small', class_='author').get_text()

9 print(f"{text} --- {author}")여러 페이지를 크롤링하려면 "다음" 버튼을 찾아 반복문을 추가하면 됩니다.

자주 하는 실수:

- robots.txt나 크롤링 지연 미준수(서버에 무리 주지 않기)

- 봇 차단에 걸림

- 무한 루프(예: 끝없는 달력 페이지)로 인해 서버 과부하

단계별 가이드: 파이썬으로 간단한 웹 크롤러 만들기

직접 코딩에 도전하고 싶다면, 아래 단계별 가이드를 참고하세요.

1단계: 파이썬 환경 준비

파이썬이 설치되어 있는지 확인 후, 필요한 라이브러리를 설치합니다:

1pip install requests beautifulsoup4문제가 있다면 파이썬 버전(python --version)과 pip 설치 여부를 확인하세요.

2단계: 크롤러 핵심 로직 작성

기본 패턴은 다음과 같습니다:

1import requests

2from bs4 import BeautifulSoup

3def crawl(url, depth=1, max_depth=2, visited=None):

4 if visited is None:

5 visited = set()

6 if url in visited or depth > max_depth:

7 return

8 visited.add(url)

9 print(f"Crawling: {url}")

10 response = requests.get(url)

11 soup = BeautifulSoup(response.text, 'html.parser')

12 # 링크 추출

13 for link in soup.find_all('a', href=True):

14 next_url = link['href']

15 if next_url.startswith('http'):

16 crawl(next_url, depth + 1, max_depth, visited)

17start_url = "<http://quotes.toscrape.com/>"

18crawl(start_url)팁:

- 크롤링 깊이 제한으로 무한 루프 방지

- 방문한 URL 추적해 중복 방문 방지

- robots.txt 준수, 요청 간 딜레이(time.sleep(1)) 추가

3단계: 데이터 추출 및 저장

데이터 저장은 CSV 또는 JSON 파일로 할 수 있습니다:

1import csv

2with open('quotes.csv', 'w', newline='', encoding='utf-8') as file:

3 writer = csv.writer(file)

4 writer.writerow(['Quote', 'Author'])

5 # 크롤링 루프 내에서:

6 writer.writerow([text, author])또는 파이썬의 json 모듈을 활용해 JSON으로 저장할 수도 있습니다.

웹 크롤링 시 주의사항 및 베스트 프랙티스

웹 크롤링은 강력하지만, 책임감 있게 사용해야 합니다(IP 차단 위험도 있어요). 다음은 꼭 지켜야 할 사항입니다:

- robots.txt 준수: 사이트의 robots.txt 파일을 확인하고, 금지된 영역은 크롤링하지 마세요.

- 서버에 무리 주지 않기: 요청 간 충분한 딜레이(몇 초 이상) 추가

- 범위 제한: 필요한 페이지만 크롤링, 깊이/도메인 제한 설정

- User-Agent 명확히: 자신을 알리는 User-Agent 사용

- 법적 이슈 확인: 비공개/민감 정보는 크롤링 금지, 공개 데이터만 활용

- 윤리적 사용: 전체 사이트 복사, 스팸 목적 데이터 활용 금지

- 테스트는 소규모로: 소규모로 시작해 문제 없을 때 점진적으로 확장

더 자세한 내용은 를 참고하세요.

웹 스크래핑이 더 적합한 경우: 비즈니스 사용자를 위한 Thunderbit

솔직히 말씀드리면, 검색 엔진을 직접 만들거나 사이트 전체 구조를 분석해야 하는 게 아니라면, 대부분의 비즈니스 사용자는 웹 스크래핑 도구가 훨씬 효율적입니다.

여기서 가 진가를 발휘합니다. 공동 창업자이자 CEO로서 약간의 편견이 있을 수 있지만, Thunderbit는 비전문가도 손쉽게 웹 데이터를 추출할 수 있는 최고의 솔루션이라고 자신합니다.

Thunderbit의 장점

- 두 번 클릭이면 끝: “AI 필드 추천” 클릭 후 “스크랩”만 누르면 바로 끝

- AI 기반: Thunderbit가 페이지를 읽고, 추출할 최적의 컬럼(상품명, 가격, 이미지 등)을 자동 제안

- 대량 & PDF 지원: 현재 페이지, 여러 URL, PDF에서도 데이터 추출 가능

- 유연한 내보내기: CSV/JSON 다운로드, Google Sheets, Airtable, Notion으로 바로 전송

- 코딩 불필요: 브라우저만 쓸 줄 알면 누구나 사용 가능

- 서브페이지 스크래핑: 더 많은 정보가 필요하다면, Thunderbit가 하위 페이지까지 자동 방문해 데이터 보강

- 스케줄링: “매주 월요일 오전 9시”처럼 자연어로 반복 스크래핑 예약 가능

언제 크롤러가 더 적합할까요?

사이트 전체를 지도처럼 파악(검색 인덱스, 사이트맵 구축 등)해야 한다면 크롤러가 필요합니다. 하지만 상품 목록, 리뷰, 연락처 등 특정 페이지만 구조화된 데이터로 뽑고 싶다면, 스크래핑이 훨씬 쉽고 빠릅니다.

결론 & 핵심 요약

정리하자면:

- 웹 크롤링은 검색 엔진과 대규모 데이터 프로젝트가 웹을 발견하고 지도를 그리는 방법입니다. 즉, 최대한 많은 페이지를 찾는 데 초점이 있습니다.

- 웹 스크래핑은 그 중에서 필요한 데이터를 뽑아내는 작업입니다. 대부분의 비즈니스 사용자는 크롤링보다 스크래핑이 더 필요합니다.

- 직접 크롤러를 코딩할 수도 있지만(파이썬 추천), 시간과 기술, 유지보수가 필요합니다.

- 노코드/AI 기반 도구(Thunderbit 등)를 활용하면 누구나 쉽게 웹 데이터를 추출할 수 있습니다.

- 베스트 프랙티스 준수: 항상 사이트 규칙을 지키고, 데이터를 윤리적으로 활용하세요.

처음 시작한다면, 간단한 프로젝트(예: 상품 가격 수집, 디렉토리에서 리드 추출 등)로 연습해보세요. 빠른 결과를 원한다면 Thunderbit 같은 도구를, 코딩을 배우고 싶다면 파이썬을 활용해보세요.

웹은 정보의 보고입니다. 올바른 방법으로 접근하면, 더 똑똑한 의사결정과 시간 절약, 비즈니스 경쟁력 강화에 큰 도움이 될 수 있습니다.

FAQ

- 웹 크롤링과 웹 스크래핑의 차이는?

크롤링은 페이지를 찾고 지도를 그리는 것, 스크래핑은 그 페이지에서 원하는 데이터를 추출하는 것입니다. 크롤링=발견, 스크래핑=추출.

- 웹 스크래핑은 합법인가요?

공개 데이터라면 robots.txt와 서비스 약관을 지키는 한 대부분 문제 없습니다. 비공개나 저작권 콘텐츠는 피하세요.

- 웹사이트에서 데이터를 추출하려면 코딩이 꼭 필요한가요?

아니요. 같은 도구를 사용하면 클릭과 AI만으로도 데이터 추출이 가능합니다.

- 왜 구글이 웹 전체를 색인화하지 않나요?

대부분의 웹페이지가 로그인, 유료벽, 차단 등으로 인해 접근이 불가능하기 때문입니다. 실제로 약 4%만 색인화됩니다.