요즘 웹에는 상상도 못할 만큼 방대한 데이터가 쏟아지고 있어요. 2024년 기준으로 전 세계 디지털 데이터가 나 된다고 하니, 정말 어마어마하죠? 더 놀라운 건 이 중 90% 이상이 최근 2년 사이에 만들어졌다는 사실이에요. 즉, 비즈니스 인사이트, 신규 리드, 경쟁력을 높여줄 정보가 웹 어딘가에 숨어 있을 확률이 높다는 뜻이죠. 문제는, 그 많은 데이터를 어떻게 쉽고 빠르게 내 것으로 만드느냐입니다.

이럴 때 꼭 필요한 게 바로 웹 스크래핑이에요. 영업, 이커머스, 시장 조사 등 어떤 분야든 웹사이트에서 데이터를 자동으로 모아 정리할 수 있다면, 그 자체가 엄청난 무기가 됩니다. 코딩이 처음이어도 걱정 마세요. 파이썬은 웹 스크래핑을 누구나 쉽게 시작할 수 있게 도와줍니다. 이 글에서는 환경 세팅부터 데이터 정제까지 차근차근 알려드리고, 빠른 결과가 필요할 땐 의 노코드 AI 웹 스크래퍼도 소개해드릴게요.

파이썬 웹 스크래핑이란?

먼저, 웹 스크래핑이란 웹사이트에서 원하는 데이터를 자동으로 뽑아오는 과정을 말해요. 예를 들어, 온라인 쇼핑몰에서 상품 가격을 모으거나, 디렉터리에서 리드 목록을 만들거나, 경쟁사 뉴스를 모니터링할 때 일일이 복사-붙여넣기 하지 않고, 스크립트 한 번으로 모든 작업을 자동화할 수 있죠.

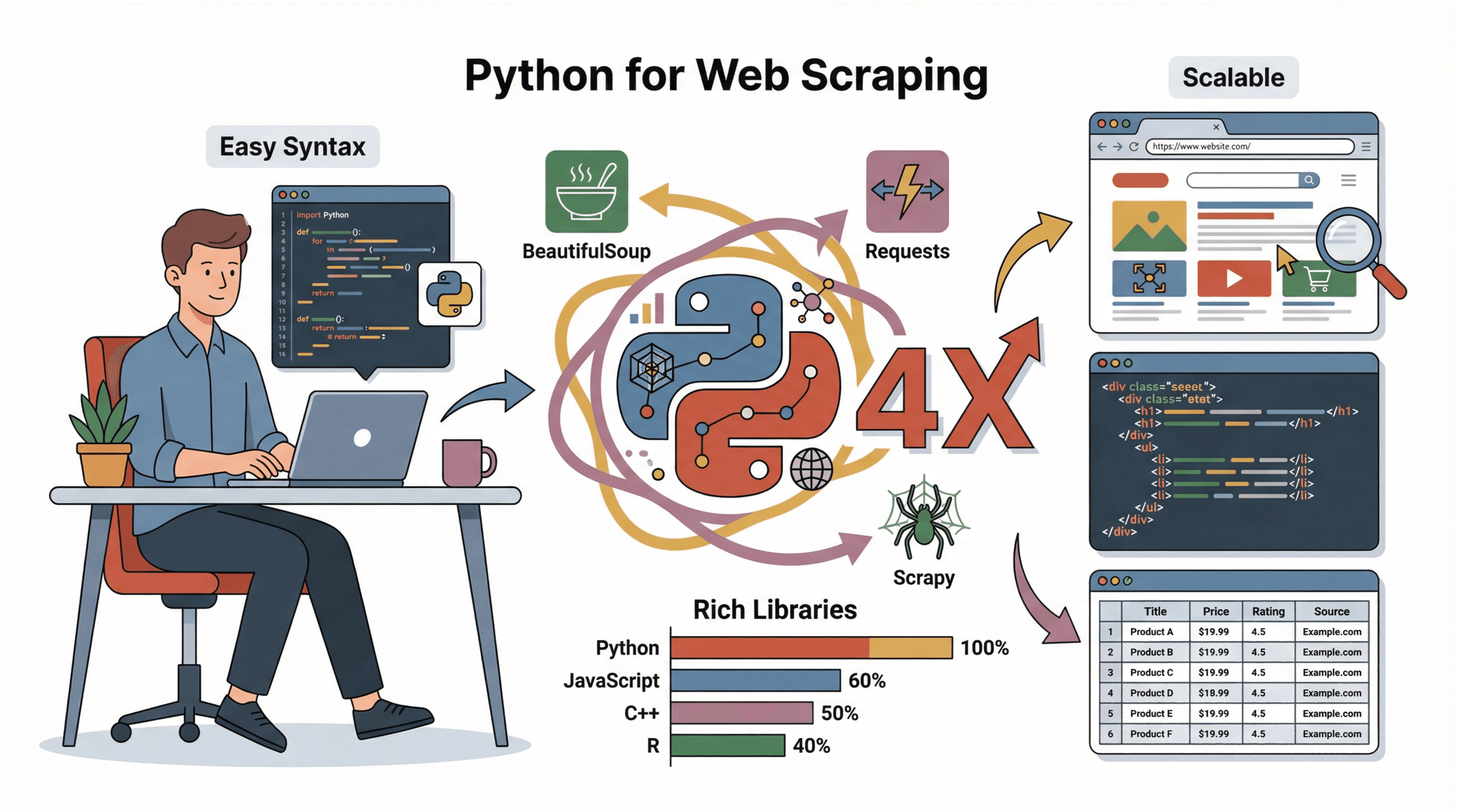

파이썬 웹 스크래핑은 이 과정을 파이썬 언어로 구현하는 걸 의미합니다. 파이썬은 문법이 직관적이고, 쓸만한 라이브러리가 많아서 코딩 경험이 적어도 금방 시작할 수 있어요. 웹페이지를 불러오고, 원하는 정보를 뽑아내고, 정리된 데이터로 저장하는 데 몇 분이면 충분하죠.

실제로 웹 스크래핑은 이런 식으로 활용돼요:

- 리드 발굴: 디렉터리나 리뷰 사이트에서 잠재 고객 리스트 만들기

- 가격 모니터링: 경쟁사 가격이나 상품 재고 추적

- 시장 조사: 뉴스, 리뷰, 소셜 미디어 언급 수집

- 운영 관리: 공급업체 정보, 채용 공고, 부동산 매물 등 수집

즉, 웹에 있는 데이터라면 파이썬으로 빠르고 대량으로 긁어올 수 있습니다.

웹 스크래핑에 파이썬이 딱인 이유

여러 언어로 스크래핑을 시도해봤지만(실패도 많이 해봤죠), 파이썬만큼 편한 게 없더라고요. 그 이유는 이렇습니다:

여러 언어로 스크래핑을 시도해봤지만(실패도 많이 해봤죠), 파이썬만큼 편한 게 없더라고요. 그 이유는 이렇습니다:

- 입문자에게 친절: 파이썬은 문법이 간단해서 비전공자도 금방 배울 수 있어요.

- 풍부한 생태계: , , 등 다양한 라이브러리 덕분에 데이터 수집, 파싱, 저장이 정말 쉬워요.

- 커뮤니티 지원: 튜토리얼, 포럼, 코드 예제가 넘쳐나서 막히는 부분도 금방 해결할 수 있습니다.

- 확장성: 간단한 스크립트부터 대규모 프로젝트까지 모두 대응 가능해요.

JavaScript, C++, R 등과 비교해도 파이썬은 배우기 쉽고, 빠른 프로토타이핑과 데이터 분석에 최적화되어 있습니다(). 그래서 입문자부터 대기업까지 파이썬을 선호하죠.

시작하기: 파이썬 스크래핑 환경 세팅

스크래핑을 시작하려면 파이썬과 몇 가지 필수 라이브러리를 설치해야 해요. 처음 설치하는 분도 아래 순서대로 따라오면 어렵지 않습니다:

-

파이썬 설치:

- 에서 최신 버전을 다운로드하세요.

- Windows에서는 설치할 때 “Add Python to PATH” 꼭 체크!

- Mac은 로

brew install python3입력. - Linux는 패키지 매니저로

sudo apt install python3 python3-pip입력.

-

pip(패키지 매니저) 설치 확인:

- 대부분의 파이썬 설치에는 pip가 포함되어 있어요.

pip --version으로 확인. - 없다면 설치 프로그램을 다시 실행하거나

python -m ensurepip --upgrade사용.

- 대부분의 파이썬 설치에는 pip가 포함되어 있어요.

-

가상환경 설정(선택, 추천):

- 프로젝트 폴더에서

python -m venv env실행 - 활성화 방법:

- Windows:

.\env\Scripts\activate - Mac/Linux:

source env/bin/activate

- Windows:

- 프로젝트 폴더에서

-

필요한 라이브러리 설치:

- 가상환경이 활성화된 상태에서 아래 명령어 입력:

1pip install requests beautifulsoup4 pandas scrapy - 동적 사이트를 다루려면

selenium도 설치할 수 있어요.

- 가상환경이 활성화된 상태에서 아래 명령어 입력:

-

코드 에디터 선택:

- 입문자에게는 , , 추천!

문제 해결 꿀팁:

pip명령어가 안 될 땐python -m pip install ...을 시도해보세요.- 권한 오류가 나면 터미널을 관리자 권한으로 실행하거나 Mac/Linux에서는

sudo를 사용하세요. - Windows에서는 파이썬 설치 후 터미널을 재시작하세요.

스크래핑 전, 웹사이트 구조 파악하기

코드를 짜기 전에, 먼저 스크래핑할 웹사이트의 구조를 이해해야 해요. 이렇게 해보세요:

-

개발자 도구 열기:

- 크롬에서 원하는 요소를 우클릭 후 “검사” 선택, 또는

F12키를 누르세요. - “Elements” 탭에서 HTML 구조를 볼 수 있습니다.

- 크롬에서 원하는 요소를 우클릭 후 “검사” 선택, 또는

-

타겟 데이터 찾기:

- “요소 선택” 도구(마우스 포인터 아이콘)로 원하는 데이터(예: 상품명, 가격 등)를 클릭하세요.

- 해당 HTML 코드가 하이라이트됩니다.

-

패턴 파악:

- 고유한 태그, 클래스, ID를 확인하세요. 예:

<h2 class="product-title">Laptop XYZ</h2> - 데이터가 리스트(

<ul>,<div class="item">등)나 테이블에 있는지 확인하세요.

- 고유한 태그, 클래스, ID를 확인하세요. 예:

-

페이지네이션 확인:

- “다음” 버튼이나 페이지 번호가 HTML에 있는지 확인하세요. URL에

?page=2와 같은 패턴이 있으면 반복문으로 여러 페이지를 처리할 수 있습니다.

- “다음” 버튼이나 페이지 번호가 HTML에 있는지 확인하세요. URL에

-

동적 콘텐츠 여부 확인:

Ctrl+U로 페이지 소스에 데이터가 없으면, JavaScript로 불러오는 데이터일 수 있어요. 이럴 땐 Selenium이나 API 엔드포인트를 찾아야 할 수도 있습니다.

자세한 시각적 설명은 참고!

Requests로 웹페이지 내용 가져오기

라이브러리는 파이썬에서 웹페이지를 다운로드할 때 가장 많이 쓰여요. 기본 예시는 아래와 같아요:

1import requests

2url = "https://www.bbc.com/news"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status() # 오류 발생 시 예외 처리

6html = response.text팁:

- 차단을 피하려면 실제 브라우저와 비슷한

User-Agent헤더를 꼭 추가하세요(). response.status_code로 응답 상태를 확인하세요(200: 정상, 404: 없음, 403: 접근 금지, 429: 요청 과다 등).

BeautifulSoup으로 HTML 파싱 및 데이터 추출

HTML을 가져왔다면, 이제 필요한 정보를 뽑아야겠죠. 으로 쉽게 할 수 있어요:

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3titles = [h.get_text(strip=True) for h in soup.select("h3")]자주 쓰는 작업:

- 텍스트 추출:

element.get_text(strip=True) - 링크 추출:

[a['href'] for a in soup.select('a')] - 클래스로 찾기:

soup.find_all('span', class_='price') - 이미지 추출:

[img['src'] for img in soup.select('img')] - 테이블 처리:

soup.select('table')로 테이블을 찾고, 행/셀을 반복문으로 처리

지저분한 HTML 처리 팁:

- 첫 번째 일치 항목만 필요하면

soup.select_one()사용 - 필드가 없을 때는

None체크 후 속성 접근 - 레이아웃이 불규칙하면 정규표현식이나 커스텀 로직이 필요할 수 있어요.

Scrapy 프레임워크: 대규모 웹 스크래핑에 최적

수백, 수천 페이지를 스크래핑해야 한다면 가 제격이에요. Scrapy는 크롤링, 요청 처리, 링크 추적, 데이터 내보내기까지 모두 지원하는 프레임워크입니다.

Scrapy의 장점:

- 속도: 여러 페이지를 동시에 비동기로 처리

- 내장 기능: 재시도, 캐싱, CSV/JSON 내보내기 등 지원

- 확장성: 대규모 프로젝트나 정기적 크롤링에 적합

Scrapy 기본 사용법:

- 설치:

pip install scrapy - 프로젝트 생성:

scrapy startproject myproject - Spider 클래스에

start_urls와parse메서드 정의 yield로 링크 추적 또는 데이터 추출- 실행:

scrapy crawl spidername -o output.csv

자세한 내용은 참고하세요.

노코드 대안: Thunderbit의 AI 웹 스크래퍼로 바로 결과 얻기

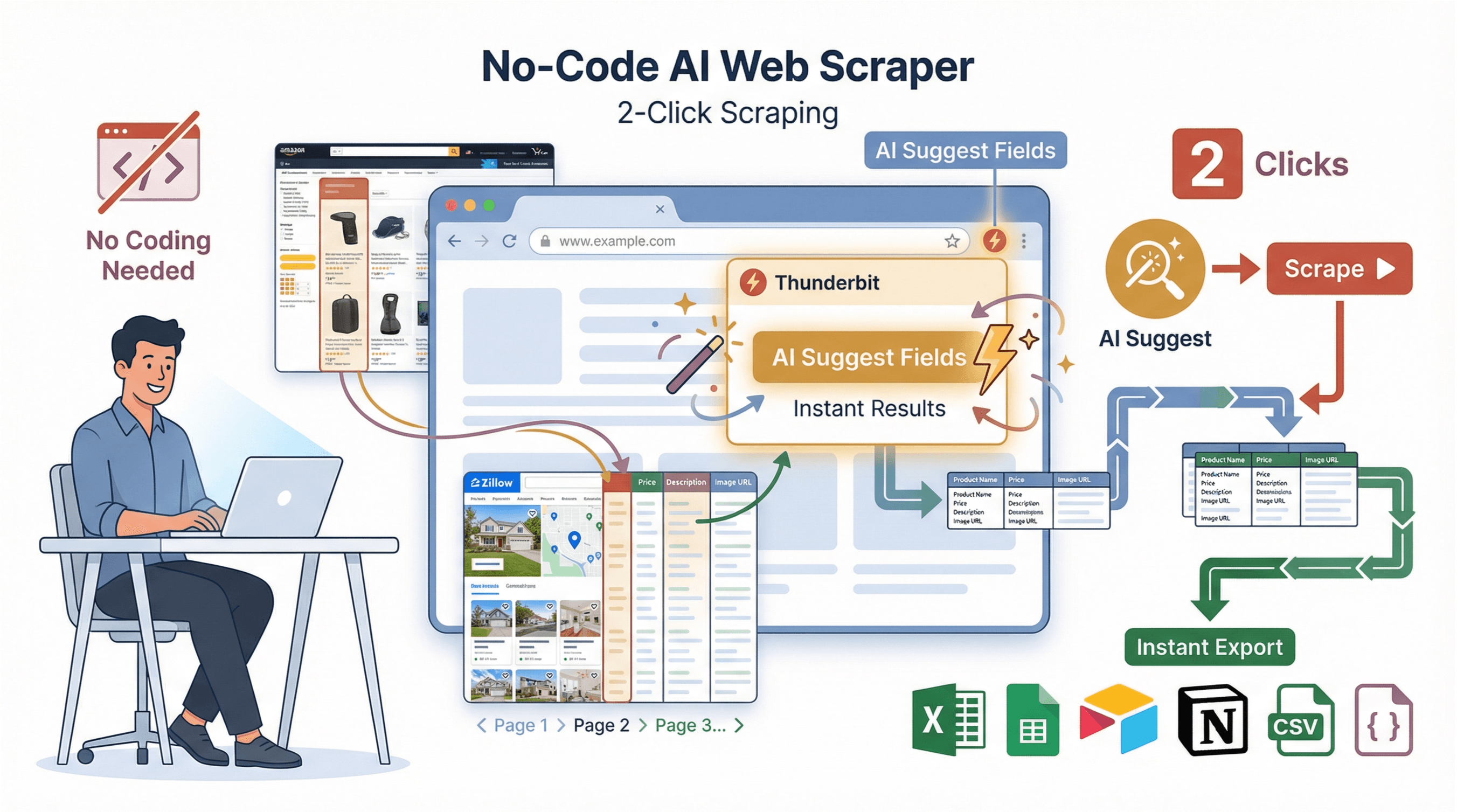

코드, 라이브러리, 디버깅에 시간 쓰기 싫으신가요? 그래서 저희는 을 만들었어요. Thunderbit은 비즈니스 사용자를 위한 AI 기반 웹 스크래퍼 크롬 확장 프로그램으로, 단 두 번의 클릭만으로 원하는 데이터를 얻을 수 있습니다.

코드, 라이브러리, 디버깅에 시간 쓰기 싫으신가요? 그래서 저희는 을 만들었어요. Thunderbit은 비즈니스 사용자를 위한 AI 기반 웹 스크래퍼 크롬 확장 프로그램으로, 단 두 번의 클릭만으로 원하는 데이터를 얻을 수 있습니다.

Thunderbit의 주요 기능:

- AI 필드 추천: “AI 필드 추천”을 누르면 Thunderbit이 페이지를 분석해 추출할 컬럼을 자동으로 제안해줘요.

- 2-클릭 스크래핑: “스크랩” 버튼만 누르면 페이지네이션, 하위 페이지, 복잡한 레이아웃까지 자동 처리!

- 하위 페이지 스크래핑: 상세 정보가 필요하다면, 각 하위 페이지(예: 상품 상세, 프로필 등)도 자동 방문해 테이블을 풍부하게 만듭니다.

- 즉시 사용 가능한 템플릿: Amazon, Zillow, Instagram, Shopify 등 인기 사이트는 1-클릭 내보내기 템플릿 제공

- 무료 데이터 내보내기: Excel, Google Sheets, Airtable, Notion, CSV, JSON 등으로 바로 내보내기—별도 결제 없이 사용 가능

Thunderbit vs. 파이썬: 간단 비교

| 기능 | 파이썬(수동) | Thunderbit(노코드) |

|---|---|---|

| 환경 세팅 시간 | 30–60분 | 2분 |

| 코딩 필요 여부 | 예 | 아니오 |

| 페이지네이션 처리 | 직접 코드 작성 | 자동 처리 |

| 하위 페이지 스크래핑 | 반복문 작성 필요 | 1클릭 |

| 데이터 내보내기 | CSV/Excel 코드 작성 | 1클릭으로 Sheets/Excel/Notion |

| 유지보수 | 사이트 변경 시 직접 수정 | AI가 자동 적응 |

| 추천 용도 | 맞춤 로직, 통합 필요 | 빠른 결과, 비개발자 |

더 자세한 내용은 에서 확인하세요.

데이터 정제 및 저장: 수집한 데이터를 가치 있게 만들기

스크래핑한 원본 데이터는 바로 쓰기 어렵죠. 로 데이터를 정제하고 저장하는 방법은 아래와 같아요:

1import pandas as pd

2# 예시: 딕셔너리 리스트 scraped_data가 있다고 가정

3df = pd.DataFrame(scraped_data)

4# 중복 제거

5df = df.drop_duplicates()

6# 필수 컬럼 결측치 제거

7df = df.dropna(subset=['title', 'price'])

8# 가격을 float로 변환(기호, 쉼표 제거)

9df['price'] = df['price'].str.replace('$', '').str.replace(',', '').astype(float)

10# CSV로 저장

11df.to_csv('results.csv', index=False)베스트 프랙티스:

- 결측치, 불일치 데이터 항상 점검

- 날짜, 가격 등 포맷 통일

- CSV로 저장하면 공유가 쉽고, Excel/Google Sheets로 협업 가능

- 대용량 데이터는 SQLite, PostgreSQL 등 데이터베이스 활용 추천

파이썬 웹 스크래핑 실전 튜토리얼: 처음부터 끝까지

실제 예시로, 샘플 이커머스 사이트에서 상품명과 가격을 추출해볼게요.

1. 웹사이트 구조 확인

예를 들어 을 스크래핑한다고 가정해요. 페이지를 검사해보면:

- 책 제목은

<article class="product_pod">내부의<h3>태그에 있어요. - 가격은

<p class="price_color">에 있습니다.

2. 페이지 가져오기

1import requests

2url = "http://books.toscrape.com/"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status()

6html = response.text3. 데이터 파싱 및 추출

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3books = []

4for article in soup.select("article.product_pod"):

5 title = article.h3.a["title"]

6 price = article.select_one("p.price_color").get_text(strip=True)

7 books.append({"title": title, "price": price})4. 데이터 정제 및 저장

1import pandas as pd

2df = pd.DataFrame(books)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df.to_csv('books.csv', index=False)

5print(f"Saved {len(df)} books to books.csv")5. 문제 해결 팁

books가 비어 있다면 CSS 선택자를 다시 확인하세요.- 인코딩 오류가 나면 CSV를 UTF-8로 열어보세요.

- 여러 페이지를 처리하려면

http://books.toscrape.com/catalogue/page-2.html과 같이 URL을 반복문으로 돌리세요.

꿀팁: 동적 사이트나 복잡한 플로우는 Selenium, Scrapy를 활용하거나, Thunderbit에 맡기면 훨씬 간편합니다.

마무리 및 핵심 요약

파이썬 웹 스크래핑은 리드 발굴부터 시장 정보 수집까지 비즈니스에 다양한 기회를 열어줍니다. 오늘 배운 핵심은 이거예요:

- 파이썬은 웹 스크래핑에 최적—간단한 문법과 강력한 라이브러리 덕분입니다.

- Requests와 BeautifulSoup—HTML을 불러오고 파싱하는 데 필수 도구입니다.

- Scrapy—대규모, 반복적 스크래핑에 강력한 프레임워크입니다.

- Thunderbit—코딩 없이 AI로 바로 결과를 얻을 수 있는 노코드 대안! 비개발자에게 특히 추천해요.

- 데이터 정제와 저장—원시 데이터를 인사이트로 바꾸는 마지막 단계입니다.

더 깊이 배우고 싶다면, 연습용 사이트에서 직접 스크래퍼를 만들어보거나 를 설치해 웹사이트 데이터를 얼마나 빠르게 추출할 수 있는지 경험해보세요. 더 많은 팁과 튜토리얼은 에서 확인할 수 있습니다.

즐거운 스크래핑 하시길 바랍니다! 데이터가 항상 깔끔하고, 구조화되어, 바로 활용할 수 있기를 응원할게요.

자주 묻는 질문(FAQ)

1. 웹 스크래핑은 합법인가요?

공개된 데이터를 수집하는 웹 스크래핑은 일반적으로 합법이지만, 각 사이트의 이용약관, robots.txt, GDPR 등 개인정보 보호법을 꼭 지켜야 해요. 동의 없이 개인정보를 수집하거나, 로그인/보안 장치를 우회하는 행위는 피하세요().

2. Requests, BeautifulSoup, Scrapy의 차이점은?

- Requests: 웹페이지를 불러오는 역할

- BeautifulSoup: HTML에서 원하는 데이터를 파싱 및 추출

- Scrapy: 대규모 크롤링과 데이터 추출, 여러 페이지 및 내보내기까지 지원하는 프레임워크

3. 웹사이트가 JavaScript로 데이터를 불러오면?

초기 HTML에 데이터가 없다면 이나 Playwright로 브라우저를 자동화하거나, 네트워크 탭에서 API 엔드포인트를 찾아 직접 접근할 수 있어요.

4. 스크래핑 시 차단을 피하려면?

실제 브라우저와 비슷한 헤더(특히 User-Agent)를 사용하고, 요청 간 랜덤 딜레이를 추가하며, 서버에 과도한 요청을 보내지 마세요. 대규모 스크래핑은 IP를 회전하거나 프록시를 활용하세요().

5. 코딩 없이 데이터 추출이 가능한가요?

물론이죠! 을 사용하면 AI가 원하는 데이터를 2번 클릭만에 추출해줍니다. 크롬 확장 프로그램을 설치하고, 원하는 정보를 설명하면 바로 데이터를 내보낼 수 있어요.

더 많은 가이드와 고급 팁은 에서 확인하세요.

더 알아보기