전 세계가 데이터의 바다에 잠겨 있는 요즘, 이 데이터를 누가 더 잘 활용하느냐가 곧 경쟁력입니다. 매일 수십억 개의 웹페이지가 웹 스크래핑을 통해 인사이트, 가격 정보, 리드, 리서치 등 다양한 목적으로 활용되고 있죠. 이 데이터는 이커머스 가격 경쟁부터 AI 혁신까지 모든 분야의 핵심 동력이 되고 있습니다(). 글로벌 웹 스크래핑 시장은 2025년 말 90억 달러를 돌파할 것으로 예상되며, 효율적인 웹 크롤러를 쓰지 않으면 중요한 기회를 놓칠 수밖에 없습니다().

저는 SaaS와 자동화 업계에서 오래 일하면서, 제대로 된 웹 크롤러가 프로젝트의 성패를 좌우하는 장면을 수도 없이 봤습니다. 최근에는 Rust가 웹 크롤러 개발에 얼마나 강력한지 몸소 체감하고 있는데요. 이 글에서는 Rust가 웹 크롤러에 왜 잘 맞는지, 어떻게 시작하면 좋은지, 그리고 같은 AI 기반 도구와 결합해 속도·안정성·편리함까지 모두 잡는 방법을 소개합니다.

왜 Rust로 웹 크롤러를 만들어야 할까?

많은 분들이 "왜 Rust로 웹 크롤러를 만들어야 하죠?"라고 묻곤 합니다. Python이나 Node.js로 웹 크롤링을 해본 분들이라면 더 궁금할 수밖에 없죠. Rust가 돋보이는 이유는 아래와 같습니다.

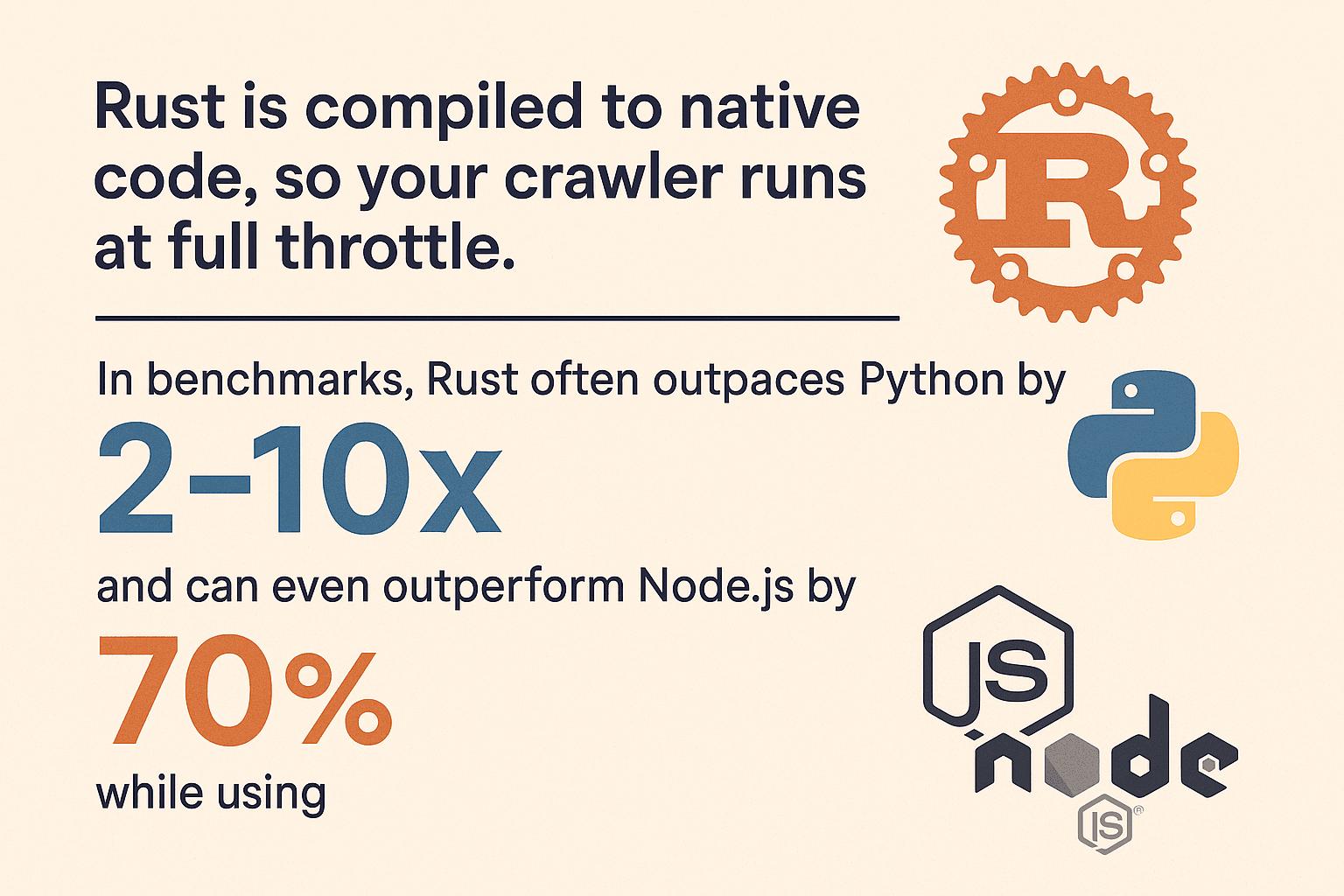

- 압도적인 속도: Rust는 네이티브 코드로 컴파일되어, 크롤러가 최대 성능을 뽑아냅니다. 벤치마크를 보면 Rust는 연산이 많은 작업에서 Python보다 2~10배 빠르고, Node.js보다 70% 더 빠르면서 메모리 사용량은 90%까지 적을 수 있습니다(, ).

- 메모리 안전성: Rust의 소유권 시스템 덕분에, 예기치 않은 크래시나 메모리 누수 걱정이 없습니다. 컴파일 단계에서 버그를 미리 잡아주죠.

- 안전한 동시성: Rust는 동시성 처리를 염두에 두고 설계됐습니다. 100개의 페이지를 동시에 긁고 싶어도 Rust의 타입 시스템이 스레드 안전과 데이터 경합을 막아줍니다.

- 높은 신뢰성: Rust의 에러 처리(

Result,Option)는 실패 상황을 꼼꼼히 챙기게 해줍니다. 잘못된 요청 하나로 크롤러가 멈추는 일은 없습니다. - 보안성: 버퍼 오버플로우, 널 포인터 등 치명적인 취약점이 원천적으로 차단됩니다. Rust의 안전성 덕분에 악의적이거나 비정상적인 웹 콘텐츠에도 강합니다.

Python(쉽지만 느리고 메모리 소모가 큼), Node.js(빠른 I/O지만 싱글 스레드, 메모리 사용량 많음)와 비교하면, Rust는 성능과 안정성 모두에서 압도적입니다. 크롤링 규모가 커질수록 그 차이는 더 커집니다().

Rust 웹 크롤러 개발 환경 세팅하기

이제 Rust 개발 환경을 준비해볼까요?

1. Rust와 Cargo 설치

Rust는 으로 배포되며, 버전 관리와 빌드 도구(cargo)가 함께 제공됩니다. 운영체제에 맞는 설치 파일을 받아 안내에 따라 설치하면 됩니다. Windows라면 Visual C++ Build Tools 설치 안내가 나올 수 있어요.

설치 확인은 아래처럼:

1rustc --version

2cargo --version버전 정보가 나오면 정상입니다.

2. 새 프로젝트 시작

터미널에서 아래 명령어를 입력하세요:

1cargo new rust_web_crawler

2cd rust_web_crawlerCargo.toml과 src/main.rs가 포함된 새 프로젝트가 만들어집니다.

3. 필수 라이브러리 추가

웹 크롤링에 필요한 주요 라이브러리는 다음과 같습니다:

- (HTTP 클라이언트)

- (CSS 셀렉터 기반 HTML 파싱)

- (비동기 런타임)

- (데이터 내보내기)

아래 명령어로 한 번에 추가할 수 있습니다:

1cargo add reqwest scraper csv tokio --features full또는 Cargo.toml에 직접 추가해도 됩니다:

1[dependencies]

2reqwest = { version = "0.11", features = ["blocking"] }

3scraper = "0.16"

4csv = "1.1"

5tokio = { version = "1.28", features = ["full"] }4. 개발 도구 및 IDE 추천

저는 확장 프로그램이 적용된 VS Code를 추천합니다. 코드 자동완성, 인라인 문서, 린트 등 개발에 필요한 기능이 다 들어있어요. 대형 프로젝트라면 JetBrains의 CLion이나 IntelliJ에 Rust 플러그인을 써도 좋습니다.

5. 문제 해결 팁

cargo명령어가 안 먹힌다면, Rust의.cargo/bin경로가 환경 변수 PATH에 포함됐는지 확인하세요.- Windows에서는 C++ 빌드 도구가 없을 수 있으니 안내에 따라 설치하세요.

- 의존성 오류가 나면

cargo update를 실행하거나Cargo.toml오타를 체크하세요.

단계별: Rust로 첫 웹 크롤러 만들기

이제 실제로 페이지를 긁어 상품 정보를 추출하고, CSV로 내보내는 기본 크롤러를 만들어봅시다. 간단한 예시이니, 필요에 따라 얼마든지 확장할 수 있습니다.

Rust로 웹페이지 가져오기

먼저 reqwest로 웹페이지를 불러와봅니다:

1use reqwest::blocking::get;

2fn main() {

3 let url = "https://www.scrapingcourse.com/ecommerce/";

4 let response = get(url);

5 let html_content = response.unwrap().text().unwrap();

6 println!("{}", html_content);

7}실제 서비스에서는 unwrap() 대신 에러 처리를 꼭 해주세요:

1let response = match reqwest::blocking::get(url) {

2 Ok(resp) => resp,

3 Err(err) => {

4 eprintln!("Request failed for {}: {}", url, err);

5 return;

6 }

7};데이터 파싱 및 추출

scraper를 활용해 HTML에서 상품 정보를 뽑아봅니다.

1use scraper::{Html, Selector};

2let document = Html::parse_document(&html_content);

3let product_selector = Selector::parse("li.product").unwrap();

4for product in document.select(&product_selector) {

5 let name = product

6 .select(&Selector::parse("h2").unwrap()).next()

7 .map(|e| e.text().collect::<String>());

8 let price = product

9 .select(&Selector::parse(".price").unwrap()).next()

10 .map(|e| e.text().collect::<String>());

11 let url = product

12 .select(&Selector::parse("a").unwrap()).next()

13 .and_then(|e| e.value().attr("href"))

14 .map(|s| s.to_string());

15 let image = product

16 .select(&Selector::parse("img").unwrap()).next()

17 .and_then(|e| e.value().attr("src"))

18 .map(|s| s.to_string());

19 println!("Name: {:?}, Price: {:?}, URL: {:?}, Image: {:?}", name, price, url, image);

20}이 방식은 에서 아이디어를 얻었고, 대부분의 이커머스나 디렉터리 페이지에 적용할 수 있습니다.

URL 관리 및 중복 방지

실제 크롤러라면 링크를 따라가면서 중복 크롤링을 막아야 하죠. 대표적인 패턴은 아래와 같습니다:

1use std::collections::{HashSet, VecDeque};

2let mut to_visit = VecDeque::new();

3let mut visited = HashSet::new();

4to_visit.push_back(start_url.to_string());

5visited.insert(start_url.to_string());

6while let Some(url) = to_visit.pop_front() {

7 // Fetch and parse page...

8 for link in extracted_links {

9 let abs_link = normalize_url(&link, &url); // `url` 크레이트 사용!

10 if !visited.contains(&abs_link) {

11 visited.insert(abs_link.clone());

12 to_visit.push_back(abs_link);

13 }

14 }

15}상대 경로, 슬래시, 프래그먼트 등은 크레이트로 정규화하세요.

동시성 구현으로 크롤링 속도 올리기

여기서부터 Rust의 진가가 드러납니다. 한 페이지씩 순차적으로 크롤링하면 느리니, 병렬로 처리해봅시다.

방법 1: 멀티스레딩

여러 스레드를 만들어 큐를 분담시키는 방식입니다. Arc<Mutex<>>로 상태를 공유하면 소규모 크롤링에 적합합니다.

방법 2: Tokio 기반 비동기 처리

진짜 속도를 원한다면 비동기를 활용하세요. tokio와 비동기 reqwest를 쓰면 수백 개의 요청을 동시에 처리해도 메모리 부담이 적습니다.

1use reqwest::Client;

2use futures::future::join_all;

3let client = Client::new();

4let urls = vec![/* ... */];

5let fetches = urls.into_iter().map(|url| {

6 let client_ref = &client;

7 async move {

8 match client_ref.get(url).send().await {

9 Ok(resp) => {

10 let text = resp.text().await.unwrap_or_default();

11 // Parse text...

12 }

13 Err(e) => eprintln!("Error fetching {}: {}", url, e),

14 }

15 }

16});

17join_all(fetches).await;비동기 Rust는 빠를 뿐 아니라 안전합니다. 데이터 경합이나 이상한 버그 없이, 순수한 처리량을 경험할 수 있습니다().

크롤링한 데이터 내보내기 및 저장

데이터를 모았다면, 내보내는 작업이 필요하겠죠. 크레이트를 쓰면 간단하게 CSV로 저장할 수 있습니다:

1use csv::Writer;

2use std::fs::File;

3let file = File::create("products.csv").expect("could not create file");

4let mut writer = Writer::from_writer(file);

5writer.write_record(&["Name", "Price", "URL", "Image"]).unwrap();

6for prod in &products {

7 let name = prod.name.as_deref().unwrap_or("");

8 let price = prod.price.as_deref().unwrap_or("");

9 let url = prod.url.as_deref().unwrap_or("");

10 let image = prod.image.as_deref().unwrap_or("");

11 writer.write_record(&[name, price, url, image]).unwrap();

12}

13writer.flush().unwrap();로 구조체를 바로 직렬화하거나, 복잡한 데이터는 JSON으로 내보낼 수도 있습니다.

Thunderbit로 웹 데이터 추출을 더 빠르고 쉽게

이제 를 소개할 차례입니다. 직접 코딩하는 것도 좋지만, 때로는 빠르게 데이터를 얻고 싶을 때가 있죠. Thunderbit는 AI 기반 Chrome 확장 프로그램으로, 클릭 몇 번만으로 코딩 없이 데이터를 추출할 수 있습니다.

Thunderbit는 AI 웹 스크래퍼 Chrome 확장 프로그램으로, 비즈니스 사용자가 AI를 활용해 웹사이트에서 데이터를 쉽게 추출할 수 있도록 도와줍니다. 반복적인 웹 작업을 자동화해 시간을 절약할 수 있는 생산성 도구입니다.

Thunderbit만의 강점은?

- AI 필드 추천: Thunderbit가 페이지를 분석해 이름, 이메일, 가격 등 추출할 컬럼을 자동으로 제안합니다().

- 원클릭 스크래핑: “스크랩” 버튼 한 번이면 데이터가 구조화된 표로 정리됩니다.

- 서브페이지 추출: 상세 페이지 정보가 필요하다면, 각 링크를 자동 방문해 표를 풍부하게 만들어줍니다().

- 페이지네이션 & 무한 스크롤: Thunderbit가 페이지네이션이나 무한 스크롤도 자동으로 감지해 처리합니다.

- 무료 데이터 내보내기: Excel, Google Sheets, Notion, Airtable, CSV 등 다양한 포맷으로 손쉽게 내보낼 수 있습니다.

- AI 자동입력: 로그인이나 폼 자동입력도 AI로 처리해, 인증이 필요한 데이터도 쉽게 추출할 수 있습니다.

Thunderbit는 복잡하거나 동적, JavaScript 기반 사이트를 다룰 때 비즈니스 사용자와 개발자 모두에게 큰 도움이 됩니다.

Thunderbit와 Rust, 언제 각각 써야 할까?

- Thunderbit: 빠른 프로토타입, 일회성 데이터 추출, 혹은 비개발자 팀원이 직접 데이터를 수집해야 할 때 딱입니다.

- Rust: 대규모, 맞춤형, 혹은 시스템에 깊이 통합된 크롤러가 필요할 때 최고의 성능과 제어력을 제공합니다.

사실, 두 가지를 함께 쓰면 시너지가 극대화됩니다.

Rust 웹 크롤러와 다른 기술의 성능 비교

조금 더 기술적으로 들어가 볼까요? Rust는 다른 언어와 비교해 어떤 장점이 있을까요?

| 언어/프레임워크 | 속도 | 메모리 사용량 | 동시성 | 안정성 | 생태계 |

|---|---|---|---|---|---|

| Rust | 🚀🚀🚀 | 🟢 낮음 | 🟢 탁월함 | 🟢 높음 | 중간 |

| Python (Scrapy) | 🚀 | 🔴 높음 | 🟡 제한적 | 🟡 보통 | 🟢 큼 |

| Node.js | 🚀🚀 | 🔴 높음 | 🟢 좋음 | 🟡 보통 | 🟢 큼 |

| Go | 🚀🚀 | 🟢 낮음 | 🟢 탁월함 | 🟢 높음 | 중간 |

- Rust는 Python보다 2~10배 빠르고, 메모리 사용량은 10% 미만에 불과합니다(, ).

- Node.js는 I/O에 강점이 있지만, JS 실행은 싱글 스레드라 무거운 파싱 작업에서는 한계가 있습니다.

- Go도 강력한 경쟁자지만, Rust의 메모리 안전성과 제로 오버헤드 추상화 덕분에 대규모, 장시간 크롤링에서는 Rust가 한 수 위입니다.

대규모 크롤링이나 극한의 성능이 필요하다면 Rust가 최고의 선택입니다.

Thunderbit와 Rust를 결합해 효율 극대화하기

제가 즐겨 쓰는 워크플로우는 Thunderbit와 Rust를 함께 활용하는 것입니다.

- 빠른 프로토타이핑: Thunderbit로 사이트 구조와 샘플 데이터를 빠르게 파악해, 코드 작성 전에 전체 흐름을 이해할 수 있습니다.

- 역할 분담: Thunderbit는 동적, 인증, 복잡한 페이지(서브페이지 추출, AI 자동입력 등)를 맡기고, Rust 크롤러는 정적/대량 페이지를 담당합니다.

- 정기 스크래핑: Thunderbit의 예약 스크래핑 기능으로 주기적으로 데이터를 수집하고, Rust 백엔드에서 후처리하거나 병합할 수 있습니다.

- 비개발자 지원: 운영, 마케팅팀이 Thunderbit로 즉석 데이터 수집을 할 수 있어, 개발자는 더 복잡한 작업에 집중할 수 있습니다.

- 유연성: Rust 크롤러가 레이아웃 변경 등으로 깨질 때도, Thunderbit의 AI는 즉시 적응해 코드 수정 없이 계속 데이터를 추출할 수 있습니다.

이런 하이브리드 방식은 Thunderbit의 속도와 유연성, Rust의 파워와 제어력을 모두 누릴 수 있습니다.

Rust 웹 크롤러를 위한 문제 해결 및 베스트 프랙티스

튼튼한 크롤러를 만들려면 코드뿐 아니라, 실제 웹 환경의 다양한 변수도 고려해야 합니다.

자주 겪는 문제

- 봇 차단 우회: 실제 브라우저 User-Agent 사용,

robots.txt준수, 요청 속도 조절, 대량 크롤링 시 프록시 활용(). - CAPTCHA 및 로그인: CAPTCHA나 복잡한 로그인은 Thunderbit의 AI 자동입력이나 , 같은 헤드리스 브라우저를 활용하세요.

- JavaScript 기반 사이트: 데이터가 AJAX로 로드된다면, API 호출을 직접 찾거나, JS 렌더링이 필요하다면 Thunderbit 또는 헤드리스 브라우저를 사용하세요.

- 에러 처리: 항상 적절한 에러 처리(

Result,Option), 타임아웃 설정, 에러 로그 기록을 잊지 마세요. - 동시성 문제: 스레드 안전 구조체(

Arc<Mutex<>>,DashMap)를 사용하고, 공유 상태에서 병목이 생기지 않도록 주의하세요. - 메모리 관리: 수백만 페이지를 크롤링한다면, 데이터를 실시간으로 디스크에 저장해 메모리 사용을 최소화하세요.

- 윤리 및 준법: 사이트 이용약관을 준수하고, 서버에 과부하를 주지 않으며, 데이터 프라이버시 법규도 반드시 지키세요.

베스트 프랙티스

- 모듈화: 데이터 수집, 파싱, 저장 로직을 분리해 유지보수를 쉽게 하세요.

- 설정 파일 활용: URL, 동시성, 지연 시간 등은 설정 파일이나 CLI 인자로 관리하세요.

- 로깅:

log크레이트로 구조화된 로그를 남기세요. - 테스트: 샘플 HTML로 파싱 로직에 대한 단위 테스트를 작성하세요.

- 모니터링: 장시간 실행되는 크롤러라면 CPU, 메모리, 에러 등 상태를 모니터링하세요.

더 많은 문제 해결 팁은 와 을 참고하세요.

결론 & 핵심 요약

Rust로 웹 크롤러를 만드는 건 단순한 기술적 도전이 아니라, 데이터 중심 시대의 전략적 무기가 될 수 있습니다. 꼭 기억해야 할 점은 아래와 같습니다.

- Rust는 웹 크롤링에 최적화된 언어입니다. 빠르고, 안전하며, 동시성에 강합니다.

- 단계별로 개발하세요: 환경 세팅, 페이지 수집/파싱, URL 관리, 동시성 추가, 데이터 내보내기까지 차근차근 진행하세요.

- Thunderbit는 복잡한 사이트나 빠른 프로토타이핑에 강력한 무기입니다. 코딩 없이도 데이터를 쉽게 추출할 수 있습니다.

- 두 가지를 결합하면 효율이 극대화됩니다. Thunderbit로 프로토타입과 난이도 높은 페이지를, Rust로 대규모/맞춤형 크롤링을 담당하세요.

- 실용성을 잊지 마세요: 때로는 수백 줄의 코드보다 클릭 몇 번이 더 나은 해법이 될 수 있습니다.

웹 크롤링 실력을 한 단계 높이고 싶다면 Rust에 도전해보세요. 그리고 필요할 때는 의 힘을 빌려보세요. 더 많은 스크래핑 팁과 자동화 노하우는 에서 확인할 수 있습니다.

즐거운 크롤링 되시길 바랍니다. 데이터가 언제나 빠르고, 깨끗하며, 한층 더 스마트하길!

자주 묻는 질문(FAQ)

1. Rust로 웹 크롤러를 만드는 게 Python이나 Node.js보다 좋은 이유는?

Rust는 성능, 메모리 안전성, 동시성 지원에서 월등합니다. Python과 Node.js는 빠른 스크립트에 적합하지만, 대규모·장기·미션 크리티컬 크롤러에는 Rust가 속도와 신뢰성 면에서 탁월합니다().

2. Rust 웹 크롤러 개발에 꼭 필요한 라이브러리는?

HTTP 요청은 reqwest, HTML 파싱은 scraper, 비동기 처리는 tokio, 데이터 내보내기는 csv가 필요합니다. URL 정규화에는 url 크레이트도 유용합니다.

3. JavaScript 기반이나 인증이 필요한 사이트는 Rust에서 어떻게 처리하나요?

JS 기반 사이트는 API 호출을 직접 찾거나, fantoccini 같은 헤드리스 브라우저를 활용하세요. 인증 페이지는 reqwest로 쿠키를 관리하거나, Thunderbit의 AI 자동입력 기능으로 로그인 자동화를 할 수 있습니다.

4. Thunderbit와 Rust를 함께 쓰는 장점은?

Thunderbit는 AI 기반의 노코드 스크래핑으로 빠른 프로토타입, 동적 페이지, 비개발자 지원에 최적입니다. Rust는 맞춤형·고성능 크롤러에 강점이 있습니다. 두 가지를 결합하면 빠르고 효율적으로 확장할 수 있습니다.

5. 크롤링 중 차단이나 밴을 피하려면 어떻게 해야 하나요?

robots.txt 준수, 실제 브라우저 헤더 사용, 요청 속도 조절, 대량 크롤링 시 프록시 활용이 필요합니다. 항상 윤리적으로 크롤링하고, 사이트 이용약관과 데이터 프라이버시 법규를 지키세요().

Thunderbit의 실제 활용이 궁금하다면 하고, 더 똑똑한 스크래핑을 시작해보세요. 웹 자동화에 대한 더 깊은 인사이트는 에서 확인할 수 있습니다.

더 알아보기