웹 데이터는 이제 ‘21세기의 원유’라고 불릴 만큼 중요한 자원이 됐어요. 2025년을 바라보는 지금, 똑똑한 영업 전략부터 세밀한 시장 조사까지, 웹 데이터가 모든 분야의 핵심 동력으로 자리 잡고 있죠. 이커머스, 부동산, SaaS 등 다양한 업계에서 복잡한 웹페이지를 깔끔한 스프레드시트로 바꾸기 위해 치열하게 경쟁하는 모습을 자주 볼 수 있습니다. 이 글을 읽고 있다면, 여러분도 그 흐름에 합류하고 싶은 마음이 있으실 거예요. 다행히도, 파이썬만 있으면 누구나 웹 스크래핑을 시작할 수 있습니다. 개발자가 아니어도 충분히 도전할 수 있죠.

이 가이드에서는 파이썬으로 웹 스크래핑을 시작하는 방법부터 Scrapy 같은 프레임워크로 확장하는 과정까지, 꼭 알아야 할 핵심을 하나씩 짚어드릴게요. 그리고 같은 AI 기반 도구가 어떻게 비즈니스 사용자의 데이터 추출을 혁신적으로 간소화하는지도 함께 살펴봅니다. 웹 스크래핑이 처음인 분도, 실무에서 더 효율적으로 활용하고 싶은 분도, 실전 예제와 코드, 실용 팁을 통해 전문가처럼 데이터 수집을 할 수 있도록 도와드릴게요.

파이썬 웹 스크래핑이란? 한눈에 살펴보기

웹 스크래핑은 웹사이트에서 정보를 자동으로 뽑아내는 기술이에요. 쉽게 말해, 컴퓨터에게 복사-붙여넣기를 엄청난 속도와 규모로 시키는 것과 비슷하죠. 파이썬에서는 웹페이지를 불러오고, HTML을 분석해서 원하는 데이터(예: 상품 가격, 연락처, 리뷰 등)를 뽑아내는 스크립트를 작성하게 됩니다.

비즈니스 관점에서 웹 스크래핑은 진짜 금광과도 같아요. 영업팀은 리드 리스트를 만들고, 이커머스팀은 경쟁사 가격을 모니터링하며, 데이터 분석가는 시장 동향을 추적합니다. 모두 웹의 비정형 데이터를 분석 가능한 구조화 데이터로 바꾸는 덕분이죠. 파이썬은 배우기 쉽고 강력해서, 소규모부터 대규모까지 웹 스크래핑에 가장 널리 쓰이는 언어입니다().

왜 웹 스크래핑에 파이썬이 최적일까?

그럼 왜 다들 웹 스크래핑에 파이썬을 쓸까요? 이유는 명확합니다. 배우기 쉽고, 강력한 라이브러리가 많고, 커뮤니티도 활발하거든요.

- 읽기 쉬운 문법: 파이썬 코드는 작성도 쉽고, 읽기도 편해서 개발자가 아니어도 금방 시작할 수 있어요.

- 강력한 라이브러리: BeautifulSoup, Scrapy, Requests 등 다양한 도구 덕분에 데이터 추출과 파싱이 정말 간단합니다.

- 다재다능함: 파이썬은 스크래핑뿐 아니라 데이터 분석, 자동화까지 한 번에 처리할 수 있어요.

- 커뮤니티 지원: 복잡한 HTML 구조에 막혀도 Stack Overflow 등에서 이미 누군가 해결책을 공유해뒀죠.

다른 언어와 비교해볼까요?

| 언어 | 장점 | 단점 | 추천 용도 |

|---|---|---|---|

| Python | 쉬운 문법, 풍부한 라이브러리, 커뮤니티 | C++/Java에 비해 속도는 느림 | 소규모~대규모 스크래핑 전반 |

| JavaScript | JS 기반 사이트에 강함 | HTML 파싱 도구가 부족, 비동기 처리 복잡 | SPA, 동적 웹사이트 |

| R | 데이터 분석에 강점 | 스크래핑 프레임워크가 적음 | 소규모, 통계 중심 작업 |

| Java/C# | 엔터프라이즈급, 빠른 속도 | 코드가 장황하고 복잡함 | 대규모, 통합 시스템 |

파이썬은 웹 스크래핑 분야에서 항상 상위권을 차지하고, 2023년에는 SQL을 제치고 세계에서 세 번째로 많이 쓰이는 언어가 됐어요().

파이썬 웹 스크래핑에 꼭 필요한 도구 & 라이브러리

파이썬 웹 스크래핑을 시작할 때 꼭 챙겨야 할 기본 도구는 아래와 같습니다.

- Requests: HTTP 요청을 보내 웹페이지를 불러오는 데 가장 많이 쓰여요.

- BeautifulSoup: HTML, XML 파싱에 특화된 라이브러리로, 원하는 데이터를 쉽게 찾고 뽑아낼 수 있습니다.

- Scrapy: 대규모 자동화 크롤링과 스크래핑에 최적화된 프레임워크입니다.

- Selenium: 동적(자바스크립트 기반) 사이트를 자동화 브라우저로 스크래핑할 때 사용합니다.

- 기타: 빠른 파싱을 위한

lxml, 데이터 가공을 위한pandas, 최신 브라우저 자동화용Playwright등도 유용해요.

언제 어떤 도구를 써야 할까?

- Requests + BeautifulSoup: 정적 페이지, 소규모 프로젝트에 딱입니다.

- Scrapy: 여러 페이지를 크롤링하거나 대량 데이터를 추출할 때 강력합니다.

- Selenium/Playwright: 자바스크립트로 동적으로 로딩되는 데이터나 사용자 행동이 필요한 경우에 사용하세요.

시작하기: 파이썬 웹 스크래핑 환경 세팅

파이썬이 처음이어도 환경 설정은 어렵지 않아요.

-

파이썬 설치: 에서 Python 3.x를 다운로드하고, 시스템 PATH에 추가하세요.

-

가상환경 만들기: 프로젝트별로 라이브러리를 관리할 수 있습니다.

1python3 -m venv venv 2# 활성화: 3# Windows: 4venv\Scripts\activate 5# Mac/Linux: 6source venv/bin/activate -

필수 라이브러리 설치:

1pip install requests beautifulsoup4 scrapy selenium -

프로젝트 구성: 간단한 스크립트는 .py 파일 하나로 충분해요. Scrapy는

scrapy startproject myproject로 프로젝트 구조를 만드세요. -

설치 확인:

1import requests, bs4, scrapy, selenium 2print("모든 라이브러리가 정상적으로 불러와졌습니다!") -

User-Agent 설정(권장): 일부 사이트는 "Python-requests"를 차단하니 브라우저처럼 보이게 헤더를 추가하세요.

1headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

이제 스크래핑을 시작할 준비가 끝났어요!

BeautifulSoup으로 HTML 파싱: 첫 번째 파이썬 웹 스크래퍼 만들기

간단한 예제로 연습해볼까요? 에서 명언과 저자를 추출해보겠습니다.

1단계: 웹사이트 구조 살펴보기

- 크롬에서 사이트를 엽니다.

- 명언 부분에서 우클릭 후 "검사"를 선택하세요.

- 각 명언은

<div class="quote">안에 있고, 텍스트는<span class="text">, 저자는<small class="author">에 있습니다.

2단계: 스크래퍼 코드 작성 및 실행

아래는 기본 스크립트 예시입니다.

1import requests

2from bs4 import BeautifulSoup

3url = "http://quotes.toscrape.com/page/1/"

4headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

5res = requests.get(url, headers=headers)

6if res.status_code != 200:

7 print(f"요청 실패: {res.status_code}")

8 exit()

9soup = BeautifulSoup(res.text, "html.parser")

10quote_divs = soup.find_all("div", class_="quote")

11for div in quote_divs:

12 quote_text = div.find("span", class_="text").get_text(strip=True)

13 author = div.find("small", class_="author").get_text(strip=True)

14 print(f"{quote_text} --- {author}")자주 발생하는 문제:

- 요소가 없을 때는

.get_text()호출 전에None체크를 하세요. - 셀렉터가 맞는지 브라우저에서 꼭 확인하세요.

확장하기: Scrapy로 파이썬 웹 스크래핑 최적화

스크래핑 범위가 한두 페이지에서 전체 사이트로 커진다면 Scrapy를 쓸 때가 됐다는 신호입니다.

- 구조: Scrapy는 "스파이더"(크롤링/파싱 방법 정의), 파이프라인(데이터 처리), 비동기 요청 등으로 구성되어 빠르고 효율적이에요.

- Scrapy의 장점: 수천 개 페이지도 빠르게 처리하고, 에러 관리, CSV/JSON 내보내기 등 대규모 작업에 최적화되어 있습니다.

언제 BeautifulSoup 대신 Scrapy를 쓸까?

- 여러 페이지를 자동으로 크롤링해야 할 때

- 재시도, 속도 조절, 데이터 파이프라인 등 내장 기능이 필요할 때

- 팀 단위로 정기적으로 스크래퍼를 운영할 때

Scrapy 실전 예제

아래는 모든 페이지의 명언을 수집하는 스파이더 예시입니다.

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/page/1/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 "tags": quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)실행 방법:

1scrapy crawl quotes -O quotes.json이렇게 하면 모든 데이터를 담은 JSON 파일이 자동으로 생성됩니다.

프로젝트 규모가 커질수록 Scrapy의 구조와 속도가 큰 힘을 발휘합니다.

Thunderbit: 파이썬 웹 스크래핑을 혁신하는 AI 도구

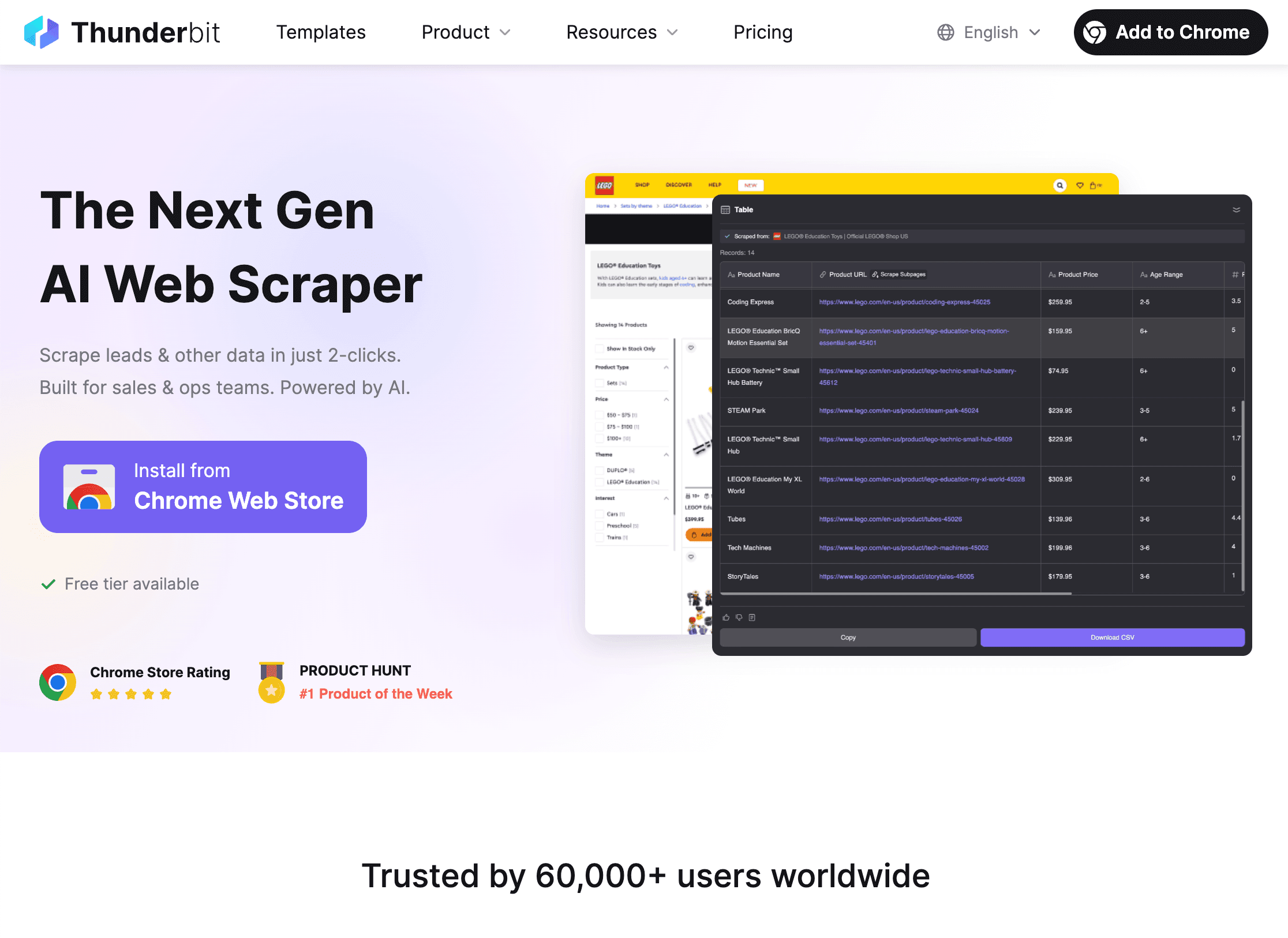

사실 파이썬만으로도 스크래핑이 항상 쉽진 않아요. 동적 사이트, 하위 페이지, 레이아웃 변경 등 복잡한 상황이 많죠. 이럴 때 가 진짜 큰 도움이 됩니다.

Thunderbit는 AI 기반 크롬 확장 프로그램으로, 단 두 번의 클릭만으로 웹사이트 데이터를 추출할 수 있어요.

- AI 필드 추천: AI가 페이지를 읽고 "상품명", "가격" 등 추출할 컬럼을 자동으로 제안합니다.

- 스크래핑: 한 번 더 클릭하면, Thunderbit가 페이지네이션, 하위 페이지, 무한 스크롤까지 모두 처리해 데이터를 수집합니다.

Thunderbit의 장점:

- 코딩 불필요: 비즈니스 사용자, 데이터 분석가도 쉽게 사용 가능

- 복잡한 사이트도 OK: 동적 콘텐츠, 하위 페이지, 레이아웃 변경에도 AI가 자동 대응

- 즉시 내보내기: Excel, Google Sheets, Airtable, Notion 등으로 바로 데이터 전송

- 하위 페이지 스크래핑: 각 상품/프로필의 상세 정보도 자동으로 테이블에 추가

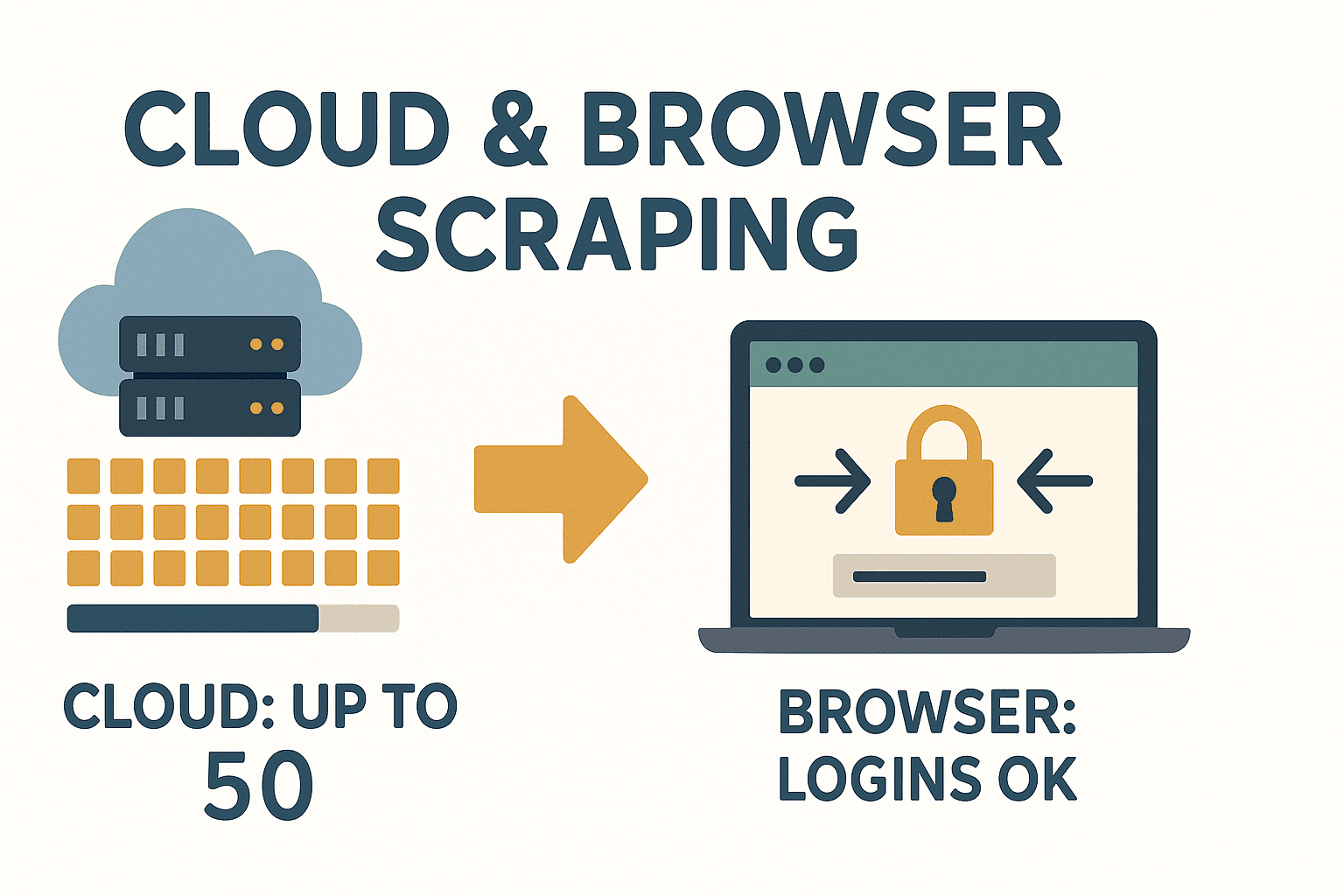

- 클라우드/브라우저 모드: 클라우드에서 최대 50페이지 동시 처리, 로그인 필요한 사이트는 브라우저 모드로

Thunderbit는 빠르고 손쉽게 데이터를 수집하고 싶은 모든 분께 혁신적인 솔루션입니다.

Thunderbit는 빠르고 손쉽게 데이터를 수집하고 싶은 모든 분께 혁신적인 솔루션입니다.

Thunderbit 같은 AI 도구가 필요한 순간

- 지금 당장 데이터가 필요할 때, IT팀이나 개발에 의존하고 싶지 않을 때

- 사이트가 복잡하거나 자주 바뀔 때

- 비개발자 팀원도 데이터 수집이 필요할 때

- 데이터 추출과 동시에 번역, 분류 등 추가 가공이 필요할 때

Thunderbit는 파이썬 워크플로우와도 찰떡궁합이에요. 빠른 프로토타이핑, 복잡한 사이트, 유지보수 부담을 줄이고 싶을 때 활용해보세요. 더 자세한 비교는 에서 확인할 수 있습니다.

동적 콘텐츠와 페이지네이션 처리하기

요즘 웹사이트는 자바스크립트로 데이터를 불러오는 경우가 많아 스크래핑이 까다로울 수 있어요. 다음과 같이 대응해보세요.

- 동적 콘텐츠: 데이터가 JS로 로딩된다면 Selenium이나 Playwright로 브라우저를 자동화해, 데이터가 나타날 때까지 기다렸다가 추출하세요.

- 페이지네이션: "다음" 링크를 따라가거나 URL의 페이지 번호를 증가시키는 방식으로 반복 처리합니다. Scrapy는 이 과정을 자동화해줍니다.

BeautifulSoup로 페이지네이션 처리 예시

1page = 1

2while True:

3 url = f"http://quotes.toscrape.com/page/{page}/"

4 res = requests.get(url, headers=headers)

5 if res.status_code == 404:

6 break

7 soup = BeautifulSoup(res.text, 'html.parser')

8 quotes = soup.find_all("div", class_="quote")

9 if not quotes:

10 break

11 # ...명언 추출 코드...

12 page += 1무한 스크롤이나 "더보기" 버튼: Selenium으로 스크롤하거나 클릭을 자동화하거나, 네트워크 탭에서 API 호출을 찾아 Requests로 직접 요청할 수도 있습니다.

데이터 저장: 비즈니스에 맞는 방식으로 보관하기

데이터를 수집했다면, 활용하기 좋은 형태로 저장해야겠죠.

- CSV: 엑셀/구글시트에서 바로 쓸 수 있어 가장 보편적입니다.

1import csv 2with open('data.csv', 'w', newline='') as f: 3 writer = csv.DictWriter(f, fieldnames=['name', 'price']) 4 writer.writeheader() 5 for row in data: 6 writer.writerow(row) - 엑셀: pandas로 손쉽게 내보낼 수 있습니다.

1import pandas as pd 2df = pd.DataFrame(data) 3df.to_excel('data.xlsx', index=False) - 데이터베이스: 대규모/지속적 프로젝트라면 SQLite나 PostgreSQL을 활용하세요.

1import sqlite3 2conn = sqlite3.connect('scraped_data.db') 3# ...테이블 생성, 데이터 삽입... 4conn.close()

팀원과 공유하려면 Excel이나 Google Sheets가 가장 편리해요.

파이썬 웹 스크래핑의 법적·윤리적 고려사항

웹 스크래핑은 강력하지만, 반드시 지켜야 할 규칙이 있습니다.

- 공개 데이터만 수집: 로그인이나 유료 벽 뒤에 있는 데이터는 주의하세요.

- 이용약관 확인: 일부 사이트는 스크래핑을 금지합니다. 무시하면 차단 등 불이익이 있을 수 있습니다().

- robots.txt 준수: 법적 강제성은 없지만, 예의상 지키는 것이 좋습니다.

- 개인정보 수집 금지: GDPR, CCPA 등 개인정보 보호법을 위반하지 않도록 주의하세요.

- 서버 과부하 방지: 요청 간 딜레이를 두고, 야간 등 비혼잡 시간에 스크래핑하세요.

준수 체크리스트:

- 사이트의 ToS와 robots.txt를 확인하세요.

- 개인정보/민감 정보는 수집하지 마세요.

- 데이터 출처를 명확히 하세요.

- 서버에 과도한 부하를 주지 마세요.

법적 이슈에 대한 자세한 내용은 에서 확인할 수 있습니다.

파이썬 웹 스크래핑 문제 해결 & 실전 팁

웹 스크래핑은 항상 순탄하지 않아요. 이런 상황에 대비해보세요.

- HTTP 에러(403, 404, 429): User-Agent를 브라우저처럼 설정하고, 요청 속도를 조절하며, 에러를 예외 처리하세요.

- IP 차단: 대량 스크래핑 시 프록시나 IP 회전을 사용하되, 윤리적 한계를 넘지 않도록 주의하세요.

- CAPTCHA: CAPTCHA가 나오면 계속 진행할지 고민하세요. 우회 서비스도 있지만, 회색지대입니다.

- 사이트 구조 변경: 셀렉터를 견고하게 작성하고, None 체크, try/except로 예외를 처리하세요.

- 인코딩 문제: 항상 UTF-8을 사용하고, 엑셀/시트에서 결과를 확인하세요.

실전 팁:

- 모든 과정을 로그로 남기세요. 어디서 문제가 생겼는지 추적할 수 있습니다.

- 실패한 요청은 재시도(backoff) 로직을 추가하세요.

- 대량 작업 전, 소수 페이지로 테스트하세요.

- 추출 데이터 개수를 모니터링해, 갑자기 줄면 구조 변경을 의심하세요.

사이트 구조가 자주 바뀌어 매번 스크래퍼를 고치는 게 지겹다면, 의 AI가 자동으로 레이아웃 변화에 대응해줍니다.

Thunderbit의 AI 기반 접근법을 활용하면, 데이터 인사이트에 집중할 수 있습니다.

결론 & 핵심 요약

파이썬 웹 스크래핑은 비즈니스 사용자가 웹의 복잡한 데이터를 실질적으로 활용 가능한 구조로 바꿔주는 강력한 무기입니다. 오늘 다룬 핵심을 정리하면:

- 파이썬은 웹 스크래핑에 최적화된 언어로, 쉬운 문법과 강력한 라이브러리가 강점입니다.

- Requests + BeautifulSoup은 소규모/정적 작업에, Scrapy는 대규모 자동화에 적합합니다.

- Thunderbit는 AI로 누구나 쉽게 스크래핑할 수 있게 해줍니다. 코딩 없이, 복잡한 유지보수 없이, 원하는 데이터를 바로 얻을 수 있습니다.

- 동적 콘텐츠와 페이지네이션은 Selenium이나 Scrapy의 내장 기능으로 처리하세요.

- 데이터 저장은 CSV, 엑셀, 데이터베이스 등 비즈니스에 맞게 선택하세요.

- 법적·윤리적 기준을 지키며, 공개 데이터만 수집하고 사이트 규칙을 준수하세요.

- 견고한 스크래퍼 구축: 로그, 재시도, 모니터링을 습관화하세요. 혹은 Thunderbit의 AI에 맡기세요.

이제 직접 파이썬 스크래퍼를 만들어보거나, 코딩 없이 을 설치해 웹 데이터 추출의 편리함을 경험해보세요. 더 많은 팁과 심층 정보는 에서 확인할 수 있습니다.

자주 묻는 질문(FAQ)

1. 파이썬 웹 스크래핑은 합법인가요?

공개된 데이터를 수집하고, 사이트의 이용약관, robots.txt, GDPR 등 개인정보 보호법을 준수하면 합법입니다. 민감 정보나 개인정보는 피하고, 시작 전 반드시 규정을 확인하세요().

2. BeautifulSoup과 Scrapy의 차이점은?

BeautifulSoup은 가볍고 단일 페이지 파싱에 적합한 HTML 파서입니다. Scrapy는 여러 페이지 크롤링, 페이지네이션, 대량 데이터 내보내기에 특화된 프레임워크입니다. 간단한 스크립트는 BeautifulSoup, 대규모 프로젝트는 Scrapy를 추천합니다().

3. 자바스크립트 기반 사이트는 파이썬으로 어떻게 스크래핑하나요?

Selenium이나 Playwright로 브라우저를 자동화해 JS가 로드된 후 데이터를 추출하세요. 또는 네트워크 탭에서 API 호출을 찾아 Requests로 직접 요청할 수도 있습니다.

4. Thunderbit는 기존 파이썬 스크래핑 라이브러리와 무엇이 다른가요?

Thunderbit는 AI로 추출 필드 추천, 하위 페이지 처리, 레이아웃 변화 자동 대응 등 코딩 없이 데이터 수집이 가능합니다. 빠르고 유지보수 부담이 없는 점이 강점입니다().

5. 수집한 데이터를 팀과 공유하려면?

CSV나 엑셀로 내보내 쉽게 공유하거나, pandas로 데이터베이스에 저장하세요. Thunderbit는 Google Sheets, Airtable, Notion 등으로 바로 내보내거나 CSV/엑셀로 무료 다운로드할 수 있습니다.

즐거운 스크래핑 되시길 바랍니다! 항상 구조화되고 깔끔한 데이터로 비즈니스에 힘을 더하세요.