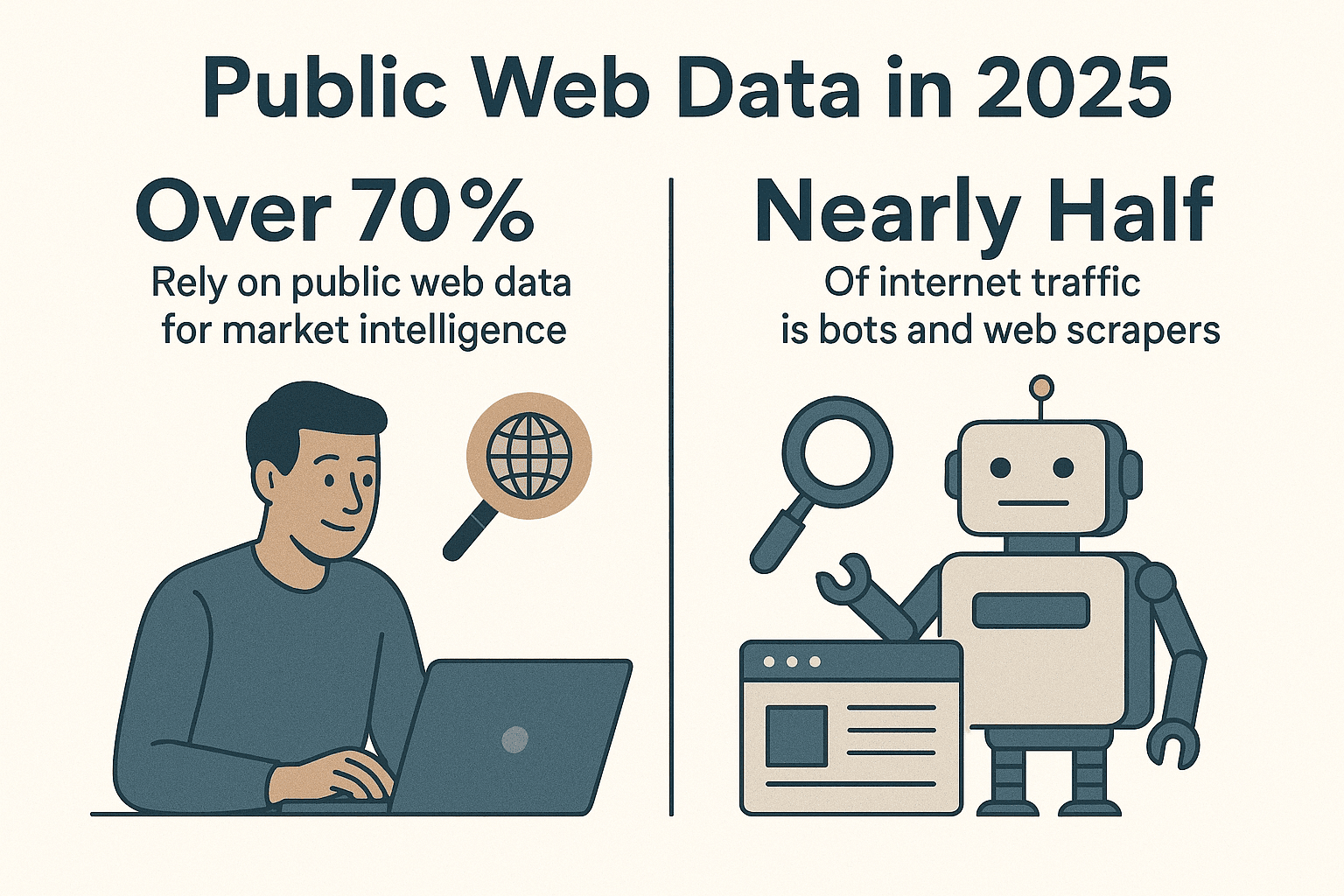

웹에는 엄청난 양의 데이터가 쏟아지고 있고, 기업들은 이 혼돈 속에서 인사이트를 뽑아내기 위해 치열하게 경쟁 중입니다. 실제로 하고 있으며, 현재 인터넷 트래픽의 절반 가까이가 사람보다 봇과 웹 스크래퍼가 차지하고 있습니다(). 수년간 자동화 도구를 만들어온 입장에서 말씀드리자면, 파이썬 웹 스파이더로 데이터 수집을 자동화하지 않는다면 엄청난 생산성 향상을 놓치고 있는 셈입니다.

파이썬은 웹 스크래핑 분야에서 사실상 표준 언어로 자리 잡았습니다. 영업, 마케팅, 운영, 리서치 등 어떤 분야든 잘 만든 파이썬 웹 스파이더 하나면 수많은 시간을 아끼고, 다른 방법으로는 얻기 힘든 인사이트를 얻을 수 있습니다. 이 글에서는 파이썬 웹 스파이더를 처음부터 효율적으로 만드는 방법, 추천 라이브러리와 실전 팁, 그리고 같은 도구로 복잡한 동적 사이트까지 손쉽게 다루는 방법을 소개합니다. 숙련된 개발자도 포기하고 싶어지는 사이트도 Thunderbit라면 걱정 없습니다.

파이썬은 웹 스크래핑 분야에서 사실상 표준 언어로 자리 잡았습니다. 영업, 마케팅, 운영, 리서치 등 어떤 분야든 잘 만든 파이썬 웹 스파이더 하나면 수많은 시간을 아끼고, 다른 방법으로는 얻기 힘든 인사이트를 얻을 수 있습니다. 이 글에서는 파이썬 웹 스파이더를 처음부터 효율적으로 만드는 방법, 추천 라이브러리와 실전 팁, 그리고 같은 도구로 복잡한 동적 사이트까지 손쉽게 다루는 방법을 소개합니다. 숙련된 개발자도 포기하고 싶어지는 사이트도 Thunderbit라면 걱정 없습니다.

왜 웹 스파이더에 파이썬을 선택해야 할까요?

파이썬은 웹 스크래핑 분야에서 독보적인 위치를 차지하고 있습니다. 최근 통계에 따르면 하며, 2024년에는 파이썬이 GitHub에서 자바스크립트를 제치고 가장 인기 있는 언어로 등극했습니다(). 데이터 사이언스와 자동화 분야에서의 강력함이 큰 역할을 했죠.

파이썬이 웹 스파이더에 적합한 이유는 다음과 같습니다:

- 가독성과 단순함: 파이썬 문법은 직관적이고 명확해서 초보자도 쉽게 시작할 수 있고, 숙련자도 빠르게 개발할 수 있습니다.

- 풍부한 라이브러리: , , , 등 다양한 라이브러리로 HTTP 요청, HTML 파싱, 브라우저 자동화까지 모두 지원합니다.

- 활발한 커뮤니티: 막히는 부분이 생기면 방대한 커뮤니티와 튜토리얼, 코드 예제가 언제든 도움을 줍니다.

- 유연성: 간단한 스크립트부터 대규모 크롤러까지, 파이썬은 어떤 규모에도 잘 맞습니다.

다른 언어와 비교해도 파이썬은 강력함과 접근성의 균형이 뛰어납니다. 자바스크립트(Node.js)는 동적 콘텐츠에 강하지만 비동기 프로그래밍이 진입장벽이 될 수 있고, Java나 C#은 견고하지만 코드가 복잡해집니다. 파이썬은 데이터에 집중할 수 있게 해줍니다.

파이썬 웹 스파이더 환경 세팅하기

웹 스파이더를 만들기 전, 환경을 제대로 갖추는 것이 중요합니다. 저의 기본 세팅 방법을 소개합니다:

1. 파이썬 3 설치

에서 최신 파이썬 3.x를 다운로드하거나, 운영체제 패키지 매니저를 사용하세요. 터미널에서 python 또는 python3 명령이 동작하는지 확인합니다.

2. 가상 환경 만들기

프로젝트별로 라이브러리를 분리하려면 가상 환경을 사용하세요:

1python3 -m venv .venv

2# Unix/Mac

3source .venv/bin/activate

4# Windows

5.venv\Scripts\activate이렇게 하면 패키지 충돌 없이 깔끔하게 관리할 수 있습니다.

3. 필수 라이브러리 설치

가상 환경을 활성화한 뒤, 주요 라이브러리를 설치합니다:

1pip install requests beautifulsoup4 lxml scrapy selenium pandas sqlalchemy각 라이브러리의 역할은 다음과 같습니다:

- Requests: HTTP로 웹페이지 가져오기

- BeautifulSoup: HTML 파싱 및 탐색

- lxml: 빠른 HTML/XML 파싱(BeautifulSoup과 함께 사용)

- Scrapy: 대규모 크롤링을 위한 프레임워크

- Selenium: 동적/자바스크립트 사이트 브라우저 자동화

- pandas: 데이터 정제 및 가공

- SQLAlchemy: 데이터베이스 저장

이제 간단한 스크립트부터 대규모 스파이더까지 모두 만들 준비가 되었습니다.

파이썬 웹 스파이더 라이브러리 선택법

파이썬에는 다양한 스크래핑 도구가 있습니다. 상황에 따라 적합한 도구를 고르는 방법을 정리했습니다:

| 라이브러리/도구 | 사용 난이도 | 속도 & 확장성 | 추천 사용처 |

|---|---|---|---|

| Requests + BeautifulSoup | 매우 쉬움 | 보통 (한 번에 한 페이지) | 초보자, 정적 페이지, 소규모 작업 |

| Scrapy | 약간 학습 필요 | 매우 빠름 (비동기, 동시 처리) | 대규모 크롤링, 전체 사이트 수집 |

| Selenium/Playwright | 보통 | 느림 (브라우저 오버헤드) | 자바스크립트/로그인 필요한 사이트 |

| aiohttp + asyncio | 보통 (비동기) | 매우 빠름 (동시 다수 URL) | 대량 정적 데이터 수집 |

| Thunderbit (노코드) | 가장 쉬움 (AI 기반) | 빠름 (클라우드/로컬) | 비개발자, 동적 사이트, 빠른 결과 |

실전 팁:

- 정적 페이지 몇 개만 필요하다면 Requests + BeautifulSoup이 가장 간단합니다.

- 수백~수천 페이지, 크롤링 기능이 필요하다면 Scrapy가 적합합니다.

- 무한 스크롤, 로그인 등 브라우저가 필요한 경우 Selenium이나 Playwright를 사용하세요.

- "코딩 없이 지금 당장 데이터가 필요하다"면 이 최고의 선택입니다.

파이썬 웹 스파이더 기본 예제: 단계별 따라하기

Hacker News에서 기사 제목을 수집하는 간단한 스파이더를 만들어보겠습니다. 웹 스크래핑의 "Hello World"라고 할 수 있죠.

1. 웹페이지 가져오기

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content2. HTML 파싱하기

1soup = BeautifulSoup(html_content, "html.parser")3. 데이터 추출하기

1articles = soup.find_all("tr", class_="athing")

2for article in articles:

3 title_elem = article.find("span", class_="titleline")

4 title = title_elem.get_text()

5 link = title_elem.find("a")["href"]

6 print(title, "->", link)4. 페이지네이션 처리

Hacker News 하단의 "More" 링크를 따라가며 여러 페이지를 수집할 수 있습니다:

1import time

2page_url = url

3while page_url:

4 resp = requests.get(page_url)

5 soup = BeautifulSoup(resp.text, 'html.parser')

6 # (위와 같이 기사 추출)

7 next_link = soup.find("a", class_="morelink")

8 if next_link:

9 page_url = requests.compat.urljoin(resp.url, next_link["href"])

10 time.sleep(1) # 서버에 부담 주지 않기!

11 else:

12 page_url = None5. 예외 처리와 매너 지키기

- 항상

response.status_code를 확인하세요. time.sleep()으로 서버에 과도한 요청을 피하세요.- User-Agent를 명확히 설정하세요:

1headers = {"User-Agent": "MyWebSpider/0.1 (+your_email@example.com)"}

2requests.get(url, headers=headers)이 기본 스파이더는 거의 모든 정적 사이트에 응용할 수 있습니다. 더 복잡한 작업이 필요하다면 Scrapy로 한 단계 업그레이드해보세요.

Scrapy로 스파이더 고도화하기

스크래핑 규모가 커지면 Scrapy가 진가를 발휘합니다. 시작 방법은 다음과 같습니다:

1. Scrapy 프로젝트 생성

1scrapy startproject myspider2. 스파이더 생성

myspider/spiders/quotes_spider.py 파일에 다음과 같이 작성합니다:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get(),

10 'tags': quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)3. 스파이더 실행

1scrapy crawl quotes -o quotes.jsonScrapy는 여러 페이지를 자동으로 크롤링하고, 동시 처리, 링크 추적, 데이터 내보내기까지 최소한의 코드로 처리해줍니다.

Scrapy의 장점:

- 동시성, 속도 제한, 매너 크롤링 기본 지원

- robots.txt 자동 준수

- 데이터 파이프라인 및 내보내기 간편

- 소규모부터 대규모까지 확장 가능

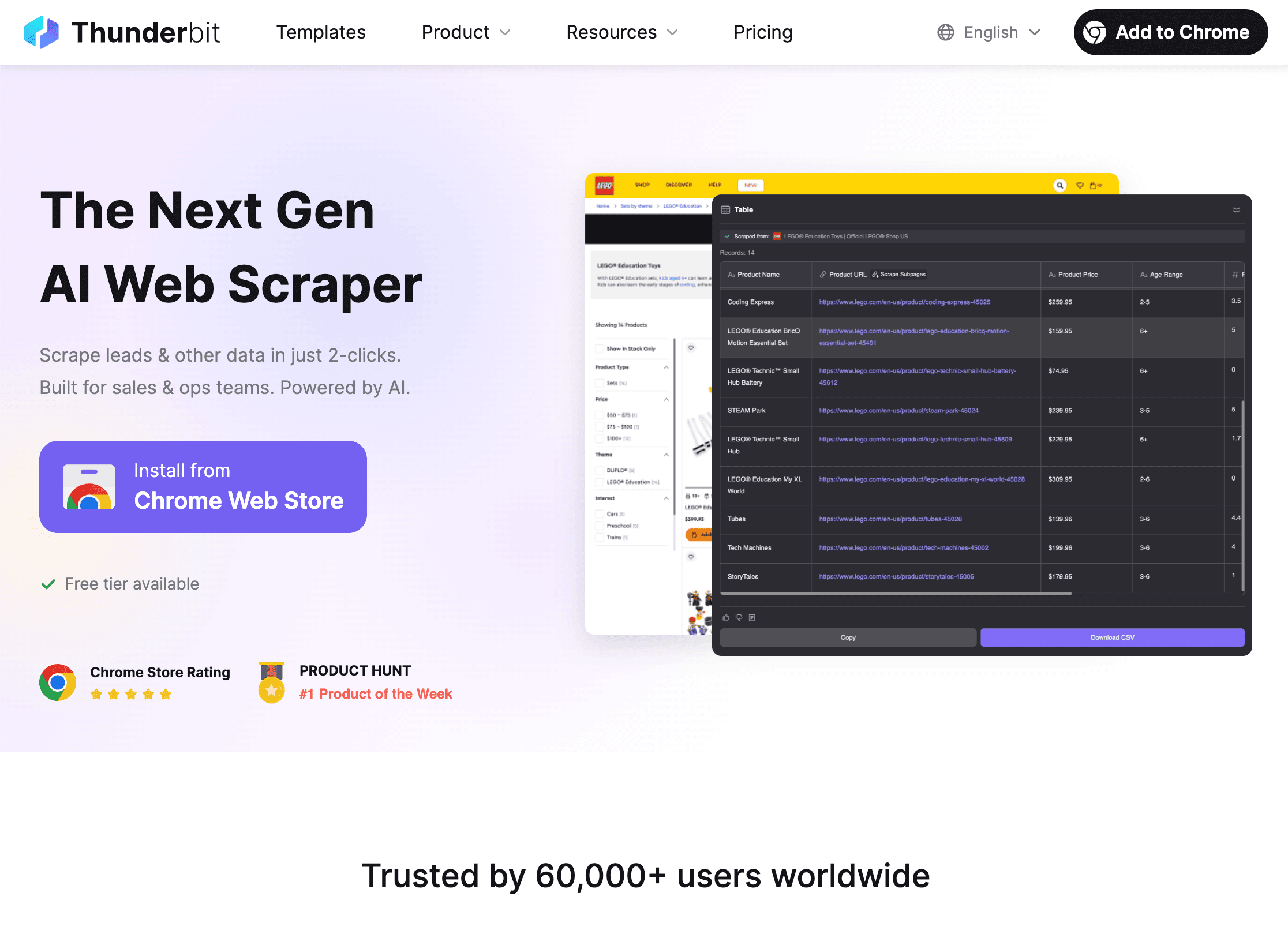

Thunderbit로 파이썬 웹 스파이더 한계 극복하기

이제 동적 웹사이트라는 난관을 이야기해볼 차례입니다. 파이썬만으로는 자바스크립트, 반봇 시스템, 자주 바뀌는 레이아웃 등 골치 아픈 사이트가 많죠. 이럴 때 가 빛을 발합니다.

Thunderbit만의 강점은?

- AI 필드 추천: 에서 "AI 필드 추천"을 클릭하면, AI가 추출할 데이터를 자동으로 제안해줍니다. HTML 구조나 셀렉터를 직접 볼 필요가 없습니다.

- 서브페이지 추출: 상세 페이지(예: 상품, 프로필 등)까지 자동으로 따라가 데이터를 한 번에 수집합니다.

- 동적 콘텐츠 완벽 지원: 실제 브라우저에서 동작하므로 자바스크립트, 무한 스크롤, 폼 자동 입력(AI Autofill)까지 문제없이 처리합니다.

- 노코드, 자연어 지원: "이 페이지에서 모든 채용공고와 위치를 추출해줘"처럼 말로만 설명하면 Thunderbit가 알아서 처리합니다.

- 즉시 데이터 내보내기: CSV, Excel, Google Sheets, Airtable, Notion 등으로 자유롭게 내보낼 수 있습니다.

- 정기 스크래핑: "매일 오전 9시"처럼 예약 작업을 설정하면, 최신 데이터를 자동으로 받아볼 수 있습니다.

Thunderbit와 파이썬의 환상적인 조합

제가 즐겨 쓰는 워크플로우는 이렇습니다:

- Thunderbit로 복잡하거나 동적인 사이트에서 데이터를 빠르게 추출합니다.

- CSV/Excel로 내보내기

- 파이썬(pandas)에서 불러와 데이터 정제, 분석, 추가 자동화를 진행합니다.

즉, Thunderbit가 복잡한 추출을 맡고, 파이썬이 데이터 가공과 자동화를 담당하는 최고의 조합입니다.

Thunderbit와 파이썬 웹 스파이더, 언제 각각 쓸까?

- Thunderbit: 비개발자, 동적 사이트, 빠른 일회성 작업, 현업 사용자가 직접 데이터 추출할 때

- 파이썬: 맞춤 로직, 대규모/정기 크롤링, 시스템 연동이 필요할 때

- 둘 다: Thunderbit로 추출, 파이썬으로 분석 및 자동화. 저는 이 조합을 "땅콩버터와 잼" 전략이라 부릅니다. 따로도 좋지만, 함께 쓰면 더 강력합니다.

하이브리드 워크플로우에 대해 더 알고 싶다면 을 참고하세요.

합법적이고 윤리적으로 웹 스크래핑하기

웹 스크래핑은 강력하지만, 그만큼 책임도 따릅니다. 법적 문제나 사이트 관리자에게 항의 메일을 받지 않으려면 다음을 지켜야 합니다:

1. robots.txt 준수

대부분의 사이트는 robots.txt 파일로 크롤링 허용 범위를 명시합니다. 파이썬에서 확인하는 방법:

1import urllib.robotparser

2rp = urllib.robotparser.RobotFileParser()

3rp.set_url("http://www.example.com/robots.txt")

4rp.read()

5if not rp.can_fetch("*", "http://www.example.com/target-page"):

6 print("robots.txt에서 스크래핑이 금지된 페이지입니다.")Scrapy는 기본적으로 robots.txt를 따릅니다(ROBOTSTXT_OBEY=True).

2. 매너 지키기

- 요청 간 딜레이(

time.sleep()또는 Scrapy의DOWNLOAD_DELAY)를 꼭 사용하세요. - User-Agent에 연락처 등 정보를 명확히 남기세요.

- 개인정보나 보호된 데이터는 수집하지 마세요.

- 사이트에서 차단하거나 중단 요청이 오면 즉시 중지하세요.

3. 속도 제한 및 CAPTCHA 대응

- 429(요청 과다) 오류가 발생하면 속도를 줄이거나 프록시를 사용하세요.

- CAPTCHA를 무리하게 우회하지 마세요. CAPTCHA가 뜨면 잠시 멈추는 것이 좋습니다.

스크래핑 윤리와 컴플라이언스에 대해 더 알고 싶다면 을 참고하세요.

파이썬으로 데이터 정리 및 저장하기

데이터를 수집했다면, 이제 정제·가공·저장 단계가 필요합니다. 저의 실전 방법을 소개합니다:

1. pandas로 데이터 정제 및 변환

1import pandas as pd

2df = pd.DataFrame(scraped_data)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df = df.dropna()2. CSV 또는 Excel로 내보내기

1df.to_csv('output.csv', index=False)

2df.to_excel('output.xlsx', index=False)3. SQLAlchemy로 데이터베이스 저장

1from sqlalchemy import create_engine

2engine = create_engine('sqlite:///scraped_data.db')

3df.to_sql(name='products', con=engine, if_exists='replace', index=False)이렇게 하면 스파이더에서 대시보드까지 데이터 파이프라인을 쉽게 구축할 수 있습니다.

데이터 파이프라인 자동화

정기 작업이 필요하다면 자동화하세요:

- 크론(cron) 작업: 파이썬 스크립트를 매일, 매시간 등 주기적으로 실행

- Apache Airflow: 복잡한 워크플로우는 Airflow로 스크래핑, 정제, 리포트까지 자동화

- Thunderbit 예약 스크래핑: Thunderbit에서 정기적으로 데이터 수집, 이후 파이썬 스크립트로 후처리

자세한 내용은 를 참고하세요.

파이썬 웹 스파이더 문제 해결 및 최적화

최고의 스파이더도 문제에 부딪힐 수 있습니다. 대표적인 이슈와 해결 팁을 정리했습니다:

- 403/429 차단: User-Agent 변경, 속도 조절, 프록시 사용, robots.txt 확인

- 데이터 누락: 셀렉터 재확인, HTML 구조 변경 여부 체크

- 동적 콘텐츠: 자바스크립트 사이트는 Selenium이나 Thunderbit 활용

- 성능 문제: 비동기(aiohttp)나 Scrapy 동시성 활용, 데이터는 점진적으로 저장

- 디버깅: 로그 출력, 브라우저 개발자 도구 활용, 결과값 꼼꼼히 확인

더 많은 팁은 에서 확인하세요.

결론 & 핵심 요약

효율적인 파이썬 웹 스파이더 구축은 시간 절약과 데이터 품질 향상에 큰 도움이 됩니다. 오늘 다룬 핵심을 정리하면:

- 파이썬은 웹 스파이더에 최적: 단순함, 라이브러리, 커뮤니티 모두 강력

- 가상환경과 필수 라이브러리(Requests, BeautifulSoup, Scrapy, Selenium, pandas, SQLAlchemy)로 환경 세팅

- 작업에 맞는 도구 선택: 소규모는 간단 스크립트, 대규모는 Scrapy, 동적 사이트는 Selenium, 노코드/AI는 Thunderbit

- 매너와 법 준수: robots.txt, 사이트 정책, 예의 지키기

- pandas, SQLAlchemy로 데이터 저장·가공, 파이프라인 자동화

- Thunderbit와 파이썬의 조합: AI로 추출, 파이썬으로 분석 및 자동화

웹 스크래핑을 한 단계 업그레이드하고 싶다면 로 복잡한 사이트도 손쉽게 다뤄보세요. 더 많은 실전 팁과 가이드는 에서 확인할 수 있습니다.

즐거운 스크래핑 되시길 바랍니다! 여러분의 스파이더가 항상 원하는 데이터를 가져오고, CAPTCHA에 걸리지 않길 기원합니다.

자주 묻는 질문(FAQ)

1. 파이썬이 웹 스파이더에 가장 적합한 언어인 이유는?

파이썬은 간결한 문법, 방대한 라이브러리(예: Requests, BeautifulSoup, Scrapy), 활발한 커뮤니티 덕분에 웹 스파이더를 쉽고 빠르게 개발·확장할 수 있습니다. 초보자도 접근하기 쉽고, 대규모 프로젝트에도 충분히 강력합니다.

2. 직접 파이썬 스파이더를 짜는 대신 Thunderbit를 써야 하는 경우는?

Thunderbit는 비개발자, 동적/자바스크립트 사이트, 빠른 데이터 수집이 필요할 때 최적입니다. 맞춤 로직, 대규모/정기 작업, 시스템 연동이 필요하다면 파이썬이 더 적합합니다. 많은 팀이 Thunderbit로 추출, 파이썬으로 분석하는 조합을 사용합니다.

3. 웹 스파이더의 합법성과 윤리성은 어떻게 지키나요?

항상 사이트의 robots.txt를 확인하고, 딜레이·User-Agent 등 매너를 지키며, 개인정보나 보호 데이터는 수집하지 마세요. 사이트에서 중단 요청이 오면 즉시 멈추세요. 자세한 내용은 참고.

4. 수집한 데이터를 저장·가공하는 최적의 방법은?

pandas로 데이터 정제·가공, CSV/Excel로 공유, SQLAlchemy로 데이터베이스(SQLite, PostgreSQL 등)에 저장하면 대규모·정기 데이터 관리에 유리합니다.

5. 웹 스크래핑 파이프라인을 자동화하려면?

크론(cron)이나 Apache Airflow로 파이썬 스크립트 예약 실행, Thunderbit의 예약 스크래핑과 파이썬을 연동해 완전 자동화 파이프라인을 구축할 수 있습니다.

실전 스크래핑 팁이 더 궁금하다면 와 에서 튜토리얼을 확인하세요.