웹에는 정말 쓸만한 데이터가 넘쳐나지만, 막상 직접 내려받으려면 쉽지 않은 경우가 많죠. 2025년 현재, 웹 스크래핑은 가격 모니터링, 채용, 부동산, 경쟁사 분석 등 거의 모든 업계에서 필수 역량이 됐어요. 그런데 Github에 웹 스크래핑 관련 프로젝트가 워낙 많다 보니, 뭘 골라야 할지 고민이 될 수밖에 없습니다. 어떤 건 완성도가 높고, 어떤 건 쓰기 어렵거나 몇 년째 방치된 것도 많거든요. 개발자가 아니라면 더더욱 선택이 어렵죠.

그래서 이번 글에서는 2025년 기준, Github에서 진짜 쓸만한 웹 스크래핑 프로젝트 15개만 엄선해 소개합니다. 단순히 리스트만 나열하는 게 아니라, 설치 난이도, 활용 분야, 동적 콘텐츠 지원, 유지보수 상태, 데이터 내보내기 방식, 그리고 실제로 어떤 사람에게 맞는지까지 꼼꼼하게 비교해드릴게요. 만약 코딩이 부담스럽다면, 처럼 AI 기반 노코드 툴이 비개발자와 비즈니스 사용자에게 얼마나 혁신적인지도 함께 살펴봅니다.

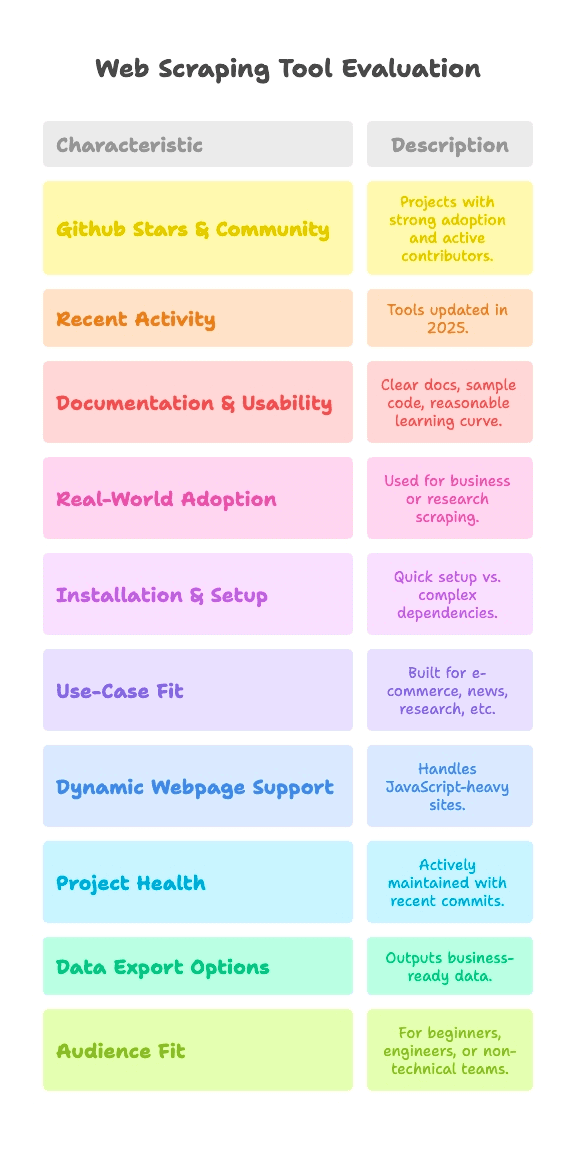

Github 웹 스크래핑 프로젝트 TOP 15 선정 기준

솔직히 말해서, Github에 올라온 모든 프로젝트가 다 똑같이 만들어진 건 아니죠. 수천 명이 검증한 프로젝트도 있고, 주말에 잠깐 만든 실험작도 있습니다. 이번 리스트는 아래 기준을 충족하는 프로젝트만 골랐어요:

- Github 스타 & 커뮤니티: 수천~9만 개 이상의 스타와 활발한 기여자들이 있는 프로젝트

- 최근 업데이트: 2025년에도 꾸준히 관리되는, 방치되지 않은 도구

- 문서화 & 사용성: 명확한 문서, 샘플 코드, 진입장벽이 낮은 학습 곡선

- 실제 활용 사례: 단순 데모가 아니라, 실제 비즈니스나 연구에 쓰이는 프로젝트

또한, 웹 스크래핑은 목적에 따라 필요한 기능이 다르기 때문에 각 프로젝트를 아래 기준으로 비교했습니다:

- 설치 및 세팅 난이도: 바로 시작할 수 있는지, 아니면 환경설정과 드라이버 설치가 필요한지

- 활용 분야: 이커머스, 뉴스, 연구 등 어떤 목적에 최적화되어 있는지

- 동적 웹페이지 지원: 최신 자바스크립트 기반 사이트도 스크래핑 가능한지

- 프로젝트 건강도: 최근까지 관리되고 있는지, 아니면 사실상 방치된 상태인지

- 데이터 내보내기: 비즈니스에 바로 쓸 수 있는 데이터로 내보낼 수 있는지, 아니면 HTML 원본만 추출하는지

- 추천 사용자: 파이썬 초보, 데이터 엔지니어, 비개발자 등 누구에게 적합한지

각 프로젝트별로 이런 기준을 한눈에 볼 수 있도록 태그를 달아뒀으니, 개발자든, 구글 시트로 데이터만 받고 싶은 분이든 자신에게 맞는 도구를 쉽게 찾으실 수 있습니다.

설치 및 세팅 난이도: 얼마나 빨리 스크래핑을 시작할 수 있을까?

웹 스크래퍼를 처음 써보는 분들이 가장 많이 막히는 부분이 바로 '설치'입니다. 난이도는 대략 이렇게 나눌 수 있어요:

- 플러그 앤 플레이(설정 거의 없음): 설치만 하면 바로 사용 가능. 입문자에게 딱 좋아요.

- 중간(커맨드라인, 간단한 코딩): 약간의 코딩이나 CLI 사용이 필요하지만, 스크립트 경험이 있다면 어렵지 않아요.

- 고급(드라이버, 안티봇, 심화 코딩): 환경설정, 브라우저 드라이버, 고급 파이썬/JS 실력이 필요합니다.

주요 프로젝트별 난이도는 아래와 같습니다:

- 플러그 앤 플레이: MechanicalSoup(파이썬), Nokogiri(루비), Maxun(배포 후 일반 사용자)

- 중간: Scrapy, Crawlee, Node Crawler, Selenium, Playwright, Colly, Puppeteer, Katana, Scrapling, WebMagic

- 고급: Heritrix, Apache Nutch(자바, 설정 파일, 빅데이터 환경 필요)

비개발자라면 '플러그 앤 플레이'나 노코드 옵션이 가장 편합니다. 그 외에는 어느 정도 코딩이 필요하지만, 너무 어렵진 않아요.

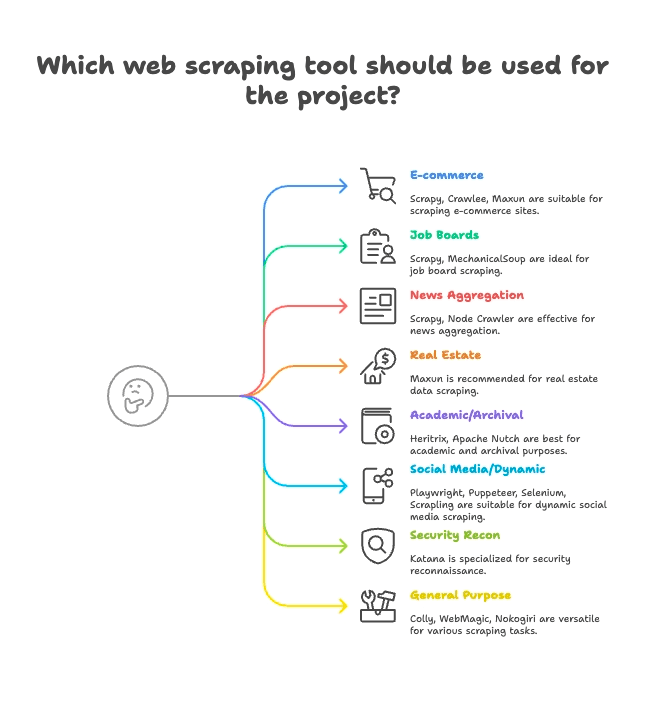

활용 분야별 그룹핑: 내 업종에 맞는 스크래퍼 찾기

모든 스크래퍼가 같은 목적에 맞춰 만들어진 건 아니에요. 주요 15개 프로젝트를 활용 분야별로 정리하면 아래와 같습니다:

이커머스 & 가격 모니터링

- Scrapy: 대규모, 다중 페이지 상품 스크래핑

- Crawlee: 정적/동적 이커머스 사이트 모두 지원

- Maxun: 노코드, 빠른 상품 리스트 추출에 강점

채용 사이트 & 구인구직

- Scrapy: 페이지네이션, 구조화된 리스트 처리

- MechanicalSoup: 로그인 필요한 채용 사이트에 적합

뉴스 & 콘텐츠 수집

- Scrapy: 대규모 뉴스 사이트 크롤링에 최적

- Node Crawler: 정적 뉴스 수집에 빠름

부동산

- Thunderbit: AI 기반 하위 페이지(상세정보)까지 자동 추출

- Maxun: 시각적 선택으로 부동산 데이터 추출

학술 연구 & 웹 아카이빙

- Heritrix: 전체 사이트 아카이빙(WARC 파일)

- Apache Nutch: 분산 크롤링, 연구 데이터셋 구축

소셜미디어 & 동적 콘텐츠

- Playwright, Puppeteer, Selenium: 동적 피드, 로그인 시뮬레이션

- Scrapling: 안티봇 방어가 강한 사이트 스텔스 스크래핑

보안 & 리서치

- Katana: 빠른 URL 탐색, 보안 크롤링

범용/멀티퍼포즈

- Colly: Go 기반 고성능 범용 스크래핑

- WebMagic: 자바 기반, 다양한 도메인에 유연하게 적용

- Nokogiri: 루비로 커스텀 파싱

동적 웹페이지 지원: 최신 사이트도 스크래핑 가능할까?

요즘 웹사이트는 자바스크립트로 꽉 차 있습니다. React, Vue, 무한 스크롤, AJAX 등 때문에, 단순히 HTML만 긁으면 데이터가 안 나오는 경우가 많죠.

각 프로젝트의 동적 콘텐츠 지원 여부는 아래와 같아요:

- 완전한 JS 지원(헤드리스 브라우저):

- Selenium: 실제 브라우저 제어, 모든 JS 실행

- Playwright: 멀티 브라우저, 멀티 언어, 강력한 JS 지원

- Puppeteer: 헤드리스 Chrome/Firefox, JS 완벽 렌더링

- Crawlee: HTTP/브라우저 모드 전환(Puppeteer/Playwright 연동)

- Katana: 옵션으로 헤드리스 모드 지원

- Scrapling: Playwright 연동, 스텔스 JS 스크래핑

- Maxun: 내부적으로 브라우저 사용, 동적 콘텐츠 지원

- JS 미지원(정적 HTML만):

- Scrapy: JS는 Selenium/Playwright 플러그인 필요

- MechanicalSoup, Node Crawler, Colly, WebMagic, Nokogiri, Heritrix, Apache Nutch: HTML만 추출, JS 미지원

Thunderbit의 AI는 여기서 진가를 발휘합니다. 별도 설정이나 플러그인 없이, 동적 콘텐츠를 자동으로 감지해 추출해주죠. 'AI 필드 추천'만 클릭하면 React 기반 사이트도 손쉽게 데이터로 만들 수 있습니다. 자세한 내용은 를 참고하세요.

프로젝트 건강도 & 신뢰성: 내년에도 쓸 수 있을까?

도구에 의존해서 워크플로우를 만들었는데, 갑자기 관리가 중단된다면 정말 난감하겠죠. 주요 프로젝트의 유지보수 현황은 아래와 같습니다:

- 활발한 유지보수(자주 업데이트):

- Scrapy:

- Crawlee:

- Playwright:

- Puppeteer:

- Katana:

- Colly:

- Maxun:

- Scrapling:

- 안정적이나 업데이트 느림:

- MechanicalSoup:

- Node Crawler:

- WebMagic:

- Nokogiri:

- 특화/느린 유지보수:

- Heritrix:

- Apache Nutch:

Thunderbit는 매니지드 서비스라서, 코드 방치 걱정이 없습니다. AI, 템플릿, 연동 기능이 항상 최신으로 유지되고, 온보딩, 튜토리얼, 지원팀까지 제공돼요.

데이터 처리 & 내보내기: 원시 HTML에서 비즈니스 데이터까지

데이터를 긁어오는 것만으로는 부족하죠. 팀에서 바로 쓸 수 있는 CSV, Excel, Google Sheets, Airtable, Notion, API 등 다양한 포맷이 필요합니다.

- 구조화된 내보내기 지원:

- Scrapy: CSV, JSON, XML 내보내기 내장

- Crawlee: 유연한 데이터셋, 스토리지

- Maxun: CSV, Excel, Google Sheets, JSON API

- Thunderbit:

- 수동 데이터 처리(직접 구현):

- MechanicalSoup, Node Crawler, Selenium, Playwright, Puppeteer, Colly, WebMagic, Nokogiri, Scrapling: 데이터 저장/내보내기 직접 코딩 필요

- 특화 내보내기:

- Heritrix: WARC(웹 아카이브 파일)

- Apache Nutch: 원본 콘텐츠 저장/색인

Thunderbit의 구조화된 내보내기와 다양한 연동 기능은 비즈니스 사용자에게 큰 시간 절약을 제공합니다. CSV 다루거나 별도 코드 작성할 필요 없이, 클릭 한 번이면 데이터가 바로 준비됩니다.

추천 사용자: 각 Github 웹 스크래핑 프로젝트는 누구에게 적합할까?

모든 도구가 모든 사람에게 맞는 건 아니에요. 각 프로젝트별 추천 사용자는 아래와 같습니다:

- 파이썬 입문자: MechanicalSoup, Scrapling(도전 정신 있다면)

- 데이터 엔지니어: Scrapy, Crawlee, Colly, WebMagic, Node Crawler

- QA & 자동화 전문가: Selenium, Playwright, Puppeteer

- 보안 연구자: Katana

- 루비 개발자: Nokogiri

- 자바 개발자: WebMagic, Heritrix, Apache Nutch

- 비개발자/비즈니스팀: Maxun, Thunderbit

- 그로스 해커, 데이터 분석가: Maxun, Thunderbit

코딩이 익숙하지 않거나, 빠른 결과가 필요하다면 Thunderbit와 Maxun이 가장 좋은 선택입니다. 그 외에는 자신의 언어와 목적에 맞는 도구를 고르세요.

Github 웹 스크래핑 TOP 15 프로젝트: 상세 비교

각 프로젝트를 활용 분야별로, 주요 특징과 함께 살펴봅니다.

이커머스, 가격 모니터링, 범용 크롤링

— 57,100+ 스타, 2025년 6월 업데이트

- 요약: 대규모 크롤링/스크래핑에 특화된 비동기 파이썬 프레임워크

- 설치: 중간(파이썬 코딩, 비동기 프레임워크)

- 활용: 이커머스, 뉴스, 연구, 다중 페이지 크롤링

- JS 지원: 기본 미지원(플러그인 필요)

- 유지보수: 활발

- 데이터 내보내기: CSV, JSON, XML 내장

- 추천: 개발자, 데이터 엔지니어

- 특징: 확장성, 견고함, 다양한 플러그인. 입문자에겐 진입장벽 있음.

— 17,900+ 스타, 2025년

- 요약: 정적/동적 웹 스크래핑을 모두 지원하는 Node.js 라이브러리

- 설치: 중간(Node/TS 코딩)

- 활용: 이커머스, 소셜미디어, 자동화

- JS 지원: 예(Puppeteer/Playwright 연동)

- 유지보수: 매우 활발

- 데이터 내보내기: 유연한 데이터셋, 스토리지

- 추천: JS/TS 개발팀

- 특징: 안티블로킹 툴킷, HTTP/브라우저 모드 전환 쉬움

— 13,000+ 스타, 2025년 6월

- 요약: 시각적 UI를 제공하는 오픈소스 노코드 웹 데이터 추출 플랫폼

- 설치: 중간(서버 배포), 쉬움(일반 사용자)

- 활용: 범용, 이커머스, 비즈니스 스크래핑

- JS 지원: 예(내부 브라우저 사용)

- 유지보수: 활발, 성장 중

- 데이터 내보내기: CSV, Excel, Google Sheets, JSON API

- 추천: 비개발자, 분석가, 팀

- 특징: 포인트 앤 클릭 방식, 다단계 네비게이션, 자체 호스팅 가능

채용 사이트, 구인구직, 간단한 상호작용

— 4,800+ 스타, 2024년

- 요약: 폼 제출, 간단한 네비게이션 자동화용 파이썬 라이브러리

- 설치: 플러그 앤 플레이(파이썬, 최소 코드)

- 활용: 로그인 필요한 채용 사이트, 정적 사이트

- JS 지원: 미지원

- 유지보수: 안정적, 가끔 업데이트

- 데이터 내보내기: 내장 없음(직접 구현)

- 추천: 파이썬 입문자, 간단 스크립트

- 특징: 브라우저 세션을 몇 줄로 시뮬레이션. 동적 사이트엔 부적합.

뉴스 집계 & 정적 콘텐츠

— 6,800+ 스타, 2024년

- 요약: Cheerio 파싱을 지원하는 빠르고 동시성 높은 서버 크롤러

- 설치: 중간(Node 콜백/비동기)

- 활용: 뉴스, 고속 정적 스크래핑

- JS 지원: 미지원(HTML만)

- 유지보수: 중간 활동(v2 베타)

- 데이터 내보내기: 내장 없음(직접 구현)

- 추천: Node.js 개발자, 고동시성 필요 시

- 특징: 비동기 크롤링, 속도 제한, jQuery 유사 API

부동산, 리스트, 하위 페이지 스크래핑

- 요약: 비즈니스 사용자를 위한 AI 기반 노코드 웹 스크래퍼

- 설치: 플러그 앤 플레이(크롬 확장, 2번 클릭)

- 활용: 부동산, 이커머스, 영업, 마케팅, 모든 웹사이트

- JS 지원: 예(AI가 동적 콘텐츠 자동 감지)

- 유지보수: 지속적 업데이트, 매니지드 서비스

- 데이터 내보내기: 원클릭 Sheets, Airtable, Notion, CSV, JSON

- 추천: 비개발자, 비즈니스팀, 영업, 마케팅

- 특징: AI 필드 추천, 하위 페이지 스크래핑, 즉시 내보내기, 온보딩, 템플릿,

학술 연구 & 웹 아카이빙

— 3,000+ 스타, 2023년

- 요약: Internet Archive의 대규모 웹 아카이빙 크롤러

- 설치: 고급(자바 앱, 설정 파일)

- 활용: 웹 아카이빙, 도메인 전체 크롤링

- JS 지원: 미지원(HTML만)

- 유지보수: 느리지만 유지

- 데이터 내보내기: WARC(웹 아카이브 파일)

- 추천: 아카이브, 도서관, 기관

- 특징: 확장성, 견고함, 표준 준수. 타겟 스크래핑엔 부적합.

— 3,000+ 스타, 2024년

- 요약: 빅데이터, 검색엔진용 오픈소스 크롤러

- 설치: 고급(자바+하둡 등)

- 활용: 검색엔진 크롤링, 빅데이터

- JS 지원: 미지원(HTTP만)

- 유지보수: 활발(Apache)

- 데이터 내보내기: 원본 콘텐츠 저장/색인

- 추천: 엔터프라이즈, 빅데이터, 학술 연구

- 특징: 플러그인 아키텍처, 분산 크롤링

소셜미디어, 동적 콘텐츠, 자동화

— 약 30,000+ 스타, 2025년

- 요약: 모든 주요 브라우저 지원, 스크래핑 및 테스트용 브라우저 자동화

- 설치: 중간(드라이버, 멀티언어)

- 활용: JS 기반 사이트, 테스트 플로우, 소셜미디어

- JS 지원: 예(실제 브라우저 자동화)

- 유지보수: 활발, 성숙

- 데이터 내보내기: 내장 없음(직접 구현)

- 추천: QA 엔지니어, 개발자

- 특징: 멀티언어, 실제 사용자 행동 시뮬레이션

— 73,500+ 스타, 2025년

- 요약: 최신 웹 자동화, 스크래핑 및 E2E 테스트용

- 설치: 중간(멀티언어 스크립팅)

- 활용: 최신 웹앱, 소셜미디어, 자동화

- JS 지원: 예(헤드리스/실제 브라우저)

- 유지보수: 매우 활발

- 데이터 내보내기: 내장 없음(직접 구현)

- 추천: 강력한 브라우저 제어가 필요한 개발자

- 특징: 크로스 브라우저, 자동 대기, 네트워크 인터셉션

— 90,900+ 스타, 2025년

- 요약: Chrome/Firefox 자동화용 고수준 API

- 설치: 중간(Node 스크립팅)

- 활용: 헤드리스 Chrome 스크래핑, 동적 콘텐츠

- JS 지원: 예(Chrome/Firefox)

- 유지보수: 활발(Chrome 팀)

- 데이터 내보내기: 내장 없음(직접 구현)

- 추천: Node.js 개발자, 프론트엔드 전문가

- 특징: 풍부한 브라우저 제어, 스크린샷, PDF, 네트워크 인터셉션

— 5,400+ 스타, 2025년 6월

- 요약: 안티봇 기능이 강한 스텔스 고성능 스크래핑

- 설치: 중간(파이썬 코드)

- 활용: 스텔스 스크래핑, 안티봇, 동적 사이트

- JS 지원: 예(Playwright 연동)

- 유지보수: 활발, 최신

- 데이터 내보내기: 내장 없음(직접 구현)

- 추천: 파이썬 개발자, 해커, 데이터 엔지니어

- 특징: 스텔스, 프록시, 안티블로킹, 비동기

보안 리서치

— 13,800+ 스타, 2025년

- 요약: 보안, 자동화, 링크 탐색용 고속 웹 크롤러

- 설치: 중간(CLI 툴 또는 Go 라이브러리)

- 활용: 보안 크롤링, 엔드포인트 탐색

- JS 지원: 예(옵션 헤드리스 모드)

- 유지보수: 활발(ProjectDiscovery)

- 데이터 내보내기: 텍스트 출력(URL 리스트)

- 추천: 보안 연구자, Go 개발자

- 특징: 속도, 동시성, 헤드리스 JS 파싱

범용/멀티퍼포즈 스크래핑

— 24,300+ 스타, 2025년

- 요약: Go 기반의 빠르고 우아한 스크래핑 프레임워크

- 설치: 중간(Go 코드)

- 활용: 고성능, 범용 스크래핑

- JS 지원: 미지원(HTML만)

- 유지보수: 활발, 최근 커밋

- 데이터 내보내기: 내장 없음(직접 구현)

- 추천: Go 개발자, 성능 중시

- 특징: 비동기, 속도 제한, 분산 스크래핑

— 11,600+ 스타, 2023년

- 요약: Scrapy 스타일의 유연한 자바 크롤러 프레임워크

- 설치: 중간(자바, 간단 API)

- 활용: 자바 기반 범용 웹 스크래핑

- JS 지원: 미지원(확장 시 Selenium 연동 가능)

- 유지보수: 커뮤니티 주도

- 데이터 내보내기: 플러그인 파이프라인

- 추천: 자바 개발자

- 특징: 스레드 풀, 스케줄러, 안티블로킹

— 6,200+ 스타, 2025년

- 요약: 루비용 빠르고 안전한 HTML/XML 파서

- 설치: 플러그 앤 플레이(루비 젬)

- 활용: 루비 앱에서 HTML/XML 파싱

- JS 지원: 미지원(파싱 전용)

- 유지보수: 활발, 루비와 동행

- 데이터 내보내기: 내장 없음(루비로 직접 처리)

- 추천: 루비 개발자, Rails 개발자

- 특징: 속도, 표준 준수, 기본 보안

한눈에 보는 기능 비교표

아래는 주요 프로젝트와 Thunderbit의 기능을 한눈에 비교한 표입니다:

| Project | Setup Complexity | Use Case | JS Support | Maintenance | Data Export | Audience | Github Stars |

|---|---|---|---|---|---|---|---|

| Scrapy | Moderate | E-commerce, news | No | Active | CSV, JSON, XML | Devs, data engineers | 57.1k |

| Crawlee | Moderate | Versatile, automation | Yes | Very active | Flexible datasets | JS/TS dev teams | 17.9k |

| MechanicalSoup | Plug & Play | Static, forms | No | Mature | None (manual) | Python beginners | 4.8k |

| Node Crawler | Moderate | News, static | No | Moderate | None (manual) | Node.js devs | 6.8k |

| Selenium | Moderate | JS-heavy, testing | Yes | Active | None (manual) | QA engineers, devs | ~30k |

| Heritrix | Advanced | Archival, research | No | Maintained | WARC | Archives, institutions | 3k |

| Apache Nutch | Advanced | Big data, search | No | Active | Raw content | Enterprises, research | 3k |

| WebMagic | Moderate | Java, general | No | Active community | Pluggable pipelines | Java devs | 11.6k |

| Nokogiri | Plug & Play | Ruby parsing | No | Active | None (manual) | Rubyists | 6.2k |

| Playwright | Moderate | Dynamic, automation | Yes | Very active | None (manual) | Devs, QA | 73.5k |

| Katana | Moderate | Security, discovery | Yes | Active | Text output | Security, Go devs | 13.8k |

| Colly | Moderate | High-perf, general | No | Active | None (manual) | Go devs | 24.3k |

| Puppeteer | Moderate | Dynamic, automation | Yes | Active | None (manual) | Node.js devs | 90.9k |

| Maxun | Easy (user) | No-code, business | Yes | Active | CSV, Excel, Sheets, API | Non-tech, analysts | 13k |

| Scrapling | Moderate | Stealth, anti-bot | Yes | Active | None (manual) | Python devs, hackers | 5.4k |

| Thunderbit | Plug & Play | No-code, business | Yes | Managed, updated | Sheets, Airtable, Notion | Non-tech, business users | N/A |

Thunderbit가 비개발자와 비즈니스 사용자에게 최고의 선택인 이유

대부분의 오픈소스 Github 프로젝트는 개발자를 위해, 개발자에 의해 만들어집니다. 즉, 설치, 유지보수, 문제 해결까지 스스로 해야 하죠. 비즈니스 사용자, 마케터, 영업팀, 혹은 단순히 결과만 빠르게 얻고 싶은 분이라면 Thunderbit가 정답입니다.

Thunderbit가 특별한 이유는 다음과 같습니다:

- 노코드, AI 기반의 간편함: 설치 후 'AI 필드 추천'만 클릭하면 바로 스크래핑 시작. 파이썬, 셀렉터, pip 설치 걱정 끝.

- 동적 페이지 완벽 지원: Thunderbit의 AI는 React, Vue, AJAX 등 최신 자바스크립트 사이트도 별도 설정 없이 데이터 추출

- 하위 페이지 스크래핑: 상품/리스트 상세정보까지 자동 클릭, 한 번에 테이블로 합치기. 별도 코드 불필요

- 비즈니스 맞춤 내보내기: Google Sheets, Airtable, Notion, CSV, JSON 등 원클릭 내보내기. 영업리드, 가격 모니터링, 콘텐츠 집계에 최적

- 지속적 업데이트 & 지원: Thunderbit는 매니지드 서비스로, 방치 걱정 없이 온보딩, 튜토리얼, 템플릿 라이브러리까지 제공

- 추천 사용자: Thunderbit는 비개발자, 비즈니스팀, 빠르고 신뢰성 있는 결과를 원하는 모든 분을 위한 도구입니다.

Thunderbit는 전 세계 3만 명 이상의 사용자가 신뢰하며, Accenture, Grammarly, Puma 등 다양한 팀에서 활용 중입니다. Product Hunt '이번 주의 제품' 1위에도 선정된 바 있습니다.

웹 스크래핑이 얼마나 쉬워질 수 있는지 직접 경험해보고 싶다면, .

결론: 2025년, 나에게 맞는 웹 스크래핑 솔루션 고르기

정리하자면, Github에는 강력한 스크래핑 도구가 가득하지만, 대부분은 개발자를 위한 설계입니다. 코딩을 즐긴다면 Scrapy, Crawlee, Playwright, Colly 같은 프레임워크가 최고의 자유도를 제공합니다. 학계나 보안 분야라면 Heritrix, Nutch, Katana가 적합하죠.

하지만 비즈니스 사용자, 분석가, 혹은 빠르고 구조화된 데이터를 원하는 분이라면 Thunderbit가 최고의 선택입니다. 설치, 유지보수, 코딩 없이 바로 결과를 얻을 수 있습니다.

이제 무엇을 할까요? 자신의 실력과 목적에 맞는 Github 프로젝트를 직접 시도해보거나, 학습 곡선을 건너뛰고 바로 결과를 보고 싶다면 해 오늘부터 스크래핑을 시작해보세요.

웹 스크래핑에 대해 더 깊이 알고 싶다면 에서 , 등 다양한 가이드를 참고하세요.

여러분의 데이터가 언제나 구조화되고, 깔끔하며, 바로 활용 가능하길 바랍니다. 혹시 막히는 일이 생기면, Github에 답이 있을 수도 있고… 아니면 Thunderbit의 AI가 대신 해결해줄 수도 있습니다.