2026년, 웹에는 엄청난 양의 데이터가 쏟아지고 있고, 이 혼란 속에서 비즈니스 기회를 잡으려는 경쟁은 그 어느 때보다 치열해졌어요. 영업, 이커머스, 운영팀이 반복되는 복사-붙여넣기 작업을 자동화하면서 일하는 방식이 완전히 달라지는 걸 직접 보고 있습니다. 이제 웹 데이터 스크래핑 소프트웨어 없이 일한다면, 경쟁사들은 여유롭게 커피 한 잔 더 마실 때도 당신은 여전히 엑셀에 갇혀 허덕이고 있을지 몰라요.

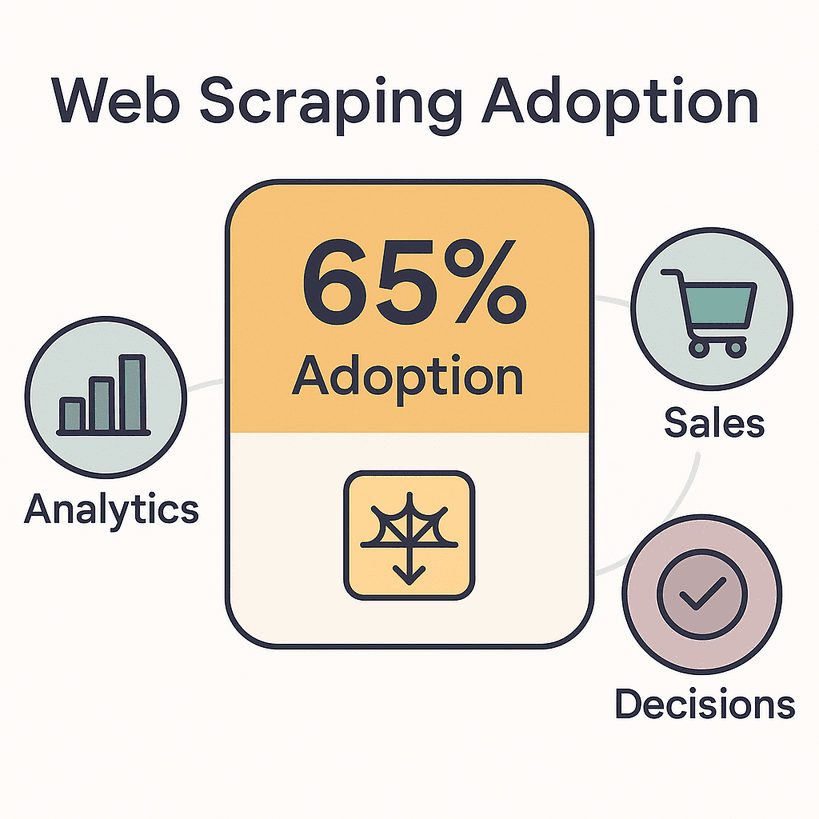

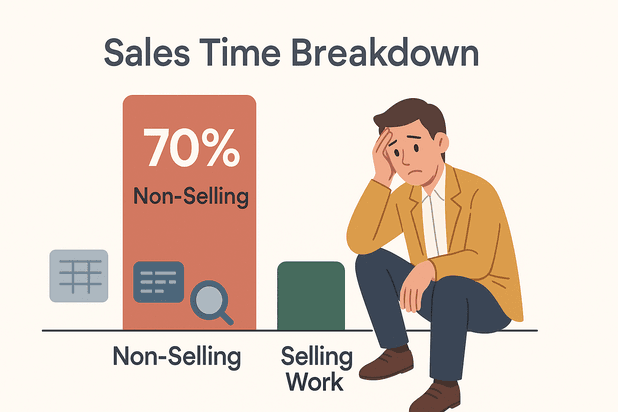

실제로 해서 분석, 영업, 의사결정에 필요한 데이터를 수집하고 있습니다. 전 세계 웹 데이터 추출 시장은 이미 규모를 넘었고, 2030년까지 두 배로 성장할 전망이에요. 영업 담당자들은 를 데이터 입력이나 조사 등 비영업 업무에 쓰고 있죠. 이 시간만 줄여도 더 많은 계약을 따내거나, 여유롭게 점심을 즐길 수 있을 거예요.

그렇다면 2026년, 진짜 쓸만한 웹 데이터 스크래핑 소프트웨어는 뭘까요? 다양한 규모와 기술 수준의 팀을 위해 혁신을 이끄는 상위 5개 툴을 꼼꼼하게 분석해봤어요. 코딩 몰라도 클릭 몇 번이면 끝나는 툴부터, 개발자에게 딱 맞는 유연한 솔루션까지 모두 소개합니다.

최고의 웹 데이터 스크래핑 소프트웨어, 어떤 기준으로 골라야 할까?

사실 모든 웹 스크래퍼가 똑같지는 않아요. 2026년 최고의 웹 데이터 스크래핑 소프트웨어는 빠르고, 신뢰할 수 있고, 누구나 쉽게 쓸 수 있어야 합니다. 파이썬 전문가만을 위한 도구가 아니라는 거죠.

제가 중요하게 보는 기준(그리고 실제 비즈니스 사용자들이 가장 신경 쓰는 부분)은 이렇습니다:

- 사용 편의성: 비전문가도 몇 분 만에 스크래핑을 시작할 수 있나요? 노코드, AI 기반 인터페이스는 이제 필수입니다.

- 데이터 소스 다양성: 웹페이지뿐 아니라 PDF, 이미지, 동적 콘텐츠(무한 스크롤, AJAX 등)도 지원하나요? 소스가 많을수록 활용도가 높아요.

- 자동화 및 스케줄링: 반복 작업 예약, 페이지네이션, 하위 페이지 자동 이동이 가능한가요? 자동화 수준이 곧 업무 효율입니다.

- 연동 및 내보내기: Excel, Google Sheets, Notion, Airtable, API 등으로 바로 내보낼 수 있나요? 수작업이 줄어들수록 팀이 더 만족하죠.

- 기술 요구 수준: 진짜 노코드인가요, 아니면 정규식 등 추가 학습이 필요한가요? 초보자와 고급 사용자 모두를 배려해야 해요.

- 확장성: 수백, 수천 페이지도 무리 없이 처리할 수 있나요?

- 지원 및 커뮤니티: 문서, 고객 지원, 사용자 커뮤니티가 잘 갖춰져 있나요?

이 기준들은 단순한 옵션이 아니라, 시간을 아껴주는 툴과 오히려 시간을 잡아먹는 툴을 가르는 핵심입니다. 2026년에는 에서 발생하는 만큼, 제대로 된 스크래퍼를 갖추는 게 경쟁력입니다.

이제, 상위 5개 툴을 살펴볼게요.

2026년 최고의 웹 데이터 스크래핑 소프트웨어 TOP 5

- : 노코드, AI 기반, 멀티 소스 스크래핑

- : 엔터프라이즈급 데이터 파이프라인 및 통합

- : 오픈소스, 개발자 중심의 유연성

- : 시각적, 노코드, 스케줄링 지원

- : 직관적, 클릭만으로 데이터 추출

1. Thunderbit: 가장 쉬운 AI 기반 웹 데이터 스크래핑 소프트웨어

은 코딩 없이 웹 데이터를 추출하고 싶은 분들에게 가장 먼저 추천하는 툴이에요. 저도 개발에 참여해서 애정이 남다르지만, Thunderbit는 결과에 집중하는 비즈니스 사용자를 위해 설계됐습니다.

Thunderbit만의 강점은?

- AI 필드 추천: “AI 필드 추천” 버튼만 누르면, Thunderbit의 AI가 페이지를 읽고 추출할 데이터를 자동으로 제안하고 설정까지 끝냅니다. 복잡한 셀렉터나 템플릿 없이 바로 시작할 수 있어요.

- 멀티 소스 스크래핑: 웹페이지뿐 아니라 PDF, 이미지에서도 데이터 추출이 가능합니다. 텍스트, 링크, 이메일, 전화번호, 이미지까지 두 번의 클릭이면 끝!

- 하위 페이지 & 페이지네이션 자동화: 상품 상세, 프로필 등 여러 하위 페이지의 정보도 링크를 따라가며 자동으로 수집하고, 표에 합쳐줍니다. 무한 스크롤, 페이지네이션도 손쉽게 처리해요.

- 배치 & 예약 스크래핑: URL 목록을 붙여넣고, 반복 작업을 예약하면 Thunderbit가 알아서 데이터를 모아줍니다. 일일 가격 모니터링, 주간 리드 업데이트 등 반복 업무에 딱이죠.

- 즉시 내보내기: Excel, Google Sheets, Airtable, Notion, CSV, JSON 등으로 바로 내보낼 수 있어 복사-붙여넣기에서 해방됩니다.

- 맞춤형 AI 프롬프트: 데이터 분류, 번역, 라벨링 등 원하는 작업을 AI에게 지시할 수 있습니다.

- 클라우드/브라우저 모드: 클라우드에서 빠르게(최대 50페이지 동시 처리) 실행하거나, 로그인 필요한 사이트는 로컬에서 실행할 수 있어요.

Thunderbit는 이 신뢰하는 툴로, 영업팀, 부동산 중개인, 소규모 이커머스까지 폭넓게 사용되고 있습니다. 무료 플랜으로 최대 6페이지(체험 부스트 시 10페이지)까지 스크래핑이 가능하고, 사용한 만큼만 결제(출력 행당 1크레딧)하는 방식이에요.

추천 이유: Thunderbit는 비전문가도 “이 데이터가 필요해”에서 “여기 내 스프레드시트!”까지 5분도 안 걸리는 유일한 툴입니다. 직관적인 인터페이스와, 웹사이트 구조가 바뀌어도 AI가 알아서 적응해주는 점이 특히 인상적이에요.

추천 대상: 영업, 이커머스, 운영 등 노코드, AI 기반, 유지보수 걱정 없는 스크래핑이 필요한 모든 분

더 많은 가이드가 궁금하다면 를 참고해보세요.

2. Import.io: 엔터프라이즈급 웹 데이터 스크래핑 및 통합

는 대규모 웹 데이터가 필요한 기업, 그리고 데이터를 비즈니스 시스템에 바로 연동해야 하는 조직에 최적화된 솔루션이에요.

Import.io의 차별점

- 엔터프라이즈 파이프라인: 단순한 스크래퍼가 아니라, 자동화된 데이터 파이프라인을 구축할 수 있는 통합 플랫폼입니다. 데이터 서비스(DAAS)처럼 지속적으로 데이터를 공급해요.

- AI 기반 자동 복구: 웹사이트 구조가 바뀌어도 AI가 필드를 자동으로 재매핑해, 데이터 파이프라인이 중단되지 않도록 지원합니다.

- 강력한 자동화: 시간 단위, 일 단위 등 원하는 주기로 스크래핑 예약이 가능하며, 이상 발생 시 알림도 받을 수 있어요.

- 복잡한 워크플로우 지원: 로그인, 폼 입력, 다단계 네비게이션 등 복잡한 사이트도 녹화/재생 기능으로 처리할 수 있습니다.

- 컴플라이언스 & 거버넌스: 개인정보 자동 감지, 마스킹, 감사 로그 등 규제 산업에 필수적인 기능을 제공합니다.

- API 및 연동: Google Sheets, Excel, Tableau, Power BI, 데이터베이스, 자체 앱 등으로 데이터 스트리밍이 가능합니다.

Import.io는 Unilever, Volvo, RedHat 등 글로벌 브랜드가 신뢰하는 툴로, 수천 개 이커머스 사이트의 가격 모니터링, 시장 정보 수집, AI/ML 모델 학습 데이터 공급 등에 활용되고 있어요.

가격: 셀프 서비스 플랜 기준 월 $299부터 시작하는 프리미엄 솔루션입니다. 무료 체험은 제공되지만, 장기 무료 플랜은 없어요. 웹 데이터가 핵심 자산이라면 투자할 가치가 충분합니다.

추천 대상: 신뢰성, 확장성, 컴플라이언스, 깊은 연동이 필요한 엔터프라이즈 및 데이터 중심 조직

3. Scrapy: 개발자를 위한 오픈소스 웹 스크래핑 프레임워크

는 개발자에게 최고의 유연성과 제어권을 제공하는 오픈소스 프레임워크입니다. 파이썬에 익숙하다면, Scrapy는 웹 스크래핑의 만능툴이라 할 수 있어요.

개발자가 Scrapy를 선호하는 이유

- 완전한 커스터마이징: 원하는 방식으로 크롤러(스파이더)를 작성해, 다중 페이지, 맞춤 로직, 복잡한 데이터 정제까지 모두 구현할 수 있습니다.

- 비동기 & 고속 처리: 수백~수천 페이지를 분당 처리할 수 있는 구조로, 대규모 분산 크롤링도 지원해요.

- 확장성: 프록시, 헤드리스 브라우저(Splash/Playwright), 다양한 연동 플러그인 등 방대한 생태계를 자랑합니다.

- 무료 & 오픈소스: 라이선스 비용 없이 자체 서버나 클라우드에서 자유롭게 확장 가능합니다.

- 커뮤니티 지원: 5만 5천 개 이상의 GitHub 스타와 대규모 사용자 커뮤니티가 있어, 문제 해결이 빠릅니다.

주의점: Scrapy는 파이썬 코딩과 커맨드라인 사용이 필수입니다. 클릭 한 번에 끝나는 UI는 없지만, 맞춤형 프로젝트, AI 학습 데이터, 대규모 크롤링에는 최고의 선택이에요.

추천 대상: 사내 개발자, 맞춤 데이터 파이프라인, 대규모/복잡한 스크래핑이 필요한 조직

4. Octoparse: 시각적으로 쉽게 배우는 웹 데이터 스크래핑

는 코딩 없이 강력한 스크래핑을 원하는 분들에게 인기 있는 시각적 툴입니다.

Octoparse가 인기인 이유

- 시각적 워크플로우 빌더: 내장 브라우저에서 요소를 클릭하면, 패턴을 자동 인식해 데이터 추출을 설정할 수 있어요. 코딩 없이 클릭만으로 작업이 가능합니다.

- 동적 콘텐츠 지원: AJAX, 무한 스크롤, 로그인 사이트 등도 클릭, 스크롤, 폼 입력 시뮬레이션으로 처리합니다.

- 클라우드 스크래핑 & 예약: 클라우드에서 빠르게 병렬 처리하며, 반복 작업 예약도 지원해요.

- 사전 제작 템플릿: Amazon, Twitter, Zillow 등 인기 사이트용 템플릿이 수백 개 제공되어 바로 시작할 수 있습니다.

- 내보내기 & API: CSV, Excel, JSON 다운로드 및 API 연동, Google Sheets, 데이터베이스 연동도 가능합니다.

Octoparse는 “초보자도 쉽게 쓸 수 있다”는 평가가 많고, 무료 플랜은 제한적이지만 월 $83부터 시작하는 유료 플랜에서 클라우드 실행, 예약 등 고급 기능을 제공합니다.

추천 대상: 비전문가, 마케터, 연구자, 소규모 팀 등 코딩 없이 정기적으로 데이터 수집이 필요한 분

5. ParseHub: 일상 업무에 딱 맞는 사용자 친화적 데이터 추출

는 소규모 비즈니스, 프리랜서 등 일상적인 데이터 작업을 자동화하고 싶은 분께 적합한 노코드 툴이에요.

ParseHub의 강점

- 클릭만으로 데이터 추출: 브라우저 화면에서 원하는 데이터를 클릭해 워크플로우를 시각적으로 구성할 수 있습니다. 코딩이 전혀 필요 없어요.

- JS & 동적 사이트 지원: 자바스크립트 기반 페이지, 무한 스크롤, 다단계 네비게이션도 문제없이 처리합니다.

- 클라우드/로컬 실행: 데스크톱 또는 클라우드에서 스크래핑을 실행할 수 있고, 상위 플랜에서는 API로 결과를 받아볼 수 있습니다.

- 다양한 내보내기: CSV, Excel, JSON 다운로드 및 API 연동 지원

- 크로스 플랫폼: Windows, Mac, Linux 모두 지원합니다.

ParseHub의 무료 플랜은 1회 200페이지로 제한되지만, 월 $189부터 시작하는 유료 플랜에서 더 많은 기능과 속도, API 연동이 가능합니다.

추천 대상: 소규모 비즈니스, 프리랜서, 간단한 스크래핑이 필요한 팀 등 직관적이고 신뢰할 수 있는 툴을 찾는 분

한눈에 보는 웹 데이터 스크래핑 소프트웨어 비교표

| 툴 | 사용 편의성 | 데이터 소스 | 자동화 & 예약 | 연동 및 내보내기 | 기술 요구 | 가격 |

|---|---|---|---|---|---|---|

| Thunderbit | 노코드, AI 기반 | 웹, PDF, 이미지 | 하위 페이지, 페이지네이션, 예약, 배치 | Excel, Sheets, Notion, Airtable, CSV, JSON | 없음 | 프리미엄(행당 결제) |

| Import.io | 클릭 기반 UI | 웹(정적/동적, 로그인) | 자동 복구, 예약, 알림 | API, BI툴, Sheets, Excel, DB | 낮음~중간 | $299+/월 |

| Scrapy | 코드 필요 | 웹, API, (JS는 추가 플러그인) | 코드 기반 완전 자동화 | 코드로 모든 연동 | 파이썬 개발자 | 무료(오픈소스) |

| Octoparse | 시각적, 노코드 | 웹(동적, 로그인) | 클라우드 예약, 템플릿 | CSV, Excel, JSON, API | 없음 | $83+/월 |

| ParseHub | 시각적, 노코드 | 웹(JS, 동적) | 클라우드/로컬, 예약 | CSV, Excel, JSON, API | 없음 | $189+/월 |

내 비즈니스에 맞는 웹 데이터 스크래핑 소프트웨어 고르는 법

어떤 툴이 내게 맞을지 고민된다면, 아래 요약을 참고하세요:

- 비전문가, 빠른 결과: 또는 추천! Thunderbit는 AI 기반 즉시 스크래핑과 멀티 소스 지원(웹, PDF, 이미지)에 강점. Octoparse는 시각적, 예약 스크래핑에 적합해요.

- 엔터프라이즈 통합, 컴플라이언스, 대규모: 가 최적. 신뢰성 높은 데이터 파이프라인과 깊은 연동을 제공합니다.

- 개발자, 맞춤 프로젝트, 대규모 크롤링: 가 정답. 파이썬 실력이 필요하지만, 무한한 유연성을 누릴 수 있어요.

- 소규모 비즈니스, 프리랜서, 일상 업무: 는 직관적이고, 클릭만으로 자동화가 가능한 실용적인 선택입니다.

툴 선택 팁:

- 팀의 기술 수준과 데이터 활용 목적에 맞춰 선택하세요.

- 스크래핑 대상 사이트의 복잡성(동적 콘텐츠, 로그인 등)을 고려하세요.

- 데이터를 어떻게 활용할지(시트로 바로 내보내기? API 연동?) 미리 생각해보세요.

- 무료 체험이나 프리미엄 플랜으로 실제 업무에 적용해보세요.

- 좋은 지원과 문서의 가치를 과소평가하지 마세요.

결론: 최고의 웹 데이터 스크래핑 소프트웨어로 비즈니스 가치를 높이세요

2026년, 웹 데이터는 더 똑똑한 비즈니스 결정을 위한 핵심 자원이에요. 제대로 된 웹 데이터 스크래핑 소프트웨어는 수작업 시간을 줄이고, 오류를 최소화하며, 팀에 실질적인 경쟁력을 제공합니다. 리드 리스트 구축, 경쟁사 모니터링, 분석 엔진 데이터 공급 등 다양한 업무에 활용할 수 있죠.

정리하자면:

- Thunderbit: 비즈니스 사용자를 위한 가장 쉬운 AI 기반 노코드 스크래퍼

- Import.io: 연속적이고 통합된 데이터 파이프라인이 필요한 엔터프라이즈 솔루션

- Scrapy: 완전한 제어와 유연성을 원하는 개발자용 오픈소스 툴킷

- Octoparse, ParseHub: 누구나 쉽게 접근할 수 있는 시각적, 노코드 스크래핑 툴

대부분의 툴이 무료 체험 또는 프리미엄 플랜을 제공하니, 직접 사용해보고 자동화의 효과를 경험해보세요. 반복 작업은 자동화하고, 새로운 인사이트를 발견하며, 팀이 더 중요한 일에 집중할 수 있도록 도와줍니다.

여러분의 데이터가 항상 신선하고, 구조화되어 있으며, 바로 활용할 수 있기를 바랍니다.

자주 묻는 질문(FAQ)

1. 웹 데이터 스크래핑 소프트웨어는 어떤 용도로 쓰이나요?

웹 데이터 스크래핑 소프트웨어는 웹사이트, PDF, 이미지 등에서 정보를 자동으로 추출합니다. 리드 생성, 가격 모니터링, 시장 조사, 콘텐츠 집계 등 다양한 업무에 활용돼요.

2. 웹 데이터 스크래핑은 합법인가요?

공개된 데이터를 수집하고, 사이트의 이용약관과 개인정보 보호법을 준수한다면 합법입니다. 항상 사이트 정책을 확인하고, 데이터를 책임감 있게 사용하세요.

3. 웹 데이터 스크래핑 소프트웨어를 쓰려면 코딩이 꼭 필요한가요?

꼭 그렇지 않아요! Thunderbit, Octoparse, ParseHub 등은 비전문가도 쉽게 사용할 수 있도록 설계됐어요. 복잡하거나 맞춤형 프로젝트에는 Scrapy 같은 개발자용 툴이 필요할 수 있습니다.

4. 추출한 데이터를 Excel이나 Google Sheets로 내보내려면?

대부분의 최신 스크래퍼(Thunderbit, Octoparse, ParseHub)는 클릭 한 번으로 Excel, Google Sheets, CSV로 내보내거나, Notion, Airtable과 직접 연동할 수 있습니다.

5. 동적 사이트나 로그인 페이지도 스크래핑이 가능한가요?

네, Import.io, Octoparse, ParseHub 등 주요 툴은 AJAX, 무한 스크롤 등 동적 콘텐츠와 로그인 보호 사이트도 지원합니다. Thunderbit 역시 동적 페이지와 하위 페이지 스크래핑을 지원해요.

최신 웹 스크래핑이 궁금하다면 을 설치하거나, 에서 더 많은 팁과 튜토리얼, AI 기반 데이터 추출 노하우를 확인해보세요.