2025년의 웹 환경은 정말 말 그대로 혼돈의 시대입니다. 이제는 웹 트래픽의 절반 가까이가 사람이 아닌 봇에서 나오고 있죠. 실제로 가 자동화 프로그램에서 발생하고 있고, 이에 맞서기 위한 안티봇 시스템도 점점 더 똑똑해지고 있습니다. 오랜 시간 자동화 도구와 웹 스크래퍼 워크플로우를 만들어온 입장에서, 유저 에이전트 하나만 잘못 골라도 데이터 수집 프로젝트가 순식간에 막힐 수 있다는 걸 너무 잘 압니다. 영업, 이커머스, 운영팀 입장에서는 웹사이트 차단이 단순한 불편을 넘어서 리드 손실, 가격 정보 누락, 매출 감소로 이어질 수밖에 없죠.

그래도 다행인 건, 복잡한 기술을 몰라도 이 문제를 충분히 해결할 수 있다는 점입니다. 이 글에서는 왜 유저 에이전트 전략이 웹 스크래핑 성공의 핵심이 됐는지, 사람들이 자주 하는 실수는 뭔지, 그리고 가 어떻게 유저 에이전트 관리를 자동화해주는지 쉽게 풀어드립니다. 리드 수집, 상품 모니터링, 스프레드시트 최신화 등 어떤 목적이든, 이 가이드만 따라오면 한발 앞서갈 수 있습니다.

왜 스크래핑에 유저 에이전트가 그렇게 중요할까?

먼저 기본부터 짚고 넘어가야겠죠. 유저 에이전트가 뭘까요? 쉽게 말해, 브라우저의 신분증 같은 겁니다. 웹사이트에 접속할 때마다(사람이든 봇이든) 브라우저는 User-Agent라는 문자열을 요청 헤더에 담아 보냅니다. "저는 윈도우에서 크롬을 쓰고 있어요" 혹은 "아이폰의 사파리입니다"라고 자신을 소개하는 셈이죠(). 대표적인 크롬 유저 에이전트 예시는 아래와 같습니다:

1Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36웹사이트가 이 정보를 활용하는 목적은 크게 두 가지입니다.

- 적합한 콘텐츠 제공 (모바일/데스크톱 레이아웃 등)

- 봇 및 웹 스크래퍼 식별

만약 유저 에이전트에 “python-requests/2.28.1”이나 “Scrapy/2.9.0”처럼 봇임을 대놓고 드러내는 문자열이 있다면, "저는 봇이에요!"라고 이름표를 달고 다니는 거랑 다를 게 없습니다. 이런 값들은 사이트의 차단 리스트에 이미 올라가 있어서, 바로 403 Forbidden 에러를 받게 되죠. 반대로, 최신 브라우저의 일반적인 유저 에이전트를 쓰면 사람처럼 자연스럽게 접근할 수 있습니다.

즉, 유저 에이전트는 위장술입니다. 위장이 정교할수록 원하는 데이터를 얻을 확률이 높아집니다.

유저 에이전트가 웹 스크래핑 성공에 미치는 영향

유저 에이전트 선택이 왜 이렇게 중요할까요? 대부분의 안티봇 시스템이 제일 먼저 확인하는 게 바로 이 값이기 때문입니다. 잘못된 유저 에이전트를 쓰면 이런 일이 벌어질 수 있습니다:

- 즉시 차단(403/429 에러): 기본 스크래핑 라이브러리의 UA를 쓰면 홈페이지도 못 보고 막힙니다().

- 빈 페이지 또는 가짜 데이터: 의심스러운 UA에는 빈 페이지나 더미 데이터가 제공될 수 있습니다.

- CAPTCHA 또는 리디렉션: 봇으로 의심되면 "로봇이 아닙니까?" 챌린지나 무한 로그인 루프에 빠질 수 있습니다.

- 속도 제한 및 IP 차단: 같은 UA로 반복 요청하면 속도 제한이나 IP 차단이 걸릴 수 있습니다.

유저 에이전트별로 실제로 어떤 일이 벌어지는지 표로 한 번 볼까요?

| User Agent String | Outcome on Most Sites (2025) |

|---|---|

python-requests/2.28.1 | Blocked instantly, flagged as bot |

Scrapy/2.9.0 (+https://scrapy.org) | Blocked or served fake content |

Mozilla/5.0 (Windows NT 10.0; Win64; x64)... | Treated as real user, allowed access |

AhrefsBot/7.0 (+http://ahrefs.com/robot/) | Blocked, known crawler |

| Blank or gibberish UA | Sometimes allowed, often suspicious |

결론은 명확합니다. 위장을 신중하게 선택해야 합니다. 그리고 요즘 안티봇 시스템은 유저 에이전트만 보는 게 아니라, Accept-Language, Referer 등 다른 헤더와의 일관성도 꼼꼼히 체크합니다. 크롬이라고 주장하면서 관련 헤더가 빠지면 바로 들통나죠().

Thunderbit는 이런 문제를 아주 쉽게 해결해줍니다. 영업, 이커머스, 부동산 등 다양한 현업에서 복잡한 HTTP 헤더 공부 없이도 데이터를 쉽게 얻을 수 있도록, Thunderbit는 유저 에이전트 관리를 자동화하고 투명하게 처리합니다.

Thunderbit: 누구나 쉽게 유저 에이전트 관리

Thunderbit의 을 사용하면 유저 에이전트 선택에 신경 쓸 필요가 없습니다. Thunderbit의 AI 엔진이 각 사이트에 가장 자연스럽고 최신 브라우저 시그니처를 자동으로 적용해줍니다. 을 쓰면 실제 크롬의 UA를 그대로 사용하고, 클라우드 스크래핑에서는 최신 브라우저 UA 풀을 AI가 알아서 순환시킵니다.

유저 에이전트뿐만 아니라 Accept-Language, Accept-Encoding, Client Hints 등 모든 헤더도 실제 브라우저처럼 일관성 있게 전송합니다. 헤더 불일치로 인한 차단 걱정은 이제 끝입니다.

가장 좋은 점은? 설정할 게 아무것도 없다는 것! Thunderbit의 AI가 모든 기술적 디테일을 자동으로 처리하니, 사용자는 신뢰할 수 있는 고품질 데이터 확보에만 집중하면 됩니다.

왜 동적 유저 에이전트 순환이 필수인가?

완벽한 유저 에이전트를 찾았다고 해서 매번 똑같이 쓰면 될까요? 절대 아닙니다. 2025년에는 같은 UA로 반복 요청하는 게 바로 봇임을 드러내는 신호입니다. 실제 사용자는 다양한 브라우저, 버전, 기기를 쓰니까요. 한 사이트에 500번 연속 같은 UA로 접근하면, 누가 봐도 자동화 스크립트라는 걸 알 수밖에 없습니다.

그래서 동적 유저 에이전트 순환이 업계 표준이 됐습니다. 즉, 매 요청이나 세션마다 현실적인 최신 브라우저 UA를 번갈아 사용하는 거죠. 이렇게 하면 웹 스크래퍼가 여러 명의 실제 방문자처럼 보입니다().

Thunderbit의 AI 기반 순환 기능은 한 단계 더 진화했습니다. 여러 페이지를 크롤링하거나 예약 작업을 할 때, Thunderbit는 유저 에이전트와 프록시 IP까지 자동으로 조합해 순환합니다. 사이트가 의심스러운 행동을 감지하면, 실시간으로 UA를 바꾸거나 헤더를 조정하고, 요청 속도도 조절합니다. 이 모든 과정이 자동으로 진행되어, 차단 걱정 없이 안정적으로 데이터를 수집할 수 있습니다.

유저 에이전트와 요청 헤더: 일관성이 핵심

전문가 팁 하나! 유저 에이전트는 요청의 "지문" 중 일부일 뿐입니다. 최신 안티봇 시스템은 UA와 Accept-Language, Accept-Encoding, Referer 등 다른 헤더의 조합이 자연스러운지까지 확인합니다. 예를 들어, 윈도우 크롬이라고 하면서 뉴욕 IP에서 프랑스어 Accept-Language를 보내면 바로 의심받습니다().

실전 팁:

- 유저 에이전트와 일치하는 전체 헤더 세트를 항상 전송하세요.

- Accept-Language, Accept-Encoding은 UA 및 IP 지역과 맞추는 게 좋습니다.

- 브라우저 개발자 도구로 실제 요청의 전체 헤더를 확인해 참고하세요.

Thunderbit는 이 모든 과정을 자동화합니다. AI가 요청마다 UA, 헤더, 브라우저 지문까지 완벽하게 맞춰주니, 사용자는 신경 쓸 필요가 없습니다.

흔히 하는 실수: 유저 에이전트 사용 시 주의점

많은 웹 스크래핑 프로젝트가 비슷한 이유로 실패합니다. 대표적인 실수는 다음과 같습니다:

- 기본 스크래핑 라이브러리 UA 사용:

python-requests/2.x,Scrapy/2.9.0,Java/1.8등은 바로 차단됩니다. - 구버전 브라우저 UA 사용: 2025년에 Chrome 85라고 하면 바로 의심받습니다. 항상 최신 버전을 사용하세요.

- 헤더 불일치: 크롬 UA를 쓰면서 Accept-Language, Accept-Encoding, Client Hints가 빠지면 위험합니다.

- 봇/크롤러/스파이더 등 명시적 UA: "bot", "crawler", "spider" 또는 툴 이름이 들어간 UA는 무조건 차단 대상입니다.

- 빈 값 또는 의미 없는 UA: 가끔 통과되지만 신뢰성도 낮고 차단 위험이 높습니다.

안전한 유저 에이전트 체크리스트:

- 실제 최신 브라우저 UA(Chrome, Firefox, Safari 등) 사용

- 다양한 UA 풀을 순환 사용

- 헤더와 UA의 일관성 유지

- UA 리스트는 매달 최신화(브라우저 업데이트 주기 반영)

- 자동화 티가 나는 값은 피하기

Thunderbit 실전 적용: 영업 및 운영팀 활용 사례

실제 현장에서 Thunderbit의 유저 에이전트 관리가 어떻게 도움이 되는지 살펴볼까요?

| Use Case | Old Way: Manual Scraping | With Thunderbit | Result |

|---|---|---|---|

| Sales Lead Gen | Frequent blocks, missing data | AI picks best UA, rotates, mimics real browsing | More leads, higher quality, fewer bounces |

| Ecommerce Monitoring | Script breaks, IP bans | Cloud scraping with dynamic UA & proxy rotation | Reliable price/stock tracking |

| Real Estate Listings | Tedious tweaks, blocks | AI adapts UA/headers, handles subpages automatically | Complete, up-to-date property lists |

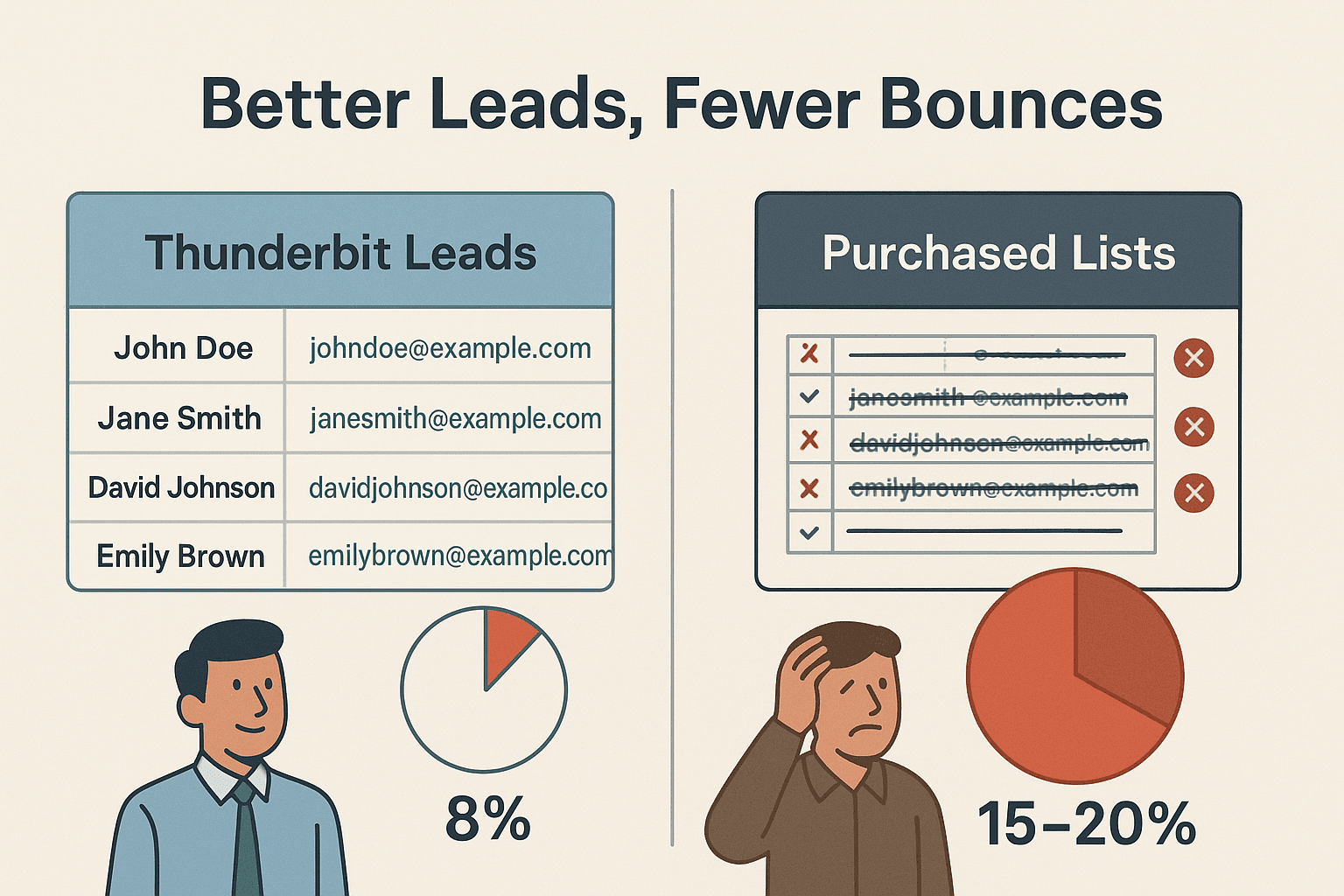

한 영업팀은 Thunderbit로 수천 개의 웹사이트에서 리드를 수집해 **이메일 반송률이 약 8%**에 불과했습니다. 이는 시중에서 구매한 리스트(15~20%)보다 훨씬 낮은 수치입니다(). 신선하고 사람 같은 스크래핑의 힘이죠.

따라하기: Thunderbit로 최적의 유저 에이전트로 스크래핑하는 방법

Thunderbit로 시작하는 방법은 정말 간단합니다. 별도의 기술 지식이 필요 없습니다:

- 설치

- 타겟 웹사이트 접속 (로그인이 필요한 경우에도 사용 가능)

- “AI 필드 추천” 클릭 – Thunderbit의 AI가 페이지를 분석해 추출할 컬럼을 제안합니다.

- 필드 검토 및 수정 – 필요에 따라 컬럼명 변경, 추가, 삭제 가능

- “스크래핑” 클릭 – Thunderbit가 유저 에이전트와 헤더를 자동으로 순환하며 데이터 추출

- 데이터 내보내기 – Excel, Google Sheets, Airtable, Notion 등으로 바로 전송하거나 CSV/JSON 다운로드

유저 에이전트 선택이나 업데이트는 신경 쓸 필요 없습니다. Thunderbit의 AI가 사이트별로 최적화해줍니다.

Thunderbit와 기존 유저 에이전트 관리 방식 비교

Thunderbit와 수동 방식의 차이를 한눈에 비교해보세요:

| Feature/Task | Manual Scraping Approach | Thunderbit Approach |

|---|---|---|

| User Agent Setup | Research & set in code | Automatic, AI-selected per site |

| Keeping UAs Updated | Manual, easy to forget | AI auto-updates with browser trends |

| UA Rotation | Code your own rotation logic | Built-in, intelligent rotation |

| Header Consistency | Manually match headers to UA | AI ensures full, consistent header set |

| Handling Blocks/CAPTCHAs | Manual swaps, high maintenance | AI adapts, retries, and rotates as needed |

| Technical Skill Needed | High (coding, HTTP knowledge) | None—designed for business users |

| Time Spent Troubleshooting | Frequent, frustrating | Minimal—focus on data, not scraping headaches |

Thunderbit는 기술적 부담 없이 누구나 신뢰할 수 있는 대규모 웹 스크래핑을 할 수 있도록 설계되었습니다.

핵심 요약: 미래에도 통하는 유저 에이전트 전략

2025년 유저 에이전트 관리에서 꼭 기억해야 할 점을 정리해볼게요:

- 기본값이나 구버전 UA는 절대 사용하지 마세요. 차단의 주범입니다.

- 유저 에이전트는 반드시 동적으로 순환하세요. 다양한 값이 자연스러움을 만듭니다.

- 헤더와 UA의 일관성을 유지하세요. UA만큼 동반 헤더도 중요합니다.

- 항상 최신 상태를 유지하세요. 브라우저 버전이 자주 바뀌니 UA 리스트도 주기적으로 갱신해야 합니다.

- 복잡한 부분은 AI에 맡기세요. Thunderbit 같은 도구는 모범 사례를 자동으로 적용해줍니다.

차단, 스크립트 오류, 반복적인 문제에 지치셨나요? . Thunderbit AI 웹 스크래퍼는 전 세계 수천 명이 신뢰하는 솔루션으로, 누구나 손쉽게 웹 데이터를 수집할 수 있도록 설계되었습니다.

더 많은 팁과 튜토리얼, 웹 스크래핑 심층 가이드는 에서 확인하세요.

자주 묻는 질문(FAQ)

1. 유저 에이전트란 무엇이며, 웹 스크래핑에서 왜 중요한가요?

유저 에이전트는 브라우저와 운영체제를 식별하는 문자열로, 모든 웹 요청에 포함됩니다. 사이트는 이를 통해 적합한 콘텐츠를 제공하고, 봇을 식별합니다. 올바른 유저 에이전트를 사용하면 웹 스크래퍼가 사람처럼 자연스럽게 보이고 차단을 피할 수 있습니다.

2. 스크래핑 라이브러리의 기본 유저 에이전트를 쓰면 안 되는 이유는?

python-requests/2.x와 같은 기본값은 이미 봇으로 널리 알려져 있어 즉시 차단됩니다. 항상 현실적인 최신 브라우저 UA를 사용하세요.

3. Thunderbit는 유저 에이전트 순환을 어떻게 처리하나요?

Thunderbit의 AI가 최신 브라우저 UA 풀을 자동으로 순환 적용해, 실제 다양한 사용자 트래픽처럼 보이게 만듭니다.

4. Thunderbit에서 Accept-Language나 Referer 같은 헤더를 직접 설정해야 하나요?

아니요! Thunderbit의 AI가 모든 헤더를 UA와 일치시켜 자동으로 전송하므로, 별도 설정이 필요 없습니다.

5. 그래도 사이트에서 차단되면 어떻게 되나요?

Thunderbit는 차단이나 CAPTCHA를 감지하면 실시간으로 UA와 헤더를 바꾸거나 재시도해, 사용자가 직접 문제를 해결할 필요가 없습니다.

더 똑똑하게 스크래핑하고 싶으신가요? 하고, 유저 에이전트 관리의 번거로움을 AI에게 맡겨보세요. 성공적인 스크래핑을 응원합니다!

더 알아보기