웹은 이제 전 세계에서 가장 방대한 데이터 놀이터가 됐어요. 그리고 솔직히 말해서, 우리 모두는 이 거대한 모래사장에서 최고의 모래성을 쌓으려고 경쟁 중이죠. 영업, 이커머스, 리서치, 혹은 저처럼 데이터에 진심인 사람이라면 웹 스크래핑이 똑똑한 의사결정과 빠른 업무 자동화의 핵심 무기라는 걸 이미 잘 아실 거예요. 2025년에는 기술 대기업뿐 아니라 하고 있고, 는 데이터 기반 의사결정이 비즈니스의 중심이라고 답했죠. 이 혁신의 한가운데에는 파이썬이 있습니다. 다양한 웹 스크래핑 라이브러리와 도구 덕분이죠.

저는 SaaS와 자동화 분야에서 오래 일하면서, 제대로 된 파이썬 스크래핑 도구 하나만 있으면 몇 시간 걸리던 일이 단 몇 분 만에 끝나는 걸 직접 경험했어요. 하지만 전통적인 라이브러리, 브라우저 자동화, 노코드 플랫폼, AI 기반 도구 등 선택지가 너무 많다 보니 뭘 골라야 할지 고민될 수밖에 없죠. 이 가이드에서는 입문자도 쉽게 쓸 수 있는 고전 라이브러리부터 같은 최신 AI 솔루션까지, 자동화를 위한 최고의 파이썬 웹 스크래핑 라이브러리 12가지를 소개합니다. 개발자, 운영 담당자, 혹은 데이터만 빠르게 얻고 싶은 비즈니스 사용자까지 모두에게 도움이 될 만한 정보만 쏙쏙 담았어요.

왜 파이썬 웹 스크래핑 도구 선택이 중요할까요?

현실적으로, 모든 웹 스크래핑 프로젝트가 똑같지는 않아요. 어떤 도구를 고르느냐에 따라 자동화된 데이터 파이프라인을 뚝딱 만들 수도 있고, 반대로 일주일 내내 오류 잡느라 고생할 수도 있죠. 실제로 한 리크루팅 에이전시는 리드 스크래핑을 자동화해서 3개월 만에 매출이 10배 뛰었고, 영업 담당자 한 명당 주 8시간을 아끼며 수천 건의 신규 리드를 확보했어요(). 반면, 동적 콘텐츠를 못 다루거나 봇 차단에 막히는 라이브러리를 골라 며칠을 허비하는 경우도 종종 봤습니다.

선택이 중요한 이유는 이렇습니다:

- 비즈니스 효과: 제대로 된 도구는 리드 생성, 가격 모니터링, 경쟁사 분석, 워크플로우 자동화 등 다양한 업무를 자동화해 영업, 이커머스, 리서치에서 경쟁력을 확실히 올려줍니다().

- 정적 vs 동적 데이터: 어떤 사이트는 단순 HTML이지만, 어떤 곳은 자바스크립트로 꽉 차 있어요. 동적 콘텐츠를 못 다루면 중요한 데이터를 놓칠 수밖에 없죠.

- 확장성과 안정성: 몇 페이지만 긁는다면 어떤 도구든 괜찮지만, 매일 수천 페이지를 크롤링하려면 Scrapy 같은 프레임워크나 클라우드 기반 솔루션이 필요합니다.

꿀팁: 해서 써요. 예를 들어, 정적 페이지는 Beautiful Soup, 동적 페이지는 Selenium을 조합하는 식이죠. 적절한 조합이 바로 비장의 무기입니다.

최고의 파이썬 웹 스크래핑 라이브러리 선정 기준

수많은 라이브러리와 플랫폼 중에서, 실제 비즈니스와 기술 사용자에게 중요한 기준에 집중했어요:

- 사용 편의성: 비개발자도 쓸 수 있는지, API가 직관적인지, 시각적/노코드 옵션이 있는지.

- 자동화 & 확장성: 다중 페이지 크롤링, 스케줄링, 대용량 데이터 처리, 클라우드/온프레미스 지원 여부.

- 동적 콘텐츠 지원: 자바스크립트 기반 사이트, 무한 스크롤, 로그인 뒤 콘텐츠도 추출 가능한지.

- 연동 및 내보내기: Excel, Google Sheets, 데이터베이스, 워크플로우로 쉽게 내보낼 수 있는지.

- 커뮤니티 & 유지관리: 활발히 개발되고 있는지, 튜토리얼과 지원이 풍부한지.

- 비용: 무료/오픈소스/유료 여부와 팀, 기업에 적합한 가치 제공 여부.

직접 써보고, 사용자 리뷰와 실제 사례까지 꼼꼼히 살펴봤어요. 이제 12가지 도구를 하나씩 살펴볼게요.

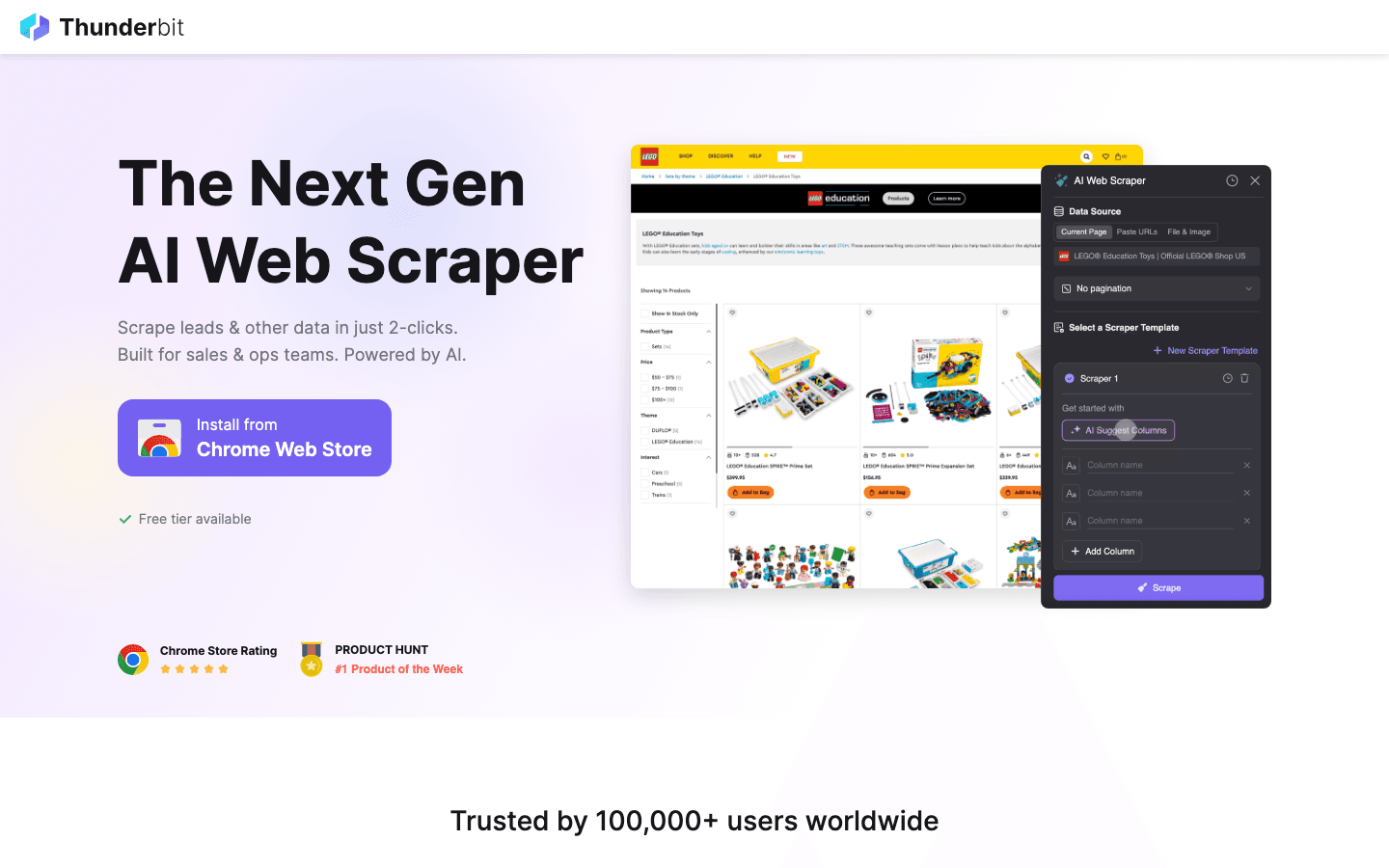

1. Thunderbit

은 복잡한 설정 없이 누구나 쉽게 웹 데이터를 추출할 수 있는 제가 가장 애정하는 도구입니다. 이라 클릭 두 번이면 어떤 웹사이트든 데이터를 뽑아낼 수 있어요. 코딩도, 템플릿도, 복잡한 설정도 필요 없어요.

은 복잡한 설정 없이 누구나 쉽게 웹 데이터를 추출할 수 있는 제가 가장 애정하는 도구입니다. 이라 클릭 두 번이면 어떤 웹사이트든 데이터를 뽑아낼 수 있어요. 코딩도, 템플릿도, 복잡한 설정도 필요 없어요.

추천 이유: Thunderbit은 영업, 운영, 이커머스, 부동산 등 빠르게 데이터가 필요한 비즈니스 사용자를 위해 설계됐어요. "AI 필드 추천"을 누르면 AI가 페이지를 읽고, "스크래핑"만 누르면 끝! 하위 페이지, 페이지네이션, 동적 콘텐츠, 온라인 폼 자동 입력까지 모두 지원합니다. Excel, Google Sheets, Airtable, Notion 등으로 무료로 내보낼 수 있어요.

주요 기능:

- AI 기반 필드 추천: Thunderbit의 AI가 페이지를 분석해 이름, 가격, 이메일 등 추출할 항목을 자동으로 제안합니다.

- 하위 페이지 자동 추출: 상세 정보가 필요하다면, 제품/연락처 등 하위 페이지도 자동 방문해 데이터를 풍부하게 수집합니다.

- 즉시 사용 가능한 템플릿: Amazon, Zillow, Instagram 등 인기 사이트는 템플릿만 선택하면 바로 시작할 수 있습니다.

- 클라우드/브라우저 스크래핑: 최대 50페이지까지 클라우드에서 동시 추출, 로그인 필요한 사이트는 브라우저에서 처리.

- 무료 데이터 내보내기: 데이터 내보내기에 별도 비용이 없습니다.

추천 대상: 비개발자, 영업/운영팀, 이커머스 등 빠른 결과가 필요한 모든 분.

아쉬운 점: 파이썬 라이브러리는 아니기 때문에, 파이썬 코드와 직접 연동하려면 데이터를 내보내서 가져와야 해요. 하지만 대부분의 비즈니스 스크래핑에는 충분히 강력합니다.

실제 사용법이 궁금하다면 나 을 참고해보세요.

2. Beautiful Soup

은 HTML과 XML 파싱에 특화된 파이썬 대표 라이브러리입니다. 저도 웹 스크래핑을 처음 배울 때 이걸로 시작했어요. 지금도 입문자에게 가장 추천하는 도구입니다.

은 HTML과 XML 파싱에 특화된 파이썬 대표 라이브러리입니다. 저도 웹 스크래핑을 처음 배울 때 이걸로 시작했어요. 지금도 입문자에게 가장 추천하는 도구입니다.

장점: 사용법이 정말 쉽고, 오류에도 관대해서 빠른 프로젝트에 딱이에요. Requests로 페이지를 받아 Beautiful Soup에 넘기면, 직관적인 API로 원하는 데이터를 쉽게 뽑을 수 있습니다. 지저분한 HTML도 잘 처리해요.

추천 대상: 소규모/중간 규모 프로젝트, 데이터 정제, 웹 스크래핑 입문자.

아쉬운 점: 자바스크립트로 렌더링되는 동적 콘텐츠는 직접 처리하지 못해요. 이런 경우 Selenium 등과 함께 써야 합니다.

3. Scrapy

는 대규모 자동화 크롤링에 최적화된 파이썬 프레임워크입니다. 수천~수백만 페이지를 크롤링하거나, 데이터 파이프라인 구축, 예약 작업이 필요하다면 Scrapy가 정답이에요.

는 대규모 자동화 크롤링에 최적화된 파이썬 프레임워크입니다. 수천~수백만 페이지를 크롤링하거나, 데이터 파이프라인 구축, 예약 작업이 필요하다면 Scrapy가 정답이에요.

강점: Scrapy는 비동기 방식으로 빠르고, 확장성이 뛰어납니다. "스파이더"를 정의해 사이트를 크롤링하고, 링크 추적, 페이지네이션, 데이터 파이프라인 처리까지 모두 지원합니다. 많은 기업형 스크래핑 프로젝트의 핵심이죠.

추천 대상: 견고하고 확장성 있는 크롤러가 필요한 개발자, 다중 페이지/사이트 크롤링, 프로덕션 데이터 파이프라인 구축.

아쉬운 점: Beautiful Soup보다 배우기가 조금 더 어렵습니다. 기본적으로 자바스크립트는 처리하지 못하지만, Splash나 Selenium과 연동해 동적 사이트도 대응 가능합니다.

4. Selenium

은 파이썬에서 Chrome, Firefox 등 브라우저를 직접 제어할 수 있는 자동화 도구입니다. 자바스크립트 기반 동적 사이트나 복잡한 웹 상호작용 자동화에 필수죠.

은 파이썬에서 Chrome, Firefox 등 브라우저를 직접 제어할 수 있는 자동화 도구입니다. 자바스크립트 기반 동적 사이트나 복잡한 웹 상호작용 자동화에 필수죠.

필수 이유: Selenium은 클릭, 폼 입력, 스크롤 등 실제 사용자의 행동을 그대로 시뮬레이션하며, 브라우저에 보이는 모든 데이터를 추출할 수 있습니다.

추천 대상: 동적 사이트, 로그인 후 데이터, 무한 스크롤, 페이지와 상호작용이 필요한 경우.

아쉬운 점: HTTP 라이브러리보다 느리고 리소스 소모가 큽니다. 대량 페이지 크롤링에는 고성능 하드웨어가 필요할 수 있어요.

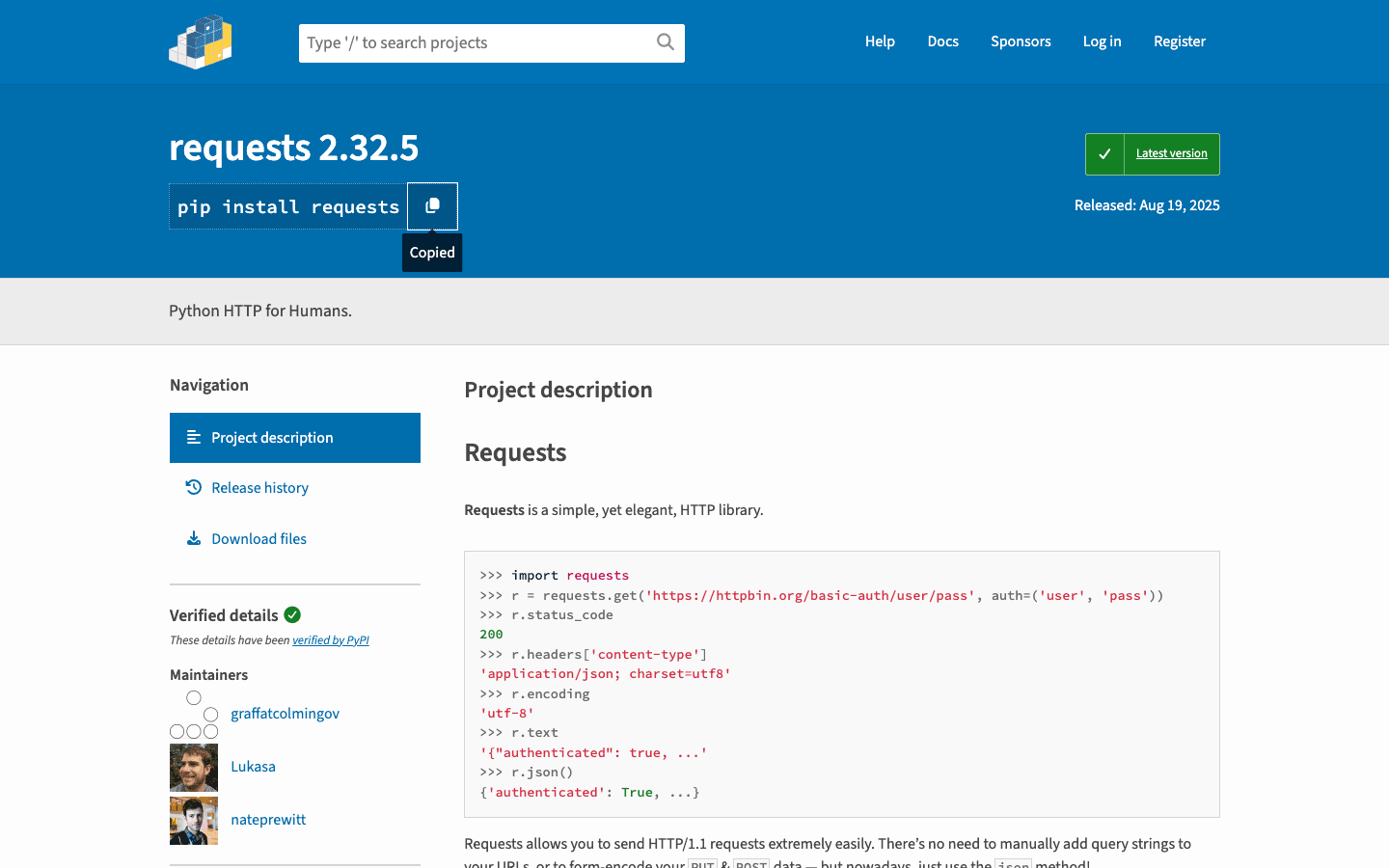

5. Requests

는 "사람을 위한 HTTP" 라이브러리로, 대부분의 파이썬 스크래핑 스크립트의 기본입니다. 웹 페이지 요청, 폼 제출, 쿠키 관리 등 다양한 기능을 제공합니다.

는 "사람을 위한 HTTP" 라이브러리로, 대부분의 파이썬 스크래핑 스크립트의 기본입니다. 웹 페이지 요청, 폼 제출, 쿠키 관리 등 다양한 기능을 제공합니다.

기본 이유: API가 간단하고 신뢰성이 높으며, Beautiful Soup이나 lxml과 완벽하게 연동됩니다. 정적 사이트나 API 호출에 적합해요.

추천 대상: 정적 HTML, API 호출, 커스텀 스크래퍼의 기반.

아쉬운 점: 자바스크립트로 렌더링되는 콘텐츠는 처리하지 못합니다. 동적 사이트는 Selenium 등과 함께 써야 해요.

6. LXML

은 파이썬에서 고성능 HTML/XML 파싱을 지원하는 라이브러리입니다. 속도가 매우 빠르고, 강력한 XPath 및 CSS 선택자를 지원합니다.

은 파이썬에서 고성능 HTML/XML 파싱을 지원하는 라이브러리입니다. 속도가 매우 빠르고, 강력한 XPath 및 CSS 선택자를 지원합니다.

선호 이유: 대용량 페이지를 빠르게 처리하거나, 복잡한 쿼리가 필요할 때 lxml이 제격입니다. Scrapy도 내부적으로 lxml을 사용해요.

추천 대상: 성능이 중요한 프로젝트, 대용량 데이터셋, 복잡한 XPath 추출.

아쉬운 점: 배우기가 약간 어렵고, 일부 시스템에서는 설치가 까다로울 수 있습니다.

7. PySpider

는 웹 기반 UI를 제공하는 파이썬 스크래핑 프레임워크입니다. Scrapy와 비슷하지만, 대시보드에서 작업 관리, 스케줄링, 모니터링까지 가능합니다.

는 웹 기반 UI를 제공하는 파이썬 스크래핑 프레임워크입니다. Scrapy와 비슷하지만, 대시보드에서 작업 관리, 스케줄링, 모니터링까지 가능합니다.

특징: 파이썬으로 스파이더를 작성하고, 스케줄링 및 결과 확인까지 브라우저에서 할 수 있어요. 여러 프로젝트를 관리하는 팀에 딱입니다.

추천 대상: 다수의 스크래핑 프로젝트를 관리하는 팀, 예약 크롤링, 시각적 인터페이스가 필요한 경우.

아쉬운 점: Scrapy만큼 활발히 유지관리되지는 않고, 최신 자바스크립트 사이트 지원이 제한적입니다.

8. MechanicalSoup

은 간단한 브라우저 작업(폼 입력, 링크 클릭 등)을 자동화할 수 있는 경량 파이썬 라이브러리입니다. Selenium보다 가볍게 쓸 수 있어요.

은 간단한 브라우저 작업(폼 입력, 링크 클릭 등)을 자동화할 수 있는 경량 파이썬 라이브러리입니다. Selenium보다 가볍게 쓸 수 있어요.

장점: Requests와 Beautiful Soup을 결합해, 로그인, 폼 제출, 결과 페이지 스크래핑을 쉽게 처리할 수 있습니다.

추천 대상: 로그인 자동화, 폼 제출, 자바스크립트가 필요 없는 간단한 웹 워크플로우.

아쉬운 점: 자바스크립트 기반 사이트나 복잡한 상호작용은 지원하지 않습니다.

9. Octoparse

는 드래그 앤 드롭 방식의 노코드 웹 스크래핑 도구입니다. 코딩 없이 데이터를 추출하고 싶은 비즈니스 사용자에게 딱이에요.

는 드래그 앤 드롭 방식의 노코드 웹 스크래핑 도구입니다. 코딩 없이 데이터를 추출하고 싶은 비즈니스 사용자에게 딱이에요.

인기 이유: 페이지네이션, 동적 콘텐츠, 클라우드 기반 예약 스크래핑까지 지원합니다. 자주 쓰는 사이트는 템플릿으로 바로 시작할 수 있고, Excel, CSV, Google Sheets로 내보낼 수 있어요.

추천 대상: 비개발자, 시장 조사, 리드 생성, 빠른 결과가 필요한 팀.

아쉬운 점: 무료 플랜은 제한적이고, 고급 기능은 유료(월 약 $75부터)입니다.

10. ParseHub

은 사이트를 클릭하며 복잡한 워크플로우를 시각적으로 만들 수 있는 또 다른 노코드 스크래핑 도구입니다. 동적 사이트, 조건부 로직, 클라우드 예약 작업에 강점이 있어요.

은 사이트를 클릭하며 복잡한 워크플로우를 시각적으로 만들 수 있는 또 다른 노코드 스크래핑 도구입니다. 동적 사이트, 조건부 로직, 클라우드 예약 작업에 강점이 있어요.

특징: 조건부 로직과 다단계 워크플로우로 팝업, 탭, 숨겨진 데이터 등 복잡한 사이트도 쉽게 처리할 수 있습니다.

추천 대상: 코딩 없이 복잡하고 동적인 웹사이트를 스크래핑하려는 사용자, 예약 데이터 수집.

아쉬운 점: 무료 플랜은 제한적이고, 대량 스크래핑은 유료 플랜이 필요합니다.

11. Colly

는 파이썬이 아닌 Go 언어로 개발된 초고속 웹 스크래핑 프레임워크입니다. 대규모 크롤링이 필요하다면 Colly를 마이크로서비스로 활용하고 파이썬에서 데이터를 처리하는 팀도 많아요.

는 파이썬이 아닌 Go 언어로 개발된 초고속 웹 스크래핑 프레임워크입니다. 대규모 크롤링이 필요하다면 Colly를 마이크로서비스로 활용하고 파이썬에서 데이터를 처리하는 팀도 많아요.

주목할 점: Colly는 최소한의 메모리로 초당 수천 페이지를 크롤링할 수 있습니다. 웹 스케일 크롤링에 적합한 크로스 플랫폼 옵션이에요.

추천 대상: 속도와 동시성이 중요한 엔지니어링 팀, Go 기반 크롤러와 파이썬 워크플로우 연동.

아쉬운 점: Go 언어 지식이 필요하고, 파이썬 라이브러리는 아닙니다.

12. Portia

는 Scrapinghub(현 Zyte)에서 만든 오픈소스 시각적 스크래퍼입니다. 브라우저에서 요소를 클릭해 Scrapy 스파이더를 만들 수 있어, 코딩 없이도 강력한 크롤러를 구축할 수 있어요.

는 Scrapinghub(현 Zyte)에서 만든 오픈소스 시각적 스크래퍼입니다. 브라우저에서 요소를 클릭해 Scrapy 스파이더를 만들 수 있어, 코딩 없이도 강력한 크롤러를 구축할 수 있어요.

장점: Portia는 비개발자와 Scrapy의 강점을 연결해줍니다. 시각적으로 추출 규칙을 정의하고, Scrapy나 Zyte 클라우드에서 실행할 수 있습니다.

추천 대상: 데이터팀의 비개발자, 시각적으로 Scrapy 스파이더를 프로토타이핑하고 싶은 분.

아쉬운 점: 유지관리가 활발하지 않고, 동적/인터랙티브 사이트에는 한계가 있습니다.

한눈에 보는 파이썬 웹 스크래핑 라이브러리 비교표

| Tool/Library | Ease of Use | Dynamic Content | Automation & Scale | Best For | Pricing |

|---|---|---|---|---|---|

| Thunderbit | ★★★★★ | ★★★★☆ | ★★★★☆ | 비개발자, 비즈니스 사용자, 빠른 결과 | 무료 + 크레딧 |

| Beautiful Soup | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | 입문자, 정적 페이지, 데이터 정제 | 무료 |

| Scrapy | ★★★☆☆ | ★★★☆☆ | ★★★★★ | 개발자, 대규모 크롤링 | 무료 |

| Selenium | ★★☆☆☆ | ★★★★★ | ★★☆☆☆ | 동적 사이트, 브라우저 자동화 | 무료 |

| Requests | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | 정적 HTML, API, 빠른 스크립트 | 무료 |

| LXML | ★★★☆☆ | ★☆☆☆☆ | ★★★★☆ | 성능, 대용량 데이터, XPath | 무료 |

| PySpider | ★★★★☆ | ★★★☆☆ | ★★★★★ | 팀, 예약 크롤링, 웹 UI | 무료 |

| MechanicalSoup | ★★★★☆ | ★☆☆☆☆ | ★★☆☆☆ | 폼 자동화, 로그인, 간단한 워크플로우 | 무료 |

| Octoparse | ★★★★★ | ★★★★☆ | ★★★★☆ | 노코드, 비즈니스 사용자, 예약 스크래핑 | 무료 + 유료 |

| ParseHub | ★★★★★ | ★★★★☆ | ★★★★☆ | 노코드, 복잡/동적 사이트 | 무료 + 유료 |

| Colly | ★★☆☆☆ | ★☆☆☆☆ | ★★★★★ | 초고속, 크로스 플랫폼, Go 연동 | 무료 |

| Portia | ★★★★☆ | ★★☆☆☆ | ★★★☆☆ | 시각적 Scrapy 스파이더, 비개발자 | 무료 |

비즈니스에 맞는 파이썬 웹 스크래핑 도구 선택법

그럼 어떤 도구를 골라야 할까요? 아래 요약표를 참고해보세요:

- 비개발자/비즈니스 사용자: , , 부터 시작해보세요. 빠르고 시각적이며, 코딩이 필요 없습니다.

- 개발자/대규모 프로젝트: , 가 견고한 크롤러 구축에 적합합니다.

- 동적/자바스크립트 기반 사이트: 이나 브라우저 자동화 지원 시각적 도구를 활용하세요.

- 빠른 정적 페이지 스크래핑: + 조합이 가장 쉽고 빠릅니다.

- 성능/크로스 플랫폼: Go 기반 마이크로서비스가 필요하다면 를 고려하거나, 파이썬과 병행해 사용하세요.

- Scrapy 시각적 프로토타이핑: 는 비개발자와 개발자 모두에게 좋은 다리 역할을 합니다.

팁: 가장 단순하면서도 내 요구에 맞는 도구부터 시작하세요. 고민된다면 으로 빠르게 경험해보거나, 대규모라면 Scrapy 프로젝트를 시작해보세요.

가장 중요한 건, 원하는 데이터를 신속하고 안정적으로 얻을 수 있는 도구가 바로 최고의 도구라는 점입니다. 복잡함에 지치지 마세요!

자주 묻는 질문(FAQ)

1. 왜 파이썬이 웹 스크래핑에 인기가 많나요?

파이썬은 간결한 문법, 방대한 라이브러리, 활발한 커뮤니티 덕분에 웹 스크래핑 분야를 장악하고 있어요. )할 정도로 입문자와 전문가 모두에게 사랑받는 언어입니다.

2. 자바스크립트 기반(동적) 웹사이트에 가장 적합한 파이썬 라이브러리는?

동적 사이트에는 이 대표적이에요. 실제 브라우저를 제어하기 때문이죠. 노코드 솔루션으로는 , , 도 자바스크립트 기반 페이지를 잘 처리합니다.

3. Scrapy와 Beautiful Soup 중 어떤 걸 선택해야 하나요?

간단하고 빠른 프로젝트, 학습 목적이라면 이 적합합니다. 대규모 자동화 크롤링, 다중 페이지, 견고한 파이프라인과 스케줄링이 필요하다면 를 추천해요.

4. Thunderbit을 파이썬 워크플로우와 연동할 수 있나요?

네, 에서 데이터를 CSV, Excel, Google Sheets로 내보내고, 이를 파이썬 스크립트에서 불러와 분석하거나 추가 처리할 수 있습니다.

5. 개발자가 아니라면 웹 스크래핑을 가장 쉽게 시작하는 방법은?

, , 를 써보세요. 모두 시각적으로 데이터를 추출할 수 있어 코딩이 필요 없습니다. 더 많은 가이드와 팁은 에서 확인하세요.

여러분의 데이터가 언제나 깔끔하고, 구조화되어, 클릭 한 번이면 손에 들어오길 바랍니다. 해피 스크래핑!

더 알아보기