2026년 웹 스크래핑의 세계는 마치 새벽에 활기찬 재래시장을 연상케 합니다. 모두가 가장 신선한 데이터를 손에 넣으려 경쟁하고, 제대로 된 도구를 쓰는 사람이 원하는 정보를 남들보다 먼저 챙겨갑니다. 요즘 기업들은 영업 리드 발굴, 시장 조사, 경쟁사 분석 등 다양한 목적으로 웹 데이터를 모으고 있죠. 그래서 파이썬 웹 스크래핑 라이브러리 선택은 단순한 기술적 결정이 아니라, 비즈니스 전략의 핵심이 되었습니다. 워낙 많은 도구와 ‘최고의 가이드’가 넘쳐나니, 어떤 걸 골라야 할지 고민하는 것도 당연합니다.

SaaS와 자동화 분야에서 오래 일하면서, 제대로 된 파이썬 웹 스크래핑 도구 하나만 있으면 며칠 걸릴 일을 몇 시간 만에 끝낼 수 있다는 걸 몸소 느꼈어요. 개발자든, 아니면 단순히 스프레드시트에 깔끔한 데이터가 필요한 비즈니스 담당자든, 이 글에서는 2026년 기준 가장 뛰어난 파이썬 웹 스크래핑 라이브러리 12가지와, 코딩 없이 쓸 수 있는 AI 기반 솔루션 하나까지 소개합니다.

왜 파이썬 웹 스크래핑 라이브러리 선택이 중요한가?

웹 스크래핑은 단순히 데이터를 긁어오는 게 아니라, 정확하고 빠르게 그리고 효율적으로 정보를 얻는 게 핵심입니다. 2026년 현재 미국 내 이 영업, 시장 조사, 운영을 위해 자동화된 웹 스크래핑을 활용하고 있고, 하루에 크롤링되는 페이지 수는 에 달합니다. 잘못된 도구를 고르면 기회를 놓치거나, 스크립트가 자주 깨지거나, 디버깅에 시간만 허비할 수 있어요.

파이썬 웹 스크래핑 도구를 고를 때 꼭 따져봐야 할 포인트는 다음과 같습니다:

- 성능: 대용량 데이터도 거뜬히 처리할 수 있나?

- 사용 편의성: 결과를 얻기까지 코드 작성에 시간을 얼마나 들여야 하나?

- 브라우저 & 자바스크립트 지원: 최신 동적 웹사이트도 잘 긁어오나?

- 확장성: 데이터 수집 규모가 커져도 유연하게 대응할 수 있나?

- 연동성: 기존 데이터 파이프라인이나 업무 프로세스와 쉽게 연결되나?

실제 현장에서는 영업 리드 확보, 가격 모니터링, 경쟁사 동향 파악, 반복적인 데이터 입력 자동화 등 다양한 목적으로 쓰입니다. 제대로 된 라이브러리를 고르면 영업팀이 경쟁사보다 한발 앞서 나갈 수 있고, 잘못 고르면 엑셀 지옥에 빠질 수도 있죠.

최고의 파이썬 웹 스크래핑 라이브러리 선정 기준

각 라이브러리를 평가할 때 아래 기준을 중점적으로 봤습니다:

- 성능 & 확장성: 대규모 작업과 복잡한 사이트도 잘 처리하는가?

- 사용 난이도: 초보자도 쉽게 쓸 수 있는가, 아니면 고급 파이썬 실력이 필요한가?

- 브라우저 & 자바스크립트 처리: 동적 콘텐츠와 최신 웹앱도 문제없이 다루는가?

- 보안 & 유지관리: 꾸준히 업데이트되고 안전하게 사용할 수 있는가?

- 커뮤니티 & 지원: 문서, 튜토리얼, 커뮤니티가 잘 갖춰져 있는가?

- 연동 가능성: Thunderbit 같은 AI 솔루션이나 다른 도구와 결합해 더 강력하게 쓸 수 있는가?

실제 비즈니스에서의 활용성도 중요하게 봤어요. 아무리 코드가 좋아도, 결과로 얻는 데이터가 만족스럽지 않으면 소용없으니까요.

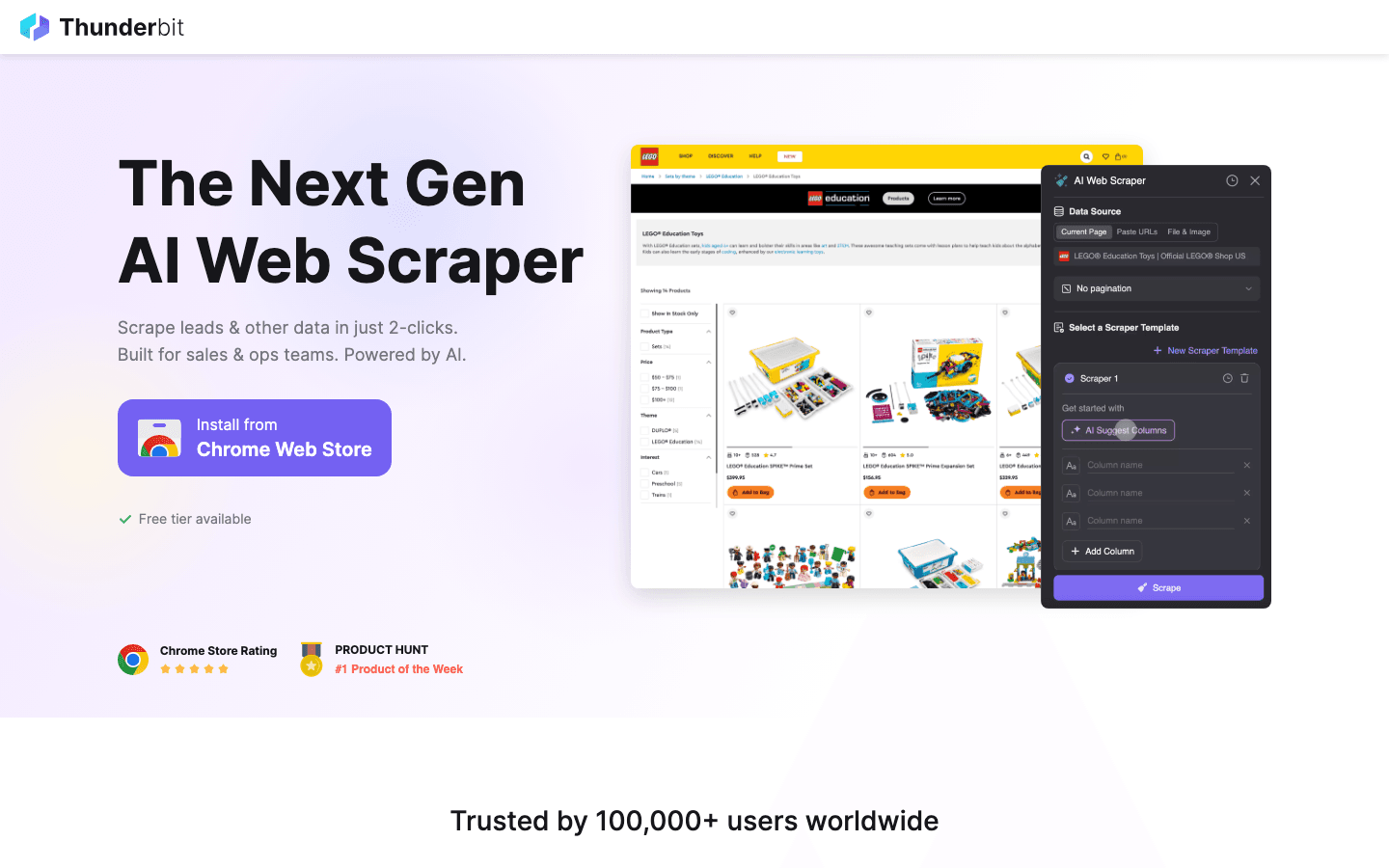

1. Thunderbit

은 전통적인 파이썬 라이브러리가 아니라, 입니다. 2026년 웹 스크래핑 판도를 바꾸고 있는 이 도구가 리스트에 포함된 이유를 살펴보세요.

은 전통적인 파이썬 라이브러리가 아니라, 입니다. 2026년 웹 스크래핑 판도를 바꾸고 있는 이 도구가 리스트에 포함된 이유를 살펴보세요.

주요 기능:

- AI 필드 추천: 원하는 데이터를 설명만 하면, Thunderbit의 AI가 자동으로 컬럼과 데이터 유형을 파악합니다.

- 서브페이지 스크래핑: 제품 상세, LinkedIn 프로필 등 하위 페이지까지 자동 방문 및 데이터 추출

- 즉시 사용 가능한 템플릿: 아마존, Zillow, Shopify 등 인기 사이트는 원클릭으로 스크래핑 가능

- 무료 데이터 내보내기: Excel, Google Sheets, Airtable, Notion, CSV, JSON 등 다양한 포맷 지원 (추가 비용 없음)

- 노코드 워크플로우: 비전문가도 쉽게 사용 가능하며, 파이썬 도구와 연동해 고급 자동화도 가능

추천 활용 사례: 영업 리드 수집, 이커머스 가격 모니터링, 부동산 매물, 운영 데이터 등 구조화된 데이터가 빠르게 필요한 모든 곳

장점:

- 코딩 없이 클릭과 설명만으로 데이터 추출

- AI가 사이트 구조 변화에 자동 적응

- 복잡하고 다양한 웹 데이터도 손쉽게 처리

- Scrapy, Beautiful Soup 등 파이썬 라이브러리와 연동해 하이브리드 워크플로우 구축 가능

단점:

- 순수 파이썬 라이브러리는 아님 (하지만 파이썬 파이프라인과 잘 연동됨)

- 비즈니스 사용자나 코드 기반 스크래핑 보조용으로 최적

팁: Thunderbit로 빠르게 스크래퍼를 프로토타이핑하거나, 복잡한 일회성 작업을 처리하세요. 대규모 자동화가 필요하다면 Thunderbit에서 추출한 구조화 데이터를 파이썬 스크립트로 연계해 추가 가공할 수 있습니다.

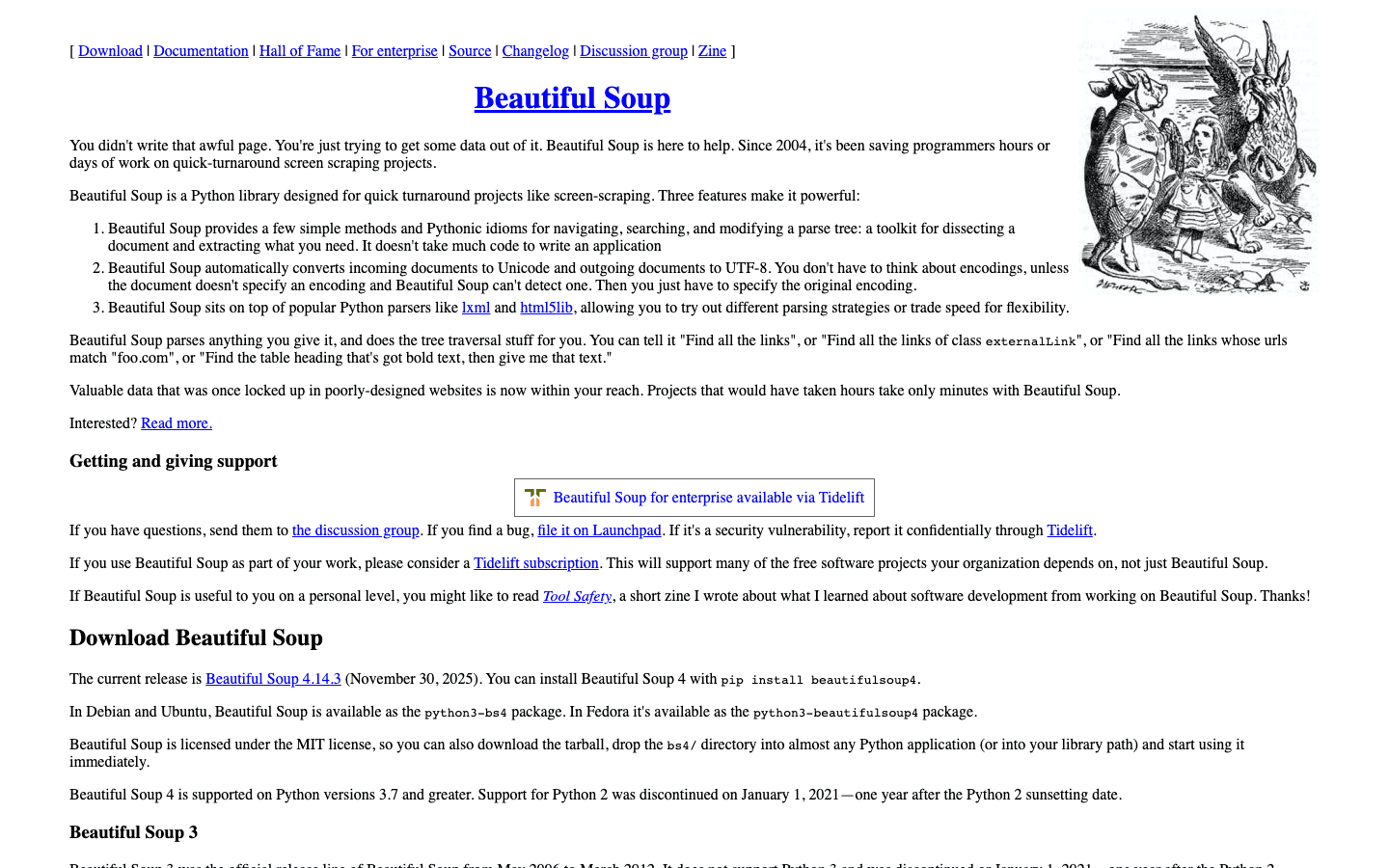

2. Beautiful Soup

은 HTML이나 XML을 파싱하고 탐색하는 데 가장 널리 쓰이는 파이썬 라이브러리입니다. 지저분하거나 깨진 웹페이지를 정리해본 경험이 있다면, 이 도구가 왜 초보자와 전문가 모두에게 사랑받는지 알 수 있습니다.

은 HTML이나 XML을 파싱하고 탐색하는 데 가장 널리 쓰이는 파이썬 라이브러리입니다. 지저분하거나 깨진 웹페이지를 정리해본 경험이 있다면, 이 도구가 왜 초보자와 전문가 모두에게 사랑받는지 알 수 있습니다.

주요 기능:

- HTML/XML 검색, 탐색, 수정이 직관적인 문법

- 형식이 잘못된 마크업도 유연하게 처리

- 와 연동해 페이지 가져오기 용이

추천 활용 사례: 간단한 스크래핑, 데이터 정제, 소규모 페이지 파싱

장점:

- 배우기 매우 쉬움

- 지저분한 HTML 정리에 탁월

- 유연하고 관대함

단점:

- 대용량 문서에서는 보다 느림

- 자바스크립트 지원 없음

팁: 속도가 중요하다면 Beautiful Soup에서 lxml 파서를 사용하세요. 동적 사이트는 Selenium이나 Pyppeteer와 함께 쓰는 것도 좋습니다.

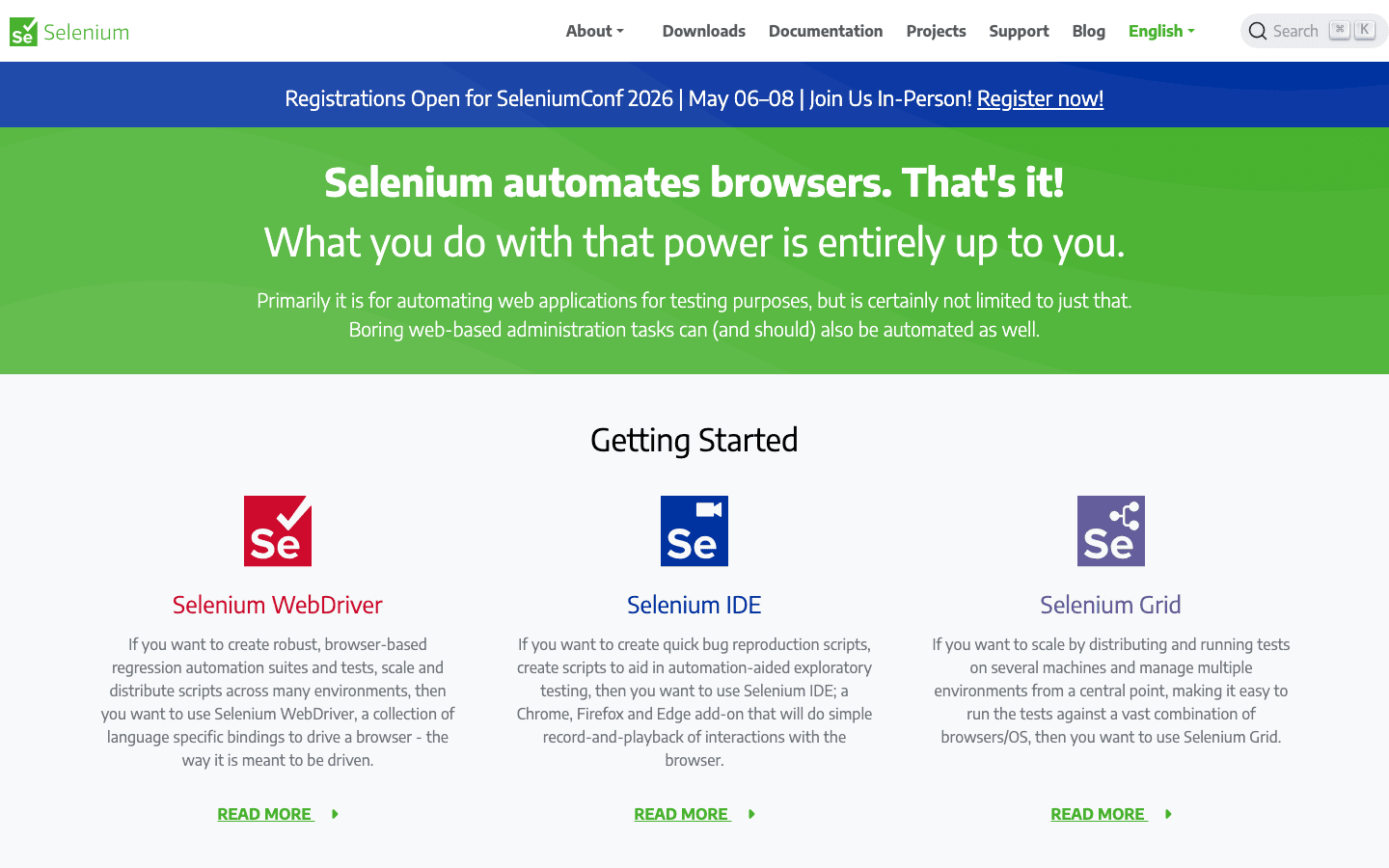

3. Selenium

은 브라우저 자동화의 대표주자입니다. Chrome, Firefox, Edge 등 다양한 브라우저를 제어할 수 있어, 자바스크립트가 많은 동적 웹사이트 스크래핑에 적합합니다.

은 브라우저 자동화의 대표주자입니다. Chrome, Firefox, Edge 등 다양한 브라우저를 제어할 수 있어, 자바스크립트가 많은 동적 웹사이트 스크래핑에 적합합니다.

주요 기능:

- 실제 브라우저(Chrome, Firefox 등) 자동화

- 헤드리스 모드 지원으로 빠르고 GUI 없이 실행 가능

- 폼, 버튼 등 사용자 행동 시뮬레이션 가능

추천 활용 사례: 로그인, 클릭 등 사용자 상호작용이 필요한 사이트, 자바스크립트 렌더링이 많은 사이트

장점:

- 거의 모든 웹사이트 대응 가능

- 다양한 브라우저 및 플랫폼 지원

- 테스트와 스크래핑을 한 번에 처리

단점:

- 헤드리스 전용 솔루션보다 느림

- 리소스 소모가 큼

- 사이트 구조 변경 시 스크립트가 깨질 수 있음

팁: Selenium은 다른 방법이 통하지 않을 때 사용하세요. 속도와 확장성이 필요하다면 Scrapy나 Pyppeteer도 고려해보세요.

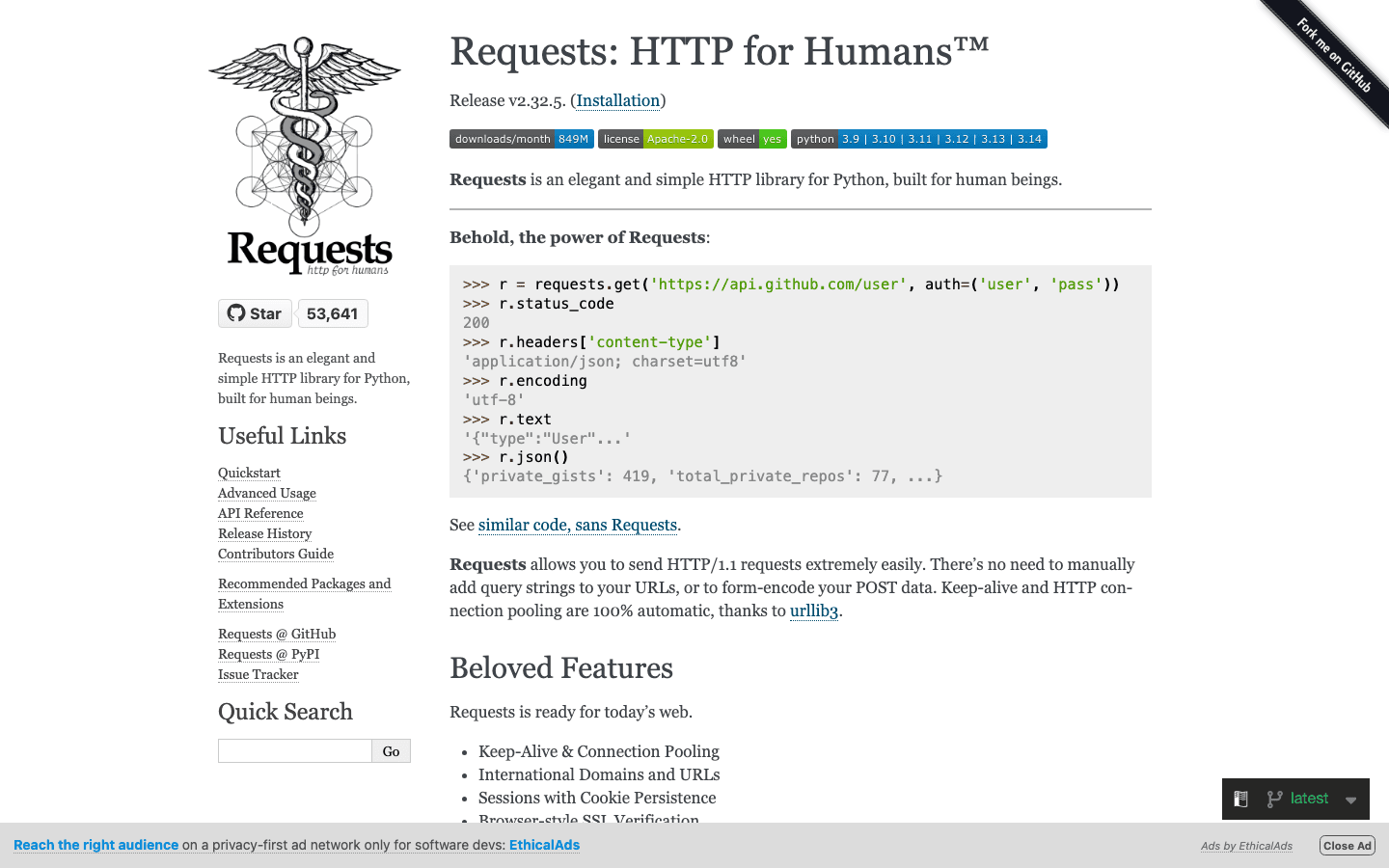

4. Requests

는 파이썬에서 HTTP 요청을 보내는 데 필수적인 라이브러리입니다. GET/POST 요청과 응답 처리를 매우 쉽게 해주며, 많은 스크래핑 워크플로우의 기본이 됩니다.

는 파이썬에서 HTTP 요청을 보내는 데 필수적인 라이브러리입니다. GET/POST 요청과 응답 처리를 매우 쉽게 해주며, 많은 스크래핑 워크플로우의 기본이 됩니다.

주요 기능:

- 파이썬다운 간결한 HTTP 요청 API

- 쿠키, 세션, 인증 등 지원

- Beautiful Soup, LXML 등 파서와 연동 용이

추천 활용 사례: 정적 페이지, API 데이터 수집, 커스텀 스크래퍼의 기본 구성요소

장점:

- 사용법이 매우 간단

- 신뢰성 높고 유지관리 잘 됨

- 빠른 스크립트 및 프로토타입에 적합

단점:

- HTML 파싱 기능 없음

- 자바스크립트 렌더링 불가

팁: Requests와 Beautiful Soup 또는 LXML을 조합하면 가볍고 효율적인 스크래핑 스택을 만들 수 있습니다.

5. LXML

은 파이썬에서 HTML/XML 파싱 속도가 가장 빠른 라이브러리입니다. 대용량 문서 처리나 복잡한 XPath 쿼리가 필요할 때 강력한 성능을 자랑합니다.

은 파이썬에서 HTML/XML 파싱 속도가 가장 빠른 라이브러리입니다. 대용량 문서 처리나 복잡한 XPath 쿼리가 필요할 때 강력한 성능을 자랑합니다.

주요 기능:

- C 기반 백엔드로 초고속 파싱

- XPath, CSS 셀렉터 완벽 지원

- HTML과 XML 모두 처리 가능

추천 활용 사례: 대규모 문서 파싱, 복잡한 문서 구조, 속도가 중요한 프로젝트

장점:

- 대용량 작업에서 Beautiful Soup보다 훨씬 빠름

- 강력한 셀렉터 지원

- 견고한 에러 처리

단점:

- 깨진 HTML에는 다소 엄격함

- 진입장벽이 약간 높음

팁: Beautiful Soup의 파서로 LXML을 사용하면 사용 편의성과 성능을 모두 잡을 수 있습니다.

6. Pyppeteer

는 Puppeteer의 파이썬 버전으로, 헤드리스 크롬을 제어해 고급 스크래핑 작업을 수행할 수 있습니다. 자바스크립트가 많은 최신 웹앱에 최적화되어 있습니다.

는 Puppeteer의 파이썬 버전으로, 헤드리스 크롬을 제어해 고급 스크래핑 작업을 수행할 수 있습니다. 자바스크립트가 많은 최신 웹앱에 최적화되어 있습니다.

주요 기능:

- 헤드리스 크롬(또는 크로미움) 완전 제어

- 자바스크립트 렌더링 및 사용자 행동 시뮬레이션 탁월

- 복잡한 네비게이션, 스크린샷, PDF 생성 등 지원

추천 활용 사례: 최신 자바스크립트 사이트, 사용자 플로우 자동화, 봇 차단 우회

장점:

- 자바스크립트 지원 최상급

- 사람처럼 행동 시뮬레이션 가능

- SPA(싱글 페이지 앱) 스크래핑에 강함

단점:

- Requests나 Scrapy보다 무겁고 느림

- 유지관리 상태가 변동될 수 있음(최신 업데이트 확인 필요)

- 설정이 다소 복잡

팁: Selenium으로 안 되는 사이트는 Pyppeteer로 시도해보세요. Thunderbit의 AI로 데이터 필드를 미리 정의한 뒤, Pyppeteer로 네비게이션을 맡기는 것도 좋은 방법입니다.

7. Splash

는 대규모 자바스크립트 렌더링에 특화된 경량 브라우저 엔진입니다. 주로 Scrapy와 함께 동적 사이트 스크래핑에 활용됩니다.

는 대규모 자바스크립트 렌더링에 특화된 경량 브라우저 엔진입니다. 주로 Scrapy와 함께 동적 사이트 스크래핑에 활용됩니다.

주요 기능:

- HTTP API 기반 헤드리스 브라우저

- 자바스크립트 렌더링 후 HTML, 스크린샷, HAR 파일 반환

- Scrapy 미들웨어로 연동 가능

추천 활용 사례: 자바스크립트가 많은 페이지의 대량 처리, 확장성 높은 스크래핑 파이프라인, 서버 사이드 렌더링

장점:

- 대규모 렌더링에 빠르고 효율적

- API 기반으로 통합이 쉬움

- 전체 브라우저 자동화보다 리소스 소모 적음

단점:

- Selenium이나 Pyppeteer에 비해 상호작용 제한적

- 설정 및 스크립팅에 약간의 학습 필요

팁: 동적 사이트 대량 스크래핑에는 Scrapy + Splash 조합이 강력합니다.

8. MechanicalSoup

은 웹 폼 자동화와 간단한 네비게이션에 특화된 경량 파이썬 라이브러리입니다. Requests와 Beautiful Soup 위에 구축되어 있습니다.

은 웹 폼 자동화와 간단한 네비게이션에 특화된 경량 파이썬 라이브러리입니다. Requests와 Beautiful Soup 위에 구축되어 있습니다.

주요 기능:

- 폼 자동 제출 및 네비게이션

- 세션 상태와 쿠키 자동 관리

- 초보자도 쉽게 쓸 수 있는 간단한 API

추천 활용 사례: 사이트 로그인, 폼 입력 자동화, 정적/약간 동적인 페이지 스크래핑

장점:

- 최소한의 설정으로 빠른 자동화

- 쿠키와 세션 기본 지원

- 간단한 로그인/검색 폼에 최적

단점:

- 자바스크립트 지원 없음

- 대규모/고도로 동적인 스크래핑에는 부적합

팁: 로그인 등 인증이 필요한 플로우는 MechanicalSoup으로 처리하고, 이후 Requests + Beautiful Soup으로 데이터 추출을 이어가세요.

9. Twisted

는 파이썬의 이벤트 기반 네트워킹 엔진입니다. 웹 스크래퍼 전용은 아니지만, 대규모 고성능 스크래핑 파이프라인 구축의 핵심이 됩니다.

는 파이썬의 이벤트 기반 네트워킹 엔진입니다. 웹 스크래퍼 전용은 아니지만, 대규모 고성능 스크래핑 파이프라인 구축의 핵심이 됩니다.

주요 기능:

- HTTP, TCP 등 비동기 네트워킹 지원

- 수천 개 동시 연결 확장 가능

- 커스텀 분산 스크래핑 시스템에 활용

추천 활용 사례: 대량 데이터 수집용 커스텀 스크래퍼, 다른 비동기 프레임워크와 통합

장점:

- 매우 확장성 높고 강력함

- 다양한 프로토콜 지원

- 고급 사용자에게 적합

단점:

- 학습 곡선이 가파름

- 일반적인 스크래핑에는 과할 수 있음

팁: 수백만 페이지 단위의 대규모 스크래핑이 필요하다면 Twisted를 배워볼 가치가 있습니다.

10. Scrapy

는 파이썬 웹 스크래핑 프레임워크의 만능툴입니다. 대규모, 실전 프로젝트에 최적화되어 있으며, 비동기 아키텍처로 수천 페이지도 거뜬히 처리합니다.

는 파이썬 웹 스크래핑 프레임워크의 만능툴입니다. 대규모, 실전 프로젝트에 최적화되어 있으며, 비동기 아키텍처로 수천 페이지도 거뜬히 처리합니다.

주요 기능:

- 고성능 비동기 엔진으로 대량 크롤링

- 파이프라인, 미들웨어, 데이터 내보내기( JSON, CSV, XML) 기본 지원

- 크롤링, 파싱, 데이터 정제를 한 번에 처리

- 프록시, 유저 에이전트 등 플러그인으로 확장 가능

추천 활용 사례: 엔터프라이즈급 대규모 스크래핑, 구조화 데이터 추출, 속도와 신뢰성이 중요한 프로젝트

장점:

- 대용량 작업에 매우 빠름

- 커스터마이즈와 확장성 뛰어남

- 커뮤니티와 문서가 탄탄함

단점:

- 초보자에게는 진입장벽이 있음

- 기본적으로 자바스크립트 사이트는 지원하지 않음(Splash 등과 연동 필요)

팁: 자바스크립트 렌더링이 필요하다면 와, AI 기반 필드 감지 및 데이터 구조화가 필요하다면 와 함께 사용해보세요.

11. PyQuery

는 jQuery 스타일의 셀렉터를 파이썬에서 사용할 수 있게 해줍니다. jQuery 문법에 익숙하다면 바로 적응할 수 있습니다.

는 jQuery 스타일의 셀렉터를 파이썬에서 사용할 수 있게 해줍니다. jQuery 문법에 익숙하다면 바로 적응할 수 있습니다.

주요 기능:

- jQuery와 유사한 API로 HTML 선택 및 조작

- lxml 기반으로 빠른 속도

- CSS 셀렉터 및 DOM 조작 지원

추천 활용 사례: jQuery 경험이 있는 개발자, 빠른 프로토타이핑, 유연한 셀렉터가 필요한 프로젝트

장점:

- 빠르고 효율적

- jQuery 경험자에게 직관적

- HTML 파싱과 수정 모두에 적합

단점:

- Beautiful Soup이나 LXML보다 커뮤니티가 작음

- 깨진 HTML 지원이 제한적

팁: XPath보다 CSS 셀렉터가 편하다면 PyQuery를 활용해보세요.

12. Parsel

은 XPath와 CSS 셀렉터로 HTML, XML에서 데이터를 추출하는 강력한 라이브러리입니다. Scrapy의 파싱 엔진의 핵심이기도 합니다.

은 XPath와 CSS 셀렉터로 HTML, XML에서 데이터를 추출하는 강력한 라이브러리입니다. Scrapy의 파싱 엔진의 핵심이기도 합니다.

주요 기능:

- XPath, CSS 셀렉터 고급 지원

- 데이터 추출 및 정제에 최적화된 API

- 단독 사용 또는 Scrapy 내에서 활용 가능

추천 활용 사례: 복잡한 데이터 추출, 강력한 셀렉터 로직이 필요한 프로젝트, Scrapy와의 통합

장점:

- 매우 유연하고 강력함

- 복잡한 페이지 레이아웃 처리에 탁월

- 문서화 잘 되어 있고, 꾸준히 유지관리됨

단점:

- 셀렉터 사용법에 대한 이해 필요

- 전체 스크래핑 프레임워크는 아니며, 파싱 컴포넌트로 적합

팁: Scrapy 스파이더나 커스텀 파싱 스크립트에서 Parsel을 활용해 복잡한 데이터 추출을 자동화하세요.

한눈에 보는 파이썬 웹 스크래핑 도구 비교표

| Library | Main Features | Performance | Ease of Use | JavaScript Support | Best For | Integration Options |

|---|---|---|---|---|---|---|

| Thunderbit | AI 기반, 노코드, 서브페이지 지원 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | 예 (브라우저 기반) | 비즈니스 사용자, 하이브리드 워크플로우 | Excel, Sheets, Notion, Python |

| Beautiful Soup | HTML/XML 파싱, 관대한 처리 | ⭐⭐ | ⭐⭐⭐⭐⭐ | 아니오 | 데이터 정제, 소규모 작업 | Requests, LXML, Thunderbit |

| Selenium | 브라우저 자동화, 동적 콘텐츠 | ⭐⭐ | ⭐⭐ | 예 | 동적 사이트, 사용자 상호작용 | Beautiful Soup, PyQuery |

| Requests | HTTP 요청, 세션 관리 | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ | 아니오 | 정적 페이지, API 수집 | Beautiful Soup, LXML |

| LXML | 빠른 파싱, XPath, CSS 셀렉터 | ⭐⭐⭐⭐ | ⭐⭐⭐ | 아니오 | 대용량 문서, 복잡한 파싱 | Beautiful Soup, PyQuery |

| Pyppeteer | 헤드리스 크롬, JS 렌더링 | ⭐⭐ | ⭐⭐ | 예 | 최신 JS 사이트, SPA | Thunderbit, Pandas |

| Splash | JS 렌더링, API 기반 | ⭐⭐⭐ | ⭐⭐ | 예 | 대량 JS 스크래핑, 파이프라인 | Scrapy, Thunderbit |

| MechanicalSoup | 폼 처리, 네비게이션 | ⭐⭐ | ⭐⭐⭐⭐ | 아니오 | 간단한 폼, 로그인 | Requests, Beautiful Soup |

| Twisted | 비동기 네트워킹, 커스텀 파이프라인 | ⭐⭐⭐⭐⭐ | ⭐ | 아니오 | 대용량, 커스텀 스크래퍼 | Scrapy, custom frameworks |

| Scrapy | 고성능, 비동기, 파이프라인 | ⭐⭐⭐⭐⭐ | ⭐⭐ | 제한적 (Splash 연동) | 엔터프라이즈급, 구조화 데이터 | Splash, Parsel, Thunderbit |

| PyQuery | jQuery 스타일 셀렉터, 빠름 | ⭐⭐⭐ | ⭐⭐⭐⭐ | 아니오 | jQuery 팬, 빠른 프로토타이핑 | LXML, Requests |

| Parsel | XPath/CSS 셀렉터, 유연한 파싱 | ⭐⭐⭐⭐ | ⭐⭐⭐ | 아니오 | 복잡한 추출, Scrapy 사용자 | Scrapy, Standalone |

내게 맞는 파이썬 웹 스크래핑 라이브러리 고르는 법

빠른 선택 가이드:

-

정적 페이지나 API를 다루나요?

Requests + Beautiful Soup 또는 LXML을 사용하세요. -

대량의 데이터를 빠르게 수집해야 하나요?

Scrapy가 적합합니다. 비동기 네트워킹이 필요하다면 Twisted도 고려해보세요. -

동적, 자바스크립트 기반 사이트를 스크래핑해야 하나요?

Selenium, Pyppeteer, 또는 Scrapy + Splash 조합을 추천합니다. -

jQuery 스타일 셀렉터가 필요하다면?

PyQuery가 좋은 선택입니다. -

폼 자동화나 로그인이 필요한가요?

MechanicalSoup이 간단하고 효과적입니다. -

코딩이 익숙하지 않거나, 빠른 셋업이 필요하다면?

Thunderbit로 자연어로 원하는 데이터를 정의하고, 구조화된 데이터를 원하는 도구로 내보낼 수 있습니다. -

하이브리드 접근이 필요하다면?

Thunderbit로 데이터 구조를 빠르게 잡고, 파이썬 스크립트로 추가 가공하세요.

도구 선택 체크리스트:

- 사이트의 복잡도(정적 vs. 동적)는?

- 수집해야 할 데이터 양은?

- 폼 입력이나 로그인이 필요한가?

- 파이썬과 셀렉터 사용에 익숙한가?

- Excel, Sheets, Notion 등 비즈니스 도구로 내보내야 하는가?

- 유지관리의 용이성은?

결론: 2026년 파이썬 웹 스크래핑의 새로운 가능성

파이썬 웹 스크래핑은 그 어느 때보다 강력하고, 접근성이 높아졌습니다. Scrapy로 대규모 크롤링을 하든, Beautiful Soup으로 데이터 정제를 하든, Selenium이나 Pyppeteer로 자바스크립트 사이트를 다루든, 혹은 한 줄의 코드도 없이 스프레드시트로 데이터를 옮기고 싶든, 여러분에게 딱 맞는 도구가 있습니다.

진짜 비밀은? 여러 도구를 조합하는 데 있습니다. 각 파이썬 웹 스크래핑 라이브러리는 저마다 강점이 있고, AI 기반 솔루션(예: )과 함께 쓰면 시간도 절약하고, 오류도 줄이며, 새로운 비즈니스 인사이트까지 얻을 수 있습니다.

2026년의 승자는 가장 빠른 코더가 아니라, 적재적소에 맞는 도구로 반복 작업을 자동화하고, 웹 데이터를 실질적인 비즈니스 가치로 바꾸는 사람입니다.

자주 묻는 질문(FAQ)

1. 파이썬 웹 스크래핑 초보자에게 가장 추천하는 라이브러리는?

Beautiful Soup이 문법이 쉽고 관대해서 입문자에게 많이 추천됩니다. 코딩이 익숙하지 않다면 Thunderbit의 AI 기반 노코드 솔루션도 좋은 대안입니다.

2. 동적/자바스크립트 기반 웹사이트에 가장 적합한 파이썬 스크래핑 도구는?

Selenium, Pyppeteer, Splash가 동적 콘텐츠 스크래핑에 강합니다. 특히 Pyppeteer는 최신 자바스크립트 앱에 최적입니다.

3. Thunderbit와 Scrapy, Beautiful Soup 같은 파이썬 라이브러리를 함께 쓸 수 있나요?

물론입니다! Thunderbit로 구조화된 데이터를 빠르게 추출한 뒤, 원하는 파이썬 라이브러리로 추가 가공할 수 있습니다.

4. 대용량 HTML 문서 파싱에 가장 빠른 파이썬 라이브러리는?

LXML이 XPath나 CSS 셀렉터를 활용할 때 가장 빠른 성능을 보입니다.

5. Scrapy와 Selenium 중 어떤 걸 선택해야 하나요?

정적 사이트의 대규모, 구조화된 스크래핑에는 Scrapy가, 동적 요소나 로그인, 자바스크립트가 많은 페이지에는 Selenium이 더 적합합니다.

Thunderbit로 웹 스크래핑 워크플로우를 어떻게 혁신할 수 있는지 궁금하다면 후, 에서 더 많은 가이드를 확인해보세요. 즐거운 스크래핑 되세요!

더 알아보기