상상해보세요. 수천 개의 상품이 쭉 나열된 웹사이트를 보고 있는데, 상사나 데이터에 진심인 당신이 그 모든 가격, 이름, 리뷰를 엑셀로 정리해달라고 부탁합니다. 하나하나 복사해서 붙여넣으려면 몇 시간은 훌쩍 지나가겠죠. 하지만 파이썬만 있으면 이런 반복 작업, 얼마든지 자동화할 수 있습니다. 바로 웹 스크래핑의 세계죠. 이건 해커나 실리콘밸리 개발자만의 영역이 아닙니다. 요즘은 영업팀, 부동산 중개인, 시장 조사원 등 다양한 분야에서 웹 스크래핑이 필수 역량이 되고 있어요. 전 세계 웹 스크래핑 소프트웨어 시장은 이미 를 넘어섰고, 2032년에는 두 배 이상 커질 전망입니다. 데이터가 곧 기회인 시대죠.

저는 공동 창업자로서, 수년간 기업들의 데이터 수집 자동화를 도와왔습니다. AI 웹 스크래퍼인 처럼 클릭 두 번이면 끝나는 시대가 오기 전, 저 역시 파이썬의 대표적인 웹 스크래핑 도구인 beautiful soup, requests와 함께 수많은 시행착오를 겪었죠. 이 글에서는 beautifulsoup 파이썬이 뭔지, 어떻게 설치하고 활용하는지, 그리고 여전히 많은 사람들이 이 도구를 선호하는 이유를 소개합니다. 마지막으로 Thunderbit 같은 AI 기반 도구가 어떻게 웹 스크래핑의 판을 바꾸고 있는지도 살펴볼게요. 파이썬 초보자든, 비즈니스 실무자든, 웹 스크래핑에 관심만 있다면 지금부터 같이 시작해봅시다.

BeautifulSoup이란? 파이썬 웹 스크래핑의 핵심 라이브러리

먼저 기본부터 짚고 넘어가죠. (줄여서 BS4)는 HTML과 XML 파일에서 원하는 데이터를 뽑아내는 파이썬 라이브러리입니다. 복잡하게 얽힌 웹 코드를 깔끔하게 정리해주는 HTML 탐정이라고 생각하면 됩니다. 덕분에 상품명, 가격, 리뷰 등 원하는 정보를 태그나 클래스명으로 손쉽게 추출할 수 있죠.

beautifulsoup 자체로 웹페이지를 가져오진 못합니다(이때는 requests 같은 라이브러리가 필요해요). 하지만 HTML만 있으면, 원하는 데이터만 쏙쏙 뽑아내는 데는 이만한 도구가 없습니다. 최근 한 설문조사에 따르면, 들이 beautifulsoup을 웹 스크래핑 도구로 선택했다고 합니다. 그만큼 신뢰받는 라이브러리죠.

beautifulsoup은 학술 연구, 이커머스 데이터 분석, 리드 생성 등 다양한 분야에서 활용됩니다. 마케팅팀이 인플루언서 리스트를 만들거나, 리크루터가 채용 공고를 수집하거나, 기자가 자동으로 기사 데이터를 모으는 데도 쓰입니다. 파이썬만 조금 다룰 줄 안다면, 누구나 쉽게 접근할 수 있습니다.

BeautifulSoup을 써야 하는 이유? 비즈니스 활용과 실제 사례

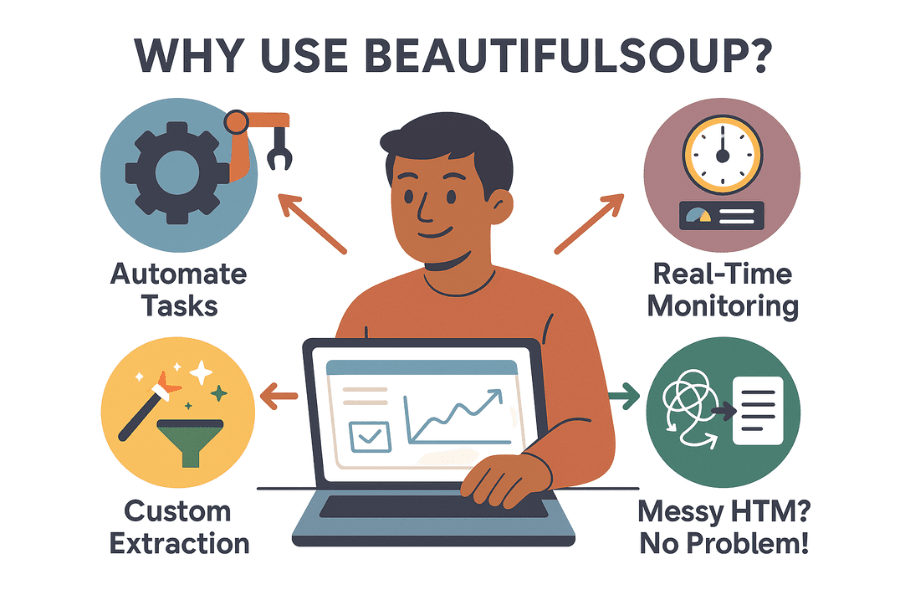

그렇다면 왜 많은 기업과 데이터 분석가들이 beautifulsoup을 선택할까요? 그 이유는 다음과 같습니다.

- 반복 작업 자동화: 복사-붙여넣기 대신 스크립트 한 번이면 수천 건의 데이터를 몇 분 만에 수집할 수 있습니다. 팀의 시간을 전략적 업무에 쓸 수 있죠.

- 실시간 모니터링: 경쟁사 가격, 재고, 뉴스 헤드라인 등을 주기적으로 체크할 수 있습니다. 경쟁사가 가격을 내리면 아침 커피 마시기 전에 바로 알 수 있죠.

- 맞춤형 데이터 추출: 인기 상품 TOP 10, 평점, 리뷰 등 원하는 정보만 정확하게 뽑아낼 수 있습니다.

- 지저분한 HTML도 문제없음: 코드가 엉망인 사이트도 대부분 잘 파싱해줍니다.

실제 활용 예시는 다음과 같습니다.

| 활용 사례 | 설명 | 기대 효과 |

|---|---|---|

| 리드 생성 | 비즈니스 디렉터리나 LinkedIn에서 이메일, 전화번호 수집 | 타겟 영업 리스트 구축 |

| 가격 모니터링 | 이커머스 사이트에서 경쟁사 가격 추적 | 실시간 가격 전략 수립 |

| 시장 조사 | 온라인 스토어에서 리뷰, 평점, 상품 정보 수집 | 트렌드 파악 및 제품 개발에 활용 |

| 부동산 데이터 | Zillow, Realtor.com 등에서 매물 정보 집계 | 가격 동향 분석, 투자 기회 탐색 |

| 콘텐츠 집계 | 뉴스, 블로그, SNS 언급 등 수집 | 뉴스레터, 감성 분석 등에 활용 |

실제 효과는 어떨까요? 한 영국 소매업체는 웹 스크래핑으로 경쟁사 동향을 모니터링해 했습니다. ASOS는 현지 가격 데이터를 스크래핑해 마케팅 전략을 조정, 해외 매출을 두 배로 늘렸습니다. 즉, 데이터 수집이 곧 비즈니스 성과로 이어집니다.

시작하기: 파이썬에 BeautifulSoup 설치하기

이제 본격적으로 시작해볼까요? beautifulsoup 파이썬을 설치하는 방법은 다음과 같습니다.

1단계: BeautifulSoup 설치(최신 버전으로)

최신 버전인 beautifulsoup4(bs4)를 설치하세요. 구버전 패키지명과 헷갈리지 않게 주의!

1pip install beautifulsoup4macOS나 Linux라면 pip3 또는 sudo를 사용할 수 있습니다.

1sudo pip3 install beautifulsoup4팁: pip install beautifulsoup(숫자 4 없이)로 설치하면 구버전이 설치되니 꼭 확인하세요.

2단계: 파서 설치(권장)

beautifulsoup은 파이썬 내장 HTML 파서도 쓸 수 있지만, 속도와 안정성을 위해 lxml과 html5lib 설치를 추천합니다.

1pip install lxml html5lib3단계: requests 설치(웹페이지 가져오기)

HTML을 가져오려면 라이브러리가 필요합니다.

1pip install requests4단계: 파이썬 환경 확인

파이썬 3을 사용하고 있는지 확인하세요. IDE(PyCharm, VS Code 등)에서는 인터프리터를 꼭 체크하세요. import 에러가 난다면 패키지가 잘못된 환경에 설치된 것일 수 있습니다. 윈도우에서는 py -m pip install beautifulsoup4로 정확한 버전에 설치할 수 있습니다.

5단계: 설치 확인

아래 코드를 실행해 정상 동작하는지 확인해보세요.

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("http://example.com").text

4soup = BeautifulSoup(html, "html.parser")

5print(soup.title)<title> 태그가 출력되면 성공입니다.

BeautifulSoup 기본 개념과 문법 익히기

beautifulsoup에서 자주 쓰는 주요 객체와 개념을 정리해봅니다.

- BeautifulSoup 객체: 파싱된 HTML 트리의 루트.

BeautifulSoup(html, parser)로 생성. - Tag:

<div>,<p>,<span>등 HTML/XML 태그를 나타냄. 속성, 자식, 텍스트 접근 가능. - NavigableString: 태그 내부의 텍스트를 나타냄.

파싱 트리 이해하기

HTML을 가족 트리로 생각해보세요. <html>이 조상, <head>, <body>가 자식, 그 아래로 계속 이어집니다. beautifulsoup은 이 트리를 파이썬스럽게 탐색할 수 있게 해줍니다.

예시:

1html = """

2<html>

3 <head><title>My Test Page</title></head>

4 <body>

5 <p class="story">Once upon a time <b>there were three little sisters</b>...</p>

6 </body>

7</html>

8"""

9soup = BeautifulSoup(html, "html.parser")

10# title 태그 접근

11print(soup.title) # <title>My Test Page</title>

12print(soup.title.string) # My Test Page

13# 첫 번째 <p> 태그와 class 속성 접근

14p_tag = soup.find('p', class_='story')

15print(p_tag['class']) # ['story']

16# <p> 태그 내부 전체 텍스트 추출

17print(p_tag.get_text()) # Once upon a time there were three little sisters...탐색과 검색

- 요소 접근:

soup.head,soup.body,tag.parent,tag.children - find() / find_all(): 태그명이나 속성으로 검색

- select(): CSS 선택자 활용 가능

예시:

1# 모든 링크 찾기

2for link in soup.find_all('a'):

3 print(link.get('href'))

4# CSS 선택자 예시

5for item in soup.select('div.product > span.price'):

6 print(item.get_text())실습: BeautifulSoup으로 나만의 웹 스크래퍼 만들기

실제 이커머스 검색 결과 페이지(예: Etsy)에서 상품명과 가격을 추출하는 예제를 살펴봅니다.

1단계: 웹페이지 가져오기

1import requests

2from bs4 import BeautifulSoup

3url = "https://www.etsy.com/search?q=clothes"

4headers = {"User-Agent": "Mozilla/5.0"} # 일부 사이트는 user-agent 필요

5resp = requests.get(url, headers=headers)

6soup = BeautifulSoup(resp.text, 'html.parser')2단계: 데이터 파싱 및 추출

각 상품이 <li class="wt-list-unstyled">에 있고, 제목은 <h3 class="v2-listing-card__title">, 가격은 <span class="currency-value">에 있다고 가정합니다.

1items = []

2for item in soup.find_all('li', class_='wt-list-unstyled'):

3 title_tag = item.find('h3', class_='v2-listing-card__title')

4 price_tag = item.find('span', class_='currency-value')

5 if title_tag and price_tag:

6 title = title_tag.get_text(strip=True)

7 price = price_tag.get_text(strip=True)

8 items.append((title, price))3단계: CSV 또는 엑셀로 저장

파이썬 내장 csv 모듈 활용:

1import csv

2with open("etsy_products.csv", "w", newline="", encoding="utf-8") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Product Title", "Price"])

5 writer.writerows(items)또는 사용:

1import pandas as pd

2df = pd.DataFrame(items, columns=["Product Title", "Price"])

3df.to_csv("etsy_products.csv", index=False)이제 분석, 리포트, 공유에 바로 쓸 수 있는 데이터가 완성됐습니다.

BeautifulSoup의 한계: 유지보수, 반스크래핑, 그리고 기술적 장벽

여기서 현실적인 이야기를 해볼게요. beautifulsoup은 정말 유용하지만, 대규모나 장기적으로 사용할 때는 몇 가지 어려움이 있습니다.

1. 사이트 구조 변경에 취약

웹사이트는 레이아웃, 클래스명, 요소 순서 등을 자주 바꿉니다. beautifulsoup 스크립트는 내가 작성한 선택자에 의존하기 때문에, 사이트가 조금만 바뀌어도 코드가 깨질 수 있습니다. 수십, 수백 개 사이트를 관리한다면 유지보수만으로도 큰 부담이죠.

2. 반스크래핑 방어

요즘 웹사이트는 CAPTCHA, IP 차단, 속도 제한, 자바스크립트 기반 동적 로딩 등 다양한 방어책을 씁니다. beautifulsoup만으로는 이런 문제를 해결할 수 없습니다. 프록시, 헤드리스 브라우저, 외부 CAPTCHA 솔버 등을 추가해야 하죠. 사이트 관리자와의 끝없는 숨바꼭질입니다.

3. 확장성과 성능

beautifulsoup은 소규모 스크립트나 중간 규모 데이터 수집에는 적합합니다. 하지만 수백만 페이지를 병렬로 크롤링하려면, 동시성 처리, 에러 핸들링, 인프라 구축 등 추가 작업이 필요합니다. 가능은 하지만, 손이 많이 갑니다.

4. 기술적 진입장벽

파이썬, HTML, 디버깅에 익숙하지 않다면 beautifulsoup은 다소 어렵게 느껴질 수 있습니다. 숙련된 개발자에게도 스크래핑은 '코드-실행-수정-반복'의 연속이죠.

5. 법적·윤리적 고려사항

robots.txt나 서비스 약관을 무시하면 법적 문제에 휘말릴 수 있습니다. 코드를 직접 짤 때는 속도 제한, 사이트 규칙 준수, 데이터 윤리 등도 신경 써야 합니다.

BeautifulSoup을 넘어: Thunderbit 같은 AI 웹 스크래퍼의 혁신

이제 진짜 혁신이 시작됩니다. AI의 발전으로 같은 도구는 코딩을 몰라도 누구나 웹 스크래핑을 할 수 있게 만들었습니다.

Thunderbit은 AI 기반 크롬 확장 프로그램으로, 클릭 두 번이면 어떤 웹사이트든 데이터를 추출할 수 있습니다. 파이썬, 선택자, 유지보수 걱정 없이, 페이지를 열고 'AI 필드 추천'을 누르면 Thunderbit의 AI가 상품명, 가격, 리뷰, 이메일, 전화번호 등 주요 데이터를 자동으로 인식합니다. '스크랩' 버튼만 누르면 끝입니다.

Thunderbit vs. BeautifulSoup: 비교표

| 기능 | BeautifulSoup(코딩) | Thunderbit(노코드 AI) |

|---|---|---|

| 설정 난이도 | 파이썬, HTML, 디버깅 필요 | 코딩 불필요, AI가 필드 자동 인식 |

| 데이터 추출 속도 | 코드 작성·테스트에 수 시간 | 클릭 2~3번, 수 분 내 완료 |

| 사이트 변경 대응 | HTML 구조 바뀌면 직접 수정 | AI가 대부분 자동 대응, 인기 사이트는 템플릿 제공 |

| 페이지네이션/하위페이지 | 직접 반복문·요청 작성 | 내장 기능으로 토글만 하면 됨 |

| 반봇 대응 | 프록시, CAPTCHA, 브라우저 시뮬레이션 직접 구현 | 대부분 내장 처리, 브라우저 환경으로 차단 회피 |

| 데이터 가공 | 직접 코드 작성 필요 | AI로 요약, 분류, 번역, 정제 가능 |

| 내보내기 옵션 | CSV, 엑셀, DB 등 직접 구현 | 클릭 한 번에 CSV, 엑셀, 구글시트, Airtable, Notion 등 |

| 확장성 | 인프라 직접 구축, 에러·재시도 관리 필요 | 확장성 높음, 대량 작업·스케줄링 지원(플랜/크레딧 한도 내) |

| 비용 | 오픈소스 무료, 시간·유지보수 비용 발생 | 소규모 무료, 대량 작업은 유료, 시간·유지보수 절감 |

| 유연성 | 코드로 모든 커스텀 가능 | 표준적 용도 대부분 지원, 특수 케이스는 코드 필요 |

더 자세한 비교는 와 에서 확인할 수 있습니다.

실전 비교: Thunderbit와 BeautifulSoup로 같은 데이터 추출하기

이커머스 사이트에서 상품 데이터를 추출하는 과정을 비교해봅니다.

BeautifulSoup 사용 시

- 브라우저 개발자 도구로 HTML 구조 분석

- 파이썬 코드 작성(페이지 요청, beautifulsoup 파싱, 데이터 추출)

- 선택자(클래스명, 태그 경로) 디버깅

- 페이지네이션은 반복문으로 직접 처리

- CSV/엑셀 내보내기 코드 추가

- 사이트 구조 바뀌면 1~5단계 반복

소요 시간: 신규 사이트 기준 1~2시간(반봇 이슈 있으면 더 소요)

Thunderbit 사용 시

- 크롬에서 대상 사이트 열기

- Thunderbit 확장 프로그램 실행

- 'AI 필드 추천' 클릭(상품명, 가격 등 자동 인식)

- 필요시 컬럼 조정 후 '스크랩' 클릭

- 페이지네이션/하위페이지는 토글로 설정

- 데이터 미리보기 후 원하는 포맷으로 내보내기

소요 시간: 2~5분. 코딩, 디버깅, 유지보수 필요 없음.

추가 기능: Thunderbit은 이메일, 전화번호, 이미지 추출, 자동 폼 입력 등도 지원합니다. 반복 작업을 대신해주는 초고속 인턴을 고용한 느낌이죠.

마무리 및 핵심 요약

웹 스크래핑은 이제 소수 개발자의 전유물이 아니라, 리드 생성부터 시장 조사까지 다양한 비즈니스에 필수 도구가 되었습니다. 은 파이썬을 조금만 다룰 줄 안다면 누구나 시작할 수 있는 강력한 도구입니다. 하지만 웹사이트가 점점 복잡해지고, 비즈니스 현장에서는 더 빠르고 쉬운 데이터 접근이 요구되면서 같은 AI 기반 도구가 새로운 표준으로 자리잡고 있습니다.

코딩을 즐기고, 나만의 맞춤형 스크래퍼를 만들고 싶다면 beautifulsoup이 최고의 선택입니다. 하지만 코딩 없이 빠르게 결과를 얻고 싶다면 Thunderbit이 정답입니다. 몇 시간씩 코드에 매달릴 필요 없이, AI로 문제를 해결해보세요.

직접 체험해보고 싶으신가요? 을 설치하거나, 에서 더 많은 튜토리얼을 확인해보세요. 파이썬에 더 도전하고 싶다면 beautifulsoup으로 계속 실습해보시고, 손목 스트레칭도 잊지 마세요!

즐거운 스크래핑 되세요!

더 읽어보기:

궁금한 점이나 경험담이 있다면 댓글로 남겨주세요. 저도 수많은 스크래퍼를 망가뜨려본 경험이 있습니다!