正直なところ、数年前までは「ウェブスクレイピング」が営業やオペレーションの現場で話題になるなんて、まったく想像していませんでした。でも2025年の今、不動産エージェントからECマネージャーまで、誰もがデータ抽出のコツを語り合う時代になっています。私自身、長年SaaSの自動化ツールを開発・活用してきましたが、今やウェブデータはIT部門だけのものではありません。リード獲得や価格調査など、現代ビジネスの推進力になっています。もしまだウェブスクレイパー、特にAIウェブスクレイパーを使っていないなら、手作業の時代に取り残されているかもしれません。

とはいえ、ツールが多すぎてどれを選べばいいのか迷うのも事実。間違った選択をすると、後悔が長引くことも。そこで今回は、2025年におすすめのウェブスクレイピングソフトを、ノーコードAIツールから本格的な開発者向けフレームワークまで徹底比較します。営業担当、EC運営者、単純作業を自動化したい方まで、きっと役立つ情報が見つかります。

2025年、なぜビジネスにウェブスクレイパーが必要なのか

まず「なぜ今ウェブスクレイピングなのか?」という疑問から。実は、。これは一時的なブームではなく、確かなトレンドです。しかも、成長をけん引しているのはIT企業だけではありません。営業・マーケティング・オペレーション部門も、ノーコードやローコードのスクレイパーの登場で、専門知識がなくてもデータ抽出ができるようになりました()。

ビジネスでの主な活用例

- リード獲得: 営業チームは公開ディレクトリやSNS、企業サイトからターゲットリストを自動生成。古いリストを買ったり、手当たり次第に電話をかける必要はありません。

- 市場調査・価格モニタリング: ECや小売部門は競合の価格や在庫、商品ラインナップを自動で追跡。John Lewisはを実現しています。

- 業務自動化: オペレーション部門は繰り返しのデータ収集作業を自動化し、手作業の時間を大幅に削減。

- 不動産インテリジェンス: 物件情報の一括取得やオーナー連絡先の抽出、市場動向の把握も一度に可能です。

さらに、、求人データの需要も50%増加しています。スピードと正確さが求められる今、ウェブスクレイパーは競争力を高める秘密兵器となっています。

AIウェブスクレイパーへの進化

従来のスクレイパーは強力でしたが、設定が難しく、根気も必要でした。今ではのようなAIウェブスクレイパーが登場し、誰でも数クリックで構造化データを抽出できる時代に。これにより、現場のチームが自分たちでデータを活用できるようになり、ボトルネックが解消。データが本当の競争優位となります。

最適なウェブスクレイパー/AIウェブスクレイパーの選び方

では、どんな基準でツールを選べばいいのでしょうか?私がウェブスクレイピングソフトを評価する際のチェックリストを紹介します(シンプルすぎて祖母でも使えるものから、ドキュメント用にモニターがもう1台欲しくなるものまで、色々試してきました)。

主な選定ポイント

- 使いやすさ: IT知識がなくてもすぐ使い始められるか?

- データ抽出の精度: サイト構造が変わっても正確にデータを取得できるか?

- 対応プラットフォーム: ブラウザ拡張、クラウドサービス、コードライブラリのどれか?

- 連携オプション: Google Sheets、Excel、Airtable、Notion、CRMなどに直接エクスポートできるか?

- 価格体系: 無料プランはあるか?従量課金か月額か?

- 自動化・スケジューリング: 定期実行が可能か?毎回手動で操作が必要か?

- AI機能: AIによるフィールド自動検出や複雑なサイト対応があるか?

まずは比較表で全体像をつかみましょう(詳細は後述します):

| ツール | コーディング要否 | AI機能 | スケジューリング | エクスポート先 | 主な強み |

|---|---|---|---|---|---|

| Thunderbit | 不要 | あり | あり | Sheets, Excel, Airtable, Notion | 最速セットアップ、AIフィールド検出 |

| Web Scraper | 不要 | なし | 限定的 | CSV, JSON, Sheets (クラウド) | ビジュアル設定、柔軟性高い |

| BeautifulSoup | 必要 | なし | なし | カスタム (CSV, JSON, DB) | シンプル、パースに最適 |

| Scrapy | 必要 | なし | あり | CSV, JSON, XML, API | 大規模クロールに強い |

| Playwright | 必要 | なし | なし | カスタム | JSサイト対応力抜群 |

| Apify | 不要/必要 | 一部あり | あり | CSV, JSON, Sheets, API | クラウド規模、プリセット豊富 |

Thunderbit:ビジネスユーザー向け最速AIウェブスクレイパー

は、営業・EC・不動産など、スピード重視の現場チーム向けに設計されたChrome拡張AIウェブスクレイパーです。IT部門の手を借りずに、誰でもすぐにデータ抽出が可能です。

主な特徴

![]()

- AIフィールド自動提案: 「AIフィールド提案」をクリックするだけで、ページを解析し、抽出すべきカラムを自動で提案。各フィールドのカスタムプロンプトも自動生成します。

- サブページ抽出: 一覧だけでなく、各詳細ページも自動巡回してデータを拡充。

- 即使えるテンプレート: Amazon、Zillow、Instagram、Shopifyなど人気サイト用テンプレートを選ぶだけ。AIクレジット不要。

- スケジュール実行: 「毎週月曜9時」など自然な日本語でスケジュール設定、定期的に自動実行。

- メール・電話・画像抽出&AI自動入力: ワンクリックで連絡先や画像を取得、AIがフォーム入力やウェブ操作も自動化。

- クラウド/ブラウザ選択: クラウド(最大50ページ同時処理)とブラウザ(ログインが必要なサイト向け)を使い分け可能。

もあり、6ページ(トライアルで10ページ)までお試し可能。多くのビジネスユーザーにとって、まずは十分な機能です。

実際の動作はや、、、などの解説記事もご覧ください。

Web Scraper:柔軟なブラウザ拡張型データ抽出ツール

Web Scraper()は、長年愛用されているChrome拡張型の定番ツール。ノーコード派でも、多少の設定に抵抗がなければ使いこなせます。サイトマップ(抽出手順の設計図)を作成し、どこをどう巡回・抽出するかを視覚的に指定します。

- ポイント&クリック操作: コーディング不要ですが、要素選択やナビゲーション設計の学習は必要。

- サブページ・ページネーション対応: 多階層サイトもOK。ただし手動設定が必要です。

- エクスポート: デフォルトはCSV/JSON。クラウド版ならGoogle SheetsやDropbox連携も。

- スケジューリング: 有料クラウドプランのみ対応。

- コミュニティサポート: ドキュメントやフォーラムは充実。ただしリアルタイムのサポートは限定的。

最大のメリットは柔軟性。デメリットは学習コスト。あるレビューでは「テック好きでないと使いこなせない」とも()。試行錯誤が苦手な方は、よりシンプルなツールを選ぶのも手です。

詳細な比較はもご参照ください。

BeautifulSoup:Pythonで自在にデータ抽出

ここからは開発者向けの領域です。は、HTMLやXMLの解析に特化したPythonライブラリ。Pythonが使えれば、思い通りのデータ抽出スクリプトを作成できます。

- UIなし: すべてコードで操作。

- 軽量&柔軟: 小〜中規模プロジェクトやPythonワークフローへの組み込みに最適。

- ページネーションは手動: ループやリンク追跡は自作が必要。

- スケジューリングなし: 自動化にはcronや外部タスク管理が必要。

- 出力先は自由: CSV/JSON/DBなど、用途に合わせてカスタマイズ可能。

BeautifulSoupは、ピンポイントなデータ抽出や大規模パイプラインの一部として最適。大規模クロールには不向きですが、Pythonユーザーの入門にもおすすめです。

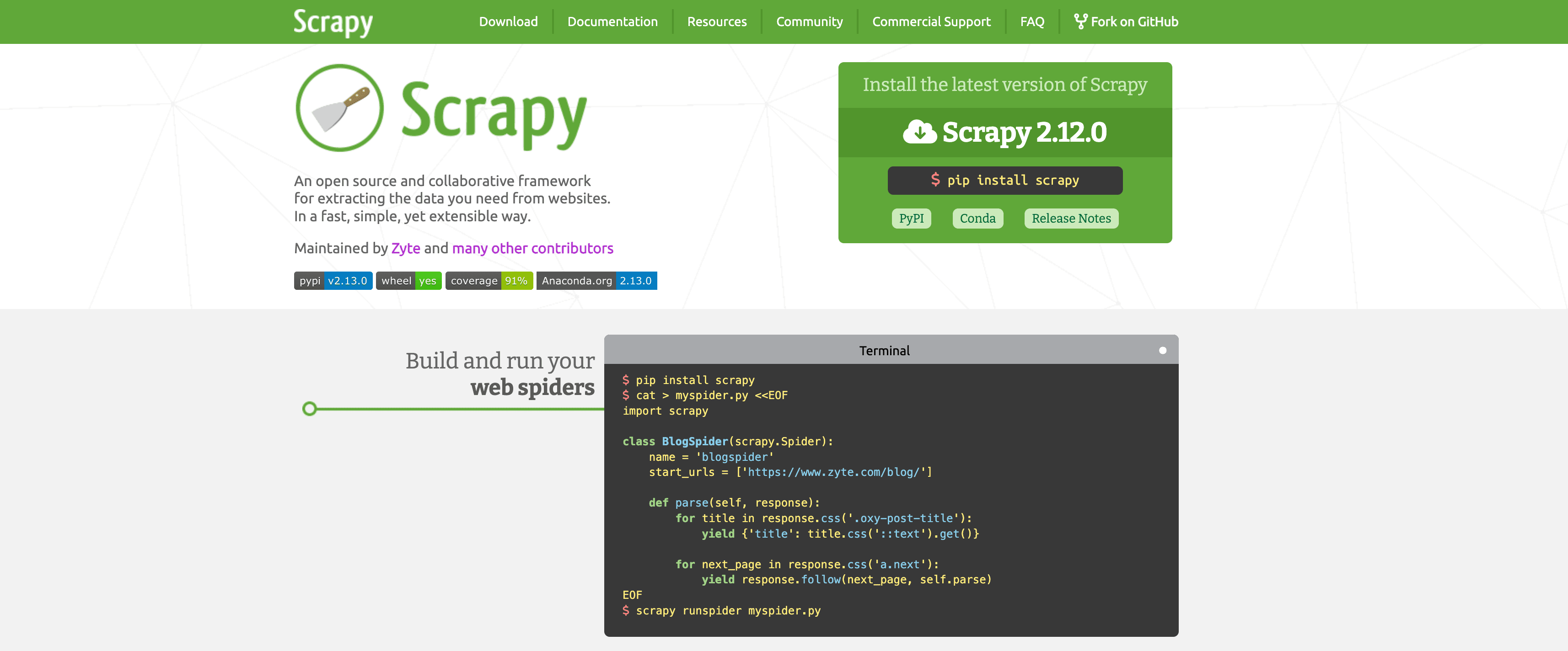

Scrapy:大規模データ抽出に最適なフレームワーク

BeautifulSoupが万能ナイフなら、は本格的な電動工具。大規模なクロールやデータ抽出に特化したPythonフレームワークです。

- 開発者向け: コマンドライン操作、Pythonクラス、プロジェクト構成が必須。

- 深いクロール対応: 自動でリンク追跡・ページネーション・robots.txt遵守。

- 高パフォーマンス: 非同期リクエスト、自動スロットリング、キャッシュ、リトライ機能。

- カスタムパイプライン: CSV/JSON/XML/API/DBなど多彩な出力先。

- スケジューリング: Scrapy Cloudやcron連携で自動実行。

- 拡張性: プロキシ・ユーザーエージェント切替、ヘッドレスブラウザ連携も可能。

デメリットは学習コストの高さ。ただし、数千〜数百万ページの安定したスクレイピングには最適です。

Playwright:最新のウェブ自動化ツール

一部のサイトはJavaScriptでデータを隠したり、ログインや複雑な操作を要求したりします。そんな時に活躍するのが()。PythonやJavaScriptなどで本物のブラウザを操作できる自動化ライブラリです。

- 動的コンテンツ対応: ReactやAngularなどJS主体のサイトもOK。

- ユーザー操作の再現: ボタン操作、フォーム入力、スクロール、要素の待機も自在。

- スケジューリングなし: 手動実行か外部スケジューラが必要。

- 出力先は自由: データ保存先は自分で決定。

- リソース消費大: ブラウザインスタンスごとにメモリ消費が大きく、中規模向け。

Playwrightは「ウェブの鍵師」。複雑なサイトも突破できますが、非エンジニアには難しく、Scrapyのような高速大量処理には不向きです。

Apify:クラウド型で大規模データ抽出を実現

は、ノーコードとコード両対応のクラウド型ウェブスクレイパープラットフォーム。自前でサーバーやプロキシを管理せずに大規模運用が可能です。

- プリセット「アクター」: Googleマップ、LinkedIn、Zillowなど主要サイト用のスクレイパーが多数。パラメータを入力するだけでOK。

- カスタムスクレイパー: 開発者はJavaScriptやPythonで独自アクターを作成・デプロイ可能。

- クラウドスケジューリング&並列実行: 複数ジョブの同時実行や定期実行も簡単。

- 連携機能: CSV/JSON/Excel/Google Sheets/API/Webhooks/n8n/Makeなど多彩。

- AI連携: 一部アクターはAIで抽出や分類を自動化。

- 学習コスト: アクターやデータセット、プロキシなど独自概念が多く、初心者にはやや難解ですが、ドキュメントは充実。

技術レベルが混在するチームや、大規模運用を手軽に始めたい組織に最適。ただし、パワフルな分だけ複雑さや従量課金には注意が必要です。

主要ウェブスクレイパー/AIウェブスクレイパー徹底比較

どのツールが自分に合うか、さらに詳しく比較してみましょう:

| ツール | ノーコード対応 | サブページ/ページネーション | スケジューリング | スケール性 | おすすめ用途 |

|---|---|---|---|---|---|

| Thunderbit | ⭐⭐⭐⭐⭐ | 自動 (AI) | 内蔵 | 中規模 | 営業・オペ・不動産 |

| Web Scraper | ⭐⭐ | 手動設定 | クラウドのみ | 中規模 | データ分析・根気ある人向け |

| BeautifulSoup | ⭐ | 手動 (コード) | なし | 小規模 | Python開発・小規模案件 |

| Scrapy | ⭐ | 自動 (コード) | あり | 大規模 | 開発者・大規模クロール |

| Playwright | ⭐ | 手動 (コード) | なし | 中規模 | 開発者・動的JSサイト |

| Apify | ⭐⭐⭐ | アクター依存 | 内蔵 | 大規模 | チーム・大規模案件 |

- Thunderbit:非エンジニアでもすぐ使える、AI自動化で最速データ取得。

- Web Scraper:学習意欲があれば柔軟に使えるが、完全な「お手軽」ではない。

- BeautifulSoup/Scrapy/Playwright:コードで細かく制御したい開発者向け。

- Apify:クラウド規模やプリセット重視、多少の複雑さも許容できるチーム向け。

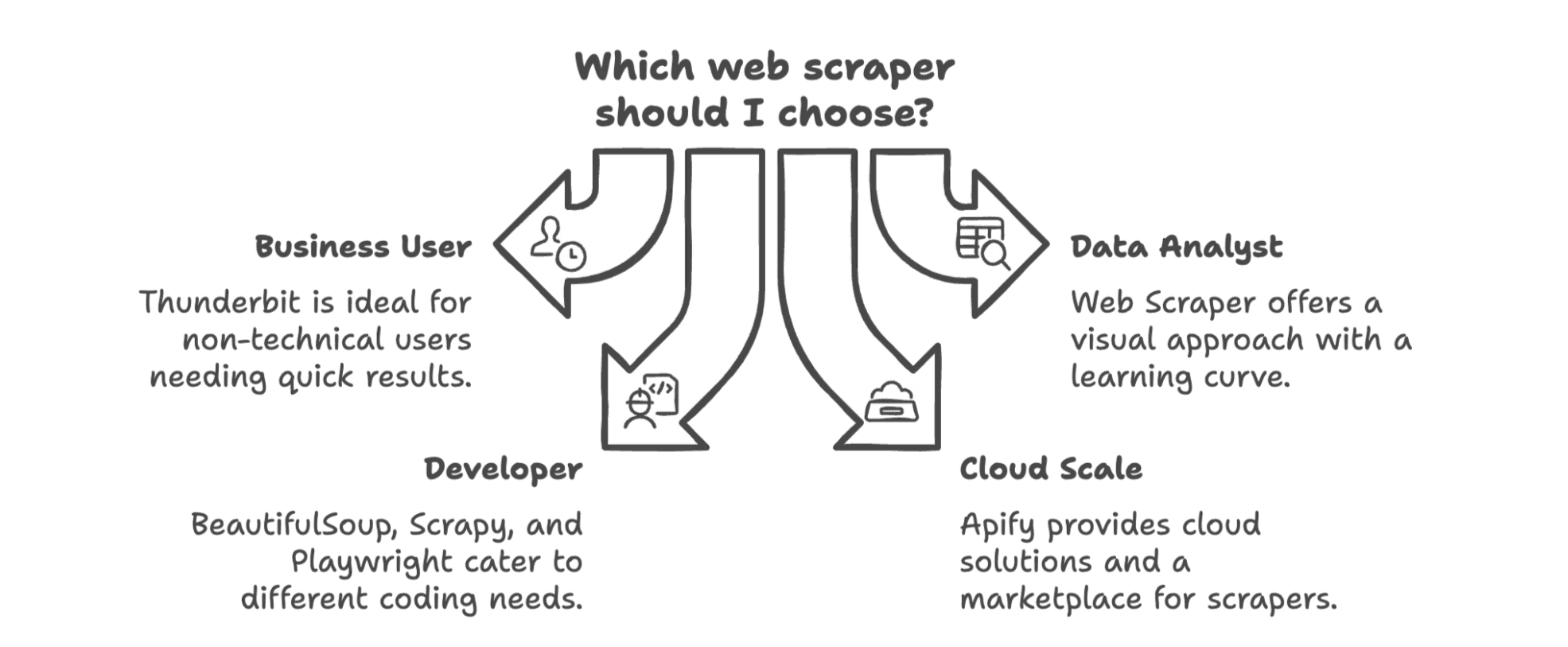

2025年、あなたのビジネスに最適なウェブスクレイパーは?

結論として、最適なウェブスクレイパーは「チームのスキル」と「データ活用の目的」によって異なります。

- **ビジネスユーザー(営業・マーケ・オペ)**でコード不要なら、が最適。エンジニア向けではなく、現場のための設計で、数分でデータ抽出が始められます。

- データ分析担当や学習意欲がある方は、Web Scraperのビジュアル設計が強力。ただし試行錯誤は覚悟を。

- 開発者なら、BeautifulSoupやScrapyが定番。手軽なスクリプトならBS4、大規模クロールならScrapy、動的サイトならPlaywright。

- クラウド規模やプリセット重視なら、Apifyが有力。スキルが混在するチームにもおすすめです。

今後はAI搭載・ノーコード・ワークフロー直結型が主流。従来の「抽出→ダウンロード→インポート→整形→繰り返し」は過去のもの。今やウェブからスプレッドシート(やCRM、Notion)まで数クリックで完結します。

ウェブスクレイピングの手軽さを体感したい方は、をぜひお試しください。さらに詳しいノウハウや裏話はで公開中です。

2025年こそ、コピペ作業から卒業し、AIに仕事を任せてみませんか?

よくある質問

Q1: 2025年、ウェブスクレイパー利用にコーディングスキルは必要ですか? A: もう不要です。ThunderbitのようなAI搭載ツールなら、非エンジニアでも数クリックでデータ抽出が可能。開発者はScrapyやPlaywrightで高度なカスタマイズもできます。

Q2: AIウェブスクレイパーで抽出できるデータの種類は? A: テキスト、数値、リンク、メールアドレス、電話番号、画像、PDFや動的サイトの構造化データまで幅広く対応。ツールによってはスケジューリングや翻訳、分類も自動化できます。

Q3: ビジネスでのウェブスクレイピングは合法ですか? A: 公開情報を正当なビジネス目的(調査やリード獲得など)で取得する場合は、基本的に問題ありません。ただし、認証が必要なページや著作権コンテンツの無断取得は避けましょう。

Q4: AIを使ったウェブスクレイピングの最大のメリットは? A: スピードと手軽さです。AIがフィールド検出やページネーション、ワークフロー自動化まで担うので、設定に悩む時間が減り、データ活用に集中できます。

さらに詳しく知りたい方へ