ウェブサイトから画像を集めたことがある人なら、ムードボード作りや商品カタログ作成、あるいはお気に入りのミームを保存したい時など、何度も右クリックして保存する作業がどれだけ手間か、きっと身にしみてるはずです。僕も同じ経験があって、長年自動化ツールを作ってきた中で(営業資料やECリサーチのために画像を大量に集めたことも数えきれません)、もっとラクなやり方が絶対あると断言できます。

この記事では、技術に自信がない人でもすぐ使える、ウェブサイトから画像をサクッと・簡単に・確実に集める10の方法を紹介します。マーケター、デザイナー、リサーチャー、あるいはお気に入りのブログから犬の写真を全部保存したい人まで、きっと自分に合ったやり方が見つかるはず。さらに、が提供している無料の画像エクストラクターも紹介します。これは僕自身が「ワンクリックで画像を一括取得したい!」という思いから作ったツールです。

なんでウェブサイトから画像を集めるの?ビジネスでのメリット

画像はただの飾りじゃなくて、今のビジネスコンテンツを支える超重要な要素です。、画像付きのブログはというデータも。マーケティング、営業、EC、リサーチなど、画像を大量かつスピーディーに集める場面は本当に多いですよね。

画像抽出が活躍するシーンはこんな感じ:

- コンテンツ制作・マーケティング: 新しいキャンペーンやブログ用にビジュアル素材が必要な時、画像一括ダウンローダーを使えば数分で素材ライブラリが完成。SNS投稿も画像付きなら。

- EC・小売: 競合サイトの商品画像を集めてトレンドや価格、カタログ戦略を分析したり、仕入先の画像をまとめてダウンロードして自社商品ページを更新したり。

- リサーチ・データ分析: 機械学習やジャーナリズム、市場調査のために何百・何千もの画像を効率よく集められる。

- デザイン・クリエイティブ: PinterestやDribbble、Google画像検索などからインスピレーション画像を一括で集めてムードボード作成。

- 営業・リード獲得: 企業ロゴや商品スクリーンショット、不動産写真などをウェブから直接CRMに取り込んでデータを充実。

つまり、画像を一枚ずつ保存してたら、めちゃくちゃ時間がかかってしまいます。ちゃんとした画像エクストラクターを使えば、何時間もかかる作業が数分で終わります。

良い画像ダウンローダー・画像エクストラクターの条件って?

画像ダウンローダーにもいろいろ種類があります。僕もたくさん試してきましたが、重要なのはこのポイント:

- 使いやすさ: 直感的に操作できて、ワンクリックで完結するのが理想。コードや難しい設定は不要。

- 一括取得機能: ページ内の全画像、または複数ページからまとめて取得できるか。

- 画像の品質・対応フォーマット: オリジナルの高解像度画像(サムネじゃなく)を取得できるか。JPEG、PNG、WebP、GIF、背景画像などに対応してるか。

- フィルタリング・選択機能: 必要な画像だけ選んでダウンロードできるか(広告やアイコン、ロゴを除外できるか)。

- 自動化・メタデータ取得: 画像URLやaltテキスト、キャプションなども同時に取得できるか。

- 対応プラットフォーム: ブラウザ拡張、ウェブアプリ、デスクトップソフト、スクリプトなど、用途に合った形態か。

- 信頼性・安全性: いろんなウェブサイトで動作し、マルウェアや余計なソフトが入ってないか。

- 無料・有料の違い: 基本機能は無料でも、クラウド保存や定期スクレイピングなど一部機能は有料の場合も。

画像ダウンローダーは画像ファイル自体を取得するツール、画像エクストラクター(またはスクレイパー)はメタデータ取得や動的ページ対応、複数ページの自動化など、より高度な処理が可能です。

画像ダウンローダー・画像エクストラクターの比較表

ウェブサイトから画像を集める代表的な10の方法・ツールを比較しました:

| 方法・ツール | 使いやすさ | 一括取得 | 対応プラットフォーム | 無料/有料 | おすすめ用途 |

|---|---|---|---|---|---|

| Thunderbit Image Extractor | 圧倒的に簡単(1クリック・AI搭載) | 可能(ページ内全画像・ページ送り対応) | Chrome | 完全無料 | 非技術者、Sheets/Notionへの即時エクスポート |

| ブラウザ拡張機能(Imageye, Fatkun, DownThemAll) | 簡単(ツールバーから操作) | 可能(ページ内全画像) | Chrome, Firefox | 無料 | その場でのダウンロード、中小規模バッチ |

| オンラインツール(extract.pics, Image Cyborg) | 非常に簡単(URL貼り付け) | 可能(1ページずつ) | どのブラウザでも | 無料(制限あり) | たまに使う、インストール不可な端末 |

| 手動(右クリック・検証) | 1枚なら簡単 | 不可(1枚ずつ) | どのブラウザでも | 無料 | 少数画像、トラブル時 |

| スクリーンショット・トリミング | 簡単 | 不可(手動) | どのOSでも | 無料 | 保護画像、素早いキャプチャ |

| URLリストから一括(JDownloader, wget) | やや中級 | 可能(数百枚一括) | Windows, Mac, Linux | 無料 | 画像URLリストがある場合 |

| 高度なソフト(Octoparse, Bulk Image Downloader) | やや中級(学習必要) | 可能(複数ページ・スケジューリング) | デスクトップ | 無料/有料 | 大規模・定期・高解像度ニーズ |

| Pythonスクリプト | 中〜上級 | 可能(カスタマイズ自在) | どの環境でも(Python) | 無料 | 開発者、自動化、独自ロジック |

| SNS系ツール(4K Stogram, Pinterest拡張) | 簡単 | 可能(アカウント/ボード全画像) | デスクトップ/ウェブ | 無料/有料 | Instagram, Pinterest等特殊サイト |

| クラウド型エクストラクター(MultCloud, Save to Drive) | 簡単 | 可能(1ページずつ) | どの端末+クラウド | 無料/有料 | チーム利用、クラウド直接保存 |

1. Thunderbit Image Extractor:ワンクリックで画像を一括取得

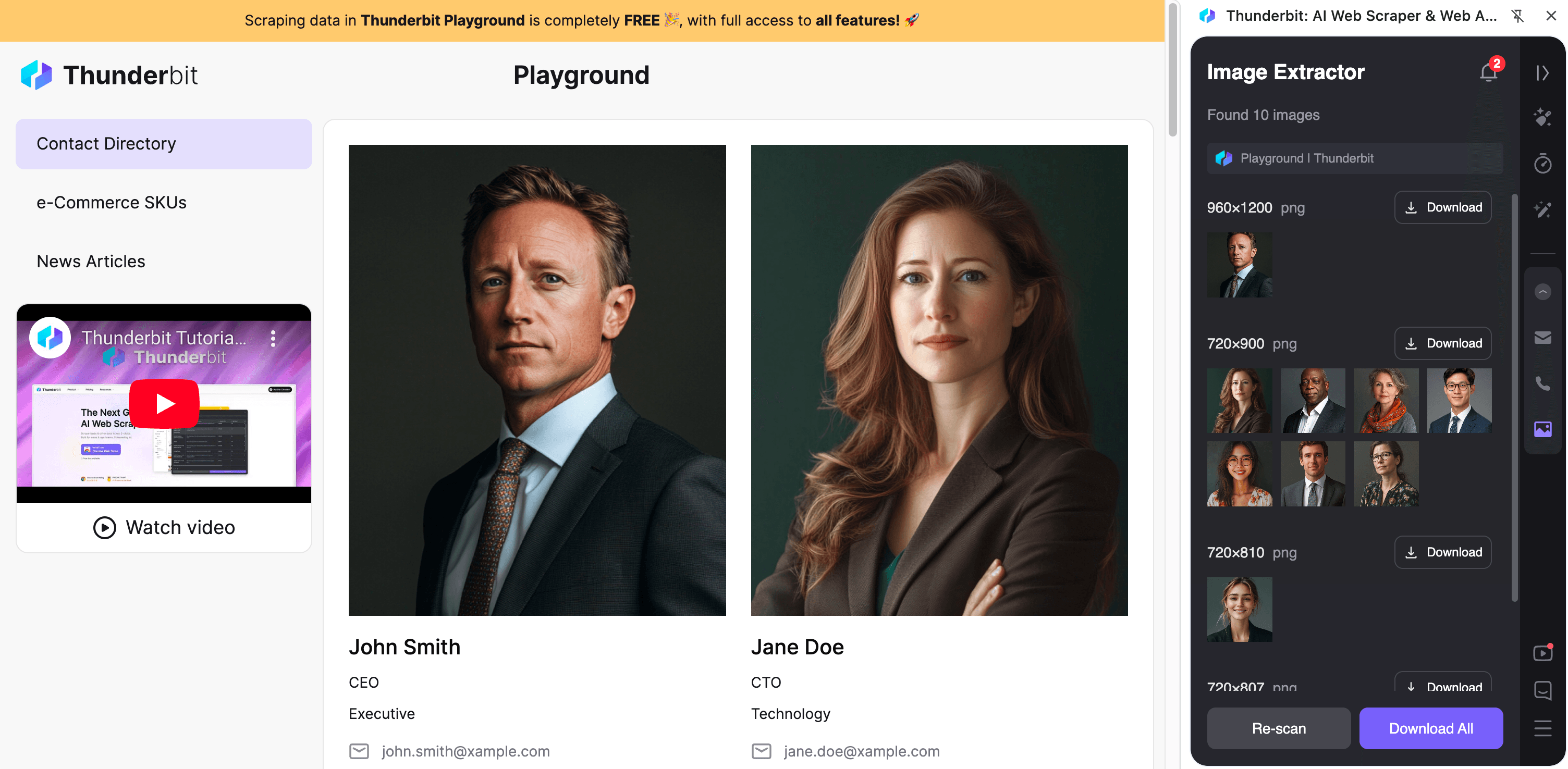

まずは僕が「こんなツール欲しかった!」と自分で作ったを紹介します。

ThunderbitはAI搭載ウェブスクレイピング用のChrome拡張で、画像エクストラクターは完全無料。使い方は超シンプル:

- ワンクリックで全画像取得: をインストールして、好きなウェブページで「Image Downloader」ボタンを押すだけ。AIがページ全体を解析して、すべての画像を一瞬で抽出。面倒な設定やHTML解析は一切不要。

- 一括ダウンロード・エクスポート: 画像をPCにまとめて保存したり、画像URLやサムネイルをGoogle Sheets、Notion、Airtableに直接エクスポートもOK。NotionやAirtableなら、実際の画像がデータベース上でそのまま見れます。

- 複雑なページもOK:

<img>タグだけじゃなく、背景画像や動的に読み込まれる画像もAIが自動で取得。EC商品ページやブログギャラリーなど、画像が多いサイトでも安心。 - ページ送り・サブページ対応: 複数ページにまたがる画像も自動で取得可能。商品カタログや不動産リストなど、大量画像の収集に最適。

- 完全無料: 画像エクストラクター機能は回数・枚数制限なし、ウォーターマークもなし(Thunderbitの無料プランは月間ページ数に制限あるけど、画像抽出はかなり軽いです)。

Thunderbitの画像エクストラクターは、「とにかく手間なく、確実に画像を集めたい」人にぴったり。Thunderbitで他のウェブスクレイピングもやってる人はもちろん、単発で画像を大量保存したい時にも最速の選択肢です。

実際に使ってみたい人は、して試してみてください。

2. ブラウザ拡張機能で画像をダウンロード

ブラウジング中にサクッと画像を集めたいなら、ブラウザ拡張機能が超便利。

Chrome向け画像ダウンローダー拡張

おすすめのChrome拡張機能はこれ:

- Image Downloader(Imageye): ページ内の全画像をプレビューして、サイズや種類でフィルタリングして選択ダウンロード可能。商品画像やブログ画像が多いページで特に便利。

- Fatkun Batch Download Image: ECサイト向けに最適化されていて、商品画像とその他のグラフィックを分けて取得可能。動的画像にも対応、80万人以上が利用中。

- Download All Images: 名前の通り、ページ内の全画像を一括でZIP保存。小さなアイコンや広告を除外するフィルターも設定できる。

- ImageAssistant(Batch Image Downloader): AJAXやFlashで読み込まれる画像も検出できて、他の拡張で見逃しがちな画像も拾える。

これらの拡張は無料で、ブラウザに統合されてるから使い勝手も抜群。ただし、1ページずつの対応なので、複数ページのギャラリーには繰り返し操作が必要。

Firefox向け画像エクストラクターアドオン

Firefoxユーザー向けの人気アドオン:

- DownThemAll!: ページ内の画像やリンクをフィルタリングして一括ダウンロードできる定番ダウンローダー。右クリックメニューからもサクッと操作可能。

- Download All Images: Chrome版と同じく、フィルタリングや一括保存に対応。

- Image Picka: 複数タブから画像を選んでダウンロードできて、ファイル名の一括リネームも可能。

Firefoxの裏技として、「ページ情報>メディア」から全画像をリスト表示して一括保存もできる(静的画像のみ対応)。

3. オンライン画像エクストラクターツール:インストール不要

インストールせずに使いたい時は、オンライン画像エクストラクターが便利。URLを貼るだけで画像を取得できます。

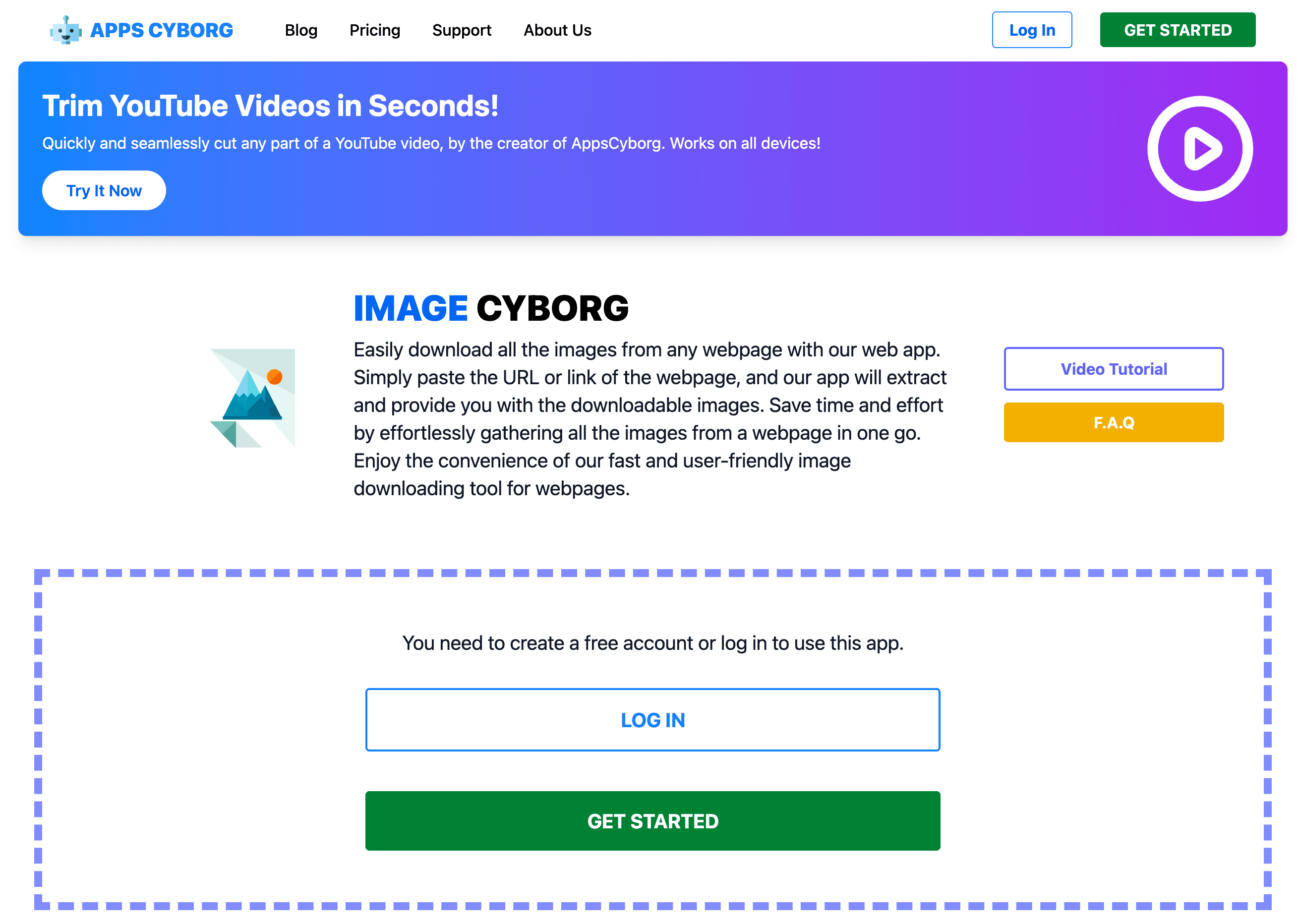

- Image Cyborg: ウェブページのURLを貼ると、全画像をZIPでまとめてダウンロード。手軽だけど、サムネや低解像度画像しか取れない場合も。

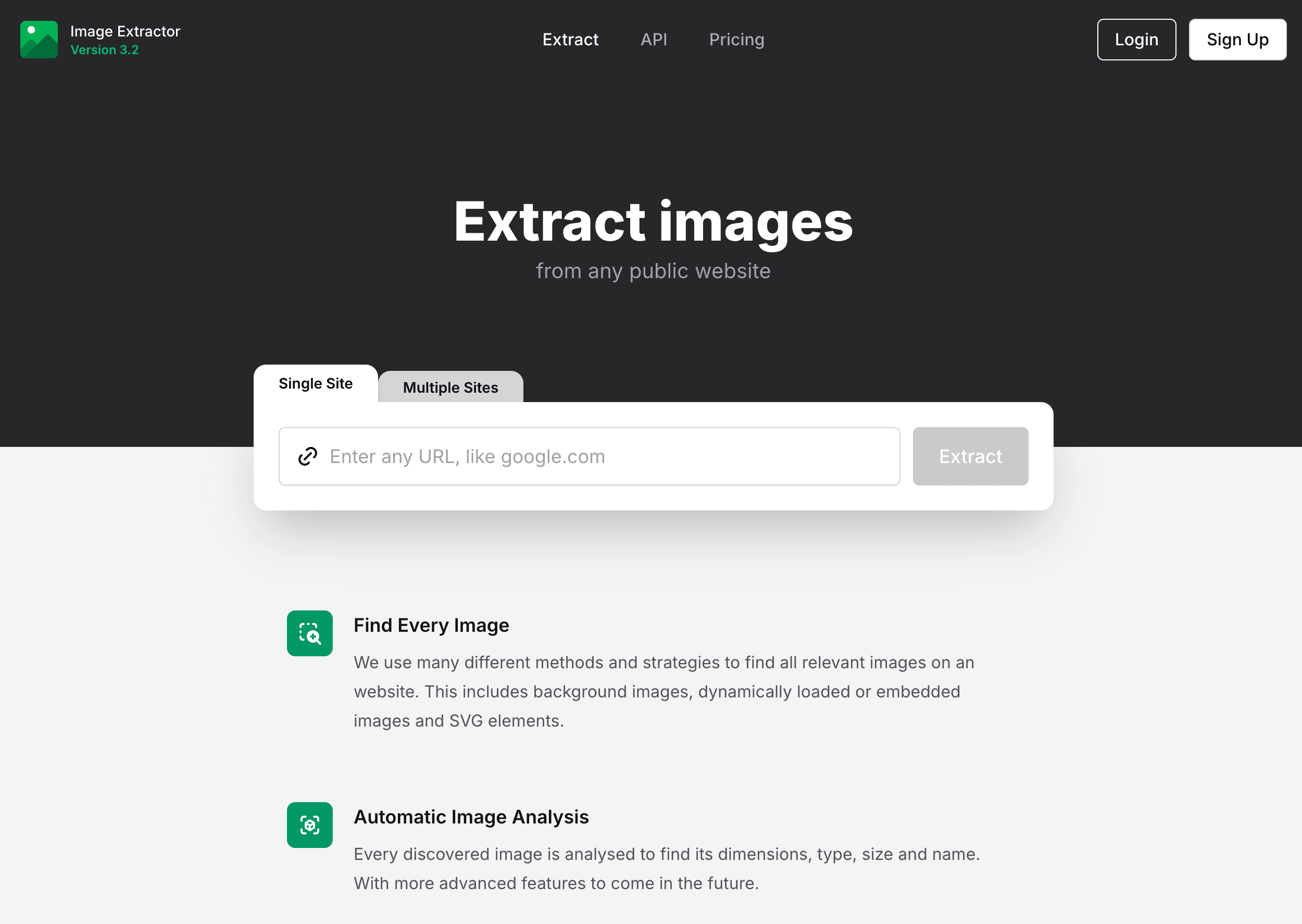

- Extract.pics: URLを貼って全画像をプレビュー、必要なものだけ選んでダウンロード可能。大量画像だとエラーが出ることも。

これらのツールは、インストール不可な端末や単発作業に最適。ただし、ログインが必要なページには対応できません。

4. 手動での保存:右クリック・要素検証

「右クリックして画像を保存」は昔ながらの方法。数枚なら確実だけど、5枚以上になると自動化したくなります。

- 右クリックで保存: どのブラウザ・OSでもOK。1〜2枚の画像に最適。

- 要素検証: 保護された画像や隠れた画像は、開発者ツールで

<img>タグや背景画像URLを探して、新しいタブで開いて保存。 - Firefoxのページ情報>メディア: ページ内の全画像をリスト表示して一括保存(静的画像のみ)。

手動方法はトラブル時や少数画像に有効だけど、大量画像には自動化が必須。

5. スクリーンショット&トリミング:最終手段

ダウンロードがブロックされてたり、特殊な埋め込み画像の場合は、スクリーンショットが有効。

- Windows: Print Screen、Snipping Tool、Snip & Sketch(Shift+Windowsキー+S)を活用。

- Mac: Command+Shift+4で範囲指定キャプチャ。

- トリミングして保存: 画像編集ソフトで必要部分を切り抜いて保存。

この方法はどんな状況でも使えるけど、画質は画面解像度に依存し、表示範囲しか取得できません。

6. URLリストから画像を一括ダウンロード

画像URLのリスト(スクレイパーやスプレッドシートから取得)を持ってる場合は、一括ダウンローダーが便利。

- JDownloader: 無料のオープンソースダウンローダー。URLリストを貼るだけで自動ダウンロード。

- wget(コマンドライン):

wget -i urls.txtでテキストファイル内の全URLを一括取得。 - Tab Saveなどのブラウザ拡張: URLリストを貼ってブラウザ上で一括ダウンロード。

データセット構築や、画像リンクだけ先に取得した場合に最適。

7. 上級者向け画像エクストラクターソフト

大規模なプロジェクトやパワーユーザーには、デスクトップソフトが最適。大量画像の抽出やスケジューリング、複雑なサイトにも対応。

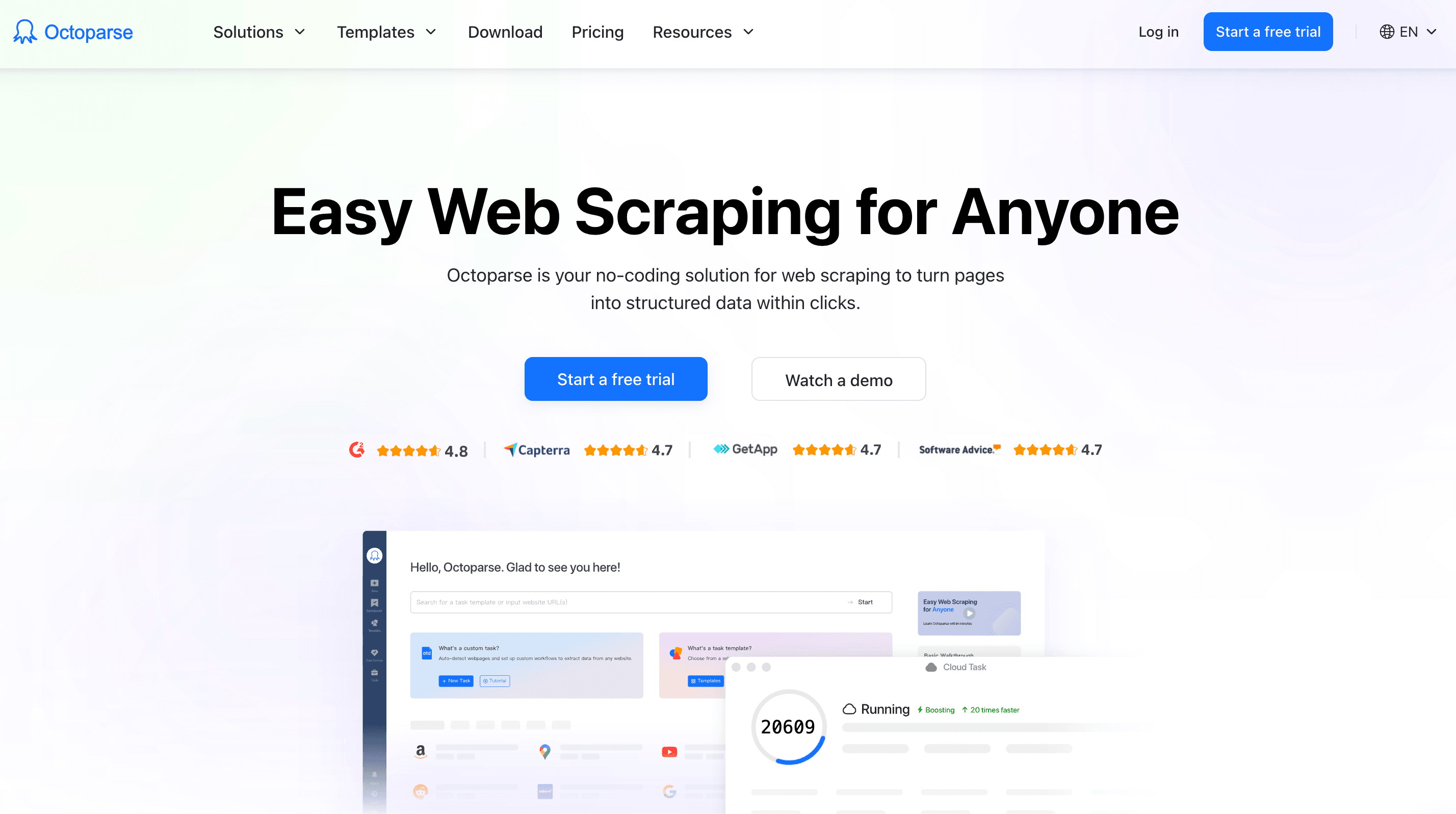

- Octoparse: ノーコードでウェブスクレイピングができて、画像・ページ送り・無限スクロール・ログインページにも対応。定期的なタスクやメタデータ取得にも最適。

- 4K Stogram: Instagram専用で、アカウント・ハッシュタグ・ストーリーの全画像を一括ダウンロード。

これらのツールは学習コストや有料プランが必要な場合もあるけど、大規模な画像収集や高度な機能が必要な時におすすめ。

8. Pythonスクリプトで画像を取得

プログラミングに慣れてる人なら、Pythonスクリプトが最強の選択肢。

基本的な例:

1import requests

2from bs4 import BeautifulSoup

3url = "<http://example.com/page-with-images>"

4response = requests.get(url)

5soup = BeautifulSoup(response.text, 'html.parser')

6img_tags = soup.find_all('img')

7for img in img_tags:

8 img_url = img.get('src')

9 if not img_url:

10 continue

11 # 相対パスの処理

12 if img_url.startswith('//'):

13 img_url = 'http:' + img_url

14 elif img_url.startswith('/'):

15 img_url = url + img_url

16 img_data = requests.get(img_url).content

17 filename = img_url.split('/')[-1]

18 with open(filename, 'wb') as f:

19 f.write(img_data)

20 print(f"Downloaded {filename}")Pythonなら複数ページの自動巡回やログイン対応、ダウンロードと同時の画像処理も自在。開発者やデータサイエンティストには大きな武器。

9. SNSや画像ギャラリーからの画像抽出

InstagramやPinterest、Google画像検索などのSNSは、無限スクロールや認証、スクレイピング対策があって一括ダウンロードが難しい場合も。

- Instagram: 4K StogramやSnapInsta、Instaloaderなどのオープンソーススクリプトでアカウントやハッシュタグの全画像を取得可能。[Thunderbitにもがあります。]

- Pinterest: 拡張機能やスクリプトでボード内の全ピンをダウンロード可能(事前に全画像を表示しておく必要あり)。

- Google画像検索: OctoparseやSeleniumスクリプトなど高度なツールで取得可能だけど、著作権やGoogleの対策には注意。

これらのツールは利用規約を守って、正しい用途で使いましょう。

10. クラウド型画像エクストラクター:直接クラウド保存

ダウンロードフォルダを経由せず、Google DriveやDropbox、OneDriveに直接画像を保存したい時はクラウド型エクストラクターが便利。

- MultCloudのImage Saver: ウェブページURLを貼ると全画像を取得して、クラウドストレージに直接保存可能。チーム作業やストレージ容量が限られた端末に最適。

- Google Drive/Dropbox拡張: 画像を右クリックしてクラウドに直接保存。

- Thunderbitのクラウドスクレイピング: Thunderbitは画像をクラウド経由でスクレイピングし、NotionやGoogle Sheets、Airtableにエクスポートできます。

チーム利用やリモートワーク、どこからでも画像にアクセスしたい人におすすめ。

まとめ:自分に合った画像エクストラクターの選び方

どの方法で画像を集めるべき?僕のおすすめは:

- スピードと手軽さ重視: やブラウザ拡張機能が最適。ワンクリックで全画像を取得できます。

- 大規模・定期的な作業: Octoparseなどの高度なソフトやPythonスクリプトがパワフル。定期的に画像を集めるなら投資する価値あり。

- SNSや特殊サイト: 専用ツールやプラットフォーム別エクストラクターを活用。

- チーム・クラウド重視: クラウド型エクストラクターでどこからでも画像を共有・管理。

そして、著作権や利用規約は必ず守ろう。正当なビジネス・リサーチ・クリエイティブ用途でのみ使って、他人のコンテンツを無断転載しないよう注意。

最終的には、自分の技術レベル・画像の量・作業フローに合った方法がベスト。今回紹介した10の方法で、もう画像保存に悩むことはありません。

画像収集をもっと効率化したい人は、Thunderbitブログでやなどのガイドもぜひチェックしてみてください。

よくある質問(FAQ)

1. なんでウェブサイトから画像を抽出するの?

マーケティング用のビジュアル集め、EC商品画像のダウンロード、AI学習用のリサーチサンプル、デザインのムードボード作成など、ビジネスやクリエイティブの現場で画像抽出は大きな効率化につながります。手作業より圧倒的に早く、まとめて取得できます。

2. 画像ダウンローダーと画像エクストラクターの違いは?

画像ダウンローダーは主に画像ファイルを取得するツール、画像エクストラクターはメタデータ(altテキストなど)や動的画像の取得、複数ページの一括ダウンロードなど、より高度な機能を持っています。

3. ウェブサイトの全画像を一括でダウンロードする一番簡単な方法は?

Thunderbitの無料画像エクストラクターのようなブラウザ拡張機能を使えば、ワンクリックでページ内の全画像(隠れた画像や背景画像も含む)を取得し、Google SheetsやNotionなどにURLを直接エクスポートできます。

4. 複数ページやサブページの画像を一括取得できるツールはある?

Thunderbitのようなツールは自動ページ送りやサブページの画像抽出にも対応。OctoparseやPythonスクリプトなど、より高度なツールなら複数リンク先も一括で巡回・取得可能です。

5. ウェブサイトから画像をダウンロードするのは合法?

利用目的やサイトによります。個人利用や教育・社内リサーチ目的なら問題ない場合が多いですが、無断転載や商用利用は著作権侵害になる可能性があります。必ずサイトの利用規約を確認して、適切に使いましょう。

さらに詳しく: