デジタルの世界で、ウェブサイトの全ページがきれいに一覧で揃っているのを見ると、まるで洗濯した靴下が全部ペアで戻ってきた時みたいな、ちょっとした満足感がありますよね。

でも、コンテンツ監査やサイト移行、あるいは「サイトの全ページを把握したい」と思っても、実際やってみると意外と大変。サイトマップやGoogle検索、CMSのエクスポートを駆使してリストを作っても、隠れページや動的に生成されるページが抜けてしまうこともよくあります。

特に、友達のWordPressサイトの全URLをエクスポートしようとした時は、コーヒー片手にちょっと絶望的な気分になりました。

でも、もう自分のサイトで「かくれんぼ」する必要はありません。このガイドでは、昔ながらの方法から最新のAIツール( など)まで、ウェブサイトのURLを取得する主要なやり方を分かりやすく紹介します。マーケター、開発者、あるいは「全URLを集めて」と頼まれた人も、実践的な手順や比較を通じて、ベストな方法が見つかるはずです。

なぜウェブサイトの全ページを取得する必要があるのか?

まず「なぜ必要なのか」を整理しましょう。実はSEOだけじゃなく、マーケティング、営業、IT、運用など、いろんな部門でウェブサイトのURLリストが求められています。主なケースはこんな感じです:

- SEOコンテンツ監査・戦略立案:コンテンツ監査は今や定番で、。全URLリストがあれば、パフォーマンス評価や古い記事の更新、順位アップに役立ちます。実際、。

- サイトリニューアル・移行: )。移行時には現行URLの把握とリダイレクト設定が必須です。

- コンプライアンス・保守:運用チームは、孤立したページや古いキャンペーンページなど、放置されたページを見つけて管理する必要があります。

- 競合分析:営業やマーケティング部門は、競合サイトの製品ページやブログ記事をリスト化し、チャンスやリードを探します。

- リード獲得・営業活動:営業チームは、店舗一覧や会員ページなどのリストを作成し、アプローチ先を網羅します。

- コンテンツ在庫管理:コンテンツ担当者は、ブログやLP、PDFなど全コンテンツをリスト化し、重複や抜け漏れを防ぎます。

以下の表で主なシナリオをまとめました:

| シナリオ | 対象者 | なぜ全ページリストが重要か |

|---|---|---|

| SEO監査 / コンテンツ監査 | SEO担当者、コンテンツマーケター | 全コンテンツを評価。抜けがあると分析や最適化が不完全に |

| サイト移行/リニューアル | 開発者、SEO、IT、マーケ | 旧URLと新URLのマッピング、リダイレクト、リンク切れ防止 |

| 競合分析 | マーケ、営業 | 競合の全ページを把握。隠れページが新たな発見に |

| リード獲得 | 営業チーム | 問い合わせ・リソースページを網羅。リードの取りこぼし防止 |

| コンテンツ在庫管理 | コンテンツマーケ | 最新リストを維持し、抜けや重複を防ぐ |

もし隠れページや未検出ページがあると、リニューアル時にコンバージョン中のLPを見落としたり、監査で5%のページが抜けていたりと、売上やSEO、時にはPRリスクにもつながります。

ウェブサイトのURLを取得する主な従来手法

では、実際どんな方法が使われているのでしょうか?昔からある定番のやり方をまとめます。

Google検索と検索演算子

方法:

Googleで site:yourwebsite.com と検索すると、そのドメインでインデックスされているページが一覧表示されます。キーワードやサブディレクトリで絞り込みも可能(例:site:yourwebsite.com/blog)。

得られるもの:

Googleが認識しているインデックス済みページのリスト。

制限:

- インデックス済みのみ。存在する全ページではない

- 数百件で打ち止め。大規模サイトは網羅不可

- 新規・隠れ・意図的に非公開のページは表示されない

おすすめシーン:

小規模サイトやざっと確認したい時に便利。網羅的な監査には不向き。

robots.txtとSitemap.xmlの確認

方法:

yourwebsite.com/robots.txt を開き、「Sitemap:」の記載を探します。sitemap(例:yourwebsite.com/sitemap.xml や /sitemap_index.xml)を開くと、サイト管理者がインデックスさせたいURL一覧が見られます。

得られるもの:

主要ページ(ブログ、商品ページなど)のリスト。 。

制限:

- サイト管理者が「インデックスさせたい」ページのみ。孤立ページは載らない

- sitemapが古い場合も

- 複数のsitemapがある場合もあり、探す手間がかかる

おすすめシーン:

自社サイトや競合の主要ページをざっと把握したい時に。

SEOスパイダー・ウェブクローラー

方法:

Screaming Frog、Sitebulb、DeepCrawlなどのツールで、サイトURLを入力すると内部リンクをたどってページ一覧を作成します。

得られるもの:

リンクされている全ページ+ステータスコードやメタ情報など。

制限:

- 孤立ページは手動で追加しないと検出不可

- 動的・JavaScript生成ページはツールによっては未対応

- 大規模サイトは時間・PCリソースを消費

- 専門知識や設定が必要

おすすめシーン:

SEO担当や開発者による本格監査向け。非技術者にはややハードル高め。

Google Search Console・Analytics

方法:

サイト管理者なら、Google Search Console(GSC)やAnalyticsからURLリストをエクスポート可能。

- GSC:インデックスカバレッジやパフォーマンスレポートで最大1,000件(APIならさらに多く)

- Analytics:一定期間にトラフィックがあった全ページ(GA4は最大10万行)

制限:

- GSC/AnalyticsはGoogleが認識・トラフィックのあったページのみ

- エクスポート上限あり(GSCは1,000件、GA4は10万件)

- サイト所有権が必要。競合調査には使えない

- トラフィックゼロや未インデックスページは出てこない

おすすめシーン:

自社サイトの移行や監査前に最適。競合調査には不向き。

CMSダッシュボード

方法:

WordPressやShopifyなどのCMSなら、管理画面からページや投稿のリストをエクスポート可能(プラグイン利用の場合も)。

得られるもの:

全コンテンツ(ページ、投稿、商品など)のリスト。

制限:

- 管理者権限が必要

- 非コンテンツや動的ページは含まれない場合も

- 複数システム利用時はエクスポートを統合する必要あり

おすすめシーン:

自社サイトの在庫管理やバックアップに最適。競合調査には不向き。

従来手法の限界

正直、どの方法も完璧じゃありません。主な課題はこんな感じです:

- 技術的ハードル:多くの方法は専門知識やツールが必要。非技術者には大きな壁。大規模サイトの手動監査は。

- 網羅性の不足:Googleは未インデックスや新規ページを見逃し、sitemapは孤立ページを拾えず、クローラーは非リンク・動的ページを見逃し、CMSエクスポートはシステム外をカバーできません。

- 手間と時間:複数ソースのデータを統合・重複排除・整形する作業は面倒でミスも起きやすい。sitemapをExcelにコピペしたり、コマンドラインでスクリプトを使う「裏技」もよく見かけます。

- 鮮度維持が大変:リストはすぐ古くなり、サイト更新のたびに再実行が必要。

- 権限の壁:管理者権限が必要な方法も多く、競合調査には使えません。

- データ過多:SEOスパイダーは技術情報が多すぎて、単純なURLリストが欲しいだけの時は逆に不便。

要するに、「レシピがコロコロ変わり、時々オーブンにロックされるケーキ作り」みたいなものです(実際にコンテンツ戦略担当者が例えた言葉です)。

Thunderbit登場:AIでウェブサイトURLを一括取得

ここからが本題です。「このサイトの全ページをリスト化して」とAIアシスタントに頼むだけで、コードも設定も不要で実現できたらどうでしょう?それがです。

Thunderbitは、非技術者でも使えるAI 웹 스크래퍼のChrome拡張機能(もちろんプロにも十分なパワー)。AIがウェブサイトを「読み取り」、データを構造化し、隠れページや動的ページ、サブページも含めて全URLをエクスポートできます。コードを書く必要も、複雑な設定も不要。サイトを開いて「AIで項目を提案」をクリックするだけで、あとはThunderbitが自動で処理します。

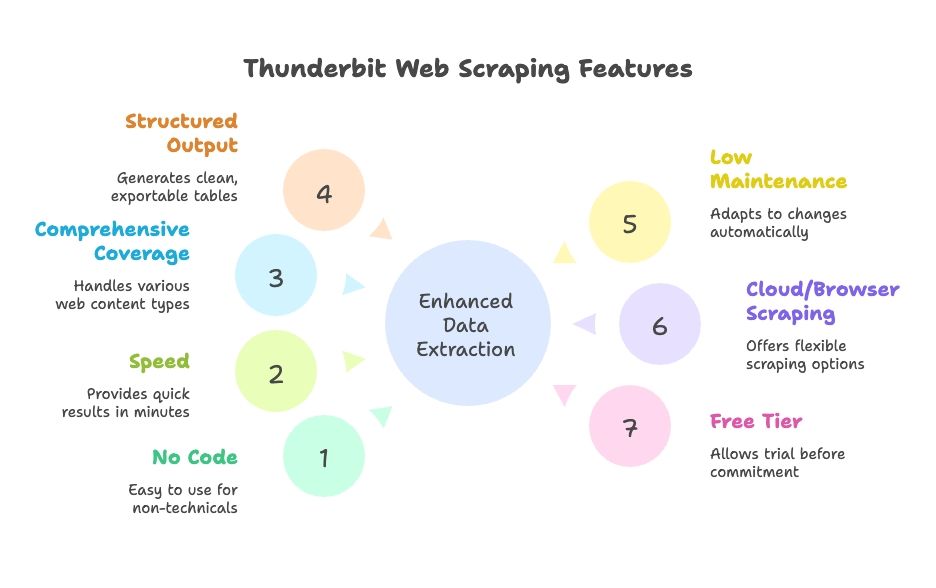

Thunderbitの特長:

- コード・設定不要:AIによる自然言語インターフェース。誰でも使えます。

- 高速:数分で結果が出るので、待ち時間が大幅短縮。

- 網羅性:動的コンテンツ、ページネーション、無限スクロール、サブページも対応。

- 構造化出力:Google Sheets、Excel、Airtable、Notion、CSV、JSONなどにワンクリックでエクスポート。

- メンテナンス不要:AIがサイトの変化に自動対応。微調整の手間が減ります。

- クラウド・ブラウザ両対応:ワークフローに合わせて選択可能。

- 無料プランあり:まずは気軽に試せます。

Thunderbitでウェブサイトページ取得が簡単になる理由

Thunderbitの実際の使い方をステップごとにご紹介します。「全ページリストが必要」から「はい、スプレッドシートできました!」まで、数クリックで完了します。

ステップ1:Thunderbitをインストール&起動

をダウンロードし、ブラウザにピン留め。取得したいサイト(例:自社ホームページ)を開き、Thunderbitアイコンをクリックしてインターフェースを表示します。

ワンポイント:新規ユーザーには無料クレジットが付与されるので、気軽にお試し可能です。

ステップ2:データ取得元を選択

Thunderbitはデフォルトで現在のページをスクレイピングしますが、URLリスト(sitemapやカテゴリページなど)を入力して特定セクションから開始することも可能です。

- 多くのサイトはホームページやsitemapページから始めるのが一般的。

- ECサイトならカテゴリや商品一覧ページからもOK。

ステップ3:「AIで項目を提案」でURLを自動検出

ここでAIの出番です。「AIで項目を提案」(または「AIでカラムを提案」)をクリックすると、ThunderbitのAIがページを解析し、「ページタイトル」「ページURL」などのカラムを自動で提案します。必要に応じてカラムの追加・削除も可能です。

- ホームページならナビゲーションやフッター、特集リンクなどが抽出されます。

- sitemapならURLの一覧がきれいに取得できます。

- 抽出したい項目を自由に調整可能。

ThunderbitのAIが裏側で複雑な作業を自動化。XPathsやCSSセレクタを書く必要はありません。まるで「理解力のあるロボットインターン」がいる感覚です。

ステップ4:サブページスクレイピングを有効化

多くのサイトはホームページだけでは全ページが網羅されません。そこでThunderbitのサブページスクレイピング機能を使います。URLカラムを「フォロー」リンクに指定すると、Thunderbitが各リンク先をたどり、さらにそのページからもURLを抽出します。多階層のスクレイピングもテンプレートで設定可能です。

- ページネーションや「もっと見る」ボタンがある場合はページネーション&スクロールを有効に。

- サブドメインやセクション(例: )もThunderbitなら対応可能。

ステップ5:スクレイピング実行

「スクレイプ」ボタンをクリックすると、ThunderbitがリアルタイムでURL(および指定した項目)をテーブルに自動入力します。大規模サイトでもバックグラウンドで処理でき、完了後に結果を確認できます。

ステップ6:結果確認&エクスポート

完了したら、Thunderbit上で重複除去や並べ替え、フィルタリングも可能。そのままGoogle Sheets、Excel、CSV、Airtable、Notion、JSONなどにワンクリックでエクスポートできます。もうコピペや面倒な整形作業は不要です。

全体の流れは? 小~中規模サイトなら10分以内で全URLリストが完成。大規模サイトでも従来より圧倒的に速く、ストレスも激減します。

Thunderbitで隠れページ・動的ページも発見

Thunderbitの大きな強みは、従来ツールが見逃しがちなページもカバーできる点です:

- JavaScript生成コンテンツ:Thunderbitは実際のブラウザ上で動作するため、無限スクロールや動的リストも取得可能。

- 孤立・非リンクページ:sitemapや検索機能などのヒントがあれば、リンクされていないページも発見できます。

- サブドメイン・セクション横断:必要に応じてサブドメインもたどり、全体像を把握。

- ユーザー操作の自動化:検索ボックス入力やフィルタクリックなどもAIオートフィルで自動化。

実例:マーケティングチームが古いLPを探していた際、ThunderbitでGoogle検索結果や既知のURLパターンを活用し、忘れられていたページを多数発見。混乱やトラブルを未然に防げました。

Thunderbitと従来手法の比較:スピード・簡単さ・網羅性

Thunderbitと従来手法を比較してみましょう:

| 項目 | Google「site:」検索 | XML Sitemap | SEOクローラー(Screaming Frog) | Google Search Console | CMSエクスポート | Thunderbit AIウェブスクレイパー |

|---|---|---|---|---|---|---|

| スピード | 速いが限定的 | sitemapがあれば即時 | 数分~数時間 | 小規模なら速い | 小規模なら即時 | 数分で設定・自動取得 |

| 使いやすさ | 非常に簡単 | 簡単 | 中程度(設定必要) | 中程度 | 管理者なら簡単 | コード不要で非常に簡単 |

| 網羅性 | 低(インデックスのみ) | 主要ページは高 | リンクページは高 | インデックス済みは高・エクスポート制限あり | コンテンツのみ中 | 非常に高い。動的・サブページも対応 |

| 出力・連携 | 手動コピペ | XML(解析必要) | CSV(余計なデータ多い) | CSV/Excel(最大1,000件) | CSV/XML(整形必要) | クリーンなテーブル。SheetsやExcel等にワンクリック出力 |

| メンテナンス | 手動で再実行 | sitemap更新必要 | サイト変更ごとに再クロール | 定期エクスポート | 変更時にエクスポート | 低負荷。AIが自動対応・定期実行も可能 |

Thunderbitは使いやすさ・網羅性・連携性で優れています。従来手法はそれぞれ強みがあるものの、結果を統合・最新化する手間がかかります。ThunderbitはAIがサイト変化に自動対応するので、設定や手動エクスポートの手間が大幅に減ります。

どの方法を選ぶべき?おすすめの使い分け

どの方法が自分に合っているか、実際の現場経験からアドバイスします:

- SEO担当・開発者:メタタグやリンク切れなど技術的な深掘りが必要なら、クローラーや自作スクリプトも有効。ただし、ThunderbitでURLリストを素早く取得し、他ツールに流用するのもおすすめ。

- マーケター・コンテンツ担当・PM:Thunderbitは救世主。IT部門に頼らず、自分で在庫管理や競合分析、簡易監査ができます。

- 営業・リード獲得:店舗一覧やイベントページ、会員ディレクトリなどもThunderbitなら簡単にリスト化できます。

- 小規模サイト・単発作業:手動やsitemapでも十分な場合も。ただしThunderbitのセットアップは非常に速いので、抜け漏れ防止のためにもおすすめ。

- コスト重視:従来手法は低コスト(ただし時間はかかる)。Thunderbitは無料プランもあり、有料でも多くの企業にとって手頃。時間の価値も考えましょう。

- 高度なカスタムデータ:非常に特殊なデータや複雑なロジックが必要な場合は自作も検討。ただしThunderbitのAIで大半のケースはカバー可能です。

選択のヒント:

- サイト所有で1,000ページ未満ならGoogle Search Consoleエクスポートも有効。ただし抜けがないか要確認。

- サイト権限がない・競合調査ならThunderbitやクローラーが便利。

- 時間効率や拡張性重視ならThunderbitが最適。

- チームでの共同作業にはThunderbitのGoogle Sheets連携が大きな強み。

多くの組織は、Thunderbitで迅速な作業や非技術者の自立を実現し、従来ツールで深掘り監査を行う「ハイブリッド運用」をしています。

まとめ:あらゆるビジネスで役立つウェブサイトページ取得

最後にポイントをまとめます:

- ウェブサイト全ページのリスト化は、SEO・コンテンツ戦略・移行・営業調査に不可欠。抜け漏れやリンク切れ、機会損失を防ぎます。多くのマーケターが年1回以上コンテンツ監査を実施しています()。

- 従来手法はそれぞれ限界がある。どれか一つで完全・最新リストは難しく、技術的ハードルや複数出力の統合も必要です。

- AIスクレイピング(Thunderbit)は現代的な解決策。AIが「考えて」「クリックして」くれるので、誰でも簡単に웹 스크래핑が可能。動的コンテンツやサブページも対応し、すぐ使えるデータ形式で出力。時間短縮・ミス削減に大きく貢献します。従来の何倍も速く、学習コストもほぼゼロです()。

- 自分のニーズやチームに合った方法を選びましょう。大規模サイトは複数ツール併用も有効ですが、多くのビジネスユーザーにはThunderbit単体で十分です。

- 定期的な更新が大切。定期監査で早期に問題を発見し、サイトを最適化。Thunderbitならスケジューリングも簡単、手動作業はつい後回しになりがちです。

最後に:自社サイト(や競合サイト)の全ページを把握できない言い訳は、もう必要ありません。正しい方法を使えば、全ページを網羅し、SEOやUX、ビジネス戦略の改善に役立てられます。AIに任せて、賢く効率的にサイト管理を進めましょう。

次のステップ

「全URLリスト作成」の憂鬱から解放されたい方は、して自社サイトや競合サイトで試してみてください。驚くほどの時短とストレス軽減を実感できるはずです。さらに웹 스크래핑を深く学びたい方は、の他のガイドもぜひご覧ください。 や なども参考になります。

よくある質問(FAQ)

1. なぜウェブサイト全ページのリストが必要なのですか?

SEO、マーケティング、営業、ITなど多くのチームが、コンテンツ監査やサイト移行、リード獲得、競合分析などの目的で全URLリストを必要とします。正確なリストがあれば、リンク切れや重複・忘れられたコンテンツを防ぎ、隠れたチャンスも見つけやすくなります。

2. 従来のウェブサイトURL取得方法は?

Googleの「site:」検索、sitemap.xmlやrobots.txtの確認、Screaming FrogなどのSEOツールによるクロール、WordPressなどCMSからのエクスポート、Google Search ConsoleやAnalyticsからのデータ抽出などが一般的です。ただし、どの方法も網羅性や使いやすさに限界があります。

3. 従来手法の課題は?

動的・孤立・未インデックスページを見逃しやすく、技術知識が必要だったり、データ統合や整形に時間がかかったりします。大規模サイトや定期監査にはスケールしにくく、管理者権限が必要な場合も多いです。

4. Thunderbitはどのように全ページ取得を簡単にしますか?

ThunderbitはAI搭載の웹 스크래퍼で、人間のようにサブページをたどり、JavaScriptにも対応し、自動でデータを構造化します。コード不要、Chrome拡張で動作し、Google SheetsやExcel、CSVなどに数分でクリーンなURLリストを出力できます。

5. Thunderbitと従来ツール、どちらを使うべき?

Thunderbitは、マーケターやコンテンツ担当、営業、非技術者が手軽に素早く全URLリストを取得したい場合に最適です。従来ツールは、より詳細なメタデータやカスタムスクリプトが必要な技術監査向け。多くのチームは、Thunderbitでスピードと手軽さを、従来ツールで深掘り分析を両立しています。