Ich erinnere mich noch genau an mein erstes Mal, als ich für ein Nebenprojekt Daten von einer Website ziehen wollte. Da saß ich, starrte auf einen Haufen HTML und hatte das Gefühl, als müsste ich plötzlich Hieroglyphen entziffern. Heute sieht das Ganze ganz anders aus: Selbst meine Freunde, die mit Technik nichts am Hut haben, stellen sich individuelle Datensätze für ihr Business zusammen – und das komplett ohne Programmierkenntnisse. Genau das ist das Coole (okay, Magie ist es nicht, aber schon ziemlich smarte KI) an der neuen Generation von Tools für individuelle Extraktion. Falls du dich auch schon mal wie im Copy-Paste-Steinzeitalter gefühlt hast: Du bist nicht allein. Die gute Nachricht? Der Weg von ein paar Klicks zu perfekt sortierten Spalten ist heute einfacher – und mächtiger – als je zuvor.

In diesem Deep Dive zeige ich dir, was individuelle Extraktion wirklich bedeutet, warum sie für moderne Unternehmen unverzichtbar ist und wie KI-Web-Scraper wie individuelle Datenerfassung für alle zugänglich machen. Egal ob Vertrieb, E-Commerce, Operations oder einfach genervt von monotoner Webarbeit – du wirst sehen, wie die richtigen Tools stundenlange Handarbeit in strukturierte, nutzbare Daten verwandeln – ganz ohne Code.

Was bedeutet individuelle Extraktion bei der Datenerfassung?

Lass uns mit den Basics starten: Individuelle Extraktion heißt, dass du den Prozess so anpasst, dass genau die Infos von einer Website gezogen werden, die du wirklich brauchst – und nicht nur das, was ein Standard-Scraper ausspuckt. Stell dir das vor wie à la carte bestellen statt das Menü von der Stange zu nehmen. Standard-Web-Scraper holen meist Titel, Preise oder Metadaten – aber was, wenn du etwas Spezielles brauchst, wie die „Materialzusammensetzung“ eines Produkts oder ein verstecktes „Verfügbarkeitslabel“? Genau hier kommt die individuelle Extraktion ins Spiel.

Mit individueller Extraktion kannst du gezielt Felder, Muster oder sogar bestimmte Seitenbereiche definieren, die extrahiert werden sollen – perfekt zugeschnitten auf deine Anforderungen. Das ist wie ein Metalldetektor, der nicht nur Münzen, sondern gezielt deinen Schatz findet – egal wie versteckt oder ungewöhnlich er auf der Seite liegt (). Diese Flexibilität ist besonders wichtig, wenn du mit nicht standardisierten Daten arbeitest, etwa mit speziellen Labels, verschachtelten Tabellen oder Inhalten, die erst nach einer Nutzeraktion erscheinen.

Der Haken: Klassische individuelle Extraktion bedeutete bisher meist, dass man technisch werden musste – XPath, CSS-Selektoren oder Regex schreiben, um die Daten zu finden. Das ist zwar mächtig, aber auch aufwendig in Einrichtung und Wartung (dazu gleich mehr). Der eigentliche Durchbruch kommt, wenn du diese Flexibilität ohne technischen Aufwand bekommst.

Warum individuelle Extraktion für Unternehmen so wichtig ist

Warum also der Aufwand für individuelle Extraktion? Weil im datengetriebenen Zeitalter die richtigen Daten – und nicht einfach irgendwelche – über Erfolg oder Misserfolg entscheiden. Der globale Markt für Web-Scraping-Software lag , und bis 2032 werden fast 144 Milliarden Dollar erwartet. Das sind nicht nur viele Nullen – das zeigt, wie zentral Webdaten für moderne Unternehmen geworden sind.

So bringt individuelle Extraktion echten Mehrwert für verschiedene Teams:

| Business Use Case | Individuell extrahierte Daten | Vorteil / ROI |

|---|---|---|

| Vertrieb – Lead-Generierung | Kontaktdaten aus Verzeichnissen, sozialen Netzwerken | Größere, gezieltere Lead-Listen; spart Recherchezeit; bis zu 80% Zeitersparnis |

| E-Commerce – Preisüberwachung | Wettbewerberpreise, Lagerbestände | Optimierte Preisgestaltung; direkter Umsatzanstieg (John Lewis erzielte 4% mehr Umsatz) |

| Operations – Datenreporting | Marktdaten, Compliance-Informationen | Automatisierte Berichte; wöchentliche Zeitersparnis; schnellere Entscheidungen |

| Immobilien – Marktforschung | Inserate, Eigentümerkontakte, Trendmetriken | Umfassender Marktüberblick; bessere Investitionsentscheidungen; 50% mehr Webdaten-Nutzung |

Konkret: Vertriebsteams können gezielte Listen selbst erstellen und müssen keine veralteten Leads mehr kaufen. E-Commerce-Manager überwachen Wettbewerberpreise fast in Echtzeit und passen ihre Strategie an. Operations-Teams automatisieren wiederkehrende Datenabfragen und sparen so viele Stunden. Immobilienmakler bündeln Inserate und Eigentümerinfos von mehreren Portalen und verschaffen sich so einen Vorsprung.

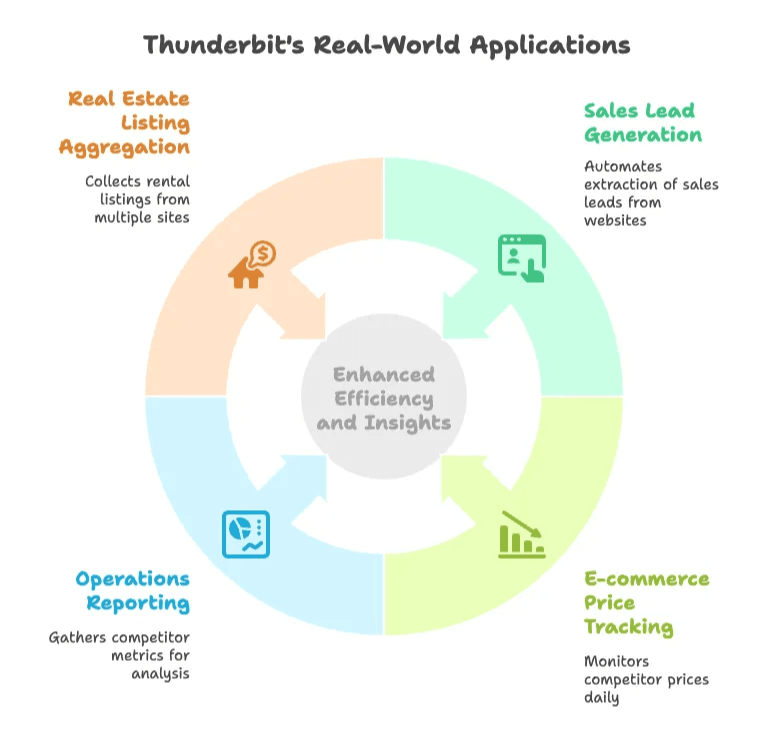

Fazit: Individuelle Extraktion ist kein Nerd-Spielplatz, sondern ein Muss für alle, die mit Webdaten schneller und klüger entscheiden wollen ().

Klassische Methoden: Technische Hürden bei individueller Extraktion

Hier wurde es früher knifflig. Klassische Methoden für individuelle Extraktion sind wie IKEA-Möbel aufbauen: Mit Erfahrung klappt’s, aber ein Fehler – und das Regal wackelt (oder die Datenpipeline bricht).

Der Einrichtungsprozess: Manuelle Schritte und Tools

So sah der klassische Ablauf aus:

- HTML inspizieren: Chrome DevTools öffnen, Rechtsklick und „Untersuchen“. Dann das richtige

<div>, die Klasse oder ID suchen, die die gewünschten Daten enthält. - Extraktionsregeln schreiben: XPath, CSS-Selektoren oder Regex-Muster erstellen, z.B.

//div[@class="product-name"]/text()für Produktnamen. - Tool oder Skript konfigurieren: Die Regeln in den Scraper einfügen – sei es eine Browser-Erweiterung oder ein Python-Skript mit BeautifulSoup oder Scrapy.

- Testen und anpassen: Scraper ausführen, Ergebnis prüfen, Selektoren anpassen, wiederholen. (Spoiler: Das kann ewig so weitergehen.)

- Paginierung und Unterseiten: Manuell Logik einbauen, um durch Seiten zu klicken oder Detailseiten zu besuchen.

Selbst „No-Code“-Tools verlangen oft Verständnis für HTML-Strukturen und Selektoren. Für Nicht-Techniker ist das eine steile Lernkurve – und endet oft in endlosen Copy-Paste-Sessions ().

Wartungsaufwand: Warum klassische Methoden oft scheitern

Das Bauen des Scrapers ist nur die halbe Miete. Ihn am Laufen zu halten, ist die eigentliche Herausforderung:

- Website-Änderungen: Seiten werden ständig neu gestaltet. Ändert sich eine Klasse oder ein Button, funktionieren die mühsam erstellten Selektoren nicht mehr ().

- Dynamische Inhalte: Immer mehr Seiten laden Inhalte per JavaScript nach. Klassische Scraper übersehen das, außer man baut komplexe Browser-Automatisierung ein.

- Fragile Extraktionsregeln: Zu spezifisch – und sie brechen schnell. Zu allgemein – und die Daten werden unbrauchbar.

- Laufende Wartung: Skripte müssen ständig geprüft, aktualisiert und debuggt werden. Für viele Teams heißt das: Spezialisten einstellen – oder wieder manuell arbeiten.

Kein Wunder, dass sich viele Business-User im Copy-Paste-Steinzeitalter gefangen fühlten ().

Der Aufstieg des KI-Web-Scraper: Neue Wege für individuelle Extraktion

Hier kommt der KI-Web-Scraper ins Spiel – ein Tool, das nicht nur stur Regeln befolgt, sondern Webseiten „versteht“ wie ein Mensch.

Statt auf fehleranfällige Selektoren zu setzen, nutzen KI-Web-Scraper Computer Vision und Natural Language Processing, um das visuelle Layout und den Kontext einer Seite zu analysieren. Sie erkennen Tabellen, Listen, Überschriften und Formulare anhand ihres Aussehens und ihrer Bedeutung – nicht nur anhand ihrer Position im HTML ().

Was bedeutet das für individuelle Extraktion?

- Minimale Einrichtung: Einfach die KI auf die Seite loslassen, sie schlägt die zu extrahierenden Felder vor. Kein Coding, kein Selektoren-Gefrickel.

- Anpassungsfähigkeit: Ändert sich das Layout, findet die KI die Daten oft trotzdem anhand des Kontexts.

- Dynamische Inhalte: KI-Scraper arbeiten mit gerenderten Seiten – JavaScript-Inhalte und Endlos-Scrollen sind kein Problem mehr.

- Für alle zugänglich: Auch ohne Technikkenntnisse können Nutzer komplexe Extraktionen durchführen, die früher einen Entwickler brauchten.

Es ist, als hätte man einen smarten Assistenten, der die Seite liest, das Wichtige erkennt und eine saubere Datentabelle liefert – ohne Regelchaos oder ständige Wartung ().

Wie Thunderbit individuelle Extraktion mit KI vereinfacht

Hier darf ich ein bisschen angeben: Thunderbit wurde von Grund auf so entwickelt, dass individuelle Extraktion für alle so einfach wie möglich ist. Als Chrome-Erweiterung bringt KI-gestützte Datenerfassung direkt in deinen Browser.

Die wichtigsten Funktionen für mühelose Web-Extraktion

Was macht Thunderbit besonders?

- KI-Feldvorschläge: Ein Klick, und Thunderbits KI scannt die Seite, schlägt passende Felder (Spalten) samt Namen und Datentypen vor. Du kannst sie übernehmen, anpassen oder eigene hinzufügen. Kein Rätselraten mehr.

- Unterseiten-Scraping: Mehr Details nötig? Thunderbit besucht automatisch verlinkte Unterseiten (z.B. Produktdetailseiten) und ergänzt die Haupttabelle mit weiteren Infos. Was früher ein technischer Kraftakt war, ist jetzt ein Klick.

- Sofortige Scraper-Vorlagen: Für bekannte Seiten wie Amazon, Zillow oder Instagram gibt es Ein-Klick-Vorlagen. Damit exportierst du Daten in Sekunden – ganz ohne KI-Credits.

- Dynamische Inhalte: Thunderbit unterstützt Cloud- und Browser-Modus. Cloud-Modus extrahiert bis zu 50 Seiten gleichzeitig (ideal für öffentliche Daten), Browser-Modus für Seiten mit Login oder komplexen Inhalten.

- Geplanter Scraper: Beschreibe deinen Zeitplan in Alltagssprache („jeden Montag um 9 Uhr“), und Thunderbit erledigt die Extraktion automatisch. Einrichten und vergessen.

- Ein-Klick-Extraktoren: E-Mails, Telefonnummern oder Bilder? Thunderbit hat spezielle Extraktoren – ein Klick, und die Daten sind da.

- Einfache Exporte: Exportiere direkt nach Excel, Google Sheets, Airtable oder Notion. Bilder werden korrekt übernommen, das Ergebnis ist ein vollständiger, nutzbarer Datensatz.

- Mehrsprachigkeit: Thunderbits Oberfläche gibt es in 34 Sprachen – ideal für internationale Teams.

- Kostenlose Testphase & Creditsystem: Thunderbit gratis testen (bis zu 6 Seiten, mit Testphase 10). Exporte sind immer kostenlos.

Mit Thunderbit brauchst du kein HTML, CSS oder XPath. Die KI übernimmt die Arbeit, du konzentrierst dich auf das Wesentliche: Die Daten, die du brauchst, genau dann, wenn du sie brauchst.

Praxisbeispiele: Thunderbit im Einsatz

- Lead-Generierung im Vertrieb: Statt stundenlanges Copy-Paste aus einem Verzeichnis öffnet ein Vertriebsmitarbeiter die Seite, klickt auf „KI-Feldvorschläge“ und Thunderbit extrahiert Namen, Firmen, Positionen und E-Mails – seitenübergreifend. Unterseiten-Scraping holt zusätzliche Details aus Profilen. Was früher Tage dauerte, geht jetzt in Minuten ().

- Preisüberwachung im E-Commerce: Ein E-Commerce-Manager richtet Thunderbit so ein, dass Wettbewerberpreise täglich überwacht werden. Die KI schlägt relevante Felder vor, der geplante Scraper läuft jeden Morgen und exportiert frische Daten nach Google Sheets. Ändert sich das Layout, reicht ein Klick auf „KI-Feldvorschläge“ – ganz ohne IT-Support.

- Operations-Reporting: Ein Analyst braucht wöchentlich Wettbewerberdaten von mehreren Seiten. Thunderbit extrahiert News, Stellenanzeigen und Social-Media-Statistiken mit KI-Prompts für jedes Feld (z.B. Sentiment-Analyse). Die Daten landen direkt im Dashboard, bereit zur Auswertung.

- Immobilien-Listing-Aggregation: Ein Makler bündelt Mietangebote von mehreren Portalen, inklusive Adressen, Preisen und Vermieterkontakten. Thunderbits Unterseiten- und Kontakt-Extraktoren holen alle Infos, auch hinter „Kontakt anzeigen“-Buttons. Das Ergebnis: Ein vollständiger, aktueller Marktüberblick.

In allen Fällen verwandelt Thunderbit einen technischen, zeitaufwendigen Prozess in einen schnellen, wiederholbaren Workflow – und macht Nicht-Technikern die Datenerfassung leicht.

Klassisch vs. KI-gestützte individuelle Extraktion im Vergleich

Hier der direkte Vergleich:

| Aspekt | Klassische individuelle Extraktion | KI-gestützte Extraktion (Thunderbit) |

|---|---|---|

| Einrichtung & Know-how | Programmierkenntnisse nötig; manuelle Selektoren; steile Lernkurve | Kein Coding; KI erkennt Felder automatisch; Point-and-Click oder Alltagssprache |

| Anpassung an Änderungen | Anfällig – bricht bei kleinen Layout-Änderungen; häufige Updates nötig | Robust – KI nutzt Kontext & visuelle Hinweise; viele Änderungen werden automatisch erkannt |

| Dynamische Inhalte | Zusätzliche Tools/Skripte für JS-Seiten nötig; komplexe Einrichtung | Unterstützung für dynamische Seiten, Endlos-Scroll & „Mehr laden“-Inhalte integriert |

| Flexibilität bei Datenfeldern | Neue Felder = neue Selektoren/Code; wenig spontane Anpassung | Felder einfach hinzufügen; KI-Prompts erlauben Formatierung, Kategorisierung, Übersetzung |

| Nutzerfreundlichkeit | Vor allem für Entwickler; Nicht-Techniker stoßen an Grenzen | Für alle konzipiert; Business-User können selbstständig Daten extrahieren |

| Skalierbarkeit & Geschwindigkeit | Skalierbar mit Aufwand; Proxies, Parallelisierung etc. nötig | Cloud-Scraping skaliert automatisch; bis zu 50 Seiten gleichzeitig; Skalierung über Plan/Credits |

| Wartungsaufwand | Hoch – ständiges Prüfen, Aktualisieren, Debuggen | Gering – KI reduziert Fehler; Anbieter aktualisieren Algorithmen; kaum Nutzeraufwand |

| Genauigkeit & Datenqualität | Genau, wenn richtig eingerichtet; fehleranfällig bei Musteränderungen; Nachbearbeitung nötig | KI liefert kontextbezogene, saubere Daten; Bereinigung & Formatierung direkt im Tool möglich |

Das Fazit: KI-gestützte individuelle Extraktion punktet bei Einrichtung, Wartung, Skalierung und Nutzerfreundlichkeit. Für die meisten Unternehmen ist das die logische Wahl.

Herausforderungen bei dynamischen und komplexen Websites meistern

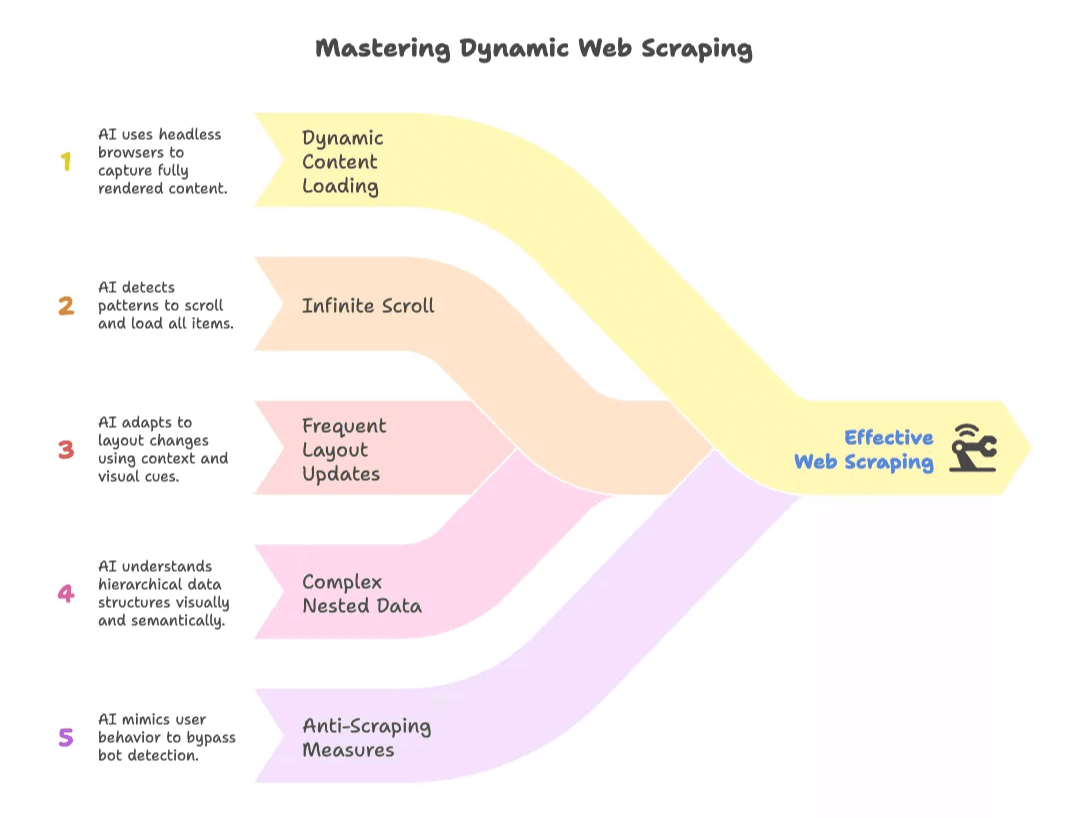

Dynamische Websites – mit Endlos-Scroll, JavaScript-Inhalten oder häufigen Layout-Änderungen – waren früher der Albtraum jedes Scrapers. Klassische Tools scheiterten oft oder verpassten Daten.

KI-Web-Scraper drehen den Spieß um:

- Dynamisches Nachladen: KI-Tools nutzen Headless-Browser oder Browser-Erweiterungen, sehen die vollständig gerenderte Seite und erfassen alle sichtbaren Daten ().

- Endlos-Scroll: KI erkennt wiederkehrende Muster und scrollt automatisch, bis alle Einträge geladen sind.

- Häufige Layout-Updates: Da KI auf Kontext und Optik setzt, brechen Extraktionen seltener bei HTML-Änderungen.

- Komplexe, verschachtelte Daten: Tabellen in Akkordeons, optionale Felder, unregelmäßige Layouts – KI versteht die Hierarchie visuell und semantisch.

- Anti-Scraping-Maßnahmen: Durch Nachahmen echten Nutzerverhaltens können KI-Scraper einfache Bot-Erkennung umgehen und auch mit CAPTCHAs oder Logins umgehen.

Für Unternehmen heißt das: Zuverlässige, robuste Datenerfassung – selbst bei Seiten, die früher als „zu schwierig“ galten oder sich ständig ändern ().

Best Practices für individuelle Extraktion – auch ohne Technik-Know-how

Auch mit KI lohnt sich ein wenig Sorgfalt:

- Datenbedarf planen: Überlege, was du brauchst, von wo und wie oft. Gute Planung spart viel Nacharbeit.

- KI-Vorschläge prüfen: Die vorgeschlagenen Felder und Beispieldaten immer kontrollieren. Vertrauen ist gut, Kontrolle besser.

- Vorlagen nutzen: Für bekannte Seiten sparen Vorlagen Zeit und Credits.

- KI mit Fachwissen kombinieren: Nutze Feld-Prompts für Formatierung, Kategorisierung oder Übersetzung direkt beim Extrahieren.

- Mit kleinen Tests starten: Erst mit wenigen Seiten testen, Ergebnisse prüfen, dann skalieren.

- Automatisieren & überwachen: Wiederkehrende Aufgaben automatisieren, aber regelmäßig Stichproben machen.

- Daten & Credits managen: Scrape so oft wie nötig und exportiere Ergebnisse zeitnah.

- Recht & Ethik beachten: Nur öffentliche Daten scrapen, AGBs respektieren, keine sensiblen Daten sammeln.

- Das richtige Tool wählen: Manchmal reicht ein Export oder eine API – KI-Scraper sind für unstrukturierte oder komplexe Webdaten ideal.

- Sicherheit beachten: Zugangsdaten schützen, besonders bei Login-basierten Scrapes.

Das Ziel: KI nutzen, aber Qualität und Compliance im Blick behalten.

Die Zukunft der individuellen Extraktion: Was kommt als Nächstes?

Der Blick nach vorn: Individuelle Extraktion wird noch intelligenter und nahtloser:

- Mehr KI-Integration: Scraper lernen aus jedem Lauf, passen sich proaktiv an und steuern komplexe Abläufe mit Multi-Agenten-Systemen.

- Echtzeit-Daten: Kontinuierliche oder gestreamte Extraktion – Live-Dashboards mit Webdaten werden Standard.

- Über Websites hinaus: Extraktion aus PDFs, Bildern, Apps, Multimedia – überall, wo Daten sind.

- No-Code wird Standard: Sprach- oder sogar AR-gesteuerte Extraktion ist in Sichtweite.

- Compliance eingebaut: Tools helfen automatisch, rechtliche und ethische Vorgaben einzuhalten.

- Integrierte Workflows: Extrahierte Daten fließen direkt in Analysen, KI-Modelle oder Business-Apps für sofortige Insights.

Kurz: Individuelle Extraktion wird zum Hintergrunddienst – immer verfügbar, immer aktuell, für jeden nutzbar ().

Fazit: Mehr Geschäftswert durch smarte individuelle Extraktion

Wir sind weit entfernt von den Tagen, in denen Copy-Paste und fehleranfällige Skripte den Alltag bestimmten. Individuelle Extraktion ist heute ein KI-gestütztes, benutzerfreundliches Power-Tool. Lösungen wie bringen Webdaten in Reichweite aller – ohne Code, ohne Kopfschmerzen, mit echten Erkenntnissen.

Der geschäftliche Nutzen ist klar: Schnellere Entscheidungen, bessere Leads, klügere Preisgestaltung und effizientere Abläufe. Wer moderne Web-Extraktion nutzt, ist agiler, informierter und hat die Nase vorn in einer datengetriebenen Welt.

Falls du also noch im Copy-Paste-Steinzeitalter feststeckst: Lass die KI die Arbeit machen. Die Zukunft der individuellen Extraktion ist da – und so einfach wie der Weg von Klicks zu Spalten, ein smarter Scrape nach dem anderen.

Neugierig geworden? Lade die herunter, lies mehr Tipps im oder erfahre, wie du .

Und falls du noch zweifelst: Das Einzige, was schlimmer ist als manuelle Dateneingabe, ist zu merken, dass du alles hättest automatisieren können.

FAQs

1. Was ist individuelle Extraktion und wie unterscheidet sie sich vom Standard-Web-Scraping?

Individuelle Extraktion bedeutet, gezielt benutzerdefinierte Daten von einer Webseite zu extrahieren – etwa das Material eines Produkts oder ein verstecktes Label – statt nur Standardfelder wie Titel oder Preise. Sie bietet maximale Flexibilität, da Nutzer die Extraktion exakt auf ihre Anforderungen zuschneiden können, während Standard-Tools nur vordefinierte Ergebnisse liefern.

2. Warum ist individuelle Datenerfassung für moderne Unternehmen wichtig?

Individuelle Extraktion ermöglicht es Unternehmen, präzise und relevante Daten zu sammeln, die bessere Entscheidungen ermöglichen. Ob gezielte Lead-Generierung, Wettbewerber-Preisüberwachung oder automatisierte Marktforschung – maßgeschneiderte Daten sorgen für mehr ROI, schnellere Abläufe und einen Vorsprung im Wettbewerb.

3. Welche Herausforderungen bringen klassische Methoden der Datenextraktion mit sich?

Klassische Methoden erfordern oft Programmierkenntnisse, manuelle Einrichtung von Selektoren und ständige Wartung bei Website-Änderungen. Sie tun sich schwer mit dynamischen Inhalten, sind fehleranfällig und benötigen meist Entwickler-Support – was sie für Nicht-Techniker unattraktiv macht.

4. Wie vereinfachen KI-Tools wie Thunderbit die individuelle Extraktion?

KI-Web-Scraper wie Thunderbit nehmen die technische Komplexität ab, indem sie Computer Vision und NLP nutzen, um Seiteninhalte zu verstehen. Nutzer können Daten mit einem Klick extrahieren – auch von dynamischen oder komplexen Seiten. Funktionen wie Feldvorschläge, Unterseiten-Scraping, geplante Läufe und Vorlagen machen den Prozess schnell, skalierbar und für alle zugänglich.

5. Was sind Best Practices für Teams, die KI-gestützte Datenextraktion nutzen?

Für optimale Ergebnisse sollten Teams klare Datenziele definieren, KI-Vorschläge prüfen, mit Testläufen starten und wiederkehrende Aufgaben automatisieren. Vorlagen nutzen, Scraping-Frequenz steuern und auf ethische Aspekte achten sind ebenso wichtig. Regelmäßige Stichproben sichern die Datenqualität, während die KI die Hauptarbeit übernimmt.

Mehr erfahren: