„Man kann Daten ohne Informationen haben, aber keine Informationen ohne Daten.“ —

Im Netz tummeln sich mittlerweile über Websites – und täglich kommen rund 2 Millionen neue Inhalte dazu. In diesem riesigen Datenmeer schlummern wertvolle Erkenntnisse, die dir bei wichtigen Entscheidungen helfen können. Allerdings sind etwa dieser Daten unstrukturiert und müssen erst einmal in eine brauchbare Form gebracht werden. Genau hier kommen Web-Scraping-Tools ins Spiel – sie sind unverzichtbar, wenn du das volle Potenzial von Online-Daten ausschöpfen willst.

Falls du beim Thema Web Scraping noch am Anfang stehst, wirken Begriffe wie oder vielleicht erstmal abschreckend. Aber dank KI sind diese Hürden heute viel leichter zu nehmen. Moderne KI-Web-Scraper machen den Einstieg auch ohne Technik-Know-how möglich. Damit kannst du Daten blitzschnell erfassen und weiterverarbeiten – ganz ohne Programmierkenntnisse.

Die besten Web-Scraping-Tools & Software

- : Intuitiver KI-Web-Scraper mit erstklassigen Ergebnissen

- : Für Live-Überwachung und Massendaten-Extraktion

- : No-Code-Automatisierung mit vielen App-Anbindungen

- : Für erfahrene Nutzer, die visuelles Scraping bevorzugen

- : Starkes No-Code-Scraping, das IP-Sperren und Bot-Erkennung umgeht

- : Für fortschrittliche, KI-basierte Datenextraktion per API und Knowledge Graphs

Teste KI-gestütztes Web Scraping

Probier’s aus! Du kannst klicken, dich durchklicken und den Workflow direkt im Video testen.

Wie funktioniert Web Scraping?

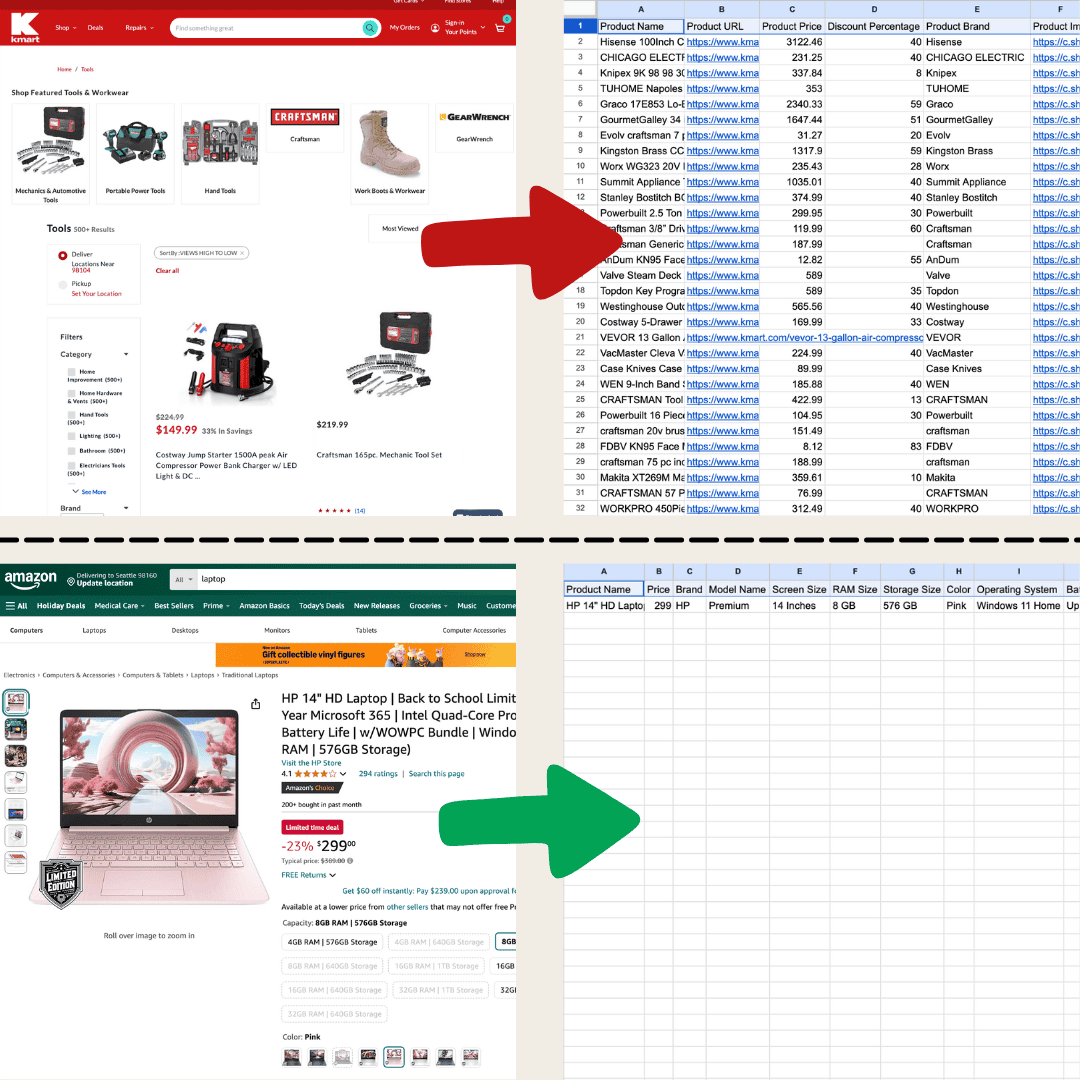

Beim Web Scraping werden Daten automatisiert von Webseiten eingesammelt. Du sagst dem Tool, welche Inhalte – zum Beispiel Texte oder Bilder – es herausziehen und in eine Tabelle packen soll. Das ist super praktisch für Preisvergleiche, Marktforschung oder um Daten direkt in Excel oder Google Sheets zu übernehmen.

Dieses Beispiel wurde mit Thunderbit und dem KI-Web-Scraper erstellt.

Dieses Beispiel wurde mit Thunderbit und dem KI-Web-Scraper erstellt.

Es gibt verschiedene Wege. Am simpelsten wäre das manuelle Kopieren und Einfügen – aber bei größeren Datenmengen ist das einfach nicht machbar. Deshalb setzen die meisten auf eine dieser drei Methoden: klassische Web-Scraper, KI-Web-Scraper oder eigene Programmierung.

Klassische Web-Scraper arbeiten mit festen Regeln, die auf der Struktur der Seite basieren. Du legst zum Beispiel fest, dass Produktnamen oder Preise aus bestimmten HTML-Tags gezogen werden. Das klappt gut bei Seiten, die sich selten ändern – aber schon kleine Layout-Änderungen machen oft Nacharbeit nötig.

Mit klassischen Scraper-Tools ist die Einrichtung oft aufwendig und erfordert viele Klicks sowie Einarbeitung.

Mit klassischen Scraper-Tools ist die Einrichtung oft aufwendig und erfordert viele Klicks sowie Einarbeitung.

KI-Web-Scraper funktionieren so: ChatGPT liest die komplette Website und zieht dann gezielt die gewünschten Inhalte heraus. Sie können Daten extrahieren, übersetzen und zusammenfassen – alles in einem Rutsch. Dank natürlicher Sprachverarbeitung erkennen sie die Seitenstruktur und passen sich auch bei Änderungen flexibel an. Wenn sich also das Layout der Website ändert, kann ein KI-Web-Scraper meist automatisch reagieren, ohne dass du etwas neu einstellen musst. Das macht sie ideal für komplexe oder oft aktualisierte Seiten.

Mit dem KI-Web-Scraper bekommst du mit wenigen Klicks strukturierte Daten – der Einstieg ist super einfach!

Mit dem KI-Web-Scraper bekommst du mit wenigen Klicks strukturierte Daten – der Einstieg ist super einfach!

Welches Tool passt zu dir? Das hängt davon ab, was du brauchst. Wer sich mit Code auskennt oder große Datenmengen von bekannten Seiten will, ist mit klassischen Scraper-Lösungen oft gut bedient. Für Einsteiger oder alle, die Wert auf Flexibilität bei Webseiten-Änderungen legen, sind KI-Web-Scraper meist die bessere Wahl. Die folgende Tabelle gibt dir einen schnellen Überblick über typische Anwendungsfälle:

| Szenario | Beste Wahl |

|---|---|

| Leichtes Scraping auf Seiten wie Verzeichnissen, Shops oder überall dort, wo Listen angezeigt werden | KI-Web-Scraper |

| Die Seite enthält weniger als 200 Datenzeilen, das Einrichten eines klassischen Scrapers dauert zu lange | KI-Web-Scraper |

| Die zu extrahierenden Daten müssen in ein bestimmtes Format gebracht werden, z.B. Kontaktdaten für den Upload zu HubSpot | KI-Web-Scraper |

| Großflächiges Scraping auf bekannten Seiten, z.B. zehntausende Amazon-Produkte oder Immobilien auf Zillow | Klassischer Web-Scraper |

Die besten Web-Scraping-Tools & Software im Überblick

| Tool | Preis | Hauptfunktionen | Vorteile | Nachteile |

|---|---|---|---|---|

| Thunderbit | Ab 9 $/Monat, kostenlose Stufe verfügbar | KI-Web-Scraper, automatische Datenerkennung und -formatierung, verschiedene Exportformate, Ein-Klick-Export, benutzerfreundlich. | Kein Code nötig, KI-Unterstützung, Integration mit Google Sheets & Co. | Bei großen Datenmengen langsamer, erweiterte Funktionen kostenpflichtig |

| Browse AI | Ab 48,75 $/Monat, kostenlose Stufe verfügbar | No-Code-Oberfläche, Echtzeit-Überwachung, Massendaten-Extraktion, Workflow-Integration. | Einfache Bedienung, Anbindung an Google Sheets & Zapier | Komplexe Seiten erfordern mehr Einrichtung, Bulk-Scraping kann zu Timeouts führen |

| Bardeen AI | Ab 60 $/Monat, kostenlose Stufe verfügbar | No-Code-Automatisierung, Integration mit 130+ Apps, MagicBox wandelt Aufgaben in Workflows um. | Viele Integrationen, skalierbar für Unternehmen | Einarbeitung für Neueinsteiger, Einrichtung kann Zeit kosten |

| Web Scraper | Lokal kostenlos, 50 $/Monat für Cloud | Visuelle Task-Erstellung, unterstützt dynamische Seiten (AJAX/JavaScript), Cloud-Scraping. | Gut für dynamische Seiten | Technisches Know-how für optimale Nutzung nötig |

| Octoparse | Ab 119 $/Monat, kostenlose Stufe verfügbar | No-Code-Scraping, automatische Seitenerkennung, Cloud-Scraping mit Zeitplanung, Vorlagenbibliothek. | Leistungsstark für dynamische Seiten, umgeht Restriktionen | Komplexe Seiten erfordern Einarbeitung |

| Diffbot | Ab 299 $/Monat | Datenextraktions-API, No-Rule-API, NLP für unstrukturierte Texte, umfangreicher Knowledge Graph. | Starke KI-Extraktion, viele API-Integrationen, großflächiges Scraping | Einarbeitung für Nicht-Techniker, Einrichtung dauert |

Der beste Web-Scraper im KI-Zeitalter

Thunderbit ist ein leistungsstarkes, einfach zu bedienendes KI-Tool für Web-Automatisierung, mit dem auch Leute ohne Programmierkenntnisse Daten ganz easy extrahieren und organisieren können. Über die macht der von Thunderbit das Sammeln von Webdaten zum Kinderspiel – du musst keine einzelnen Scraper für verschiedene Layouts mehr bauen oder dich mit Seitenelementen rumschlagen.

Hauptfunktionen

- KI-gestützte Flexibilität: Der KI-Web-Scraper von Thunderbit erkennt und formatiert Webdaten automatisch – ganz ohne CSS-Selektoren.

- Extrem einfache Bedienung: Einfach auf „KI-Spalte vorschlagen“ klicken und dann auf der gewünschten Seite „Scrapen“ auswählen – fertig.

- Verschiedene Datenformate: Thunderbit kann URLs, Bilder und weitere Formate extrahieren und übersichtlich darstellen.

- Automatische Datenverarbeitung: Die KI kann Daten direkt zusammenfassen, kategorisieren oder übersetzen und ins gewünschte Format bringen.

- Einfache Datenexporte: Mit nur einem Klick lassen sich Daten nach Google Sheets, Airtable oder Notion exportieren.

- Intuitive Benutzeroberfläche: Die Bedienung ist für alle Erfahrungsstufen geeignet.

Preise

Thunderbit bietet flexible Tarife ab 9 $ pro Monat für 5.000 Credits. Im Jahresabo bekommst du alle Credits direkt am Anfang. Die Preise reichen bis 199 $ für 240.000 Credits.

Vorteile:

- Starke KI-Unterstützung macht Datenerfassung und -verarbeitung super einfach.

- Kein Programmieren nötig, für alle geeignet.

- Perfekt für leichtes Scraping, z.B. Verzeichnisse oder Onlineshops.

- Direkte Integration in beliebte Apps für den Datenexport.

Nachteile:

- Großflächiges Scraping kann etwas mehr Zeit brauchen.

- Einige erweiterte Funktionen sind kostenpflichtig.

Du willst mehr wissen? Installiere oder schau dir auf an, wie einfach Web Scraping mit Thunderbit funktioniert.

Bester Web-Scraper für Datenüberwachung und Massendaten-Extraktion

Browse AI

Browse AI ist ein vielseitiges No-Code-Tool, mit dem du Daten extrahieren und überwachen kannst, ohne eine Zeile Code zu schreiben. Browse AI bringt ein paar KI-Funktionen mit, ist aber kein vollwertiger KI-Scraper. Trotzdem macht es den Einstieg sehr einfach.

Hauptfunktionen

- No-Code-Oberfläche: Eigene Workflows lassen sich per Mausklick zusammenstellen.

- Echtzeit-Überwachung: Bots überwachen Webseiten und liefern aktuelle Infos.

- Massendaten-Extraktion: Bis zu 50.000 Datensätze können auf einmal verarbeitet werden.

- Workflow-Integration: Mehrere Bots lassen sich für komplexe Aufgaben kombinieren.

Preise

Ab 48,75 $ pro Monat mit 2.000 Credits. Die kostenlose Stufe bietet 50 Credits pro Monat zum Ausprobieren der Grundfunktionen.

Vorteile:

- Integration mit Google Sheets und Zapier.

- Vorgefertigte Bots erleichtern Standardaufgaben.

Nachteile:

- Für komplexe Seiten ist zusätzliche Konfiguration nötig.

- Die Geschwindigkeit beim Massenscraping kann schwanken, manchmal gibt’s Timeouts.

Bester Web-Scraper für Workflow-Integration

Bardeen AI

Bardeen AI ist ein No-Code-Automatisierungstool, das verschiedene Apps miteinander verbindet und so Arbeitsabläufe vereinfacht. Es nutzt KI, um individuelle Automatisierungen zu erstellen, ist aber kein vollwertiger KI-Scraper.

Hauptfunktionen

- No-Code-Automatisierung: Workflows lassen sich einfach per Klick zusammenstellen.

- MagicBox: Aufgaben werden in Alltagssprache beschrieben und von Bardeen AI in Workflows umgewandelt.

- Breite Integrationsmöglichkeiten: Über 130 Apps wie Google Sheets, Slack oder LinkedIn werden unterstützt.

Preise

Ab 60 $ pro Monat mit 1.500 Credits (ca. 1.500 Datenzeilen). Die kostenlose Stufe bietet 100 Credits pro Monat für Basisfunktionen.

Vorteile:

- Viele Integrationen für unterschiedlichste Geschäftsanforderungen.

- Flexibel und skalierbar für Unternehmen jeder Größe.

Nachteile:

- Neue Nutzer brauchen etwas Zeit, um sich einzuarbeiten.

- Die Ersteinrichtung kann aufwendig sein.

Bester visueller Web-Scraper für erfahrene Nutzer

Web Scraper

Richtig gelesen: Das Tool heißt tatsächlich „Web Scraper“. Es ist eine beliebte Browser-Erweiterung für Chrome und Firefox, mit der du Daten visuell und ohne Programmierung extrahieren kannst. Allerdings solltest du etwas Zeit für die Tutorials einplanen, um das volle Potenzial auszuschöpfen. Wer es besonders einfach haben will, greift besser zum KI-Web-Scraper.

Hauptfunktionen

- Visuelle Erstellung: Scraping-Aufgaben werden durch Klicken auf Seitenelemente eingerichtet.

- Unterstützung dynamischer Seiten: Kann mit AJAX und JavaScript umgehen.

- Cloud-Scraping: Aufgaben können über die Cloud geplant und regelmäßig ausgeführt werden.

Preise

Lokal kostenlos; Cloud-Funktionen ab 50 $/Monat.

Vorteile:

- Sehr gut für dynamische Seiten geeignet.

- Für lokale Nutzung kostenlos.

Nachteile:

- Für optimale Ergebnisse sind technische Kenntnisse erforderlich.

- Änderungen erfordern oft aufwendige Tests.

Bester Web-Scraper zum Umgehen von IP-Blockaden und Bot-Erkennung

Octoparse

Octoparse ist eine vielseitige Software für technisch versierte Nutzer, die gezielt und ohne Programmierung große Datenmengen sammeln und überwachen möchten. Octoparse läuft nicht im Browser des Nutzers, sondern nutzt Cloud-Server – so können IP-Blockaden und Bot-Erkennung effektiv umgangen werden.

Hauptfunktionen

- No-Code-Bedienung: Scraping-Aufgaben lassen sich ohne Programmierkenntnisse erstellen.

- Intelligente Auto-Erkennung: Die Software erkennt relevante Seitenelemente automatisch und vereinfacht so die Einrichtung.

- Cloud-Scraping: Rund-um-die-Uhr-Datensammlung mit geplanten Aufgaben.

- Umfangreiche Vorlagenbibliothek: Hunderte Vorlagen für gängige Websites ermöglichen schnellen Einstieg ohne komplexe Einrichtung.

Preise

Ab 119 $ pro Monat mit 100 Aufgaben. Die kostenlose Stufe bietet 10 Aufgaben pro Monat zum Testen der Grundfunktionen.

Vorteile:

- Leistungsstark für dynamische Seiten und flexibel anpassbar.

- Bietet Lösungen für Scraping-Restriktionen und dynamische Inhalte.

Nachteile:

- Komplexe Seitenstrukturen erfordern mehr Zeit bei der Einrichtung.

- Neue Nutzer müssen sich in die Bedienung einarbeiten.

Bester Web-Scraper für fortschrittliche, KI-basierte Datenextraktion per API

Diffbot

Diffbot ist ein fortschrittliches Tool zur Webdaten-Extraktion, das mithilfe von KI unstrukturierte Webinhalte in strukturierte Daten verwandelt. Mit leistungsstarken APIs und einem umfangreichen Knowledge Graph unterstützt Diffbot Unternehmen dabei, Informationen aus dem Web zu extrahieren, zu analysieren und zu verwalten – branchenübergreifend und vielseitig einsetzbar.

Hauptfunktionen

- Datenextraktions-API: Mit der No-Rule-API reicht eine URL, um Daten automatisch zu extrahieren – individuelle Regeln sind nicht nötig.

- NLP-API: Erkennt Entitäten, Beziehungen und Stimmungen in unstrukturierten Texten und hilft beim Aufbau eigener Knowledge Graphs.

- Knowledge Graph: Einer der größten Knowledge Graphs mit umfangreichen Informationen zu Personen und Unternehmen.

Preise

Ab 299 $ pro Monat mit 250.000 Credits (entspricht ca. 250.000 API-basierten Webseiten-Extraktionen).

Vorteile:

- Sehr flexible, regelbasierte Datenextraktion mit hoher Anpassungsfähigkeit.

- Umfangreiche API-Integrationen für die Einbindung in bestehende Systeme.

- Unterstützt großflächiges Scraping – ideal für Unternehmen.

Nachteile:

- Die Ersteinrichtung erfordert Einarbeitung, besonders für Nicht-Techniker.

- Für die Nutzung ist ein eigenes Programm zur API-Anbindung nötig.

Wofür lassen sich Scraper einsetzen?

Wenn du neu im Web Scraping bist, hier ein paar beliebte Anwendungsbeispiele: Viele nutzen Scraper, um Amazon-Produktlisten zu erfassen, Immobiliendaten von Zillow zu sammeln oder Unternehmensdaten aus Google Maps zu extrahieren. Das ist aber nur der Anfang – mit dem kannst du Daten von fast jeder Website sammeln und so viele Aufgaben automatisieren und Zeit sparen. Egal ob für Recherchen, Preisbeobachtung oder den Aufbau von Datenbanken – Web Scraping eröffnet dir unzählige Möglichkeiten, das Internet für dich zu nutzen.

Häufige Fragen (FAQ)

-

Ist Web Scraping legal?

Web Scraping ist in der Regel legal, solange du die Nutzungsbedingungen der jeweiligen Website beachtest und die Art der Daten berücksichtigst. Schau dir immer die Richtlinien an und halte dich an geltende Gesetze.

-

Brauche ich Programmierkenntnisse für Web-Scraping-Tools?

Die meisten hier vorgestellten Tools funktionieren ohne Programmierkenntnisse. Bei Tools wie Octoparse oder Web Scraper ist technisches Grundverständnis aber hilfreich, um alles rauszuholen.

-

Gibt es kostenlose Web-Scraping-Tools?

Ja, es gibt kostenlose Tools wie BeautifulSoup, Scrapy oder Web Scraper. Viele Anbieter haben außerdem kostenlose Basisversionen mit eingeschränkten Funktionen.

-

Welche Herausforderungen gibt es beim Web Scraping?

Typische Herausforderungen sind der Umgang mit dynamischen Inhalten, CAPTCHAs, IP-Blockaden und komplexen HTML-Strukturen. Moderne Tools und Techniken helfen dir, diese Hürden zu meistern.

Mehr erfahren:

-

Mit KI mühelos arbeiten.