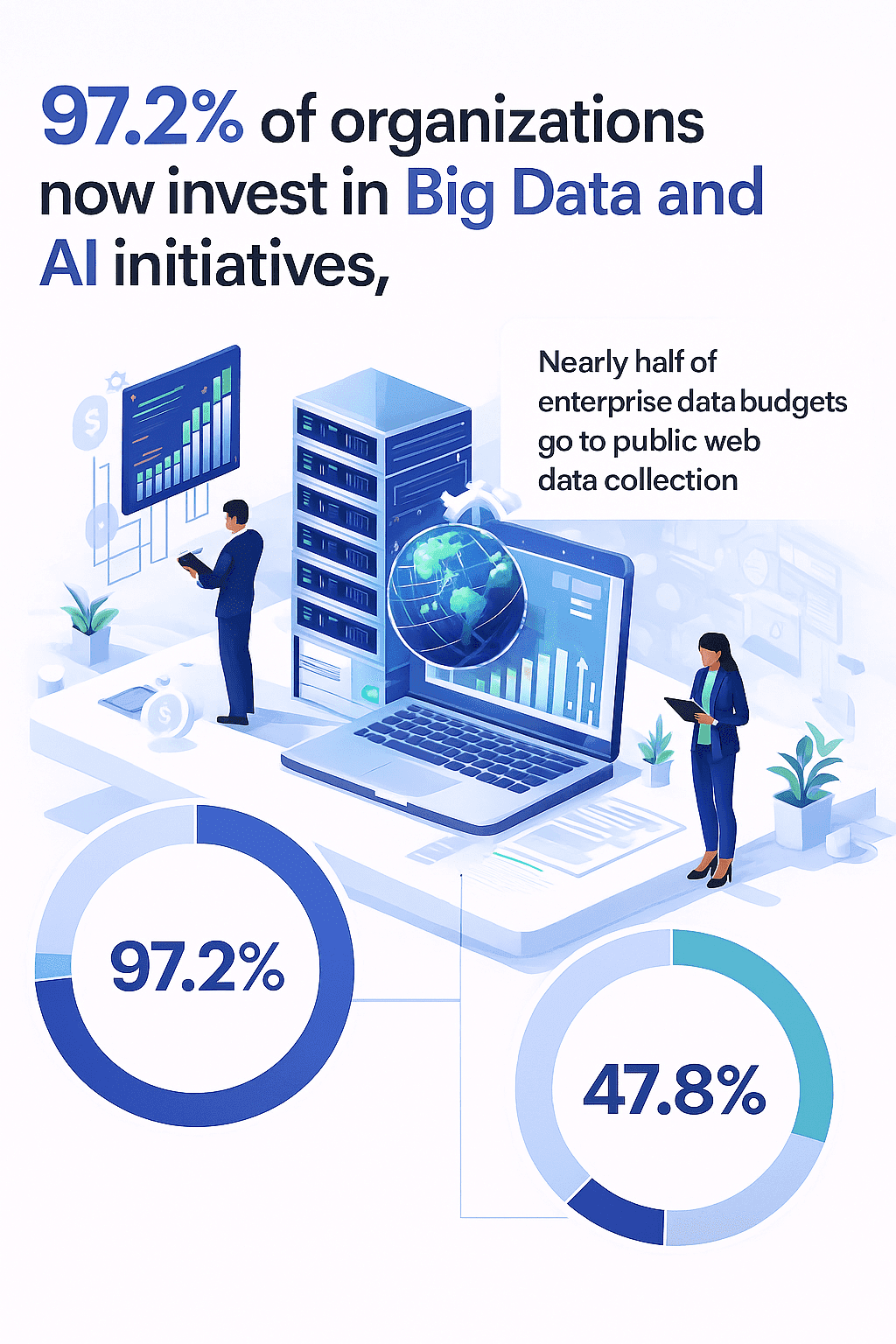

Das Internet ist heutzutage wie ein riesiger Goldschatz voller wertvoller Daten – vorausgesetzt, du weißt, wie du sie für dich nutzen kannst. Egal ob im Vertrieb, E-Commerce oder in der Organisation: Immer mehr Unternehmen stehen unter Zugzwang, öffentlich verfügbare Webdaten in echte Insights zu verwandeln. Ich habe das selbst erlebt – nach Jahren in der Automatisierung und SaaS habe ich gesehen, wie Firmen blitzschnell vom Bauchgefühl auf datenbasierte Entscheidungen umschalten. Mittlerweile investieren ), und fast . Das Problem: Die meisten dieser Daten stecken irgendwo in unübersichtlichem HTML, auf dynamischen Seiten oder hinter endlosem Scrollen fest.

Was heißt es also 2025 wirklich, eine Website „auszulesen“? Spoiler: Es geht nicht um Hacking oder irgendwas Illegales. Vielmehr nutzt du clevere, legale Tools, um strukturierte Daten – wie Tabellen, Produktinfos oder Kontaktlisten – von öffentlichen Webseiten zu holen. So sparst du dir das lästige Copy-Paste und kannst direkt mit den Daten weiterarbeiten. Lass uns gemeinsam anschauen, wie das Schritt für Schritt funktioniert – und warum KI-gestützte Tools wie das Extrahieren von Webdaten so einfach und sicher machen wie nie zuvor.

Was bedeutet „eine Website rippen“ im Kontext von Webdaten-Extraktion?

Viele denken bei „Website rippen“ erstmal ans komplette Herunterladen einer Seite für die Offline-Nutzung – oder sogar an etwas Verbotenes. Im Business-Alltag meint „rippen“ aber das gezielte Extrahieren strukturierter Infos – zum Beispiel Produktlisten, Preise, E-Mail-Adressen oder Bewertungen – von öffentlich zugänglichen Seiten, nicht das bloße Speichern von HTML-Dateien.

Genau das ist Web-Scraping: Mit Software werden gezielt bestimmte Daten von einer Website erkannt und in ein nutzbares Format wie eine Tabelle oder Datenbank gebracht (). Wer schon mal eine Tabelle von einer Webseite nach Excel kopiert hat, hat im Prinzip eine Mini-Version davon gemacht – nur eben sehr langsam.

Wichtig: Eine Website für Daten zu rippen ist kein Hacking. Es geht um den automatisierten Zugriff auf öffentlich verfügbare Infos. Gerichte haben sogar bestätigt, dass das Scrapen öffentlicher Daten in vielen Fällen legal ist (siehe das LinkedIn vs. hiQ-Urteil) (). Entscheidend ist das Wie:

- Beachte die Nutzungsbedingungen der Website – manche Seiten verbieten Scraping ausdrücklich.

- Beschränke dich auf öffentliche, nicht sensible Daten – keine persönlichen Daten oder urheberrechtlich geschützten Inhalte scrapen.

- Belaste den Server nicht unnötig – also in moderatem Tempo scrapen.

- Nutze offizielle APIs, wenn vorhanden – sie sind für den Datenzugriff gedacht.

Kurz gesagt: Webseiten rippen heißt, unstrukturierte Webinhalte in strukturierte, nutzbare Infos zu verwandeln – und das legal und respektvoll.

Warum es für Unternehmen wichtig ist, Webseiten auslesen zu können

Kommen wir zur Praxis: Warum wollen so viele Teams Webdaten extrahieren? Weil Webdaten der neue Treibstoff für Unternehmen sind. So werden sie genutzt:

- Lead-Generierung: Vertriebsteams sammeln Kontaktinfos, Firmenlisten oder Social-Media-Profile aus Verzeichnissen, um potenzielle Kunden zu finden. Automatisiertes Scraping kann .

- Wettbewerbsbeobachtung & Preisüberwachung: E-Commerce- und Einzelhandelsteams scrapen Preise und Lagerbestände der Konkurrenz, um dynamische Preisstrategien umzusetzen. Target steigerte so den Umsatz um ).

- Marktforschung & Trendanalyse: Marketing-Teams sammeln Bewertungen, Forenbeiträge und News, um Trends zu erkennen oder Stimmungen einzuschätzen. .

- Content-Aggregation: Medien- und Forschungsteams bündeln Angebote, Jobanzeigen oder Reise-Deals aus verschiedenen Quellen zu Berichten oder Plattformen.

- Effizienzsteigerung: Statt dass Praktikanten stundenlang Daten kopieren, reduziert Automatisierung den Verwaltungsaufwand um .

Hier eine Übersicht zum ROI:

| Anwendungsfall | Vorteil der Webdaten-Extraktion | Datenbasierter ROI |

|---|---|---|

| Lead-Generierung | Schnelles Sammeln von Kontakten für Akquise-Listen | +47 % qualifizierte Leads durch KI-gestützte Akquise |

| Preisüberwachung | Echtzeit-Überblick über Preise und Lagerbestände | +15 % Umsatz durch datenbasierte Preisoptimierung |

| Marktforschung | Bewertungen und News für Trends/Stimmungsbilder | 69 % der Firmen berichten von besserer Strategie durch Analytics |

| Content-Aggregation | Zusammenführen von Angeboten, Jobs oder Deals | Schnellere, umfassendere Marktabdeckung |

| Manuelle Arbeit ersetzen | Automatisierung wiederkehrender Datensammlung | >50 % weniger Verwaltungsaufwand, weniger Fehler |

Fazit: Automatisierte Webdaten-Extraktion verwandelt tagelange Fleißarbeit in Minuten – mit aktuellen, hochwertigen Daten ().

Vergleich: Klassische vs. KI-gestützte Website-Ripping-Tools

Bevor wir ins „Wie“ einsteigen, ein Überblick zu den Möglichkeiten. Nicht jedes Tool zum Auslesen von Webseiten ist gleich. Hier die wichtigsten Ansätze im Vergleich:

| Kriterium | Klassische Tools (HTTrack, Wget, Manuell) | Codebasierte Scraper (Python, etc.) | No-Code Tools (vor KI) | KI-Web-Scraper (Thunderbit) |

|---|---|---|---|---|

| Bedienung | Einfach bei statischen Seiten, keine Struktur | Programmierkenntnisse nötig | Visuell, aber Einrichtung nötig | No-Code, Klick & los, KI übernimmt Arbeit |

| Datenstrukturierung | Keine – nur Dateien | Manuelle Feldwahl | Manuell/visuell | KI schlägt Felder vor, strukturiert automatisch |

| Dynamische Inhalte | Scheitert bei JS-lastigen Seiten | Headless-Browser, Spezialcode nötig | Mitunter schwierig | Meistern JS, Endlos-Scroll, mehrstufige Navigation |

| Wartung | Hoch – bricht bei Änderungen | Hoch – Skripte oft fehleranfällig | Mittel – Selektoren brechen | Gering – KI passt sich Layout an |

| Exportmöglichkeiten | Manuell | Manuell (CSV, JSON) | CSV, Excel | Ein Klick zu Excel, Sheets, Airtable, Notion, JSON |

| Technisches Know-how | Gering bei statisch, hoch bei Struktur | Hoch | Mittel | Nicht erforderlich |

Klassische Tools wie HTTrack oder Wget sind super, um statische Seiten offline zu speichern, liefern aber keine strukturierten Daten. Codebasierte Scraper sind mächtig, brauchen aber Programmierkenntnisse und viel Wartung. No-Code-Tools helfen, aber du musst Felder selbst definieren und bei Änderungen nachbessern.

Thunderbit macht’s anders: Die KI liest die Seite, schlägt Felder vor, verarbeitet dynamische Inhalte und exportiert die Daten mit einem Klick – ganz ohne Code, Selektoren oder Frust ().

Schritt 1: Thunderbit einrichten – so einfach geht’s

Mit startest du in wenigen Minuten. So geht’s:

- Chrome-Erweiterung installieren: Geh auf die und klick auf „Zu Chrome hinzufügen“. Thunderbit läuft auf Chrome, Edge, Brave und anderen Chromium-Browsern ().

- Konto anlegen: Öffne die Thunderbit-Seitenleiste (⚡-Icon) und registriere dich mit E-Mail oder Google-Account. Für die Gratis-Version brauchst du keine Kreditkarte.

- Sprachunterstützung: Thunderbit unterstützt 34 Sprachen – du kannst also in deiner Lieblingssprache Daten extrahieren.

- Gratis-Tarif & Credits: Thunderbit arbeitet mit einem Credit-System (1 Credit = 1 Datenzeile). Im Gratis-Tarif kannst du bis zu 6 Seiten pro Monat scrapen und Daten kostenlos exportieren ().

Die Einrichtung dauert weniger als eine Kaffeepause. Danach kannst du direkt loslegen und deine erste Website auslesen.

Schritt 2: Mit KI-Feldvorschlägen die richtigen Daten finden

Hier zeigt Thunderbit, was es draufhat. Anstatt Felder mühsam selbst zu markieren oder Code zu schreiben, übernimmt die KI das für dich:

- Zur gewünschten Seite navigieren: Öffne die Website, von der du Daten holen willst.

- Thunderbit öffnen: Klick auf das Erweiterungs-Icon, um die Seitenleiste zu öffnen.

- Neues Scraper-Template starten: Das ist quasi deine Datentabelle.

- „KI-Felder vorschlagen“ klicken: Thunderbits KI analysiert die Seite und schlägt passende Spaltennamen und Datentypen vor – wie „Produktname“, „Preis“, „E-Mail“ oder „Firmenname“.

Auf einer Produktseite schlägt Thunderbit z. B. „Produktname“, „Preis“, „Bild-URL“ und „Bewertung“ vor. In einem Verzeichnis erkennt es „Name“, „Position“, „Firma“ und „Kontaktinfo“. Du kannst Felder beliebig hinzufügen, entfernen oder umbenennen.

Du willst es noch individueller? Mit einem Feld-KI-Prompt kannst du der KI sagen, wie sie Daten klassifizieren oder formatieren soll – z. B. Preise als „hoch/mittel/niedrig“ einstufen oder Firmen nach Branche taggen.

Das Ergebnis: In Sekunden steht dein fertiges Datenschema – statt nach stundenlanger Handarbeit ().

Schritt 3: Mit einem Klick Daten extrahieren

Jetzt wird’s spannend – die eigentliche Datenerfassung:

- „Scrapen“ klicken: Thunderbit startet und holt die Daten von der aktuellen Seite (und bei Bedarf von allen Folgeseiten).

- Automatische Paginierung: Thunderbit erkennt „Weiter“-Buttons oder Endlos-Scroll und sammelt alles ein.

- Unterseiten scrapen: Du brauchst mehr Details? Thunderbit kann in jedes Element (z. B. Produkt oder Profil) klicken, weitere Infos holen und alles in deiner Tabelle zusammenführen.

- Dynamische Inhalte meistern: Thunderbit sieht die Seite wie du – inklusive JavaScript-Inhalten, Pop-ups und mehr.

- PDFs & Bilder extrahieren: Du kannst sogar PDFs oder Bilder hochladen, Thunderbit liest den Text aus und strukturiert ihn für dich ().

Du kannst den Scrape im Browser (ideal für Login-Seiten) oder in der Cloud (schneller, bis zu 50 Seiten gleichzeitig) ausführen. Die KI übernimmt Wiederholungen und passt sich Layout-Änderungen an – du musst nicht ständig nachjustieren.

Schritt 4: Export und Verwaltung deiner extrahierten Webdaten

Nach dem Scraping erscheinen deine Daten in einer übersichtlichen Tabelle. Jetzt kannst du sie vielseitig nutzen:

- Export nach Excel oder CSV: Lade die Daten als Tabelle für Analysen oder zum Teilen herunter.

- Export zu Google Sheets: Übertrage die Daten direkt in ein neues oder bestehendes Google Sheet – ideal für Dashboards oder Teamarbeit.

- Export zu Airtable oder Notion: Schicke die Daten in Airtable-Bases oder Notion-Datenbanken. Thunderbit lädt sogar Bilder mit hoch, damit du sie direkt siehst ().

- Export als JSON: Für Entwickler oder komplexe Workflows – einfach als JSON exportieren.

Thunderbit verlangt für Exporte keine Gebühren – auch nicht im Gratis-Tarif. Und wenn du deine Daten aktuell halten willst, kannst du Scrapes automatisch planen (z. B. jeden Morgen um 9 Uhr), sodass deine Tabelle oder Datenbank immer auf dem neuesten Stand ist ().

Best Practices: Notiere immer die Quell-URLs und das Extraktionsdatum. Verwende klare Spaltennamen und einheitliche Datentypen. Für laufende Projekte empfiehlt sich die regelmäßige Aktualisierung und die Nutzung von Cloud-Tabellen oder Datenbanken für die Zusammenarbeit.

Thunderbit vs. klassische Website-Ripping-Tools: Der Direktvergleich

Warum ist Thunderbit ein echter Fortschritt? Hier die wichtigsten Unterschiede:

| Funktion | HTTrack/Wget/Manuell | Codebasierter Scraper | No-Code-Tool | Thunderbit |

|---|---|---|---|---|

| Einrichtungszeit | Minuten (statisch) | Stunden/Tage | 30–60 Min. | 2–3 Minuten |

| Datenstrukturierung | Keine | Manuell | Manuell | KI-gestützt, automatisch |

| Dynamische Inhalte | Nein | Ja (mit Aufwand) | Teilweise | Ja, integriert |

| Paginierung/Unterseiten | Nein | Manuelle Schleifen | Manuelle Einrichtung | Automatisch, KI-gesteuert |

| Exportmöglichkeiten | Manuelle Dateien | CSV, JSON | CSV, Excel | Excel, Sheets, Airtable, Notion, JSON |

| Wartung | Hoch | Hoch | Mittel | Gering – KI passt sich an |

| Technisches Know-how | Gering/Hoch | Hoch | Mittel | Nicht erforderlich |

| Kostenloser Export | Ja | Ja | Teilweise | Immer |

Thunderbit richtet sich an Business-Anwender, nicht nur an Entwickler. Es ist der „Easy Button“ für Webdaten – ohne Code, ohne Vorlagen, ohne Stress.

Legal & fair: So bleibst du beim Web Scraping auf der sicheren Seite

Ein Wort zur Ethik: Web Scraping ist mächtig, aber mit großer Macht kommt auch Verantwortung. So bleibst du korrekt:

- Prüfe die Nutzungsbedingungen der Website vor dem Scraping.

- Respektiere robots.txt – kein Gesetz, aber guter Stil.

- Scrape in moderatem Tempo – Server nicht überlasten.

- Nur öffentliche, nicht sensible Daten extrahieren – keine persönlichen Daten oder Inhalte hinter Bezahlschranken.

- APIs nutzen, wenn vorhanden – sie sind für den Datenaustausch gedacht.

- Quellen angeben, wenn du Daten veröffentlichst – besonders bei Bewertungen oder Artikeln.

Thunderbit ist für verantwortungsvolle Nutzung gemacht. Es ist kein Tool, um Seiten zu überlasten oder Sicherheitsmechanismen zu umgehen. Nutze es, um öffentlich zugängliche Daten zu extrahieren – und behandle die Quelle immer mit Respekt ().

Fazit: So einfach und effektiv kann Website-Ripping sein

- Webseiten rippen heißt, strukturierte, nutzbare Infos aus öffentlichen Seiten zu extrahieren – nicht einfach nur Dateien runterzuladen.

- Unternehmen nutzen Webdaten für Leads, Preise, Marktforschung und mehr. Der ROI ist messbar: mehr Leads, bessere Preise, weniger Handarbeit.

- Klassische Tools sind umständlich – sie scheitern an dynamischen Seiten, brauchen Programmierkenntnisse und liefern keine sauberen Daten.

- Mit Thunderbit geht’s easy: Erweiterung installieren, KI schlägt Felder vor, „Scrapen“ klicken, Daten überallhin exportieren.

- Legal & fair bleiben: Regeln beachten, schonend scrapen, auf öffentliche Infos konzentrieren.

Du hast keine Lust mehr auf Copy-Paste und willst schneller, smarter entscheiden? und probiere das Auslesen deiner ersten Website aus. Du wirst überrascht sein, wie viel Zeit (und Nerven) du sparst.

Mehr Tipps zu Web Scraping, Datenautomatisierung oder Profi-Tricks? Schau im vorbei – dort findest du Anleitungen, Praxisbeispiele und Deep Dives.

Häufige Fragen (FAQ)

1. Ist das Auslesen von Webseiten für Daten legal?

Ja – solange du öffentliche, nicht sensible Daten extrahierst und die Nutzungsbedingungen der Seite beachtest. Verzichte auf das Scrapen persönlicher Daten, urheberrechtlich geschützter Inhalte oder das Überlasten von Servern. Im Zweifel: Regeln prüfen oder offizielle APIs nutzen.

2. Was ist der Unterschied zwischen Website-Ripping und Download?

Klassische „Site Ripper“ (wie HTTrack) kopieren alle Dateien für die Offline-Nutzung. Beim Data Ripping (Web Scraping) werden gezielt strukturierte Infos – wie Tabellen, Preise oder Kontakte – extrahiert, um sie in Tabellen oder Datenbanken weiterzuverarbeiten.

3. Kann Thunderbit mit dynamischen Webseiten, Endlos-Scroll oder Pop-ups umgehen?

Absolut. Thunderbits KI ist darauf ausgelegt, JavaScript-Inhalte, Endlos-Scroll, Pop-ups und sogar mehrstufige Navigation zu meistern. Die Seite wird so gesehen, wie ein Mensch sie sieht.

4. Welche Exportmöglichkeiten bietet Thunderbit?

Du kannst deine Daten nach Excel, Google Sheets, Airtable, Notion, CSV oder JSON exportieren. Exporte sind immer kostenlos – auch im Gratis-Tarif.

5. Wie halte ich meine gescrapten Daten aktuell?

Mit Thunderbit kannst du Scrapes automatisch planen – täglich, wöchentlich oder nach deinem eigenen Rhythmus. So sind deine Tabellen oder Datenbanken immer auf dem neuesten Stand.

Bereit, deine erste Website smart auszulesen? und erlebe, wie einfach Webdaten-Extraktion sein kann. Viel Erfolg beim Scrapen!