Das Internet ist heutzutage eine echte Goldmine für Daten – und wenn du 2025 ein Unternehmen leitest, weißt du: Wer am schnellsten die besten Daten nutzt, ist klar im Vorteil. Egal ob Sales, E-Commerce, Operations oder Marktforschung – die Fähigkeit, Webdaten in großem Stil und auf Knopfdruck zu extrahieren, ist ein echter Gamechanger. Python ist dabei der absolute Favorit: Fast setzen auf Python für die Webdaten-Extraktion – dank der riesigen Auswahl an Bibliotheken und der einfachen, aber starken Bedienung.

Aber es gibt einen neuen Trend: Python ist zwar das Multitool für Webdaten, aber längst nicht mehr die einzige Option. No-Code-Tools wie machen es mittlerweile jedem möglich – selbst absoluten Technik-Anfängern – Webdaten mit ein paar Klicks zu extrahieren, zu bereinigen und zu strukturieren. In diesem Guide zeige ich dir beide Welten: den klassischen Python-Ansatz (Requests, Beautiful Soup, Selenium, Scrapy, Pandas) und wie Thunderbit als Produktivitäts-Booster ins Spiel kommt. Du bekommst praxisnahe Codebeispiele, Business-Szenarien und wertvolle Tipps direkt aus dem Alltag. Los geht’s!

Was bedeutet "Python Pull Data from Website"?

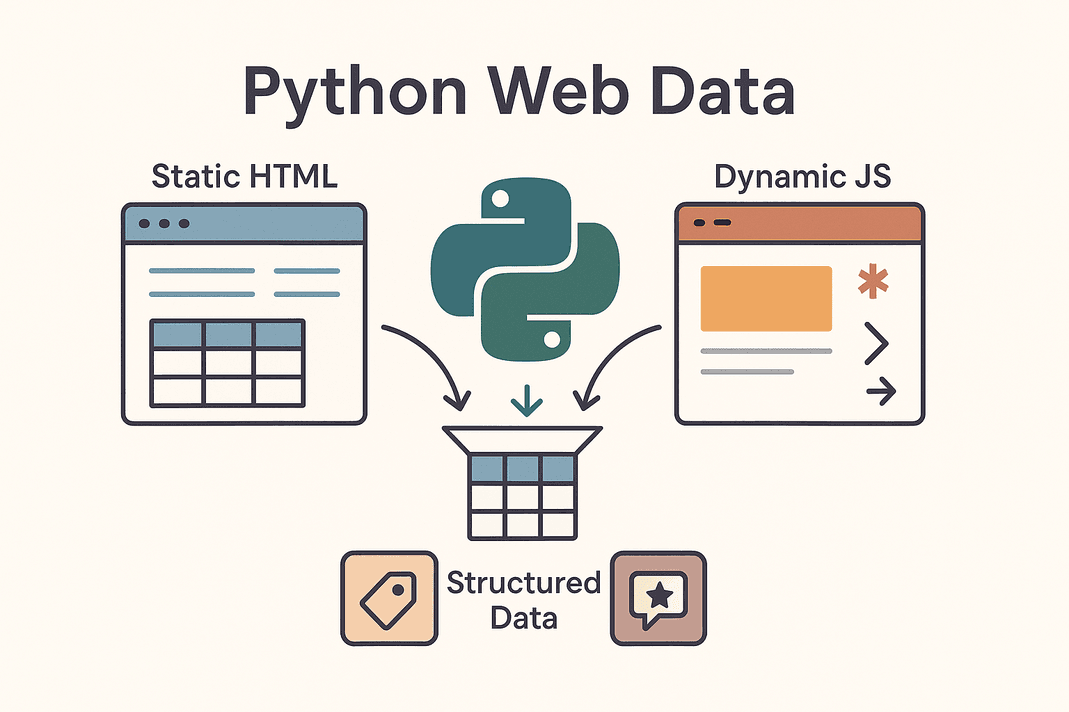

Im Kern heißt „python pull data from website“, dass du mit Python-Skripten automatisch Infos von Webseiten abgreifst – und aus wildem HTML saubere, strukturierte Daten machst. Das Ganze nennt sich Web-Scraper. Statt Produktpreise, Kontaktdaten oder Bewertungen mühsam per Hand zu kopieren, übernimmt Python die Arbeit für dich.

Im Kern heißt „python pull data from website“, dass du mit Python-Skripten automatisch Infos von Webseiten abgreifst – und aus wildem HTML saubere, strukturierte Daten machst. Das Ganze nennt sich Web-Scraper. Statt Produktpreise, Kontaktdaten oder Bewertungen mühsam per Hand zu kopieren, übernimmt Python die Arbeit für dich.

Dabei gibt es zwei Hauptarten von Webseiten:

- Statische Webseiten: Hier steckt der komplette Inhalt direkt im HTML. Was du im „Seitenquelltext“ siehst, ist auch das, was du bekommst. Das Scrapen ist hier easy: HTML laden, parsen, fertig.

- Dynamische Webseiten: Diese Seiten laden Inhalte erst nachträglich per JavaScript. Beispiele sind endloses Scrollen, Live-Preis-Updates oder Inhalte, die erst nach einem Klick erscheinen. Hier brauchst du mehr Power – zum Beispiel einen Browser-Simulator wie Selenium oder du suchst die versteckten APIs, die die Seite beliefern ().

Typische Ziele beim Web Scraping sind Produktlisten, Lead-Tabellen, Preise, Bewertungen, Bilder und vieles mehr. Egal ob du eine Lead-Liste aufbaust, Wettbewerberpreise trackst oder Marktstimmungen sammelst – mit Python wird das Web zu deiner persönlichen Datenquelle.

Warum Unternehmen Python für Webdaten nutzen

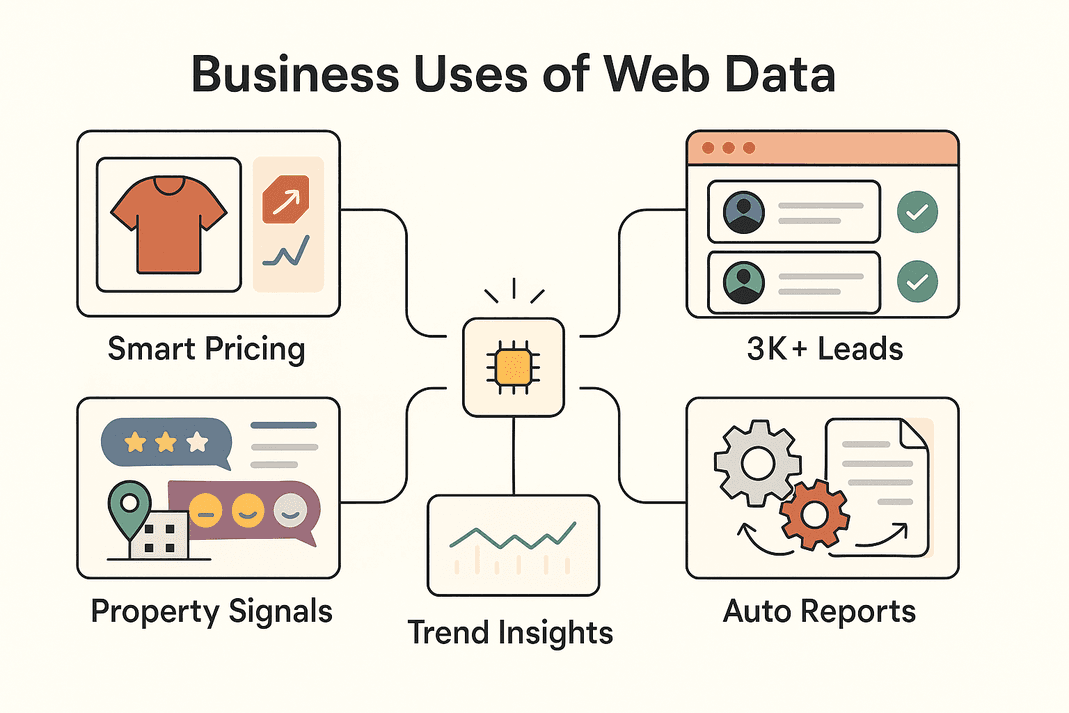

Kommen wir zum Alltag: Warum setzen so viele Unternehmen auf Webdaten-Extraktion? Hier die wichtigsten Anwendungsfälle – und der geschäftliche Mehrwert:

| Business Use Case | Data Pulled | ROI / Benefit |

|---|---|---|

| Lead-Generierung (Vertrieb) | Kontaktdaten aus Verzeichnissen, Socials | 3.000+ Leads/Monat, ~8 Stunden/Woche pro Mitarbeiter gespart (Thunderbit)) |

| Preisüberwachung (E-Commerce) | Produktpreise, Lagerbestände | ~4 % mehr Umsatz, 30 % weniger Analystenzeit (blog.apify.com) |

| Marktforschung | Bewertungen, Social Posts, Forenkommentare | Besseres Targeting; 26 % der Scraper zielen auf Social Data (Thunderbit) |

| Immobilien-Listings | Objektdaten, Vergleichswerte, Standortdaten | Schnellere Deals, aktuelle Vergleichswerte |

| Prozessautomatisierung | Bestände, Reports, wiederkehrende Daten | 10–50 % Zeitersparnis bei manuellen Aufgaben |

Fazit: Webdaten-Extraktion mit Python (oder Thunderbit) hilft Teams, schneller zu reagieren, bessere Entscheidungen zu treffen und nervige Routinearbeiten zu automatisieren. Kein Wunder, dass der – und weiter rasant wächst.

Die wichtigsten Python-Tools für Webdaten-Extraktion

Pythons Stärke beim Web Scraping liegt im riesigen Ökosystem. Hier ein Überblick über die beliebtesten Tools – und wann du welches nutzt:

| Tool | Best For | Pros | Cons |

|---|---|---|---|

| Requests | Statisches HTML oder APIs abrufen | Einfach, schnell, ideal für Einsteiger | Kann kein JavaScript verarbeiten |

| Beautiful Soup | HTML/XML in strukturierte Daten umwandeln | Leicht zu bedienen, flexibel | Braucht HTML, nicht für JS-Seiten |

| Selenium | Dynamische/JS-lastige Seiten, Logins, Klicks | Kann alles, was ein Browser kann | Langsamer, mehr Setup, ressourcenintensiv |

| Scrapy | Große Crawls, viele Seiten | Schnell, asynchron, skalierbar | Höhere Einstiegshürde, kein JS out-of-the-box |

| Thunderbit | No-Code/Low-Code, Business-Anwender | KI-gestützt, kann JS, einfacher Export | Weniger anpassbar für komplexe Logik |

In der Praxis werden oft mehrere Tools kombiniert: Requests + Beautiful Soup für einfache Aufgaben, Selenium für dynamische Seiten, Scrapy für große Crawls und Thunderbit, wenn es schnell und unkompliziert gehen soll.

Schritt 1: Mit Python Requests Webdaten abrufen

Starten wir mit den Basics. Requests ist das Arbeitstier zum Laden von Webseiten in Python. So läuft’s:

-

Requests installieren:

1pip install requests -

Seite abrufen:

1import requests 2url = "https://example.com/products" 3response = requests.get(url) 4if response.status_code == 200: 5 html_content = response.text 6else: 7 print(f"Fehler beim Abrufen der Daten: {response.status_code}")()

-

Tipps zur Fehlerbehebung:

- Browser-Header hinzufügen:

1headers = {"User-Agent": "Mozilla/5.0"} 2response = requests.get(url, headers=headers) - Fehler mit

response.raise_for_status()abfangen - Für JSON-APIs:

data = response.json()

- Browser-Header hinzufügen:

Requests ist perfekt für statische Seiten oder APIs. Fehlen Daten, werden sie meist per JavaScript nachgeladen – dann ist Selenium gefragt.

Schritt 2: Webinhalte mit Beautiful Soup parsen

Sobald du das HTML hast, hilft dir Beautiful Soup beim Extrahieren der gewünschten Infos. So geht’s:

-

Beautiful Soup installieren:

1pip install beautifulsoup4 -

HTML parsen:

1from bs4 import BeautifulSoup 2soup = BeautifulSoup(html_content, 'html.parser') -

Daten extrahieren:

- Alle Produktkarten finden:

1for product in soup.select('div.product-card'): 2 name = product.select_one('.product-name').text.strip() 3 price = product.select_one('.product-price').text.strip() 4 print(name, price) - Für Tabellen:

1for row in soup.find_all('tr'): 2 cells = row.find_all('td') 3 # Zellen nach Bedarf auslesen

- Alle Produktkarten finden:

Tipps:

- Mit den Entwicklertools des Browsers die richtigen Selektoren finden.

.get_text()oder.textfür Textinhalte nutzen.- Fehlende Daten mit Checks abfangen (

if price_elem else "N/A").

Requests + Beautiful Soup ist das Dream-Team für statische Seiten – einfach, zuverlässig und schnell.

Schritt 3: Dynamische Inhalte mit Selenium abgreifen

Wenn eine Seite Daten per JavaScript nachlädt, brauchst du ein Tool, das wie ein echter User agiert. Hier kommt Selenium ins Spiel.

-

Selenium installieren:

1pip install seleniumDen passenden Browser-Treiber (z. B. ChromeDriver) herunterladen und im PATH hinterlegen.

-

Browser automatisieren:

1from selenium import webdriver 2driver = webdriver.Chrome() 3driver.get("https://example.com/products") 4products = driver.find_elements_by_class_name("product-card") 5for prod in products: 6 print(prod.text) 7driver.quit() -

Logins und Klicks automatisieren:

1driver.get("https://site.com/login") 2driver.find_element_by_name("username").send_keys("myuser") 3driver.find_element_by_name("password").send_keys("mypassword") 4driver.find_element_by_id("login-button").click() -

Auf dynamische Inhalte warten:

1from selenium.webdriver.common.by import By 2from selenium.webdriver.support.ui import WebDriverWait 3from selenium.webdriver.support import expected_conditions as EC 4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.CLASS_NAME, "data-row"))) -

Headless-Modus (ohne Fenster):

1options = webdriver.ChromeOptions() 2options.add_argument("--headless") 3driver = webdriver.Chrome(options=options)

Selenium ist mächtig, aber braucht ordentlich Ressourcen – ideal für Seiten, die echte Browser-Interaktion verlangen.

Schritt 4: Mit Scrapy große Datenmengen skalieren

Wenn du hunderte oder tausende Seiten crawlen willst, ist Scrapy dein Werkzeug.

-

Scrapy installieren:

1pip install scrapy 2scrapy startproject myproject -

Spider erstellen:

1import scrapy 2class ProductsSpider(scrapy.Spider): 3 name = "products" 4 start_urls = ["https://example.com/category?page=1"] 5 def parse(self, response): 6 for product in response.css("div.product-card"): 7 yield { 8 'name': product.css(".product-title::text").get().strip(), 9 'price': product.css(".price::text").get().strip(), 10 } 11 next_page = response.css("a.next-page::attr(href)").get() 12 if next_page: 13 yield response.follow(next_page, self.parse) -

Spider ausführen:

1scrapy crawl products -o products.csv

Scrapy ist asynchron, blitzschnell und für große Crawls gemacht – perfekt für ganze Webseiten oder komplexe Paginierung.

Schritt 5: Datenextraktion mit Thunderbit auf das nächste Level bringen

Jetzt zu – dem No-Code KI-Web-Scraper, der besonders für Business-Anwender neue Maßstäbe setzt.

- KI-Feldvorschläge: Thunderbit erkennt automatisch die wichtigsten Datenfelder – kein mühsames HTML-Suchen mehr.

- Dynamische Seiten: Thunderbit sieht die Seite wie du – JavaScript, endloses Scrollen und Logins sind kein Problem.

- Unterseiten-Scraping: Thunderbit kann automatisch in Detailseiten klicken und deine Daten anreichern.

- Vorlagen für beliebte Seiten: Für Plattformen wie Amazon, Zillow oder Shopify gibt es fertige Templates – sofort startklar.

- One-Click-Extractor: Alle E-Mails oder Telefonnummern auf einer Seite? Mit einem Klick erledigt.

- Zeitplanung & Cloud-Scraping: Wiederkehrende Scrapes per natürlicher Sprache planen („jeden Montag um 9 Uhr“) und bis zu 50 Seiten gleichzeitig in der Cloud abarbeiten lassen.

- Export überallhin: Daten direkt nach Excel, Google Sheets, Airtable, Notion oder als CSV/JSON exportieren – kostenlos und unbegrenzt.

Thunderbit ist perfekt für Teams, die schnell an Daten kommen wollen – ohne Programmierung. Du kannst Thunderbit sogar nutzen, um Daten zu extrahieren und sie anschließend in Python weiterzuverarbeiten – das Beste aus beiden Welten.

Schritt 6: Extrahierte Daten mit Pandas bereinigen und analysieren

Sobald du deine Daten (mit Python oder Thunderbit) hast, geht’s ans Bereinigen und Auswerten mit Pandas.

-

Daten laden:

1import pandas as pd 2df = pd.read_csv("products.csv") 3print(df.head()) -

Daten bereinigen:

- Duplikate entfernen:

1df = df.drop_duplicates() - Fehlende Werte behandeln:

1df = df.fillna("N/A") - Formate vereinheitlichen (z. B. Preise):

1df['price'] = df['price'].str.replace('$','').str.replace(',','').astype(float)

- Duplikate entfernen:

-

Analysieren:

- Statistiken abrufen:

1print(df.describe()) - Nach Kategorie gruppieren:

1avg_price = df.groupby('category')['price'].mean() 2print(avg_price)

- Statistiken abrufen:

Pandas ist das Multitool, um aus Rohdaten wertvolle Business-Insights zu gewinnen.

Schritt 7: Webdaten für das Team organisieren und speichern

Die Daten sind sauber – jetzt müssen sie für dein Team nutzbar werden.

- CSV/Excel: Mit

df.to_csv("out.csv", index=False)oderdf.to_excel("out.xlsx")einfach teilen. - Google Sheets: Über oder mit Pythons

gspread-Bibliothek. - Datenbanken: Für große Datenmengen per

df.to_sql()in SQL-Datenbanken speichern. - Automatisierung: Skripte oder Thunderbit-Zeitpläne einrichten, um Daten aktuell zu halten.

- Best Practices: Daten immer mit Zeitstempel versehen, Spalten dokumentieren und Zugriffsrechte beachten.

Wähle die Speicherform, die zu deinem Workflow passt – Tabellen für schnelle Erfolge, Datenbanken für Skalierung.

Thunderbit vs. Python-Code: Was passt zu deinem Team?

Hier der direkte Vergleich:

| Faktor | Thunderbit (No-Code KI) | Python-Bibliotheken (Code) |

|---|---|---|

| Erforderliche Kenntnisse | Keine (browserbasiertes UI) | Python-Programmierung nötig |

| Einrichtungszeit | Minuten (KI-Vorschläge, sofort loslegen) | Stunden bis Tage (Code, Debugging, Setup) |

| JS/Interaktivität | Ja, integriert (Browser-/Cloud-Modus) | Ja, aber mit Selenium/Playwright |

| Wartung | Gering – KI passt sich vielen Änderungen an | Manuell – Code bei Änderungen anpassen |

| Skalierung | Mittel (schnell für 10–100 Seiten via Cloud) | Hoch (Scrapy für tausende Seiten) |

| Anpassbarkeit | Über UI-Optionen & KI-Prompts | Unbegrenzt (jede Logik, jede Integration) |

| Anti-Bot/Proxies | Intern gelöst | Muss selbst implementiert werden |

| Datenexport | 1-Klick zu Sheets, Excel, Notion, Airtable | Eigener Code nötig |

| Am besten geeignet für | Nicht-Techniker, schnelle Ergebnisse, wenig Wartung | Entwickler, komplexe/große Projekte |

Tipp: Nutze Thunderbit für schnelle Ergebnisse und um dein Business-Team zu empowern. Python ist ideal, wenn du maximale Anpassung oder große Skalierung brauchst. Viele Teams kombinieren beides: Thunderbit für den schnellen Start, Python für Automatisierung und Wachstum.

Praxisbeispiele: So nutzen Unternehmen Webdaten

So setzen Teams Web-Scraper konkret ein:

So setzen Teams Web-Scraper konkret ein:

- E-Commerce: John Lewis , indem sie Wettbewerberpreise scrapen und ihre eigenen Preise in Echtzeit anpassen.

- Vertrieb: Teams generieren 3.000+ Leads/Monat und sparen 8 Stunden/Woche pro Mitarbeiter ()) – keine manuelle Recherche mehr.

- Marktforschung: Marketer sammeln tausende Bewertungen oder Social Posts für Sentiment-Analysen und erkennen Trends, bevor Dashboards sie anzeigen.

- Immobilien: Makler scrapen Listings, um unterbewertete Objekte oder neue Chancen schneller zu entdecken – noch bevor sie im MLS auftauchen.

- Workflow-Automatisierung: Operations-Teams automatisieren Bestandsprüfungen, Reportings oder sogar Support-FAQs durch Scraping von Partner- oder internen Seiten.

Oft ist der Workflow hybrid: Thunderbit für die Datensammlung, Python für die Analyse und dann Export in Sheets oder Datenbanken fürs Team.

Fazit & wichtigste Erkenntnisse

Webdaten mit Python (und Thunderbit) zu extrahieren, ist heute eine Kernkompetenz für moderne Business-Teams. Die Kurzfassung:

- Requests + Beautiful Soup: Ideal für statische Seiten, schnell und einfach.

- Selenium: Für dynamische, JS-lastige oder Login-geschützte Seiten.

- Scrapy: Für große, mehrseitige Crawls.

- Thunderbit: Für No-Code, KI-gestütztes Scraping – schnell, einfach, perfekt für Business-Anwender.

- Pandas: Zum Bereinigen, Analysieren und Auswerten deiner Daten.

- Export clever wählen: CSV, Sheets oder Datenbanken – je nach Workflow.

Die beste Strategie? Starte mit dem Tool, das zu deinem technischen Level und Business-Bedarf passt. Kombiniere nach Bedarf. Und wenn du sehen willst, wie einfach Web Scraping sein kann, oder stöbere im nach weiteren Anleitungen.

Viel Erfolg beim Scrapen – und auf saubere, strukturierte und einsatzbereite Daten!

FAQs

1. Wie kann ich am einfachsten mit Python Daten von einer Webseite extrahieren?

Für statische Seiten nutzt du die Requests-Bibliothek zum Laden des HTML und Beautiful Soup zum Parsen und Extrahieren der gewünschten Daten. Für dynamische Seiten brauchst du meist Selenium.

2. Wann sollte ich Thunderbit statt Python-Code verwenden?

Thunderbit ist ideal, wenn du schnell Daten brauchst, nicht programmieren willst oder dynamische Seiten, Unterseiten oder Sofort-Exporte nach Sheets/Excel benötigst. Perfekt für Business-Anwender oder schnelle Projekte.

3. Wie gehe ich mit Seiten um, die Daten per JavaScript laden?

Nutze Selenium (oder Playwright), um einen Browser zu automatisieren – oder probiere Thunderbits Browser-/Cloud-Modus, der JS automatisch verarbeitet.

4. Wie bereinige und analysiere ich gescrapte Daten am besten?

Importiere deine Daten in Pandas, entferne Duplikate, fülle fehlende Werte auf, vereinheitliche Formate und nutze groupby oder describe für schnelle Auswertungen.

5. Ist Web Scraping legal und sicher für Unternehmen?

Grundsätzlich ist das Scrapen öffentlicher Daten legal, aber prüfe immer die Nutzungsbedingungen und robots.txt der Seite. Verzichte auf das Scrapen personenbezogener Daten ohne Einwilligung und gehe respektvoll mit Ressourcen um. Thunderbit und Python unterstützen ethisches Scraping.

Bereit, dein Daten-Game aufs nächste Level zu bringen? oder leg mit Python los – so oder so hast du im Handumdrehen wertvolle Webdaten.

Mehr erfahren