Stell dir vor: Es ist spät am Abend, der Kaffee dampft noch – und du brauchst dringend die aktuellsten Preise der Konkurrenz, frische Leads oder die neuesten Trend-Posts. Aber deine „Daten“ sind schon wieder von letzter Woche, und bis du endlich an die Infos kommst, ist der Markt längst weitergezogen. Ich kenn das nur zu gut – und es ist alles andere als angenehm. In der heutigen Business-Welt fühlt es sich an, als würdest du zu einem Blitzverkauf kommen, wenn schon alles ausverkauft ist, nur weil du auf veraltete, zwischengespeicherte Daten wartest. Genau deshalb ist Live Crawling – also das Erfassen von Echtzeitdaten direkt beim Entstehen – längst kein Luxus mehr, sondern ein echter Gamechanger.

Als jemand, der seit Jahren SaaS- und Automatisierungstools entwickelt (und dabei viel zu viel Kaffee trinkt), hab ich erlebt, wie ein live crawler die Arbeit von Teams komplett verändern kann. Mit wollten mein Team und ich live crawling so einfach machen, dass wirklich jeder – auch ohne Vorkenntnisse – mit ein paar Klicks an die aktuellsten Webdaten kommt. In diesem Guide zeige ich dir, was ein live crawler wirklich ist, warum er so wichtig ist und wie du sofort loslegen kannst – ganz ohne Programmierkenntnisse.

Was ist ein live crawler? Dein direkter Draht zu Echtzeitdaten

Fangen wir ganz vorne an: Was ist eigentlich ein „live crawler“? Ganz einfach: Ein live crawler ist ein Tool, das bei jedem Start die Daten direkt und in Echtzeit von einer Website abruft. Stell dir das vor wie einen Livestream statt einer alten Aufzeichnung. Klassische Web-Scraper greifen oft auf gespeicherte Kopien oder regelmäßige Downloads zurück – du bist also immer einen Schritt zu spät. Ein live crawler dagegen besucht die Seite genau jetzt, sieht, was aktuell angezeigt wird, und holt sich die neuesten Infos.

Manche nennen diese Tools auch „live crawler escort“ oder „live escort crawler“ (klingt ein bisschen wie ein Geheimagent für deine Tabellen, oder?). Das Entscheidende: Diese Crawler geben sich nicht mit alten Daten zufrieden. Sie nutzen Browser-Automatisierung oder Cloud-Browsing, um Inhalte so zu erfassen, wie ein Mensch sie sehen würde – inklusive dynamischer Elemente wie JavaScript, Endlos-Scrollen oder Pop-ups. Egal ob du einen Preissturz, einen viralen Post oder einen neuen Kontakt tracken willst: Du arbeitest immer mit den aktuellsten Daten ().

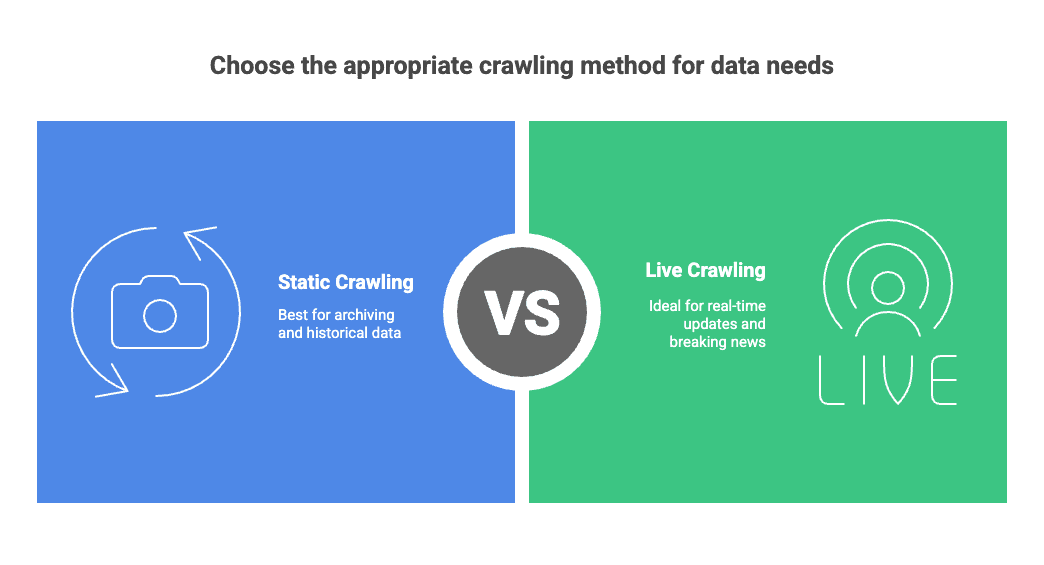

Live vs. Statisches Crawling:

- Statisches Crawling: Wie ein tägliches Foto einer Website – gut für Archive, aber nicht für aktuelle Entwicklungen.

- Live Crawling: Wie ein Livestream – du siehst, was gerade passiert.

Gerade für alle, die auf topaktuelle Infos angewiesen sind, ist dieser Unterschied riesig. In schnelllebigen Märkten können schon ein paar Stunden Verzögerung bedeuten, dass Chancen verpasst oder Entscheidungen auf veralteter Basis getroffen werden ().

Warum Live Crawling für Unternehmen so wichtig ist: Anwendungsfälle & Vorteile

Kommen wir zur Praxis: Warum ist live crawling für Vertrieb, Marketing, Operations und Co. so wertvoll? Die Antwort ist simpel: Echtzeitdaten führen zu besseren Entscheidungen. Laut erzielen Unternehmen, die in „Echtzeit“ agieren, rund 50 % mehr Umsatzwachstum und Gewinnmarge als die Konkurrenz, die auf alte Daten setzt.

| Anwendungsfall | Teams/Funktion | Beispielhafte Vorteile/Daten |

|---|---|---|

| Wettbewerber-Preisüberwachung | Vertrieb/E-Commerce | Preise und Aktionen in Echtzeit verfolgen für dynamische Preisgestaltung (promptcloud.com Pricing) |

| Lead-/Kontakt-Extraktion | Vertrieb/Marketing | Frische Kontaktdaten (Name, E-Mail, Telefon) aus Verzeichnissen oder LinkedIn extrahieren (Thunderbit Blog) |

| Social Media & Trendanalyse | Marketing/Produkt | Hashtags, Trends und Stimmungen in Echtzeit beobachten (promptcloud.com Pricing) |

| Produktkatalog-Updates | E-Commerce/Operations | Produktlisten (Preise, Beschreibungen, Lagerbestand) aktuell halten (datadwip.com Pricing) |

| Sales Pipeline Daten | Vertrieb | Automatisierte Lead-Listen aus Unternehmensverzeichnissen erstellen (Thunderbit Blog) |

| Immobilienanzeigen | Immobilien | Neue Objekte und Preisänderungen direkt beim Erscheinen sammeln (promptcloud.com Pricing) |

Und nicht zu vergessen: Schnellere, präzisere Daten bedeuten schnellere, bessere Entscheidungen. Teams müssen nicht mehr raten, erkennen Trends sofort und handeln, bevor die Konkurrenz überhaupt reagieren kann. Kurz gesagt: Live Crawling verwandelt Rohdaten aus dem Web in sofort nutzbare Erkenntnisse ().

Thunderbit: Der einfachste live crawler für alle

Du denkst jetzt vielleicht: „Klingt super, aber ich bin kein Programmierer. Wie soll ich das machen?“ Genau dieses Problem wollten wir mit lösen.

Thunderbit ist eine KI-gestützte Chrome-Erweiterung, die live crawling so einfach macht wie eine Essensbestellung (und manchmal sogar schneller). Das macht Thunderbit besonders:

- Keine Programmierung nötig: Einfach die Erweiterung installieren, gewünschte Seite öffnen und Thunderbits KI übernimmt den Rest.

- KI-Feldvorschläge: Mit einem Klick scannt Thunderbit die Seite und schlägt automatisch die besten Spalten vor (z. B. „Name“, „Preis“, „E-Mail“) ().

- Unterseiten-Crawling: Du brauchst Infos, die hinter Links versteckt sind? Thunderbit besucht jede Unterseite (z. B. Produktdetails oder Kontaktprofile) und sammelt alle Daten in einer Tabelle.

- Sofort-Vorlagen: Für bekannte Seiten (Amazon, Zillow, LinkedIn usw.) gibt es fertige Templates – kein Einrichten, kein Stress.

- Mehrsprachigkeit: Thunderbit unterstützt 34 Sprachen und ist damit weltweit einsetzbar ().

- Kostenloser Datenexport: Exportiere deine Ergebnisse gratis nach Excel, Google Sheets, Airtable, Notion, CSV oder JSON ().

Das Beste: Auch absolute Einsteiger sind in wenigen Minuten startklar. Ein Nutzer bringt es auf den Punkt: „Ich muss nur zwei Buttons klicken und die Daten sind sofort da. Die Genauigkeit ist beeindruckend“ ().

Live crawler im Vergleich: Thunderbit vs. klassische Tools

Natürlich gibt es auch andere Wege, um Live-Webdaten zu extrahieren. Du könntest dir mit Python, Selenium & Co. selbst einen Crawler bauen. Aber wenn du nicht gerade gerne nachts um zwei Code debuggen willst, gibt es eine bessere Lösung.

| Kriterium | Klassische Tools (Python/Selenium) | Thunderbit KI Crawler |

|---|---|---|

| Einrichtung & Know-how | Programmierkenntnisse und Setup nötig | Kein Code – einfach installieren und loslegen (Thunderbit Blog) |

| Einrichtungszeit | Stunden bis Tage | Minuten |

| Datenaktualität | Momentaufnahmen, oft veraltet | Live, sekundengenau (dataprocorp.tech Pricing) |

| Dynamische Inhalte | Schwierig (zusätzlicher Code nötig) | Integriert, verarbeitet JS und Scrollen automatisch (Thunderbit Blog) |

| Anpassungsfähigkeit | Bricht bei Website-Änderungen | KI passt sich automatisch an (dataprocorp.tech Pricing) |

| Wartung | Hoch (häufige Anpassungen nötig) | Gering (KI übernimmt die meisten Änderungen) (dataprocorp.tech Pricing) |

| Ausgabeformat | Rohes HTML, manuelle Nachbearbeitung | Strukturierte Tabellen, direkt exportierbar (Thunderbit Blog) |

| Integrationen | Individuelle Programmierung nötig | Direkter Export zu Sheets, Airtable, Notion, CSV, JSON (Thunderbit Blog) |

Wenn du also keine Lust auf das Schreiben von Web-Scraping-Skripten hast, ist Thunderbit die perfekte Lösung für alle, die schnell und zuverlässig Ergebnisse brauchen.

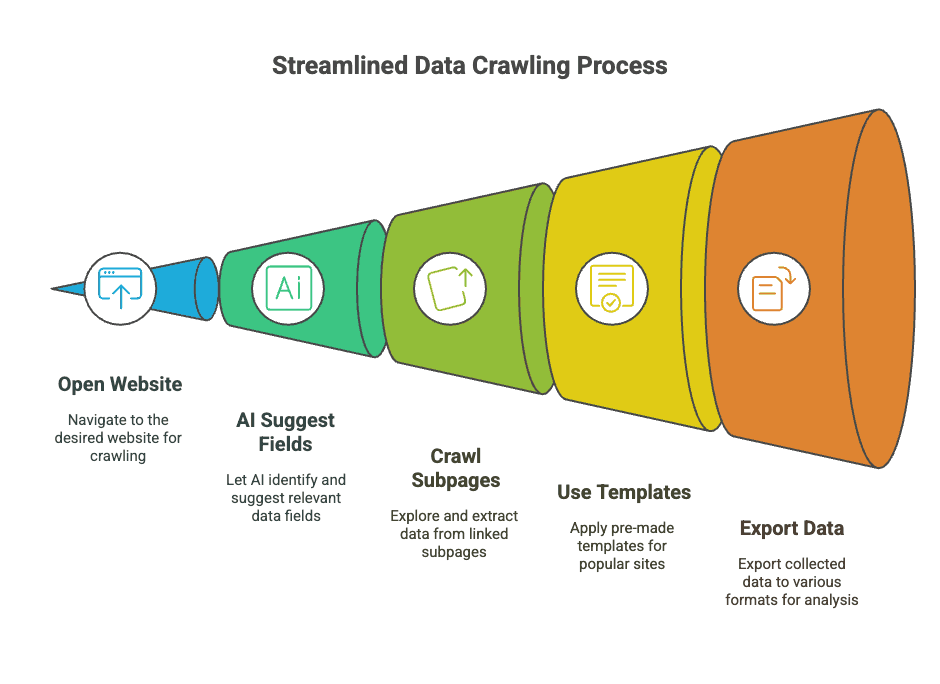

Schritt-für-Schritt: So nutzt du Thunderbit als live crawler

Du willst live crawling in Aktion sehen? So einfach holst du mit Thunderbit Echtzeitdaten von jeder Website – ganz ohne Technik-Frust.

Schritt 1: Thunderbit installieren und Zielseite öffnen

Installiere zuerst die in deinem Browser. Das dauert nur eine Minute (es sei denn, dein WLAN ist im Schneckentempo unterwegs).

Nach der Installation öffnest du einfach die gewünschte Website. Thunderbit funktioniert auf jeder Seite, die dein Browser anzeigen kann – also auch auf Seiten mit Login.

Schritt 2: Mit KI-Feldvorschlägen Datenfelder automatisch erkennen

Jetzt kommt die Magie (bzw. die KI) ins Spiel. Klicke auf KI-Feldvorschläge in Thunderbit. Die KI scannt die Seite und schlägt automatisch die wichtigsten Spalten vor – etwa „Name“, „Preis“, „Lagerbestand“, „E-Mail“ oder was sonst relevant ist ().

Du kannst diese Felder anpassen, umbenennen oder eigene hinzufügen. Wer es individuell mag, kann für jedes Feld eigene Anweisungen hinterlegen – z. B. „Telefonnummern im E.164-Format“ oder „Produkte nach Typ kategorisieren“.

Schritt 3: Live-Daten mit einem Klick extrahieren

Sind die Felder festgelegt, klickst du auf Scrape. Thunderbit durchsucht die Seite in Echtzeit, folgt bei Bedarf der Paginierung oder dem Endlos-Scrollen. Wenn du das Unterseiten-Crawling aktiviert hast, werden auch verlinkte Detailseiten (z. B. Produktinfos oder Profile) automatisch mit erfasst ().

Du siehst live, wie die Zeilen gefüllt werden – fast wie Popcorn beim Aufpoppen, nur viel nützlicher.

Schritt 4: Frische Daten nach Excel, Google Sheets oder Notion exportieren

Nach Abschluss des Crawlings kannst du deine Daten direkt weiterverwenden. Thunderbit ermöglicht den kostenlosen Export nach Excel, Google Sheets, Airtable, Notion, CSV oder JSON (). Einfach das gewünschte Format wählen – und schon sind deine Live-Daten bereit für Analyse, Reporting oder zum Teilen.

Profi-Tipps: So holst du das Maximum aus deinem live crawler

Du willst noch mehr aus Thunderbit rausholen? Hier ein paar Tipps aus der Praxis:

- Crawls planen: Mit dem Scheduler von Thunderbit kannst du Scrapes automatisch ausführen lassen (z. B. „jeden Montag um 9 Uhr“). Perfekt für Preisüberwachung oder Lead-Updates ().

- Unterseiten nutzen: Sind Details hinter Links versteckt (z. B. Kontaktdaten in Profilen), aktiviere das Unterseiten-Crawling. Thunderbit besucht jeden Link und fügt die Zusatzdaten zusammen.

- Feld-Prompts anpassen: Für komplexe Daten kannst du individuelle KI-Anweisungen hinterlegen – etwa zur Kategorisierung oder Formatierung.

- Sofort-Vorlagen verwenden: Für viele bekannte Seiten gibt es Ein-Klick-Templates – das spart Zeit beim Einrichten.

- Websites nicht überlasten: Scrape nicht schneller als nötig. Nutze Zeitpläne und Pausen, um Server zu schonen ().

- Cloud vs. Browser clever wählen: Für öffentliche Seiten ist der Cloud-Modus extrem schnell (bis zu 50 Seiten gleichzeitig). Für Login-Seiten nutze den Browser-Modus, damit Thunderbit unter deiner Sitzung läuft.

Sicher und rechtskonform crawlen

Ein wichtiger Hinweis: Beachte immer die Nutzungsbedingungen und Datenschutzregeln der Websites. Prüfe vor dem Crawlen die robots.txt und die AGB der Seite (). Manche Seiten beschränken automatisierte Zugriffe oder Crawling-Raten. Thunderbit bietet Tools zum Drosseln und Planen – die Verantwortung für einen fairen Einsatz liegt aber bei dir.

- Datenschutz und Recht: Nur öffentliche Daten scrapen und keine personenbezogenen Infos ohne Einwilligung sammeln. Wer E-Mails oder Telefonnummern extrahiert, sollte auf DSGVO- oder CCPA-Konformität achten ().

- Fair bleiben: Nutze die Daten nur für legitime Geschäftszwecke und überlaste keine Server. Transparenz und Compliance minimieren rechtliche Risiken und sorgen für ein gutes Miteinander.

Typische Herausforderungen beim live crawling meistern

Live crawling läuft nicht immer ganz reibungslos. Hier die häufigsten Stolpersteine – und wie Thunderbit sie löst:

- Anti-Bot-Maßnahmen: Manche Seiten setzen CAPTCHAs oder IP-Sperren ein. Thunderbit imitiert menschliches Surfverhalten (vor allem im Browser-Modus) und versucht es bei Fehlern erneut. Bei hartnäckigen CAPTCHAs ist manchmal manuelles Lösen nötig.

- JavaScript & dynamische Seiten: Klassische Scraper scheitern oft, Thunderbit läuft im echten Browser und verarbeitet Skripte, AJAX und Endlos-Scrollen problemlos.

- Layout-Änderungen: Wenn sich das Design einer Seite ändert, brechen klassische Scraper oft ab. Thunderbits KI passt sich meist automatisch an – bei Bedarf einfach „KI-Felder verbessern“ klicken ().

- Datenqualität: Thunderbit bereinigt und strukturiert die Daten beim Scrapen, aber ein kurzer Check vor dem Export schadet nie.

- Schwere JavaScript-Seiten: Bei sehr komplexen Seiten hilft oft ein Wechsel zwischen Cloud- und Browser-Modus oder eine alternative URL.

- Ständige CAPTCHAs: Wenn eine Seite Bots besonders aggressiv blockt, nutze besser eine offizielle API oder passe die Crawl-Rate an.

Mit Thunderbit sind diese Probleme meist deutlich leichter zu lösen als mit selbstgeschriebenen Skripten. Und falls du mal nicht weiterkommst, hilft der mit Tipps und Lösungen.

Fazit & wichtigste Erkenntnisse: Mit live crawling zum Datenvorsprung

Kurz gesagt: Live-Web-Crawling ist der schnellste Weg zu topaktuellen Daten für dein Business. Egal ob Vertrieb, Marketing, Operations oder einfach Daten-Fan – wer die frischesten Infos hat, trifft bessere Entscheidungen, muss weniger raten und ist der Konkurrenz immer einen Schritt voraus.

Mit Thunderbit brauchst du weder Programmierkenntnisse noch Datenwissenschaft. Jeder kann in wenigen Minuten einen live crawl einrichten, automatisieren und die Ergebnisse in die Lieblingstools exportieren. Dank KI-Felderkennung, Unterseiten-Crawling und Sofort-Vorlagen verbringst du weniger Zeit mit Datenaufbereitung und mehr mit der eigentlichen Arbeit.

Fazit: In einer Welt, in der , ist live crawling nicht nur die Zukunft – sondern schon heute unverzichtbar. Thunderbit macht es für alle zugänglich: Schluss mit Warten, jetzt durchstarten.

Bereit für den Einstieg? , Website auswählen und erleben, wie einfach live crawling sein kann. Wer tiefer einsteigen will, findet im und im viele weitere Anwendungsbeispiele.

Viel Spaß beim Crawlen – und mögen deine Daten immer frischer sein als dein Morgenkaffee.

FAQs

1. Was ist ein live crawler und wie unterscheidet er sich von klassischen Web-Scrapern?

Ein live crawler ist ein Tool, das Daten in Echtzeit direkt beim Abruf von Websites sammelt. Im Gegensatz zu klassischen Scrapern, die nach Zeitplan oder mit zwischengespeicherten Daten arbeiten, liefert ein live crawler immer aktuelle Informationen. Oft kommt KI zum Einsatz, um relevante Felder zu erkennen und Seiten automatisch zu navigieren – das macht die Nutzung schneller und einfacher.

2. Warum sind Echtzeitdaten für Vertriebs- und Operationsteams so wichtig?

Echtzeitdaten ermöglichen es Teams, sofort auf Veränderungen zu reagieren. Ob Preisänderungen bei der Konkurrenz, neue Social-Media-Trends oder aktuelle Lagerbestände – mit den neuesten Daten bleiben Unternehmen wettbewerbsfähig, vermeiden Verzögerungen und steigern den Umsatz.

3. Wie verbessert KI den live crawling-Prozess?

KI vereinfacht live crawling, indem sie relevante Datenfelder automatisch erkennt, sich an Layout-Änderungen anpasst, Paginierung und Unterseiten steuert und sogar Daten transformiert (z. B. Übersetzungen oder Währungsumrechnungen). So wird das Tool auch für Nicht-Techniker zugänglich und der manuelle Aufwand sinkt.

4. Für welche Anwendungsfälle eignet sich live crawling?

Live crawler werden eingesetzt, um Preise auf E-Commerce-Plattformen zu überwachen, Kommentare auf TikTok oder Twitter zu extrahieren, Leads auf LinkedIn zu generieren, Kundenbewertungen zu sammeln oder Wettbewerber-Inhalte zu verfolgen. Die Einsatzmöglichkeiten reichen von Handel über Immobilien bis Marketing und Logistik.

5. Wie kann man mit einem live crawler wie Thunderbit starten?

Einfach die Thunderbit Chrome-Erweiterung installieren, die gewünschte Webseite öffnen und mit „KI-Feldvorschläge“ die Datenfelder auswählen. Nach dem Klick auf „Scrape“ sammelt das Tool die Daten und stellt sie strukturiert bereit – der Export in Tabellen oder die Integration mit Google Sheets oder Airtable ist ohne Programmierung möglich.