Ich muss ehrlich sein: Als ich meinen allerersten Web-Scraper gebaut habe, hatte ich das Gefühl, plötzlich eine geheime Superkraft zu besitzen. Die Zeiten, in denen ich stundenlang Daten für Vertriebskontakte oder Preisvergleiche mühsam per Copy & Paste zusammengesucht habe, waren auf einen Schlag vorbei. Fakt ist: Einen eigenen Web-Scraper mit Python zu schreiben, ist für alle, die monotone Aufgaben im Netz automatisieren wollen, ein echter Gamechanger. Gerade im Business kann das den Unterschied machen, ob du deinen Freitagabend mit Excel-Listen verbringst – oder entspannt ins Wochenende startest.

In dieser Anleitung zeige ich dir Schritt für Schritt, wie du mit Python einen Web-Scraper programmierst – inklusive echtem Beispielcode. Außerdem erfährst du, warum es für die meisten Unternehmen heute viel einfacher geht: Mit einem , der dir in zwei Klicks Ergebnisse liefert – ganz ohne Programmierkenntnisse. Egal, ob du Python-Fan bist oder einfach nur schnell an die Daten willst: Hier findest du die passende Lösung.

Was ist Web Scraping mit Python? Ein kompakter Einstieg

Ganz von vorne: Web Scraping heißt nichts anderes, als automatisiert Infos von Webseiten zu sammeln. Stell dir vor, du schickst einen Roboter-Praktikanten los, der für dich alles kopiert – nur dass der Roboter nie müde wird und nie nach einer Gehaltserhöhung fragt.

Ein Web-Scraper ist ein Skript oder Programm, das:

- Eine Webseite aufruft (wie dein Browser)

- Gezielt bestimmte Daten extrahiert (z. B. Produktnamen, Preise oder Kontaktdaten)

- Die Ergebnisse strukturiert abspeichert (z. B. als Tabelle oder JSON-Datei)

Python ist dafür die erste Wahl: Die Sprache ist super lesbar, hat viele praktische Bibliotheken und ist für Entwickler ein echtes Multitool. Tatsächlich nutzen .

So läuft der Prozess ab:

- Webseite abrufen (HTML laden)

- HTML analysieren und die gewünschten Daten herausfiltern

- Ergebnisse speichern

Es ist wie beim Kochen: Zutaten besorgen (HTML), das Beste rauspicken (Daten) und servieren (Export).

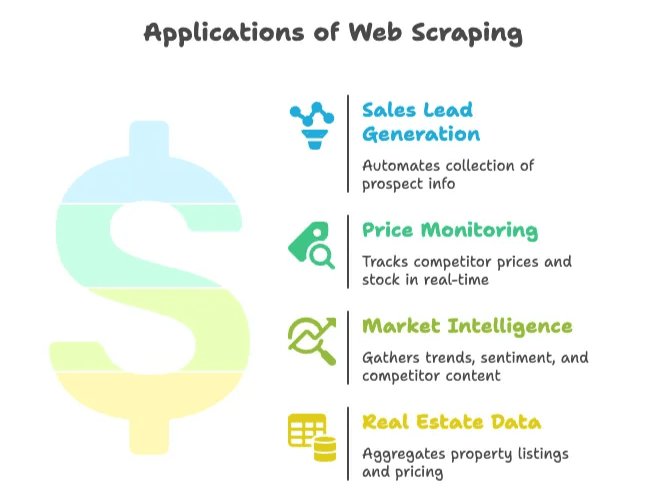

Warum Web Scraping für Unternehmen unverzichtbar ist

Web Scraping ist längst nicht mehr nur ein Thema für IT-Nerds. Egal ob Vertrieb, Marketing, E-Commerce oder Immobilien – überall, wo aktuelle Webdaten für Entscheidungen gebraucht werden, ist automatisiertes Sammeln ein echter Vorteil. Der – und wächst weiter.

Hier ein paar typische Praxisbeispiele:

| Anwendungsfall | Vorteil | Beispiel-Ergebnis |

|---|---|---|

| Lead-Generierung im Vertrieb | Automatisierte Sammlung von Kontaktdaten aus Verzeichnissen oder Netzwerken | ~8 Stunden/Woche pro Mitarbeiter gespart; 3.000 Leads/Monat, 10× Umsatzwachstum in 3 Monaten |

| Preisüberwachung | Echtzeit-Tracking von Wettbewerberpreisen und Lagerbeständen | 30 % weniger Zeitaufwand für Datensammlung; 4 % Umsatzplus durch bessere Preisstrategie |

| Marktanalyse | Trends, Stimmungen und Wettbewerberinhalte für Analysen sammeln | Über 70 % der Unternehmen nutzen Webdaten für Marktanalysen |

| Immobiliendaten | Immobilienangebote und Preise von verschiedenen Portalen bündeln | Unternehmen scrapen Zillow/Trulia, um lokale Marktveränderungen früh zu erkennen |

Das Fazit: Web Scraping spart Zeit, reduziert Handarbeit und verschafft dir einen Vorsprung. Wer noch von Hand kopiert, ist der Konkurrenz meist schon einen Schritt hinterher.

Vorbereitung: Tools und Know-how für deinen eigenen Web-Scraper

Bevor du loslegst, solltest du ein paar Dinge parat haben.

Die Basics

- Python installiert: Lade die aktuelle Version () herunter und prüfe, ob du

pythonim Terminal ausführen kannst. - Code-Editor: VS Code, PyCharm oder Notepad++ – alles geeignet. Ich persönlich mag VS Code wegen der starken Python-Unterstützung.

- Virtuelle Umgebung: Nicht zwingend, aber sehr empfehlenswert, um Abhängigkeiten sauber zu halten. Erstelle eine mit

python -m venv venv.

Wichtige Python-Bibliotheken

- Requests: Zum Abrufen von Webseiten ().

- BeautifulSoup: Zum Parsen von HTML und Finden von Elementen ().

- Selenium: Für Webseiten, die Inhalte per JavaScript nachladen ().

Installation:

1pip install requests beautifulsoup4 lxml seleniumGrundkenntnisse in HTML

Du musst kein Webentwickler sein, aber wissen, wie du den HTML-Code einer Seite inspizierst. Rechtsklick → „Untersuchen“ – und du siehst die DOM-Struktur. Hier findest du die Tags und Klassen, die dein Scraper ansteuern muss ().

Schritt für Schritt: So schreibst du einen Web-Scraper mit Python

Jetzt wird’s praktisch: Wir bauen einen einfachen Web-Scraper von Grund auf. Als Beispiel nehmen wir Produktlisten oder Nachrichtenüberschriften – das Prinzip kannst du leicht anpassen.

Python-Umgebung einrichten

Lege einen Projektordner an und richte eine virtuelle Umgebung ein:

1mkdir my-scraper

2cd my-scraper

3python -m venv venv

4# Aktivieren der venv:

5# Unter Windows:

6venv\Scripts\activate

7# Unter macOS/Linux:

8source venv/bin/activateBibliotheken installieren:

1pip install requests beautifulsoup4 lxmlErstelle eine Datei namens scraper.py und öffne sie im Editor.

Webseiten abrufen und parsen

Wir holen uns das HTML einer Zielseite. Im Beispiel nutzen wir – ein Klassiker für Scraping-Demos.

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content

7else:

8 print(f"Request failed with status {response.status_code}")

9 exit()Jetzt parsen wir das HTML mit BeautifulSoup:

1soup = BeautifulSoup(html_content, "html.parser")

2print(soup.title.string) # Sollte "Hacker News" ausgebenDie gewünschten Daten extrahieren

Angenommen, du willst alle Überschriften und Links sammeln. Im HTML findest du die Titel in <a class="storylink">.

1stories = soup.find_all('a', class_='storylink')

2data = []

3for story in stories:

4 title = story.get_text()

5 link = story['href']

6 data.append({"title": title, "url": link})

7 print(title, "->", link)Bei Produkten suchst du z. B. nach <div class="product-item"> und extrahierst die Felder darin. Ein allgemeines Muster:

1products = soup.find_all('div', class_='product-item')

2for prod in products:

3 name = prod.find('h2').get_text()

4 price = prod.find('span', class_='price').get_text()

5 url = prod.find('a')['href']

6 data.append({"name": name, "price": price, "url": url})Gesammelte Daten als CSV oder JSON speichern

Jetzt speichern wir die Daten, damit du sie weiterverwenden kannst.

Als CSV:

1import csv

2with open("output.csv", mode="w", newline="", encoding="utf-8") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "URL"])

5 for item in data:

6 writer.writerow([item["title"], item["url"]])Als JSON:

1import json

2with open("output.json", mode="w", encoding="utf-8") as f:

3 json.dump(data, f, indent=2)Öffne die CSV in Excel oder die JSON-Datei im Editor – und schon hast du stundenlange Handarbeit automatisiert.

Fortgeschritten: Paginierung und dynamische Inhalte meistern

Die meisten echten Webseiten passen nicht auf eine Seite. So gehst du mit komplexeren Fällen um.

Paginierung

Wenn die Seite per URL paginiert (z. B. ?page=2), kannst du einfach über die Seitenzahlen iterieren:

1base_url = "https://example.com/products?page="

2for page_num in range(1, 6):

3 url = base_url + str(page_num)

4 resp = requests.get(url)

5 if resp.status_code != 200:

6 break

7 soup = BeautifulSoup(resp.content, "html.parser")

8 # Daten extrahieren wie zuvor()

Bei „Weiter“-Buttons suchst du den Link und folgst ihm:

1url = "https://example.com/products"

2while url:

3 resp = requests.get(url)

4 soup = BeautifulSoup(resp.content, "html.parser")

5 # Daten extrahieren

6 next_link = soup.find('a', class_='next-page')

7 if next_link and 'href' in next_link.attrs:

8 url = "https://example.com" + next_link['href']

9 else:

10 url = NoneDynamische Inhalte (JavaScript)

Wenn die Daten nicht direkt im HTML stehen (sondern per JavaScript nachgeladen werden), brauchst du Selenium:

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/complex-page")

4driver.implicitly_wait(5)

5page_html = driver.page_source

6soup = BeautifulSoup(page_html, "html.parser")

7# Daten extrahieren wie zuvor()

Mit Selenium kannst du auch „Mehr laden“-Buttons klicken oder scrollen. Beachte: Das ist langsamer und braucht mehr Ressourcen als Requests.

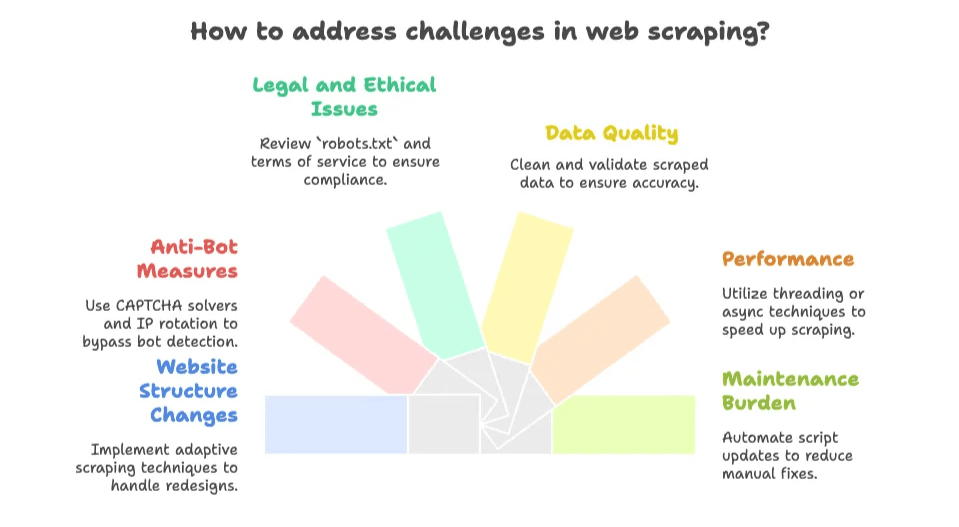

Typische Stolpersteine und Herausforderungen beim eigenen Web-Scraper

Jetzt wird’s realistisch: Einen Web-Scraper zu schreiben macht Spaß – bis die Webseite sich ändert und dein Skript kurz vor der Deadline nicht mehr läuft. Die häufigsten Probleme:

- Strukturänderungen der Webseite: Wenn das Design oder die Klassennamen geändert werden, funktioniert dein Scraper nicht mehr. Ständige Wartung ist nötig ().

- Anti-Bot-Maßnahmen: CAPTCHAs, Rate-Limits und IP-Sperren sind weit verbreitet. .

- Rechtliche und ethische Fragen: Prüfe immer die

robots.txtund die Nutzungsbedingungen der Seite. Öffentliche Daten sind meist erlaubt, private oder urheberrechtlich geschützte Inhalte nicht (). - Datenqualität: Die extrahierten Daten sind oft unstrukturiert. Du musst HTML-Tags, Leerzeichen oder fehlerhaften Text bereinigen.

- Performance: Viele Seiten zu scrapen dauert lange, wenn du nicht mit Threads oder asynchronen Methoden arbeitest.

- Wartungsaufwand: Jede neue Seite oder Änderung bedeutet mehr Arbeit. Es ist ein endloses Katz-und-Maus-Spiel.

Für Entwickler, die Herausforderungen lieben, ist das Teil des Reizes. Wer aber einfach nur Daten will, verliert schnell die Geduld.

Die clevere Alternative: KI-Web-Scraper wie Thunderbit

Hier kommt Thunderbit ins Spiel (stell dir ein Blitz-Logo mit Basecap vor). Die meisten Business-Anwender wollen keinen Code schreiben oder pflegen – sie wollen einfach nur die Daten, und zwar sofort.

Deshalb haben wir entwickelt: Eine , mit der du jede Webseite, PDF oder jedes Bild in zwei Klicks auslesen kannst. Kein Code, keine Einrichtung, keine HTML-Kenntnisse nötig.

Was macht Thunderbit besonders?

- 2-Klick-Bedienung: Webseite öffnen, „KI-Felder vorschlagen“ klicken, dann „Scrapen“. Fertig.

- KI-Feldvorschläge: Thunderbits KI erkennt automatisch die wichtigsten Spalten (z. B. Produktname, Preis, Bewertung usw.).

- Unterseiten & Paginierung: Folgt automatisch „Weiter“-Links oder springt in Detailseiten, um deine Daten zu vervollständigen.

- Sofortiger Datenexport: Exportiere direkt nach Excel, Google Sheets, Airtable, Notion, CSV oder JSON – kostenlos und ohne Umwege.

- Vielfältige Datentypen: Extrahiere E-Mails, Telefonnummern, Bilder oder sogar Text aus PDFs und Bildern (dank integrierter OCR).

- Cloud- oder Browser-Scraping: Bis zu 50 Seiten gleichzeitig in der Cloud scrapen oder im Browser für Seiten mit Login.

- Keine Wartungssorgen: Die KI passt sich automatisch an Layout-Änderungen an – du musst keine Skripte reparieren.

Direktvergleich: Python vs. Thunderbit

| Kriterium | Python-Scraper | Thunderbit (KI-Web-Scraper) |

|---|---|---|

| Einrichtungszeit | Stunden für Setup, Code & Debugging | Minuten – Erweiterung installieren, klicken, fertig |

| Technisches Know-how | Hoch (Python, HTML, CSS, Debugging) | Gering (Point-and-Click, kein Code) |

| Wartung | Du musst bei jeder Änderung nachbessern | Thunderbits KI passt sich automatisch an |

| Paginierung/Unterseiten | Eigene Schleifen & Logik nötig | Integriert, einfach Option aktivieren |

| Datentypen | Standardmäßig nur Basisdaten; Bilder, PDFs, E-Mails etc. erfordern Zusatzcode | Ein-Klick-Extraktion für Text, Bilder, E-Mails, Telefonnummern, PDFs u. v. m. |

| Skalierung & Geschwindigkeit | Begrenzung durch eigenen Code & Ressourcen | Cloud-Scraping für 50 Seiten gleichzeitig; Browser-Modus für Login-Seiten |

| Kosten | Python ist kostenlos, aber deine Zeit nicht; Infrastruktur & Proxys können teuer werden | Kostenloser Tarif verfügbar; kostenpflichtig ab ca. 16,5 $/Monat für 30.000 Credits/Jahr (Preise) |

| Flexibilität & Kontrolle | Maximale Kontrolle für individuelle Logik | Maximaler Komfort für Standardfälle |

Für die meisten Unternehmen ist Thunderbit der schnellste Weg zu strukturierten Daten – ohne Kopfschmerzen.

Wann lohnt sich ein eigener Web-Scraper, wann ein KI-Web-Scraper?

Welche Lösung passt zu dir? Hier meine ehrliche Einschätzung:

Eigener Scraper, wenn:

- Du sehr individuelle Logik brauchst (z. B. Login mit 2FA, mehrstufige Workflows, tiefe Backend-Integration).

- Du gute Programmierkenntnisse hast und gerne tüftelst.

- Die Zielseite stabil ist und du Wartung nicht scheust.

- Du Scraping in ein größeres Softwaresystem einbinden willst.

- Du Daten hinter einem Login oder außerhalb des KI-Tools extrahieren musst.

KI-Web-Scraper (Thunderbit), wenn:

- Du nicht programmieren oder Skripte pflegen willst.

- Du schnell Daten brauchst (einmalig oder regelmäßig).

- Die Seite sich oft ändert oder Anti-Bot-Maßnahmen hat (Thunderbit übernimmt das für dich).

- Du integrierte Features wie OCR, E-Mail-/Telefon-Extraktion oder direkten Export nutzen möchtest.

- Du deine Zeit lieber für Analyse statt Debugging nutzt.

Hier eine schnelle Entscheidungshilfe:

- Sind die Daten öffentlich und nicht hinter einem schwierigen Login? → Thunderbit ist meist die beste Wahl.

- Ist es ein einmaliger oder spontaner Bedarf? → Thunderbit.

- Brauchst du tiefe Anpassung oder Integration? → Python-Skript.

- Hast du einen Entwickler im Team und Spaß am Coden? → Python-Skript.

- Willst du Wartungsaufwand vermeiden? → Thunderbit.

Tipp: Du kannst mit Thunderbit schnell starten und bei komplexeren Anforderungen später eigene Skripte entwickeln.

Mehr dazu, wie KI-Web-Scraper funktionieren und wann sie sinnvoll sind, findest du in unserem .

Fazit: So profitierst du von Web Scraping im Unternehmen

Zusammengefasst:

- Web Scraping mit Python ist mächtig und flexibel, braucht aber Einarbeitung und laufende Wartung.

- KI-Web-Scraper wie Thunderbit machen Datensammlung für alle zugänglich – ohne Code, ohne Einrichtung, mit sofortigen Ergebnissen.

- Für die meisten Unternehmen ist der schnellste Weg zum Ziel ein KI-Tool – außer du hast sehr spezielle Anforderungen.

- Das Web ist eine wahre Datenquelle – mit der richtigen Methode sparst du Stunden oder sogar Tage an Handarbeit.

Häufige Fragen (FAQ)

1. Was ist Web Scraping und warum wird dafür oft Python verwendet?

Web Scraping ist das automatisierte Sammeln von Daten aus Webseiten. Python ist dafür besonders beliebt, weil es leicht verständlich ist, viele Bibliotheken (wie requests, BeautifulSoup und Selenium) bietet und HTML-Inhalte einfach verarbeitet werden können.

2. Welche typischen Anwendungsfälle gibt es für Web Scraping im Business?

Unternehmen nutzen Web Scraping für Lead-Generierung, Preisüberwachung, Marktanalysen und das Sammeln von Immobiliendaten. So lassen sich wiederkehrende Aufgaben automatisieren und aktuelle Erkenntnisse für Entscheidungen gewinnen.

3. Was sind die größten Herausforderungen beim eigenen Web-Scraper?

Häufige Probleme sind Änderungen an Webseiten, Anti-Bot-Schutz wie CAPTCHAs, rechtliche Fragen, unstrukturierte Daten und der ständige Wartungsaufwand, um die Scraper aktuell zu halten.

4. Wie unterscheidet sich der KI-Web-Scraper von Thunderbit von klassischen Python-Scrapern?

Thunderbit bietet eine No-Code-Lösung mit KI-gestützten Feldvorschlägen, automatischer Paginierung und Exportfunktionen. Die Einrichtung ist minimal, die KI passt sich automatisch an Änderungen an und auch Nicht-Entwickler können sofort loslegen – im Gegensatz zu Python-Skripten, die Programmierkenntnisse und Wartung erfordern.

5. Wann sollte man einen KI-Scraper wie Thunderbit statt eines eigenen Skripts nutzen?

Thunderbit ist ideal, wenn du schnell und ohne Programmierung Daten extrahieren möchtest – besonders für öffentliche oder einmalige Aufgaben. Ein eigenes Python-Skript lohnt sich, wenn du volle Kontrolle, tiefe Integration oder komplexe, geschützte Inhalte brauchst.

Weiterführende Artikel:

Wenn du tiefer ins Thema Web Scraping einsteigen möchtest, empfehlen wir diese Anleitungen:

Und wenn du die einfachste Lösung direkt ausprobieren möchtest: und überzeug dich selbst. Deine Daten – und deine Freizeit – werden es dir danken.