Stell dir mal vor: Du bist Journalist und musst ständig die neuesten Nachrichtenartikel aus zig Quellen im Auge behalten, um PR-Möglichkeiten zu entdecken. Oder du bist SEO-Profi und suchst gezielt nach bestimmten Keywords, um Top-Blogs zu analysieren und die Inhalte deiner Konkurrenz zu überwachen. Vielleicht bist du auch Forscher und sammelst Daten aus unzähligen Online-Fachzeitschriften und Publikationen zu einem bestimmten Thema.

Manuelles Kopieren und Einfügen? Viel zu mühsam und zeitfressend! Deshalb denkst du sicher darüber nach, einen einzusetzen, um Nachrichtenartikel und andere Inhalte automatisch zu extrahieren. Aber wenn du keine Programmierkenntnisse hast, wirken viele Tools mit ihren Codes schnell abschreckend. Selbst beliebte sind oft nicht so einfach, wie sie klingen – vor allem, wenn du mehrere Webseiten mit ganz unterschiedlichen Strukturen auslesen willst. Und sobald sich das Layout einer Seite ändert, funktionieren die bisherigen Regeln oft nicht mehr.

Gibt es also eine schnellere und smartere Lösung für das Scrapen von Artikeln? Die Antwort: der . Statt komplizierter analysiert die KI mit nur einem Klick die Webseitenstruktur und den Inhalt. Solche Scraper passen sich flexibel an verschiedene Websites an, bereinigen die Daten und können sie sogar direkt auswerten.

Wenn du den passenden suchst, zeigt dir dieser Beitrag die Vor- und Nachteile der gängigsten Tools und für welche Anwendungsfälle sie sich am besten eignen.

TL;DR

| Vorteile | Nachteile | Ideal für | |

|---|---|---|---|

| KI-Artikel-Scraper | - Kann mehrere Websites mit hoher Genauigkeit scrapen - Entfernt automatisch Störfaktoren - Passt sich an Webseitenänderungen an - Unterstützt dynamisches Nachladen von Inhalten - Geringer Aufwand für Datenbereinigung | - Höherer Rechenaufwand - Längere Verarbeitungszeit - Manche Seiten erfordern manuelle Nacharbeit - Kann Anti-Scraping-Mechanismen auslösen | - Scraping komplexer oder dynamischer Seiten (z. B. Newsportale, Social Media) - Großflächige Datensammlung |

| Klassischer No-Code-Artikel-Scraper | - Schnelle Ausführung - Geringe Kosten - Kaum Ressourcenbedarf - Hohe Steuerbarkeit | - Häufige Wartung wegen Webseitenänderungen - Kann nicht mehrere Seiten gleichzeitig scrapen - Kommt mit dynamischen Inhalten nicht zurecht - Hoher Aufwand für Datenbereinigung | - Schnelles, großflächiges Scraping einfacher, statischer Webseiten - Begrenzte Ressourcen oder Budget |

Was ist ein Artikel-Scraper? Warum sind KI-Artikel-Scraper so relevant?

Ein ist eine spezielle Art von , die gezielt Infos wie Titel, Autor, Veröffentlichungsdatum, Inhalt, Schlagwörter, Bilder und Videos von Nachrichten-Websites extrahiert und diese strukturiert – zum Beispiel als JSON, CSV oder Excel – bereitstellt.

arbeiten mit , um Inhalte anhand der -Struktur einer Seite zu erfassen. Das bringt aber einige Nachteile mit sich:

- Keine Allzwecklösung: Jede Website braucht eigene , und schon kleine Änderungen am Seitenaufbau machen die Regeln unbrauchbar – ständiges Nachjustieren ist angesagt.

- Probleme mit dynamischen Inhalten: Viele Seiten laden Inhalte per AJAX oder JavaScript nach, was mit nicht direkt ausgelesen werden kann.

- Begrenzte Datenverarbeitung: holen nur -Fragmente – für weitere Analysen, Formatierungen oder Bewertungen ist zusätzliche Nachbearbeitung nötig.

Hier kommt der ins Spiel.

Hier kommt der ins Spiel.

-

Diese Technologie nutzt LLMs zur Seitenanalyse und bietet:

- Intelligente Erkennung: Automatische Identifikation von Titeln, Autoren, Zusammenfassungen und Hauptinhalten.

- Automatische Störfaktor-Entfernung: Navigation, Werbung und verwandte Artikel werden ausgefiltert – für saubere Daten und effizientes Scraping.

- Anpassungsfähigkeit: Selbst bei Änderungen im Seitenaufbau kann die KI dank semantischer und visueller Analyse weiter scrapen.

- Seitenübergreifende Anwendung: Im Gegensatz zu funktioniert die KI-Lösung ohne manuelle Anpassungen auf verschiedenen Websites.

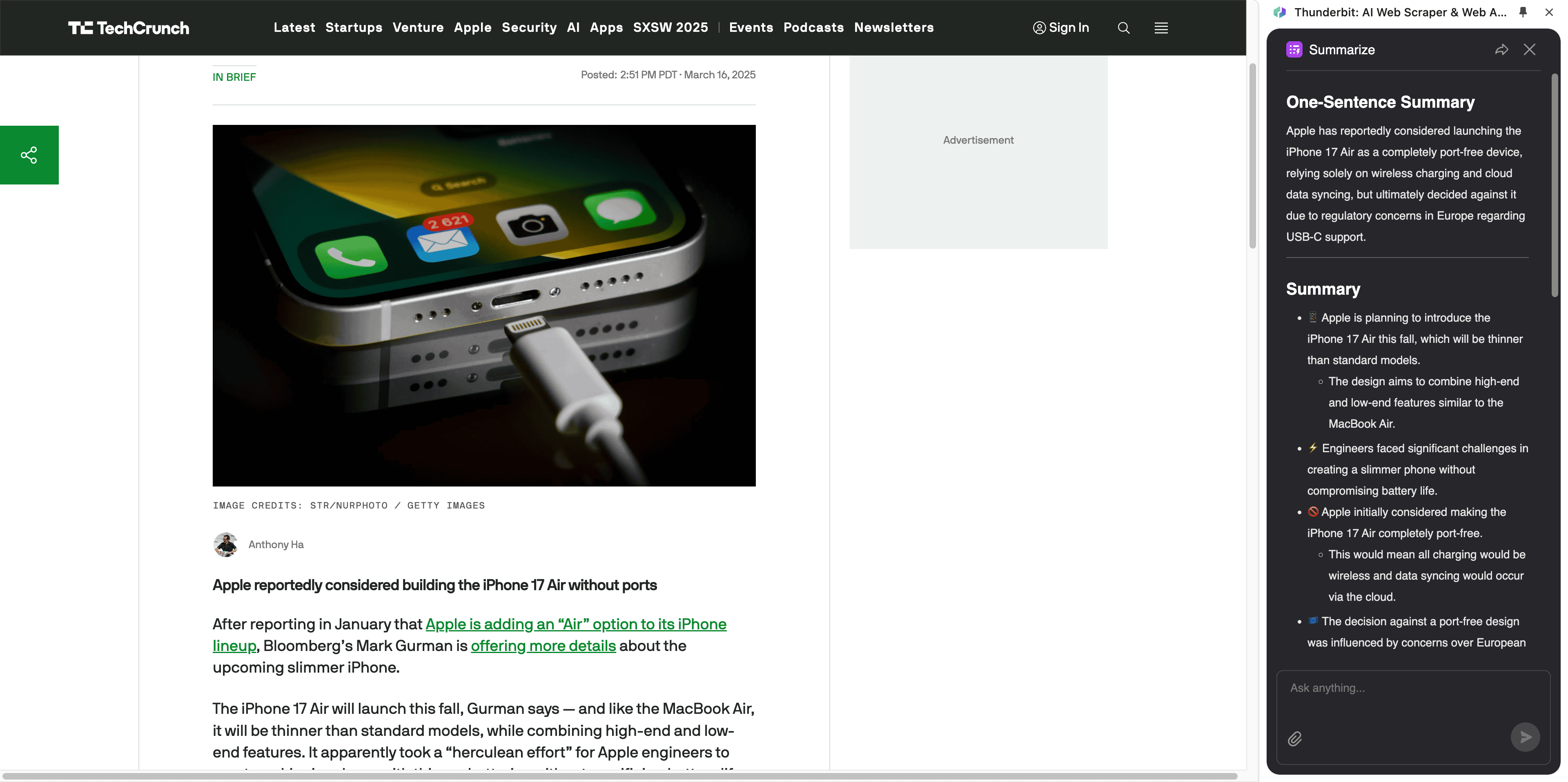

- Integration von NLP und Deep Learning: Aufgaben wie Übersetzung, Zusammenfassung oder Sentiment-Analyse werden direkt mit erledigt.

Was macht den besten Artikel-Scraper 2025 aus?

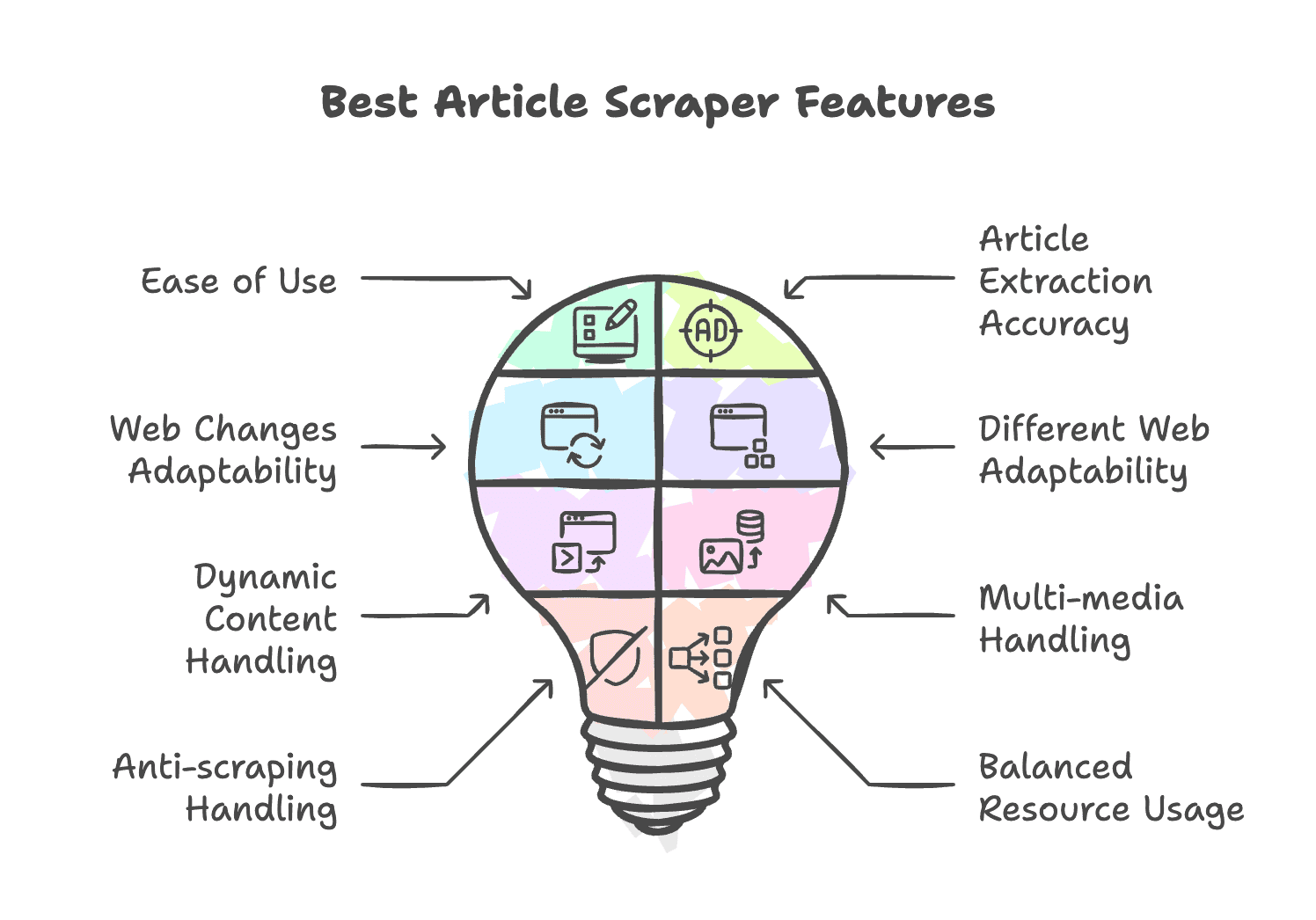

Ein richtig guter artikel scraper vereint Power, Preis, einfache Bedienung, Flexibilität und Skalierbarkeit. Nach diesen Kriterien solltest du 2025 auswählen:

- Einfache Bedienung: Intuitive Oberfläche, keine Programmierkenntnisse nötig.

- Hohe Extraktionsgenauigkeit: Relevante Infos werden präzise erkannt, Werbung und Navigation bleiben außen vor.

- Anpassung an Webseitenänderungen: Automatische Anpassung an neue Strukturen ohne ständige Wartung.

- Vielseitigkeit: Funktioniert auf unterschiedlich aufgebauten Webseiten.

- Dynamische Inhalte: Unterstützt das Nachladen per JavaScript oder AJAX.

- Multimedia-Unterstützung: Erkennt Bilder, Videos und Audios.

- Anti-Scraping-Mechanismen: Nutzt IP-Rotation, CAPTCHA-Lösungen und Proxys, um Blockaden zu umgehen.

- Effizienter Ressourceneinsatz: Benötigt keine übermäßigen Systemressourcen.

Die besten Artikel- & News-Scraper im Überblick

| Tool | Hauptfunktionen | Ideal für | Preise |

|---|---|---|---|

| Thunderbit | KI-basierter Scraper; vorgefertigte Templates; PDF-, Bild- & Dokumenten-Scraping; fortschrittliche Datenverarbeitung | Nutzer ohne Technikkenntnisse, die mehrere Nischenseiten scrapen möchten | 7 Tage kostenlos testen, ab 9 $/Monat (Jahresabo) |

| WebScraper.io | Browser-Erweiterung; unterstützt dynamische Inhalte; keine Proxy-Integration | Nutzer, die keine komplexen Seiten oder Spezialfunktionen benötigen | 7 Tage kostenlos testen, ab 40 $/Monat (Jahresabo) |

| Browse.ai | No-Code-Scraper & Monitoring; vorgefertigte Roboter; virtueller Browser; verschiedene Paginierungsmethoden; starke Integrationen | Unternehmen mit großem Bedarf an komplexem Site-Scraping | 19 $/Monat (Jahresabo) |

| Octoparse | No-Code-Scraper auf CSS-Selektor-Basis; automatische Workflow-Erstellung; vorgefertigte Artikel-Scraper-Templates; virtueller Browser; Anti-Anti-Scraping | Unternehmen mit komplexen Scraping-Anforderungen | Ab 99 $/Monat (Jahresabo) |

| Bardeen | Umfassende Web-Automatisierung; vorgefertigte Templates; No-Code-Scraper; nahtlose Integration ins Workspace | GTM-Teams, die Scraping in bestehende Workflows einbinden | 7 Tage kostenlos testen, ab 99 $/Monat (Jahresabo) |

| PandaExtract | Benutzerfreundliche Oberfläche; automatische Erkennung & Labeling | Nutzer, die schnell und ohne Aufwand Daten extrahieren möchten | 49 $ Einmalzahlung |

Der leistungsstärkste KI-Artikel-Scraper für Unternehmen

- Vorteile:

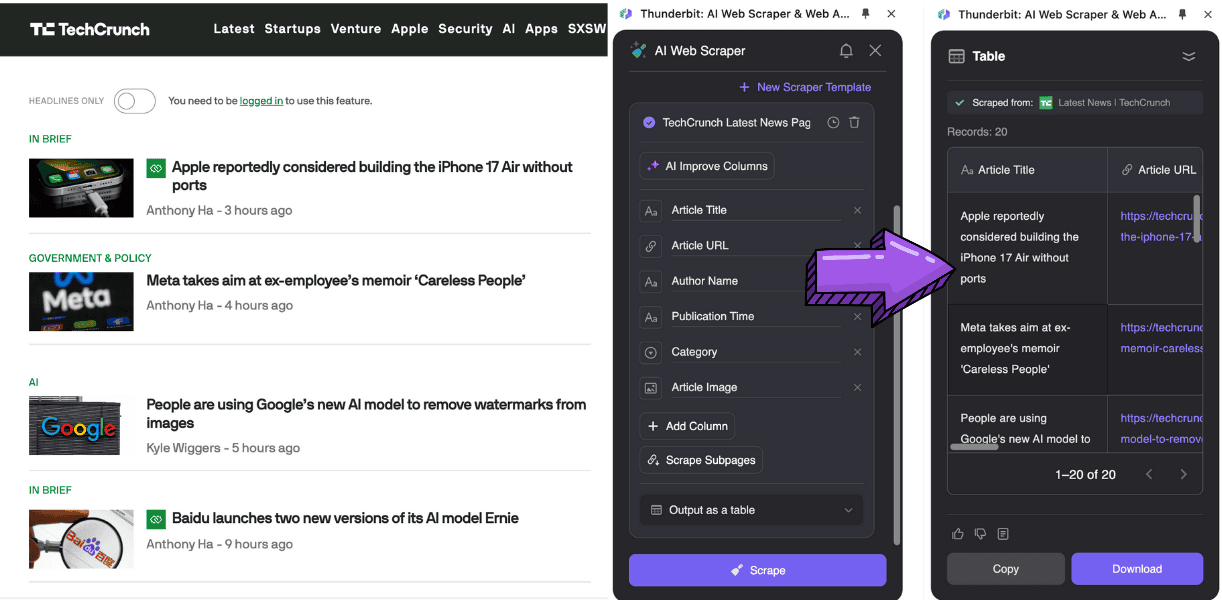

- Erkennt und analysiert Webseiteninhalte per natürlicher Sprache, ganz ohne CSS-Selektoren

- KI-gestützte Datenanalyse, inklusive Formatumwandlung, , Klassifizierung, Übersetzung und Tagging

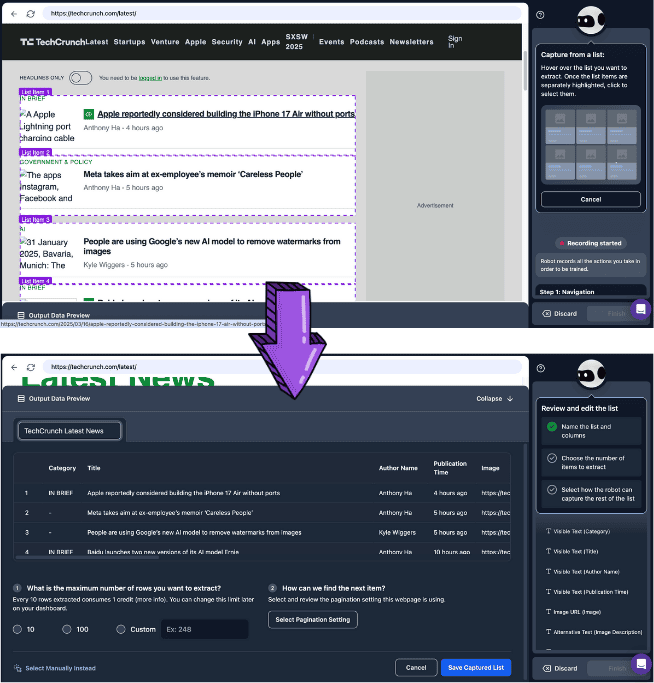

- für das Scrapen von Listen und Inhalten per Klick

- Nachteile:

- Aktuell nur als verfügbar

- Nicht für großflächiges Massenscraping geeignet

- Mehrseitiges Scraping ist langsamer, kann aber im Hintergrund laufen

Ein KI-Artikel-Scraper für den Unternehmenseinsatz

Browse.ai

- Vorteile:

- No-Code-Artikel-Scraper und Monitoring

- Virtueller Browser vermeidet Anti-Scraping-Sperren

- Viele vorgefertigte Roboter für das Scrapen von , , u. v. m.

- Tiefe Integration mit und

- Nachteile:

- Für Deep Extract müssen zwei Roboter erstellt werden – das ist umständlich

- CSS-Selektoren sind für Nischenseiten oft ungenau

- Teuer, lohnt sich vor allem für kontinuierliches Massenscraping

No-Code-Scraper für kleine Datenmengen

PandaExtract

- Vorteile:

- Erkennt Artikel-Listen und Details automatisch, sehr benutzerfreundlich

- Extrahiert Listen, Details, E-Mails und Bilder – ideal für kleine, strukturierte Datenmengen

- Einmalzahlung für lebenslange Nutzung

- Nachteile:

- Nur als Browser-Erweiterung, kein Cloud-Betrieb

- In der Gratisversion nur Kopieren, kein Export als CSV, JSON etc.

Out-of-the-Box-Artikel-Scraper für Unternehmen

Octoparse

- Vorteile:

- No-Code-Artikel-Scraper mit automatischer Strukturerkennung und Workflow-Generierung

- Viele vorgefertigte Templates, sofort einsatzbereit

- Virtueller Browser mit IP-Rotation, CAPTCHA-Lösungen und Proxys gegen Anti-Scraping

- Nachteile:

- Auto-Detect basiert weiterhin auf CSS-Selektoren, Genauigkeit nur durchschnittlich

- Fortgeschrittene Funktionen erfordern Einarbeitung und technisches Know-how

- Hohe Kosten bei großem Datenvolumen

Umfassende Automatisierung für GTM-Teams

Bardeen

- Vorteile:

- No-Code-Artikel-Scraper mit LLM für Automatisierung per Klick

- Integration mit über 100 Apps, darunter , und

- Leistungsstarke Web-Automatisierung für KI-Analysen nach dem Scraping

- Ideal, um Scraping in bestehende Workflows einzubinden

- Nachteile:

- Starke Abhängigkeit von vorgefertigten Playbooks, individuelle Workflows erfordern Ausprobieren

- Trotz No-Code-Plattform ist für komplexe Automatisierungen Einarbeitung nötig

- Einrichtung für Subpage-Extraktion ist komplex

- Sehr teuer

Leichter Artikel-Scraper für schnelle Datenerfassung

Webscraper.io

- Vorteile:

- No-Code-Scraper mit Point-and-Click-Oberfläche

- Unterstützt dynamisches Nachladen von Inhalten

- Cloud-basierter Betrieb

- Integration mit , und

- Nachteile:

- Keine vorgefertigten Templates, eigene Sitemaps müssen erstellt werden

- Lernkurve für Nutzer ohne CSS-Selektor-Erfahrung

- Komplexe Einrichtung für Paginierung und Subpages

- Cloud-Version ist teuer

Fortgeschrittene Lösungen für Entwickler

Wenn du technisches Know-how hast, kannst du auf zurückgreifen. Diese bieten:

- Flexibilität: Direkte API-Aufrufe für individuelles Scraping, inklusive dynamischem Rendering und IP-Rotation

- Skalierbarkeit: Einbindung in eigene Datenpipelines für große, häufige Abfragen

- Geringer Wartungsaufwand: Kein Management von Proxy-Pools oder Anti-Scraping-Strategien nötig

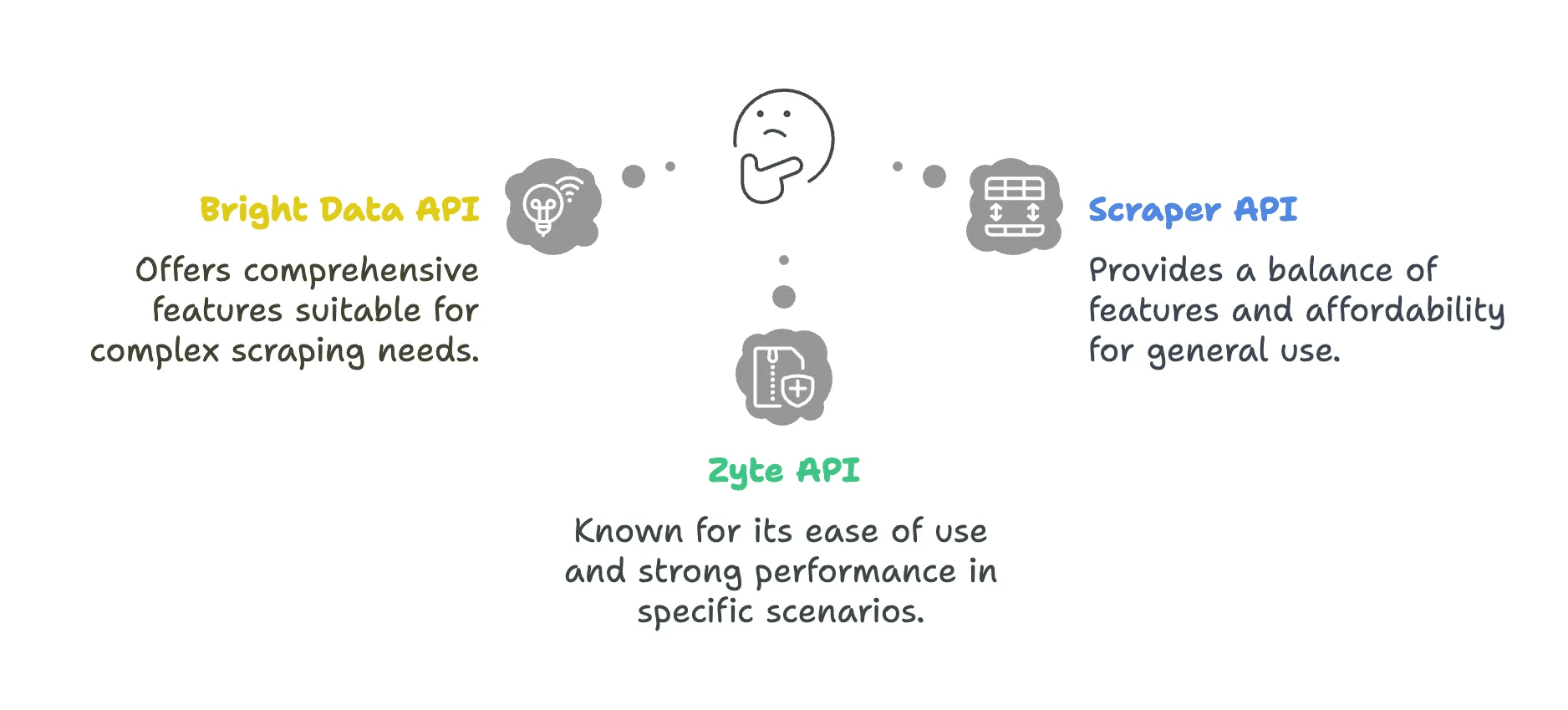

API-Lösungen im Überblick

| API | Vorteile | Nachteile |

|---|---|---|

| Bright Data API | - Riesiges Proxy-Netzwerk (72M+ IPs in 195 Ländern) - Präzises Geo-Targeting bis auf Stadt/PLZ - Leistungsstarker Proxy-Manager für IP-Rotation | - Langsame Antwortzeiten (Ø 22,08s) - Hoher Preis, nicht für kleine Teams - Komplexe Konfiguration erfordert Einarbeitung |

| ScraperAPI | - Günstiger Einstieg ab 49 $ - Autoparse für automatische Datenerkennung - Web-UI-Player zum Testen | - Blockierte Anfragen werden trotzdem berechnet - Eingeschränkte JavaScript-Unterstützung - Kosten steigen mit Premium-Parametern |

| Zyte API | - KI-Parsing - Keine Berechnung fehlgeschlagener Anfragen | - Hohe Grundgebühr (~450 $/Monat) - Credits verfallen monatlich |

- Bright Data Web Scraper API

- Vorteile:

- 72M+ Residential-IPs in 195 Ländern, automatische IP-Rotation und Geo-Simulation – ideal für Seiten mit starker Anti-Scraping-Absicherung (z. B. , )

- Unterstützt JavaScript-Rendering und Seitensnapshots

- Nachteile:

- Hohe Kosten (Abrechnung pro Anfrage und Bandbreite), für kleine Projekte wenig wirtschaftlich

- Vorteile:

- Scraper API

- Vorteile:

- 40M Proxys weltweit, automatische Umschaltung zwischen Rechenzentrum/Residential, umgeht Cloudflare, Integration von Drittanbieter-CAPTCHA-Lösungen (z. B. )

- Strukturierte Endpunkte und asynchrone Scraper für hohe Geschwindigkeit

- Nachteile:

- Zusatzkosten für dynamisches Rendering, eingeschränkte Unterstützung für komplexe AJAX-Seiten

- Vorteile:

- Zyte API

- Vorteile:

- KI-gestützte automatische Webdatenerfassung, keine Entwicklung und Wartung von Extraktionsregeln nötig

- Flexible Pay-as-you-go-Preise

- Nachteile:

- Fortgeschrittene Features (z. B. Session-Handling, scriptbare Browser) erfordern Einarbeitung

- Vorteile:

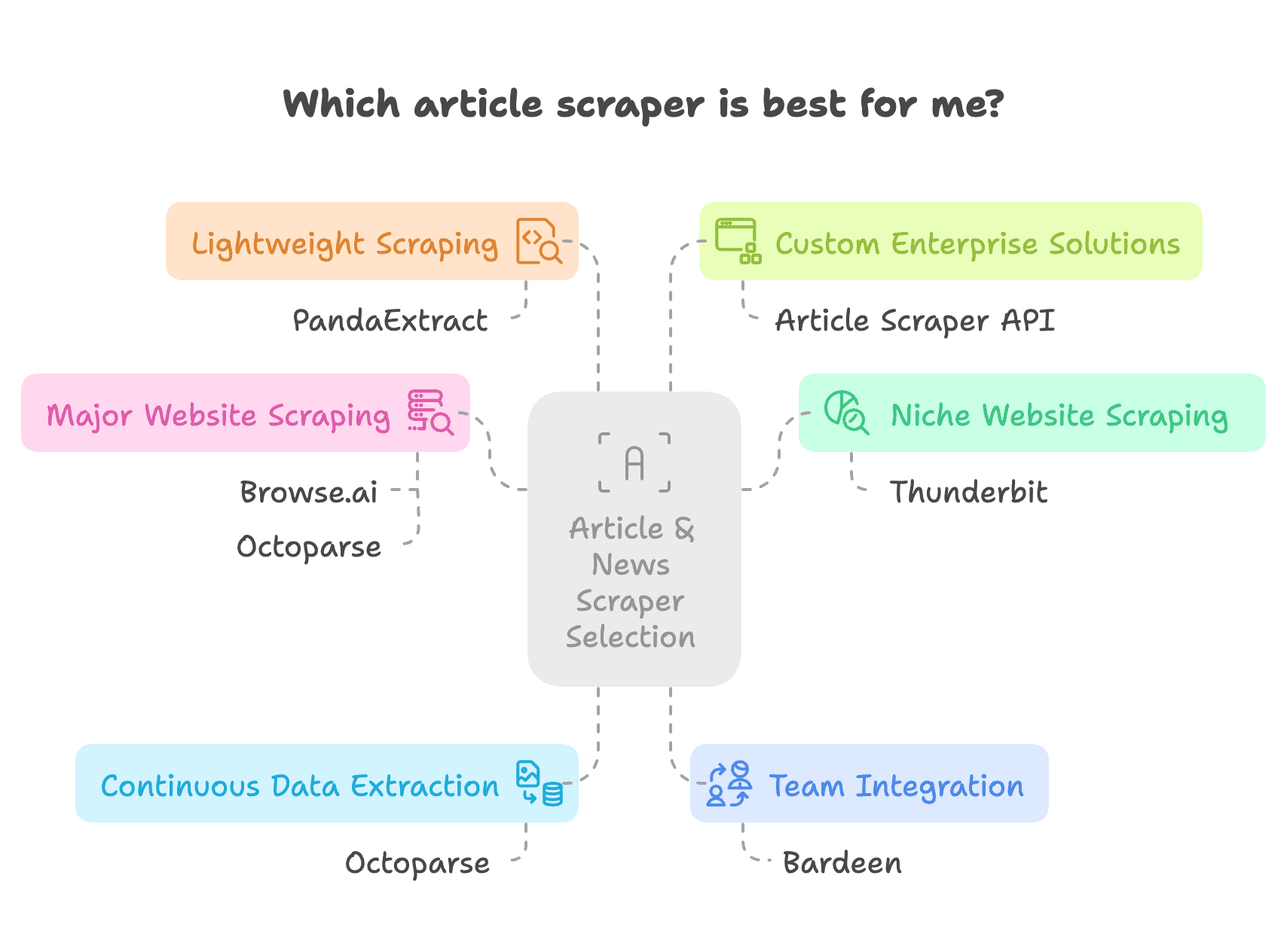

Wie finde ich den passenden Artikel- & News-Scraper?

Überleg dir, welche Anforderungen, welches technische Know-how und welches Budget du hast.

- Musst du viele Nischenseiten scrapen, ohne für jede Seite eigene Regeln zu erstellen, und hast ein gewisses Budget? ist dann die beste Wahl. Statt nutzt Thunderbit KI zur Analyse und ermöglicht nachgelagerte Auswertungen. Für Thunderbit AI sind alle Websites gleich – Artikel werden zuverlässig extrahiert.

- Für große Newsportale wie oder brauchst du einen Scraper mit starken Anti-Scraping-Mechanismen und Templates, z. B. Browse.ai oder Octoparse. Am einfachsten ist aber eine Chrome-Erweiterung wie : Das Scraping läuft wie normales Browsen und Kopieren ab, inklusive Login – ganz ohne komplizierte Einrichtung.

- Für kontinuierliches Massenscraping sind Tools mit Zeitplan-Funktion wie Octoparse geeignet.

- Für Teams und nahtlose Integration in bestehende Workflows ist Bardeen ideal, da es weit mehr als nur Scraping bietet.

- Für kleine Datenmengen ohne Einarbeitungszeit empfiehlt sich ein Point-and-Click-Scraper wie PandaExtract.

- Wer technisch fit ist oder eine eigene Unternehmenslösung baut, kann auf API-Tools oder eigene Scraper neben den setzen.

Fazit

In diesem Beitrag hast du gesehen, wie vielseitig und praktisch artikel scraper und news artikel scraper sind. basieren auf und erfordern Grundkenntnisse in und – besonders für fortgeschrittene Aufgaben. Die neue Generation der setzt auf semantisches Verständnis und visuelle Erkennung, ist anpassungsfähiger bei Webseitenänderungen, funktioniert seitenübergreifend, verarbeitet dynamische Inhalte und übernimmt die Datenaufbereitung gleich mit.

Wir haben sechs empfehlenswerte artikel scraper und news artikel scraper sowie API-Tools für Entwickler verglichen – mit ihren Stärken, Schwächen, Einsatzbereichen und Zielgruppen. Such dir die Lösung aus, die zu deinen Anforderungen passt und ein gutes Verhältnis von Leistung und Kosten bietet.

Häufige Fragen

1. Was ist ein KI-Artikel-Scraper und wie funktioniert er?

- Nutzt KI, um Inhalte von Webseiten zu analysieren und zu extrahieren – ganz ohne CSS-Selektoren.

- Erkennt Titel, Autoren, Veröffentlichungsdatum und Hauptinhalt mit hoher Präzision.

- Entfernt automatisch Werbung, Navigation und andere irrelevante Elemente.

- Passt sich an Webseitenänderungen an und funktioniert seitenübergreifend.

2. Welche Vorteile bietet ein KI-Artikel-Scraper gegenüber klassischen Scraper-Tools?

- Kann Inhalte von mehreren Websites mit nur einem Tool extrahieren.

- Kommt mit dynamischen Inhalten wie JavaScript- oder AJAX-Seiten zurecht.

- Weniger manueller Aufwand und Wartung als CSS-basierte Scraper.

- Bietet Zusatzfunktionen wie Zusammenfassung, Übersetzung und Sentiment-Analyse.

3. Kann ich Thunderbit für KI-Artikel-Scraping ohne Programmierkenntnisse nutzen?

- Ja, Thunderbit ist speziell für Nicht-Techniker mit einer einfachen No-Code-Oberfläche entwickelt.

- Die KI erkennt und extrahiert Artikelinhalte automatisch.

- Vorgefertigte Templates ermöglichen schnelles und effizientes Scraping.

- Export in verschiedene Formate wie CSV, JSON oder Google Sheets ist möglich.

Mehr erfahren: