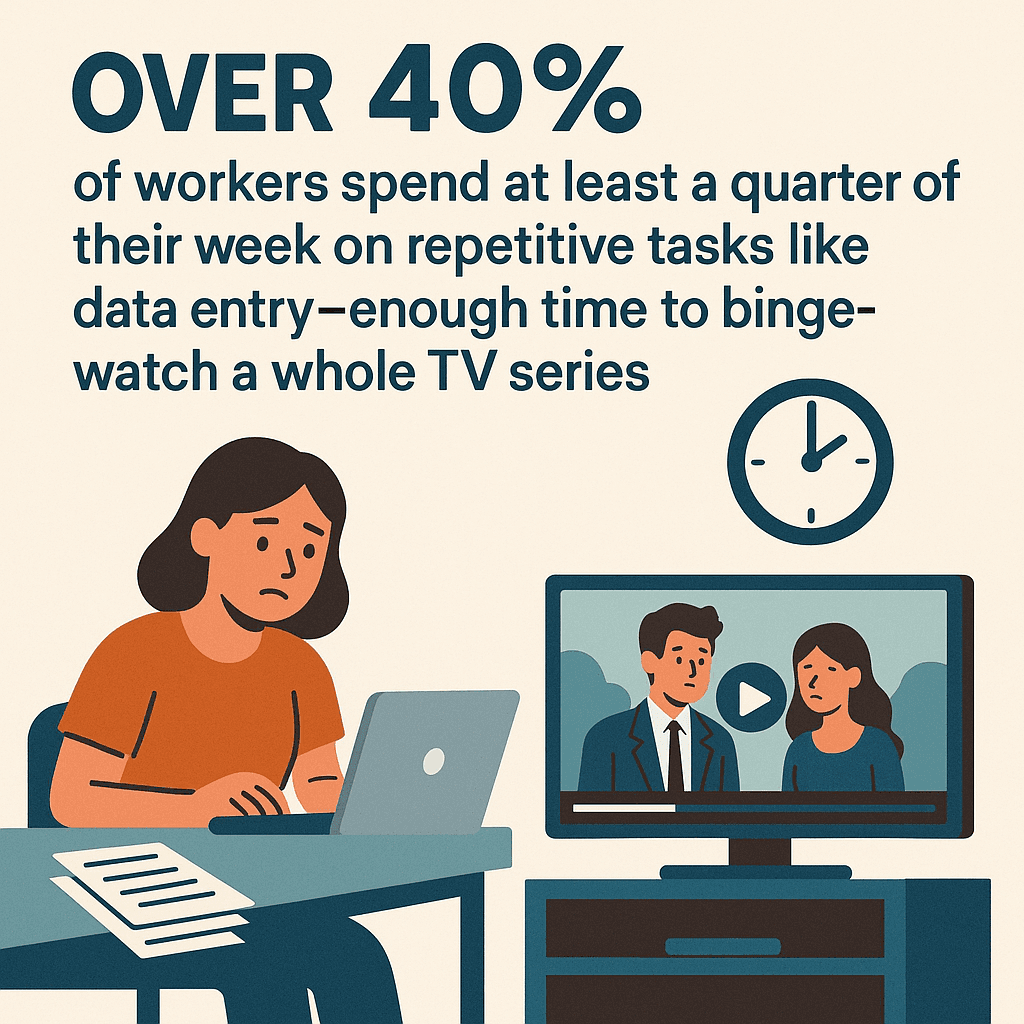

Wer kennt das nicht: Stundenlanges Copy-Paste von Daten, ewiges Gefummel mit Tabellen oder noch vor dem ersten Kaffee die aktuellen Preise der Konkurrenz zusammensuchen – du bist damit definitiv nicht allein. In der heutigen Business-Welt sind frische Daten Gold wert, aber manuelles Sammeln ist einfach nicht mehr zeitgemäß. Wusstest du, dass mindestens ein Viertel ihrer Arbeitszeit mit immer gleichen Aufgaben wie Dateneingabe verbringen? Das reicht locker für eine ganze Netflix-Serie (frag lieber nicht, woher ich das weiß). Kleine Unternehmen verlieren im Schnitt 96 Minuten Produktivität pro Tag durch umständliche Prozesse – das sind hochgerechnet drei Wochen im Jahr, die einfach verpuffen ().

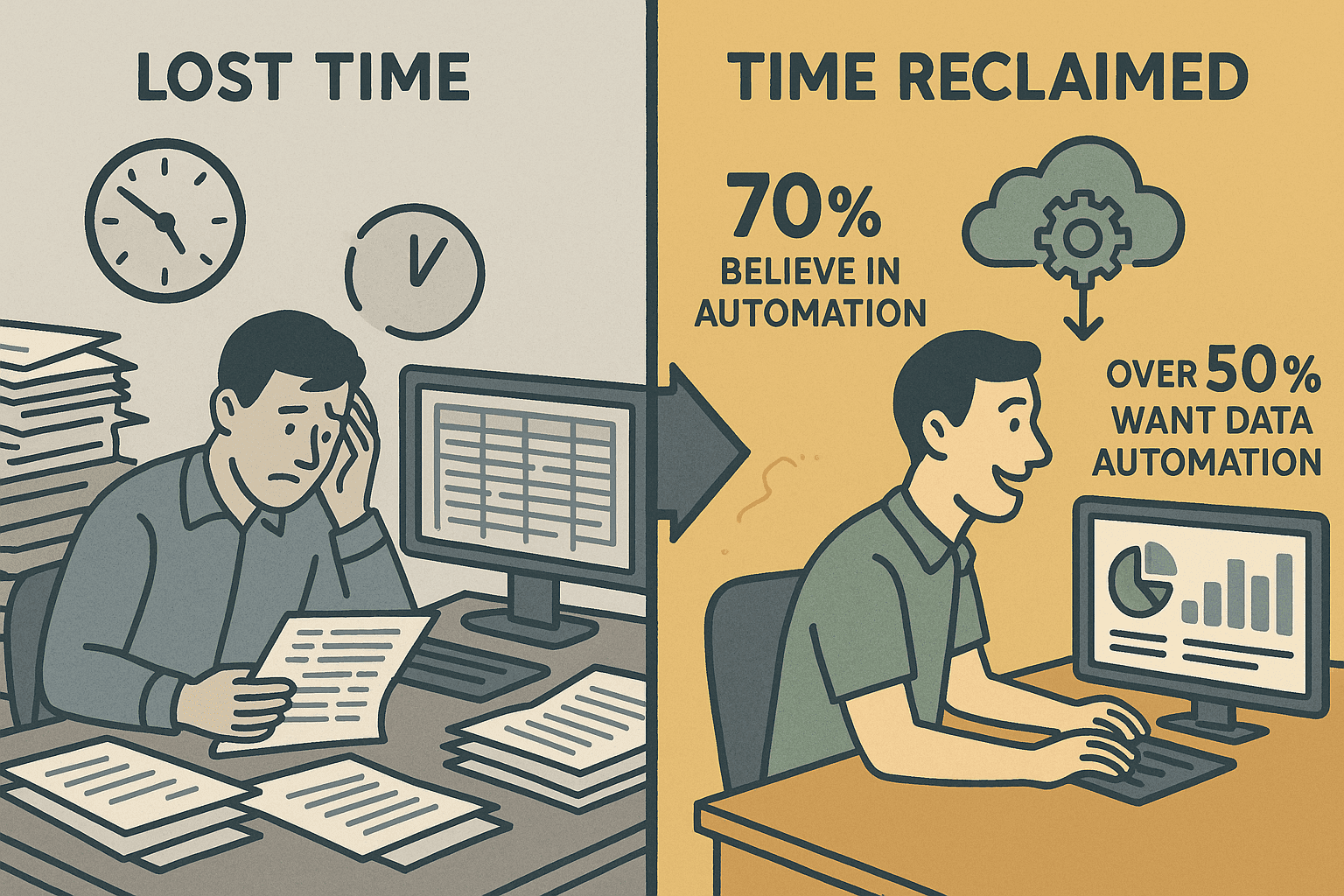

Die gute Nachricht: Fast 70 % der Beschäftigten sind überzeugt, dass Automatisierung der Schlüssel ist, um diese Zeit zurückzugewinnen – und mehr als die Hälfte will vor allem die Datenerfassung automatisieren. Genau hier kommen automatisierte Web-Scraper wie ins Spiel. Aus meiner Erfahrung im SaaS- und Automatisierungsbereich weiß ich: Mit den richtigen Tools wird aus Datenchaos echter Mehrwert fürs Business. Lass uns anschauen, wie du automatisiertes Data Scraping meisterst, dein Team entlastest und Copy-Paste endgültig in Rente schickst.

Was ist automatisiertes Data Scraping? So nutzt du die Power der Automatisierung

Automatisiertes Data Scraping heißt: Eine Software (oft mit KI-Power) sammelt für dich Infos aus Webseiten, PDFs, Bildern oder anderen digitalen Quellen und verwandelt sie in strukturierte Daten – zum Beispiel in Tabellen, Datenbanken oder Google Sheets (). Stell dir vor, ein digitaler Assistent durchforstet das Netz, sammelt gezielt Namen, Preise, E-Mails und sortiert alles schön ordentlich – keine Handarbeit, keine Tippfehler, keine Nachtschichten mehr.

Was ist der Unterschied zu klassischem Scraping oder manueller Sammlung? Manuelles Datensammeln ist langsam, fehleranfällig und kaum skalierbar. Klassisches Web Scraping (z. B. mit Python-Skripten oder Browser-Automation) ist zwar schneller, braucht aber technisches Know-how und ständige Pflege – schon kleine Website-Änderungen können alles lahmlegen (). Automatisiertes Data Scraping mit KI versteht dagegen den Seiteninhalt im Kontext, passt sich an und du kannst einfach in Alltagssprache beschreiben, was du brauchst.

Was kann man alles scrapen? Praktisch alles, was du auf einer Webseite oder in einem Dokument siehst: Texte, Zahlen, Daten, URLs, E-Mails, Telefonnummern, Bilder und mehr. Moderne Tools wie Thunderbit verarbeiten sogar PDFs und Bilder per OCR – du bist also nicht auf Webseiten beschränkt.

Warum automatisiertes Data Scraping für Unternehmen ein Gamechanger ist

Kurz gesagt: Automatisiertes Data Scraping bringt dir vor allem drei Dinge – Zeitersparnis, Genauigkeit und bessere Insights.

- Zeitersparnis: Vertriebsteams sparen sich tagelange Recherche und erledigen Aufgaben in Minuten (). Operations-Teams können Dutzende Lieferanten oder Produkte easy überwachen.

- Genauigkeit & Konsistenz: Automatisierung verhindert Tippfehler und sorgt dafür, dass Daten exakt übernommen werden. Keine „Ups, falscher Preis“-Momente mehr.

- Aktuelle Einblicke: In dynamischen Märkten sind gestrige Daten schon alt. Automatisiertes Scraping liefert dir Infos in Echtzeit, damit du schnell reagieren kannst.

Hier siehst du, wie verschiedene Teams profitieren:

| Hauptvorteil | Vertrieb/Marketing | Operations/Forschung |

|---|---|---|

| Zeitersparnis | Mehr Zeit für Kundenkontakte, schnellere Kampagnenstarts | Regelmäßige Checks (Preise, Lagerbestand) laufen automatisch, mehr Zeit für Analysen |

| Genauigkeit | Saubere Daten sorgen für gezielte Ansprache und passgenaue Kampagnen | Weniger Fehler in Berichten, verlässliche Preis- und Bestandsdaten |

| Aktuelle Einblicke | Vertriebsinformationen sind immer aktuell, Aktionen perfekt getimt | Operations kann sofort auf Marktveränderungen reagieren |

| Skalierbarkeit | Ein Marketer kann Tausende Leads generieren, nicht nur eine Handvoll | Forschung lässt sich beliebig skalieren – 100 Produkte überwachen ist so einfach wie eines |

| Kosteneffizienz | Geringere Personalkosten, schneller am Markt, keine teuren Datenanbieter nötig | Spart Entwicklerressourcen, wenig Wartung, günstiger als Eigenentwicklungen |

Typische Anwendungsfälle:

- Lead-Generierung: Geschäftsdatenbanken in Minuten für Kontaktlisten durchforsten.

- Preisüberwachung: Tägliche Preisupdates der Konkurrenz automatisch erfassen.

- Review-Tracking: Neue Bewertungen oder Ratings für deine Marke im Blick behalten.

- Marktforschung: News, Social Media oder Wettbewerberdaten bündeln und auswerten.

Automatisierte Data Scraping-Lösungen im Vergleich: Thunderbit vs. klassische Tools

Es gibt viele Wege, Data Scraping zu automatisieren – aber nicht alle sind gleich entspannt. Hier der direkte Vergleich:

| Kriterium | Klassisches Scraping (Skripte/Manuell) | KI-Web-Scraping (Thunderbit) |

|---|---|---|

| Benutzerfreundlichkeit | Programmierkenntnisse und komplexe Einrichtung nötig | No-Code, natürliche Sprache, einfaches Point-and-Click (Thunderbit Blog) |

| Einrichtungsdauer | Stunden oder Tage für Skripte und Debugging | In wenigen Minuten startklar, KI schlägt Felder vor |

| Anpassungsfähigkeit | Bricht bei Layout-Änderungen schnell zusammen | KI versteht Inhalte kontextuell und passt sich an |

| Wartungsaufwand | Hoher Aufwand, Skripte müssen oft angepasst werden | Geringer Aufwand, KI und Vorlagen übernehmen die Anpassung |

| Technisches Know-how | Programmierkenntnisse erforderlich | Keine Technikkenntnisse nötig, für Business-Anwender gemacht |

| Genauigkeit | Ergebnisse müssen oft nachbearbeitet werden | Saubere, strukturierte Daten direkt als Output |

| Integration | CSV/JSON-Export, Integrationen erfordern Zusatzaufwand | Ein-Klick-Export zu Excel, Google Sheets, Notion, Airtable usw. |

| Skalierbarkeit | Komplex, erfordert Proxies und Parallelisierung | Skaliert für Business-Bedarf, Cloud-Modus verarbeitet 50 Seiten gleichzeitig |

| Kosten | Open Source „gratis“, aber hoher Zeitaufwand; Enterprise-Lösungen teuer | Freemium mit günstigen Tarifen, kostenlose Exportfunktionen |

Thunderbits große Stärke: KI-gestützte Felderkennung und die superleichte Chrome-Erweiterung. Das Tool ist für alle gemacht, die einfach Ergebnisse wollen – ohne Programmieren, ohne Stress.

So easy läuft automatisiertes Data Scraping mit Thunderbit: KI-Feldvorschläge & Zwei-Schritt-Workflow

Hier zeigt Thunderbit, was es kann. Der Ablauf ist so simpel, dass sogar deine Oma damit ihre Bingo-Gewinne verwalten könnte.

Schritt 1: Mit KI-Feldvorschlägen die Datenstruktur festlegen

Öffne Thunderbit auf der gewünschten Webseite und klick auf „KI-Feldvorschläge“. Die KI analysiert die Seite und schlägt dir passende Spaltennamen und Datentypen vor – wie „Produktname“, „Preis“, „Bewertung“ oder „Kontakt-E-Mail“. Du kannst Felder anpassen, umbenennen, löschen oder neue hinzufügen. Kein Rätselraten mehr, keine komplizierten Selektoren – die KI macht den Job.

Gerade für alle ohne Programmierkenntnisse ist das ein echter Gamechanger. Es ist, als hättest du einen schlauen Assistenten, der sofort sagt: „Das kannst du von dieser Seite holen – willst du noch was ergänzen?“

Schritt 2: Mit einem Klick Daten extrahieren und exportieren

Sind die Felder festgelegt, klickst du einfach auf „Scrapen“. Thunderbit sammelt die Daten, erkennt automatisch mehrere Seiten (Paginierung) und zeigt alles übersichtlich in einer Tabelle. Danach kannst du direkt exportieren nach:

- Excel oder CSV

- Google Sheets

- Airtable

- Notion

- JSON

Alle Exporte sind kostenlos und direkt integriert – keine versteckten Kosten, keine Umwege.

Tipp: Thunderbit kann sogar Bilder direkt in Notion oder Airtable hochladen – du bekommst also nicht nur den Link, sondern das Originalbild.

Automatisierte Data Scraping-Aufgaben einrichten und Daten aktuell halten mit Thunderbit

Du willst deine Daten immer aktuell, ohne ständig selbst nachzuschauen? Dann ist Thunderbits Geplanter Scraper genau das Richtige.

So funktioniert die Terminierung

- Intervall festlegen: Einfach „jeden Tag um 8 Uhr“ oder „montags um 18 Uhr“ eingeben – Thunderbits KI versteht ganz normale Sprache.

- URLs einfügen: Trag die Seiten ein, die du überwachen willst (egal ob 10 oder 100).

- KI füllt Felder automatisch aus: Thunderbit nutzt deine Felder oder schlägt neue vor.

- Paralleles Scraping: Im Cloud-Modus werden bis zu 50 Seiten gleichzeitig verarbeitet.

- Automatischer Export: Ergebnisse landen direkt in deinem Lieblingstool (Sheets, Excel usw.).

Typische Anwendungsfälle:

- Tägliche Preisüberwachung

- Wöchentliche Review-Analysen

- Bestandsaktualisierungen

- Lead-Listen regelmäßig auffrischen

Tipps für Datenqualität und Aktualität

- Passende Frequenz wählen: Nicht zu oft scrapen – Intervall an die Datenaktualisierung anpassen.

- Auf Änderungen achten: Bei Website-Redesigns „KI-Feldvorschläge“ erneut ausführen.

- Benachrichtigungen nutzen: Mit Google Sheets-Skripten oder Integrationen kannst du dich bei Auffälligkeiten benachrichtigen lassen.

- Daten regelmäßig prüfen: Kontrolliere stichprobenartig die Ergebnisse.

- Login-geschützte Seiten: Nutze den Browser-Modus für Seiten mit Zugangsbeschränkung.

Datenqualität steigern: Ergebnisse mit Thunderbits KI-Prompt individuell anpassen

Mit Thunderbits Feld-KI-Prompt kannst du schon beim Scraping festlegen, wie Daten extrahiert und formatiert werden.

Was ist mit KI-Prompts möglich?

- Daten bereinigen/formatieren: Währungssymbole entfernen, Datumsformate vereinheitlichen, nur Zahlen ausgeben.

- Kategorisieren/Taggen: Produkte nach Kategorie kennzeichnen, Sonderangebote markieren, Stimmungsanalyse bei Bewertungen.

- Daten anreichern: Firmenbeschreibungen zusammenfassen, Leads bewerten, Texte übersetzen.

- Bedingte Logik: „N/A“ ausgeben, wenn ein Feld fehlt, oder eigene Regeln anwenden.

Beispiel: Du scrapest Preise der Konkurrenz? Füge einen Prompt hinzu, der nur den Zahlenwert ausgibt und Produkte im Angebot markiert. Bei Bewertungen kannst du automatisch „Positiv“, „Negativ“ oder „Neutral“ zuordnen lassen.

Das Beste: Diese Anpassungen passieren direkt beim Scraping – deine exportierten Daten sind sofort einsatzbereit.

Praxisbeispiel: Datenqualität und Nutzbarkeit mit Thunderbit verbessern

Angenommen, du bist E-Commerce-Manager und überwachst täglich 50 Produkte der Konkurrenz. So easy geht’s mit Thunderbit:

- Einrichten: Produktseite öffnen, auf „KI-Feldvorschläge“ klicken und Spalten wie Produktname, Preis, Verfügbarkeit übernehmen.

- Anpassen: Ein Feld „Im Angebot“ hinzufügen mit dem Prompt: „Gib ‚Ja‘ aus, wenn ein Rabatt angezeigt wird, sonst ‚Nein‘.“ Das Preisfeld so bearbeiten, dass nur Zahlen ausgegeben werden.

- Bulk-URLs: Alle 50 Produkt-URLs in den Scheduler einfügen und auf täglich 8 Uhr stellen.

- Export: Die Daten landen in Google Sheets – jede Zeile zeigt den aktuellen Preis, Lagerstatus und Angebots-Flag.

- Analysieren: Preisentwicklungen visualisieren, Preisalarm einrichten und schneller reagieren als die Konkurrenz.

Keine manuellen Kontrollen mehr, keine unübersichtlichen Daten – sondern täglich verwertbare Insights.

Thunderbit mit Google Sheets, Notion & Co. verbinden – für reibungslose Analyse

Dank direkter Exporte landen deine Daten nahtlos in den Tools, die dein Team sowieso nutzt:

- Google Sheets: Live-Dashboards, Formeln und Teamarbeit. Automatisiere Benachrichtigungen oder Folgeaktionen.

- Notion: Erstelle eine Wissensdatenbank oder einen Marktmonitor – inklusive Bildern und strukturierter Daten.

- Airtable: Verknüpfe gescrapte Daten mit anderen Tabellen, automatisiere Prozesse oder erstelle eigene Ansichten.

- Excel/CSV/JSON: Für Offline-Analysen, Datenbankimporte oder individuelle Workflows.

So wird Thunderbit zum Herzstück deines datengetriebenen Workflows – Schluss mit E-Mail-Anhängen und CSV-Chaos.

Durch die nahtlose Integration mit Google Sheets, Notion und Airtable kannst du deine komplette Datenpipeline automatisieren – von der Erfassung bis zur Analyse, ohne dein Lieblingstool zu verlassen.

Schritt-für-Schritt-Anleitung: So meisterst du automatisiertes Data Scraping mit Thunderbit

Hier deine Schnellstart-Checkliste:

- Ziel definieren: Welche Daten brauchst du, von wo und wie oft?

- Thunderbit installieren: und kostenlos registrieren.

- Zielseite öffnen: Thunderbit-Icon anklicken.

- KI-Feldvorschläge nutzen: Spaltenvorschläge übernehmen oder anpassen.

- (Optional) KI-Prompts hinzufügen: Felder für Formatierung, Kategorisierung oder Anreicherung anpassen.

- Testlauf: Vorschau starten, Ergebnisse prüfen, ggf. nachjustieren.

- Bulk-/geplantes Scraping: Mehrere URLs einfügen oder einen Zeitplan für wiederkehrende Aufgaben festlegen.

- Exportieren: Daten an Sheets, Notion, Airtable, Excel senden oder als CSV/JSON herunterladen.

- Analysieren & teilen: Mit deinen Tools Insights gewinnen und weitergeben.

- Pflegen: Ergebnisse stichprobenartig prüfen, bei Website-Änderungen KI-Vorschläge neu ausführen und Workflow aktuell halten.

Tipps zur Fehlerbehebung:

- Wenn Daten nicht stimmen, „KI-Feldvorschläge“ erneut ausführen oder KI-Prompts anpassen.

- Für Login-Seiten den Browser-Modus nutzen.

- Bei großen oder häufigen Scrapes auf Thunderbit-Guthaben achten.

Mehr Infos findest du in den oder auf unserem .

Fazit & wichtigste Erkenntnisse: So wirst du zum Data Scraping-Profi

Automatisiertes Data Scraping ist längst nicht mehr nur was für Entwickler – es ist ein Muss für jedes Team, das effizient und datengetrieben arbeiten will. Mit Thunderbit profitierst du von:

- Einfache Bedienung: Kein Code, keine komplizierte Einrichtung – einfach klicken, scrapen, exportieren.

- Tempo: Von der Idee zur fertigen Datentabelle in wenigen Minuten.

- Genauigkeit: Saubere, strukturierte und verlässliche Daten.

- Flexibilität: Komplexe Aufgaben mit KI-Prompts und Subseiten-Scraping meistern.

- Integration: Daten landen direkt in Sheets, Notion, Airtable oder Excel.

- Wenig Wartung: Die KI passt sich an Website-Änderungen an – keine kaputten Skripte mehr.

Bereit, manuelle Datenerfassung hinter dir zu lassen? und erlebe, wie einfach automatisiertes Data Scraping sein kann. Deine Tabellen – und deine Nerven – werden es dir danken.

Noch mehr Tipps, Praxisbeispiele und Deep Dives findest du im .

Häufige Fragen (FAQ)

1. Was ist automatisiertes Data Scraping und wie unterscheidet es sich vom klassischen Scraping?

Automatisiertes Data Scraping nutzt KI-gestützte Tools, um Daten aus Webseiten, PDFs und Bildern zu extrahieren – ganz ohne Programmierung oder aufwendige Einrichtung. Im Gegensatz zu klassischen Methoden mit Skripten und technischem Know-how kannst du bei Lösungen wie Thunderbit einfach in Alltagssprache beschreiben, was du brauchst, und die KI passt sich automatisch an Änderungen an.

2. Wer profitiert von automatisiertem Data Scraping?

Vertrieb, Marketing, Operations, E-Commerce, Immobilien und Forschung – kurz: alle, die strukturierte Webdaten schneller und präziser als per Hand brauchen.

3. Wie sorgt Thunderbit für Datenqualität und Genauigkeit?

Thunderbits KI-Feldvorschläge und Feld-KI-Prompts stellen sicher, dass du die richtigen Daten im passenden Format extrahierst. Du kannst Felder individuell anpassen, kategorisieren oder bereinigen – so sind deine Exporte direkt analysierbar und müssen kaum nachbearbeitet werden.

4. Kann ich mit Thunderbit wiederkehrende Scraping-Aufgaben planen?

Klar! Mit dem Geplanten Scraper von Thunderbit richtest du automatisierte Aufgaben (täglich, wöchentlich usw.) ein, um deine Daten immer aktuell zu halten – ideal für Preisüberwachung, Review-Tracking oder Bestandsupdates.

5. In welche Plattformen kann ich Thunderbit-Daten exportieren?

Thunderbit unterstützt den direkten Export zu Excel, Google Sheets, Notion, Airtable, CSV und JSON. So lassen sich gescrapte Daten easy in bestehende Workflows und Analysetools integrieren.

Bereit für automatisierte Datenerfassung? und erlebe die Zukunft des Web-Scrapings schon heute.