網路上資料多到爆炸,到了 2025 年,大家都知道,誰能最快、最有效率地拿到關鍵資訊,誰就能在市場上搶得先機。不管你是做銷售、電商、營運還是市場調查,能夠大規模、隨時隨地擷取網站資料,已經是企業競爭的秘密武器。Python 會這麼受歡迎,就是因為它有超多強大的函式庫,功能又齊全又好上手,根據 都用它來抓網頁資料。

不過,現在有個新趨勢:雖然 Python 是抓網站資料的萬用工具,但像 這種零程式碼工具也越來越夯,讓完全不會寫程式的人也能輕鬆抓、清理、整理網頁資料。這篇文章會帶你一次看懂兩種世界:經典 Python 工具(Requests、Beautiful Soup、Selenium、Scrapy、Pandas),還有 Thunderbit 怎麼幫你效率大提升。我會分享實用程式碼、商業應用場景,還有一些實戰經驗。準備好了嗎?我們開始吧!

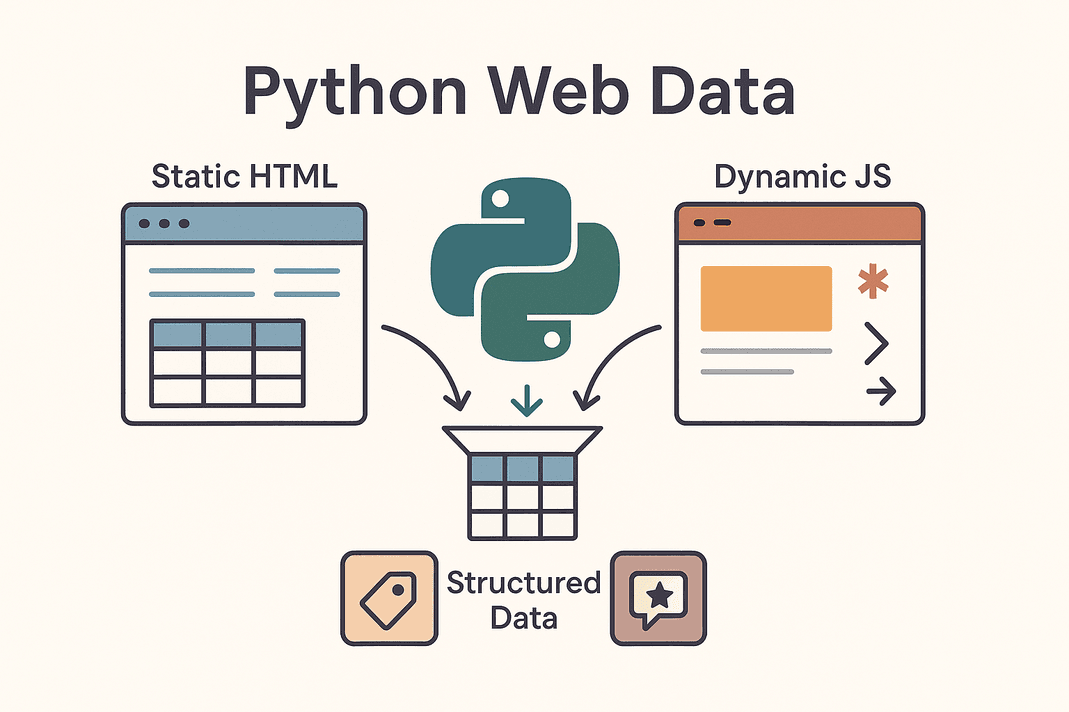

「Python 從網站抓取資料」到底是什麼?

簡單說,「python pull data from website」就是用 Python 腳本自動從網頁抓資料,把亂七八糟的 HTML 變成乾淨、結構化的資訊。這就是所謂的網頁爬蟲。你不用再一個一個複製貼上商品價格、聯絡方式或評論,Python 會自動幫你搞定。

簡單說,「python pull data from website」就是用 Python 腳本自動從網頁抓資料,把亂七八糟的 HTML 變成乾淨、結構化的資訊。這就是所謂的網頁爬蟲。你不用再一個一個複製貼上商品價格、聯絡方式或評論,Python 會自動幫你搞定。

你會遇到兩種網站:

- 靜態網站: 所有內容都直接寫在 HTML 裡,從「檢視原始碼」看到的就是全部。這種網站超好抓,只要下載 HTML 再解析就行。

- 動態網站: 內容是靠 JavaScript 在頁面載入後才顯示,像是無限捲動、即時價格更新,或是點按鈕才出現的內容。這種網站要用進階工具,例如 Selenium 模擬瀏覽器,或找出網站背後的 API()。

常見的爬取目標有商品資訊表格、潛在客戶名單、價格、評論、圖片等等。不管你是要建立名單、追蹤競爭對手價格,還是收集市場聲量,Python 都能讓網路變成你的專屬資料庫。

為什麼企業都愛用 Python 擷取網站資料?

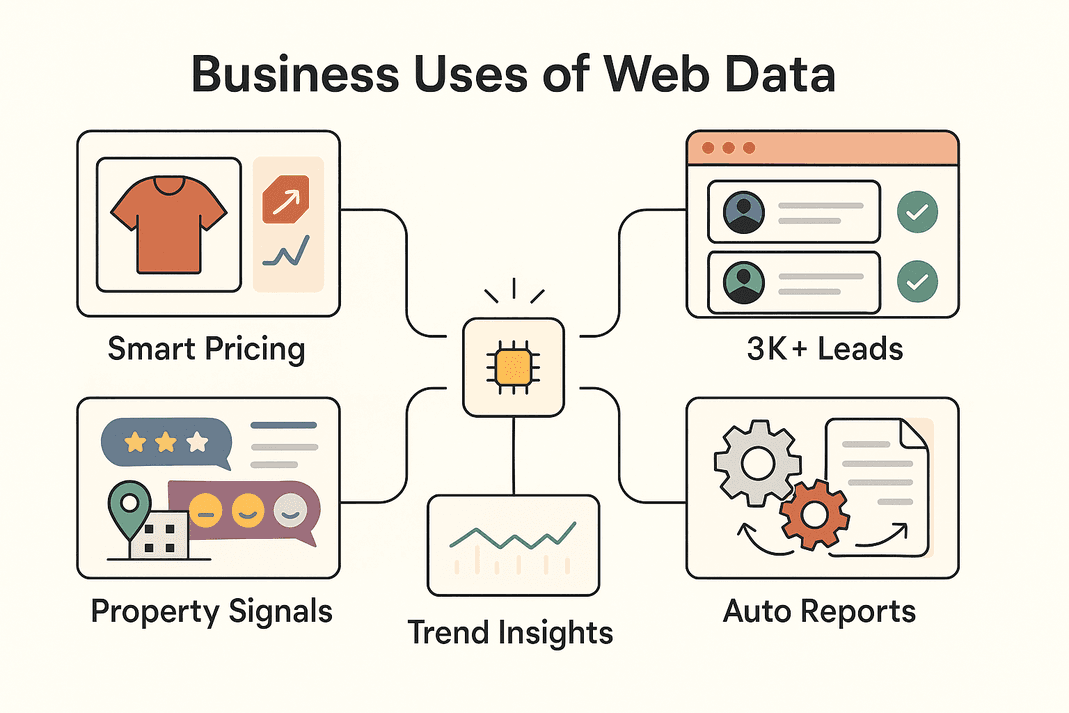

實際來看,為什麼這麼多企業都在用網頁資料擷取?下面這些應用場景和帶來的商業價值,絕對讓你心動:

| 商業應用場景 | 擷取資料內容 | 效益 / 投資報酬 |

|---|---|---|

| 潛在客戶開發(銷售) | 目錄、社群網站上的聯絡資訊 | 每月 3,000+ 筆名單,每位業務每週省下約 8 小時 (Thunderbit)) |

| 價格監控(電商) | 商品價格、庫存狀態 | 銷售提升約 4%,分析師工時減少 30% (blog.apify.com) |

| 市場調查 | 評論、社群貼文、論壇留言 | 精準行銷定位;26% 的爬蟲專注於社群資料 (Thunderbit) |

| 房地產資訊 | 物件資料、行情、地點統計 | 更快找到交易機會,行情即時更新 |

| 營運自動化 | 庫存、報表、重複性資料 | 手動作業時間減少 10–50% |

總結來說,不管你用 Python 還是 Thunderbit,網頁資料擷取都能讓團隊更快行動、做出更聰明的決策,還能自動化原本超花時間的重複工作。難怪 ,而且還在狂飆。

Python 網頁資料擷取必備工具

Python 會紅,就是因為它的工具生態系超強。下面這些是最常用的工具,還有適合的情境:

| 工具 | 最適合用途 | 優點 | 缺點 |

|---|---|---|---|

| Requests | 抓取靜態 HTML 或 API | 簡單快速,新手友善 | 無法處理 JavaScript |

| Beautiful Soup | 解析 HTML/XML 結構化資料 | 易用、彈性高 | 需先取得 HTML,不適合 JS 網站 |

| Selenium | 動態/JS 網站、登入、點擊 | 能處理瀏覽器能做的事 | 速度較慢、設定較繁重 |

| Scrapy | 大規模、多頁面爬取 | 非同步、快速、可擴展 | 學習曲線較高,預設不支援 JS |

| Thunderbit | 零程式碼/低程式碼、商業用戶 | AI 驅動、支援 JS、匯出方便 | 深度邏輯自訂性較低 |

實務上,最常見的組合是:簡單任務用 Requests + Beautiful Soup,遇到動態網站用 Selenium,大規模爬取用 Scrapy,想要快速又簡單就用 Thunderbit。

步驟一:用 Python Requests 抓網頁資料

先從最基本的開始。Requests 是 Python 抓網頁的主力工具。用法超簡單:

-

安裝 Requests:

1pip install requests -

抓取網頁:

1import requests 2url = "https://example.com/products" 3response = requests.get(url) 4if response.status_code == 200: 5 html_content = response.text 6else: 7 print(f"Failed to retrieve data: {response.status_code}")()

-

常見問題排解:

- 加入 headers 模擬瀏覽器:

1headers = {"User-Agent": "Mozilla/5.0"} 2response = requests.get(url, headers=headers) - 用

response.raise_for_status()處理錯誤 - 如果 API 回傳 JSON:

data = response.json()

- 加入 headers 模擬瀏覽器:

Requests 適合靜態頁面或 API。如果你發現資料抓不到,通常是 JavaScript 動態載入,這時就要用 Selenium。

步驟二:用 Beautiful Soup 解析網頁內容

抓到 HTML 後,Beautiful Soup 幫你把重點資料撈出來。步驟如下:

-

安裝 Beautiful Soup:

1pip install beautifulsoup4 -

解析 HTML:

1from bs4 import BeautifulSoup 2soup = BeautifulSoup(html_content, 'html.parser') -

提取資料:

- 找出所有商品卡片:

1for product in soup.select('div.product-card'): 2 name = product.select_one('.product-name').text.strip() 3 price = product.select_one('.product-price').text.strip() 4 print(name, price) - 解析表格:

1for row in soup.find_all('tr'): 2 cells = row.find_all('td') 3 # 依需求提取欄位資料

- 找出所有商品卡片:

小技巧:

- 用瀏覽器開發者工具找對的選擇器。

- 用

.get_text()或.text取得文字。 - 資料可能缺漏時要加判斷(像

if price_elem else "N/A")。

Requests + Beautiful Soup 是靜態網站爬蟲的黃金組合,簡單又穩定。

步驟三:用 Selenium 處理動態內容

遇到 JavaScript 動態載入的網站,就要用能模擬真實用戶操作的工具——Selenium。

-

安裝 Selenium:

1pip install selenium下載對應的瀏覽器驅動(像 ChromeDriver),並設定好路徑。

-

自動化瀏覽器操作:

1from selenium import webdriver 2driver = webdriver.Chrome() 3driver.get("https://example.com/products") 4products = driver.find_elements_by_class_name("product-card") 5for prod in products: 6 print(prod.text) 7driver.quit() -

處理登入與點擊:

1driver.get("https://site.com/login") 2driver.find_element_by_name("username").send_keys("myuser") 3driver.find_element_by_name("password").send_keys("mypassword") 4driver.find_element_by_id("login-button").click() -

等待動態內容載入:

1from selenium.webdriver.common.by import By 2from selenium.webdriver.support.ui import WebDriverWait 3from selenium.webdriver.support import expected_conditions as EC 4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.CLASS_NAME, "data-row"))) -

無頭模式(不開視窗):

1options = webdriver.ChromeOptions() 2options.add_argument("--headless") 3driver = webdriver.Chrome(options=options)

Selenium 功能超強,但比較重,適合一定要模擬瀏覽器操作的網站。

步驟四:用 Scrapy 大規模抓取資料

如果你要爬數百、數千頁,Scrapy 就是你的好夥伴。

-

安裝 Scrapy:

1pip install scrapy 2scrapy startproject myproject -

建立爬蟲:

1import scrapy 2class ProductsSpider(scrapy.Spider): 3 name = "products" 4 start_urls = ["https://example.com/category?page=1"] 5 def parse(self, response): 6 for product in response.css("div.product-card"): 7 yield { 8 'name': product.css(".product-title::text").get().strip(), 9 'price': product.css(".price::text").get().strip(), 10 } 11 next_page = response.css("a.next-page::attr(href)").get() 12 if next_page: 13 yield response.follow(next_page, self.parse) -

執行爬蟲:

1scrapy crawl products -o products.csv

Scrapy 支援非同步、速度快,適合全站爬取或複雜分頁。

步驟五:用 Thunderbit 強化資料擷取效率

接下來介紹 ,這款零程式碼人工智慧網頁爬蟲,讓商業用戶也能輕鬆上手。

- AI 智能欄位建議: Thunderbit 會自動分析頁面,推薦最適合擷取的欄位,完全不用自己找 HTML。

- 支援動態頁面: Thunderbit 看到的內容跟你一樣,JavaScript、無限捲動、登入頁都能搞定。

- 子頁面爬取: 可以自動點每個項目的詳細頁,資料更完整。

- 內建範本: Amazon、Zillow、Shopify 等熱門網站有現成範本,直接套用超方便。

- 一鍵提取器: 想抓頁面上的所有 Email 或電話?Thunderbit 一鍵就搞定。

- 排程與雲端爬取: 支援自然語言排程(像「每週一上午 9 點」),雲端同時處理最多 50 頁。

- 多元匯出: 資料可即時匯出到 Excel、Google Sheets、Airtable、Notion,或下載成 CSV/JSON,完全免費無限制。

Thunderbit 超適合需要快速取得資料、又不想寫程式的團隊。你甚至可以用 Thunderbit 抓資料,再用 Python 分析,兩者搭配效果更強。

步驟六:用 Pandas 清理與分析擷取資料

不管你是用 Python 還是 Thunderbit 抓到資料,接下來就用 Pandas 來清理和分析。

-

載入資料:

1import pandas as pd 2df = pd.read_csv("products.csv") 3print(df.head()) -

清理資料:

- 移除重複值:

1df = df.drop_duplicates() - 處理缺漏值:

1df = df.fillna("N/A") - 格式標準化(像價格):

1df['price'] = df['price'].str.replace('$','').str.replace(',','').astype(float)

- 移除重複值:

-

分析資料:

- 查看統計數據:

1print(df.describe()) - 依類別分組:

1avg_price = df.groupby('category')['price'].mean() 2print(avg_price)

- 查看統計數據:

Pandas 是把雜亂網頁資料變成商業洞察的萬用工具。

步驟七:組織與儲存擷取資料,方便團隊應用

資料清理好後,接下來就是讓團隊能方便使用。

- CSV/Excel: 用

df.to_csv("out.csv", index=False)或df.to_excel("out.xlsx")超方便分享。 - Google Sheets: 可以用 或 Python 的

gspread套件。 - 資料庫: 大型資料可用

df.to_sql()存進 SQL 資料庫。 - 自動化: 設定腳本或 Thunderbit 排程,讓資料自動更新。

- 最佳實踐: 記得加上時間戳記、欄位說明,敏感資料要控管權限。

重點是根據團隊需求選擇儲存方式——小型專案用試算表,大型專案用資料庫。

Thunderbit vs. Python 程式碼:哪種方式適合你的團隊?

來比較一下:

| 比較項目 | Thunderbit(零程式碼 AI) | Python 函式庫(程式碼) |

|---|---|---|

| 需要技能 | 無(瀏覽器介面) | 需會 Python 程式設計 |

| 設定時間 | 幾分鐘(AI 建議、即時爬取) | 幾小時到幾天(寫程式、除錯、設定) |

| 支援 JS/互動 | 有,內建(瀏覽器/雲端模式) | 有,但需用 Selenium/Playwright |

| 維護成本 | 低——AI 可自動適應網站變動 | 高——網站變動需手動修改程式 |

| 擴展性 | 中等(雲端可快速處理數十到數百頁) | 高(Scrapy 可大規模擴展) |

| 客製化 | 介面選項與 AI 提示 | 無限(可寫任何邏輯、整合) |

| 反爬蟲/代理 | 內建處理 | 需自行實作 |

| 資料匯出 | 一鍵匯出到 Sheets、Excel、Notion、Airtable | 需自訂程式 |

| 最適合 | 非技術用戶、追求快速成果、維護簡單 | 開發者、複雜或大規模專案 |

小建議: Thunderbit 適合快速取得成果、賦能商業團隊;Python 則適合需要高度自訂或大規模自動化的情境。很多團隊會兩者一起用——先用 Thunderbit 驗證、快速抓資料,再用 Python 自動化或擴展。

網頁資料擷取的實際商業應用

來看看各行業怎麼玩這些工具:

來看看各行業怎麼玩這些工具:

- 電商: John Lewis 。

- 銷售團隊: 每月自動抓 3,000+ 筆名單,每位業務每週省下 8 小時 ()),不用再人工搜尋。

- 市場調查: 行銷人員批次抓評論或社群貼文,做情緒分析,搶先掌握市場趨勢。

- 房地產: 經紀人自動抓物件資訊,快速發現低價物件或新商機,比等 MLS 更新還快。

- 營運自動化: 營運團隊自動化庫存檢查、報表產生,甚至抓合作夥伴或內部網站的 FAQ。

實務上,最常見流程是:Thunderbit 先抓資料,Python 清理分析,最後匯出到 Sheets 或資料庫給團隊用。

結論與重點整理

用 Python(和 Thunderbit)從網站抓資料,已經是現代企業團隊的必備技能。重點如下:

- Requests + Beautiful Soup: 靜態網站首選,快速又簡單。

- Selenium: 動態、JS 或需登入的網站。

- Scrapy: 大規模、多頁面爬取。

- Thunderbit: 零程式碼、AI 驅動,商業用戶快速上手。

- Pandas: 清理、分析、洞察資料。

- 聰明匯出: 用 CSV、Sheets 或資料庫,依團隊需求選擇。

最佳做法?根據你的技術能力和商業需求選擇工具,隨著需求成長靈活搭配。如果想體驗網頁爬蟲有多簡單,,或到 看更多教學。

祝你爬蟲順利,資料永遠乾淨、結構化、隨時可用!

常見問題

1. 用 Python 從網站抓資料最簡單的方法是什麼?

對於靜態網站,建議用 Requests 下載 HTML,再用 Beautiful Soup 解析並提取所需資料。動態網站則多半需要 Selenium。

2. 什麼情況下該用 Thunderbit 而不是 Python?

當你需要快速取得資料、不想寫程式,或要處理動態頁面、子頁面、即時匯出到 Sheets/Excel 時,Thunderbit 是最佳選擇。非常適合商業用戶或急件專案。

3. 如何處理用 JavaScript 載入資料的網站?

可以用 Selenium(或 Playwright)自動化瀏覽器,或直接用 Thunderbit 的瀏覽器/雲端模式,能自動處理 JS。

4. 擷取下來的資料怎麼清理與分析?

用 Pandas 匯入資料,去除重複、補齊缺漏、標準化格式,再用 groupby 或 describe 快速取得洞察。

5. 網頁爬蟲在商業上是否合法、安全?

一般來說,抓取公開資料是合法的,但一定要檢查網站的服務條款與 robots.txt。避免未經同意抓取個資,並尊重網站資源。Thunderbit 和 Python 都支援合規、道德的爬蟲實踐。

想提升你的資料力嗎? 或動手寫 Python,無論哪種方式,都能讓你快速取得有價值的網頁資料。

延伸閱讀