說真的,當我第一次自己寫出網頁爬蟲時,真的有種像是開啟新世界大門的感覺。以前那種為了找銷售名單或比價,得一行一行複製貼上的日子,瞬間就成為過去式。其實,學會用 Python 寫網頁爬蟲,對想把網路重複工作自動化的你來說,絕對是個重要的里程碑。尤其對商務工作者來說,這甚至能決定你週五晚上是在跟 Excel 奮戰,還是能準時下班去跟朋友聚餐。

這篇教學會帶你一步步用 Python 寫出自己的網頁爬蟲,還有實用的範例程式碼。最後,我也會介紹一個更簡單的選擇——直接用 ,兩下點擊就能搞定,完全不用寫程式。不管你是 Python 愛好者,還是只想輕鬆拿到資料,都能找到最適合你的方法。

Python 網頁爬蟲是什麼?快速入門

先來聊聊基本觀念。網頁爬蟲,其實就是一種自動化從網站收集資料的小幫手。你可以把它想像成一個永遠不會喊累的機器人,幫你做那些重複又無聊的複製貼上工作。

一個網頁爬蟲通常會做這幾件事:

- 連上網頁(就像你平常用瀏覽器一樣)

- 擷取你要的資料(像是商品名稱、價格、聯絡方式)

- 把資料整理成結構化格式(例如 Excel 表格或 JSON 檔)

Python 會成為主流語言,是因為它語法簡單、函式庫又多,根本就是程式界的瑞士刀。事實上,。

基本流程大致如下:

- 取得網頁內容(抓 HTML)

- 解析 HTML,找到你要的資料

- 把結果存到你想要的地方

就像做蛋糕:先備好食材(HTML),挑出精華(資料),最後端上桌(匯出)。

為什麼商務團隊需要網頁爬蟲?

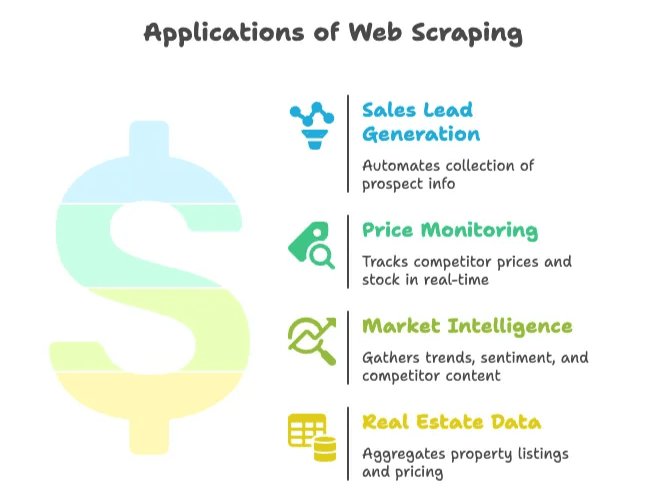

網頁爬蟲早就不是工程師的專利。現在,不管是銷售、行銷、電商、房仲,甚至任何需要即時網路資訊來決策的行業,都離不開網頁爬蟲。根據統計,,而且每年還以 28% 的速度成長。這代表有超大的商機和資料紅利。

來看看幾個實際商業應用:

| 應用場景 | 帶來效益 | 實際成果 |

|---|---|---|

| 銷售名單開發 | 自動收集潛在客戶資訊 | 每位業務每週省下約 8 小時,單月抓取 3,000 筆名單,3 個月業績成長 10 倍 |

| 價格監控 | 即時追蹤競品價格與庫存 | 資料收集時間減少 30%,聰明定價帶動銷售提升 4% |

| 市場情報 | 分析趨勢、情緒與競品內容 | 超過 70% 企業仰賴網頁爬蟲取得市場情報 |

| 房地產資料 | 整合多站房源與價格資訊 | 公司透過爬取 Zillow/Trulia,搶先掌握在地市場變化 |

一句話總結:網頁爬蟲能大幅節省時間、減少人工作業,還能讓你領先競爭對手。如果你還在手動複製貼上,競爭者可能早就用自動化超車你了。

寫網頁爬蟲前的準備:工具與基礎技能

在開始寫程式之前,先來看看你需要準備哪些工具。

基本配備

- 安裝 Python: 下載最新版(),並確保終端機能執行

python。 - 程式編輯器: VS Code、PyCharm 或 Notepad++ 都可以。我自己最愛 VS Code,因為對 Python 支援超友善。

- 虛擬環境: 雖然不是必備,但強烈建議用

python -m venv venv建立虛擬環境,管理套件更方便。

重要 Python 套件

- Requests: 用來抓網頁內容()。

- BeautifulSoup: 解析 HTML、搜尋標籤()。

- Selenium: 處理 JavaScript 動態載入的網站()。

安裝指令:

1pip install requests beautifulsoup4 lxml selenium基本 HTML 概念

不用變成網頁工程師,但要會用瀏覽器的「檢查元素」功能。右鍵點網頁,選「檢查」,就能看到 DOM 結構。這裡就是你要找的標籤和 class 名稱()。

手把手教學:用 Python 寫出你的第一個網頁爬蟲

現在來實作一個簡單的網頁爬蟲。這裡以抓取商品列表或新聞標題為例,你也可以依照需求調整。

建立 Python 專案環境

先建立資料夾並啟動虛擬環境:

1mkdir my-scraper

2cd my-scraper

3python -m venv venv

4# 啟動虛擬環境:

5# Windows:

6venv\Scripts\activate

7# macOS/Linux:

8source venv/bin/activate安裝所需套件:

1pip install requests beautifulsoup4 lxml建立 scraper.py 檔案並打開編輯。

抓取並解析網頁內容

以 為例,先抓取 HTML:

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content

7else:

8 print(f"Request failed with status {response.status_code}")

9 exit()用 BeautifulSoup 解析 HTML:

1soup = BeautifulSoup(html_content, "html.parser")

2print(soup.title.string) # 應該會印出 "Hacker News"擷取你要的資料

假設你想抓所有新聞標題及連結。檢查網頁後會發現,每個標題都在 <a class="storylink"> 標籤內。

1stories = soup.find_all('a', class_='storylink')

2data = []

3for story in stories:

4 title = story.get_text()

5 link = story['href']

6 data.append({"title": title, "url": link})

7 print(title, "->", link)如果是抓商品資訊,則找 <div class="product-item">,並擷取裡面的欄位。範例如下:

1products = soup.find_all('div', class_='product-item')

2for prod in products:

3 name = prod.find('h2').get_text()

4 price = prod.find('span', class_='price').get_text()

5 url = prod.find('a')['href']

6 data.append({"name": name, "price": price, "url": url})將資料存成 CSV 或 JSON

最後,把資料匯出,方便後續分析。

匯出成 CSV:

1import csv

2with open("output.csv", mode="w", newline="", encoding="utf-8") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "URL"])

5 for item in data:

6 writer.writerow([item["title"], item["url"]])匯出成 JSON:

1import json

2with open("output.json", mode="w", encoding="utf-8") as f:

3 json.dump(data, f, indent=2)打開 Excel 或文字編輯器,你就能看到自動化產出的資料,省下大把手動整理的時間。

進階技巧:處理分頁與動態內容

現實中的網站通常不只一頁,這時就要用進階技巧。

分頁處理

如果網站用網址參數分頁(像 ?page=2),可以用迴圈自動抓多頁:

1base_url = "https://example.com/products?page="

2for page_num in range(1, 6):

3 url = base_url + str(page_num)

4 resp = requests.get(url)

5 if resp.status_code != 200:

6 break

7 soup = BeautifulSoup(resp.content, "html.parser")

8 # 繼續擷取資料()

如果是「下一頁」按鈕,則要找出連結並自動跳轉:

1url = "https://example.com/products"

2while url:

3 resp = requests.get(url)

4 soup = BeautifulSoup(resp.content, "html.parser")

5 # 擷取資料

6 next_link = soup.find('a', class_='next-page')

7 if next_link and 'href' in next_link.attrs:

8 url = "https://example.com" + next_link['href']

9 else:

10 url = None動態內容(JavaScript 載入)

如果資料不是直接在 HTML,而是由 JavaScript 動態載入,就要用 Selenium:

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/complex-page")

4driver.implicitly_wait(5)

5page_html = driver.page_source

6soup = BeautifulSoup(page_html, "html.parser")

7# 接下來照前面方式擷取資料()

Selenium 也能自動點擊「載入更多」或自動捲動頁面。但要注意,這種方式比單純用 Requests 慢很多,也比較吃資源。

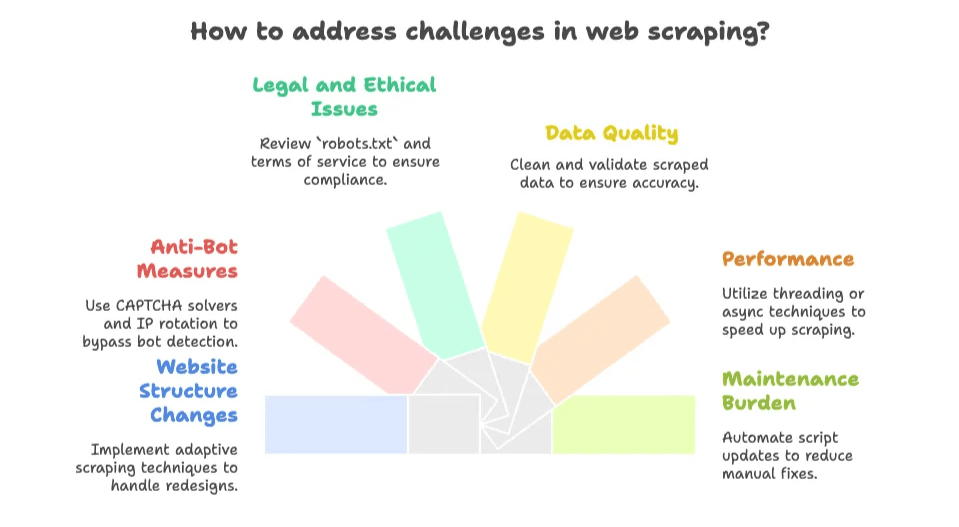

自己寫爬蟲常見的挑戰與陷阱

這裡才是真正的考驗。寫爬蟲很有成就感,但網站一改版,半夜腳本就壞掉,真的會讓人崩潰。常見問題包括:

- 網站結構變動: 網站改版或 class 名稱變了,爬蟲就失效。維護永遠是場持久戰()。

- 反爬蟲機制: CAPTCHA、流量限制、IP 封鎖到處都是。。

- 法律與道德問題: 一定要看清楚網站的

robots.txt和服務條款。公開資料通常沒問題,但不要抓取私人或有版權的內容()。 - 資料品質: 抓下來的資料可能很亂,要花時間清理。

- 效能問題: 抓大量頁面時,沒用多執行緒或非同步會很慢。

- 維護負擔: 每遇到新網站或網站改版,就要修腳本,永遠修不完。

如果你熱愛挑戰,這些問題也許很有趣。但如果你只想拿到資料,這些麻煩很快就會讓人想放棄。

更聰明的選擇:Thunderbit 等人工智慧網頁爬蟲工具

這時候,就輪到 Thunderbit 登場了(腦中自帶閃電棒球帽)。多數商務用戶其實不想寫程式、也不想維護腳本,他們只想要資料,越快越好。

這也是我們打造 ,這款 。只要兩下點擊,就能抓取任何網站、PDF 或圖片資料,完全不用寫程式、也不用懂 HTML。

Thunderbit 有哪些獨特優勢?

- 兩步驟操作: 開啟網頁,點「AI 建議欄位」,再點「開始抓取」,就完成了。

- AI 智慧欄位建議: Thunderbit 會自動判斷頁面內容,推薦最適合的欄位(像商品名稱、價格、評分等)。

- 自動分頁與子頁面抓取: 能自動點擊「下一頁」或深入細節頁,讓資料更完整。

- 即時匯出資料: 一鍵匯出到 Excel、Google Sheets、Airtable、Notion、CSV 或 JSON,完全免費、無需繁瑣設定。

- 多元資料型態: 可擷取信箱、電話、圖片,甚至能從 PDF 或圖片中辨識文字(內建 OCR)。

- 雲端或瀏覽器模式: 雲端一次可抓 50 頁,遇到需要登入的網站也能用瀏覽器模式。

- 免維護煩惱: AI 會自動適應網頁變動,不用再修壞掉的腳本。

Python vs. Thunderbit:功能比較

| 比較項目 | Python 爬蟲 | Thunderbit(人工智慧網頁爬蟲) |

|---|---|---|

| 建置時間 | 需花數小時寫程式、除錯 | 幾分鐘安裝擴充功能,點擊即可開始 |

| 技術門檻 | 高(需懂 Python、HTML、CSS、除錯) | 低(滑鼠點一點,完全免寫程式) |

| 維護成本 | 網站一改版就要自己修 | Thunderbit AI 自動適應變動 |

| 分頁/子頁面 | 需自行寫迴圈與邏輯 | 內建功能,開關即可 |

| 資料型態 | 預設僅支援基本欄位,進階需額外寫程式 | 一鍵擷取文字、圖片、信箱、電話、PDF 等多種資料 |

| 規模與速度 | 受限於本地程式與硬體資源 | 雲端可同時抓 50 頁,瀏覽器模式支援登入網站 |

| 成本 | Python 免費,但耗時且可能需額外伺服器/代理 | 有免費方案,付費版每年 30,000 點數約 NT$500/月起(價格說明) |

| 彈性與控制 | 可完全自訂邏輯 | 標準應用最方便,複雜需求建議用程式 |

對大多數商務用戶來說,Thunderbit 是快速取得結構化資料的最佳捷徑。

什麼時候該自己寫爬蟲?什麼時候該用 AI 網頁爬蟲?

那要怎麼選擇呢?以下是我的建議:

適合自己寫爬蟲的情境:

- 需要高度自訂邏輯(像 2FA 登入、多步驟流程、跟自家系統深度整合)

- 你本身有程式能力,也喜歡動手解決問題

- 目標網站結構穩定,且你願意持續維護腳本

- 需要將爬蟲嵌入大型軟體系統

- 目標資料在登入後或 AI 工具無法支援的情境

適合用 AI 網頁爬蟲(Thunderbit)的情境:

- 不想寫程式或不想維護腳本

- 需要快速取得資料(一次性或定期任務)

- 網站經常變動或有反爬蟲機制(Thunderbit 會自動處理)

- 想要內建功能如 OCR、信箱/電話擷取、直接匯出到常用工具

- 更重視時間效益,想把精力放在分析而不是除錯

快速決策清單:

- 資料是公開的、沒複雜登入?→ Thunderbit 最適合

- 只是臨時或偶爾需要?→ Thunderbit

- 需要高度自訂或整合?→ Python 程式

- 有開發人員且熱愛寫程式?→ Python 程式

- 不想被維護困擾?→ Thunderbit

你也可以先用 Thunderbit 快速驗證,等需求變複雜再考慮自訂腳本。

想更深入了解 AI 網頁爬蟲的運作與適用時機,歡迎參考我們的。

重點整理:讓網頁爬蟲成為你的商業利器

重點如下:

- 用 Python 寫網頁爬蟲,彈性高、功能強,但學習曲線和維護成本也高

- 人工智慧網頁爬蟲如 Thunderbit,讓資料擷取變得人人可用——免寫程式、免設定,直接拿到結果

- 對大多數商務用戶來說,最快速、最省力的方式就是用 AI 工具,除非你有非常特殊的需求

- 網路資料是金礦,選對方法能幫你省下大量時間與人力

常見問答

1. 什麼是網頁爬蟲?為什麼 Python 這麼常用?

網頁爬蟲是自動化從網站收集資料的工具。Python 之所以受歡迎,是因為語法簡單、函式庫齊全(像 requests、BeautifulSoup、Selenium),很適合處理 HTML。

2. 網頁爬蟲有哪些商業應用?

企業常用網頁爬蟲來開發銷售名單、監控價格、蒐集市場情報、整合房地產資料等。這能自動化重複性資料收集,並提供即時決策依據。

3. 自己寫爬蟲會遇到哪些挑戰?

常見挑戰包括網站結構變動、反爬蟲機制(像 CAPTCHA)、法律與道德問題、資料品質不一,以及持續維護的負擔。

4. Thunderbit 的人工智慧網頁爬蟲和傳統 Python 爬蟲有什麼不同?

Thunderbit 提供免寫程式的 AI 智慧欄位建議、自動分頁、即時匯出等功能。幾乎不用設定,遇到網站變動也能自動調整,適合不會寫程式的用戶。Python 則需自行維護與開發。

5. 什麼時候該用 Thunderbit 這類 AI 爬蟲?什麼時候該自己寫?

如果你想快速、穩定地抓取公開資料,尤其是臨時或重複性任務,建議用 Thunderbit。若需要高度自訂、深度整合或抓取複雜登入資料,則建議用 Python 自行開發。

延伸閱讀:

想更深入了解網頁爬蟲,推薦以下教學:

如果你想體驗最簡單的網頁爬蟲,現在就試試看,讓你的週五晚上和資料都變得更輕鬆!