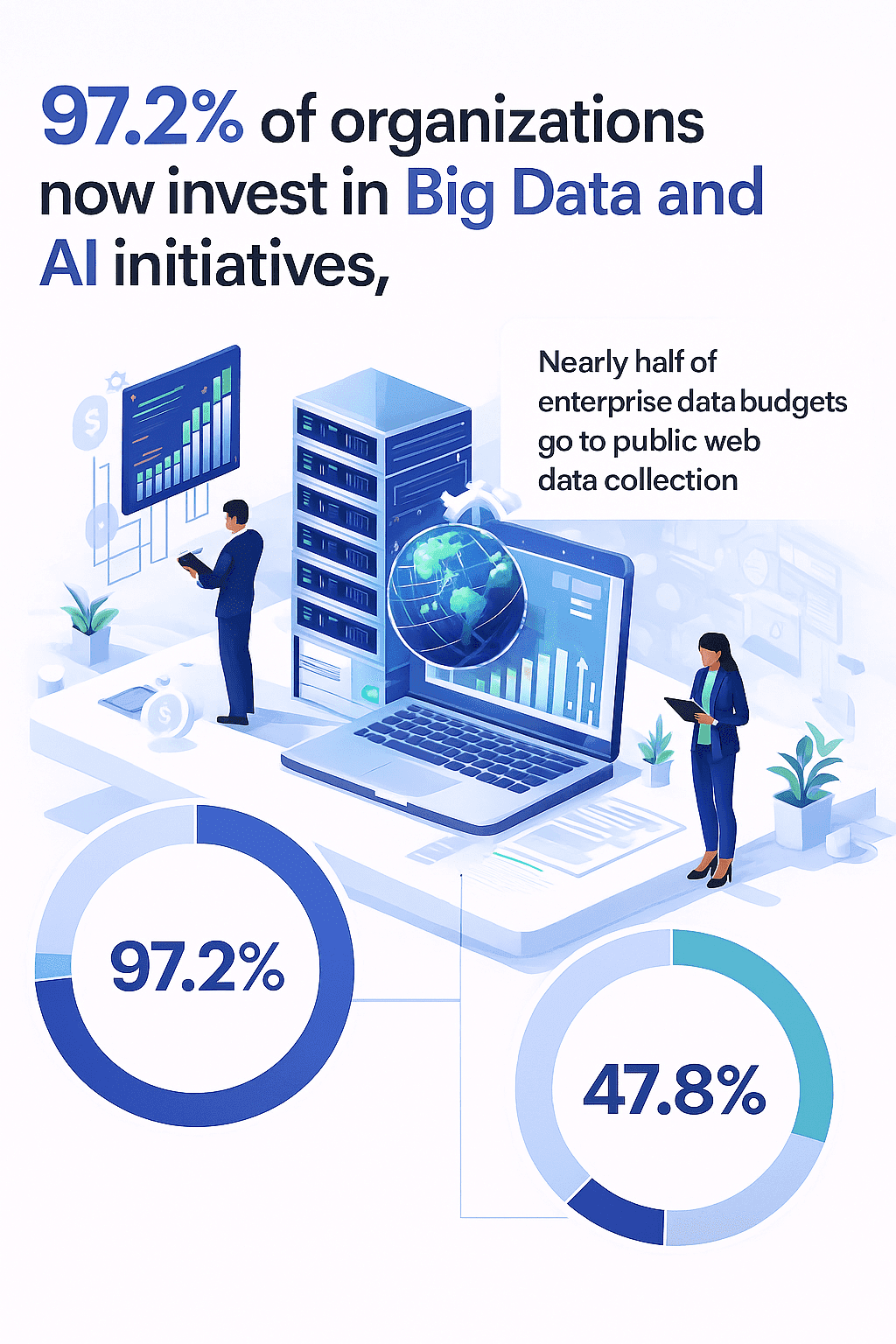

Het internet zit vol met waardevolle data—als je maar weet hoe je die slim verzamelt. Of je nu in sales, e-commerce of operations werkt, je merkt vast dat de druk om openbare webinfo om te zetten in bruikbare inzichten steeds groter wordt. Ik snap dat helemaal. Na jaren in automatisering en SaaS heb ik de trend duidelijk gezien: bedrijven laten hun onderbuikgevoel steeds vaker links liggen en vertrouwen liever op data. Wist je dat ), en dat bijna ? Maar er zit een addertje onder het gras: het grootste deel van die data zit verstopt achter rommelige HTML, dynamische pagina’s en eindeloos scrollen.

Dus, wat betekent het anno 2025 eigenlijk om een website te 'rippen'? Kleine spoiler: het heeft niks te maken met hacken of iets illegaals. Het draait juist om slim en legaal gestructureerde data verzamelen—denk aan tabellen, productinfo of contactlijsten—van openbare websites. Zo hoef je niet meer eindeloos te kopiëren en plakken, maar kun je direct met de data aan de slag. In deze blog leg ik stap voor stap uit hoe je dat doet, en waarom AI-tools zoals het verzamelen van webdata makkelijker (en veiliger) maken dan ooit.

Dus, wat betekent het anno 2025 eigenlijk om een website te 'rippen'? Kleine spoiler: het heeft niks te maken met hacken of iets illegaals. Het draait juist om slim en legaal gestructureerde data verzamelen—denk aan tabellen, productinfo of contactlijsten—van openbare websites. Zo hoef je niet meer eindeloos te kopiëren en plakken, maar kun je direct met de data aan de slag. In deze blog leg ik stap voor stap uit hoe je dat doet, en waarom AI-tools zoals het verzamelen van webdata makkelijker (en veiliger) maken dan ooit.

Wat betekent 'een website rippen' bij webdata-extractie?

Laten we meteen een misverstand uit de wereld helpen. Als mensen 'een website rippen' horen, denken ze vaak aan het downloaden van een hele site voor offline gebruik, of erger nog, aan iets illegaals. Maar in de zakelijke praktijk betekent 'rippen' van een website het verzamelen van gestructureerde informatie—zoals productoverzichten, prijzen, e-mails of reviews—van openbare pagina’s, niet simpelweg het opslaan van HTML-bestanden.

Dit noemen we webscraping: software gebruiken om specifieke data van een website te herkennen en te verzamelen, en die om te zetten naar een bruikbaar formaat, zoals een spreadsheet of database (). Heb je ooit een tabel van een webpagina naar Excel gekopieerd? Dan heb je eigenlijk al een mini-webscrape gedaan—maar dan op de omslachtige manier.

Belangrijk: een website rippen voor data is geen hacken. Je haalt openbare informatie op, maar dan geautomatiseerd. Rechtbanken hebben zelfs geoordeeld dat het scrapen van openbare data in veel gevallen legaal is (zie bijvoorbeeld de LinkedIn vs. hiQ zaak) (). Waar het om draait is hoe je het doet:

- Respecteer de gebruiksvoorwaarden van de site—sommige sites staan scraping niet toe.

- Blijf bij openbare, niet-gevoelige data—vermijd het verzamelen van persoonlijke gegevens of auteursrechtelijk beschermd materiaal.

- Overbelast de server niet—scrape met mate.

- Gebruik officiële API’s als die er zijn—die zijn bedoeld voor data-toegang.

Kortom, 'rippen' van een website draait om het omzetten van ongestructureerde webinhoud naar gestructureerde, bruikbare informatie—op een legale en respectvolle manier.

Waarom is leren 'rippen' van een website belangrijk voor bedrijven?

Laten we het praktisch maken. Waarom willen zoveel teams webdata verzamelen? Omdat webdata de nieuwe brandstof is voor bedrijven. Zo wordt het ingezet:

- Leadgeneratie: Sales-teams verzamelen contactgegevens, bedrijfsnamen of social media-profielen uit online directories om prospectlijsten te bouwen. Geautomatiseerd scrapen levert .

- Concurrentieprijzen monitoren: E-commerce- en retailteams verzamelen prijzen en voorraadniveaus van concurrenten, zodat ze hun eigen prijzen dynamisch kunnen aanpassen. Zo zag Target een ) dankzij datagedreven prijsoptimalisatie.

- Marktonderzoek & trendanalyse: Marketeers verzamelen reviews, forumberichten en nieuws om trends te signaleren of sentiment te meten. .

- Contentaggregatie: Media- en onderzoeksteams verzamelen lijsten, vacatures of reisdeals van verschillende bronnen om complete rapporten of platforms te maken.

- Operationele efficiëntie: In plaats van stagiairs die eindeloos data kopiëren, kan automatisering het administratieve werk met .

Hier een overzicht van de ROI:

| Toepassing | Voordeel van webdata-extractie | Data-gedreven ROI Voorbeeld |

|---|---|---|

| Leadgeneratie | Snel contacten verzamelen voor prospectlijsten | +47% gekwalificeerde leads via AI-prospectie |

| Prijsmonitoring | Real-time concurrentieprijzen en voorraad volgen | +15% omzet door datagedreven prijsstelling |

| Marktonderzoek | Reviews en nieuws verzamelen voor trends/sentiment | 69% van bedrijven noemt betere strategie door analytics |

| Contentaggregatie | Lijsten, vacatures of deals samenbrengen | Snellere, completere marktanalyse |

| Handmatig werk vervangen | Repetitieve dataverzameling automatiseren | >50% minder administratief werk, minder fouten |

Kortom: geautomatiseerde webdata-extractie verandert dagenlang handwerk in minuten actueel, hoogwaardige data ().

Vergelijking van website-riptools: traditioneel vs. AI-gedreven

Voordat we de diepte in gaan, eerst even de opties. Niet elke website-ripper werkt hetzelfde. Dit zijn de belangrijkste verschillen:

| Aspect | Traditionele tools (HTTrack, Wget, Handmatig) | Code-gebaseerde scrapers (Python, etc.) | No-code tools (pre-AI) | AI-webscraper (Thunderbit) |

|---|---|---|---|---|

| Gebruiksgemak | Simpel voor statische sites, niet gestructureerd | Vereist programmeerkennis | Visueel, maar instellen nodig | No-code, aanwijzen en klikken, AI doet het werk |

| Data structureren | Geen—alleen bestanden | Handmatig velden selecteren | Handmatig/visueel | AI stelt velden en structuur automatisch voor |

| Dynamische content | Werkt niet op JS-rijke sites | Vereist headless browser, maatwerk | Soms lastig | Kan overweg met JS, infinite scroll, subnavigatie |

| Onderhoud | Hoog—breekt bij sitewijzigingen | Hoog—scripts breken vaak | Gemiddeld—selectors breken | Laag—AI past zich aan lay-out aan |

| Exportopties | Handmatig | Handmatig (CSV, JSON) | CSV, Excel | Eén klik naar Excel, Sheets, Airtable, Notion, JSON |

| Technische kennis | Laag voor statisch, hoog voor gestructureerd | Hoog | Gemiddeld | Niet nodig |

Traditionele tools zoals HTTrack of Wget zijn handig om statische sites offline op te slaan, maar leveren geen gestructureerde data. Code-gebaseerde scrapers zijn krachtig, maar vragen programmeerkennis en veel onderhoud. No-code tools helpen, maar je moet nog steeds velden instellen en bij wijzigingen handmatig aanpassen.

Thunderbit pakt het anders aan: AI leest de pagina, stelt velden voor, verwerkt dynamische content en exporteert alles met één klik—zonder code, zonder gedoe met selectors, zonder frustratie ().

Stap 1: Thunderbit instellen voor eenvoudig webdata verzamelen

Aan de slag gaan met is verrassend makkelijk. Zo begin je:

- Installeer de Chrome-extensie: Ga naar de en klik op “Toevoegen aan Chrome.” Thunderbit werkt op Chrome, Edge, Brave en andere Chromium-browsers ().

- Maak een account aan: Open de Thunderbit-zijbalk (klik op het ⚡-icoon) en meld je aan met je e-mail of Google-account. Geen creditcard nodig voor het gratis abonnement.

- Taalondersteuning: Thunderbit ondersteunt 34 talen—je kunt dus data verzamelen in je eigen taal.

- Gratis tegoed: Thunderbit werkt met een creditsysteem (1 credit = 1 datarij). Met het gratis plan kun je tot 6 pagina’s per maand scrapen en data gratis exporteren ().

Eerlijk is eerlijk: de installatie is sneller dan een kop koffie zetten. Daarna kun je meteen je eerste website rippen.

Stap 2: Met AI Suggest Fields automatisch data identificeren

Hier komt de kracht van Thunderbit echt naar voren. In plaats van zelf velden aan te klikken of code te schrijven, laat je de AI het werk doen:

- Navigeer naar de gewenste pagina: Ga naar de website waarvan je data wilt verzamelen.

- Open Thunderbit: Klik op het extensie-icoon om de zijbalk te openen.

- Start een nieuwe scraper-sjabloon: Zie dit als je datatabel.

- Klik op “AI Suggest Fields”: Thunderbit’s AI scant de pagina en stelt kolomnamen en gegevenstypen voor—zoals “Productnaam”, “Prijs”, “E-mail” of “Bedrijfsnaam”.

Op een productpagina stelt Thunderbit bijvoorbeeld “Productnaam”, “Prijs”, “Afbeeldings-URL” en “Beoordeling” voor. Op een bedrijvengids vindt het “Naam”, “Functie”, “Bedrijf” en “Contactinfo”. Je kunt velden toevoegen, verwijderen of hernoemen zoals je wilt.

Wil je het geavanceerder? Voeg een Field AI Prompt toe—een instructie voor de AI om data te labelen, categoriseren of formatteren tijdens het scrapen. Bijvoorbeeld: laat prijzen indelen in “Hoog/Midden/Laag”, of bedrijven taggen op branche.

Het resultaat? Binnen enkele seconden een kant-en-klaar dataschema, in plaats van uren werk ().

Stap 3: Met één klik data scrapen via Thunderbit

Nu het leuke deel—de data daadwerkelijk verzamelen:

- Klik op “Scrape”: Thunderbit begint data te verzamelen van de huidige pagina, en indien nodig, van alle vervolgpagina’s.

- Automatische paginering: Thunderbit herkent “Volgende”-knoppen of oneindig scrollen en gaat door tot alle data binnen is.

- Subpagina’s scrapen: Meer details nodig? Thunderbit kan doorklikken naar elk item (zoals een product of profiel) en extra info ophalen, die het samenvoegt in je tabel.

- Dynamische content verwerken: Thunderbit ziet de pagina zoals jij—dus ook JavaScript-content, pop-ups, enzovoort.

- PDF’s & afbeeldingen scrapen: Je kunt zelfs PDF’s of afbeeldingen uploaden, waarna Thunderbit de tekst eruit haalt en structureert ().

Je kunt de scrape in je browser uitvoeren (handig voor sites waar je moet inloggen) of in de cloud (sneller, tot 50 pagina’s tegelijk). Thunderbit’s AI herkent fouten en past zich aan bij lay-outwijzigingen, zodat je niet hoeft in te grijpen.

Stap 4: Je verzamelde webdata exporteren en beheren

Na het scrapen toont Thunderbit je data in een overzichtelijke tabel. Tijd om ermee aan de slag te gaan:

- Exporteren naar Excel of CSV: Download je data als spreadsheet voor analyse of delen.

- Exporteren naar Google Sheets: Stuur je data direct naar een nieuwe of bestaande Google Sheet—ideaal voor dashboards of samenwerking.

- Exporteren naar Airtable of Notion: Zet je data over naar Airtable-bases of Notion-databases. Thunderbit uploadt zelfs afbeeldingen zodat je ze direct ziet ().

- Exporteren naar JSON: Voor ontwikkelaars of geavanceerde workflows, exporteer als JSON voor eenvoudige integratie.

Thunderbit rekent geen kosten voor exporteren—ook niet in het gratis plan. Wil je je data actueel houden? Plan dan automatische scrapes in (bijvoorbeeld elke ochtend om 9 uur), zodat je spreadsheet of database altijd up-to-date is ().

Best practices: Noteer altijd de bron-URL’s en extractiedata. Gebruik duidelijke kolomnamen en consistente gegevenstypen. Voor doorlopende projecten: plan regelmatige updates en gebruik cloud-sheets of databases voor eenvoudig delen.

Thunderbit vs. traditionele website-riptools: een snelle vergelijking

Waarom is Thunderbit zo’n gamechanger?

| Functie | HTTrack/Wget/Handmatig | Code-gebaseerde scraper | No-code tool | Thunderbit |

|---|---|---|---|---|

| Installatietijd | Minuten (statisch) | Uren/dagen | 30–60 min | 2–3 minuten |

| Data structureren | Geen | Handmatig | Handmatig | AI-voorstel, auto-tabel |

| Dynamische content | Nee | Ja (met moeite) | Soms | Ja, standaard |

| Paginering/subpagina’s | Nee | Handmatige loops | Handmatig | Automatisch, AI-gestuurd |

| Exportopties | Handmatige bestanden | CSV, JSON | CSV, Excel | Excel, Sheets, Airtable, Notion, JSON |

| Onderhoud | Hoog | Hoog | Gemiddeld | Laag—AI past zich aan |

| Technische kennis nodig | Laag/Hoog | Hoog | Gemiddeld | Niet nodig |

| Gratis export | Ja | Ja | Soms | Altijd |

Thunderbit is gemaakt voor zakelijke gebruikers, niet alleen voor techneuten. Het is de 'easy button' voor webdata-extractie—geen code, geen sjablonen, geen stress.

Legaal en respectvol websites rippen

Even over ethiek. Webscraping is krachtig, maar met die kracht komt verantwoordelijkheid. Zo blijf je netjes:

- Check de gebruiksvoorwaarden van de site voordat je gaat scrapen.

- Respecteer robots.txt—het is geen wet, maar wel netjes.

- Scrape met beleid—overbelast servers niet.

- Blijf bij openbare, niet-gevoelige data—vermijd persoonlijke info of betaalde content.

- Gebruik API’s als die er zijn—die zijn bedoeld voor data.

- Vermeld de bron als je data opnieuw publiceert—vooral bij reviews of artikelen.

Thunderbit is bedoeld voor verantwoord gebruik. Het is geen tool om beveiliging te omzeilen of sites te overbelasten. Gebruik het om openbare data te verzamelen, en wees altijd respectvol naar de bron ().

Samenvatting: zo maak je webdata verzamelen makkelijk en effectief

- Een website rippen voor data betekent gestructureerde, bruikbare info halen uit openbare webpagina’s—niet alleen bestanden downloaden.

- Bedrijfsteams gebruiken webdata voor leads, prijzen, onderzoek en meer. De ROI is duidelijk: meer leads, slimmere prijzen, minder handwerk.

- Traditionele tools zijn omslachtig—ze werken niet op dynamische sites, vereisen code en leveren geen schone data.

- Thunderbit maakt het simpel: Installeer de extensie, laat AI velden voorstellen, klik op “Scrape” en exporteer je data waar je wilt.

- Blijf legaal en ethisch: Respecteer de regels van de site, scrape voorzichtig en focus op openbare info.

Wil je stoppen met kopiëren en plakken en sneller, slimmer beslissingen nemen? en probeer je eerste website te rippen. Je zult versteld staan hoeveel tijd (en frustratie) je bespaart.

Meer weten over webscraping, data-automatisering of geavanceerde extractietips? Check de voor diepgaande artikelen, tutorials en praktijkvoorbeelden.

Veelgestelde vragen

1. Is het legaal om een website te rippen voor data?

Ja—zolang je alleen openbare, niet-gevoelige data verzamelt en de gebruiksvoorwaarden van de site respecteert. Vermijd het scrapen van persoonlijke gegevens, auteursrechtelijk beschermd materiaal of het overbelasten van servers. Twijfel je? Check de regels van de site of gebruik officiële API’s.

2. Wat is het verschil tussen een website rippen en downloaden?

Traditionele 'site rippers' (zoals HTTrack) kopiëren alle bestanden voor offline gebruik. Data rippen (webscraping) haalt gestructureerde info—zoals tabellen, prijzen of contacten—zodat je het kunt gebruiken in spreadsheets of databases.

3. Kan Thunderbit omgaan met dynamische websites met infinite scroll of pop-ups?

Zeker. Thunderbit’s AI is gemaakt om JavaScript-content, infinite scroll, pop-ups en zelfs meerlagige navigatie te verwerken. Het ziet de pagina zoals een mens dat doet.

4. Welke exportopties biedt Thunderbit?

Je kunt je data exporteren naar Excel, Google Sheets, Airtable, Notion, CSV of JSON. Exporteren is altijd gratis, ook in het gratis plan.

5. Hoe houd ik mijn gescrapete data actueel?

Met Thunderbit kun je scrapes automatisch laten uitvoeren—dagelijks, wekelijks of volgens je eigen schema. Je spreadsheet of database is dus altijd up-to-date.

Klaar om je eerste website slim te rippen? en ontdek hoe eenvoudig webdata verzamelen kan zijn. Succes!