Het internet zit bomvol data, en als je in 2025 een bedrijf runt, weet je: wie het snelst de beste data binnenhaalt, heeft meestal een flinke voorsprong. Of je nu in sales, e-commerce, operations of marktonderzoek werkt, de mogelijkheid om grootschalig en on-demand webdata te verzamelen is stiekem een doorslaggevend voordeel geworden. Python is hiervoor dé favoriet: bijna kiest voor Python als het om webdata-extractie gaat, vooral door het enorme aanbod aan libraries en de ideale mix van kracht en gebruiksgemak.

Maar er is iets nieuws aan de hand: hoewel Python een echte alleskunner is voor webdata-extractie, is het niet meer de enige optie. No-code tools zoals maken het nu mogelijk voor iedereen—zelfs je collega die niks met code heeft—om webdata te scrapen, op te schonen en te organiseren met slechts een paar klikken. In deze gids neem ik je mee in beide werelden: de klassieke Python-aanpak (Requests, Beautiful Soup, Selenium, Scrapy, Pandas) én hoe Thunderbit je productiviteit een flinke boost geeft. Je krijgt praktische codevoorbeelden, zakelijke scenario’s en lessen uit de praktijk. Laten we erin duiken.

Wat betekent "Python pull data from website"?

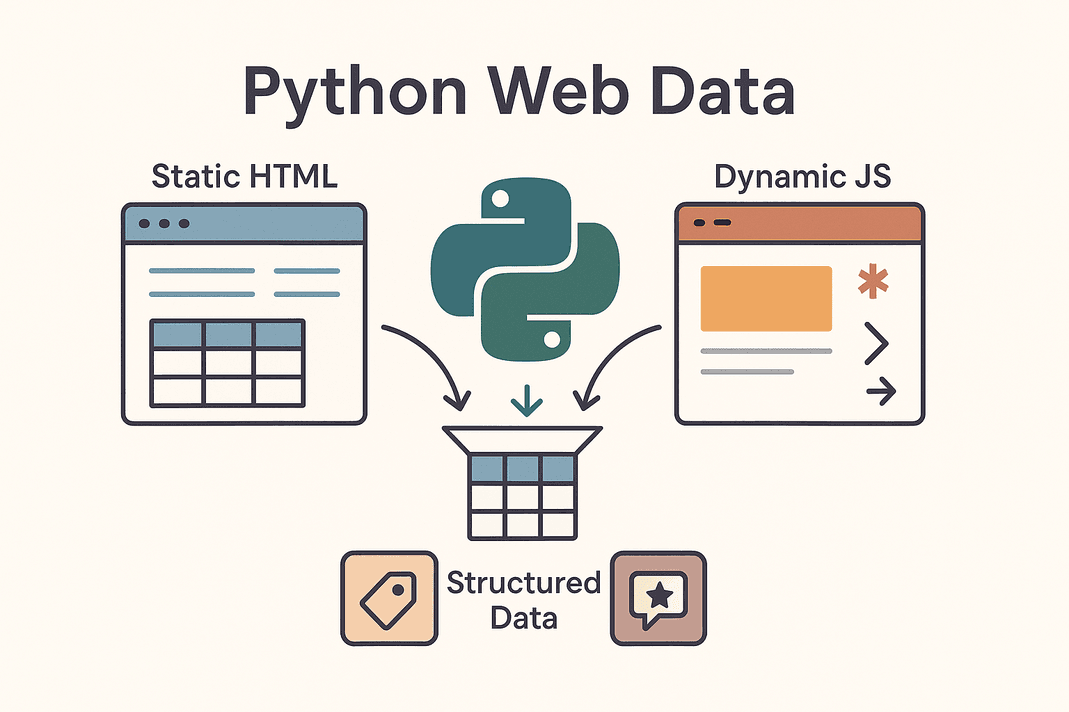

Heel simpel gezegd: “python pull data from website” betekent dat je met Python-scripts automatisch info van webpagina’s ophaalt en omzet in gestructureerde, bruikbare data. Dit noemen we ook wel webscraping. In plaats van handmatig productprijzen, contactgegevens of reviews te kopiëren, laat je Python het zware werk doen.

Heel simpel gezegd: “python pull data from website” betekent dat je met Python-scripts automatisch info van webpagina’s ophaalt en omzet in gestructureerde, bruikbare data. Dit noemen we ook wel webscraping. In plaats van handmatig productprijzen, contactgegevens of reviews te kopiëren, laat je Python het zware werk doen.

Je komt grofweg twee soorten websites tegen:

- Statistische websites: Hier staat alle content direct in de HTML. Wat je ziet bij “Paginabron weergeven” is wat je krijgt. Scrapen is hier makkelijk: HTML ophalen en parsen.

- Dynamische websites: Deze laden data pas na het openen van de pagina via JavaScript. Denk aan oneindig scrollen, live prijsupdates of content die pas verschijnt na een klik. Hiervoor heb je wat meer power nodig—zoals browser-simulatie met Selenium of het achterhalen van verborgen API’s ().

Veelgebruikte doelen voor webscraping zijn producttabellen, leadlijsten, prijzen, reviews, afbeeldingen en meer. Of je nu een leadlijst bouwt, concurrentieprijzen volgt of marktsentiment verzamelt: met Python maak je van het web je eigen datameer.

Waarom bedrijven Python gebruiken om data van websites te halen

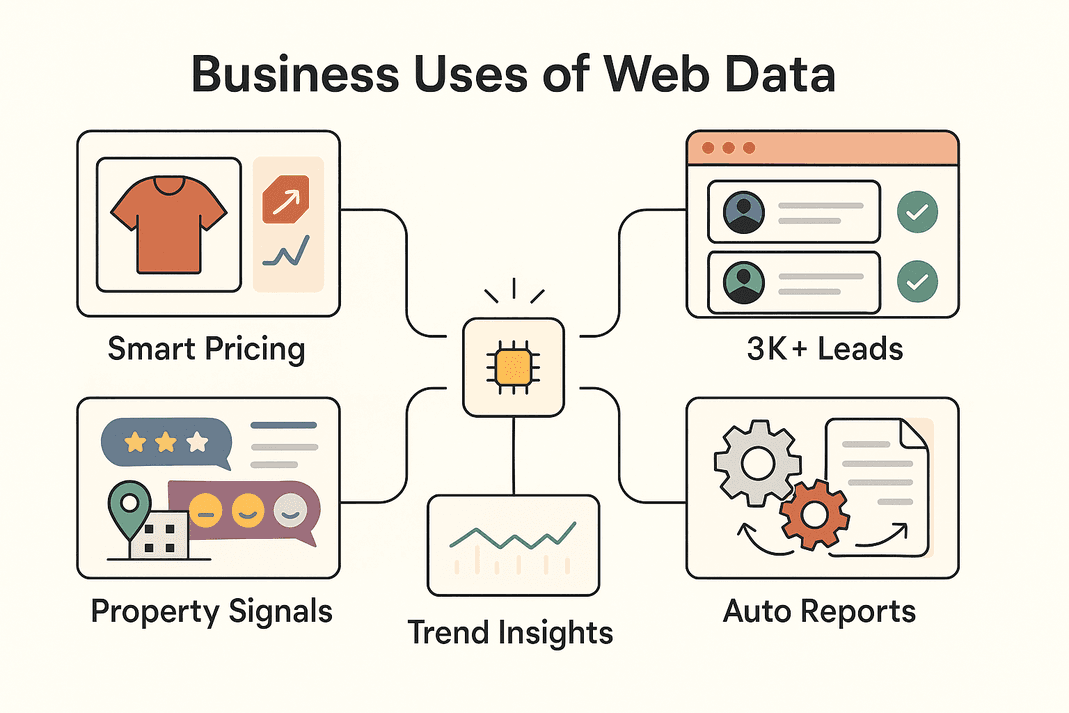

Laten we het praktisch maken. Waarom zijn zoveel bedrijven zo gefocust op webdata-extractie? Hier zijn de belangrijkste toepassingen—en de waarde die ze opleveren:

| Zakelijke Toepassing | Data die je haalt | ROI / Voordeel |

|---|---|---|

| Leadgeneratie (Sales) | Contactgegevens uit directories, socials | 3.000+ leads/maand, ~8 uur/week tijdwinst per medewerker (Thunderbit)) |

| Prijsmonitoring (E-commerce) | Productprijzen, voorraadniveaus | ~4% meer omzet, 30% minder analistentijd (blog.apify.com) |

| Marktonderzoek | Reviews, social posts, forumreacties | Betere targeting; 26% van de scrapers richt zich op social data (Thunderbit) |

| Vastgoedaanbod | Woningdata, vergelijkingen, locatiegegevens | Sneller deals vinden, altijd actuele vergelijkingen |

| Operationele automatisering | Voorraad, rapportages, repetitieve data | 10–50% tijdwinst op handmatige taken |

Kortom: webdata-extractie met Python (of Thunderbit) zorgt ervoor dat teams sneller werken, slimmere beslissingen nemen en saaie handmatige taken automatiseren. Niet gek dat de en nog steeds hard groeit.

Onmisbare Python-tools voor webdata-extractie

Python is zo populair voor webscraping dankzij het uitgebreide ecosysteem. Hier een kort overzicht van de meest gebruikte tools—en wanneer je ze inzet:

| Tool | Ideaal voor | Voordelen | Nadelen |

|---|---|---|---|

| Requests | Ophalen van statische HTML of API’s | Simpel, snel, ideaal voor beginners | Kan geen JavaScript aan |

| Beautiful Soup | HTML/XML omzetten naar gestructureerde data | Makkelijk, flexibel | Vereist HTML, niet geschikt voor JS-sites |

| Selenium | Dynamische/JS-rijke sites, logins, klikken | Kan alles wat een browser kan | Langzamer, meer setup, zwaarder |

| Scrapy | Grootschalige, multi-page crawls | Snel, asynchroon, schaalbaar | Steilere leercurve, geen JS standaard |

| Thunderbit | No-code/low-code, zakelijke gebruikers | AI-gestuurd, ondersteunt JS, makkelijk exporteren | Minder aanpasbaar voor complexe logica |

In de praktijk combineer je vaak tools: Requests + Beautiful Soup voor simpele klussen, Selenium voor lastige dynamische sites, Scrapy voor grote crawls, en Thunderbit als je snel en eenvoudig resultaat wilt.

Stap 1: Met Python Requests webdata ophalen

We beginnen bij de basis. Requests is dé tool om webpagina’s op te halen in Python. Zo werkt het:

-

Requests installeren:

1pip install requests -

Pagina ophalen:

1import requests 2url = "https://example.com/products" 3response = requests.get(url) 4if response.status_code == 200: 5 html_content = response.text 6else: 7 print(f"Failed to retrieve data: {response.status_code}")()

-

Tips bij problemen:

- Headers toevoegen om een browser na te bootsen:

1headers = {"User-Agent": "Mozilla/5.0"} 2response = requests.get(url, headers=headers) - Fouten afvangen met

response.raise_for_status() - Voor API’s die JSON teruggeven:

data = response.json()

- Headers toevoegen om een browser na te bootsen:

Requests is ideaal voor statische pagina’s of API’s. Ontbreekt de data? Dan wordt deze waarschijnlijk via JavaScript geladen—tijd voor Selenium.

Stap 2: Webinhoud parsen met Beautiful Soup

Heb je de HTML binnen, dan helpt Beautiful Soup je om de juiste data eruit te halen. Zo werkt het:

-

Beautiful Soup installeren:

1pip install beautifulsoup4 -

HTML parsen:

1from bs4 import BeautifulSoup 2soup = BeautifulSoup(html_content, 'html.parser') -

Data extraheren:

- Alle productkaarten vinden:

1for product in soup.select('div.product-card'): 2 name = product.select_one('.product-name').text.strip() 3 price = product.select_one('.product-price').text.strip() 4 print(name, price) - Voor tabellen:

1for row in soup.find_all('tr'): 2 cells = row.find_all('td') 3 # Haal de celdata op zoals nodig

- Alle productkaarten vinden:

Tips:

- Gebruik de ontwikkelaarstools van je browser om de juiste selectors te vinden.

- Gebruik

.get_text()of.textom tekst te extraheren. - Controleer op ontbrekende data (

if price_elem else "N/B").

Requests + Beautiful Soup is de klassieke combinatie voor webscraping—eenvoudig, betrouwbaar en ideaal voor statische sites.

Stap 3: Dynamische content aanpakken met Selenium

Laadt een site data via JavaScript, dan heb je een tool nodig die zich als een echte gebruiker gedraagt. Dat is waar Selenium om de hoek komt kijken.

-

Selenium installeren:

1pip install seleniumDownload de juiste browserdriver (bijv. ChromeDriver) en zorg dat deze in je PATH staat.

-

Browser automatiseren:

1from selenium import webdriver 2driver = webdriver.Chrome() 3driver.get("https://example.com/products") 4products = driver.find_elements_by_class_name("product-card") 5for prod in products: 6 print(prod.text) 7driver.quit() -

Logins en klikken automatiseren:

1driver.get("https://site.com/login") 2driver.find_element_by_name("username").send_keys("myuser") 3driver.find_element_by_name("password").send_keys("mypassword") 4driver.find_element_by_id("login-button").click() -

Wachten op dynamische content:

1from selenium.webdriver.common.by import By 2from selenium.webdriver.support.ui import WebDriverWait 3from selenium.webdriver.support import expected_conditions as EC 4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.CLASS_NAME, "data-row"))) -

Headless modus (zonder venster):

1options = webdriver.ChromeOptions() 2options.add_argument("--headless") 3driver = webdriver.Chrome(options=options)

Selenium is krachtig maar wat zwaarder—ideaal voor sites die echt browserautomatisering vereisen.

Stap 4: Schalen met Scrapy voor grootschalige dataverzameling

Wil je honderden of duizenden pagina’s crawlen, dan is Scrapy je beste vriend.

-

Scrapy installeren:

1pip install scrapy 2scrapy startproject myproject -

Spider aanmaken:

1import scrapy 2class ProductsSpider(scrapy.Spider): 3 name = "products" 4 start_urls = ["https://example.com/category?page=1"] 5 def parse(self, response): 6 for product in response.css("div.product-card"): 7 yield { 8 'name': product.css(".product-title::text").get().strip(), 9 'price': product.css(".price::text").get().strip(), 10 } 11 next_page = response.css("a.next-page::attr(href)").get() 12 if next_page: 13 yield response.follow(next_page, self.parse) -

Spider uitvoeren:

1scrapy crawl products -o products.csv

Scrapy is asynchroon, razendsnel en gemaakt voor schaal. Ideaal voor het crawlen van complete websites of complexe paginering.

Stap 5: Data-extractie versnellen met Thunderbit

En dan —de no-code AI-webscraper die het voor zakelijke gebruikers supermakkelijk maakt.

- AI stelt velden voor: Thunderbit leest de pagina en stelt automatisch de beste kolommen voor—je hoeft niet zelf in de HTML te zoeken.

- Ondersteunt dynamische pagina’s: Thunderbit ziet de pagina precies zoals jij, dus JavaScript, infinite scroll en logins zijn geen probleem.

- Subpagina’s scrapen: Thunderbit kan automatisch doorklikken naar detailpagina’s en je dataset verrijken.

- Kant-en-klare sjablonen: Voor populaire sites als Amazon, Zillow of Shopify zijn er direct te gebruiken templates—geen setup nodig.

- One-click extractors: Alle e-mails of telefoonnummers op een pagina nodig? Thunderbit regelt het met één klik.

- Plannen en cloud scraping: Stel terugkerende scrapes in met natuurlijke taal (“elke maandag om 9 uur”) en laat Thunderbit tot 50 pagina’s tegelijk verwerken in de cloud.

- Overal exporteren: Stuur je data direct naar Excel, Google Sheets, Airtable, Notion of download als CSV/JSON—gratis en onbeperkt.

Thunderbit is ideaal voor teams die snel data willen, zonder te programmeren. Je kunt zelfs Thunderbit gebruiken om data te verzamelen en deze vervolgens in Python analyseren—het beste van beide werelden.

Stap 6: Geëxtraheerde data opschonen en analyseren met Pandas

Heb je je data (uit Python of Thunderbit) binnen, dan kun je deze met Pandas opschonen en analyseren.

-

Data inladen:

1import pandas as pd 2df = pd.read_csv("products.csv") 3print(df.head()) -

Data opschonen:

- Dubbelen verwijderen:

1df = df.drop_duplicates() - Ontbrekende waarden aanvullen:

1df = df.fillna("N/B") - Formaten standaardiseren (bijv. prijzen):

1df['price'] = df['price'].str.replace('$','').str.replace(',','').astype(float)

- Dubbelen verwijderen:

-

Analyseren:

- Statistieken opvragen:

1print(df.describe()) - Groeperen op categorie:

1avg_price = df.groupby('category')['price'].mean() 2print(avg_price)

- Statistieken opvragen:

Pandas is je Zwitsers zakmes om rommelige webdata om te zetten in waardevolle inzichten.

Stap 7: Gehaalde data organiseren en opslaan voor zakelijk gebruik

Je data is opgeschoond—nu maak je het bruikbaar voor je team.

- CSV/Excel: Gebruik

df.to_csv("out.csv", index=False)ofdf.to_excel("out.xlsx")om makkelijk te delen. - Google Sheets: Gebruik of de

gspread-library in Python. - Databases: Voor grotere datasets kun je met

df.to_sql()opslaan in een SQL-database. - Automatisering: Zet scripts of Thunderbit-planningen op om je data actueel te houden.

- Best practices: Voeg altijd een timestamp toe, documenteer kolommen en beheer toegang bij gevoelige data.

Kies de opslag die past bij je team—spreadsheets voor snelle resultaten, databases voor schaalbaarheid.

Thunderbit vs. Python-code: welke aanpak past bij jouw team?

Hier een overzicht:

| Factor | Thunderbit (No-Code AI) | Python Libraries (Code) |

|---|---|---|

| Vereiste kennis | Geen (browser-gebaseerde interface) | Python-programmeren nodig |

| Installatietijd | Minuten (AI-voorstellen, direct scrapen) | Uren–dagen (coderen, debuggen, opzetten) |

| Ondersteunt JS/Interactief | Ja, standaard (browser/cloud-modi) | Ja, maar vereist Selenium/Playwright |

| Onderhoud | Laag—AI past zich aan veel sitewijzigingen aan | Handmatig—code aanpassen bij sitewijzigingen |

| Schaal | Gemiddeld (snel voor tientallen tot honderden pagina’s via cloud) | Hoog (Scrapy kan duizenden+ aan) |

| Aanpasbaarheid | Via UI-opties & AI-prompts | Onbeperkt (elke logica, elke integratie) |

| Anti-bot/Proxies | Intern geregeld | Zelf implementeren |

| Data export | 1-klik naar Sheets, Excel, Notion, Airtable | Eigen code nodig |

| Ideaal voor | Niet-technische gebruikers, snel resultaat, minimaal onderhoud | Developers, complexe/grote projecten |

Tip: Gebruik Thunderbit voor snelle resultaten en om je business team te versterken. Python is ideaal als je veel wilt aanpassen of grootschalig wilt werken. Veel teams combineren beide: Thunderbit voor snelle validatie en data, Python voor automatisering of opschaling.

Praktische zakelijke toepassingen van webdata-extractie

Zo zetten teams deze tools in de praktijk in:

Zo zetten teams deze tools in de praktijk in:

- E-commerce: John Lewis door concurrentieprijzen te scrapen en hun eigen prijzen direct aan te passen.

- Sales: Teams halen 3.000+ leads per maand binnen en besparen 8 uur per week per medewerker ())—geen handmatig zoekwerk meer.

- Marktonderzoek: Marketeers verzamelen duizenden reviews of social posts voor sentimentanalyse en signaleren trends voordat dashboards dat doen.

- Vastgoed: Makelaars scrapen woningaanbod om ondergewaardeerde panden of nieuwe kansen te spotten—sneller dan wachten op MLS-updates.

- Workflow-automatisering: Operationele teams automatiseren voorraadchecks, rapportages of zelfs FAQ’s door partner- of interne sites te scrapen.

Vaak is de workflow hybride: Thunderbit om data te verzamelen, Python om te schonen en analyseren, en dan exporteren naar Sheets of een database voor het team.

Conclusie & belangrijkste inzichten

Data van websites halen met Python (en Thunderbit) is een onmisbare skill voor moderne business teams. De samenvatting:

- Requests + Beautiful Soup: Ideaal voor statische sites, snel en simpel.

- Selenium: Voor dynamische, JS-rijke of login-pagina’s.

- Scrapy: Voor grootschalige, multi-page crawls.

- Thunderbit: Voor no-code, AI-gestuurde scraping—snel, makkelijk en perfect voor zakelijke gebruikers.

- Pandas: Voor het opschonen, analyseren en interpreteren van je data.

- Slim exporteren: Gebruik CSV, Sheets of databases—wat maar het beste past bij je workflow.

De beste aanpak? Kies het gereedschap dat past bij je technische niveau en zakelijke doelen. Combineer en schaal op waar nodig. Wil je ervaren hoe eenvoudig webscraping kan zijn? of check de voor meer handige guides.

Veel succes met scrapen—en moge je data altijd schoon, gestructureerd en direct bruikbaar zijn.

Veelgestelde vragen

1. Wat is de makkelijkste manier om data van een website te halen met Python?

Voor statische sites gebruik je de Requests-library om de HTML op te halen en Beautiful Soup om de gewenste data te extraheren. Voor dynamische sites heb je meestal Selenium nodig.

2. Wanneer kies ik voor Thunderbit in plaats van Python-code?

Thunderbit is ideaal als je snel data nodig hebt, niet wilt programmeren of te maken hebt met dynamische pagina’s, subpagina’s of directe export naar Sheets/Excel. Perfect voor zakelijke gebruikers of snelle projecten.

3. Hoe ga ik om met sites die data via JavaScript laden?

Gebruik Selenium (of Playwright) om een browser te automatiseren, of probeer Thunderbit’s browser/cloud-modus, die JavaScript automatisch verwerkt.

4. Wat is de beste manier om gescrapete data op te schonen en te analyseren?

Importeer je data in Pandas, verwijder dubbelen, vul ontbrekende waarden aan, standaardiseer formaten en gebruik groupby of describe voor snelle inzichten.

5. Is webscraping legaal en veilig voor zakelijk gebruik?

In het algemeen is het scrapen van openbare data toegestaan, maar check altijd de gebruiksvoorwaarden en robots.txt van de site. Vermijd het scrapen van persoonsgegevens zonder toestemming en wees respectvol met de resources van de site. Thunderbit en Python ondersteunen beide ethisch scrapen.

Klaar om je dataskills te verbeteren? of ga aan de slag met Python—hoe dan ook, je haalt in no-time waardevolle webdata binnen.

Meer weten