Eerlijk is eerlijk: de eerste keer dat ik een webscraper bouwde, voelde het alsof ik ineens een geheime superkracht had ontdekt. Al dat eindeloze knip- en plakwerk voor sales leads of prijsvergelijkingen? Dat was in één klap verleden tijd. Zelf een webscraper schrijven met Python is dan ook een must voor iedereen die saaie online klusjes wil automatiseren. En voor bedrijven kan het echt het verschil maken: of je nu je vrijdagavond besteedt aan eindeloze spreadsheets, of eindelijk eens op tijd bij de borrel bent.

In deze gids neem ik je stap voor stap mee in het bouwen van een webscraper met Python, inclusief praktische codevoorbeelden. Daarna laat ik je zien waarom er voor de meeste bedrijven een veel snellere oplossing is: een waarmee je in twee klikken data binnenhaalt, zonder ook maar één regel code te schrijven. Of je nu graag met Python aan de slag gaat of gewoon snel data wilt zonder gedoe, hier vind je de aanpak die bij jou past.

Wat is Webscraping met Python? Een Korte Intro

Laten we bij het begin beginnen. Webscraping betekent simpelweg automatisch informatie van websites verzamelen. Zie het als een digitale stagiair die al het saaie kopieer- en plakwerk voor je doet—zonder ooit te klagen of om opslag te vragen.

Een webscraper is een script of programma dat:

- Een webpagina bezoekt (net als je browser)

- Specifieke data eruit haalt (denk aan productnamen, prijzen of contactgegevens)

- Alles netjes opslaat (bijvoorbeeld in een spreadsheet of JSON-bestand)

Python is hiervoor de populairste taal: het is makkelijk te lezen, heeft talloze handige libraries en is super veelzijdig. .

Het basisproces werkt zo:

- Je haalt de webpagina op (HTML binnenhalen)

- Je parseert de HTML en zoekt de data die je nodig hebt

- Je slaat de resultaten op een handige plek op

Het is net als een taart bakken: je verzamelt de ingrediënten (HTML), haalt eruit wat je nodig hebt (data) en serveert het (exporteren).

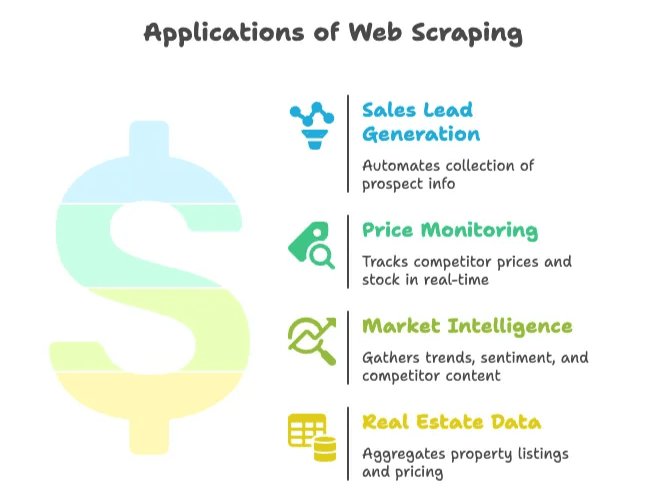

Waarom Webscraping Belangrijk is voor Bedrijven

Webscraping is allang niet meer alleen voor techneuten of data-analisten. Het is onmisbaar geworden voor sales, marketing, e-commerce, vastgoed en iedereen die actuele webdata nodig heeft voor beslissingen. De , en groeit elk jaar met 28%. Kortom: veel data, veel kansen.

Hier wat praktijkvoorbeelden:

| Toepassing | Voordeel | Resultaat |

|---|---|---|

| Sales leads genereren | Automatisch prospects verzamelen uit directories of sociale netwerken | Bespaart ~8 uur/week per medewerker; 3.000 leads/maand, 10× salesgroei in 3 maanden |

| Prijsmonitoring | Direct inzicht in prijzen en voorraad van concurrenten | 30% minder tijd kwijt aan dataverzameling; 4% meer omzet door slimme prijsstrategie |

| Marktinformatie | Trends, sentiment en concurrentie-informatie verzamelen | Meer dan 70% van de bedrijven gebruikt webdata voor marktanalyses |

| Vastgoeddata | Woningen en prijzen van meerdere sites samenvoegen | Bedrijven scrapen Zillow/Trulia om lokale marktontwikkelingen te volgen |

Kortom: webscraping bespaart tijd, voorkomt handwerk en geeft je een voorsprong op de concurrentie. Wie nog steeds handmatig kopieert en plakt, loopt al snel achter.

Wat Heb Je Nodig om Zelf een Webscraper te Schrijven?

Voordat je begint, is het handig om je gereedschap op orde te hebben.

De Basis

- Python geïnstalleerd: Download de nieuwste versie () en zorg dat je

pythonin je terminal kunt gebruiken. - Code-editor: VS Code, PyCharm of zelfs Notepad++ werkt prima. Zelf ben ik fan van VS Code vanwege de fijne Python-ondersteuning.

- Virtuele omgeving: Niet verplicht, maar wel handig om je project overzichtelijk te houden. Maak er een aan met

python -m venv venv.

Belangrijke Python Libraries

- Requests: Om webpagina’s op te halen ().

- BeautifulSoup: Voor het parsen van HTML en het vinden van elementen ().

- Selenium: Voor websites die hun inhoud met JavaScript laden ().

Installeer ze met:

1pip install requests beautifulsoup4 lxml seleniumBasiskennis van HTML

Je hoeft geen webdeveloper te zijn, maar het is handig als je weet hoe je de HTML van een pagina inspecteert. Rechtsklik, kies “Inspecteren” en je ziet de DOM-structuur. Hier vind je de tags en klassen die je scraper moet targeten ().

Stap voor Stap: Zelf een Webscraper Bouwen met Python

Tijd om de handen uit de mouwen te steken. We bouwen een simpele scraper, bijvoorbeeld voor productlijsten of nieuwsberichten. Je kunt dit makkelijk aanpassen aan je eigen situatie.

Je Python-omgeving Inrichten

Maak eerst een projectmap en een virtuele omgeving aan:

1mkdir my-scraper

2cd my-scraper

3python -m venv venv

4# Activeer de venv:

5# Op Windows:

6venv\Scripts\activate

7# Op macOS/Linux:

8source venv/bin/activateInstalleer de benodigde libraries:

1pip install requests beautifulsoup4 lxmlMaak een bestand scraper.py aan en open het in je editor.

Webpagina’s Ophalen en Parsen

We halen de HTML op van een voorbeeldsite. In dit geval (een klassieker voor scraping-demo’s).

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content

7else:

8 print(f"Request failed with status {response.status_code}")

9 exit()Nu parsen we de HTML met BeautifulSoup:

1soup = BeautifulSoup(html_content, "html.parser")

2print(soup.title.string) # Zou "Hacker News" moeten printenDe Gezochte Data Extracten

Stel, je wilt alle titels en links van de nieuwsberichten verzamelen. Door de pagina te inspecteren zie je dat elke titel in een <a class="storylink"> tag staat.

1stories = soup.find_all('a', class_='storylink')

2data = []

3for story in stories:

4 title = story.get_text()

5 link = story['href']

6 data.append({"title": title, "url": link})

7 print(title, "->", link)Wil je producten scrapen, zoek dan bijvoorbeeld naar <div class="product-item"> en haal daar de velden uit. Een generiek voorbeeld:

1products = soup.find_all('div', class_='product-item')

2for prod in products:

3 name = prod.find('h2').get_text()

4 price = prod.find('span', class_='price').get_text()

5 url = prod.find('a')['href']

6 data.append({"name": name, "price": price, "url": url})Data Opslaan als CSV of JSON

Nu kun je de data opslaan zodat je er echt iets mee kunt.

Naar CSV:

1import csv

2with open("output.csv", mode="w", newline="", encoding="utf-8") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "URL"])

5 for item in data:

6 writer.writerow([item["title"], item["url"]])Naar JSON:

1import json

2with open("output.json", mode="w", encoding="utf-8") as f:

3 json.dump(data, f, indent=2)Open je CSV in Excel of je JSON in een teksteditor—en voilà, je hebt uren handwerk geautomatiseerd.

Verder Gaan: Paginering en Dynamische Inhoud

De meeste websites passen niet op één pagina. Zo pak je meer geavanceerde situaties aan.

Paginering

Als de site werkt met URL-paginering (bijvoorbeeld ?page=2), kun je door de paginanummers loopen:

1base_url = "https://example.com/products?page="

2for page_num in range(1, 6):

3 url = base_url + str(page_num)

4 resp = requests.get(url)

5 if resp.status_code != 200:

6 break

7 soup = BeautifulSoup(resp.content, "html.parser")

8 # Data extracten zoals eerder()

Heeft de site een “Volgende”-knop, zoek dan de link en volg die:

1url = "https://example.com/products"

2while url:

3 resp = requests.get(url)

4 soup = BeautifulSoup(resp.content, "html.parser")

5 # Data extracten

6 next_link = soup.find('a', class_='next-page')

7 if next_link and 'href' in next_link.attrs:

8 url = "https://example.com" + next_link['href']

9 else:

10 url = NoneDynamische Inhoud (JavaScript)

Staat de data niet direct in de HTML (maar wordt deze door JavaScript geladen), dan heb je Selenium nodig:

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/complex-page")

4driver.implicitly_wait(5)

5page_html = driver.page_source

6soup = BeautifulSoup(page_html, "html.parser")

7# Data extracten zoals eerder()

Met Selenium kun je ook op “Meer laden”-knoppen klikken of scrollen. Houd er rekening mee dat dit trager en zwaarder is dan Requests.

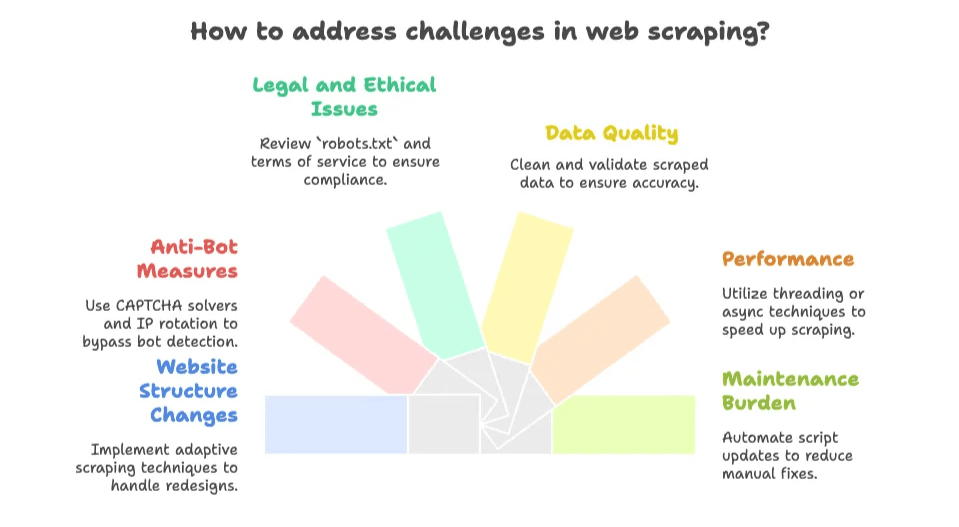

Veelvoorkomende Valkuilen bij Zelf Webscrapers Bouwen

Hier wordt het spannend. Een webscraper schrijven is leuk—totdat de website verandert en je script het begeeft vlak voor een deadline. Dit zijn de grootste uitdagingen:

- Website verandert: Als de site een nieuw ontwerp krijgt of klassen wijzigt, werkt je scraper niet meer. Onderhoud is een doorlopend proces ().

- Anti-botmaatregelen: CAPTCHAs, limieten en IP-blokkades zijn overal. .

- Juridische en ethische kwesties: Controleer altijd de

robots.txten de gebruiksvoorwaarden van de site. Openbare data mag meestal, maar scrape geen privé- of auteursrechtelijk beschermde inhoud (). - Datakwaliteit: Gescrapete data kan rommelig zijn. Soms moet je HTML-tags, witruimtes of kapotte tekst opschonen.

- Prestaties: Veel pagina’s scrapen is traag, tenzij je threading of async gebruikt.

- Onderhoudslast: Elke nieuwe site of wijziging betekent weer scripts aanpassen. Het blijft een kat-en-muisspel.

Voor ontwikkelaars die van puzzelen houden is dit een leuke uitdaging. Maar als je gewoon snel data wilt, kan het frustrerend zijn.

Slimmer Werken: AI-webscraper Tools zoals Thunderbit

Hier mag ik even mijn Thunderbit-pet opzetten (in gedachten een pet met een bliksemschicht). De meeste zakelijke gebruikers willen geen code schrijven of onderhouden—ze willen gewoon direct de data.

Daarom hebben we ontwikkeld: een waarmee je elke website, PDF of afbeelding in twee klikken kunt scrapen. Geen code, geen installatie, geen HTML-kennis nodig.

Wat Maakt Thunderbit Uniek?

- 2-kliks installatie: Open een webpagina, klik op “AI Suggest Fields” en daarna op “Scrape”. Klaar.

- AI-veldherkenning: Thunderbit’s AI leest de pagina en stelt automatisch de beste kolommen voor (zoals productnaam, prijs, beoordeling, enz.).

- Subpagina’s en paginering: Volgt automatisch “Volgende”-links of duikt in detailpagina’s voor extra data.

- Direct exporteren: Exporteer naar Excel, Google Sheets, Airtable, Notion, CSV of JSON—gratis, zonder gedoe.

- Uitgebreide datatypes: Haal e-mails, telefoonnummers, afbeeldingen en zelfs tekst uit PDF’s of afbeeldingen (dankzij ingebouwde OCR).

- Cloud- of browserscraping: Scrape tot 50 pagina’s tegelijk in de cloud, of gebruik je browser voor sites waar je moet inloggen.

- Geen onderhoudszorgen: De AI past zich automatisch aan als de lay-out verandert, dus je hoeft geen scripts te repareren.

Vergelijking: Python vs. Thunderbit

| Aspect | Python-scraper | Thunderbit (AI-webscraper) |

|---|---|---|

| Installatietijd | Uren voor opzetten, coderen en debuggen | Minuten—extensie installeren, klikken en klaar |

| Technische kennis | Hoog (Python, HTML, CSS, debuggen) | Laag (wijzen en klikken, geen code) |

| Onderhoud | Je moet het zelf aanpassen bij sitewijzigingen | Thunderbit’s AI past zich automatisch aan |

| Paginering/subpagina’s | Zelf loops en logica schrijven | Ingebouwd, alleen optie aanzetten |

| Datatypes | Standaard beperkt; extra code voor afbeeldingen, PDF’s, e-mails, enz. | Eén klik voor tekst, afbeeldingen, e-mails, telefoonnummers, PDF’s en meer |

| Schaal & snelheid | Beperkt door je eigen code en resources | Cloudscraping tot 50 pagina’s tegelijk; browsermodus voor inlogsites |

| Kosten | Python is gratis, maar je tijd niet; hosting en proxies kunnen optellen | Gratis versie beschikbaar; betaalde plannen vanaf ~$16,5/maand voor 30.000 credits/jaar (prijzen) |

| Flexibiliteit & controle | Maximale controle voor maatwerk | Maximale eenvoud voor standaardgebruik |

Voor de meeste zakelijke gebruikers is Thunderbit de snelste route naar gestructureerde data zonder gedoe.

Wanneer Zelf een Webscraper Bouwen en Wanneer een AI-webscraper Gebruiken?

Welke aanpak past het beste bij jou? Mijn eerlijke advies:

Zelf een Scraper Schrijven als:

- Je zeer specifieke logica nodig hebt (zoals inloggen met 2FA, complexe workflows of integratie met je eigen backend).

- Je sterke programmeervaardigheden hebt en graag sleutelt.

- De site stabiel is en je het onderhoud niet erg vindt.

- Je scraping wilt integreren in een groter softwaresysteem.

- Je data wilt scrapen die achter een login zit of niet door AI-tools wordt ondersteund.

Een AI-webscraper (Thunderbit) Gebruiken als:

- Je niet wilt programmeren of scripts onderhouden.

- Je snel data nodig hebt (voor eenmalige of terugkerende taken).

- De site vaak verandert of anti-botmaatregelen heeft (Thunderbit regelt dit voor je).

- Je extra functies wilt zoals OCR, e-mail/telefoonextractie of directe export naar je favoriete tools.

- Je je tijd waardeert en wilt focussen op analyse, niet op debuggen.

Een snelle beslischeck:

- Is de data openbaar en niet achter een lastige login? → Thunderbit is waarschijnlijk de beste keuze.

- Is het een eenmalige of ad-hoc taak? → Thunderbit.

- Heb je diepgaande maatwerk of integratie nodig? → Python-script.

- Heb je een ontwikkelaar in huis en programmeer je graag? → Python-script.

- Wil je onderhoud vermijden? → Thunderbit.

Je kunt altijd beginnen met Thunderbit voor snelle resultaten, en overstappen op maatwerk als je behoeften complexer worden.

Meer weten over hoe AI-webscrapers werken en wanneer je ze inzet? Bekijk onze .

Samenvatting: Zo Haal Je Meer uit Webscraping voor Jouw Bedrijf

Tot slot:

- Webscraping met Python is krachtig en flexibel, maar vraagt om leercurve en onderhoud.

- AI-webscrapers zoals Thunderbit maken data-extractie toegankelijk voor iedereen—geen code, geen installatie, direct resultaat.

- Voor de meeste bedrijven is een AI-tool de snelste weg naar waarde, tenzij je heel specifieke wensen hebt.

- Het web is een goudmijn aan data, en met de juiste aanpak bespaar je uren (of zelfs dagen) handmatig werk.

Veelgestelde Vragen

1. Wat is webscraping en waarom wordt Python er vaak voor gebruikt?

Webscraping is het automatisch verzamelen van data van websites. Python is populair vanwege de leesbaarheid, de vele libraries (zoals requests, BeautifulSoup en Selenium) en het gemak waarmee je HTML kunt verwerken.

2. Wat zijn veelvoorkomende zakelijke toepassingen van webscraping?

Bedrijven gebruiken webscraping voor het genereren van sales leads, prijsmonitoring, marktanalyses en het verzamelen van vastgoeddata. Het automatiseert repetitieve taken en levert actuele inzichten voor betere beslissingen.

3. Wat zijn de grootste uitdagingen bij het zelf schrijven van een webscraper?

Veelvoorkomende problemen zijn veranderende websitestructuren, anti-botmaatregelen zoals CAPTCHAs, juridische en ethische kwesties, datakwaliteit en het voortdurende onderhoud om scrapers werkend te houden.

4. Hoe verschilt Thunderbit’s AI-webscraper van traditionele Python-scrapers?

Thunderbit biedt een no-code oplossing met AI-veldherkenning, automatische paginering en exportmogelijkheden. Je hoeft niets in te stellen, de AI past zich aan bij sitewijzigingen en het is toegankelijk voor niet-programmeurs—terwijl Python-scripts programmeerkennis en handmatig onderhoud vereisen.

5. Wanneer kies je voor een AI-scraper zoals Thunderbit in plaats van zelf coderen?

Gebruik Thunderbit als je snel en betrouwbaar wilt scrapen zonder te programmeren, vooral voor openbare data of eenmalige taken. Kies voor een Python-script als je volledige controle, diepgaande integratie of complexe, afgeschermde data nodig hebt.

Verder lezen:

Wil je dieper duiken in webscraping? Bekijk dan onze andere gidsen:

Klaar om de makkelijkste manier van webscraping te proberen? en ervaar het zelf. Je vrijdagavonden (en je data) zullen je dankbaar zijn.