Ik weet het nog goed: de allereerste keer dat ik probeerde bedrijfsdata van een website te plukken, zat ik voorovergebogen achter mijn laptop, stuntelend met Ruby-scripts, browsertools en dat groeiende gevoel van: “Waarom moet dit zo lastig zijn?” Maar nu, in 2025, is de wereld van webscraping compleet op z’n kop gezet. Webdata is allang niet meer alleen voor techneuten of data scientists—het is de geheime motor achter slimmere sales, effectievere marketing en realtime bedrijfsinzichten.

Toch, laten we eerlijk zijn: voor de meeste mensen klinkt “webscraping met Ruby” nog steeds als iets waarvoor je óf een informaticadiploma óf een flinke voorraad koffie nodig hebt. Gelukkig is er goed nieuws: dankzij AI-webscraper tools zoals heb je geen programmeerkennis meer nodig om waardevolle data van het web te halen. In deze gids laat ik je zowel de klassieke Ruby-aanpak als de nieuwe AI-gestuurde alternatieven zien—zodat je zelf kunt kiezen wat het beste past bij jouw skills, team en doelen.

Waarom Webscraping met Ruby Interessant is voor Bedrijven

Webscraping is allang niet meer alleen een hobby voor nerds—het is een onmisbare strategie voor bedrijven geworden. Wist je dat webscraping inzet om openbare data te verzamelen? En het blijft niet bij e-commerce: sales-, marketing- en operationele teams gebruiken gescrapete data om de concurrentie voor te blijven, nieuwe leads te vinden en hun aanbod up-to-date te houden.

Hier wat praktijkvoorbeelden:

| Toepassing | Hoe bedrijven het inzetten | Typisch resultaat / impact |

|---|---|---|

| Leadgeneratie | Contacten verzamelen uit bedrijvengidsen, LinkedIn of openbare lijsten | 10× meer leads per week, lagere kosten per lead (zie case study) |

| Prijsmonitoring | Dagelijks prijzen en voorraad van concurrenten volgen | 2–5% omzetstijging door dynamische prijzen (John Lewis zag ~4%) |

| Productcatalogus bijwerken | Data van leveranciers of marktplaatsen samenvoegen | Minder fouten, uren bespaard op handmatig werk |

| Marktonderzoek | Reviews, fora en social media scrapen voor trends | Betere campagnes, sneller kansen of problemen signaleren |

| Content & SEO monitoring | Blogs, zoekwoorden en meta tags van concurrenten volgen | Betere SEO, altijd op de hoogte van contenttrends |

| Vastgoedinzichten | Woningen en prijzen scrapen | Sneller reageren op nieuwe aanbiedingen, beter marktinzicht |

Kortom: webscraping is een echte krachtvermenigvuldiger voor elk team. Het draait niet alleen om “data verzamelen”—het gaat om voorsprong nemen.

Wat is Webscraping met Ruby? In Jip-en-Janneketaal

Laten we het simpel houden. Webscraping betekent eigenlijk: “Automatisch de data van websites halen die je nodig hebt, zonder alles met de hand te kopiëren.” Met Ruby schrijf je instructies voor een digitale assistent—een script dat webpagina’s bezoekt, de inhoud leest en precies die info pakt die jij wilt.

Ruby is hiervoor populair omdat het lekker leesbaar is, flexibel en boordevol open-source bibliotheken (“gems”). Je kunt Ruby bijvoorbeeld laten zoeken naar alle productnamen en prijzen op een pagina, en die direct in een spreadsheet zetten. Het is alsof je je computer een supersnelle, onvermoeibare stagiair geeft.

Maar er zit een addertje onder het gras: traditioneel scrapen met Ruby vraagt programmeerkennis, inzicht in HTML en de bereidheid om je script te fixen als een website verandert. Daar komen AI-webscraper tools om de hoek kijken—die nemen het technische werk uit handen en leveren direct de data.

De Klassieke Manier: Zelf Scrapen met Ruby

Ben je nieuwsgierig (of een beetje avontuurlijk)? Zo werkt het klassieke Ruby-scrapingproces:

- Ruby installeren: Installeer Ruby (versie 3.x is standaard in 2025) en zet je omgeving op met Bundler voor het beheren van gems.

- Gems toevoegen: Installeer gems zoals

HTTParty(voor webverzoeken) enNokogiri(voor HTML-parsing). Voor dynamische sites heb je somsselenium-webdriverofwatirnodig. - Webpagina ophalen: Gebruik

HTTParty.get('<https://example.com>')om de HTML van de pagina binnen te halen. - HTML parsen: Met

Nokogiri::HTML(page)maak je van de HTML een doorzoekbare structuur—zoals “vind alle<span class='price'>-elementen.” - Data extraheren: Loop door de elementen, pak de gewenste tekst en sla die op in een array of hash.

- Exporteren: Gebruik Ruby’s

CSV-bibliotheek om je data naar een CSV-bestand te schrijven, of exporteer als JSON voor complexere toepassingen.

Voordelen:

- Volledige controle—je bepaalt elk detail zelf.

- Geen extra softwarekosten (als je de skills al hebt).

- Makkelijk te integreren met andere Ruby-systemen.

Nadelen:

- Steile leercurve (Ruby, HTML, CSS, webprotocollen).

- Kost veel tijd om op te zetten en te debuggen.

- Onderhoudsgevoelig—websites veranderen, scripts gaan stuk.

- Schalen en anti-botmaatregelen vragen extra werk.

Ik heb teams dagenlang zien sleutelen aan een Ruby-scraper, die vervolgens de week erop stukging omdat de website een classnaam wijzigde. Het hoort erbij, maar efficiënt is het niet altijd.

De Belangrijkste Ruby-bibliotheken voor Webscraping

Een handig overzichtje:

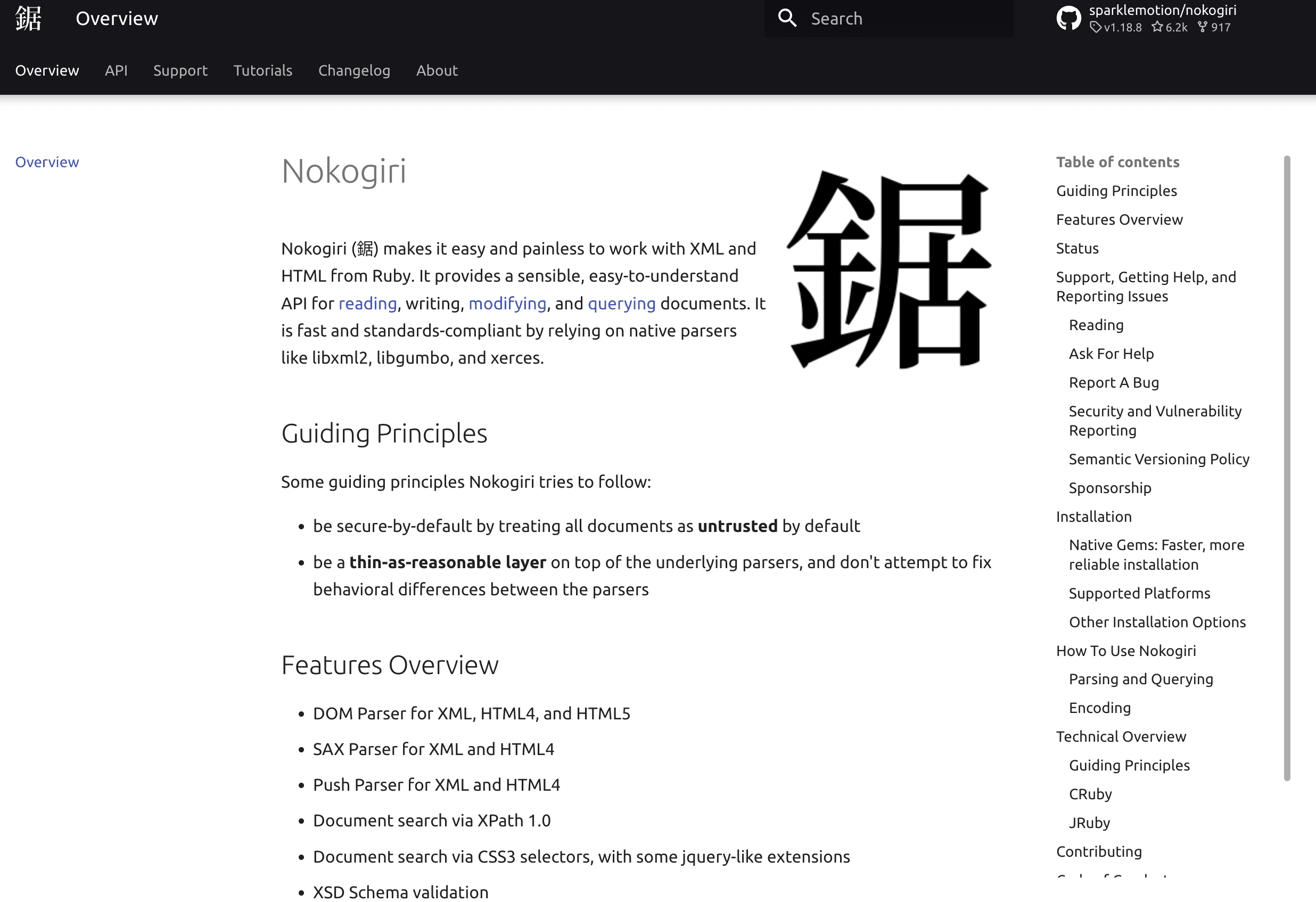

- Nokogiri: Dé standaard voor HTML/XML-parsing. Hiermee kun je met CSS-selectors of XPath content ophalen.

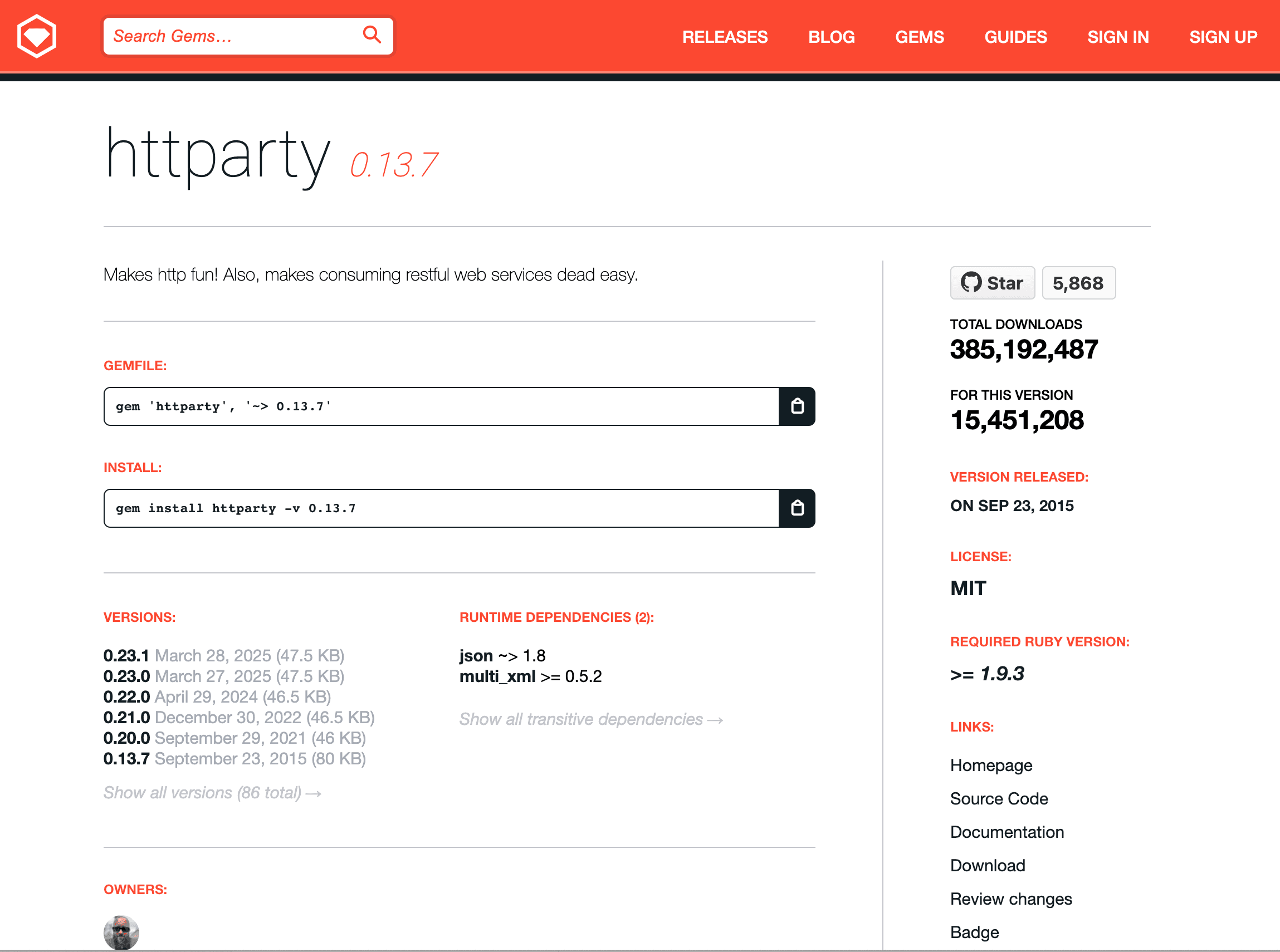

- HTTParty: Maakt HTTP-verzoeken makkelijk—pagina’s ophalen, headers en cookies beheren, enzovoort.

- Selenium / Watir: Voor sites die data met JavaScript laden. Hiermee kun je een echte browser aansturen (ook headless) en gebruikersacties nabootsen.

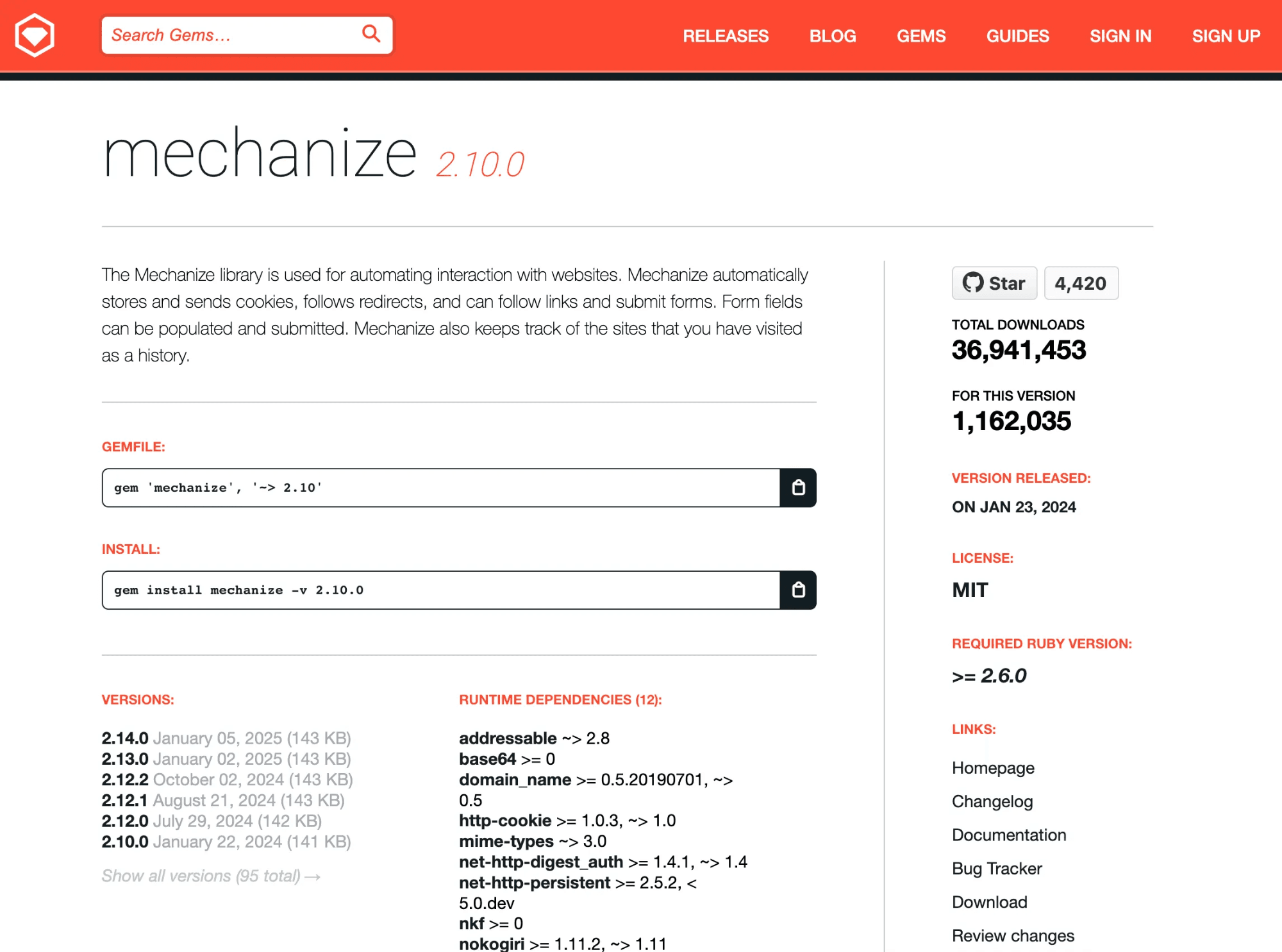

- Mechanize: Automatiseert formulierinvoer, linknavigatie en sessiebeheer voor eenvoudigere, oudere sites.

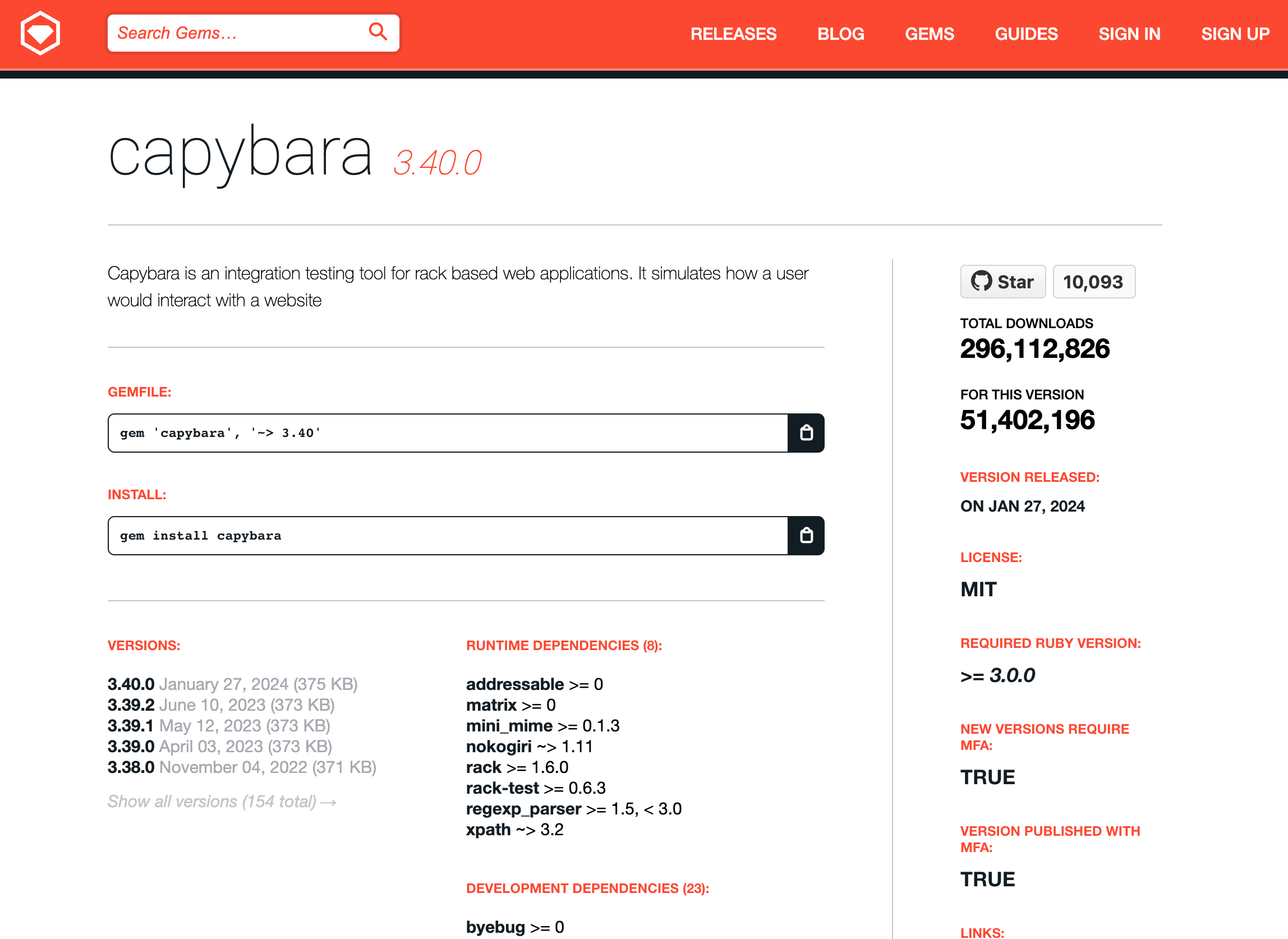

- Capybara: Vooral bekend uit testomgevingen, maar ook bruikbaar voor scraping met een browser-achtige API.

Elke library heeft z’n eigen kracht. Nokogiri + HTTParty werkt top voor statische pagina’s; voor JavaScript-rijke sites heb je Selenium of Watir nodig.

Veelvoorkomende Struggles bij Ruby-scraping

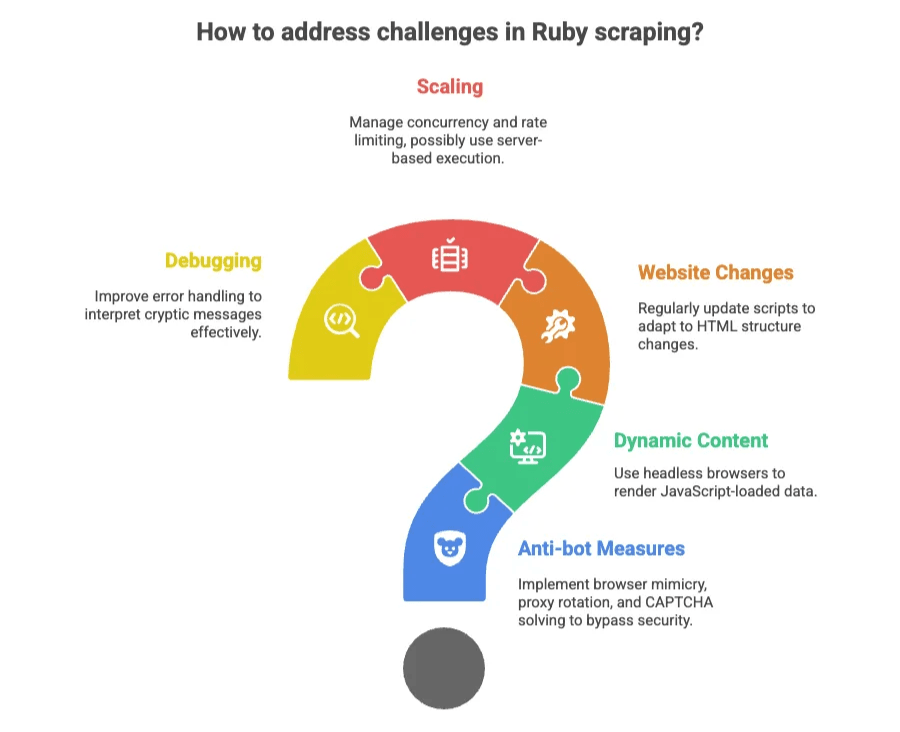

Zelfs met goede libraries loop je tegen obstakels aan:

- Anti-botmaatregelen: IP-blokkades, CAPTCHAs, verplichte logins. Je moet browsers nabootsen, proxies roteren en soms zelfs puzzels oplossen die voor mensen bedoeld zijn.

- Dynamische content: Veel sites laden data met JavaScript. Met alleen HTTP-verzoeken zie je die niet—je hebt een headless browser nodig.

- Websitewijzigingen: Als de HTML-structuur verandert, werkt je script niet meer. Onderhoud is continu nodig.

- Schalen: Wil je duizenden pagina’s scrapen? Dan moet je rekening houden met gelijktijdigheid, limieten en mogelijk je scripts op een server draaien.

- Debuggen: Fouten zijn soms vaag. “NoMethodError for nil:NilClass” is Ruby’s manier om te zeggen: “Ik kon niet vinden wat je zocht—succes!”

Voor niet-ontwikkelaars zijn dit vaak showstoppers. Zelfs voor developers is het veel werk voor routinematige dataverzameling.

AI-webscraper Tools: De No-code Oplossing

Nu het leuke deel. Stel je voor: data van elke website halen in twee klikken—zonder code, zonder installatie, zonder frustratie. Dat is precies wat AI-webscraper tools zoals mogelijk maken.

In plaats van te programmeren, gebruik je een Chrome-extensie of webapp. De AI leest de pagina, stelt voor welke data je kunt halen en regelt alles—van paginering tot subpagina’s en anti-botmaatregelen.

Thunderbit: AI-webscraper voor Iedereen

Thunderbit is gemaakt voor zakelijke gebruikers—sales, marketing, e-commerce, vastgoed, noem maar op. Dit maakt het uniek:

- AI Suggest Fields: Eén klik en Thunderbit’s AI scant de pagina en stelt kolommen voor (zoals Naam, Prijs, URL). Geen gedoe meer met CSS-selectors.

- Subpagina’s Scrapen: Meer details nodig? Thunderbit bezoekt automatisch alle subpagina’s (zoals product- of profielpagina’s) en vult je tabel aan.

- Directe Templates: Voor populaire sites (Amazon, Zillow, Instagram, Shopify) kies je een template en exporteer je data met één klik.

- Gratis Data-export: Stuur je data direct naar Excel, Google Sheets, Airtable of Notion—zonder extra kosten of gedoe.

- Meerdere Gegevenstypen: Haal e-mails, telefoonnummers, afbeeldingen, datums en meer op. Thunderbit ondersteunt zelfs AI-transformaties—samenvatten, categoriseren of vertalen tijdens het scrapen.

- Cloud- & Browsermodus: Scrapen via je browser (handig voor ingelogde sessies) of via Thunderbit’s cloudservers (tot 50 pagina’s tegelijk).

- Ingebouwde Extractors: Met één klik alle e-mails, telefoonnummers of afbeeldingen van een pagina halen.

- AI-autovullen: Gebruik AI om formulieren automatisch in te vullen en webprocessen te automatiseren—volledig gratis.

En het mooiste: je hoeft niets te weten van HTML, CSS of Ruby. Als je een browser kunt gebruiken, kun je met Thunderbit aan de slag.

Wanneer Kies je voor een AI-webscraper in plaats van Ruby?

Wanneer is no-code de beste keuze?

- Snelheid: Direct data nodig? Met Thunderbit heb je binnen enkele minuten resultaat.

- Niet-technische teams: Sales, operations, marketing—iedereen kan ermee werken.

- Regelmatige websitewijzigingen: AI past zich aan nieuwe layouts aan; scripts gaan stuk.

- Routinematige of eenmalige taken: Geen code nodig voor elk nieuw project.

- Schalen: Thunderbit’s cloud regelt grote klussen zonder extra werk.

- Anti-botproblemen: Laat de tool proxies, vertragingen en blokkades afhandelen.

Er zijn nog steeds situaties waarin maatwerk met Ruby zinvol is—zoals complexe workflows, diepe integratie of grootschalige projecten waar je alles zelf wilt regelen. Maar voor 90% van de zakelijke scrapingbehoeften zijn AI-tools sneller, eenvoudiger en stressvrij.

Ruby vs. AI-webscraper: De Vergelijking

Hier alles overzichtelijk op een rij:

| Aspect / Criteria | Ruby-codering (eigen script) | Thunderbit AI-webscraper (no-code) |

|---|---|---|

| Installatietijd | Hoog—Ruby, gems, code schrijven, debuggen. | Zeer laag—Chrome-extensie installeren, direct starten. |

| Technische kennis | Veel—Ruby, HTML/CSS, webprotocollen vereist. | Minimaal—alleen browserkennis, AI doet de rest. |

| Leercurve | Steil—scripten, debuggen, selectors, HTTP, enz. | Vlak—wijzen en klikken, AI-voorstellen. |

| Veldselectie | Handmatig—HTML inspecteren, selectors schrijven. | Automatisch—AI stelt velden voor, gebruiker kan aanpassen. |

| Paginering/Subpagina’s | Handmatig—loops schrijven, URL’s beheren, kans op fouten. | Ingebouwd—“Subpagina’s scrapen” met één klik. |

| Anti-botmaatregelen | Voor de developer—proxies, headers, vertragingen, CAPTCHAs. | Door de tool geregeld—cloudscraping, IP-rotatie, automatische blokkadehandling. |

| Dynamische content | Vereist Selenium/Watir, extra complexiteit. | Tool kiest automatisch—schakelt naar browsermodus indien nodig. |

| Onderhoud | Doorlopend—scripts breken bij sitewijzigingen, developer moet fixen. | Laag—AI past zich aan, templates worden bijgewerkt, minimale inspanning. |

| Schaalbaarheid | Gemiddeld—threads, servers, infrastructuur nodig. | Hoog—cloud regelt gelijktijdigheid, planning en grote klussen standaard. |

| Export/Integratie | Extra code—naar CSV, JSON of database schrijven. | Eén klik export naar Excel, Google Sheets, Airtable, Notion, enz. |

| Kosten | Dev-tijd + infrastructuur; open-source is “gratis” maar arbeid niet. | Abonnement/credits (bijv. $15–38/maand voor duizenden pagina’s), gratis voor kleine klussen. |

| Security/Compliance | Volledige controle—data blijft lokaal, gebruiker verantwoordelijk. | Door leverancier geregeld—data kan via cloud gaan, compliance deels ingebouwd, gebruiker blijft eindverantwoordelijk. |

| Beste voor | Complexe, maatwerkprojecten, diepe integratie, dev-teams. | Snel data nodig, niet-technische gebruikers, prototyping, terugkerende taken. |

Voor de meeste zakelijke gebruikers is no-code de logische keuze. Maar voor developers of unieke wensen blijft Ruby waardevol.

Best Practices voor Webscraping met Ruby in 2025

Of je nu codeert of AI-tools gebruikt, met deze tips houd je je projecten soepel, netjes en effectief.

Blijf Compliant en Eerlijk

- Respecteer de gebruiksvoorwaarden: Check of de website scraping toestaat. Overtreding kan leiden tot blokkades—of erger.

- Houd je aan

robots.txt: Dit bestand geeft aan wat bots wel en niet mogen. Het is geen wet, maar wel netjes (en soms verplicht). - Vermijd persoonsgegevens: Scrape geen gevoelige of privé-informatie. Blijf bij openbare data en anonimiseer indien nodig.

- Overbelast sites niet: Doseer je verzoeken. Gouden regel: als je sneller scrape’t dan een mens kan browsen, doe je te snel.

- Blijf op de hoogte van wetgeving: Regels als GDPR, CCPA en nieuwe wetten in 2025 veranderen continu. Twijfel? Vraag juridisch advies.

Gegevens Slim Organiseren en Gebruiken

- Bepaal je datastructuur: Kies vooraf welke velden je nodig hebt en houd namen consistent.

- Slim exporteren: Gebruik Thunderbit’s directe exports naar Google Sheets, Excel, Airtable of Notion voor overzicht en toegankelijkheid.

- Schoonmaken en valideren: Controleer op ontbrekende waarden, vreemde tekens of dubbele data. Thunderbit’s AI helpt bij het opschonen en formatteren.

- Automatiseer routineklussen: Gebruik planningen (Thunderbit laat je dit in gewoon Nederlands instellen) om data actueel te houden.

- Beveilig en documenteer: Sla data veilig op en houd bij hoe en wanneer je deze hebt verzameld.

Veelgemaakte Fouten en Hoe Je Ze Voorkomt

- Te snel scrapen: Overbelast de site niet—gebruik vertragingen of laat Thunderbit het tempo bepalen.

- Sitewijzigingen negeren: Scripts gaan stuk bij HTML-wijzigingen. AI-tools passen zich aan, maar check altijd je data.

- Data niet valideren: Rommel erin is rommel eruit. Controleer steekproefsgewijs je resultaten.

- Foutafhandeling overslaan: Gebruik in Ruby

begin-rescue-blokken. In tools: let op mislukte URL’s of ontbrekende data. - Juridische/ethische blinde vlekken: Scrape geen data die je niet mag hebben. Twijfel? Vraag het na.

- Data niet opslaan: Exporteer en maak altijd een back-up van je resultaten.

- Te ingewikkeld maken: Soms is de simpelste oplossing (zoals een template of AI-tool) de beste.

Aan de Slag: Je Eerste Webscrapingproject

Klaar om te beginnen? Hier een stappenplan voor niet-technische gebruikers:

- Bepaal je doel: Welke data heb je nodig? Van welke site?

- Verken de site: Zoek de pagina’s met jouw data. Let op paginering of subpagina’s.

- Installeer Thunderbit: en maak een account aan (gratis voor kleine klussen).

- Open de gewenste pagina: Klik op het Thunderbit-icoon.

- Klik op “AI Suggest Fields”: Laat de AI kolommen voorstellen. Pas aan indien nodig.

- Klik op “Scrapen”: Zie de data binnenstromen.

- (Optioneel) Subpagina’s scrapen: Klik op “Subpagina’s scrapen” voor extra details.

- Exporteren: Stuur je data naar Google Sheets, Excel, Airtable of Notion.

- Controleer & gebruik je data: Valideer, maak schoon en zet het in.

- (Optioneel) Probeer Ruby: Ben je nieuwsgierig? Experimenteer met een simpel Ruby-script om te zien hoe het werkt.

Voor de meeste gebruikers levert Thunderbit razendsnel resultaat. Wil je verder groeien? Dan is wat basiskennis van Ruby een mooie volgende stap.

Conclusie: De Toekomst van Webscraping met Ruby en AI

Webscraping in 2025 kent twee werelden: de kracht en flexibiliteit van Ruby-codering, en de snelheid en toegankelijkheid van AI-webscraper tools zoals Thunderbit. Beide hebben hun plek, en de beste teams weten wanneer ze welk gereedschap moeten inzetten—of zelfs combineren.

AI maakt webscraping toegankelijker dan ooit. Waar zakelijke gebruikers vroeger weken op IT moesten wachten, hebben ze nu binnen minuten hun data. Developers kunnen zich richten op de complexe uitdagingen, terwijl routine-scraping door slimme tools wordt afgehandeld. En naarmate AI zich verder ontwikkelt, zal steeds meer “zwaar werk” verdwijnen, zodat we ons kunnen focussen op inzichten in plaats van infrastructuur.

Of je nu een nieuwsgierige beginner bent of gewoon snel data wilt verzamelen: het web ligt voor je open. Blijf nieuwsgierig, werk netjes en veel succes met scrapen!

Veelgestelde Vragen

1. Wat is webscraping met Ruby en waarom is het nuttig voor bedrijven?

Webscraping met Ruby betekent dat je scripts schrijft die automatisch data van websites halen. Voor bedrijven is dit handig voor leadgeneratie, prijsmonitoring, marktonderzoek en meer—je krijgt snel inzichten en bespaart tijd zonder handmatig werk.

2. Wat zijn de grootste uitdagingen bij webscraping met Ruby?

Ruby vereist technische kennis van scripting, HTML/CSS en het omgaan met anti-botmaatregelen. Veelvoorkomende uitdagingen zijn onderhoud bij websitewijzigingen, omgaan met dynamische content, proxybeheer en het oplossen van lastige fouten zoals NoMethodError for nil:NilClass.

3. Hoe verhoudt Thunderbit zich tot traditioneel scrapen met Ruby?

Thunderbit is een no-code AI-webscraper die het hele proces automatiseert. In tegenstelling tot Ruby heb je geen programmeerkennis nodig, past het zich aan veranderende websites aan, regelt het paginering en subpagina’s en kun je met één klik exporteren naar bijvoorbeeld Google Sheets of Airtable. Ideaal voor wie snelheid en eenvoud zoekt.

4. Wanneer kies ik voor een Ruby-script in plaats van een AI-tool zoals Thunderbit?

Gebruik Ruby als je volledige controle, maatwerk of diepe systeemintegratie nodig hebt. Het is vooral geschikt voor teams met veel ontwikkelaars en doorlopende scrapingbehoeften. Voor de meeste andere gevallen—vooral snelle of eenmalige datataken—is Thunderbit sneller, eenvoudiger en beter schaalbaar.

5. Welke best practices gelden er voor webscraping in 2025?

Controleer altijd de gebruiksvoorwaarden van een website, respecteer robots.txt, vermijd persoonsgegevens en doseer je verzoeken. Valideer en maak je data schoon, automatiseer routineklussen en blijf op de hoogte van privacywetgeving zoals GDPR en CCPA. Of je nu Ruby of Thunderbit gebruikt: netjes en compliant scrapen is essentieel.

Zelf aan de slag?

- voor meer tips en handleidingen

En wil je verder lezen? Check dan deze uitgebreide artikelen: