솔직히 예전만 해도 '웹 스크래핑'이 영업팀이나 운영팀에서 흔하게 오가는 얘깃거리가 될 줄은 상상도 못 했어요. 그런데 2025년이 된 지금은 부동산 중개인부터 이커머스 매니저까지, 다들 데이터 추출 전략을 마치 맛집 추천하듯 자연스럽게 나누고 있죠. SaaS 자동화 툴을 오랫동안 만들고 써온 입장에서, 이 변화가 정말 피부로 느껴집니다—웹 데이터는 이제 IT 전문가만의 영역이 아니에요. 리드 발굴부터 가격 모니터링까지, 현대 비즈니스의 핵심 자원이 됐죠. 만약 아직도 웹 스크래퍼, 특히 AI 웹 스크래퍼를 안 써보고 있다면, 아직도 복붙에 머물러 있는 셈입니다.

하지만 워낙 다양한 도구가 쏟아지다 보니, 어떤 웹 스크래퍼를 골라야 할지 고민이 깊어집니다. 마트에서 시리얼 고를 때처럼 종류가 너무 많아 선택이 어렵고, 잘못 고르면 몇 달 동안 후회할 수도 있죠. 그래서 2025년을 위한 최고의 웹 스크래핑 소프트웨어를 한눈에 정리해봤어요. 노코드 AI 솔루션부터 개발자용 프레임워크까지, 영업 담당자든, 이커머스 운영자든, 반복 작업을 자동화하고 싶은 누구에게나 맞는 도구가 있습니다.

2025년에 비즈니스에 웹 스크래퍼가 꼭 필요한 이유

왜 웹 스크래핑과 데이터 추출이 이렇게 주목받고 있을까요? 숫자만 봐도 답이 나옵니다: 이라고 해요. 단순한 유행이 아니라 거대한 흐름이죠. 그리고 이 성장의 주인공은 IT 기업만이 아닙니다. 최근에는 영업, 마케팅, 운영팀까지 저코드·노코드 스크래퍼 덕분에 비전문가도 손쉽게 데이터 추출에 뛰어들고 있습니다().

비즈니스 활용 사례

- 리드 발굴: 영업팀은 이제 공개 디렉터리, 소셜 미디어, 기업 웹사이트에서 직접 타겟 고객 리스트를 만들 수 있습니다. 더 이상 오래된 리스트를 사거나 무작정 콜드콜을 할 필요가 없죠.

- 시장 조사 & 가격 모니터링: 이커머스와 리테일팀은 경쟁사 가격, 재고, 상품 구성을 실시간으로 추적할 수 있습니다. 예를 들어 John Lewis는 웹 스크래핑을 통해 을 이뤘다고 밝혔어요.

- 업무 자동화: 운영팀은 반복적인 데이터 수집을 자동화해, 수작업에 소모되던 시간을 아낄 수 있습니다.

- 부동산 인사이트: 중개인과 투자자는 매물 정보, 소유주 연락처, 시장 동향까지 한 번에 모아볼 수 있습니다.

특히 했고, 시장 인텔리전스를 위한 구인 데이터도 50% 성장했다는 점이 눈에 띕니다. 속도와 정확성이 경쟁력인 시대, 웹 스크래퍼는 앞서가는 팀의 비밀 무기가 되고 있어요.

AI 웹 스크래퍼로의 전환

예전 웹 스크래퍼는 강력하긴 했지만, '셀렉터 설정' 같은 복잡한 과정을 거쳐야 했죠. 이제 같은 AI 웹 스크래퍼가 나오면서, 누구나 몇 번의 클릭만으로 구조화된 데이터를 뽑을 수 있게 됐어요. 덕분에 더 많은 팀이 데이터에 쉽게 접근하고, 병목 현상은 사라지며, 데이터가 진짜 경쟁력이 되고 있습니다.

내게 맞는 웹 스크래퍼 또는 AI 웹 스크래퍼 고르는 법

그럼 어떤 도구를 골라야 할까요? 제가 웹 스크래핑 소프트웨어를 고를 때 꼭 체크하는 기준을 공유합니다. (정말 다양한 도구를 써봤거든요. 할머니도 쓸 수 있을 만큼 쉬운 것부터, 설명서만 따로 모니터가 필요할 만큼 복잡한 것까지!)

주요 체크포인트

- 사용 편의성: 비전문가도 별도 교육 없이 바로 쓸 수 있나?

- 데이터 추출 정확도: 웹사이트가 바뀌어도 원하는 데이터를 잘 뽑아내나?

- 지원 플랫폼: 브라우저 확장, 클라우드 서비스, 코드 라이브러리 중 어떤 방식인가?

- 연동 옵션: Google Sheets, Excel, Airtable, Notion, CRM 등으로 바로 내보낼 수 있나?

- 가격 정책: 무료 플랜이 있나? 행/실행/월 단위로 과금하나?

- 자동화 & 스케줄링: 예약 실행이 가능한가, 매번 직접 돌려야 하나?

- AI 기능: AI가 필드 추천, 복잡한 사이트 처리, 설정 자동화를 지원하나?

아래 표에서 각 도구의 특징을 빠르게 비교할 수 있습니다. (각 도구별 상세 설명은 이어집니다)

| Tool | Coding Required | AI Features | Scheduling | Export Options | Notable Strengths |

|---|---|---|---|---|---|

| Thunderbit | No | Yes | Yes | Sheets, Excel, Airtable, Notion | Easiest setup, AI field detection |

| Web Scraper | No | No | Limited | CSV, JSON, Sheets (cloud) | Visual config, flexible |

| BeautifulSoup | Yes | No | No | Custom (CSV, JSON, DB) | Simple, great for parsing |

| Scrapy | Yes | No | Yes | CSV, JSON, XML, API | Scalable, robust crawling |

| Playwright | Yes | No | No | Custom | Handles JS-heavy sites |

| Apify | No/Yes | Some | Yes | CSV, JSON, Sheets, API | Cloud scale, prebuilt actors |

Thunderbit: 비즈니스 사용자를 위한 가장 쉬운 AI 웹 스크래퍼

은 크롬 확장 프로그램으로, AI 기반 웹 스크래핑을 누구나 쉽게 쓸 수 있게 해줍니다. 특히 빠른 데이터가 필요한 영업, 이커머스, 부동산팀에 딱 맞아요.

주요 기능

![]()

- AI 필드 추천: 'AI 필드 추천' 버튼만 누르면 Thunderbit이 페이지를 읽고, 추출할 컬럼을 제안하며 각 필드별 맞춤 프롬프트까지 자동 생성합니다. 어떤 요소를 선택해야 할지 고민할 필요가 없어요.

- 서브페이지 스크래핑: 단순 리스트뿐 아니라, 각 상세 페이지까지 방문해 데이터를 자동으로 풍부하게 수집합니다.

- 즉시 사용 가능한 스크래퍼 템플릿: Amazon, Zillow, Instagram, Shopify 등 인기 사이트는 템플릿만 선택하면 바로 시작할 수 있습니다. AI 크레딧도 필요 없습니다.

- 예약 스크래핑: '매주 월요일 오전 9시'처럼 자연어로 스케줄을 입력하면, Thunderbit이 자동으로 실행합니다.

- 이메일, 전화번호, 이미지 추출 및 AI 자동입력: 클릭 한 번으로 연락처나 이미지를 추출하고, AI가 폼 작성이나 웹 자동화까지 지원합니다.

- 클라우드 vs 브라우저 스크래핑: 빠른 속도의 클라우드(최대 50페이지 동시 처리)와 로그인 필요한 사이트에 적합한 브라우저 방식 중 선택할 수 있습니다.

무료 플랜()도 제공되어, 최대 6페이지(체험 시 10페이지)까지 무료로 스크래핑할 수 있습니다. 대부분의 비즈니스 사용자라면 이 정도면 Thunderbit의 강점을 충분히 느낄 수 있어요.

Thunderbit의 실제 사용법은 이나, , , 등 심층 가이드에서 확인할 수 있습니다.

Web Scraper: 유연한 브라우저 기반 데이터 추출 도구

Web Scraper( 제공)는 오랜 역사를 가진 크롬 확장 프로그램입니다. 코딩은 싫지만, 약간의 설정은 감수할 수 있는 '시민 데이터 분석가'들에게 인기죠. 사이트맵이라는 시각적 설계도를 만들어, 어떤 경로로 이동하고 어떤 데이터를 추출할지 지정하는 방식입니다.

- 포인트 앤 클릭 인터페이스: 코딩은 필요 없지만, 요소 선택과 네비게이션 경로 설정을 익혀야 합니다.

- 서브페이지·페이지네이션 지원: 다단계 사이트도 처리 가능하지만, 각 단계별로 직접 설정해야 합니다.

- 내보내기 옵션: 기본적으로 CSV, JSON 지원. 클라우드 사용자는 Google Sheets, Dropbox로도 내보낼 수 있습니다.

- 스케줄링: 유료 클라우드 플랜에서만 제공됩니다.

- 커뮤니티 지원: 문서와 포럼은 많지만, 실시간 지원은 제한적입니다.

가장 큰 장점은 유연성, 단점은 학습 곡선입니다. 한 리뷰어의 말처럼, '기술에 익숙한 사람만이 이 도구를 제대로 활용할 수 있다'고 할 정도죠(). 인내심과 실험정신이 있다면 거의 모든 사이트를 스크래핑할 수 있지만, 시행착오가 싫다면 더 쉬운 도구를 추천합니다.

자세한 비교는 에서 확인하세요.

BeautifulSoup: 파이썬 기반 맞춤형 데이터 추출 라이브러리

이제 개발자 영역으로 넘어갑니다. 은 HTML, XML 파싱에 특화된 파이썬 라이브러리로, 파이썬만 알면 원하는 데이터를 원하는 방식으로 추출할 수 있습니다.

- UI 없음: 오직 코드로만 작업합니다.

- 가볍고 유연함: 소규모 프로젝트나 파이썬 워크플로우에 통합하기에 적합합니다.

- 부분적 페이지네이션 지원: 링크 추적이나 페이지 이동은 직접 루프와 로직을 짜야 합니다.

- 스케줄링 미지원: 자동화하려면 cron 등 외부 스케줄러를 사용해야 합니다.

- 출력 포맷 자유: CSV, JSON, 데이터베이스 등 원하는 대로 저장할 수 있습니다.

BeautifulSoup은 빠르고 간단한 데이터 추출이나, 대규모 파이프라인의 한 부분으로 활용하기 좋습니다. 수천~수만 페이지 대규모 크롤링에는 Scrapy가 더 적합합니다.

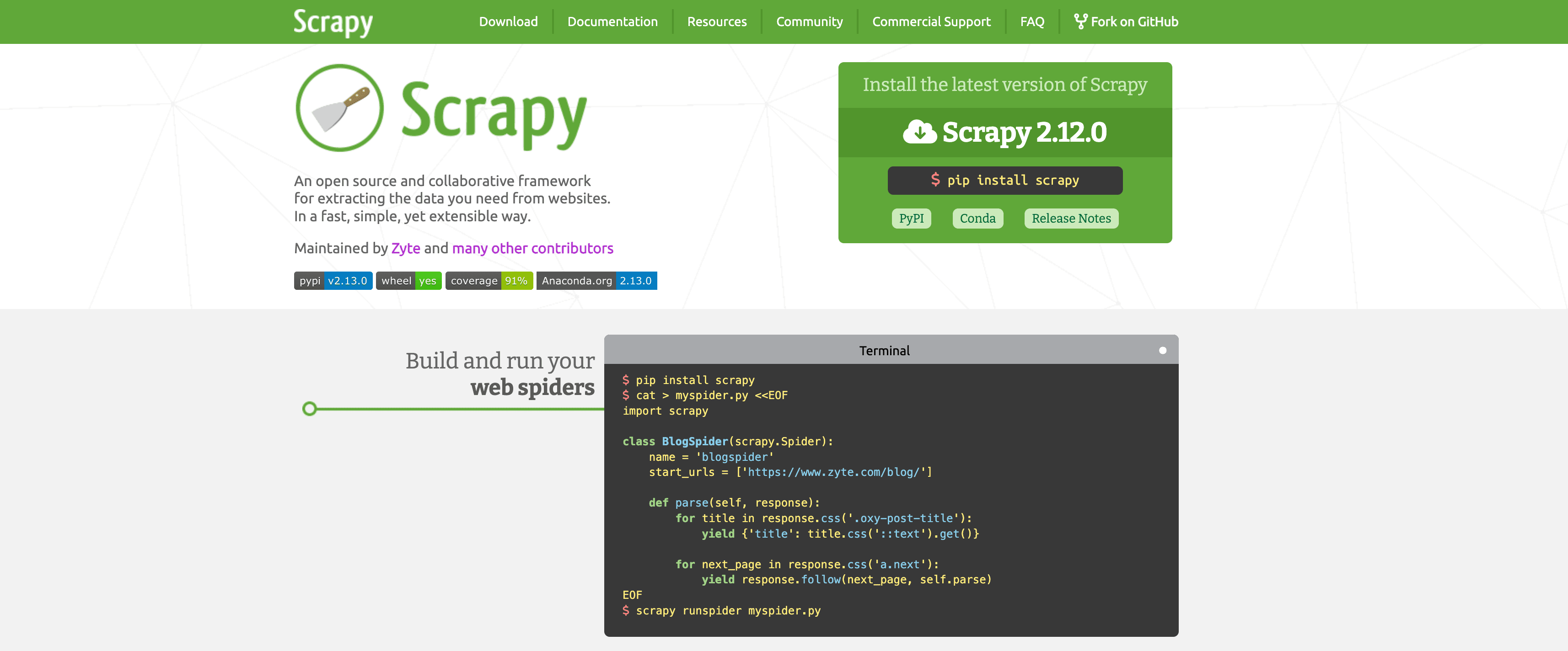

Scrapy: 대규모 데이터 추출을 위한 강력한 프레임워크

BeautifulSoup이 만능 칼이라면, 는 본격적인 파워툴입니다. Scrapy는 대규모 크롤링과 데이터 추출을 위해 설계된 파이썬 프레임워크입니다.

- 개발자 지향: 커맨드라인, 파이썬 클래스, 구조화된 프로젝트 레이아웃 필요

- 딥 크롤링 지원: 링크 자동 추적, 페이지네이션, robots.txt 준수

- 고성능: 비동기 요청, 자동 속도 조절, 캐싱, 재시도 등 지원

- 커스텀 파이프라인: CSV, JSON, XML, API, 데이터베이스 등 다양한 출력 지원

- 스케줄링: Scrapy Cloud 또는 cron 연동 가능

- 확장성: 프록시, User-Agent 변경, 헤드리스 브라우저 연동 등 미들웨어 지원

단점은 복잡성입니다. 학습 곡선이 가파르지만, 수천~수백만 페이지를 안정적으로 크롤링하려면 Scrapy만한 도구가 없습니다.

Playwright: 최신 웹 자동화 기반 스크래핑

일부 웹사이트는 데이터 추출을 어렵게 만듭니다. 자바스크립트로 데이터를 숨기거나, 로그인·복잡한 클릭을 요구하죠. 는 실제 브라우저를 자동으로 제어할 수 있는 최신 자동화 라이브러리(파이썬, 자바스크립트 등 지원)로, 마치 사람이 직접 조작하는 것처럼 동작합니다. ()

- 동적 콘텐츠 처리: React, Angular 등 JS 기반 사이트에 최적

- 사용자 행동 시뮬레이션: 버튼 클릭, 폼 입력, 스크롤, 요소 로딩 대기 등 가능

- 스케줄링 미지원: 직접 실행하거나 외부 스케줄러 필요

- 출력 포맷 자유: 원하는 곳에 데이터 저장 가능

- 리소스 소모 큼: 브라우저 인스턴스마다 메모리 사용량이 많아, 중간 규모 작업에 적합

Playwright는 까다로운 사이트의 '자물쇠를 푸는 열쇠'입니다. 하지만 비전문가에게는 어렵고, Scrapy 같은 네트워크 기반 스크래퍼보다 속도는 느립니다.

Apify: 대규모 확장 가능한 클라우드 기반 웹 스크래퍼

는 웹 스크래핑의 스위스 아미 나이프 같은 플랫폼입니다. 노코드와 코드 방식 모두 지원해, 인프라 관리 없이 대규모로 확장하고 싶은 팀에 적합합니다.

- 사전 제작된 '액터': Google Maps, LinkedIn, Zillow 등 인기 사이트용 스크래퍼가 수천 개 준비되어 있습니다. 파라미터만 입력하면 바로 실행 가능

- 커스텀 스크래퍼: 개발자는 JavaScript나 Python으로 직접 액터를 만들고 배포할 수 있습니다.

- 클라우드 스케줄링·확장: 여러 작업을 병렬로 실행하고, 예약 실행도 지원. 서버·프록시 관리는 Apify가 담당

- 연동성: CSV, JSON, Excel, Google Sheets, API, 웹훅, n8n, Make 등 다양한 자동화 툴과 연동

- AI 통합: 일부 액터는 AI로 더 똑똑한 추출·분류 지원

- 학습 곡선: 액터, 데이터셋, 프록시 등 개념이 초보자에겐 다소 복잡하지만, 문서가 잘 되어 있음

Apify는 다양한 기술 수준의 팀이나, 서버·프록시 걱정 없이 대규모 스크래핑을 원하는 조직에 이상적입니다. 단, 강력한 만큼 약간의 복잡성과 사용량 기반 과금이 있다는 점은 참고하세요.

한눈에 보는 웹 스크래퍼·AI 웹 스크래퍼 비교

아래 표는 각 도구의 특징을 한눈에 비교할 수 있도록 정리한 것입니다.

| Tool | No-Code Friendly | Subpage/Pagination | Scheduling | Scalability | Best For |

|---|---|---|---|---|---|

| Thunderbit | ⭐⭐⭐⭐⭐ | Auto (AI) | Built-in | Medium | Sales, ops, real estate |

| Web Scraper | ⭐⭐ | Manual config | Cloud only | Medium | Data analysts, patient users |

| BeautifulSoup | ⭐ | Manual (code) | No | Low | Python devs, small projects |

| Scrapy | ⭐ | Auto (code) | Yes | High | Devs, large-scale crawling |

| Playwright | ⭐ | Manual (code) | No | Medium | Devs, dynamic JS sites |

| Apify | ⭐⭐⭐ | Actor-dependent | Built-in | High | Teams, scalable projects |

- Thunderbit: 비전문가가 빠르게 데이터 추출, 최소한의 설정, AI 자동화까지 원하는 분께 추천

- Web Scraper: 시행착오를 감수할 수 있다면 강력하지만, 진정한 '플러그 앤 플레이'는 아님

- BeautifulSoup/Scrapy/Playwright: 코드에 익숙한 개발자에게 적합

- Apify: 클라우드 확장, 사전 제작 솔루션, 약간의 복잡성을 감수할 수 있는 팀에 적합

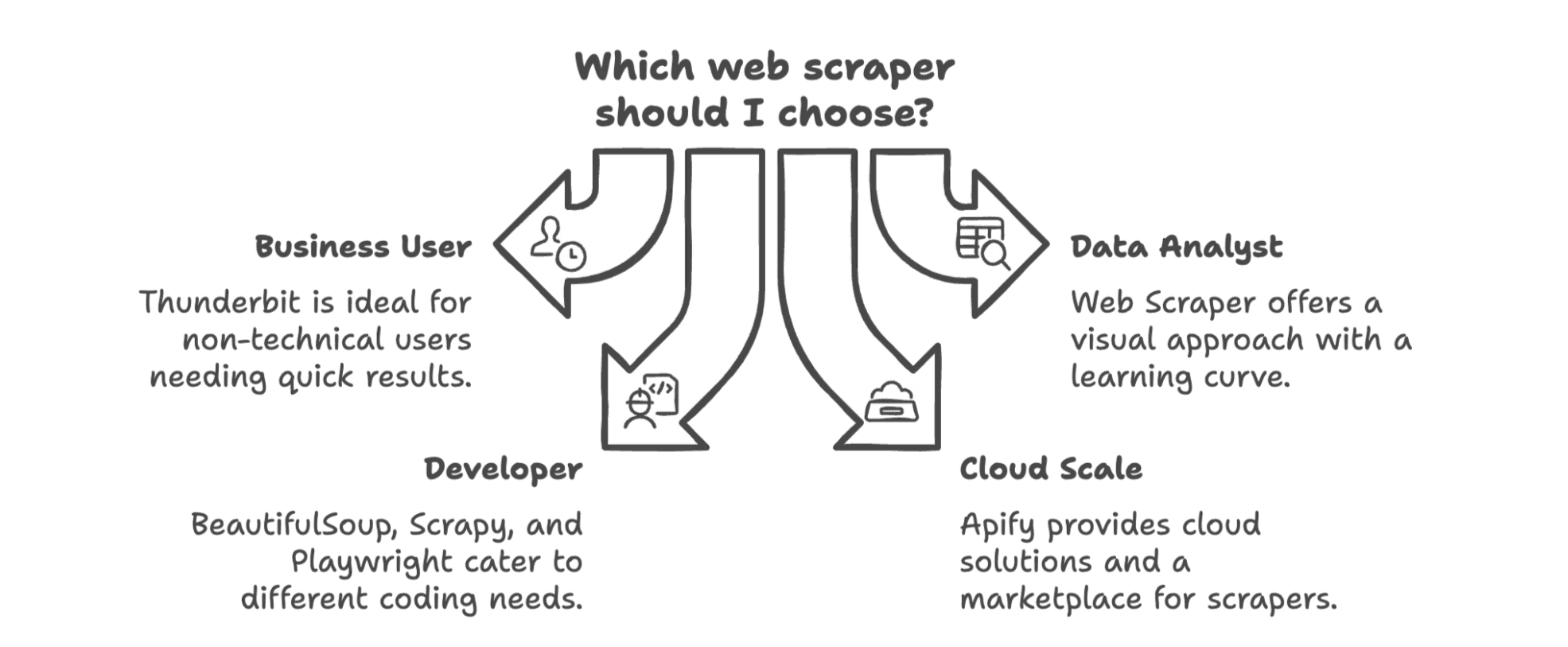

2025년, 내 비즈니스에 가장 적합한 웹 스크래퍼 고르기

결론적으로, 최고의 웹 스크래퍼는 팀 구성, 기술 역량, 데이터 활용 목적에 따라 달라집니다.

- 비즈니스 사용자(영업, 마케팅, 운영)라면, 이 가장 쉽고 빠른 선택입니다. 엔지니어가 아니어도 몇 분 만에 데이터 추출이 가능합니다.

- 데이터 분석가이거나 학습 곡선을 감수할 수 있다면, Web Scraper의 시각적 방식도 강력하지만, 시행착오를 각오해야 합니다.

- 개발자라면, BeautifulSoup(빠른 스크립트), Scrapy(대규모 크롤링), Playwright(동적 사이트)에 맞게 선택하세요.

- 클라우드 확장, 사전 제작 스크래퍼 마켓플레이스가 필요하다면, Apify가 좋은 선택입니다. 다양한 기술 수준의 팀에도 적합합니다.

그리고 꼭 기억하세요: 앞으로는 AI 기반 노코드 솔루션이 워크플로우와 바로 연동되는 시대입니다. '스크래핑-다운로드-가공-반복'의 시대는 저물고, 이제는 웹에서 스프레드시트(혹은 CRM, Notion)로 단 몇 번의 클릭이면 충분합니다.

웹 스크래핑이 얼마나 쉬워졌는지 궁금하다면, 을 직접 써보세요. 더 많은 팁과 심층 가이드는 에서 확인할 수 있습니다. (가끔은 유쾌한 농담도 곁들여져 있어요!)

2025년에는 복붙에서 벗어나, AI에게 반복 작업을 맡겨보세요.

자주 묻는 질문(FAQ)

Q1: 2025년에는 웹 스크래퍼 사용에 코딩이 꼭 필요한가요?

A: 이제는 아닙니다. Thunderbit 같은 AI 기반 도구는 비전문가도 몇 번의 클릭만으로 데이터 추출이 가능합니다. 개발자는 여전히 Scrapy, Playwright 등으로 맞춤 로직을 구현하길 선호합니다.

Q2: AI 웹 스크래퍼로 어떤 데이터를 추출할 수 있나요?

A: 텍스트, 숫자, 링크, 이메일, 전화번호, 이미지, PDF나 동적 웹사이트의 구조화 데이터까지 다양하게 추출할 수 있습니다. 일부 도구는 예약 실행, 번역, 실시간 분류도 지원합니다.

Q3: 비즈니스 목적으로 웹 스크래핑이 합법인가요?

A: 네, 공개된 데이터를 합법적인 비즈니스 목적으로 활용(예: 리서치, 리드 발굴)하는 것은 일반적으로 허용됩니다. 단, 로그인 필요하거나 저작권이 있는 콘텐츠는 허가 없이 스크래핑하지 마세요.

Q4: 웹 스크래핑에 AI를 쓰면 가장 큰 장점은?

A: 속도와 접근성입니다. AI가 필드 감지, 페이지네이션, 워크플로우 자동화까지 처리해주니, 설정에 소요되는 시간을 줄이고 데이터 활용에 집중할 수 있습니다.

더 알아보기