비밀 하나 살짝 풀어볼게요. 예전엔 웹 스크래핑이 마치 후드티 입은 해커나 모니터 앞에 앉아 있는 데이터 과학자들만의 전유물처럼 느껴졌죠. 그런데 요즘은 웹사이트에서 데이터 추출하는 게 아침에 커피 한 잔 내리는 것만큼이나 일상적인 일이 됐어요. 다행히 파이썬 몰라도 되고, 에스프레소 연거푸 마실 필요도 없습니다. AI 웹 스크래퍼 덕분에, HTML이 샌드위치 이름인 줄 아는 분들도 이제 웹에서 구조화된 데이터를 손쉽게 뽑아낼 수 있게 됐거든요.

혹시 제품 정보나 영업 리드, 가격표 같은 걸 복사해서 엑셀에 붙여넣어 본 적 있으세요? 혼자만 그런 거 아니에요. 이 시장 분석이나 경쟁사 모니터링을 위해 웹 스크래핑을 활용하고 있거든요. 그리고 웹 스크래핑 소프트웨어 시장은 규모로 커질 전망이에요. 즉, 데이터 추출은 더 이상 IT 전문가만의 영역이 아니란 얘기죠. 영업, 마케팅, 반복적인 데이터 입력에서 벗어나고 싶은 분이라면 이 글이 딱 맞을 거예요. 기본 개념부터 전통 방식과 AI 기반 방법 비교, 그리고 시작하는 방법까지 쉽게 풀어드릴게요. 후드티는 필요 없어요.

웹 스크래퍼란? 웹사이트에서 데이터 추출의 기본

먼저, 정말 쉽게 시작해볼게요. 웹 스크래퍼는 웹사이트에서 데이터를 자동으로 모아주는 도구(혹은 스크립트, 크롬 확장 프로그램 등)예요. 반복되는 복사-붙여넣기 작업을 대신해주는 초고속 인턴이라고 생각하면 딱 맞아요. 사람이 일일이 정보를 복사하지 않아도, 웹 스크래퍼는 몇 초 만에 모든 데이터를 쏙쏙 모아줍니다. 커피 한 잔 마실 시간도 필요 없죠.

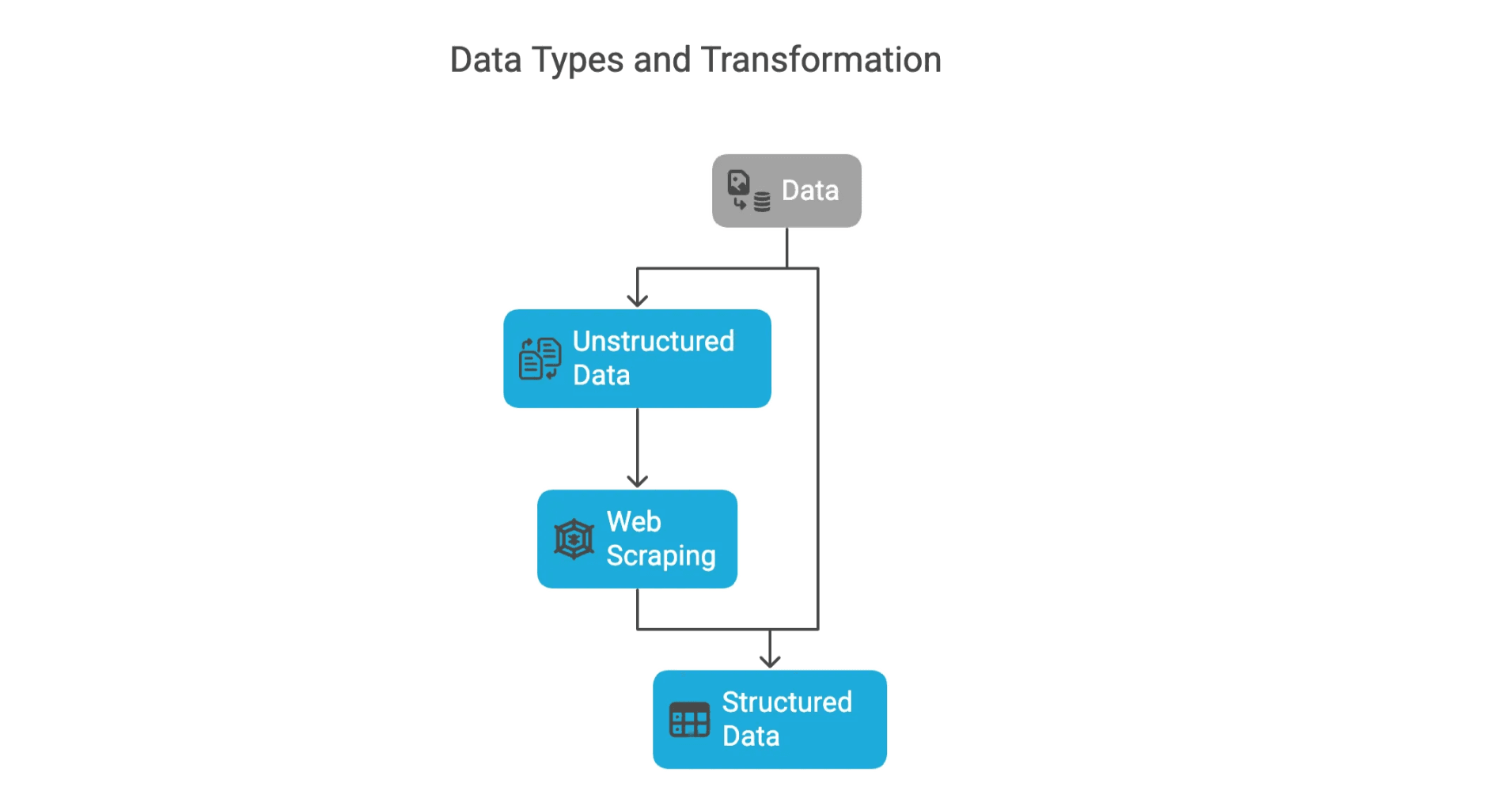

웹에서 만나는 데이터는 크게 두 가지로 나뉘어요:

- 구조화된 데이터: 엑셀에 바로 넣을 수 있는 표 형태의 데이터(예: 제품명, 가격, 이메일 등). 정돈되어 있어서 분석하기도 쉽죠.

- 비구조화 데이터: 블로그 글, 리뷰, 이미지 등 표로 정리되지 않은 데이터. 대부분의 웹 스크래핑은 이런 비구조화 데이터를 구조화 데이터로 바꾸는 게 목표예요.

웹사이트에서 표를 복사해 엑셀에 붙여넣어 본 적 있다면, 이미 수작업 웹 스크래핑을 해본 거예요. 그런데 이걸 1만 페이지에 반복한다고 상상해보세요. (직접 하진 마세요. 그럴 때 웹 스크래퍼가 필요한 거니까요.)

왜 웹사이트에서 데이터를 추출해야 할까? 비즈니스에 주는 이점

그럼, 굳이 데이터를 추출해야 하는 이유가 뭘까요? 한마디로, 비즈니스는 데이터로 움직이고, 웹은 세상에서 가장 큰 데이터 창고이기 때문이에요. 영업, 마케팅, 이커머스, 부동산 등 어떤 분야든 웹 데이터 추출은 경쟁력을 확실히 높여줍니다.

대표적인 활용 예시는 아래와 같아요:

| 활용 사례 | 설명 | 기대 효과/ROI |

|---|---|---|

| 리드 발굴 | 디렉터리나 소셜 사이트에서 연락처, 이메일, 기업 리스트 수집 | 영업팀의 시간 절약 및 더 많은 유효 리드 확보 |

| 가격 모니터링 | 경쟁사 가격, 재고, 프로모션 실시간 추적 | 소매업체가 가격을 유연하게 조정해 매출 4% 증가 |

| 시장 조사 | 리뷰, 뉴스, 소셜 반응 등 트렌드 파악 | 마케터가 실시간 소비자 인사이트로 캠페인 최적화 |

| 경쟁사 분석 | 경쟁사 제품, 신제품, 콘텐츠 모니터링 | 시장 변화에 빠르게 대응 |

| 부동산 인텔리전스 | 매물, 가격, 입주 가능 정보 수집 | 중개인·투자자가 시장보다 먼저 기회 포착 |

실제로 가 경쟁사 가격 스크래핑을 활용한 동적 가격 전략을 쓰고 있어요. John Lewis, ASOS 같은 기업도 웹 데이터를 활용해 매출이 쑥쑥 올랐죠.

전통적인 웹 스크래퍼 도구: 어떻게 작동할까?

AI가 나오기 전에는, 전통적인 웹 스크래퍼는 주로 파이썬 같은 언어로 짠 스크립트나 브라우저 확장 프로그램이었어요. 원하는 데이터를 모으기 위해 정해진 규칙을 따라야 했죠.

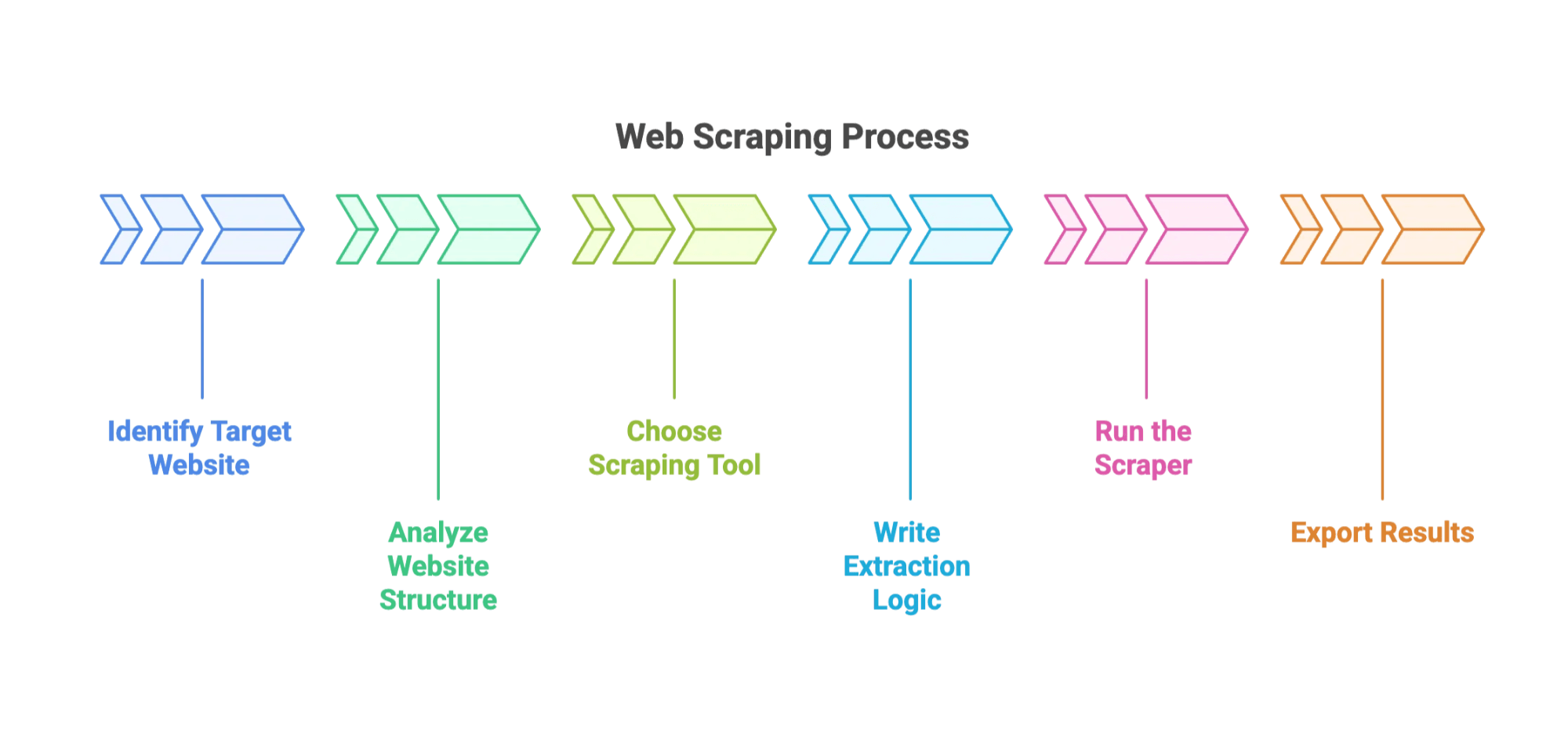

일반적인 과정은 이렇습니다:

- 대상 웹사이트와 추출할 데이터 필드 선정

- 웹사이트 구조 분석 (브라우저 개발자 도구로 HTML 구조 파악—마치 디지털 발굴 작업 같죠)

- 도구 선택: , 같은 라이브러리나 브라우저 플러그인 활용

- 추출 로직 작성: CSS 선택자나 XPath로 데이터 위치 지정

- 스크래퍼 실행: 여러 페이지에서 데이터 수집

- 결과 내보내기: CSV, JSON, 엑셀 등으로 저장

실습 예시: 전통적인 웹 스크래퍼로 데이터 추출하기

예를 들어, 이커머스 사이트에서 상품 목록을 추출한다고 가정해볼게요.

- 1단계: 파이썬과 BeautifulSoup 설치

- 2단계: 브라우저로 상품 페이지의 HTML 태그(상품명, 가격 등) 확인

- 3단계: 페이지를 불러오고, HTML을 파싱해 필요한 필드 추출하는 스크립트 작성

- 4단계: 여러 페이지를 반복 처리(페이지네이션)

- 5단계: 데이터를 CSV 파일로 저장

이론상 간단해 보여도, 실제로는 첫 시도에 오류가 나기 쉽죠. (저도 처음엔 클래스명을 잘못 써서 500줄의 'None'만 뽑아본 적 있어요.)

전통적인 웹 스크래퍼의 흔한 어려움

여기서부터가 진짜 고비입니다:

- 웹사이트 구조 변경: 사이트 레이아웃이 조금만 바뀌어도 스크래퍼가 멈출 수 있어요. 가 매주 이런 이유로 깨진다고 하네요.

- 봇 차단: CAPTCHA, IP 차단, 요청 제한 등으로 중단될 수 있습니다. 프록시, 지연, CAPTCHA 우회 등 추가 대응이 필요하죠.

- 기술적 역량 필요: 코딩, HTML/CSS 기본 지식이 있어야 해요.

- 지속적인 관리: 스크래퍼는 자주 점검하고 수정해야 합니다.

- 데이터 정제: 불규칙한 형식, 누락값, 인코딩 문제 등 데이터 정리가 필요해요.

초보자라면, 레시피가 계속 바뀌고 오븐이 가끔 잠기는 베이킹을 하는 기분일 거예요.

AI 웹 스크래퍼의 등장: 데이터 추출이 쉬워진다

이제부터가 진짜 재미있는 부분이에요. AI 웹 스크래퍼는 복잡한 코딩이나 선택자 지정 없이, 원하는 데이터를 자연어로 설명만 하면 AI가 알아서 추출해줍니다.

Thunderbit(저희 서비스!)가 대표적인 예죠. 를 사용하면, 코딩 없이도 자연어로 원하는 데이터를 지정해 웹사이트에서 구조화된 정보를 추출할 수 있어요. 영업, 마케팅, 이커머스 등 다양한 분야에서 필요한 데이터를 몇 분 만에 모을 수 있죠.

Thunderbit AI 웹 스크래퍼: 데이터 추출을 쉽게 만드는 방법

Thunderbit가 어떻게 업무를 간단하게 만들어주는지 살펴볼게요:

- AI 필드 추천: 'AI 필드 추천' 버튼만 누르면 Thunderbit가 웹사이트를 읽고, 컬럼명과 추출 방법까지 자동으로 제안해줘요.

- 서브페이지 추출: 상세 정보가 필요하다면, 각 상품 상세 페이지 등 서브페이지까지 방문해 데이터를 자동으로 보강합니다.

- 즉시 사용 가능한 템플릿: Amazon, Zillow 등 인기 사이트는 미리 준비된 템플릿으로 바로 추출 가능

- 무료 데이터 내보내기: 엑셀, 구글 시트, Airtable, Notion 등으로 데이터 내보내기. CSV, JSON 다운로드도 지원. 숨겨진 비용 없음.

- 예약 스크래핑: 정기적으로 데이터 추출 예약 가능—가격 모니터링, 리드 업데이트에 유용

- AI 자동 입력: 온라인 폼도 AI가 대신 입력(10페이지짜리 공급업체 등록 폼도 OK)

- 이메일, 전화번호, 이미지 추출: 클릭 한 번으로 연락처나 이미지를 수집

가장 좋은 점은? 코딩을 전혀 몰라도 된다는 것! Thunderbit 크롬 확장 프로그램은 할 수 있고, 에서 더 자세히 알아볼 수 있어요.

전통 방식 vs. AI 웹 스크래퍼 비교

두 방식의 차이를 한눈에 볼까요?

| 비교 항목 | 전통적 웹 스크래퍼 | AI 웹 스크래퍼(Thunderbit) |

|---|---|---|

| 사용 편의성 | 코딩 또는 복잡한 설정 필요 | 노코드, 자연어 인터페이스 |

| 변화 대응력 | 사이트 변경에 쉽게 깨짐 | AI가 자동으로 레이아웃 변화에 적응 |

| 유지보수 | 자주 수정 필요 | 대부분 AI가 자동 처리 |

| 기술 역량 | 프로그래밍, HTML 지식 필요 | 비즈니스 사용자도 쉽게 사용 |

| 세팅 속도 | 수 시간~수일 | 몇 분이면 완료 |

| 데이터 정제 | 수동 정리 필요 | AI가 자동으로 정제 및 구조화 |

| 비용 | 오픈소스는 무료지만 시간 소모 큼 | 합리적 요금제, 무료 내보내기 지원 |

특히 초보자나 비즈니스 사용자라면, Thunderbit 같은 AI 웹 스크래퍼가 속도, 편의성, 신뢰성 면에서 훨씬 유리해요. 대규모 맞춤형 프로젝트에는 전통 도구도 여전히 쓰이지만, 95%의 일반적인 용도에는 AI가 훨씬 효율적입니다.

따라하기: 입문자를 위한 웹사이트 데이터 추출 단계별 가이드

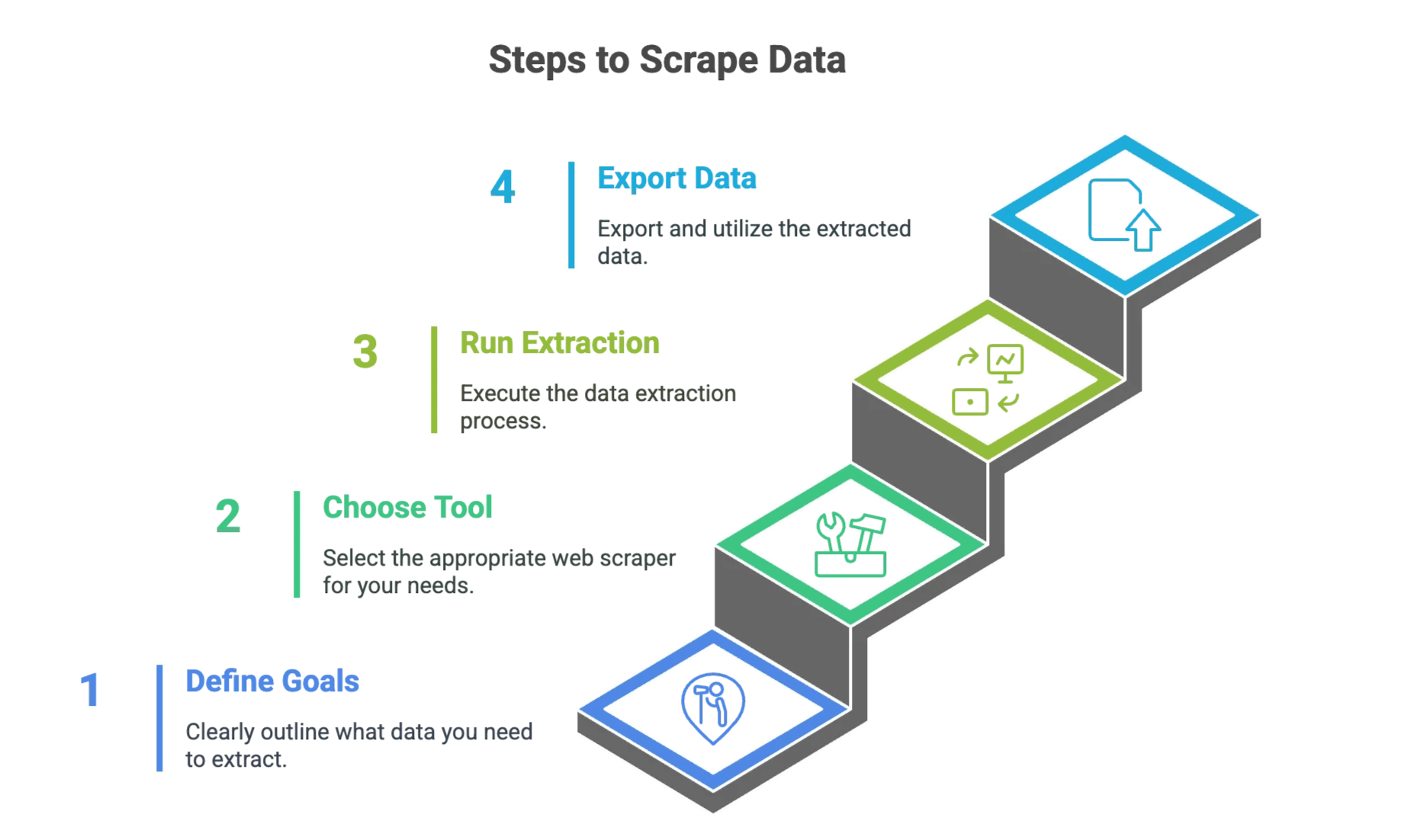

1단계: 데이터 추출 목표 정하기

시작 전에, 어떤 데이터가 필요한지 명확히 해두세요. 예를 들어:

- 어떤 웹사이트에서 추출할 것인가?

- 어떤 데이터 필드가 중요한가? (예: 제품명, 가격, 이메일, 전화번호 등)

- 데이터가 필요한 빈도는? (1회성인지, 정기적인지)

체크리스트를 만들어보세요. 예시: “XYZ.com에서 첫 5페이지의 제품명, 가격, 평점을 수집하고 싶다.”

2단계: 적합한 웹 스크래퍼 도구 선택

간단한 선택 가이드입니다:

- 코딩에 익숙하고 세밀한 제어가 필요하다면? BeautifulSoup, Scrapy 같은 전통 도구 추천

- 빠르고 쉽게, 코딩 없이 하고 싶다면? 같은 AI 웹 스크래퍼 추천

잘 모르겠다면, 일단 AI로 시작해보세요. 필요하면 나중에 더 깊이 들어가도 됩니다.

3단계: 데이터 추출 실행하기

전통 방식

- 도구 설치: 파이썬 및 필요한 라이브러리 설치

- 웹사이트 구조 확인: 브라우저 개발자 도구로 HTML 구조 파악

- 스크립트 작성: 각 데이터 필드 추출 방법 정의

- 한 페이지에서 테스트: 원하는 데이터가 잘 추출되는지 확인

- 확장: 페이지네이션 등 여러 페이지로 범위 확대

- 데이터 내보내기: CSV, JSON 등으로 저장

AI 방식(Thunderbit)

- Thunderbit 크롬 확장 설치:

- 대상 웹사이트 열기: 추출할 페이지로 이동

- 'AI 필드 추천' 클릭: Thunderbit가 페이지를 읽고 컬럼 제안

- 미리보기 확인: 데이터가 제대로 보이는지 체크, 필요시 컬럼 수정

- '스크래핑' 클릭: Thunderbit가 데이터를 수집

- 데이터 내보내기: 엑셀, 구글 시트, Airtable, Notion 등으로 다운로드

시각적 안내가 필요하다면 도 참고해보세요.

4단계: 데이터 내보내기 및 활용

데이터를 추출했다면:

- 원하는 도구로 내보내기: 엑셀, 구글 시트, Airtable, Notion, CSV, JSON 등

- 업무에 통합: 영업, 가격 분석, 시장 조사 등 다양한 용도로 활용

- 정확성 검증: AI를 써도 샘플 데이터를 직접 확인하는 게 좋아요.

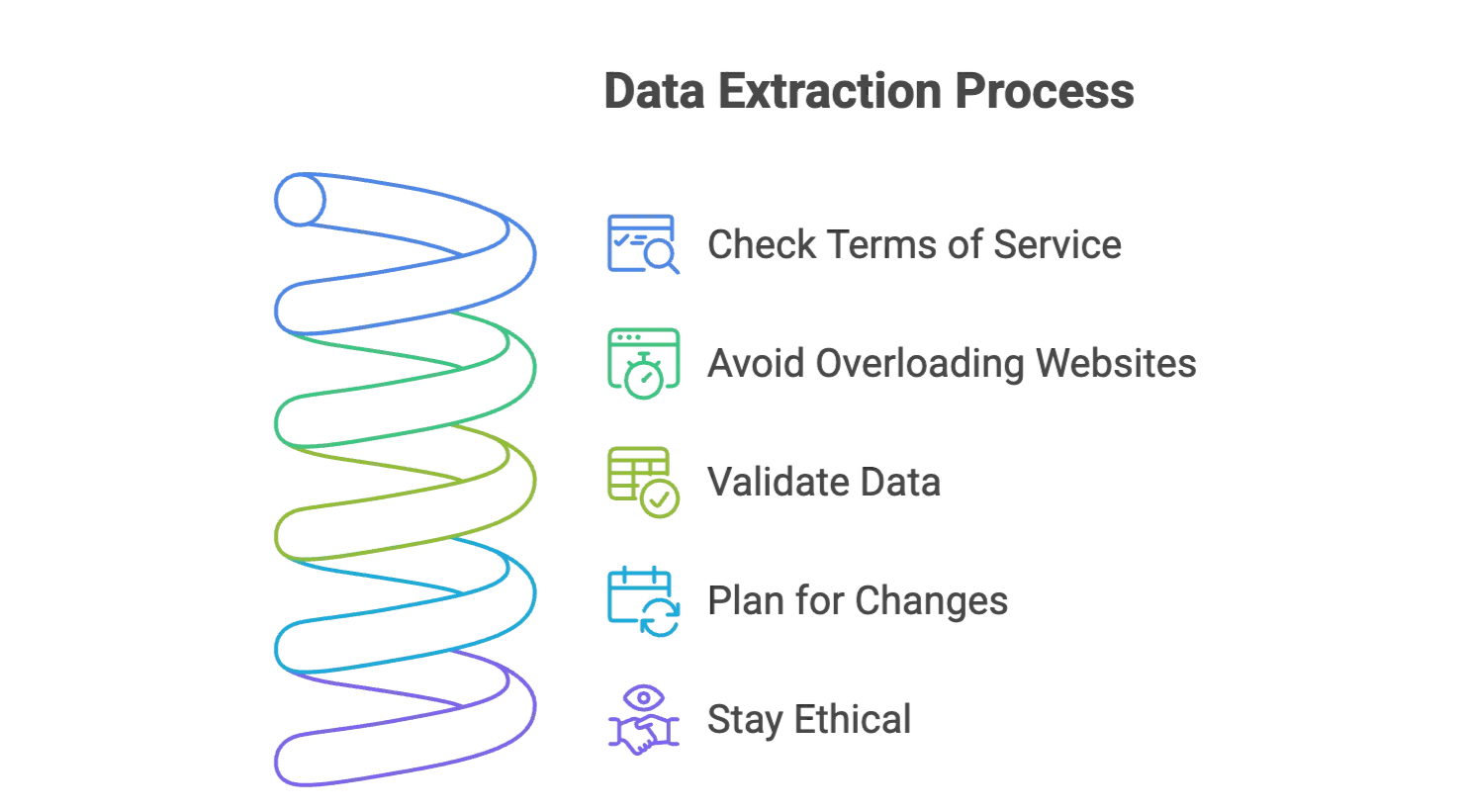

데이터 추출 성공 팁: 흔한 실수 피하기

- 웹사이트 이용약관 확인: 데이터 추출이 허용되는지 꼭 확인하세요. 공개 정보만 활용하고, 민감한 개인정보는 피하세요.

- 웹사이트 과부하 방지: 전통 도구는 요청 간 지연을 두고, Thunderbit는 자동으로 처리해줍니다.

- 데이터 검증: 결과 샘플을 꼭 확인해 정확성을 점검하세요.

- 변화에 대비: 웹사이트는 자주 바뀌어요. Thunderbit 같은 AI 스크래퍼는 자동 적응하지만, 큰 변화는 직접 모니터링하는 게 좋아요.

- 윤리적 사용: 필요한 데이터만 추출하고, 보고서나 게시물에 활용할 땐 출처를 꼭 남기세요.

더 많은 팁은 와 에서 확인할 수 있어요.

마무리 & 핵심 요약

웹 스크래핑은 수작업 스크립트 시대를 지나, 이제 AI 기반의 누구나 쉽게 쓸 수 있는 도구로 진화했어요. 주요 차이점은?

- 전통적 스크래퍼는 세밀한 제어가 가능하지만, 코딩과 유지보수, 인내심이 필요합니다.

- AI 웹 스크래퍼(예: )는 자연어 명령, 즉시 미리보기, 서브페이지·예약 스크래핑 등 다양한 기능으로 누구나 쉽게 데이터 추출이 가능합니다.

웹 스크래핑이 처음이라도 걱정하지 마세요. 도구는 점점 더 쉬워지고, 비즈니스 가치도 분명합니다. 리드 발굴, 가격 모니터링, 반복 작업 자동화 등 다양한 업무에 AI 웹 스크래퍼가 큰 도움이 될 거예요.

웹 데이터 앞에서 막막하다면, 컴퓨터공학 박사학위도, 후드티도 필요 없어요. 명확한 목표, 적합한 도구, 그리고 따뜻한 커피 한 잔이면 충분하답니다.

직접 경험해보고 싶으신가요? 후, 웹 데이터 추출이 얼마나 쉬운지 확인해보세요.

더 궁금하다면 에서 아마존, 구글, PDF 등 다양한 스크래핑 노하우를 확인해보세요. 즐거운 데이터 추출 되세요!

자주 묻는 질문(FAQ)

Q1: 웹 스크래핑은 합법인가요? A: 네, 공개된 데이터의 스크래핑은 많은 나라에서 일반적으로 합법이에요. 다만, 각 웹사이트의 이용약관을 꼭 확인하고, 민감한 개인정보는 피하세요.

Q2: 로그인해야 볼 수 있는 사이트도 스크래핑할 수 있나요? A: 가능합니다. 다만, 더 복잡하고 사이트 정책을 위반할 수 있어요. 세션 관리나 인증이 필요한 도구가 필요하며, 법적 이슈도 반드시 검토해야 합니다.

Q3: 자바스크립트로 동적으로 렌더링되는 사이트는 어떻게 스크래핑하나요? A: 헤드리스 브라우저나, 자바스크립트 렌더링을 지원하는 AI 스크래퍼 등 동적 페이지를 처리할 수 있는 도구를 사용하세요.

Q4: 차단을 피하려면 어떻게 해야 하나요? A: 요청 속도 제한, 무작위 지연, User-Agent 변경 등 다양한 전략이 필요합니다. AI 기반 스크래퍼는 이런 부분을 자동으로 처리해주는 경우가 많아요.

더 알아보기

-

법적 가이드라인, 업계 통계, 윤리적 모범 사례 정리

-

트렌드, 시장 성장, AI가 웹 데이터 추출에 미치는 영향(2024~2025)

-

robots.txt 파일 해석법과 윤리적·합법적 스크래핑 가이드